学习路线:

这个方向初期比较容易入门一些,掌握一些基本技术,拿起各种现成的工具就可以开黑了。不过,要想从脚本小子变成黑客大神,这个方向越往后,需要学习和掌握的东西就会越来越多以下是网络渗透需要学习的内容:

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

- ( n ) 是样本数量。

- (

Y

i

Y_i

Yi ) 是实际观测值。

- (

Y

^

i

\hat{Y}_i

Y^i ) 是相应的预测值。

MSE 的值越小,表示模型的预测效果越好,因为它衡量了模型预测值与真实值之间的平均平方误差。然而,MSE 的值受到量纲影响,通常需要与实际问题的背景一起考虑。

在机器学习中,优化算法通常会试图最小化 MSE,以改进模型的性能。

1.3 权重和偏置

在机器学习和神经网络中,权重(Weights)和偏置(Bias)是模型中的两个关键参数,它们对于模型的学习和预测起着重要的作用。

- 权重(Weights): 权重是连接两个神经元之间的参数,用于调整输入特征的影响力。在神经网络中,每个连接都有一个权重,它表示两个神经元之间连接的强度。训练模型的目标是调整这些权重,使得模型能够更好地拟合训练数据,从而提高对新数据的泛化能力。

- 偏置(Bias): 偏置是神经网络中每个神经元的一个附加参数,它独立于输入特征。偏置的作用是在没有输入时引入一个固定的偏移,从而使网络更灵活地适应不同的模式。偏置的调整可以帮助模型更好地拟合数据。

在神经网络的一层中,每个神经元都有自己的权重和一个共享的偏置。模型通过训练数据来学习调整这些权重和偏置,以最小化损失函数,从而提高模型的性能。

数学上,对于一个简单的神经网络的线性变换,可以表示为:

输出

=

权重

×

输入

偏置

\text{输出} = \text{权重} \times \text{输入} + \text{偏置}

输出=权重×输入+偏置

这一变换后通常还会通过一个激活函数,如ReLU(Rectified Linear Unit)来引入非线性。整个过程使得神经网络能够学习更复杂的模式和特征。

1.4 梯度下降

梯度下降是一种用于最小化损失函数的优化算法,特别是在机器学习和深度学习中广泛应用。其核心思想是通过迭代调整模型参数,使得损失函数的值逐渐减小,达到找到最优参数的目的。

以下是梯度下降的基本步骤:

- 初始化参数: 随机或使用一些启发式方法初始化模型的参数,如权重和偏置。

- 计算梯度: 计算损失函数关于模型参数的梯度(导数)。梯度表示了损失函数在参数空间中的变化方向,指向最快的增长方向。

- 更新参数: 沿着梯度的反方向调整模型参数,从而减小损失函数的值。这一步通过学习率(learning rate)来控制每次参数更新的步长。

- 重复迭代: 重复步骤2和步骤3,直到满足停止条件,如达到预定的迭代次数或损失函数变化不大。

梯度下降有不同的变种,其中包括批量梯度下降(Batch Gradient Descent)、随机梯度下降(Stochastic Gradient Descent)和小批量梯度下降(Mini-batch Gradient Descent)。这些变种主要区别在于每次迭代更新时使用的样本数量。

梯度下降的成功依赖于选择合适的学习率和适当的停止条件,以及对损失函数的充分理解。这一优化算法在训练神经网络等复杂模型时被广泛使用。

1.5 激活函数

激活函数是神经网络中的一种非线性映射,它将输入信号转换为输出信号。激活函数的引入使得神经网络能够学习和表示更为复杂的模式和特征,从而提高网络的表达能力。以下是一些常见的激活函数:

- Sigmoid 函数:

σ

(

x

)

=

1

1

e

−

x

\sigma(x) = \frac{1}{1 + e^{-x}}

σ(x)=1+e−x1,将输入映射到0到1之间,常用于二分类问题。但在深度神经网络中,它可能导致梯度消失问题,因此在隐藏层中使用较少。

2. Hyperbolic Tangent 函数(tanh):

tanh

(

x

)

=

e

2

x

−

1

e

2

x

1

\tanh(x) = \frac{e^{2x} - 1}{e^{2x} + 1}

tanh(x)=e2x+1e2x−1,类似于 Sigmoid 函数,将输入映射到-1到1之间。它在一些情况下相对于 Sigmoid 函数更有优势,但同样存在梯度消失问题。

3. Rectified Linear Unit 函数(ReLU):

R

e

L

U

(

x

)

=

max

(

0

,

x

)

ReLU(x) = \max(0, x)

ReLU(x)=max(0,x),在输入大于零时输出输入值,否则输出零。ReLU 是目前最常用的激活函数之一,因为它简单、计算效率高,且在许多情况下表现良好。

4. Leaky ReLU 函数:

L

e

a

k

y

R

e

L

U

(

x

)

=

max

(

α

x

,

x

)

LeakyReLU(x) = \max(\alpha x, x)

LeakyReLU(x)=max(αx,x),其中 (

α

\alpha

α) 是小于1的小常数,解决了 ReLU 函数中负数部分导致的神经元死亡问题。

5. Softmax 函数: 用于多类别分类问题,将一组数值转换为表示概率分布的形式。

6. Swish 函数:

S

w

i

s

h

(

x

)

=

x

⋅

σ

(

x

)

Swish(x) = x \cdot \sigma(x)

Swish(x)=x⋅σ(x),其中 (

σ

(

x

)

\sigma(x)

σ(x)) 是 Sigmoid 函数。Swish 是一种类似于 ReLU 的激活函数,具有更平滑的曲线,有时在某些情况下表现较好。

选择适当的激活函数取决于问题的性质和神经网络的结构。ReLU 及其变种是目前常用的选择,但在某些场景下其他激活函数也可能更合适。

1.5.1 Softmax函数

Softmax 函数是一种常用的激活函数,特别适用于多类别分类问题。它将一组数值转换为表示概率分布的形式,使得每个类别的概率都在0到1之间,并且所有类别的概率之和为1。

Softmax 函数的定义如下,对于给定的输入向量 ( z ),Softmax 函数的输出 (

σ

(

z

)

\sigma(z)

σ(z) ) 的每个元素 (

σ

(

z

)

i

\sigma(z)_i

σ(z)i) 计算如下:

σ

(

z

)

i

=

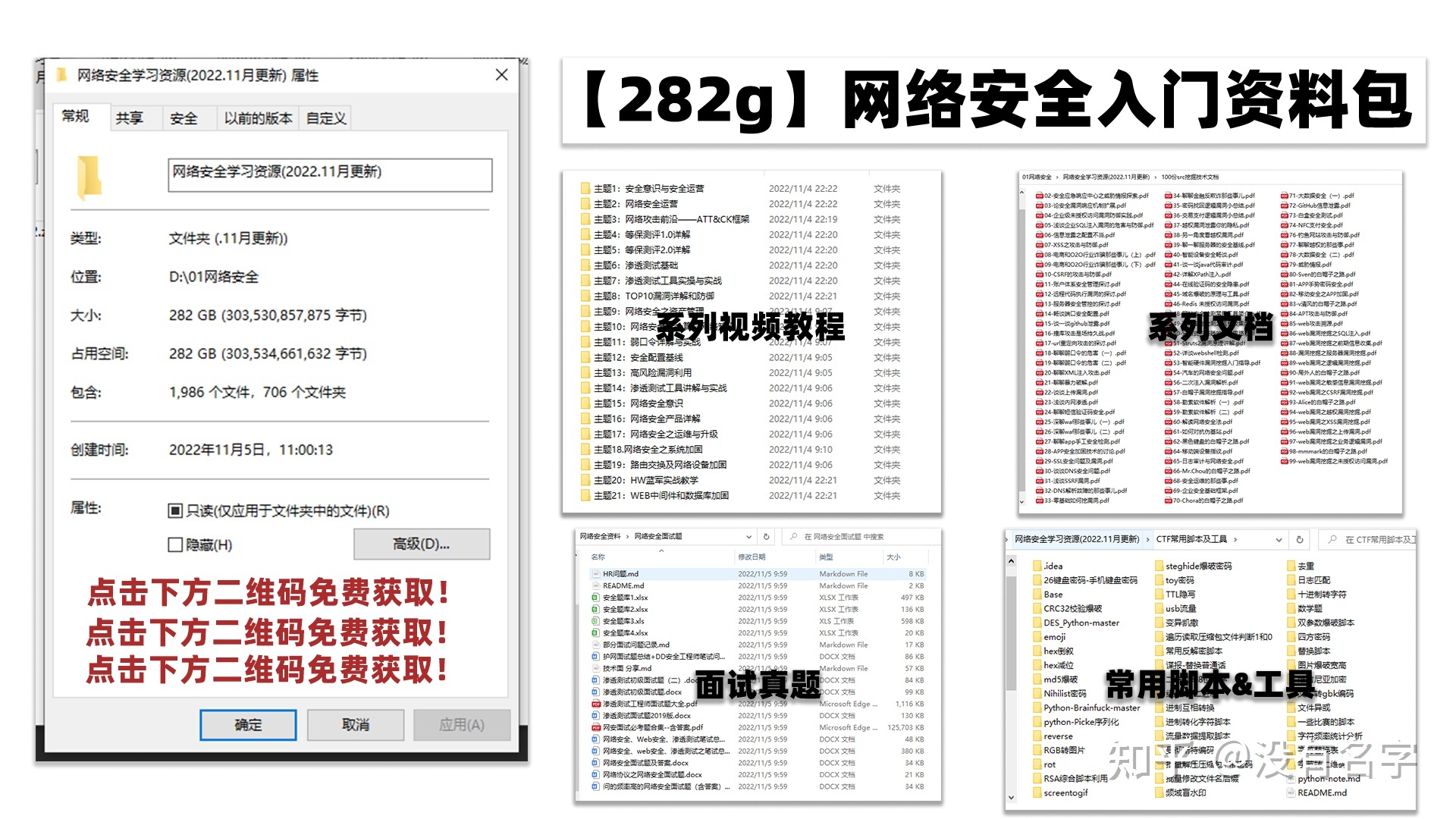

本人从事网路安全工作12年,曾在2个大厂工作过,安全服务、售后服务、售前、攻防比赛、安全讲师、销售经理等职位都做过,对这个行业了解比较全面。

最近遍览了各种网络安全类的文章,内容参差不齐,其中不伐有大佬倾力教学,也有各种不良机构浑水摸鱼,在收到几条私信,发现大家对一套完整的系统的网络安全从学习路线到学习资料,甚至是工具有着不小的需求。

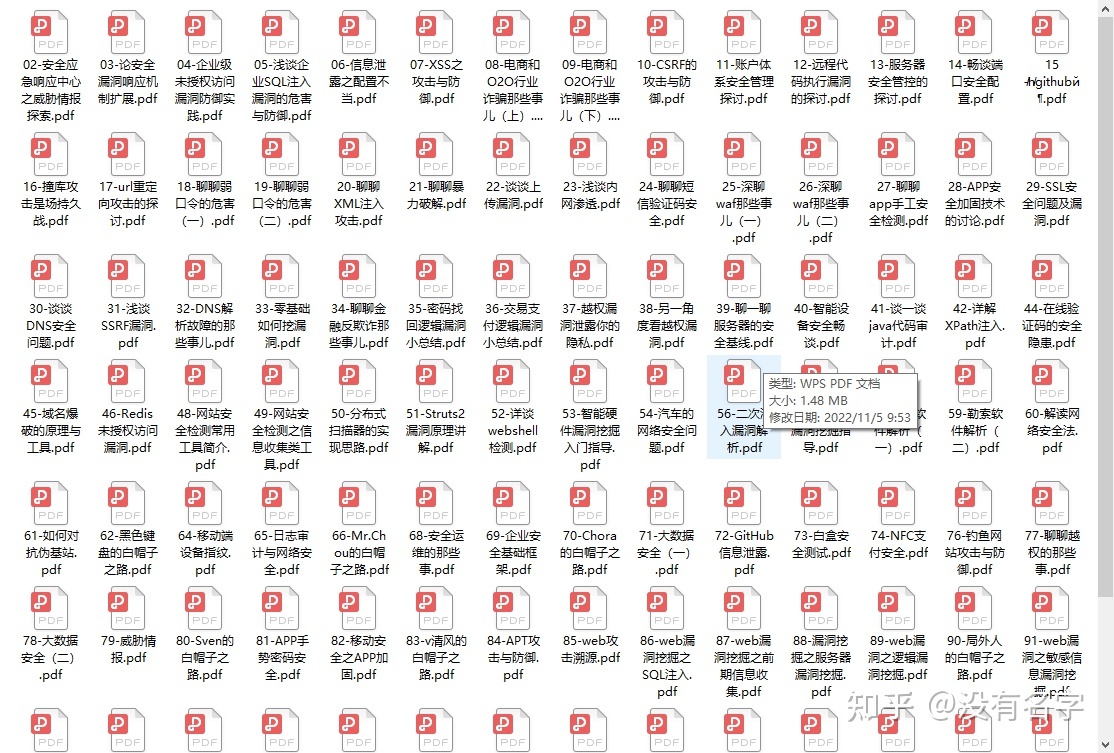

最后,我将这部分内容融会贯通成了一套282G的网络安全资料包,所有类目条理清晰,知识点层层递进,需要的小伙伴可以点击下方小卡片领取哦!下面就开始进入正题,如何从一个萌新一步一步进入网络安全行业。

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

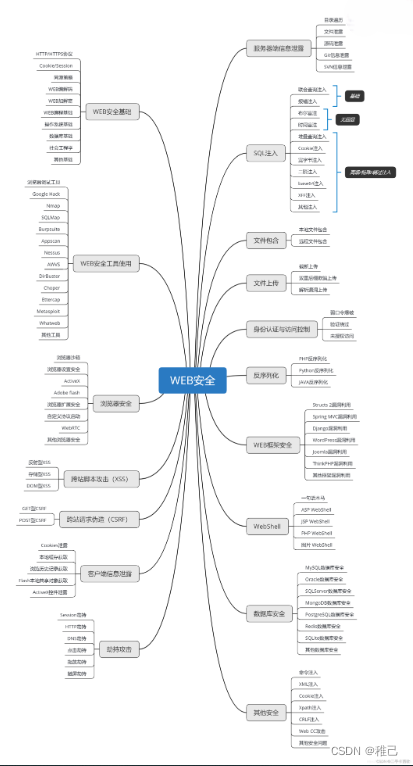

学习路线图

其中最为瞩目也是最为基础的就是网络安全学习路线图,这里我给大家分享一份打磨了3个月,已经更新到4.0版本的网络安全学习路线图。

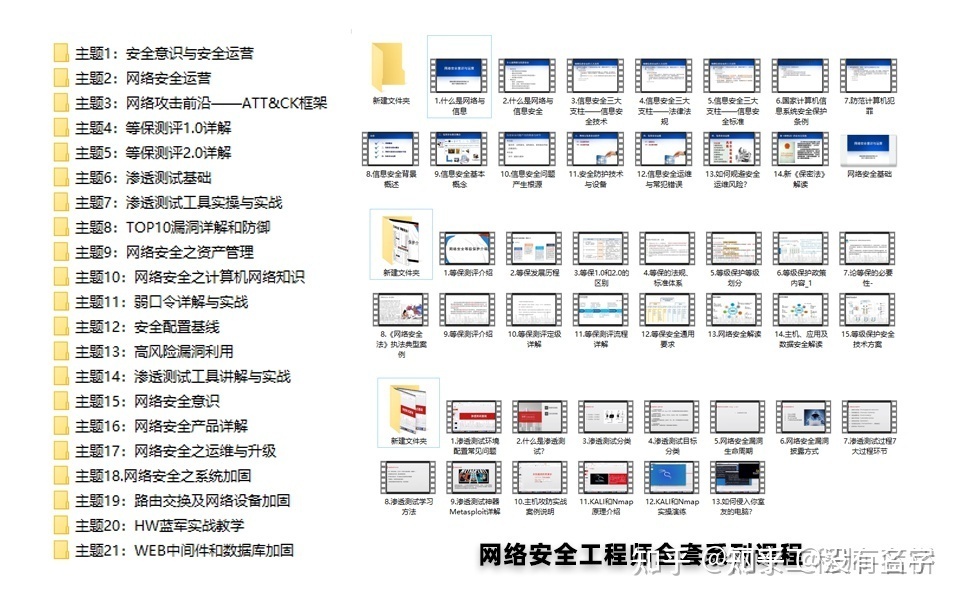

相比起繁琐的文字,还是生动的视频教程更加适合零基础的同学们学习,这里也是整理了一份与上述学习路线一一对应的网络安全视频教程。

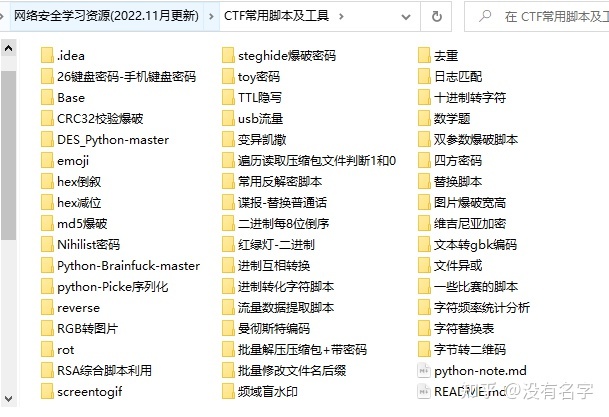

网络安全工具箱

当然,当你入门之后,仅仅是视频教程已经不能满足你的需求了,你肯定需要学习各种工具的使用以及大量的实战项目,这里也分享一份我自己整理的网络安全入门工具以及使用教程和实战。

项目实战

最后就是项目实战,这里带来的是SRC资料&HW资料,毕竟实战是检验真理的唯一标准嘛~

面试题

归根结底,我们的最终目的都是为了就业,所以这份结合了多位朋友的亲身经验打磨的面试题合集你绝对不能错过!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?