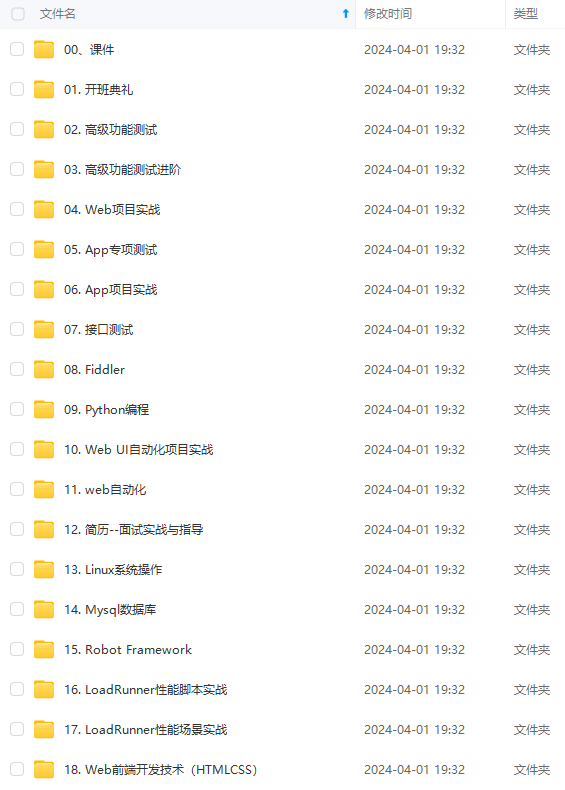

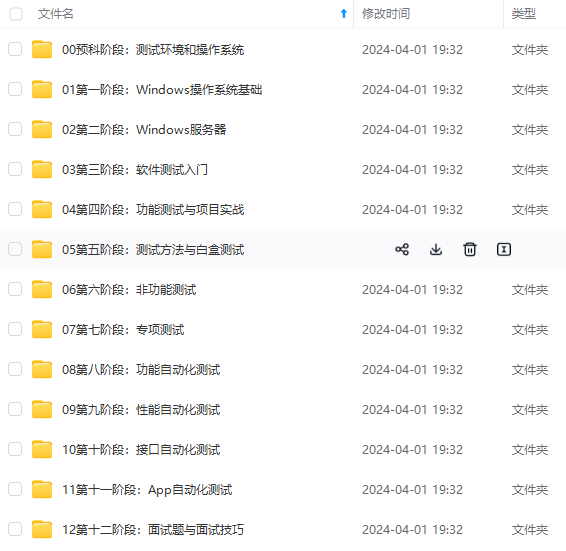

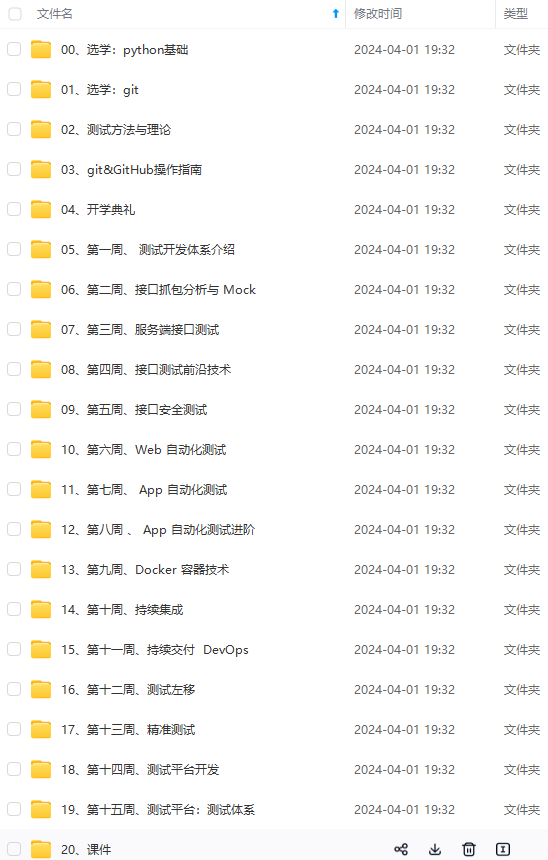

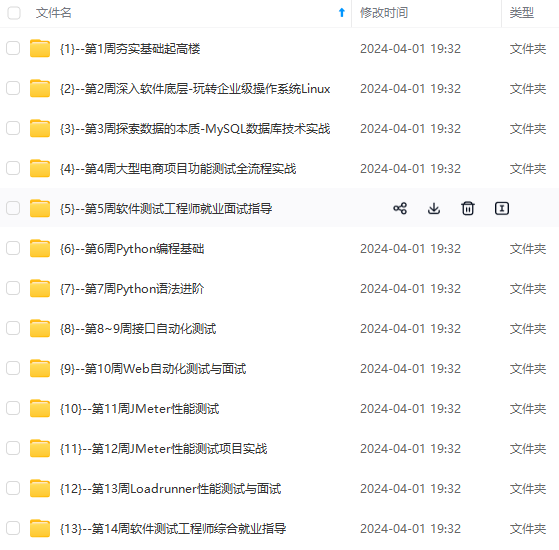

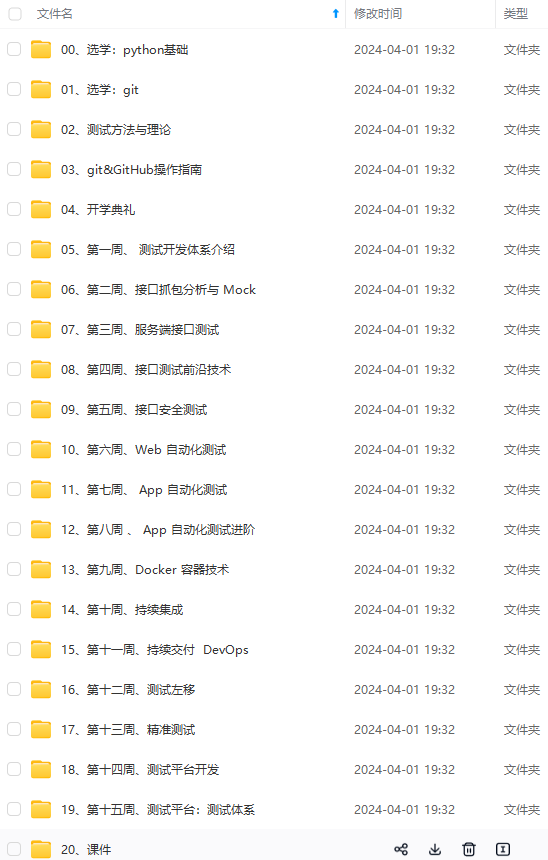

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

文章目录

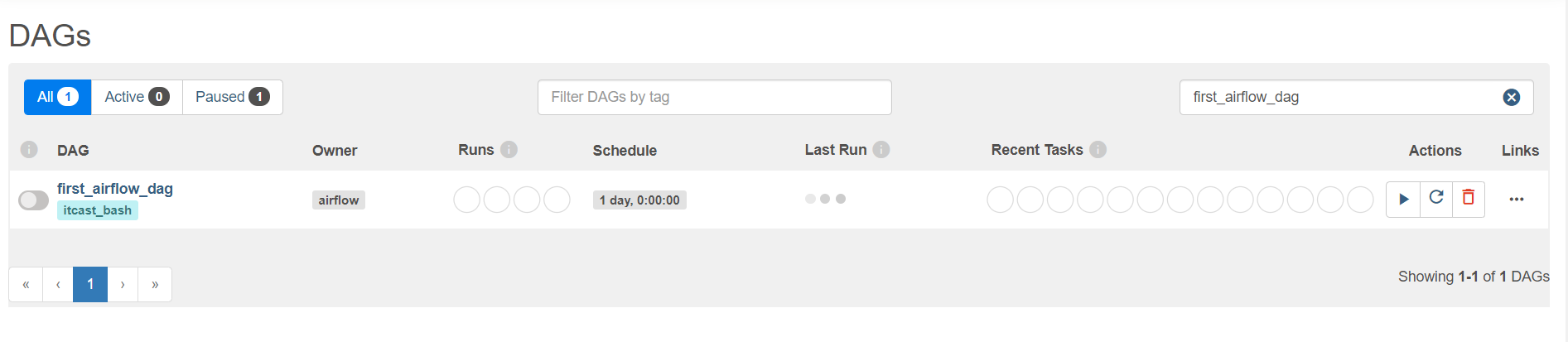

知识点07:Shell调度测试

-

目标:实现Shell命令的调度测试

-

实施

-

需求:使用BashOperator调度执行一条Linux命令

-

代码

- 创建

# 默认的Airflow自动检测工作流程序的文件的目录 mkdir -p /root/airflow/dags cd /root/airflow/dags vim first_bash_operator.py- 开发

# import from airflow import DAG from airflow.operators.bash import BashOperator from airflow.utils.dates import days_ago from datetime import timedelta # define args default_args = { 'owner': 'airflow', 'email': ['airflow@example.com'], 'email\_on\_failure': True, 'email\_on\_retry': True, 'retries': 1, 'retry\_delay': timedelta(minutes=1), } # define dag dag = DAG( 'first\_airflow\_dag', default_args=default_args, description='first airflow task DAG', schedule_interval=timedelta(days=1), start_date=days_ago(1), tags=['itcast\_bash'], ) # define task1 run_bash_task = BashOperator( task_id='first\_bashoperator\_task', bash_command='echo "hello airflow"', dag=dag, ) # run the task run_bash_task- 工作中使用bashOperator ``` bash_command='sh xxxx.sh' ``` - xxxx.sh:根据需求 * Linux命令 * hive -f * spark-sql -f * spark-submit python | jar- 提交

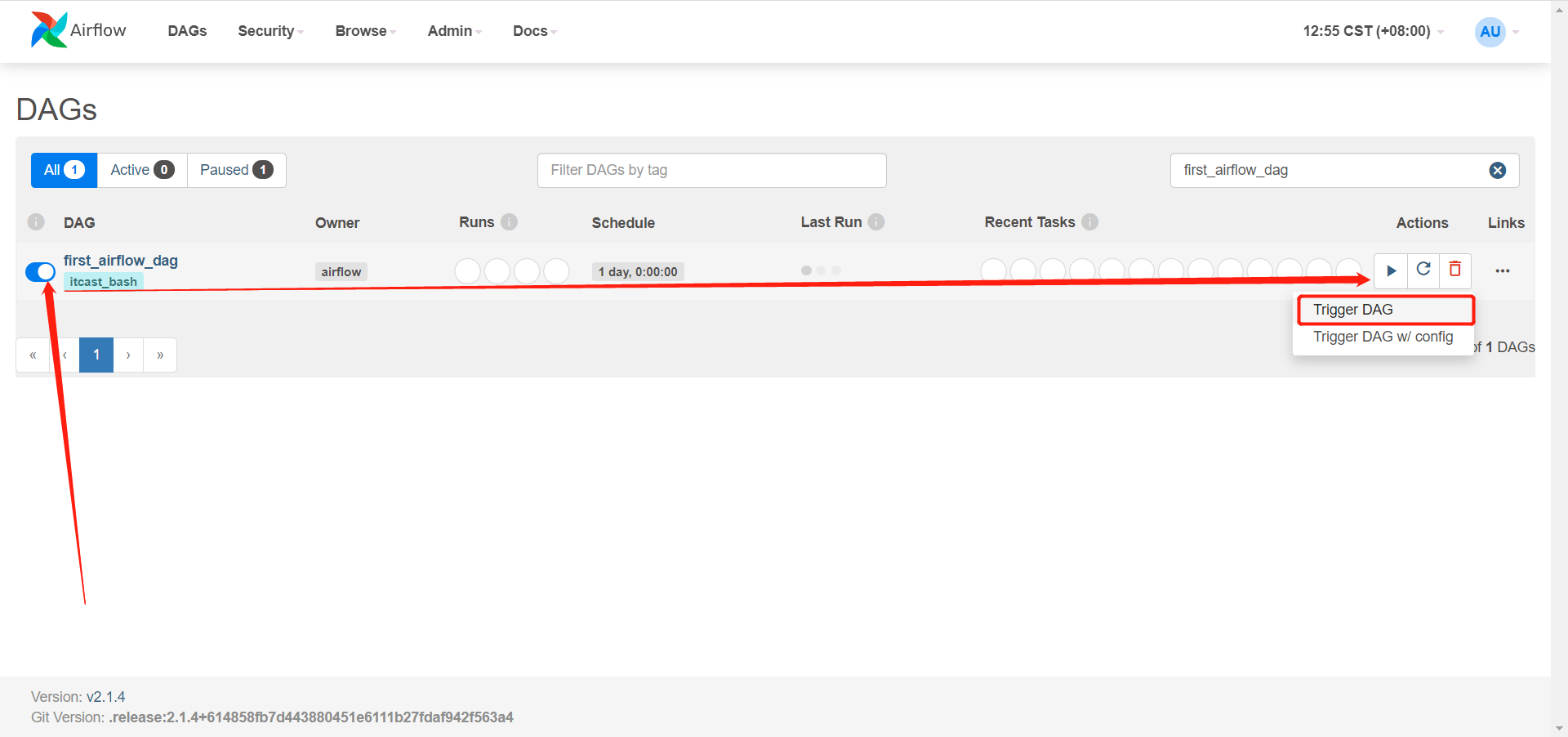

python first_bash_operator.py- 查看

- 执行

-

-

小结

- 实现Shell命令的调度测试

知识点08:依赖调度测试

-

目标:实现AirFlow的依赖调度测试

-

实施

-

需求:使用BashOperator调度执行多个Task,并构建依赖关系

-

代码

- 创建

cd /root/airflow/dags vim second_bash_operator.py- 开发

# import from datetime import timedelta from airflow import DAG from airflow.operators.bash import BashOperator from airflow.utils.dates import days_ago # define args default_args = { 'owner': 'airflow', 'email': ['airflow@example.com'], 'email\_on\_failure': True, 'email\_on\_retry': True, 'retries': 1, 'retry\_delay': timedelta(minutes=1), } # define dag dag = DAG( 'second\_airflow\_dag', default_args=default_args, description='first airflow task DAG', schedule_interval=timedelta(days=1), start_date=days_ago(1), tags=['itcast\_bash'], ) # define task1 say_hello_task = BashOperator( task_id='say\_hello\_task', bash_command='echo "start task"', dag=dag, ) # define task2 print_date_format_task2 = BashOperator( task_id='print\_date\_format\_task2', bash_command='date +"%F %T"', dag=dag, ) # define task3 print_date_format_task3 = BashOperator( task_id='print\_date\_format\_task3', bash_command='date +"%F %T"', dag=dag, ) # define task4 end_task4 = BashOperator( task_id='end\_task', bash_command='echo "end task"', dag=dag, ) say_hello_task >> [print_date_format_task2,print_date_format_task3] >> end_task4 -

提交

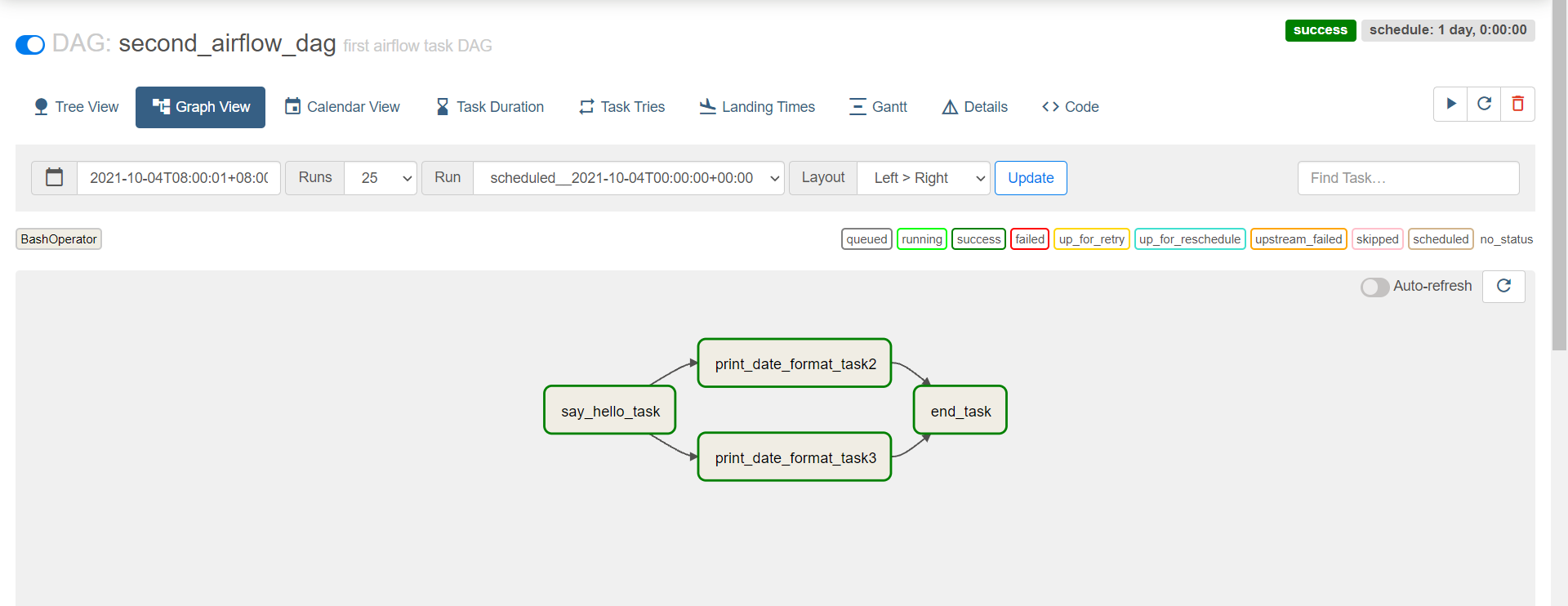

python second_bash_operator.py- 查看

-

-

小结

- 实现AirFlow的依赖调度测试

知识点09:Python调度测试

-

目标:实现Python代码的调度测试

-

实施

-

需求:调度Python代码Task的运行

-

代码

- 创建

cd /root/airflow/dags vim python_etl_airflow.py- 开发

# import package from airflow import DAG from airflow.operators.python import PythonOperator from airflow.utils.dates import days_ago import json # define args default_args = { 'owner': 'airflow', } # define the dag with DAG( 'python\_etl\_dag', default_args=default_args, description='DATA ETL DAG', schedule_interval=None, start_date=days_ago(2), tags=['itcast'], ) as dag: # function1 def extract(\*\*kwargs): ti = kwargs['ti'] data_string = '{"1001": 301.27, "1002": 433.21, "1003": 502.22, "1004": 606.65, "1005": 777.03}' ti.xcom_push('order\_data', data_string) # function2 def transform(\*\*kwargs): ti = kwargs['ti'] extract_data_string = ti.xcom_pull(task_ids='extract', key='order\_data') order_data = json.loads(extract_data_string) total_order_value = 0 for value in order_data.values(): total_order_value += value total_value = {"total\_order\_value": total_order_value} total_value_json_string = json.dumps(total_value) ti.xcom_push('total\_order\_value', total_value_json_string) # function3 def load(\*\*kwargs): ti = kwargs['ti'] total_value_string = ti.xcom_pull(task_ids='transform', key='total\_order\_value') total_order_value = json.loads(total_value_string) print(total_order_value) # task1 extract_task = PythonOperator( task_id='extract', python_callable=extract, ) extract_task.doc_md = """\ #### Extract task A simple Extract task to get data ready for the rest of the data pipeline. In this case, getting data is simulated by reading from a hardcoded JSON string. This data is then put into xcom, so that it can be processed by the next task. """ # task2 transform_task = PythonOperator( task_id='transform', python_callable=transform, ) transform_task.doc_md = """\ #### Transform task A simple Transform task which takes in the collection of order data from xcom and computes the total order value. This computed value is then put into xcom, so that it can be processed by the next task. """

-

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

存中…(img-IOXkjwNK-1715078051222)]

[外链图片转存中…(img-6uDeAuqU-1715078051222)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

551

551

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?