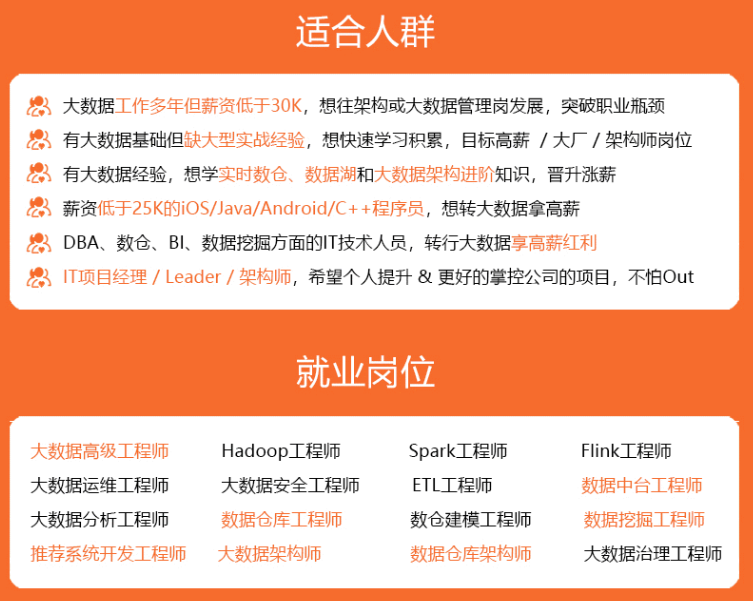

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

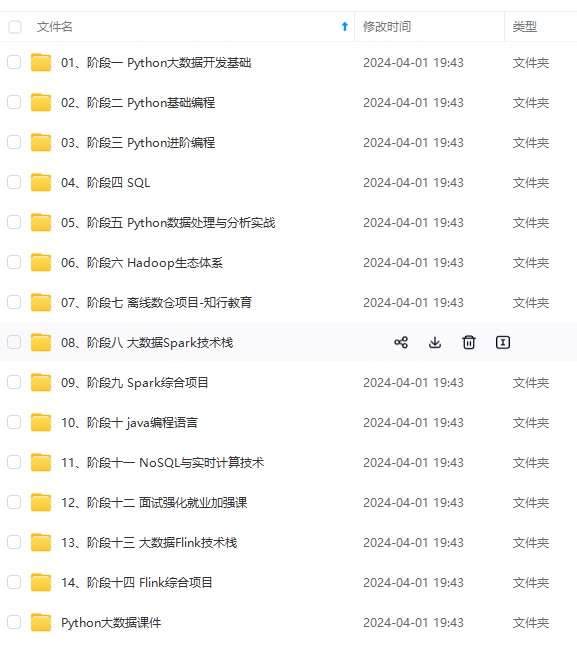

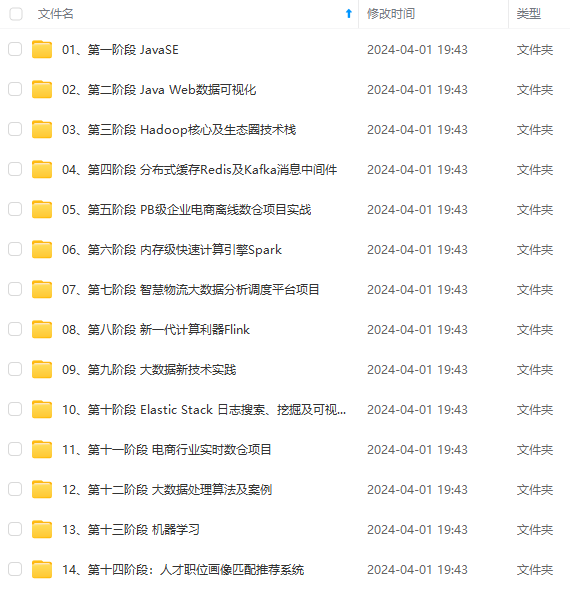

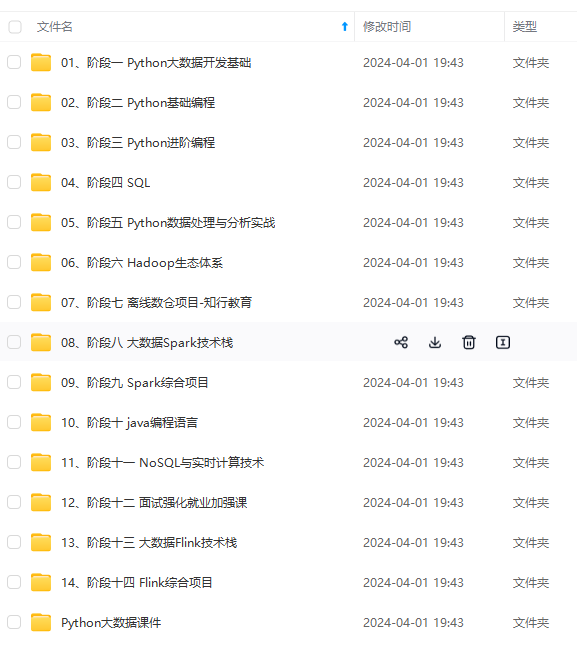

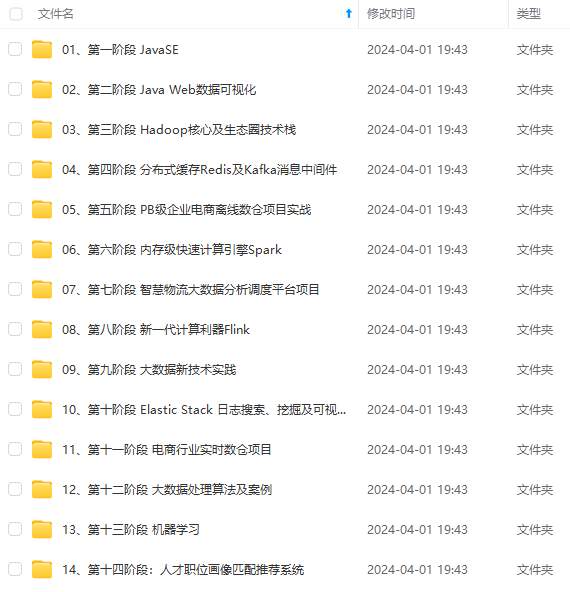

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

6.1通过读取文件生成

由外部存储系统的数据集创建,包括本地的文件系统,还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase等

scala> val file = sc.textFile("/spark/hello.txt")

6.2通过并行化的方式创建RDD

由一个已经存在的Scala集合创建

scala> val array = Array(1,2,3,4,5)

array: Array[Int] = Array(1, 2, 3, 4, 5)

scala> val rdd = sc.parallelize(array)

rdd: org.apache.spark.rdd.RDD[Int] = ParallelCollectionRDD[27] at parallelize at <console>:26

6.3其他方式

读取数据库等等其他的操作。也可以生成RDD。

RDD可以通过其他的RDD转换而来的。

七、RDD编程API

Spark支持两个类型(算子)操作:Transformation和Action

7.1Transformation

主要做的是就是将一个已有的RDD生成另外一个RDD。Transformation具有lazy特性(延迟加载)。Transformation算子的代码不会真正被执行。只有当我们的程序里面遇到一个action算子的时候,代码才会真正的被执行。这种设计让Spark更加有效率地运行。

常用的Transformation:

| 转换 | 含义 |

|---|---|

| map(func) | 返回一个新的RDD,该RDD由每一个输入元素经过func函数转换后组成 |

| filter(func) | 返回一个新的RDD,该RDD由经过func函数计算后返回值为true的输入元素组成 |

| flatMap(func) | 类似于map,但是每一个输入元素可以被映射为0或多个输出元素(所以func应该返回一个序列,而不是单一元素) |

| union(otherDataset) | 对源RDD和参数RDD求并集后返回一个新的RDD |

| groupByKey([numTasks]) | 在一个(K,V)的RDD上调用,返回一个(K, Iterator[V])的RD |

| sortByKey | 在一个(K,V)的RDD上调用,K必须实现Ordered接口,返回一个按照key进行排序的(K,V)的RDD |

| 官方很全面,这里只做了解。 |

7.2Action

触发代码的运行,我们一段spark代码里边至少需要有一个action操作

常用的Action:

| 动作 | 含义 |

|---|---|

| reduce(func) | 通过func函数聚集RDD中的所有元素,这个功能必须是课交换且可并联的 |

| collect() | 在驱动程序中,以数组的形式返回数据集的所有元素 |

| count() | 返回RDD的元素个数 |

| first() | 返回RDD的第一个元素(类似于take(1)) |

| foreach(func) | 在数据集的每一个元素上,运行函数func进行更新。 |

| 此处只是列举几个,更为全面的去查看官方文档 |

7.3Spark WordCount代码编写

使用maven进行项目搭建

查看官方文档,导入2个依赖包

详细代码-scala

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object SparkWordCountWithScala {

def main(args: Array[String]): Unit = {

val conf = new SparkConf()

/\*\*

\* 如果这个参数不设置,默认认为你运行的是集群模式

\* 如果设置成local代表运行的是local模式

\*/

conf.setMaster("local")

//设置任务名

conf.setAppName("WordCount")

//创建SparkCore的程序入口

val sc = new SparkContext(conf)

//读取文件 生成RDD

val file: RDD[String] = sc.textFile("E:\\hello.txt")

//把每一行数据按照,分割

val word: RDD[String] = file.flatMap(_.split(","))

//让每一个单词都出现一次

val wordOne: RDD[(String, Int)] = word.map((_,1))

//单词计数

val wordCount: RDD[(String, Int)] = wordOne.reduceByKey(_+_)

//按照单词出现的次数 降序排序

val sortRdd: RDD[(String, Int)] = wordCount.sortBy(tuple => tuple._2,false)

//将最终的结果进行保存

sortRdd.saveAsTextFile("E:\\result")

sc.stop()

}

详细代码-jdk8

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object SparkWordCountWithScala {

def main(args: Array[String]): Unit = {

val conf = new SparkConf()

/\*\*

\* 如果这个参数不设置,默认认为你运行的是集群模式

\* 如果设置成local代表运行的是local模式

\*/

conf.setMaster("local")

//设置任务名

conf.setAppName("WordCount")

//创建SparkCore的程序入口

val sc = new SparkContext(conf)

//读取文件 生成RDD

val file: RDD[String] = sc.textFile("E:\\hello.txt")

//把每一行数据按照,分割

val word: RDD[String] = file.flatMap(_.split(","))

//让每一个单词都出现一次

val wordOne: RDD[(String, Int)] = word.map((_,1))

//单词计数

val wordCount: RDD[(String, Int)] = wordOne.reduceByKey(_+_)

//按照单词出现的次数 降序排序

val sortRdd: RDD[(String, Int)] = wordCount.sortBy(tuple => tuple._2,false)

//将最终的结果进行保存

sortRdd.saveAsTextFile("E:\\result")

sc.stop()

}

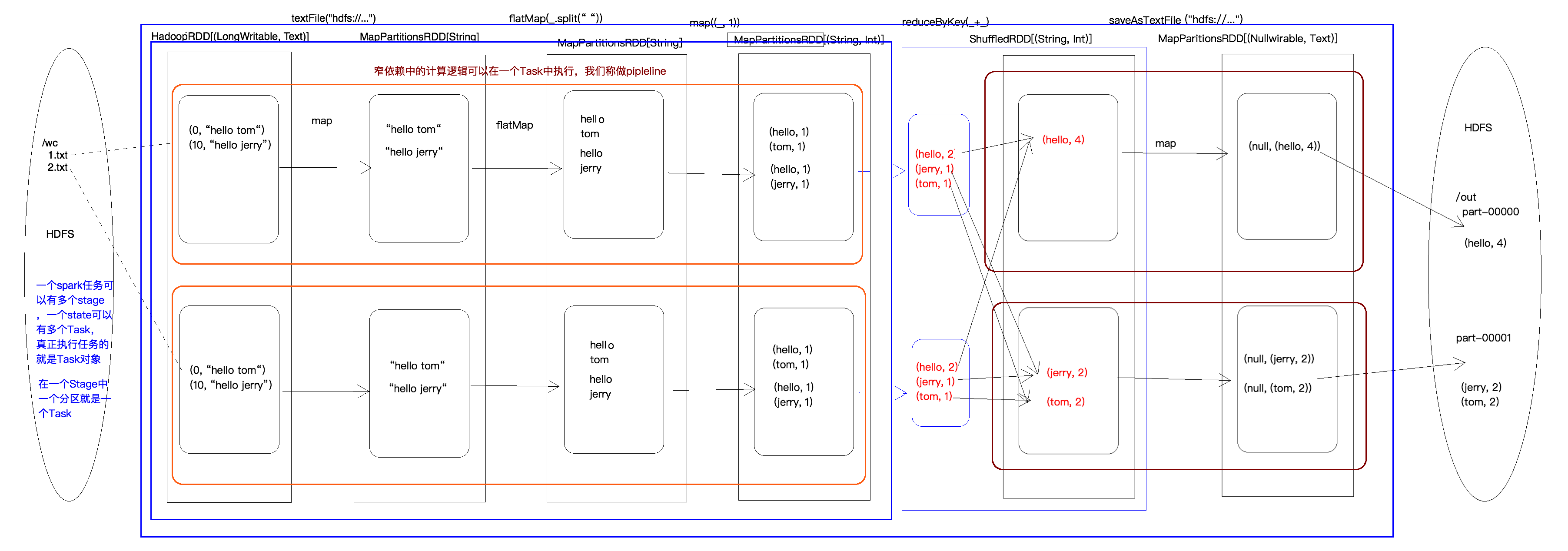

WordCount执行过程图

- 在统计词数的程序中,首先读取数据,在执行两次map操作,和一个reduce操作,最后保存结果,在这个过程中,一共生成了6个RDD

- 在读取数据的时候,生成了两个RDD,经过两次map,又生成了两个RDD,在reduce时生成了一个RDD,在执行saveAsTextFile时又生成了一个RDD

- reduce时的过程也称为shuffle,一共有两个步骤,第一步是进行局部聚合,第二步是进行全局聚合

- 一个分区对应一个task(在同一个stage),一个分区对应的task只能在一台机器上(在executor中),一台机器上可以有多个分区对应的task

- 一共有两个阶段(stage),在shuffle时是一个分水岭,shuffle前的task称为shufflemaptask,shuffle后的task成为resulttask.所以,WordCount执行过程中,一共生成了2种task,4个task(因为本例中有两个分区)。

八、RDD的宽依赖和窄依赖

8.1RDD依赖关系的本质内幕

由于RDD是粗粒度的操作数据集,每个Transformation操作都会生成一个新的RDD,所以RDD之间就会形成类似流水线的前后依赖关系;RDD和它依赖的父RDD的关系有两种不同的类型,即窄依赖和宽依赖。

**窄依赖:**是指每个父RDD的一个Partition最多被子RDD的一个Partition所使用,例如map,filter,union等操作都会产生窄依赖;(独生子女)

**宽依赖:**是指一个父RDD的Partition会被多个子RDD的Partition所使用,例如groupByKey、reduceByKey、sortByKey等操作都会产生宽依赖。(超生)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

4716

4716

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?