网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

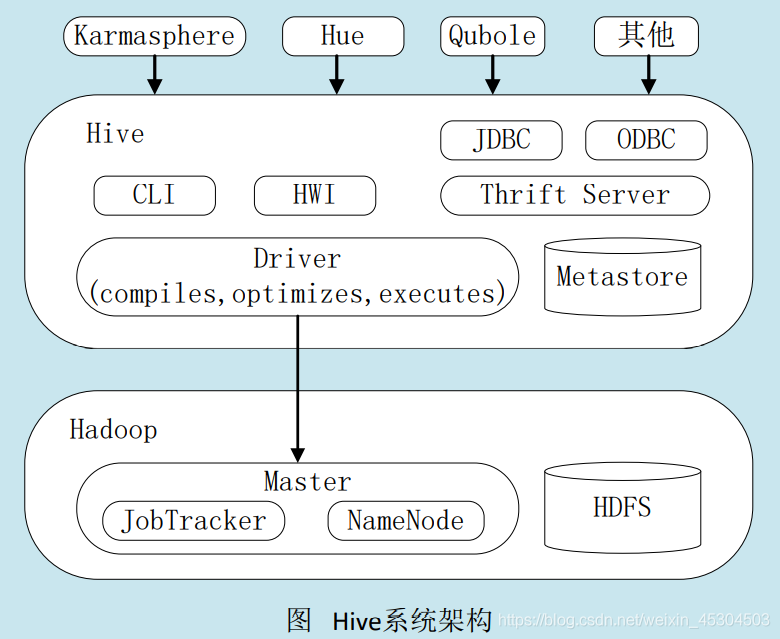

3. Hive系统架构

- 用户接口模块。包括CLI、HWI、JDBC、ODBC、Thrift Server

- 驱动模块(Driver)。包括编译器、优化器、执行器等,负责把HiveQL语句转换成一系列MapReduce作业

- 元数据存储模块(Metastore)。是一个独立的关系型数据库(自带derby数据库,或MySQL数据库)

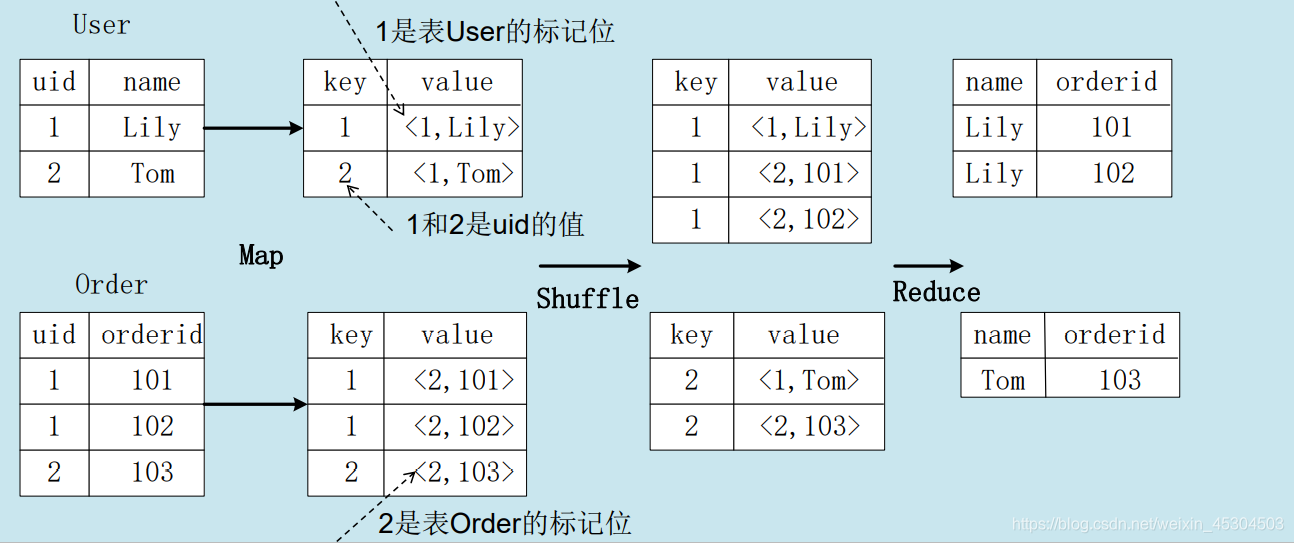

4. HQL转成MapReduce作业的原理

4.1 join的实现原理

select name, orderid from user join order on user.uid=order.uid;

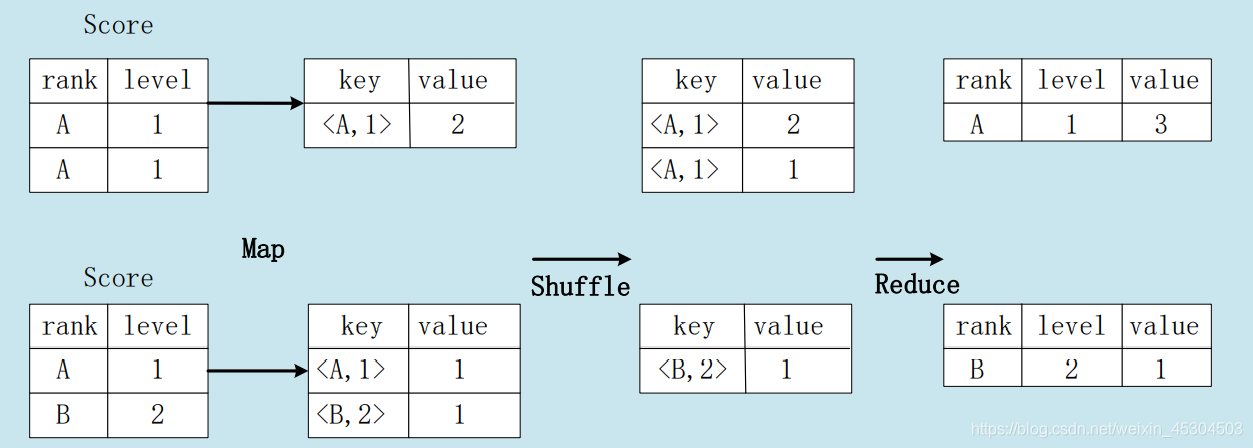

4.2 group by的实现原理

存在一个分组(Group By)操作,其功能是把表Score的不同片段按照rank和level的组合值进行合并,计算不同rank和level的组合值分别有几条记录:

select rank, level ,count(\*) as value from score group by rank, level

5. 实验练习

5.1 环境配置

5.1.1 HIVE

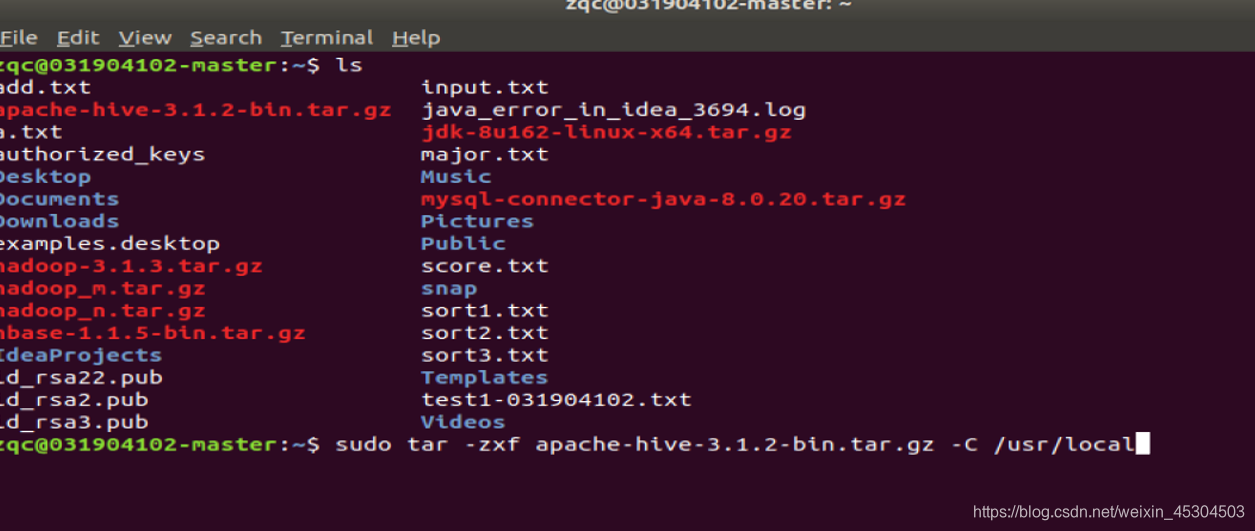

将Hive解压到/usr/local中

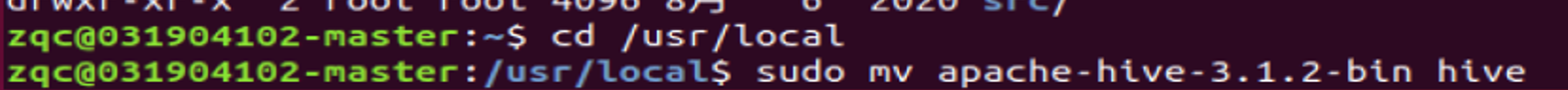

更改名字

更改hive目录所有者和所在用户组

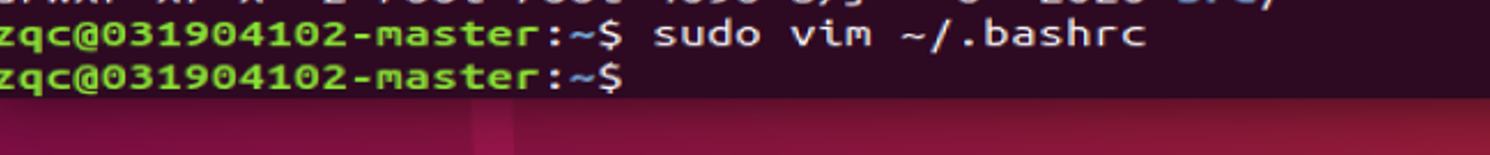

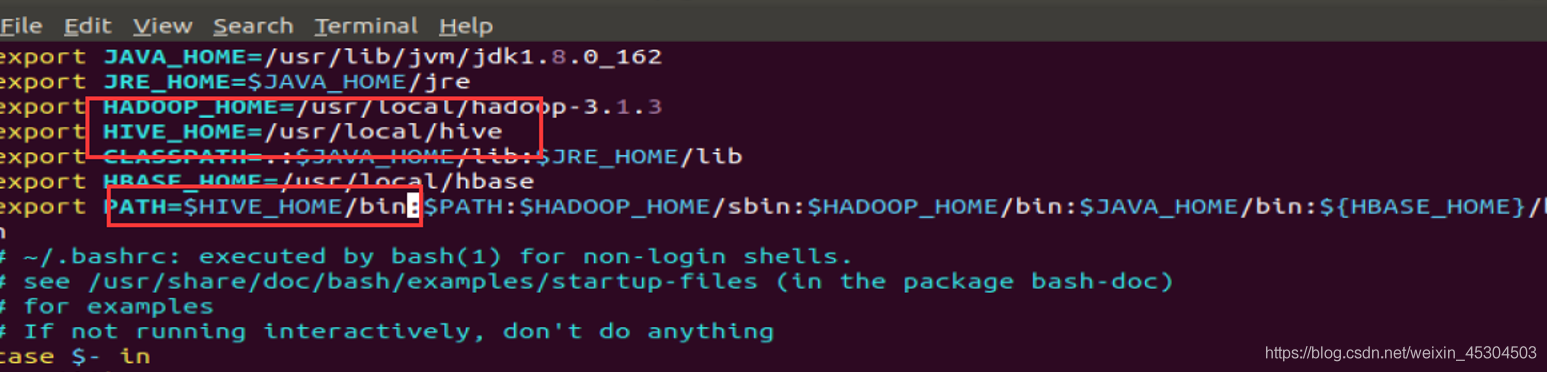

环境配置

使环境生效

5.1.2 MYSQL

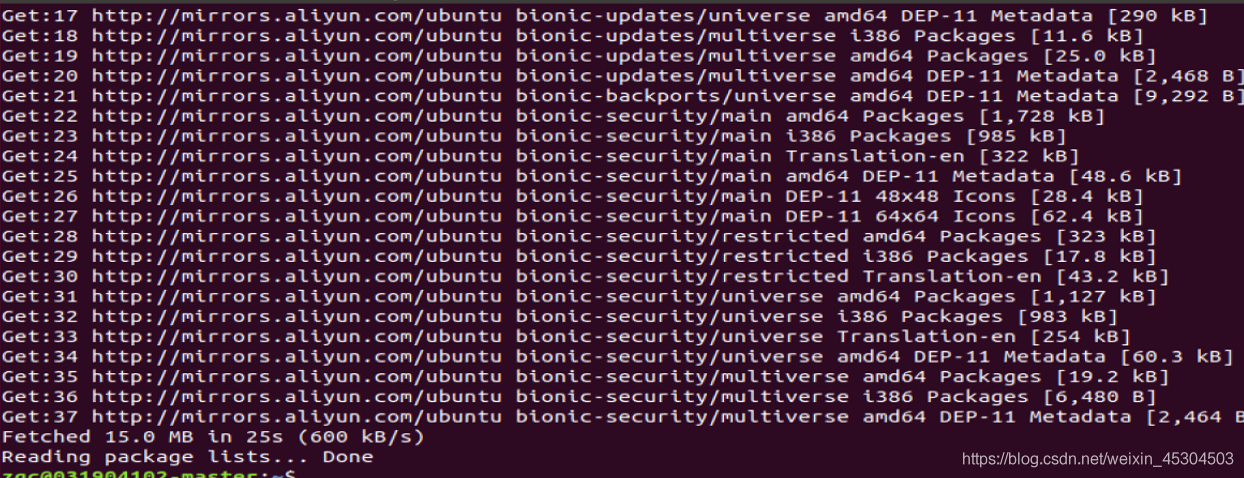

更新软件源

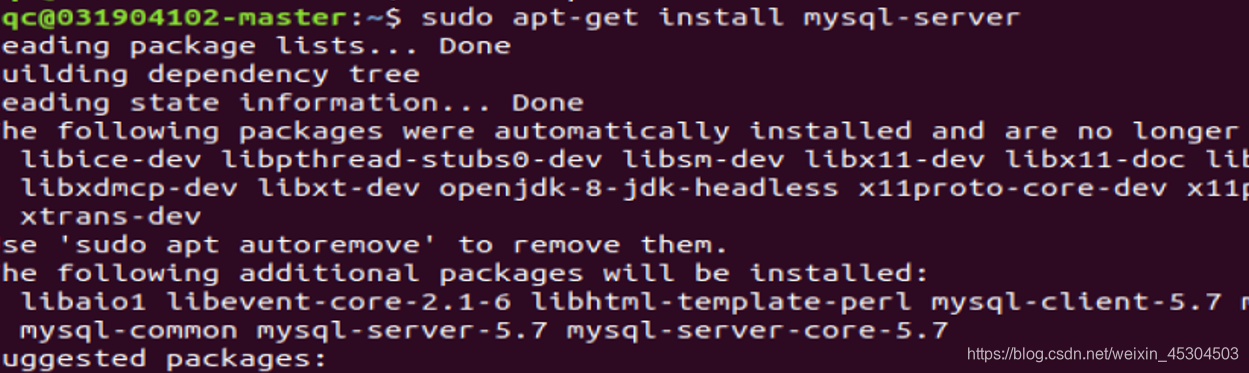

安装mysql-server

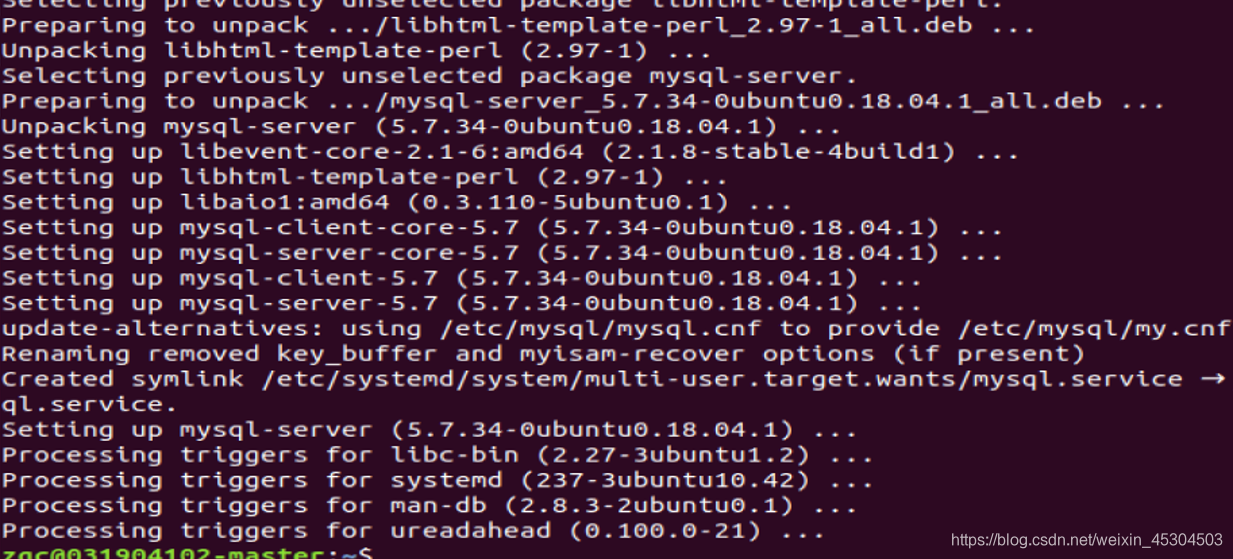

安装成功

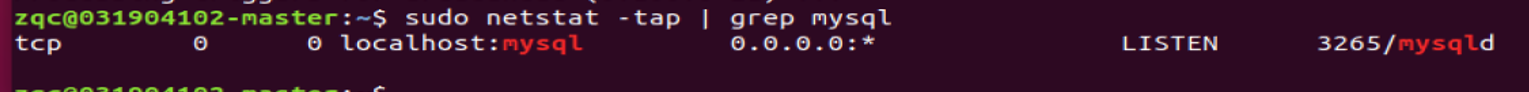

确定mysql服务是否打开

启动和关闭mysql服务

- 关闭

service mysql stop

- 启动

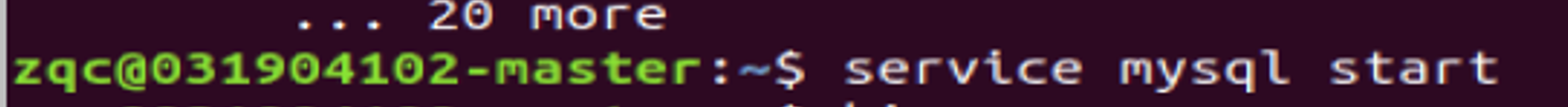

service mysql start

5.1.3 配置MySql为hive元数据存储数据库

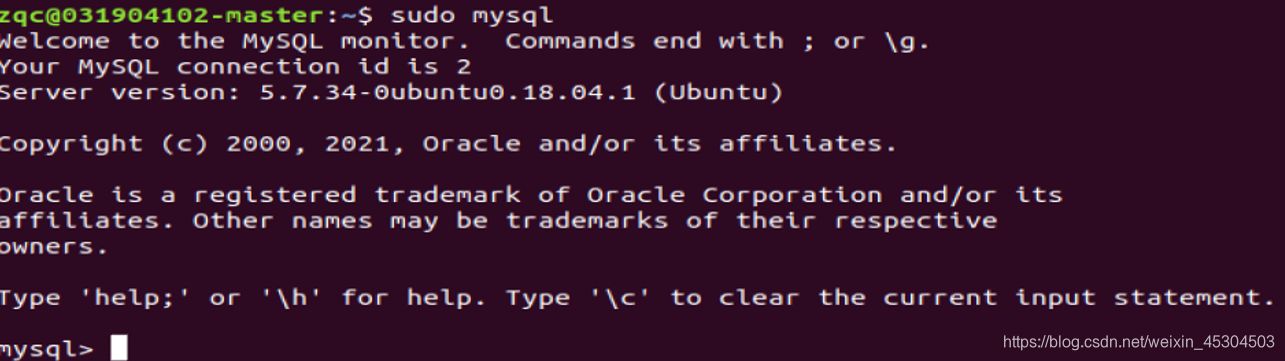

进入mysql shell

sudo mysql 或 sudo mysql –u root –p 命令,回车后会提示输入密码,前者输入当前系统用户密码,后者是输入 mysql root 用户密码一般为空,回车进入 mysql 命令行。这里 root是 mysql 安装时默认创建的用户,不是 Ubuntu 系统的 root 用户。

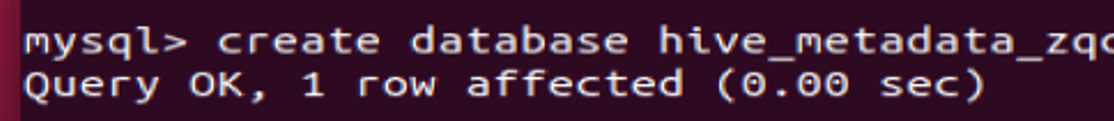

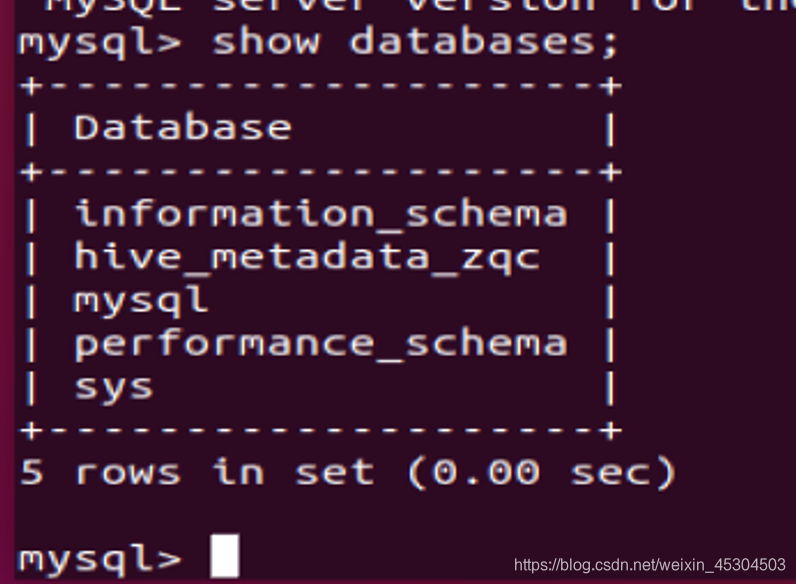

新建一个数据库用来保存hive元数据(hive_metadata_zqc)

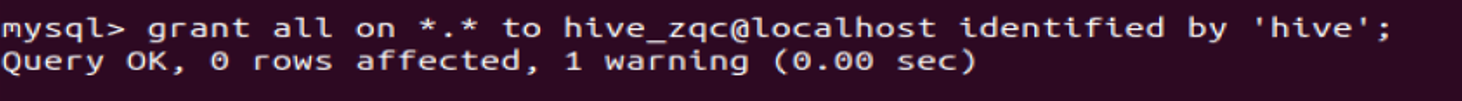

- 配置mysql允许hive接入

将所有数据库的所有表的所有权限赋给新建的hive_zqc用户,hive_zqc、'hive’是后续操作中要对 hive-site.xml 文件配置的连接到 MySQL 数据库的用户名、密码,由你自己定义;

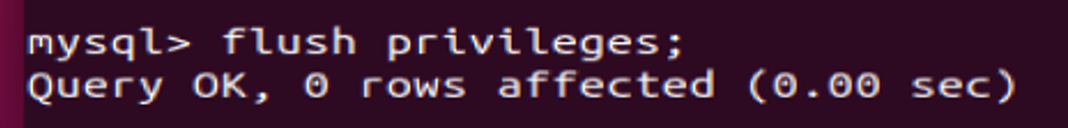

刷新mysql系统权限关系表

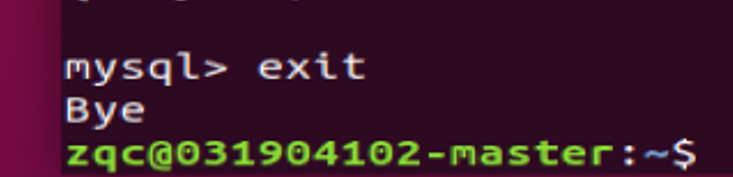

exit 退出

2. 配置hive

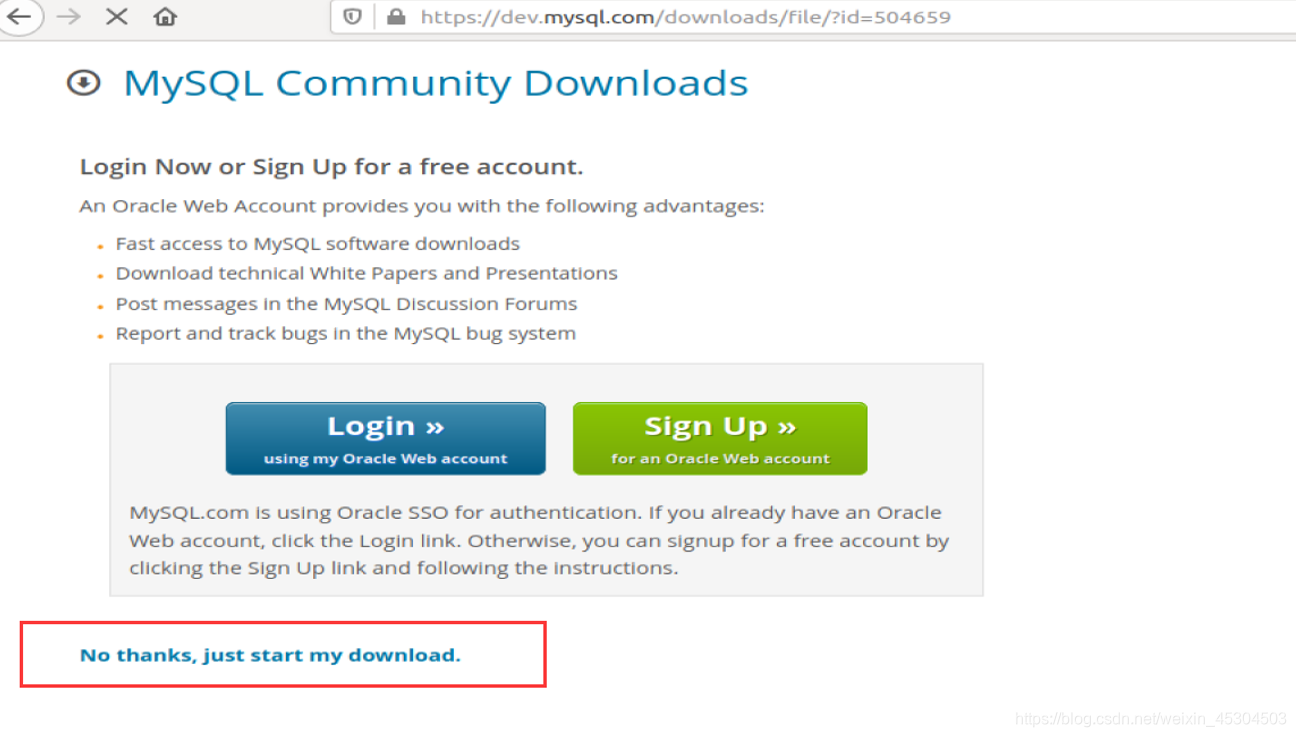

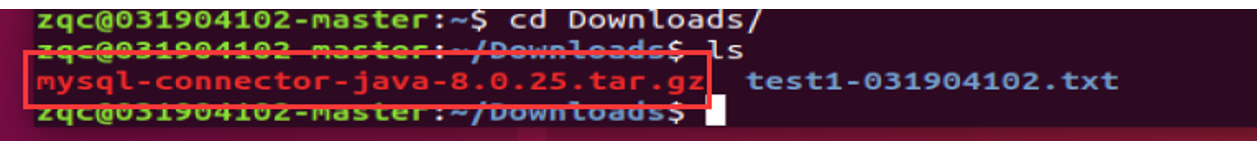

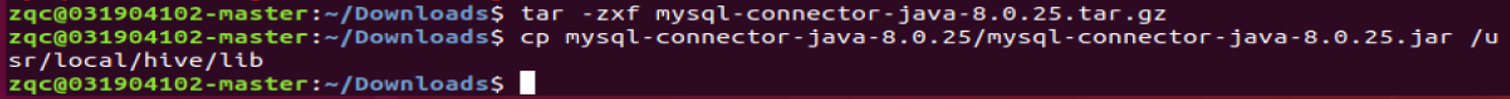

下载mysql jdbc包https://dev.mysql.com/downloads/connector/j/ ;

解压jdbc包后,将其中的jar包拷贝至hive安装目录下lib文件夹中

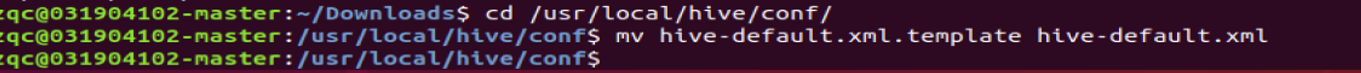

进入/usr/local/hive/conf 目录。将hive-default.xml.template 重命名为hive-default.xml 保存着各个配置参数的默认值。

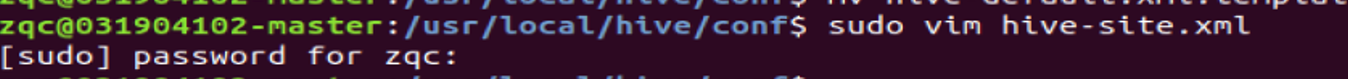

新建一个hive-site.xml 配置文件,并添加如下内容,该文件内容会覆盖原默认值

箭头标记处说明:hive_metadata_zqc 是前面步骤 MySQL 里新建的 database、hive_zqc和 hive 是连接数据库的用户名以及密码;

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive_metadata_zqc?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive_zqc</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

</configuration>

- 初始化元数据库,启动 Hive,进入 Hive 运行时环境

初始化元数据库,不然有可能会报错。

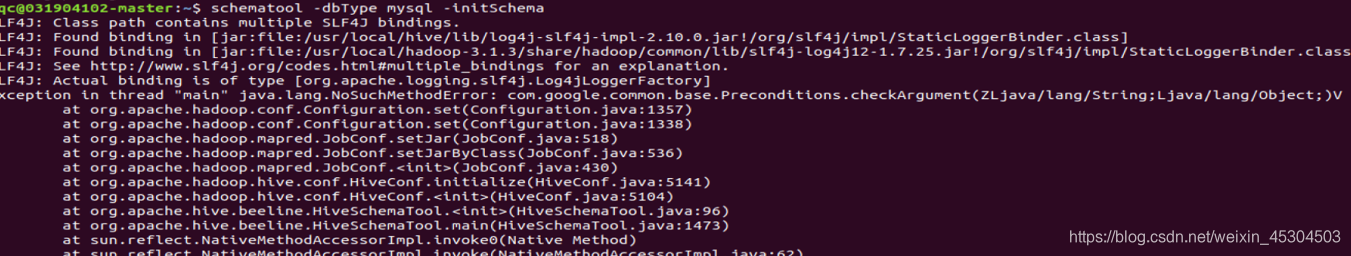

可能出现错误

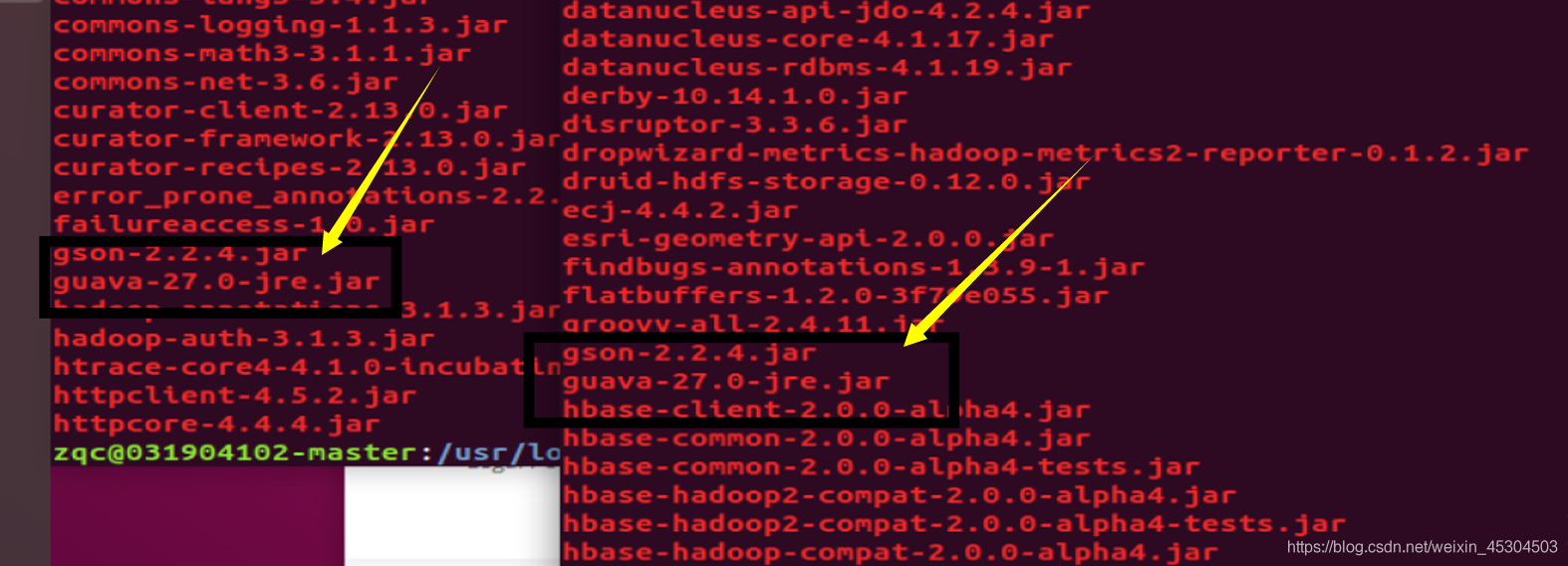

原因:com.google.common.base.Preconditions.checkArgument 这是因为 hive 内依赖的 guava.jar 和hadoop内的版本不一致造成的。

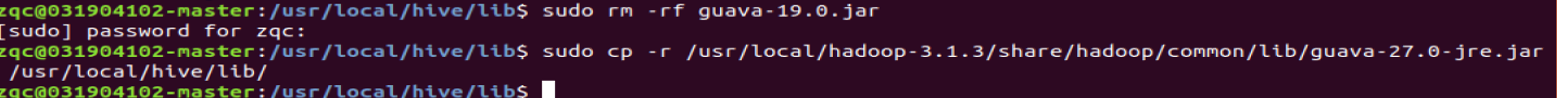

解决方法:查看hadoop安装目录下 share/hadoop/common/lib 内 guava.jar 版本,查看 hive安装目录下lib内guava.jar的版本,如果两者不一致,删除版本低的,并拷贝高版本的。

两个版本一样了

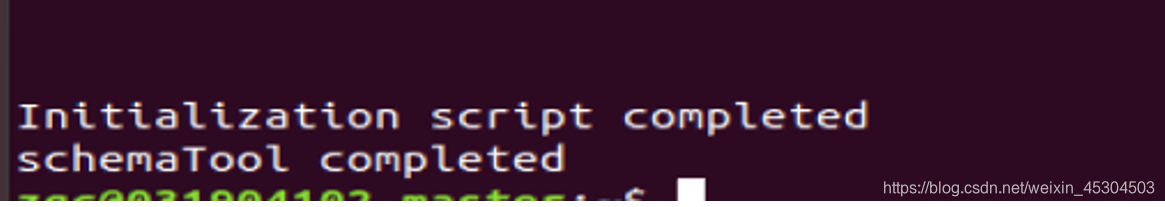

在进行一次初始化元数据库

成功了!

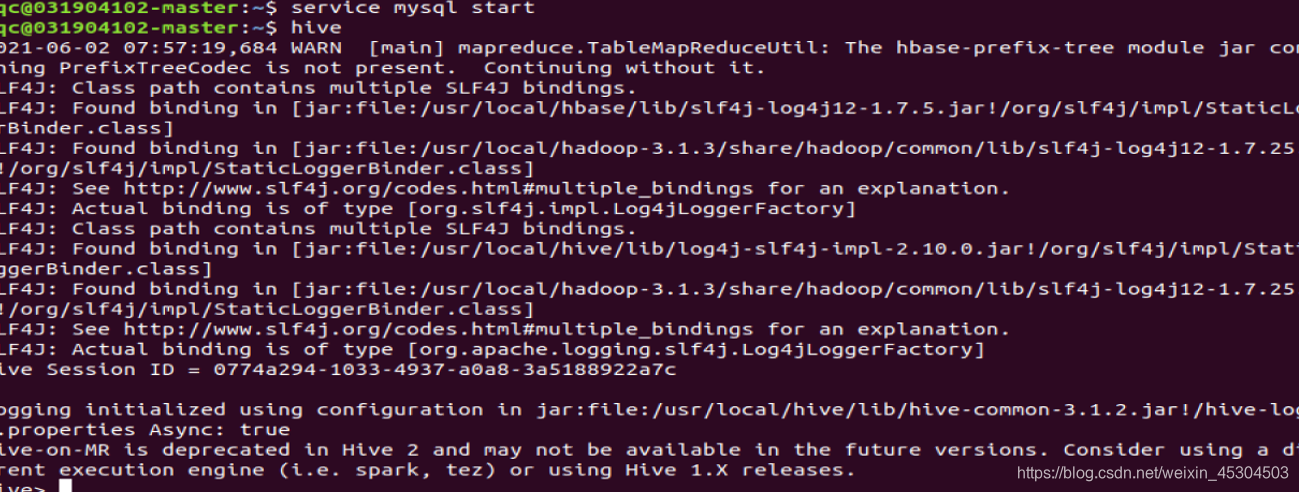

4. 启动Hive

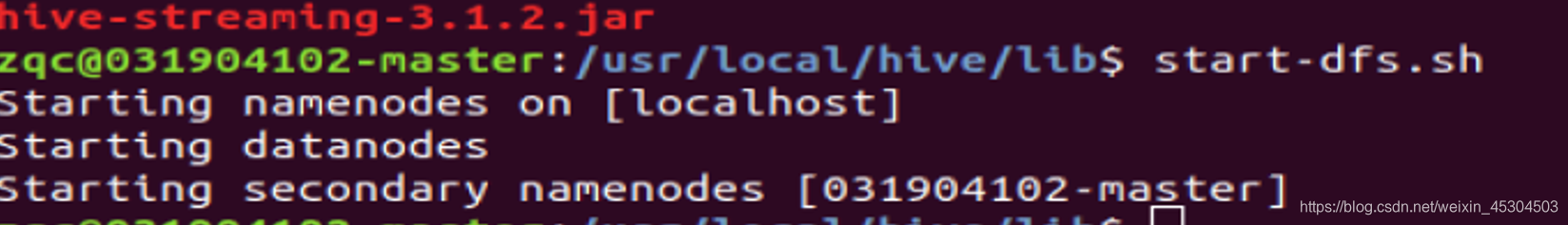

启动hive 之前,请先启动hadoop集群(start-dfs.sh)和确保MySQL服务正常运行。“hive”命令启动 hive。

启动hadoop集群

启动mysql

启动hive

5.2 Shell进行实验内容

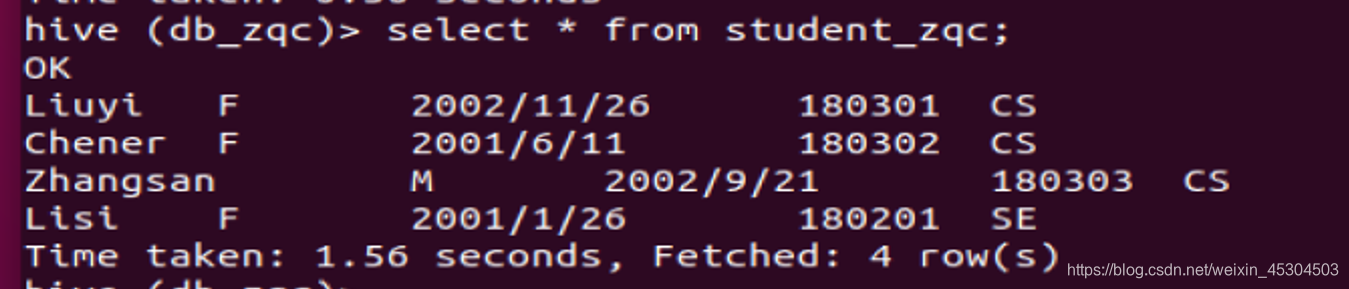

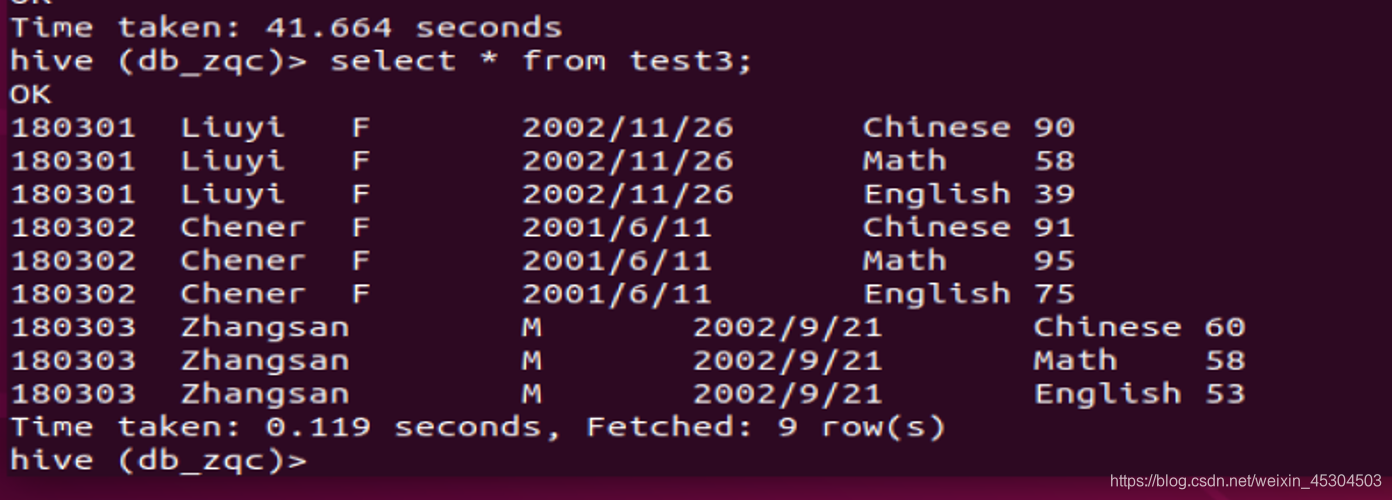

表1 student_zqc:

| Name | Sex | Birth | Dept | Uid |

|---|---|---|---|---|

| Liuyi | F | 2002/11/26 | CS | 180301 |

| Chener | F | 2001/6/11 | CS | 180302 |

| Zhangsan | M | 2002/9/21 | CS | 180303 |

| Lisi | F | 2001/1/26 | SE | 180201 |

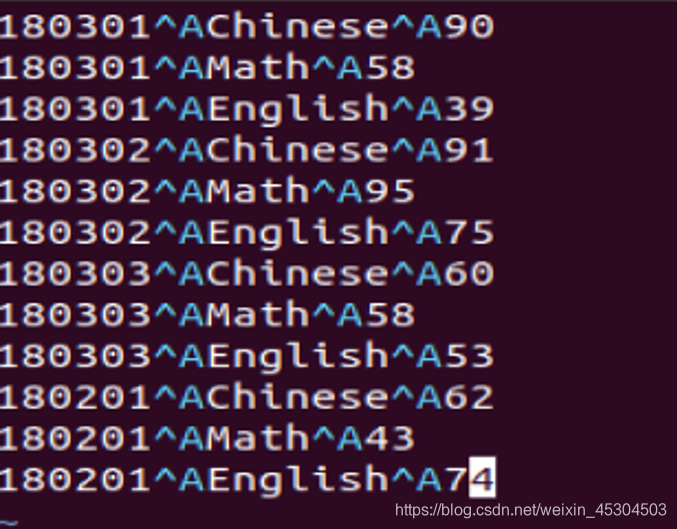

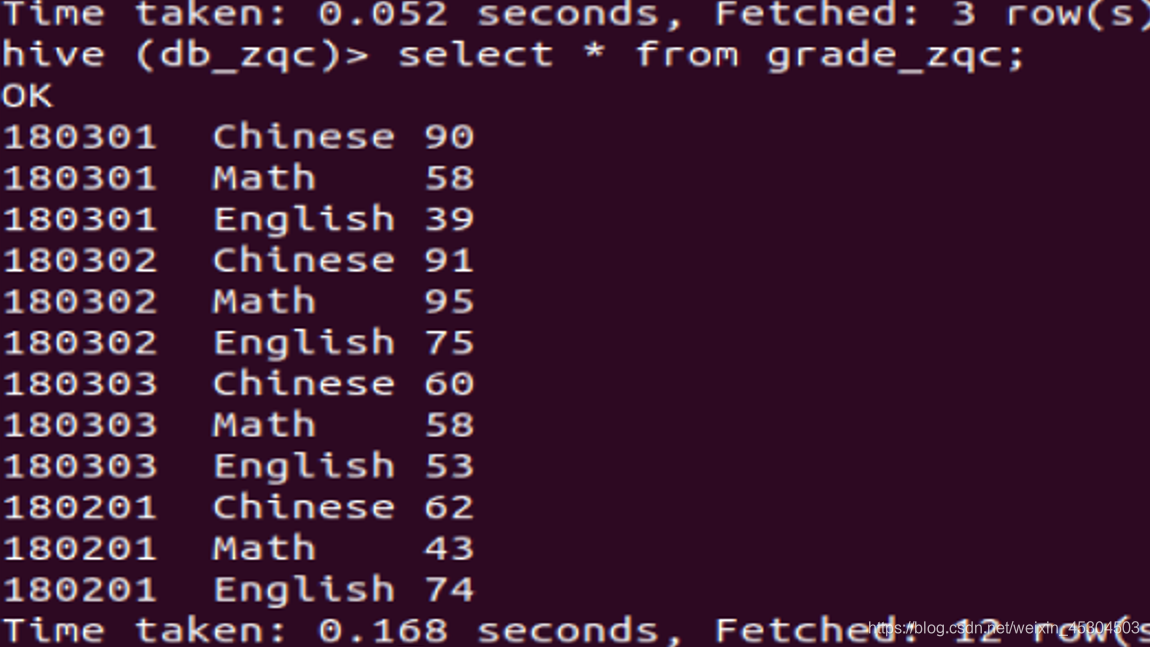

表2 grade_zqc:

| Uid | Course | Grade |

|---|---|---|

| 180301 | Chinese | 90 |

| 180301 | Math | 58 |

| 180301 | English | 39 |

| 180302 | Chinese | 91 |

| 180302 | Math | 95 |

| 180302 | English | 75 |

| 180303 | Chinese | 60 |

| 180303 | Math | 58 |

| 180303 | English | 53 |

| 180201 | Chinese | 62 |

| 180201 | Math | 43 |

| 180201 | English | 74 |

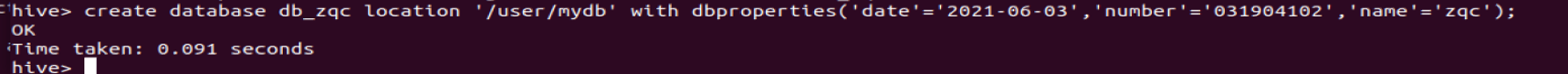

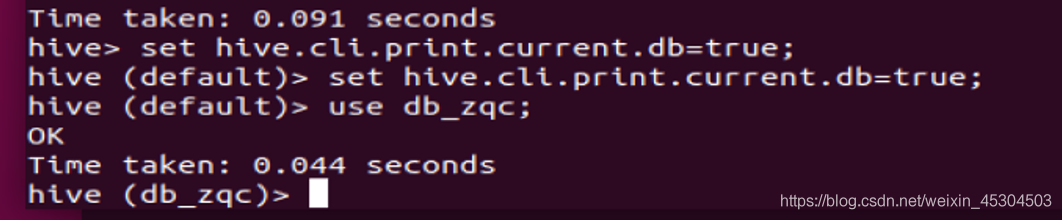

5.2.1 新建一个数据库;

新建一个数据库db_xxx,添加扩展参数:日期、学号、姓名;使用该数据库做后续操作;设置命令行显示当前使用的数据库,请保证后续操作都能显示。

创建的时候添加了日期,学号,姓名,以及存放路径

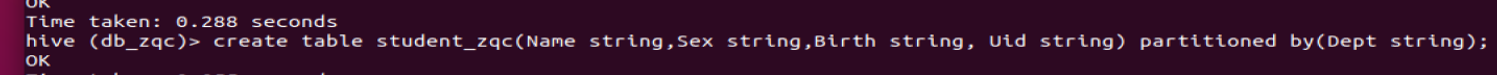

5.2.2 新建表

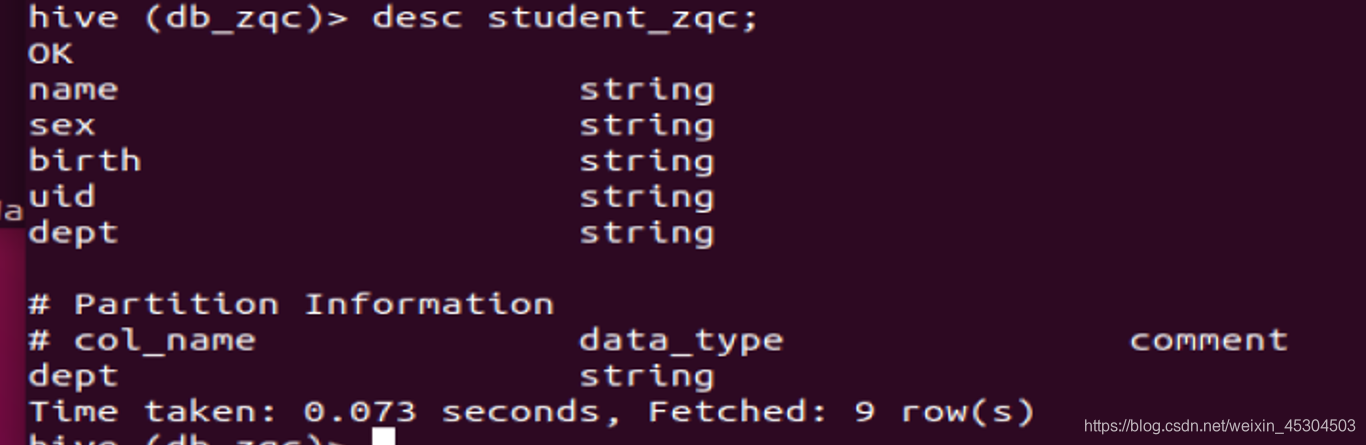

新建student_xxx分区表(分区字段Dept)和grade_xxx内部表,分别查看表结构和存储路径;(字段类型自定义)

5.2.3 添加分区

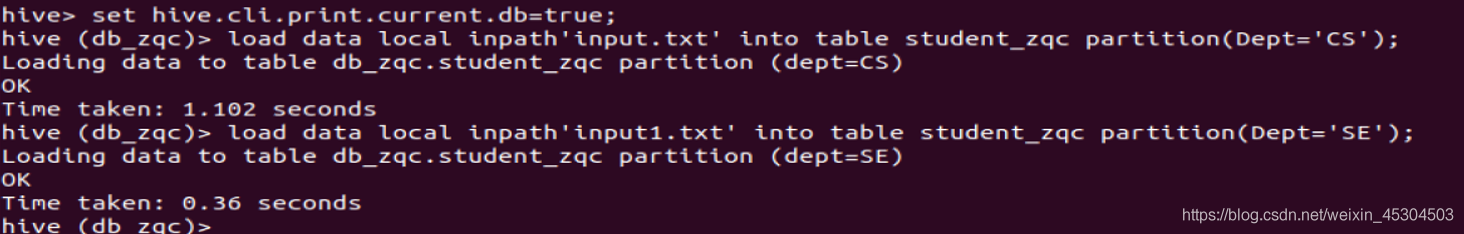

在表student_zqc中添加两个分区Dept=’CS’和Dept=’SE’,从本地导入数据到student_xxx表的两个分区中,分别查看两个分区所有记录,查看表数据存储目录;

从文件中加载数据,load data

语法 :

LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename

首先在本地主目录下创建数据文件 input.txt,并上传到 HDFS 中。

注意分隔符要跟你表设置一致。

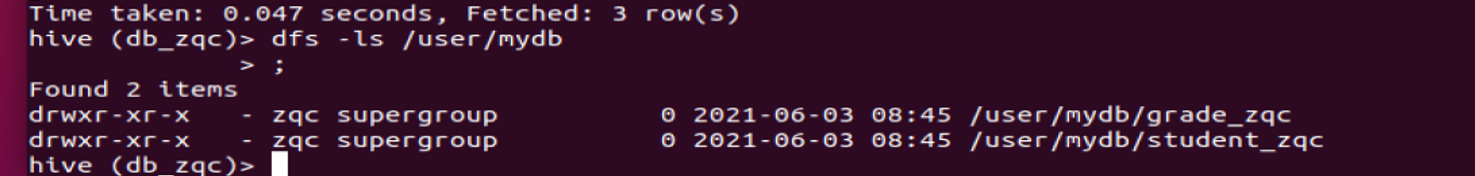

- 本地创建两个文件

input1.txt

input.txt

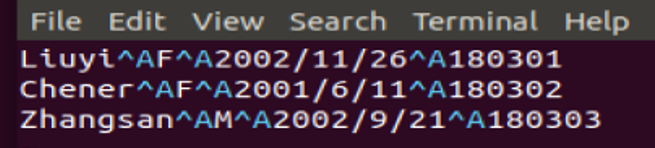

- 将两个文件上传到HDFS

- 在hive中加载

- 查看是否加载成功

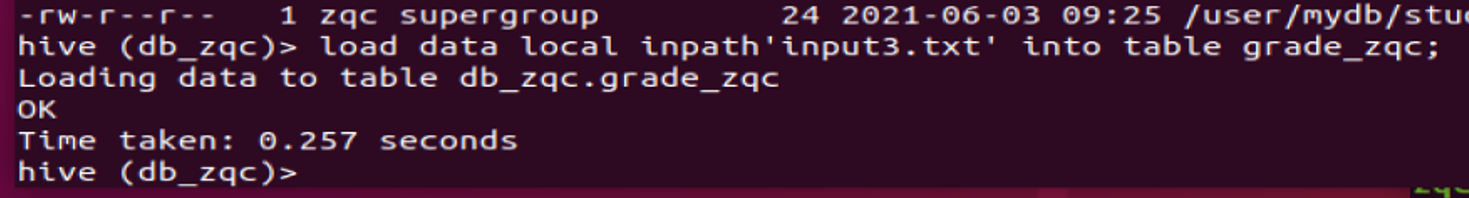

5.2.4 导入grade_zqc

从HDFS导入数据到grade_xxx表中,查看grade_xxx表所有记录,查看表数据存储目录;

本地创建表 input3.txt

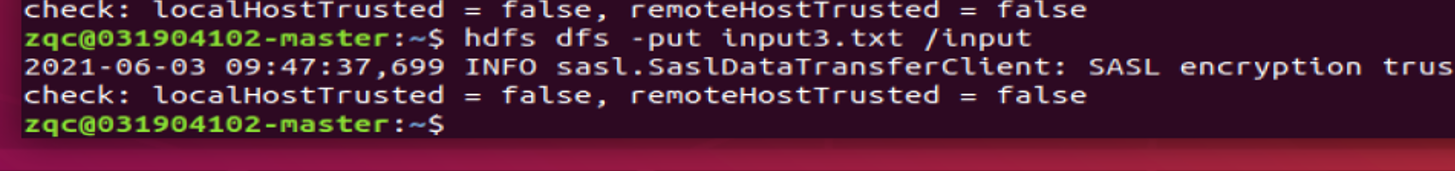

上传到hdfs

加载到hive中

5.2.5 统计男、女生人数

select sex,count(1) from student_zqc group by sex;

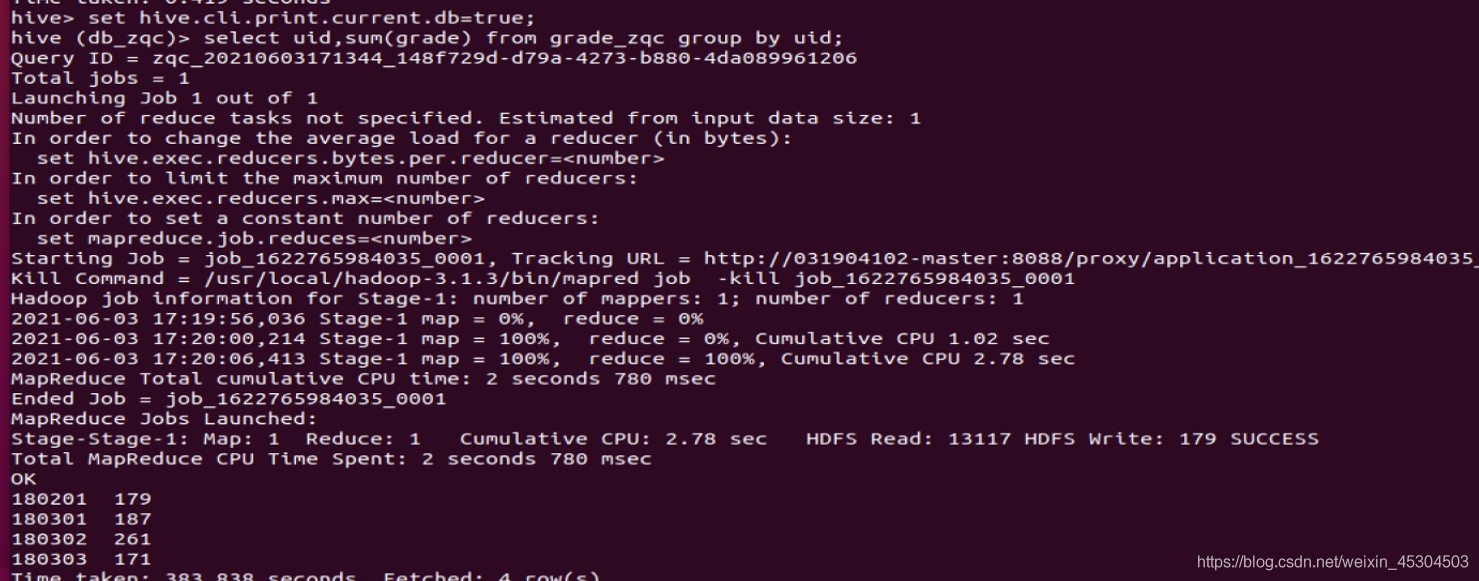

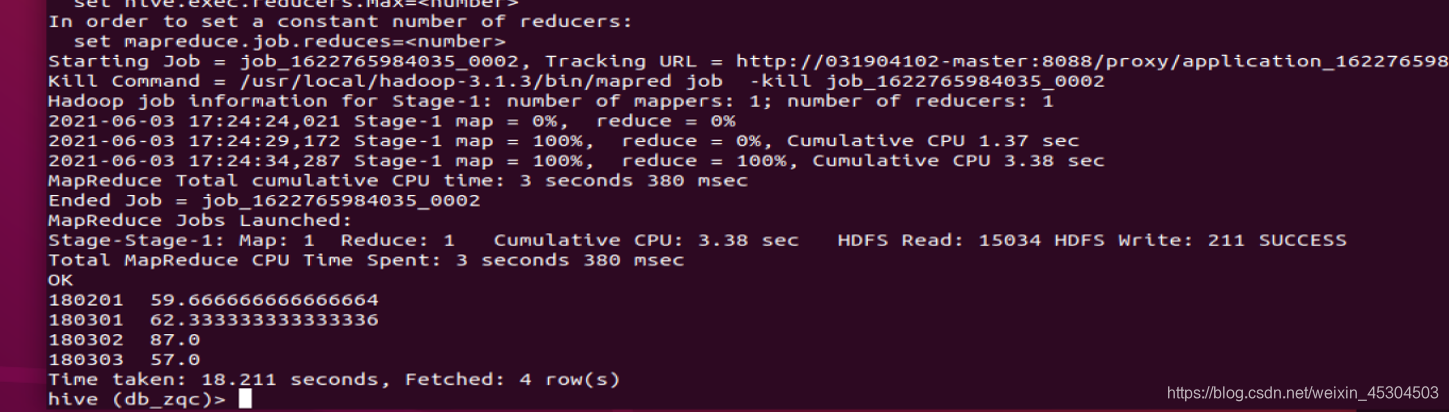

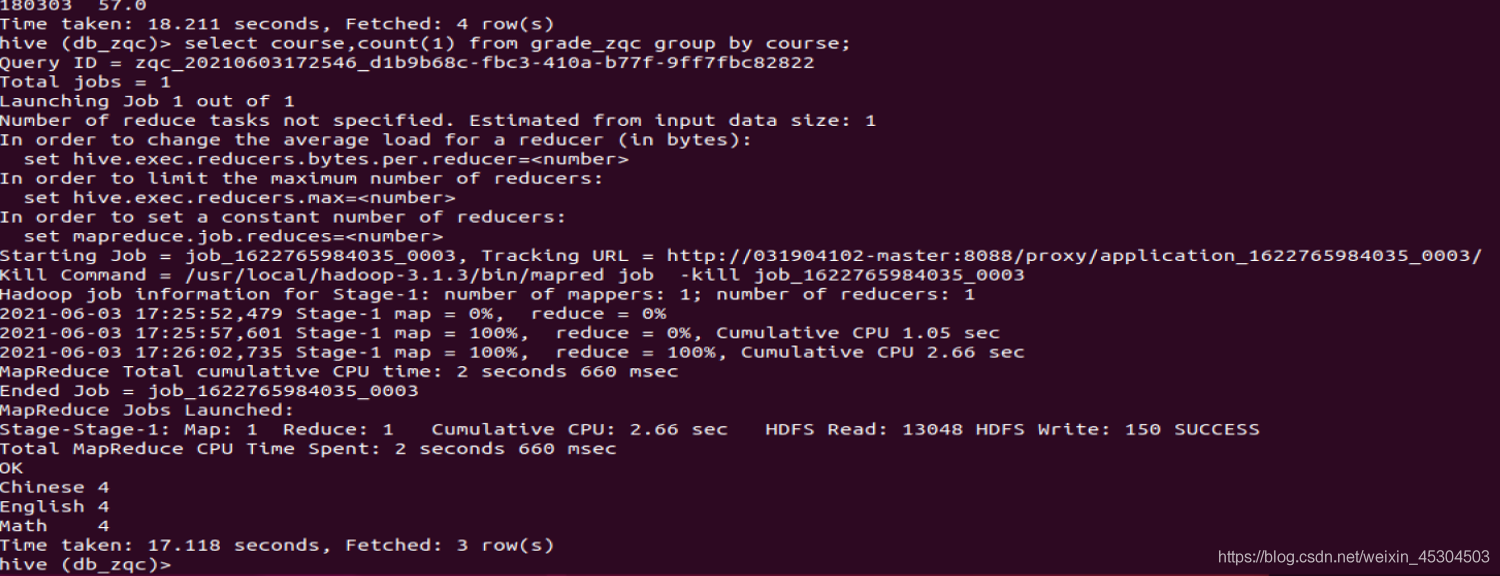

5.2.6 统计每个学生所有科目的总分以及平均分

select uid,avg(grade) from grade_zqc group by uid;

5.2.7 统计每个科目有多少人以及每个科目平均成绩

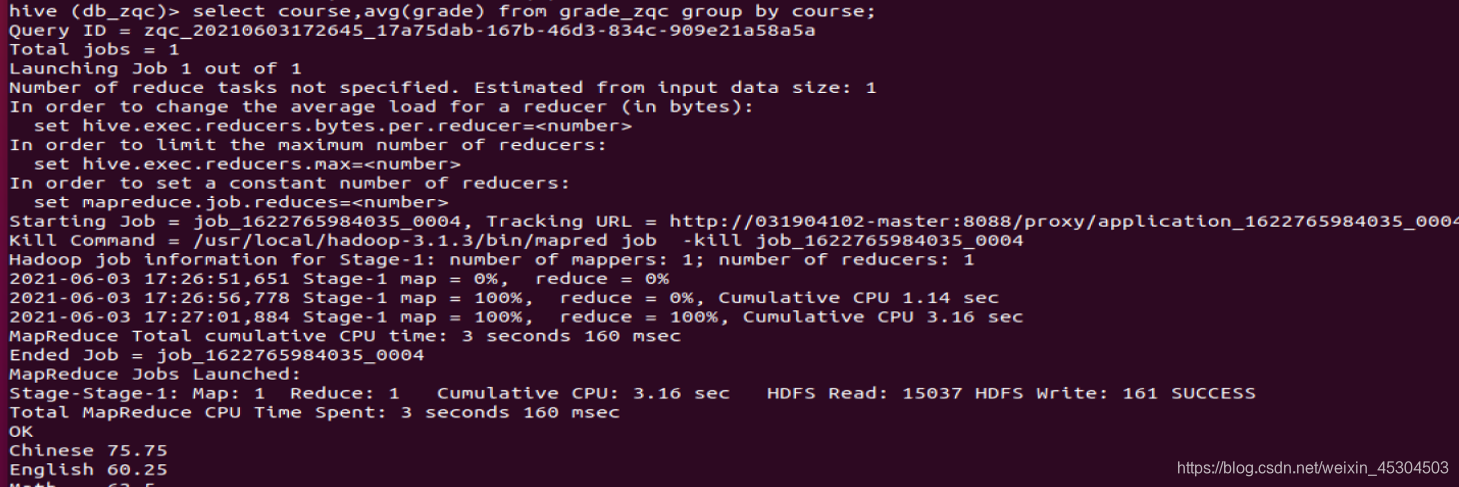

5.2.8 查询chinese科目得分排前两名学生学号和分数;

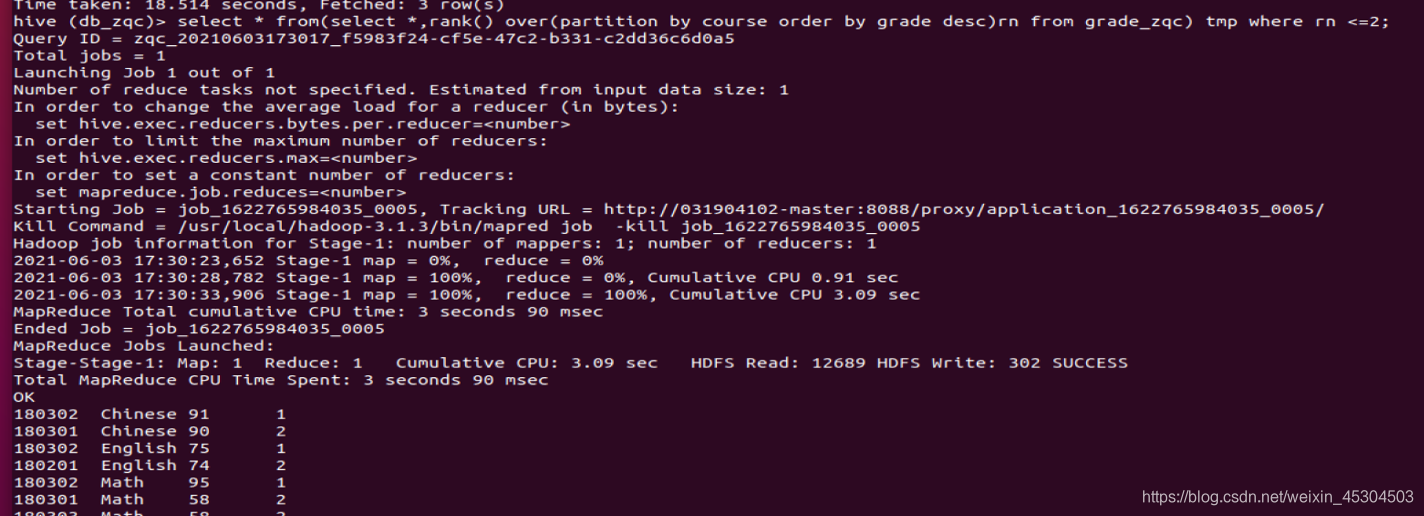

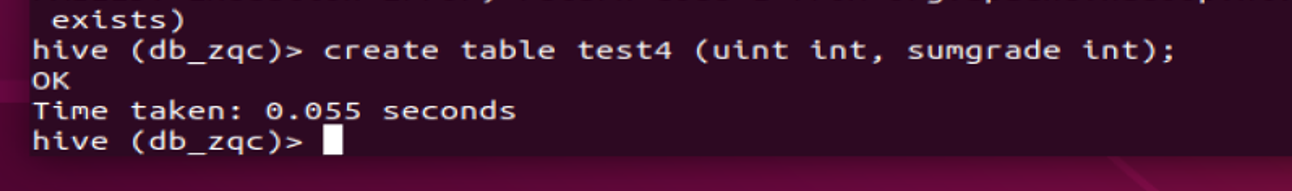

5.2.9 创建一个新表rank_zqc保存CS系每个学生信息和科目总分,按成绩降序排序,并查询结果;

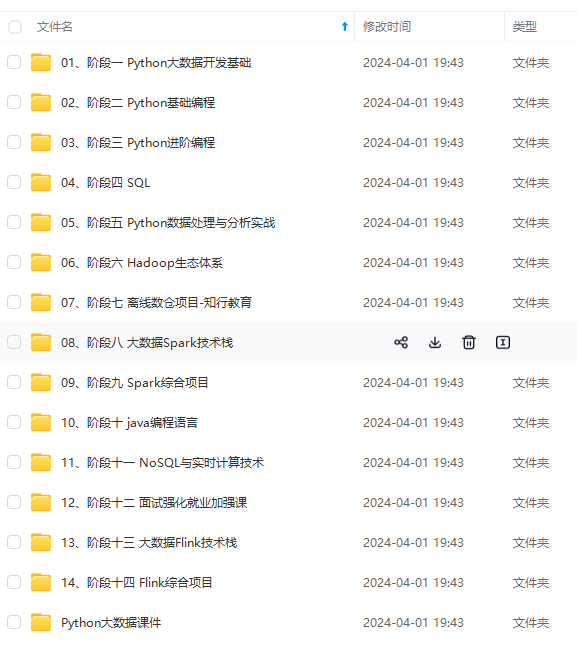

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

mNzZG4ubmV0L3dlaXhpbl80NTMwNDUwMw==,size_16,color_FFFFFF,t_70)

[外链图片转存中…(img-e2YCnrGg-1715711579835)]

[外链图片转存中…(img-EpHgAkui-1715711579835)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

7037

7037

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?