网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

8) flume Interceptors相关配置和案例分析

9) flume AVRO Client开发

10) flume 和kafka 的整合

11) 案例:采集目录到HDFS

12) 案例:采集文件到HDFS

数据迁移工具Sqoop主要内容:

1) 介绍 和 配置Sqoop

2) Sqoop shell使用

3) Sqoop-import a) DBMS-hdfs b) DBMS-hive c) DBMS-hbase

4) Sqoop-export

#### 3.3第三阶段

>

> 实现Hadoop的HA(HA是High availability的缩写,即高可用,7\*24小时不中断服务)——ZooKeeper(Zookeeper是分布式协调管理服务框架,管理分布式环境中的数据。简要来说,Zookeeper = 文件系统 + 监听通知机制。)

>

>

>

分布式协调管理服务ZooKeeper主要内容:

1) ZooKeeper简介及应用场景

2) ZooKeeper集群安装部署

3) ZooKeeper的数据节点与命令行操作

4) ZooKeeper的java客户端基本操作及事件监听

5) ZooKeeper核心机制及数据节点

6) ZooKeeper应用案例–分布式共享资源锁

7) ZooKeeper应用案例–服务器上下线动态感知

8) ZooKeeper的数据一致性原理及leader选举机制

>

> Web管理工具——Hue(Hue是大数据分析交互平台,是大数据web管理器,是运营和开发Hadoop应用的图形化用户界面。其包括三个主要部分:Hue UI,Hue Server,Hue DB。Hue程序被整合到一个类似桌面的环境,以web程序的形式发布,对于单独的用户来说不需要额外的安装。)

>

>

> 工作流引擎——Oozie(Oozie,能够提供对Hadoop的MapReduce和Pig的Jobs任务调度与协调。功能相似的任务调度框架还有Azkaban和Zeus。)

>

>

> 注1:Hadoop-HA严格来说应该分成各个组件的HA机制——*HDFS*的*HA*、*YARN*的*HA*

>

>

> 注2:大数据四大协作框架——Oozie(任务调度框架)、Sqoop(数据转换工具)、Flume(文件收集库框架)、Hue(大数据Web工具)。

>

>

>

### 4.Spark生态学习

内存计算Spark基础主要内容:

1) Spark介绍

2) Spark应用场景

3) Spark和Hadoop MR、Storm的比较和优势

4) RDD

5) Transformation

6) Action

7) Spark计算PageRank

8) Lineage

9) Spark模型简介

10) Spark缓存策略和容错处理

11) 宽依赖与窄依赖

12) Spark配置讲解

13) Spark集群搭建

14) 集群搭建常见问题解决

15) Spark原理核心组件和常用RDD

16) 数据本地性

17) 任务调度

18) DAGScheduler

19) TaskScheduler

20) Spark源码解读

21) 性能调优

22) Spark和Hadoop2.x整合:Spark on Yarn原理

#### 4.1第一阶段

>

> Scala编程

>

>

> 1.Scala是一门多范式(Multi-paradigm)的编程语言,类似Java编程语言,设计初衷是实现可伸缩的语言、并要集成面向对象编程和命令式编程、函数式编程的各种特性。

>

>

> 2.Scala是运行在Java虚拟机上的,并兼容现有Java程序。Scala 源代码被编译成Java字节码,所以它可以运行于JVM之上,并可以调用现有的Java类库。

>

>

> 3.可应用于后端开发,表达能力较强,擅长处理数据,长期运行且吞吐量较大的场景。

>

>

>

编程语言Scala主要内容:

1) scala解释器、变量、常用数据类型等

2) scala的条件表达式、输入输出、循环等控制结构

3) scala的函数、默认参数、变长参数等

4) scala的数组、变长数组、多维数组等

5) scala的映射、元组等操作

6) scala的类,包括bean属性、辅助构造器、主构造器等

7) scala的对象、单例对象、伴生对象、扩展类、apply方法等

8) scala的包、引入、继承等概念

9) scala的特质

10) scala的操作符

11) scala的高阶函数

12) scala的集合

13) scala数据库连接

#### 4.2第二阶段

>

> Spark Core——基于内存的数据计算,替代的是Hadoop中的MapReduce部分。MapReduce是基于外存的计算,其计算速度较慢、时效性较差。

>

>

>

#### 4.3第三阶段

>

> Spark SQL——类似于Oracle的SQL语句

>

>

>

#### 4.4第四个阶段

>

> Spark Streaming——进行实时计算(流式计算),典型流式计算的生活场景是自来水厂。

>

>

>

流式计算Spark Streaming主要内容:

1) Spark-Streaming简介

2) Spark-Streaming编程

3) 实战:StageFulWordCount

4) Flume结合Spark Streaming

5) Kafka结合Spark Streaming

6) 窗口函数

7) ELK技术栈介绍

8) ElasticSearch安装和使用

9) Storm架构分析

10) Storm编程模型、Tuple源码、并发度分析

11) Storm WordCount案例及常用Api分析

### 5.Storm学习——实时计算

>

> Storm是分布式实时大数据处理框架,是流计算中的佼佼者和主流,被业界称为实时版Hadoop。

>

>

> 和Storm相关的NoSQL数据库,Redis——基于内存的数据库。作用类似Spark Streaming。

>

>

>

实时计算Storm主要内容:

1) Storm的基本概念

2) Storm的应用场景

3) Storm和Hadoop的对比

4) Storm集群的安装的linux环境准备

5) zookeeper集群搭建

6) Storm集群搭建

7) Storm配置文件配置项讲解

8) 集群搭建常见问题解决

9) Storm常用组件和编程API:Topology、 Spout、Bolt

10) Storm分组策略(stream groupings)

11) 使用Strom开发一个WordCount例子

12) Storm程序本地模式debug、Storm程序远程debug

13) Storm事物处理

14) Storm消息可靠性及容错原理

15) Storm结合消息队列Kafka:消息队列基本概念(Producer、Consumer、Topic、Broker等)、消息队列Kafka使用场景、Storm结合Kafka编程API

16) Storm Trident概念

17) Trident state 原理

18) Trident开发实例

19) Storm DRPC(分布式远程调用)介绍

20) Storm DRPC实战讲解

21) Storm和Hadoop 2.x的整合:Storm on Yarn

内存数据库Redis主要内容:

1) redis特点、与其他数据库的比较

2) 如何安装redis

3) 如何使用命令行客户端

4) redis的字符串类型

5) redis的散列类型

6) redis的列表类型

7) redis的集合类型

8) 如何使用java访问redis【a.python访问redis,scala访问redis】

9) redis的事务(transaction)

10) redis的管道(pipeline)

11) redis持久化(AOF+RDB)

12) redis优化

13) redis的主从复制

14) redis的sentinel高可用

15) twemproxy,codis实战

16) redis3.x集群安装配置

### 6.其他学习

#### 6.1 Kafka

>

> Kafka是一个开源流处理平台——高吞吐量的分布式发布订阅消息系统,由Scala和Java编写。它可处理用户在网站中的所有动作流数据。类似的消息中间件还有RocketMQ。

>

>

>

消息纸中间件Kafka主要内容:

1) kafka是什么

2) kafka体系结构

3) kafka配置详解

4) kafka的安装

5) kafka的存储策略

6) kafka分区特点

7) kafka的发布与订阅

8) java编程操作kafka

9) scala编程操作kafka

10) flume 和kafka 的整合

11) Kafka 和storm 的整合

#### 6.2 机器学习算法

1、python及numpy库

1) 机器学习简介

2) 机器学习与python

3) python语言–快速入门

4) python语言–数据类型详解

5) python语言–流程控制语句

6) python语言–函数使用

7) python语言–模块和包

8) phthon语言–面向对象

9) python机器学习算法库–numpy

10) 机器学习必备数学知识–概率论

2、常用算法实现

1) knn分类算法–算法原理

2) knn分类算法–代码实现

3) knn分类算法–手写字识别案例

4) lineage回归分类算法–算法原理

5) lineage回归分类算法–算法实现及demo

6) 朴素贝叶斯分类算法–算法原理

7) 朴素贝叶斯分类算法–算法实现

8) 朴素贝叶斯分类算法–垃圾邮件识别应用案例

9) kmeans聚类算法–算法原理

10) kmeans聚类算法–算法实现

11) kmeans聚类算法–地理位置聚类应用

12) 决策树分类算法–算法原理

13) 决策树分类算法–算法实现

#### 6.3 大型网站高并发处理

- 第四层负载均衡

a) Lvs负载均衡 i. 负载算法,NAT模式,直接路由模式(DR),隧道模式(TUN)

b) F5负载均衡器介绍 - 第七层负载均衡

a) Nginx b) Apache - Tomcat、JVM优化提高并发量

- 缓存优化

a) Java缓存框架 i. Oscache,ehcache

b) 缓存数据库 i. Redis,Memcached - Lvs+nginx+tomcat+redis|memcache构建二层负载均衡千万并发处理

- Haproxy

- Fastdfs小文件独立存储管理

- Redis缓存系统 a) Redis基本使用 b) Redis sentinel高可用 c) Redis好友推荐算法

#### 6.4 Lucene基础

Lucene主要内容:

1) Lucene介绍

2) Lucene 倒排索引原理

3) 建索引 IndexWriter

4) 搜索 IndexSearcher

5) Query

6) Sort和 过滤 (filter)

7) 索引优化和高亮

#### 6.5 Solr基础

Solr主要内容:

1) 什么是solr

2) 为什么工程中要使用solr

3) Solr的原理

4) 如何在tomcat中运行solr

5) 如何利用solr进行索引与搜索

6) solr的各种查询

7) solr的Filter

8) solr的排序

9) solr的高亮

10) solr的某个域统计

11) solr的范围统计

12) solrcloud集群搭建

#### 6.6 Federation

>

> HDFS Federation即HDFS的联邦,可简单理解为多个HDFS集群聚合到一起,更准确的理解是有多个namenode节点的HDFS集群。

>

>

>

### 7.总结

>

> 常见大数据开源框架:

>

>

> 离线计算:Hadoop MapReduce、Spark

>

>

> 实时(流式)计算:Storm、Spark Streaming、S4、Heron

>

>

> 文件存储:Hadoop HDFS、Tachyon、KFS

>

>

> NoSQL数据库:HBase(列存储数据库)、Redis(K-V数据库)、MongoDB(文档数据库)、Neo4j(图形数据库)

>

>

> 资源管理:Yarn、Mesos

>

>

> 日志收集:Flume、Scribe、Logstash、Kibana

>

>

> 消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ

>

>

> 查询分析:Hive、Impala、Pig、Presto、Phoenix、Spark SQL、Drill、Flink、Kylin、Druid

>

>

> 分布式协调服务:ZooKeeper

>

>

> 集群管理与监控:Ambari、Ganglia、Nagios、Cloudera Manager

>

>

> 数据挖掘与机器学习:Mahout、Spark MLlib

>

>

> 数据同步:Sqoop、DataX

>

>

> 任务调度:Oozie

> …

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

>

> 数据挖掘与机器学习:Mahout、Spark MLlib

>

>

> 数据同步:Sqoop、DataX

>

>

> 任务调度:Oozie

> …

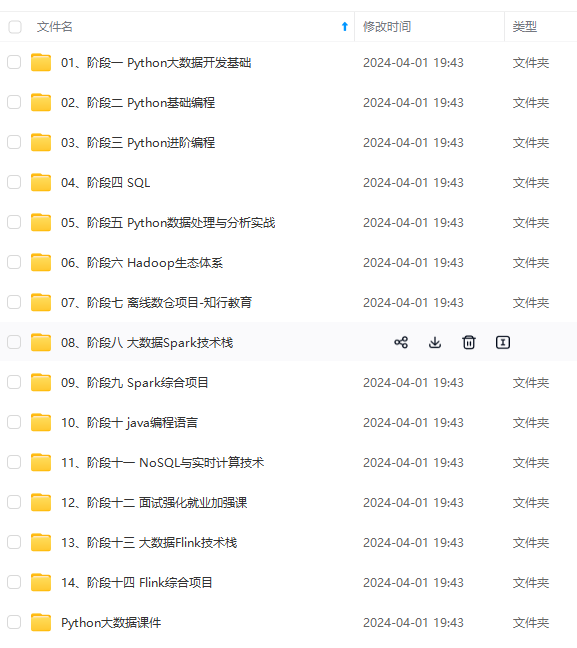

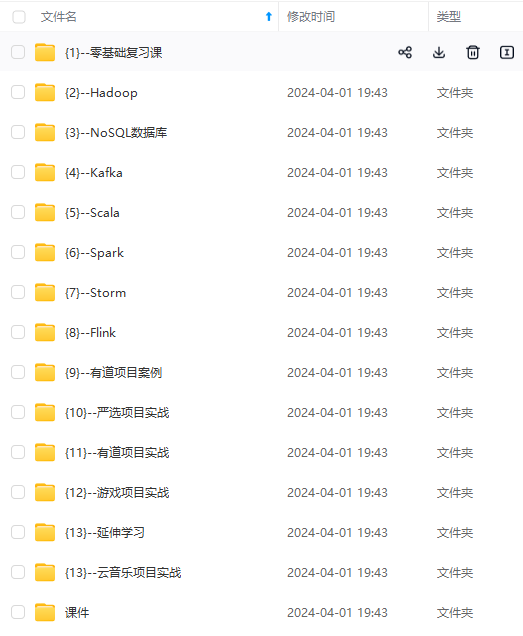

[外链图片转存中...(img-woPLwyDZ-1715252970681)]

[外链图片转存中...(img-tYYetHHc-1715252970681)]

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/forums/4f45ff00ff254613a03fab5e56a57acb)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

5533

5533

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?