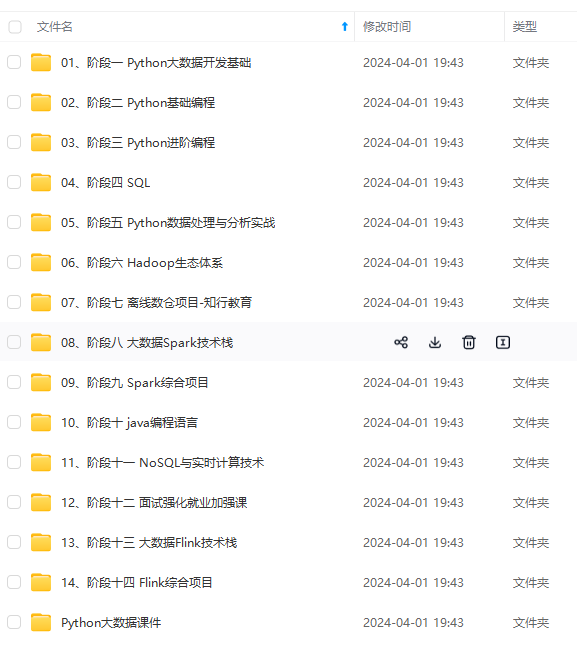

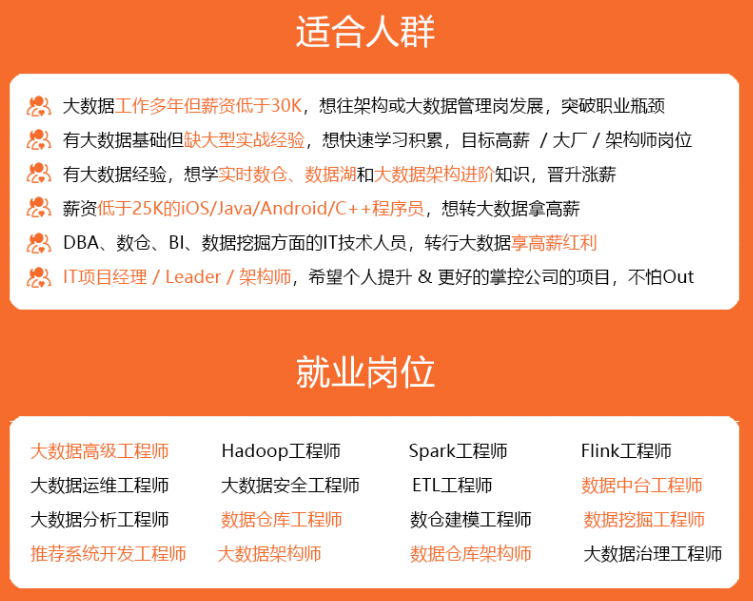

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

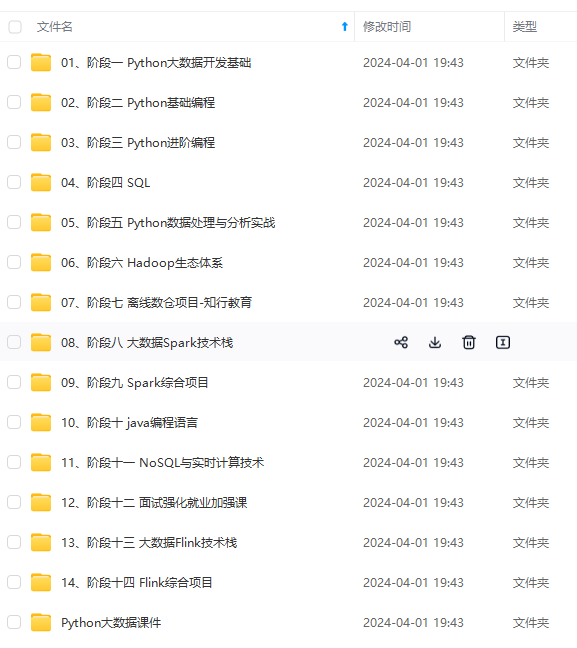

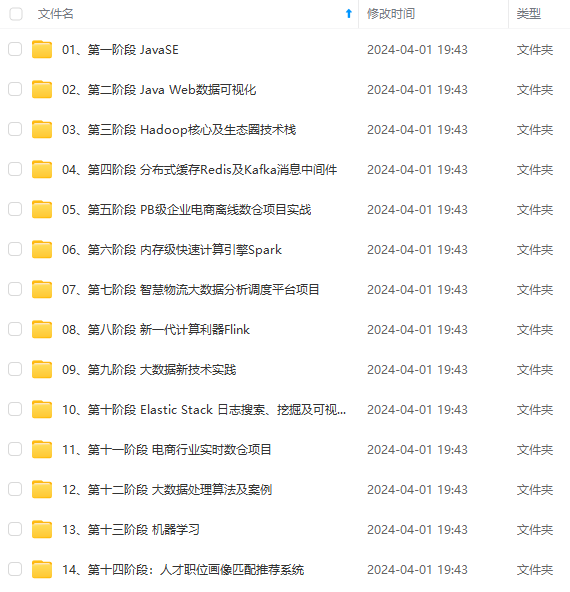

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

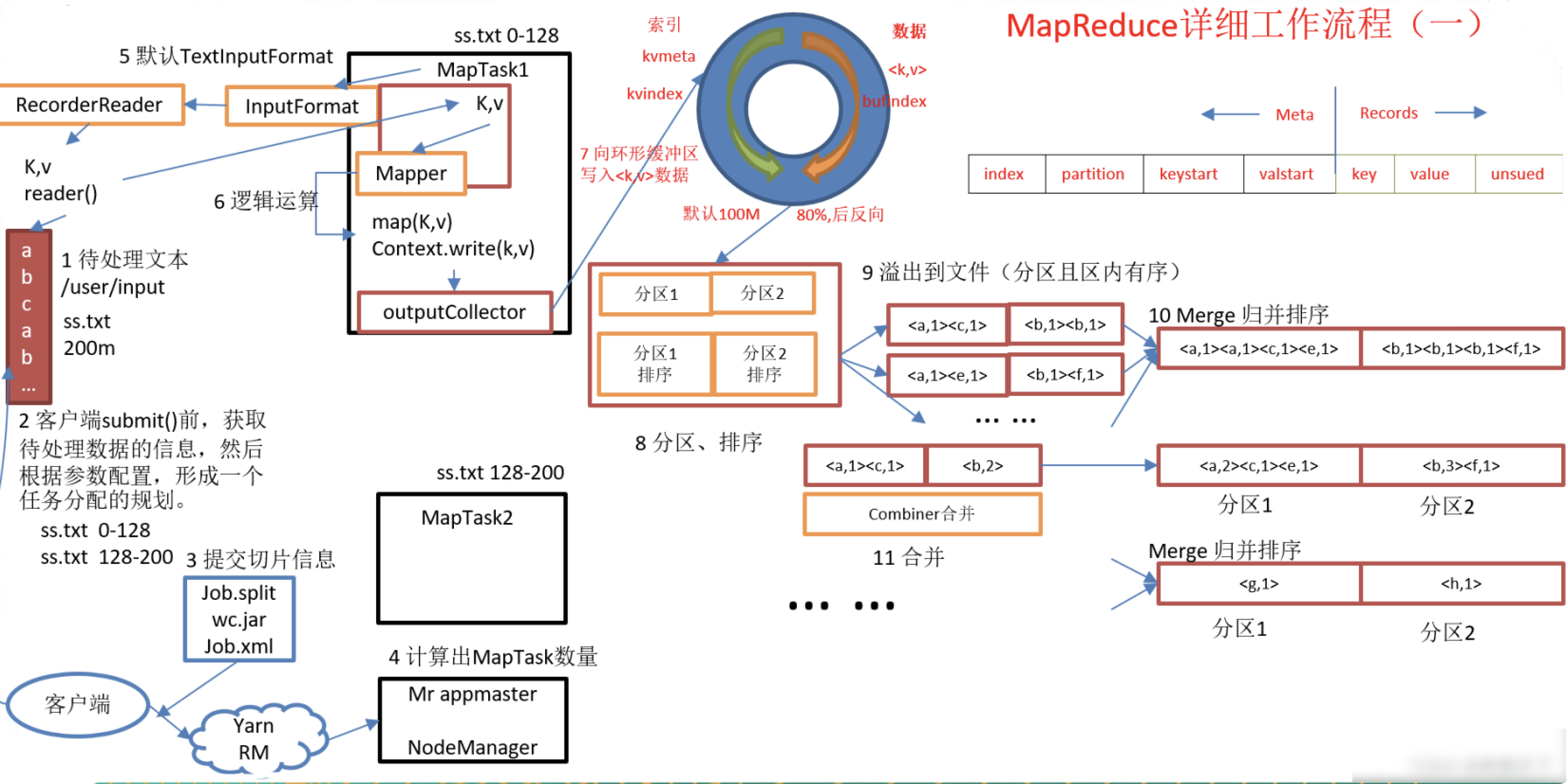

- 客户端提交任务到yarn 资源调度分配task数量,输入文件split成片,每片由每个task计算,map成k v模式,写入环形缓冲区,分区 排序,80%之后溢写到本地再归并排序或者combiner合并,

相同分区数据进入一个reduce,归并排序。最后输出。

二、hdfs读写|hbase读写

hdfs写:

客户端向namenode申请上传文件,namenode检查文件及父目录是否存在,不存在的话返回datanode节点。

上传block块,请求datanode1,dn1调用dn2,dn2调用dn3建立通道,上传到dn1,以packet为单位,分发给dn2 dn3。关闭连接。

请求namenode上传第二个block块。依次循环

hdfs读:

客户端向nn申请读文件,namenode查询元数据信息,就近原则返回dn节点,dn开始传输数据,以packet为单位,客户端接收到数据,本地缓存,最后写入目标文件。

hbase读:

客户端向zookeeper请求读文件,zookeeper查询元数据信息,根据namespace,表名,及列族找到文件所在的region,根据region找到对应regionserver,客户端请求regionserver读取region上的文件,

先从memorystore读,再读blockcache。如果没有就读storefile。从storefile读的数据先在内存缓存然后再写入目标文件。

hbase写:

客户端向zookeeper请求写文件,zookeeper查询元数据及列族,namespar,表名找到表的region位置,找到region对应的regionserver发送写数据请求。

同时写入到Hlog和memorystore,memorystore溢出刷到磁盘storefile,删除Hlog历史数据。

三、hdfs

datanode和namenode工作机制

第一次启动 格式化namenode,创建fsimage和edits log,只需要加载一次fsimage

第二次重启,加载fsimage和edits log,合并操作,生成新的edits log.启动过程有30秒等待时间 为安全模式

四、yarn

在YARN HA中,有两个主要组件:ResourceManager(RM)和NodeManager(NM)。ResourceManager负责管理和调度集群资源,NodeManager负责在每个节点上运行和监控应用程序的执行

Yarn工作机制简述

1、用户使用客户端向 RM 提交一个任务job,同时指定提交到哪个队列和需要多少资源。

2、RM 在收到任务提交的请求后,先根据资源和队列是否满足要求选择一个 NM,通知它启动一个ApplicationMaster(AM) container,后续流程由它发起

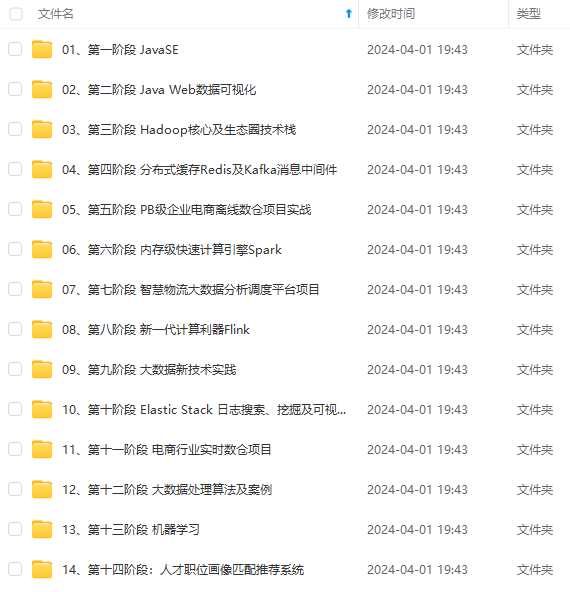

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

4447

4447

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?