既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

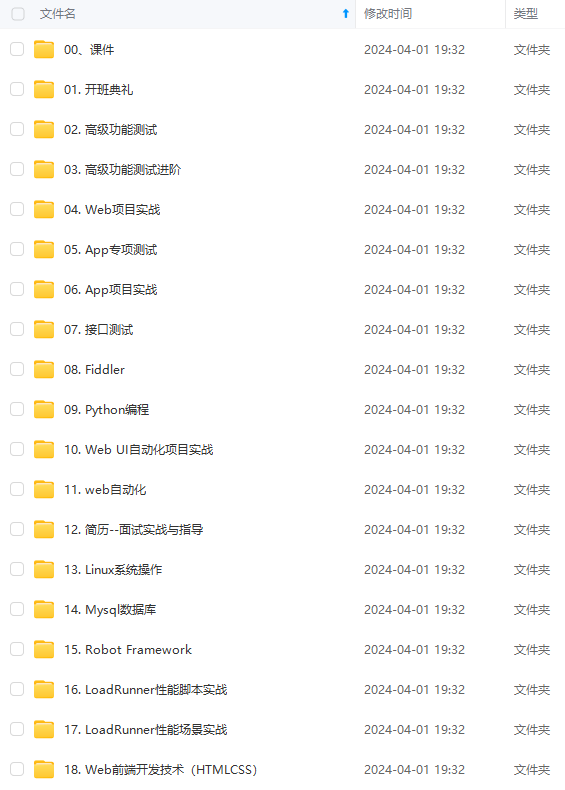

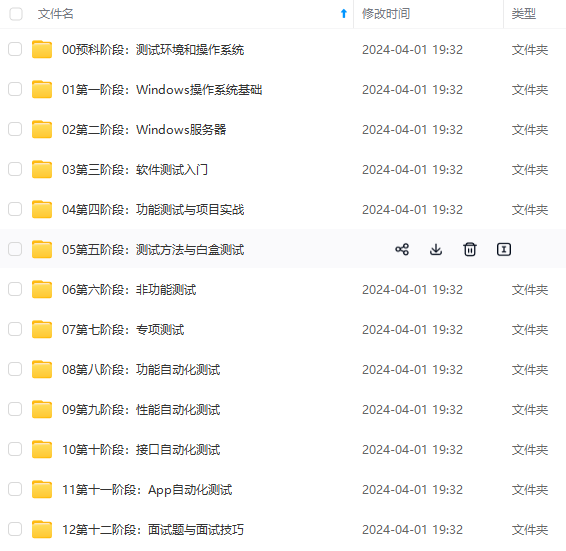

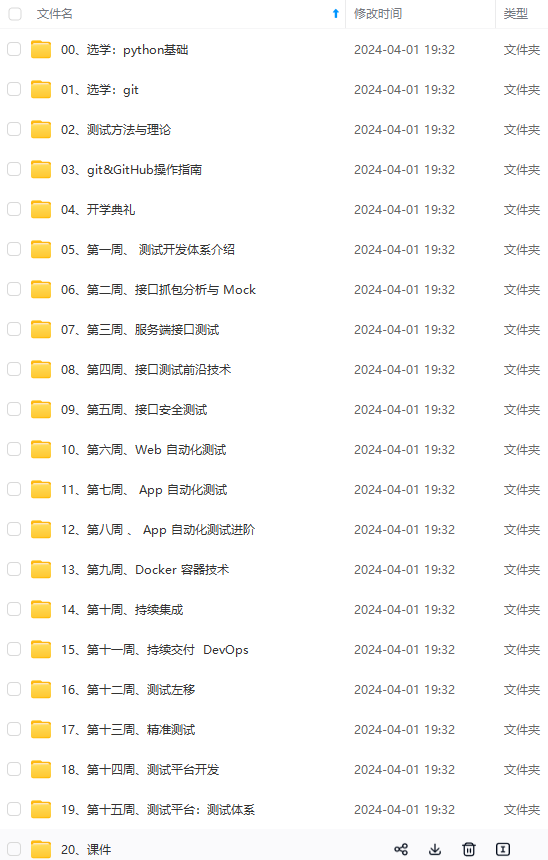

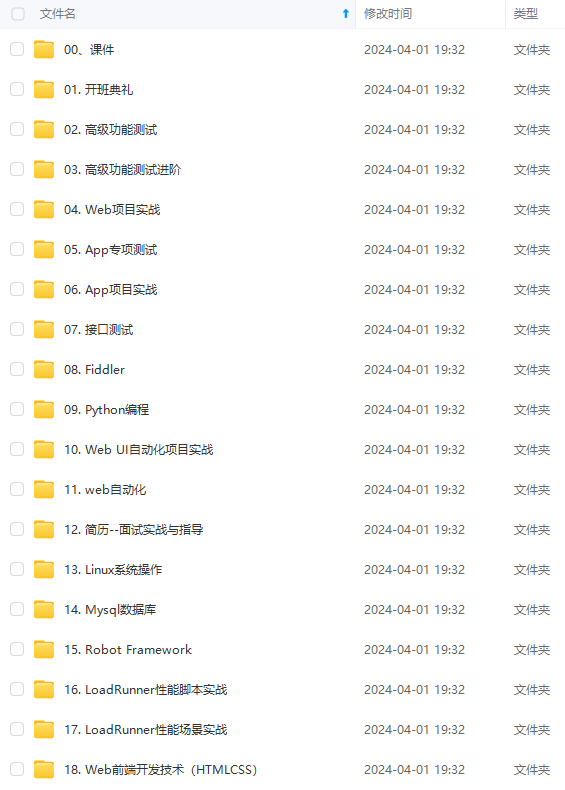

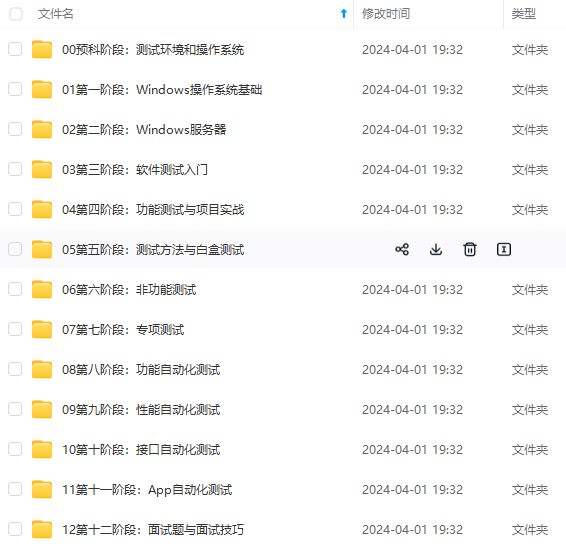

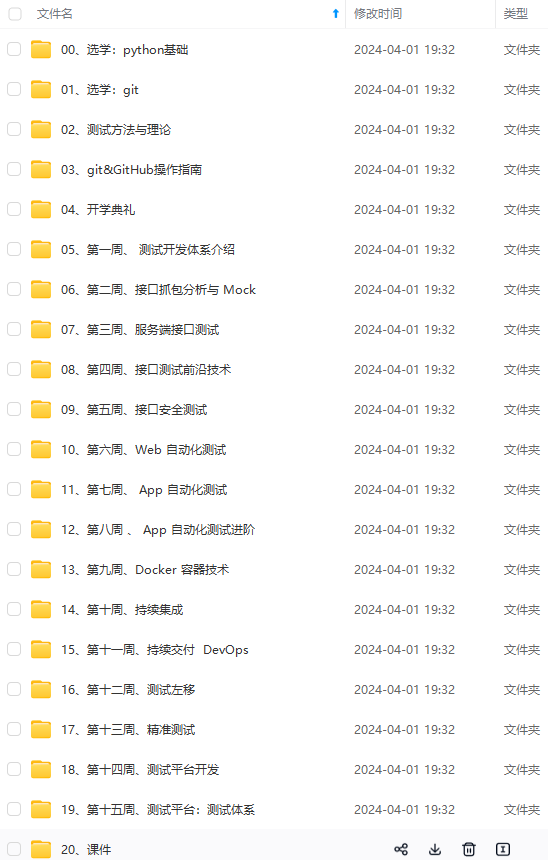

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

6.3.9 如何使用clickhouse-backup进行数据备份

1. 了解ClickHouse的架构

1.1 ClickHouse的分布式架构

ClickHouse的分布式架构允许您将数据分片存储在多个服务器上,以提高查询性能和可靠性。在ClickHouse中,可以使用分布式表来实现数据分片。分布式表会根据定义的分片键将数据分发到不同的服务器上。可以使用随机数或哈希函数作为分片键。

此外,ClickHouse还支持数据复制,以提供容错能力。可以使用ReplicatedMergeTree表来实现数据复制。ClickHouse Keeper提供了用于数据复制和分布式DDL查询执行的协调系统。ClickHouse Keeper与Apache ZooKeeper兼容。

1.1.1 ClickHouse是读写分离架构吗

ClickHouse是一个列式数据库管理系统,它支持数据复制和分片。你可以在多个服务器上部署ClickHouse集群,以提高数据的容错能力和查询性能。

在ClickHouse集群中,每个分片都可以包含多个副本。每个副本都存储了一份完整的数据。当你执行写入操作时,数据会被写入到所有副本中。当你执行查询操作时,查询会被发送到一个健康的副本上执行。

因此,ClickHouse并不是严格意义上的读写分离架构。所有副本都可以用于读写操作。但是,由于每个分片都包含多个副本,所以你可以通过负载均衡来分配查询请求,从而实现类似于读写分离的效果。

1.1.2 如何查询ClickHouse的分布式表

查询ClickHouse的分布式表与查询普通表非常相似。只需编写一个标准的SQL查询,并将其指向分布式表即可。当查询分布式表时,ClickHouse会自动将查询发送到所有分片,并将结果合并在一起。

例如,如果您有一个名为my\_distributed\_table的分布式表,您可以使用以下查询来检索所有行:

SELECT * FROM my_distributed_table;

这个查询会被自动发送到所有分片,并返回所有分片中的所有行。

1.2 数据存储方式

ClickHouse是一个真正的列式数据库管理系统。数据按列存储,并在执行过程中以数组(向量或列块)的形式处理。只要有可能,操作都会在数组上进行,而不是在单个值上进行。这被称为“向量化查询执行”,它有助于降低实际数据处理的成本。

通常,处理的数据存储在本地文件系统中,即与ClickHouse服务器位于同一台机器上。这需要大容量磁盘,可能会非常昂贵。为了避免这种情况,您可以将数据远程存储在Amazon S3磁盘或Hadoop分布式文件系统(HDFS)中。要使用Amazon S3磁盘上存储的数据,请使用S3表引擎;要使用Hadoop分布式文件系统中的数据,请使用HDFS表引擎。

ClickHouse使用列式存储来存储数据。这意味着,每一列的数据都单独存储在一个文件中。这种存储方式有助于提高查询性能,因为在处理查询时,只需要读取相关的列,而不需要读取整张表。

此外,ClickHouse还使用了多种压缩算法来压缩数据。这些压缩算法可以有效地减少磁盘空间占用,并提高查询性能。

在存储数据时,ClickHouse会将数据分成多个分区。每个分区包含一段时间内的数据。分区可以帮助提高查询性能,因为在处理查询时,只需要扫描相关的分区,而不需要扫描整张表。

总之,在ClickHouse中,数据存储方式包括列式存储、数据压缩和分区等技术。这些技术都有助于提高查询性能。

1.2.1 如何配置数据压缩

在ClickHouse中,数据压缩是自动进行的,无需手动配置。但是,可以通过调整配置参数来控制数据压缩的行为。

例如,可以在config.xml文件中配置<compression>标签来指定压缩算法和压缩级别。下面是一个简单的示例:

<compression>

<case>

<min_part_size>10000000000</min_part_size>

<min_part_size_ratio>0.01</min_part_size_ratio>

<method>zstd</method>

<level>1</level>

</case>

</compression>

上面的配置指定了当分区大小大于10GB或占总大小的1%时,使用zstd算法进行压缩,并且压缩级别为1。

此外,还可以配置其他参数来控制数据压缩的行为。例如,可以配置<min\_rows>和<min\_bytes>参数来指定触发压缩的最小行数和最小字节数。

总之,在ClickHouse中,可以通过调整配置参数来控制数据压缩的行为。

1.2.2 如何选择合适的压缩算法

在ClickHouse中,可以根据数据特征和查询需求来选择合适的压缩算法。例如:

-

LZ4:LZ4算法具有较快的压缩和解压速度,但压缩率较低。适用于对查询性能要求较高,但对磁盘空间占用要求不高的场景。

-

ZSTD:ZSTD算法具有较高的压缩率,但压缩和解压速度较慢。适用于对磁盘空间占用要求较高,但对查询性能要求不高的场景。

-

Delta + LZ4/ZSTD:Delta编码可以有效地压缩有序数据。可以将Delta编码与LZ4或ZSTD算法结合使用,以提高压缩率。

此外,在选择压缩算法时,还应考虑数据类型、数据分布、查询模式等因素。可以通过测试不同的压缩算法来确定最佳的压缩方案。

总之,在ClickHouse中,可以根据数据特征和查询需求来选择合适的压缩算法。

1.2.3 如何清理旧数据

在ClickHouse中,可以使用多种方法来清理旧数据。例如:

- 使用

ALTER TABLE ... DELETE语句:可以使用ALTER TABLE ... DELETE语句来删除不再需要的数据。例如,可以执行以下SQL语句来删除早于2022年1月1日的数据:

ALTER TABLE mytable DELETE WHERE date < '2022-01-01';

- 使用

ALTER TABLE ... DROP PARTITION语句:如果需要删除整个分区的数据,可以使用ALTER TABLE ... DROP PARTITION语句。例如,可以执行以下SQL语句来删除2022年1月份的数据:

ALTER TABLE mytable DROP PARTITION '202201';

- 使用

TTL设置:可以在创建表时指定TTL设置,以自动删除过期数据。例如,可以执行以下SQL语句来创建一个带有TTL设置的表:

CREATE TABLE mytable

(

date Date,

id UInt32,

value String,

TTL date + INTERVAL 1 MONTH

)

ENGINE = MergeTree()

PARTITION BY toYYYYMM(date)

ORDER BY id;

上面的SQL语句指定了一个TTL设置,表示数据在插入1个月后会自动过期并被删除。

总之,在ClickHouse中,可以使用ALTER TABLE ... DELETE语句、ALTER TABLE ... DROP PARTITION语句和TTL设置等方法来清理旧数据。

1.2.4 关于TTL设置,自动删除过期数据

当然可以。在ClickHouse中,可以使用TTL(Time To Live)设置来自动删除过期数据。TTL设置允许您指定数据的过期时间,过期的数据会被自动删除。

下面是一个简单的例子,展示了如何使用TTL设置来自动删除过期数据:

CREATE TABLE mytable

(

event_time DateTime,

event_date Date DEFAULT toDate(event_time),

id UInt32,

value String,

TTL event_time + INTERVAL 1 MONTH

)

ENGINE = MergeTree()

PARTITION BY toYYYYMM(event_date)

ORDER BY id;

在上面的例子中,我们创建了一个名为mytable的表,并指定了一个TTL设置。这个TTL设置表示数据在插入1个月后会自动过期并被删除。

例如,如果我们在2022年1月1日插入一条数据:

INSERT INTO mytable (event_time, id, value) VALUES ('2022-01-01 00:00:00', 1, 'a');

那么这条数据会在2022年2月1日后自动过期并被删除。

此外,还可以使用更复杂的表达式来指定TTL设置。例如,可以使用条件表达式来根据数据内容指定不同的过期时间。

总之,在ClickHouse中,可以使用TTL设置来自动删除过期数据。

1.2.5 关于TTL设置,使用条件表达式来根据数据内容指定不同的过期时间

在ClickHouse中,可以使用TTL表达式来根据数据内容指定不同的过期时间。下面是一些例子:

- 假设我们有一个名为

events的表,其中包含event\_time和event\_type两个字段。我们希望对于event\_type = 1的事件,数据在event\_time + INTERVAL 1 MONTH后过期;对于event\_type = 2的事件,数据在event\_time + INTERVAL 2 MONTH后过期。我们可以这样设置TTL表达式:

ALTER TABLE events

MODIFY TTL

event_time + INTERVAL 1 MONTH IF event_type = 1,

event_time + INTERVAL 2 MONTH IF event_type = 2;

- 假设我们有一个名为

users的表,其中包含register\_time和is\_active两个字段。我们希望对于活跃用户(即is\_active = 1),数据永不过期;对于非活跃用户(即is\_active = 0),数据在注册时间后的一年内过期。我们可以这样设置TTL表达式:

ALTER TABLE users

MODIFY TTL

register_time + INTERVAL 1 YEAR IF is_active = 0;

1.2.6 如何删除TTL表达式

要删除TTL表达式,可以使用ALTER TABLE ... MODIFY TTL命令并指定一个空的TTL表达式。例如,假设我们有一个名为events的表,我们想要删除它的TTL表达式,可以这样操作:

ALTER TABLE events

MODIFY TTL;

1.2.7 如何查看当前设置的TTL表达式

要查看当前设置的TTL表达式,可以使用SHOW CREATE TABLE命令。例如,假设我们有一个名为events的表,我们想要查看它的TTL表达式,可以这样操作:

SHOW CREATE TABLE events;

这个命令会返回一个包含表定义的字符串,其中包括TTL表达式。你可以在返回的字符串中查找TTL关键字来查看当前设置的TTL表达式。

1.2.8 TTL表达式支持哪些函数

在ClickHouse中,TTL表达式支持多种函数。你可以使用任何返回Date或DateTime类型的表达式作为TTL表达式。例如,你可以使用now()函数来获取当前时间,然后使用INTERVAL子句来指定一个时间间隔。你也可以使用其他函数,如toStartOfDay()、toMonday()等,来对时间进行转换。

下面是一个例子,它展示了如何使用函数来设置TTL表达式:

CREATE TABLE example1 (

timestamp DateTime,

x UInt32 TTL now() + INTERVAL 1 MONTH,

y String TTL toMonday(timestamp) + INTERVAL 1 WEEK

) ENGINE = MergeTree

ORDER BY tuple();

在这个例子中,我们为x列设置了一个TTL表达式,它表示数据在当前时间的一个月后过期。我们还为y列设置了一个TTL表达式,它表示数据在timestamp字段所表示的周一的一周后过期。

1.2.9 TTL表达式是否支持嵌套

TTL表达式不支持嵌套。每个列或表只能有一个TTL表达式。但是,你可以在一个TTL表达式中使用多个条件来指定不同的过期时间。例如,你可以这样设置TTL表达式:

ALTER TABLE events

MODIFY TTL

event_time + INTERVAL 1 MONTH IF event_type = 1,

event_time + INTERVAL 2 MONTH IF event_type = 2;

在这个例子中,我们为events表设置了一个TTL表达式,它包含两个条件。对于event\_type = 1的事件,数据在event\_time + INTERVAL 1 MONTH后过期;对于event\_type = 2的事件,数据在event\_time + INTERVAL 2 MONTH后过期。

1.2.10 如何修改TTL表达式

要修改TTL表达式,可以使用ALTER TABLE ... MODIFY TTL命令。例如,假设我们有一个名为events的表,我们想要修改它的TTL表达式,可以这样操作:

ALTER TABLE events

MODIFY TTL

event_time + INTERVAL 1 WEEK;

这样就会将events表的TTL表达式修改为event\_time + INTERVAL 1 WEEK。

1.2.11 删除TTL表达式后,之前过期的数据会被恢复吗?

不会。删除TTL表达式只会影响未来的数据过期,它不会恢复已经过期的数据。如果你想要恢复已经过期的数据,你需要从备份中恢复数据。

1.2.12 如何强制执行TTL规则

在ClickHouse中,TTL规则的执行是在后台表合并期间进行的。如果你想强制执行TTL规则,可以使用OPTIMIZE命令来强制表合并。例如,假设我们有一个名为events的表,我们想要强制执行它的TTL规则,可以这样操作:

OPTIMIZE TABLE events FINAL;

这个命令会强制events表进行一次合并,从而触发TTL规则的执行。

需要注意的是,这种方法并不推荐经常使用,因为它会增加I/O开销并影响集群性能。通常情况下,你可以通过修改merge\_with\_ttl\_timeout设置来控制TTL规则执行的频率。

1.3 查询执行流程

在ClickHouse中,查询执行流程大致如下:

- 启动线程处理客户端接入的TCP连接;

- 接收请求数据,交给函数 executeQueryImpl () 处理;

- executeQueryImpl () 处理查询的SQL语句字符串;

- 生成 QueryPipeline 实例, QueryPipeline 实例可以包含数据也可以仅包含如何读取数据的信息;

- 通过 *PipelineExecutor 例如 PullingAsyncPipelineExecutor 执行 QueryPipeline 实例,获得数据结果。

ClickHouse使用向量化查询执行来加速查询处理。这意味着在执行过程中,操作尽可能在数组(向量或列块)上进行,而不是在单个值上进行。这有助于降低实际数据处理的成本。

当您向ClickHouse提交查询时,它会根据查询语句生成查询执行计划。然后,ClickHouse会按照执行计划执行查询,并将结果返回给客户端。

1.3.1 向量化查询执行

向量化查询执行是一种加速查询处理的技术。它通过在数组(向量或列块)上执行操作,而不是在单个值上执行操作,来降低实际数据处理的成本。这种方法可以更好地利用CPU的SIMD功能,从而提高查询性能。

简单来说,向量化查询执行就是将查询操作应用于一组数据,而不是逐个应用于每个数据。这样可以减少CPU指令的数量,提高查询速度。

在ClickHouse中,向量化查询执行是默认启用的,无需进行任何特殊配置。当您向ClickHouse提交查询时,它会自动使用向量化查询执行来加速查询处理。

向量化查询执行是一种查询执行技术,它能够提高查询性能。在标准的查询执行系统中,每次只处理一行数据,每次处理都要走过较长的代码路径和元数据解释,从而导致CPU使用率非常低。而在向量化查询执行中,每次处理包含多行记录的一批数据,每一批数据中的每一列都会被存储为一个向量(一个原始数据类型的数组),这就极大地减少了执行过程中的方法调用、反序列化和不必要的if-else操作,大大减少CPU的使用时间。

但是,向量化查询执行有一个限制,就是我们必须把要查询的数据存储为列式格式。例如磁盘列式存储格式:ORC、Parquet;内存列式存储格式:Arrow。

1.3.2 如何启用向量化查询执行

可以通过编写高效的SQL查询语句来充分利用向量化查询执行的优势。例如,尽量避免使用SELECT *,而是只选择需要的列;使用LIMIT来限制返回的行数;避免在WHERE子句中使用函数等。

启用向量化查询执行的方法取决于你使用的数据库。例如,在Hive中,要使用向量化查询执行,必须以ORC格式存储数据,并设置以下变量:set hive.vectorized.execution.enabled = true;。

1.3.3 哪些数据库支持向量化查询执行

有许多数据库支持向量化查询执行,包括Presto、Snowflake、SQLServer、Amazon Redshift等。Spark 2.x 的 SQL 引擎也开始支持向量化执行模型。

1.3.4 向量化查询执行的优势和劣势有哪些

向量化查询执行是指在执行数组(向量或列块)期间,尽可能地对数组进行操作,而不是对单个值进行操作。这有助于降低实际数据处理的成本。这种方法的优点包括更好地利用CPU缓存和允许使用SIMD CPU指令。

然而,向量化查询执行也有一些劣势。它涉及临时向量,必须写入缓存并读回。如果临时数据不适合L2缓存,这就成为一个问题。

另一种加速查询处理的方法是运行时代码生成,它消除了所有间接和动态调度。这两种方法都不是绝对优于另一种方法。运行时代码生成在融合许多操作时可能更好,从而充分利用CPU执行单元和流水线。研究表明,最好结合两种方法使用。

1.3.5 ClickHouse如何扩展

ClickHouse可以通过水平扩展来扩展。这意味着可以通过添加更多的服务器来增加系统的容量和性能。ClickHouse可以利用集群中所有可用的CPU内核和磁盘来执行甚至是单个查询。这使得它能够处理大量数据并快速响应复杂查询。

此外,ClickHouse还支持分片和复制。分片允许将数据分布在多个服务器上,以便每个服务器只需处理一部分数据。复制则允许在多个服务器上存储相同的数据,以提高可用性和容错能力。

1.3.6 什么是列式存储

列式存储是一种数据库存储技术,它将数据按列而不是按行存储。这意味着每一列的数据都存储在一起,而不是每一行的数据存储在一起。这种存储方式对于联机分析处理(OLAP)非常有用,因为它可以避免读取不必要的列,从而避免昂贵的磁盘读取操作。此外,将同一列的不同值存储在一起通常会导致更好的压缩比率(与行式系统相比),因为在实际数据中,相邻行的同一列通常具有相同或不太多的不同值。

1.3.7 ClickHouse的列式存储有哪些优缺点

ClickHouse的列式存储有许多优点,包括:

- 避免读取不必要的列:源数据通常包含数百甚至数千列,而报表只使用其中的几列。系统需要避免读取不必要的列,以避免昂贵的磁盘读取操作。

- 数据压缩:将同一列的不同值存储在一起通常会导致更好的压缩比率(与行式系统相比),因为在实际数据中,相邻行的同一列通常具有相同或不太多的不同值。此外,除了通用压缩外,ClickHouse还支持专用编解码器,可以使数据更加紧凑。

- 向量化查询执行:ClickHouse不仅将数据存储在列中,而且还按列处理数据。这导致更好地利用CPU缓存,并允许使用SIMD CPU指令。

然而,与任何技术一样,列式存储也有一些劣势。例如,在处理事务性工作负载时,它可能不如行式存储高效。此外,在更新数据时,它可能需要更多的时间和资源来维护列式结构。

1.3.8 SIMD计算机处理器指令集架构

SIMD(Single Instruction Multiple Data)是一种计算机处理器指令集架构,它允许一条指令同时对多个数据进行操作。这种架构可以大大提高数据并行处理的效率。

例如,假设您需要将两个长度为4的整数数组相加。在传统的标量处理器中,需要执行4次加法指令,每次对数组中的一个元素进行操作。但是,在支持SIMD的处理器中,您可以使用一条SIMD加法指令,一次性将两个数组中的所有元素相加。

向量化查询执行可以更好地利用CPU的SIMD功能,从而提高查询性能。

可以通过查询CPU的技术文档来检查CPU是否支持SIMD。大多数现代CPU都支持至少一种SIMD指令集,例如Intel的SSE和AVX指令集,以及ARM的NEON指令集。

此外,还可以在操作系统中使用特定的工具来检查CPU是否支持SIMD。例如,在Linux和macOS中,可以使用sysctl -a | grep machdep.cpu.features命令来查看CPU支持的指令集。在Windows中,可以使用CPU-Z等第三方工具来查看CPU信息。

1.3.9 ClickHouse如何使用SIMD CPU指令

SIMD(单指令多数据)是一种允许CPU同时对多个数据元素执行相同操作的技术。ClickHouse通过向量化查询执行来利用SIMD指令。这意味着它不仅将数据存储在列中,而且还按列处理数据。这导致更好地利用CPU缓存,并允许使用SIMD CPU指令。

2. 数据建模

2.1 表结构设计

在ClickHouse中,表结构设计是数据建模的重要组成部分。表结构设计包括选择合适的列类型、定义主键和索引、设置分区键等。

-

列类型:ClickHouse支持多种数据类型,包括数值类型、字符串类型、日期和时间类型等。你应该根据数据的实际情况选择合适的列类型。

-

主键和索引:在ClickHouse中,主键和索引的设计对查询性能有很大影响。你应该仔细考虑主键和索引的设计,以便在查询时能够快速定位数据。ClickHouse还支持数据跳过索引,可以用来跳过不需要的数据块,从而提高查询性能。

-

分区键:分区键是表结构设计中的一个关键因素。分区可以是任意表达式,但通常是时间段,如月、日或周。ClickHouse会尽力通过使用最小的分区集来最小化读取的数据量。

2.1.1 如何选择合适的列类型

在ClickHouse中,选择合适的列类型是很重要的。你应该根据数据的实际情况选择合适的列类型。ClickHouse支持多种数据类型,包括数值类型、字符串类型、日期和时间类型等。

-

数值类型:ClickHouse支持有符号和无符号整数(如

UInt8、UInt16、UInt32、UInt64、Int8、Int16、Int32、Int64等),以及浮点数(如Float32和Float64)和十进制数。 -

字符串类型:ClickHouse支持两种字符串类型:

String和FixedString。其中,String类型用于存储可变长度的字符串,而FixedString(N)类型用于存储固定长度为N的字符串。 -

日期和时间类型:ClickHouse支持多种日期和时间类型,包括

Date、DateTime、DateTime64等。

此外,ClickHouse还支持一些特殊的数据类型,如数组、元组、枚举、低基数类型等。你可以根据实际情况选择合适的数据类型来存储数据。

2.1.2 如何定义主键和索引

在ClickHouse中,主键和索引的定义对查询性能有很大影响。你可以在创建表时使用CREATE TABLE语句来定义主键和索引。

- 主键:主键用于定义数据的排序顺序,以便在查询时能够快速定位数据。你可以在创建表时使用

ORDER BY子句来指定主键。例如,假设我们有一个名为events的表,其中包含event\_time和event\_type两个字段,我们想要按照event\_time和event\_type来排序数据,可以这样创建表:

CREATE TABLE events (

event_time DateTime,

event_type UInt8,

...

) ENGINE = MergeTree

ORDER BY (event_time, event_type);

需要注意的是,主键并不要求唯一。你可以插入多行具有相同主键值的数据。

- 索引:ClickHouse支持数据跳过索引,可以用来跳过不需要的数据块,从而提高查询性能。你可以在创建表时使用

INDEX子句来定义索引。例如,假设我们有一个名为events的表,其中包含一个名为value的字段,我们想要为这个字段创建一个索引,可以这样创建表:

CREATE TABLE events (

event_time DateTime,

event_type UInt8,

value UInt32,

...

INDEX value_index value TYPE minmax GRANULARITY 3

) ENGINE = MergeTree

ORDER BY (event_time, event_type);

在这个例子中,我们为value列创建了一个名为value\_index的索引。索引类型为minmax,粒度为3。

2.1.3 什么是低基数类型

LowCardinality是ClickHouse中的一种数据类型,它可以用来修改其他数据类型,以改变数据的存储方式和处理规则。ClickHouse会对LowCardinality列进行字典编码,从而提高查询性能。

使用LowCardinality数据类型的效率取决于数据的多样性。如果字典中包含的不同值少于10,000个,那么ClickHouse通常会显示更高的数据读取和存储效率。如果字典中包含的不同值超过100,000个,那么ClickHouse可能会比使用普通数据类型更差。

例如,假设我们有一个名为events的表,其中包含一个名为event\_type的字段,这个字段只包含少量不同的值。我们可以使用LowCardinality数据类型来存储这个字段,以提高查询性能:

CREATE TABLE events (

event_time DateTime,

event_type LowCardinality(UInt8),

...

) ENGINE = MergeTree

ORDER BY (event_time);

在这个例子中,我们为event\_type列指定了LowCardinality(UInt8)类型。这意味着ClickHouse会对这个列进行字典编码,从而提高查询性能。

你可以在ClickHouse文档中查看更多关于LowCardinality数据类型的信息。

2.1.4 如何修改主键和索引

在ClickHouse中,主键和索引是在创建表时定义的,之后不能更改。如果你想要修改主键或索引,你需要重新创建表并导入数据。

例如,假设我们有一个名为events的表,其中包含event\_time和event\_type两个字段。我们想要修改主键,可以这样操作:

- 创建一个新表,指定新的主键:

CREATE TABLE events_new (

event_time DateTime,

event_type UInt8,

...

) ENGINE = MergeTree

ORDER BY (event_type, event_time);

- 将旧表中的数据导入新表:

INSERT INTO events_new SELECT * FROM events;

- 删除旧表:

DROP TABLE events;

- 将新表重命名为旧表:

RENAME TABLE events_new TO events;

这样就完成了主键的修改。需要注意的是,这种方法会导致数据丢失,因此在执行操作前应该先备份数据。

2.1.5 如何优化查询性能

在ClickHouse中,有多种方法可以优化查询性能。下面是一些常用的方法:

-

选择合适的列类型:选择合适的列类型可以提高查询性能。例如,对于包含少量不同值的列,可以使用

LowCardinality数据类型来提高查询性能。 -

定义主键和索引:主键和索引的定义对查询性能有很大影响。你应该仔细考虑主键和索引的设计,以便在查询时能够快速定位数据。

-

设置分区键:分区键是表结构设计中的一个关键因素。分区可以是任意表达式,但通常是时间段,如月、日或周。ClickHouse会尽力通过使用最小的分区集来最小化读取的数据量。

-

优化查询语句:你应该仔细检查查询语句,确保它们是高效的。例如,你应该尽量避免使用笛卡尔积,而是使用

JOIN子句来连接表。 -

使用预处理数据:如果你需要对大量数据进行复杂的计算,可以考虑使用预处理数据来提高查询性能。例如,你可以创建一个物化视图来存储预处理后的数据,然后在查询时直接使用这些数据。

在ClickHouse中,表的分片和表的分区是两个不同的概念。

表的分片是指将表中的数据分布到不同的服务器上,以提高查询性能和容错能力。当你在ClickHouse集群中创建分布式表时,你需要指定表的分片键。ClickHouse会根据分片键来将数据分布到不同的分片中。

表的分区是指将表中的数据按照某个条件划分为多个部分,以提高查询性能。当你在创建表时,你可以使用

PARTITION BY语法来指定表的分区键。ClickHouse会根据分区键来将数据划分为多个部分。因此,表的分片和表的分区之间并没有直接的关系。它们都可以用来提高查询性能,但它们的实现方式和使用场景不同。

2.2 分区策略

在ClickHouse中,分区策略是指如何根据业务需求选择合适的分区键来划分表中的数据。分区可以帮助提高查询性能,因为ClickHouse会尽量只访问与查询相关的分区。

在设计分区策略时,应考虑以下几点:

-

**选择合适的分区键**:分区键可以是任意表达式,但通常是时间段,如月、日或周。应根据业务需求选择合适的分区键。

-

**避免过于细粒度的分区**:您应避免过于细粒度的分区(超过大约一千个分区)。否则,由于文件系统中文件数量过多和打开文件描述符过多,SELECT查询的性能将变差。

-

**管理分区**:ClickHouse提供了一些操作来管理分区,包括删除、移动和添加分区等。应定期维护分区以保持数据组织良好。

2.2.1 如何选择合适的分区键

选择合适的分区键是分区策略中非常重要的一步。分区键应该能够将数据分成多个部分,且每个部分都包含一定范围内的数据。通常,分区键应该满足以下几点要求:

- **查询相关性**:分区键应该与查询条件相关,这样可以提高查询性能。

- **数据分布均匀**:分区键应该能够将数据均匀地分布在各个分区中,避免出现数据倾斜的情况。

- **易于维护**:分区键应该易于维护,方便添加、删除和修改分区。

2.2.2 如何确定分区粒度

确定分区粒度是指确定每个分区包含多少数据。这取决于查询模式和硬件配置。

如果查询主要是针对某个时间范围内的数据,那么可以考虑按时间分区,每个分区包含一定时间范围内的数据。例如,如果您的查询主要是针对最近一周内的数据,那么可以将数据按天分区,每个分区包含一天内的数据。

如果硬件配置较高,可以考虑使用更细粒度的分区,这样可以进一步提高查询性能。但是,细粒度的分区会增加维护成本,因此需要在查询性能和维护成本之间进行权衡。

2.2.3 如何避免数据倾斜

数据倾斜是指数据分布不均匀,导致某些分区中的数据量远大于其他分区。这会影响查询性能,因为查询需要在大量数据中进行,而不是在少量数据中进行。

要避免数据倾斜,需要选择一个合适的分区键,使得数据能够均匀地分布在各个分区中。例如,如果您的数据中有一个地区列,且每个地区的数据量大致相同,那么可以考虑使用地区作为分区键。

此外,可以定期检查数据分布情况,如果发现数据倾斜严重,可以考虑重新调整分区策略。

2.2.4 如何使用时间作为分区键

如果您的数据具有生命周期,那么可以考虑使用时间作为分区键。这样可以方便地删除过期数据,也可以提高查询性能。

要使用时间作为分区键,首先需要在建表时指定分区键。例如,如果您想按月分区,可以这样建表:

CREATE TABLE mytable (

...

EventDate Date,

...

) ENGINE = MergeTree()

PARTITION BY toYYYYMM(EventDate)

上面的代码中,我们使用了toYYYYMM(EventDate)作为分区键,这样就可以按月分区。

在插入数据时,需要确保EventDate列的值正确。例如,如果您想插入2022年1月1日的数据,可以这样插入:

INSERT INTO mytable (..., EventDate, ...) VALUES (..., '2022-01-01', ...)

2.2.5 如何检查数据分布情况

要检查数据分布情况,可以使用system.parts表。这个表包含了每个分区的信息,包括分区键的值、分区中的数据量等。

例如,如果您想查看每个分区中的数据量,可以这样查询:

SELECT

partition,

count()

FROM system.parts

WHERE table = 'mytable'

GROUP BY partition

ORDER BY partition

上面的查询会返回每个分区中的数据量。您可以根据查询结果来判断数据是否分布均匀。

2.2.6 如何重新调整分区策略

如果发现当前的分区策略不再满足需求,可以考虑重新调整分区策略。这需要重新建立一个新表,并将旧表中的数据迁移到新表中。

首先,需要创建一个新表,使用新的分区策略。例如,如果您想按周分区,可以这样建表:

CREATE TABLE mytable_new (

...

EventDate Date,

...

) ENGINE = MergeTree()

PARTITION BY toYearWeek(EventDate)

然后,可以使用INSERT INTO ... SELECT语句将旧表中的数据迁移到新表中:

INSERT INTO mytable_new

SELECT * FROM mytable

最后,可以删除旧表,并将新表重命名为旧表的名称:

DROP TABLE mytable;

RENAME TABLE mytable_new TO mytable;

2.3 分片策略

在ClickHouse中,分片是一种水平扩展集群的策略,它将一个ClickHouse数据库的部分数据放在不同的分片上。每个分片由一个或多个副本主机组成。对分片的写入或读取请求可以发送到其任何一个副本,因为没有专用的主节点。

当插入数据时,数据从执行INSERT请求的副本中取出,并以异步模式复制到分片中的其他副本。当执行SELECT查询时,ClickHouse会将子查询发送到集群中的所有分片,而不管数据如何分布在分片上。

2.3.1 如何创建分片表

要使用分片,需要创建一个分布式表,该表使用这些分片。可以直接访问分片表中的数据,也可以通过分布式表访问数据。

在ClickHouse中,您可以使用分布式表引擎创建分布式表。分布式表不存储任何数据,而是允许在多个服务器上进行分布式查询处理。读取会自动并行化。在读取过程中,如果远程服务器上有表索引,则会使用它们¹。

下面是一个创建分布式表的示例:

CREATE TABLE [IF NOT EXISTS] [db.]table_name [ON CLUSTER cluster]

(

name1 [type1] [DEFAULT|MATERIALIZED|ALIAS expr1],

name2 [type2] [DEFAULT|MATERIALIZED|ALIAS expr2],

...

)

ENGINE = Distributed(cluster, database, table[, sharding_key[, policy_name]])

其中,cluster是集群名称;database是远程数据库名称;table是远程表名称;sharding\_key是可选的分片键;policy\_name是可选的策略名称。

2.3.2 如何选择分片键

在ClickHouse中,分片键用于确定数据应该存储在哪个分片上。它的值决定了查询被定向到哪个分片。分片键类似于分区键。

选择合适的分片键非常重要,因为它可以确保数据在分片之间逻辑分布,并且与不同分片中的数据没有关联。这样可以更好地利用分片带来的性能优势。

在选择分片键时,应考虑以下几点:

-

**业务需求**:您应根据业务需求选择合适的分片键。例如,如果您的查询通常按客户ID进行过滤,则可以使用客户ID作为分片键。

-

**均匀分布**:您应选择能够将数据均匀分布在所有分片上的分片键。这样可以避免某些分片过载,而其他分片空闲的情况。

-

**可扩展性**:您应选择能够支持集群扩展的分片键。例如,如果您使用哈希函数作为分片键,则可以在添加新的分片时重新哈希数据以实现扩展。

2.3.3 如何确保数据均匀分布

在ClickHouse中,您可以通过选择合适的分片键来确保数据在分片之间均匀分布。分片键应能够将数据均匀分布在所有分片上,以避免某些分片过载,而其他分片空闲的情况。

例如,可以使用哈希函数作为分片键。哈希函数可以将数据均匀分布在所有分片上,从而避免数据倾斜。但是,应注意选择合适的哈希函数,以确保数据均匀分布。

此外,还可以定期监控数据分布情况,并在必要时调整分片策略。例如,如果发现某些分片过载,而其他分片空闲,则可以考虑更改分片键或重新分配数据。

2.3.4 如何使用哈希函数作为分片键

在ClickHouse中,您可以使用哈希函数作为分片键来确保数据在分片之间均匀分布。哈希函数可以将数据均匀分布在所有分片上,从而避免数据倾斜。

下面是一个使用哈希函数作为分片键的示例:

CREATE TABLE [IF NOT EXISTS] [db.]table_name [ON CLUSTER cluster]

(

name1 [type1] [DEFAULT|MATERIALIZED|ALIAS expr1],

name2 [type2] [DEFAULT|MATERIALIZED|ALIAS expr2],

...

)

ENGINE = Distributed(cluster, database, table, cityHash64(sharding_key), policy_name)

其中,sharding\_key是您要使用的分片键。在这个示例中,我们使用cityHash64函数对sharding\_key进行哈希,以确保数据在分片之间均匀分布。

但是,应注意选择合适的哈希函数和分片键,以确保数据均匀分布。

3. 索引优化

3.1 索引类型

在ClickHouse中,索引是用来加速查询的一种数据结构。它可以帮助查询引擎快速定位需要查询的数据,从而提高查询性能。

ClickHouse支持多种类型的索引,包括:

- **主键索引**:主键索引是用来加速

ORDER BY和GROUP BY查询的。它通过对数据进行排序和分组,来加速这些查询。 - **最小/最大索引**:最小/最大索引是用来加速范围查询的。它通过存储每个分区中数据的最小值和最大值,来帮助查询引擎快速定位需要查询的分区。

- **Set索引**:Set索引是用来加速

IN和NOT IN查询的。它通过存储每个分区中数据的集合,来帮助查询引擎快速定位需要查询的分区。 - **ngram索引**:ngram索引是用来加速文本搜索的。它通过将文本分成多个ngram,然后建立倒排索引,来加速文本搜索。

3.1.1 如何创建主键索引

在ClickHouse中,可以在建表时指定主键,来创建主键索引。例如,如果想创建一个包含EventDate和UserID两列的主键索引,可以这样建表:

CREATE TABLE mytable (

...

EventDate Date,

UserID UInt64,

...

) ENGINE = MergeTree()

PARTITION BY toYYYYMM(EventDate)

ORDER BY (EventDate, UserID)

上面的代码中,我们使用了ORDER BY (EventDate, UserID)来指定主键。这样就可以创建一个包含EventDate和UserID两列的主键索引。

在插入数据时,需要确保数据按照主键排序。例如,如果您想插入一条数据,可以这样插入:

INSERT INTO mytable (..., EventDate, UserID, ...) VALUES (..., '2022-01-01', 12345, ...)

3.1.2 如何创建最小/最大索引

在ClickHouse中,最小/最大索引是默认创建的,无需手动创建。当创建一个表时,ClickHouse会自动为每个分区创建最小/最大索引。

最小/最大索引会存储每个分区中每列数据的最小值和最大值。当您执行范围查询时,ClickHouse会使用这些信息来快速定位需要查询的分区。

例如,如果您想查询EventDate在2022年1月1日到2022年1月7日之间的数据,可以这样查询:

SELECT * FROM mytable

WHERE EventDate >= '2022-01-01' AND EventDate <= '2022-01-07'

上面的查询会使用最小/最大索引来快速定位需要查询的分区。

3.1.3 如何创建Set索引

在ClickHouse中,可以使用CREATE SET语句来创建Set索引。例如,如果您想为mytable表中的UserID列创建Set索引,可以这样创建:

CREATE SET myset ENGINE = Set AS SELECT UserID FROM mytable

上面的代码会创建一个名为myset的Set索引,包含mytable表中所有UserID的值。

在执行查询时,可以使用IN和NOT IN语句来使用Set索引。例如,如果您想查询UserID在Set索引中的数据,可以这样查询:

SELECT * FROM mytable

WHERE UserID IN myset

上面的查询会使用Set索引来快速定位需要查询的数据。

3.1.4 如何创建ngram索引

在ClickHouse中,可以使用ngrambf\_v1函数来创建ngram索引。这个函数可以将文本分成多个ngram,然后建立倒排索引。

例如,如果您想为mytable表中的content列创建ngram索引,可以这样创建:

CREATE MATERIALIZED VIEW myindex

ENGINE = MergeTree()

ORDER BY tuple()

POPULATE

AS SELECT

ngrambf_v1(3, 5, content) AS ngrams,

count() AS c

FROM mytable

GROUP BY ngrams

上面的代码会创建一个名为myindex的物化视图,包含mytable表中content列的ngram索引。其中,ngrambf\_v1(3, 5, content)表示将文本分成3到5个字符的ngram。

在执行查询时,可以使用MATCH语句来使用ngram索引。例如,如果您想查询包含文本“hello”的数据,可以这样查询:

SELECT * FROM mytable

WHERE hasToken(ngrambf_v1(3, 5, content), 'hello')

上面的查询会使用ngram索引来快速定位需要查询的数据。

3.1.5 如何修改主键

在ClickHouse中,目前还不支持直接修改主键。如果想修改主键,需要重新建立一个新表,并将旧表中的数据迁移到新表中。

首先,需要创建一个新表,使用新的主键。例如,如果您想创建一个包含EventDate和UserID两列的主键索引,可以这样建表:

CREATE TABLE mytable_new (

...

EventDate Date,

UserID UInt64,

...

) ENGINE = MergeTree()

PARTITION BY toYYYYMM(EventDate)

ORDER BY (EventDate, UserID)

然后,可以使用INSERT INTO ... SELECT语句将旧表中的数据迁移到新表中:

INSERT INTO mytable_new

SELECT * FROM mytable

最后,可以删除旧表,并将新表重命名为旧表的名称:

DROP TABLE mytable;

RENAME TABLE mytable_new TO mytable;

3.1.6 如何查看最小/最大索引信息

在ClickHouse中,可以使用system.parts\_columns表来查看最小/最大索引信息。这个表包含了每个分区中每列数据的最小值和最大值。

例如,如果您想查看mytable表中value列的最小/最大索引信息,可以这样查询:

SELECT

partition,

min_value,

max_value

FROM system.parts_columns

WHERE table = 'mytable' AND column = 'value'

ORDER BY partition

上面的查询会返回每个分区中value列的最小值和最大值。您可以根据查询结果来判断数据是否分布均匀。

3.1.7 如何更新Set索引

在ClickHouse中,Set索引不会自动更新。如果数据发生了变化,需要手动更新Set索引。

要更新Set索引,可以使用ALTER TABLE ... UPDATE语句。例如,如果您想更新myset索引,可以这样更新:

ALTER TABLE myset

UPDATE x = (SELECT groupArray(UserID) FROM mytable) WHERE 1

上面的代码会将myset索引中的数据更新为mytable表中所有UserID的值。

需要注意的是,更新Set索引可能会影响查询性能,因此建议在业务低峰期进行更新。

3.1.8 如何更新ngram索引

在ClickHouse中,ngram索引是通过物化视图实现的。如果数据发生了变化,需要手动更新物化视图。

要更新物化视图,可以使用ALTER TABLE ... DELETE语句删除旧数据,然后使用INSERT INTO ... SELECT语句插入新数据。例如,如果您想更新myindex物化视图,可以这样更新:

ALTER TABLE myindex DELETE WHERE 1;

INSERT INTO myindex

SELECT

ngrambf_v1(3, 5, content) AS ngrams,

count() AS c

FROM mytable

GROUP BY ngrams

上面的代码会删除myindex物化视图中的所有数据,然后重新插入mytable表中content列的ngram索引。

需要注意的是,更新物化视图可能会影响查询性能,因此建议在业务低峰期进行更新。

3.1.9 如何定期更新Set索引

在ClickHouse中,可以使用定时任务来定期更新Set索引。您可以在操作系统中创建一个定时任务,定期执行更新Set索引的命令。

例如,在Linux系统中,可以使用crontab命令来创建定时任务。假设您想每天凌晨1点更新myset索引,可以这样创建定时任务:

# 编辑crontab

crontab -e

# 在crontab中添加以下内容

0 1 * * * clickhouse-client --query "ALTER TABLE myset

UPDATE x = (SELECT groupArray(UserID) FROM mytable) WHERE 1"

上面的代码会在每天凌晨1点执行ALTER TABLE ... UPDATE语句,更新myset索引。

需要注意的是,更新Set索引可能会影响查询性能,因此建议在业务低峰期进行更新。

3.1.10 适用场景和注意事项

在ClickHouse中,索引是用来加速查询的一种数据结构。不同类型的索引适用于不同的查询场景,使用时需要注意以下几点:

- **主键索引**:主键索引适用于

ORDER BY和GROUP BY查询。在设计主键时,应该选择与查询条件相关的列作为主键,以提高查询性能。 - **最小/最大索引**:最小/最大索引适用于范围查询。它会自动创建,无需手动维护。

- **Set索引**:Set索引适用于

IN和NOT IN查询。在使用Set索引时,需要注意Set索引不会自动更新,如果数据发生变化,需要手动更新Set索引。 - **ngram索引**:ngram索引适用于文本搜索。在使用ngram索引时,需要注意ngram索引不会自动更新,如果数据发生变化,需要手动更新ngram索引。

3.2 索引选择性

在索引优化中,索引选择性是一个重要的概念。索引选择性指的是索引能够缩小搜索范围的程度。具有高选择性的索引可以大大减少查询所需扫描的数据量,从而提高查询性能。

例如,假设我们有一个包含1000万行数据的表,其中有一个名为“性别”的列,只有两个可能的值:“男”和“女”。如果我们在这一列上创建索引,那么这个索引的选择性就非常低,因为它只能将搜索范围缩小到一半。相反,如果我们在一个具有大量唯一值的列上创建索引,那么这个索引的选择性就会非常高。

因此,在选择要创建索引的列时,应该尽量选择具有高选择性的列。这样可以最大限度地提高查询性能。

在确定索引选择性时,可以通过计算列中不同值的数量与总行数的比值来估算。例如,如果一列中有1000万行数据,其中有100万个不同值,则该列的选择性为100万/1000万=0.1。通常来说,选择性越高,索引对查询性能的提升就越大。

此外,在使用索引时也应注意一些问题。例如,在进行复杂计算或函数运算时,索引可能无法发挥作用;在数据量较小或查询条件过于复杂时,全表扫描可能比使用索引更快。

总之,在进行索引优化时,应该综合考虑各种因素,合理选择索引列,并注意使用索引时可能遇到的问题。

3.3 索引创建和维护

在ClickHouse中,索引优化是一个重要的部分。它可以帮助提高查询性能。在创建索引时,应尽量选择基数大的,也就是重复相对较多的列作为索引列。这是因为ClickHouse使用稀疏索引。

在创建和维护索引时,还应注意以下几点:

- 索引列应该是查询条件中经常被用来充当筛选条件的属性。

- 可以是单一维度,也可以是组合维度的索引,通常需要满足高级列在前、查询频率大的在前原则²。

- 基数特别大的不适合做索引列。

3.3.1 稀疏索引

稀疏索引是一种索引类型,它不是为每一行创建索引,而是为一组数据行(称为颗粒(granule))构建一个索引条目。这种索引类型可以帮助提高查询性能,尤其是在大数据场景下的范围查询和数据分析。

在ClickHouse中,稀疏索引可通过 PRIMARY KEY 语法指定。它的功能上类似于MySQL中的主键索引,但实现原理上是截然不同的。ClickHouse的稀疏索引存储的是每一个颗粒中起始行的主键值,而MergeTree存储中的数据是按照主键严格排序的。所以当查询给定主键条件时,我们可以根据主键索引确定数据可能存在的颗粒。

3.3.2 如何创建稀疏索引

在ClickHouse中,稀疏索引可通过 PRIMARY KEY 语法指定。例如,下面的代码创建了一个名为 mytable 的表,并指定了 column1 和 column2 作为主键,从而创建了稀疏索引:

CREATE TABLE mytable (

column1 String,

column2 Int32,

column3 Float64

) ENGINE = MergeTree()

PRIMARY KEY (column1, column2)

ORDER BY (column1, column2);

3.3.3 如何使用稀疏索引

在ClickHouse中,稀疏索引的使用是自动的。当你在查询中使用了主键列作为筛选条件时,ClickHouse会自动使用稀疏索引来加速查询。例如,如果你创建了一个表并指定了 column1 和 column2 作为主键,那么当你执行以下查询时,ClickHouse会自动使用稀疏索引来加速查询:

SELECT * FROM mytable WHERE column1 = 'value1' AND column2 = 123;

3.3.4 如何创建组合维度的索引

在ClickHouse中,你可以创建组合维度的稀疏索引,也就是指定多个列作为主键。例如,下面的代码创建了一个名为 mytable 的表,并指定了 column1 和 column2 作为主键,从而创建了组合维度的稀疏索引:

CREATE TABLE mytable (

column1 String,

column2 Int32,

column3 Float64

) ENGINE = MergeTree()

PRIMARY KEY (column1, column2)

ORDER BY (column1, column2);

3.3.5 如何维护索引

在ClickHouse中,稀疏索引的维护是自动的。当你插入、更新或删除数据时,ClickHouse会自动更新稀疏索引。你不需要手动维护稀疏索引。

但是,你可以通过优化表来提高稀疏索引的性能。例如,你可以使用 OPTIMIZE 语句来合并数据分区,从而提高稀疏索引的性能。下面是一个示例:

OPTIMIZE TABLE mytable FINAL;

你也可以指定要合并的数据分区。例如,下面的代码将合并 mytable 表中 partition1 数据分区:

OPTIMIZE TABLE mytable PARTITION 'partition1' FINAL;

需要注意的是,OPTIMIZE 语句可能会消耗大量的计算资源和时间。因此,在执行 OPTIMIZE 语句之前,你应该确保它是必要的。

在ClickHouse中,你可以使用多个 OPTIMIZE 语句来合并多个数据分区。例如,下面的代码将合并 mytable 表中 partition1 和 partition2 数据分区:

OPTIMIZE TABLE mytable PARTITION 'partition1' FINAL;

OPTIMIZE TABLE mytable PARTITION 'partition2' FINAL;

需要注意的是,每个 OPTIMIZE 语句只能指定一个数据分区。如果你想合并多个数据分区,你需要使用多个 OPTIMIZE 语句。

4. 查询优化

4.1 避免SELECT *

在ClickHouse中,避免使用 SELECT \* 是一个重要的查询优化技巧。当你使用 SELECT \* 时,ClickHouse会返回表中的所有列,这可能会导致查询速度变慢,尤其是当表中包含大量列时。

为了提高查询性能,你应该尽量避免使用 SELECT \*,而是明确指定需要返回的列。例如,下面的代码只返回 column1 和 column2 列:

SELECT column1, column2 FROM mytable WHERE column3 = 'value';

这样,ClickHouse只需要读取和处理 column1 和 column2 列,从而提高查询性能。

4.2 使用LIMIT

在ClickHouse中,使用 LIMIT 是一个重要的查询优化技巧。当你在查询中使用 LIMIT 时,ClickHouse会限制返回的行数,从而提高查询性能。

例如,下面的代码只返回前10行数据:

SELECT column1, column2 FROM mytable WHERE column3 = 'value' LIMIT 10;

这样,ClickHouse只需要处理前10行数据,从而提高查询性能。

需要注意的是,LIMIT 只限制返回的行数,而不会影响查询的执行方式。因此,在某些情况下,使用 LIMIT 可能并不能显著提高查询性能。

4.3 避免在WHERE子句中使用函数

在ClickHouse中,避免在 WHERE 子句中使用函数是一个重要的查询优化技巧。当你在 WHERE 子句中使用函数时,ClickHouse需要对每一行数据执行函数计算,这可能会导致查询速度变慢。

为了提高查询性能,你应该尽量避免在 WHERE 子句中使用函数。例如,下面的代码在 WHERE 子句中使用了 LOWER 函数:

SELECT column1, column2 FROM mytable WHERE LOWER(column3) = 'value';

为了提高查询性能,你可以改为使用以下代码:

SELECT column1, column2 FROM mytable WHERE column3 = 'VALUE';

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

4. 查询优化

4.1 避免SELECT *

在ClickHouse中,避免使用 SELECT \* 是一个重要的查询优化技巧。当你使用 SELECT \* 时,ClickHouse会返回表中的所有列,这可能会导致查询速度变慢,尤其是当表中包含大量列时。

为了提高查询性能,你应该尽量避免使用 SELECT \*,而是明确指定需要返回的列。例如,下面的代码只返回 column1 和 column2 列:

SELECT column1, column2 FROM mytable WHERE column3 = 'value';

这样,ClickHouse只需要读取和处理 column1 和 column2 列,从而提高查询性能。

4.2 使用LIMIT

在ClickHouse中,使用 LIMIT 是一个重要的查询优化技巧。当你在查询中使用 LIMIT 时,ClickHouse会限制返回的行数,从而提高查询性能。

例如,下面的代码只返回前10行数据:

SELECT column1, column2 FROM mytable WHERE column3 = 'value' LIMIT 10;

这样,ClickHouse只需要处理前10行数据,从而提高查询性能。

需要注意的是,LIMIT 只限制返回的行数,而不会影响查询的执行方式。因此,在某些情况下,使用 LIMIT 可能并不能显著提高查询性能。

4.3 避免在WHERE子句中使用函数

在ClickHouse中,避免在 WHERE 子句中使用函数是一个重要的查询优化技巧。当你在 WHERE 子句中使用函数时,ClickHouse需要对每一行数据执行函数计算,这可能会导致查询速度变慢。

为了提高查询性能,你应该尽量避免在 WHERE 子句中使用函数。例如,下面的代码在 WHERE 子句中使用了 LOWER 函数:

SELECT column1, column2 FROM mytable WHERE LOWER(column3) = 'value';

为了提高查询性能,你可以改为使用以下代码:

SELECT column1, column2 FROM mytable WHERE column3 = 'VALUE';

[外链图片转存中…(img-sAHsoTEY-1715736193299)]

[外链图片转存中…(img-xjQOqe4w-1715736193299)]

[外链图片转存中…(img-LxkGq8xT-1715736193300)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

522

522

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?