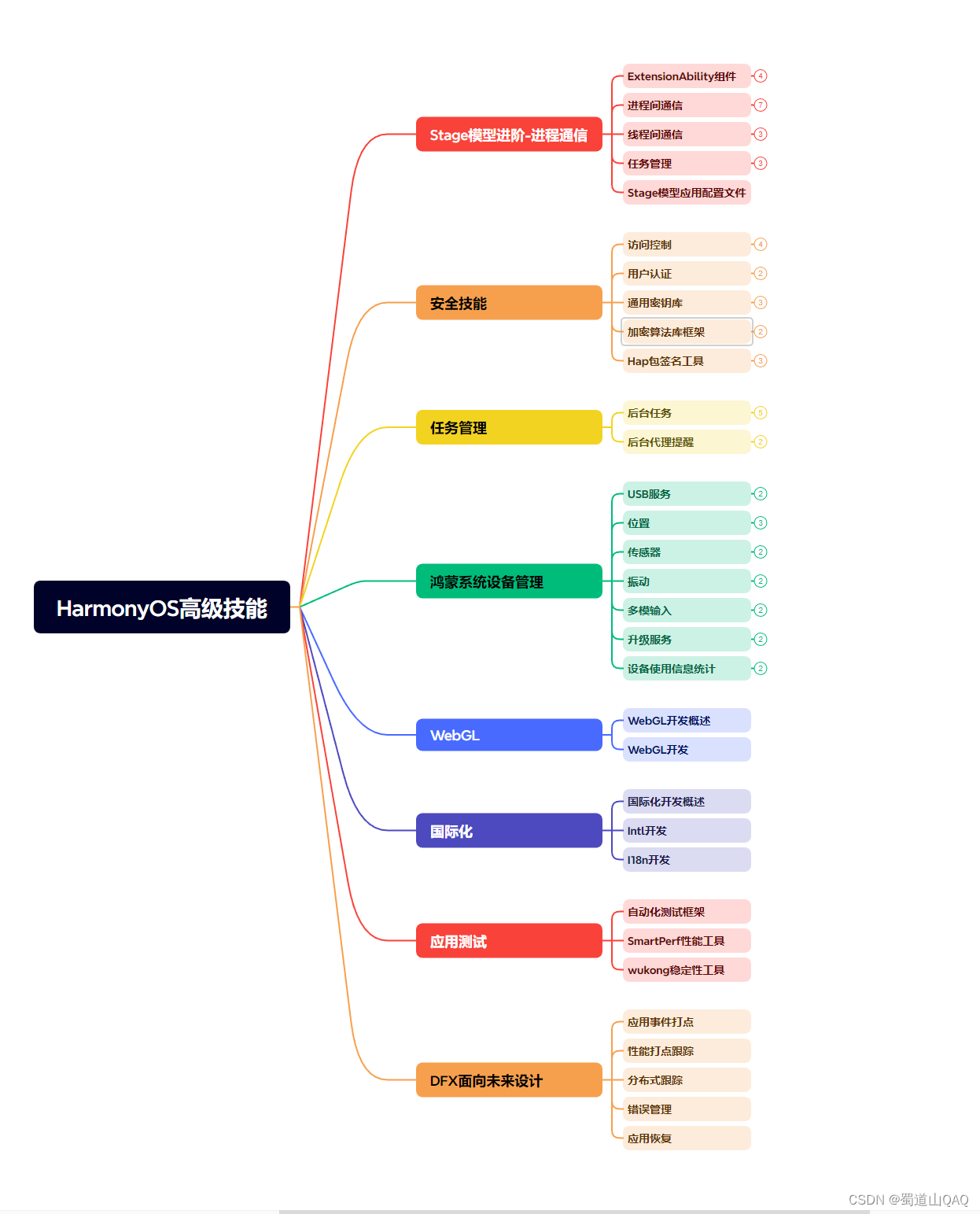

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

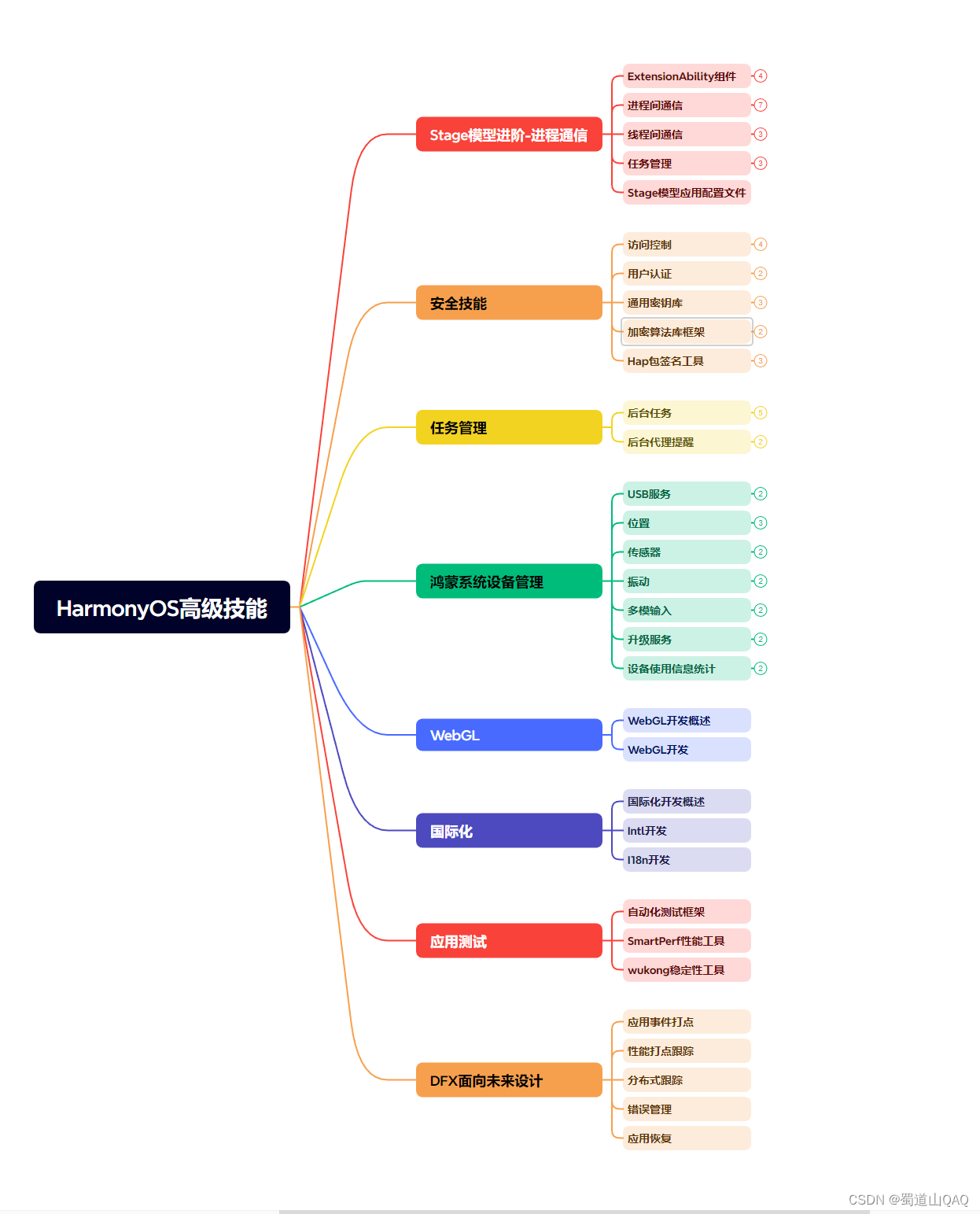

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上鸿蒙开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

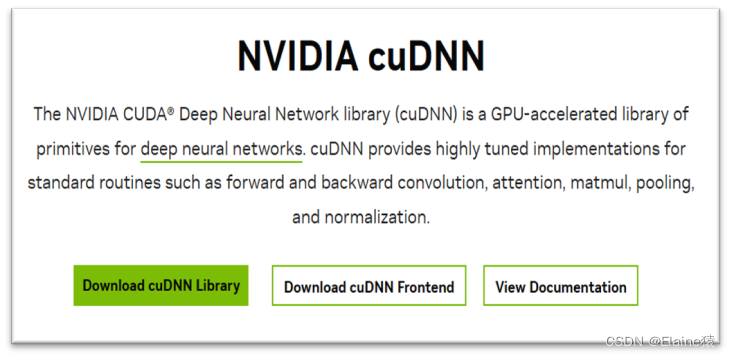

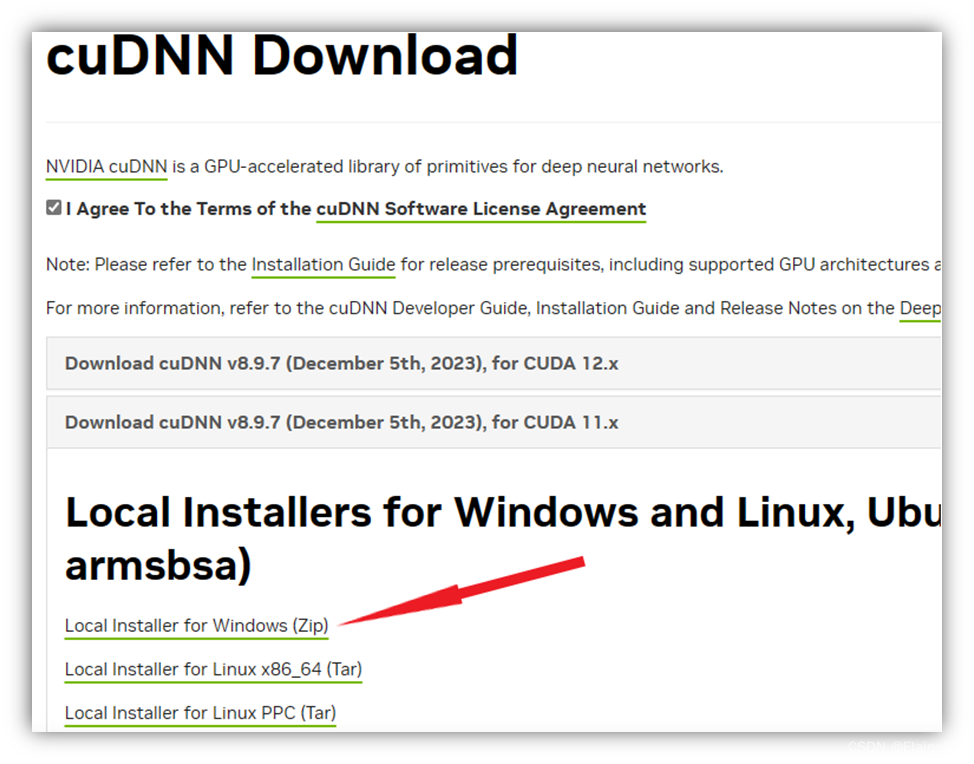

⑤ 安装CUDNN : 进入以下网址,需要进行注册下载

NVIDIA官网(https://developer.nvidia.com/cudnn)

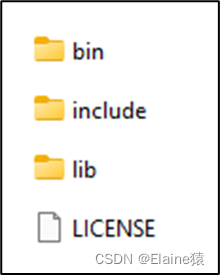

下载后将cudnn解压为一个文件夹,将以下文件复制到cuda的根目录下

在系统高级设置中添加如下环境变量:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\bin

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\include

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\lib

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\libnvvp

Part4. 制作数据集

PPOCRLabel就是跟PaddleOCR配套的标注工具

前面在介绍环境搭建过程中已下载,直接可以使用

1. 先查看下载的ppocrlabel库所在位置:pip show ppocrlabel

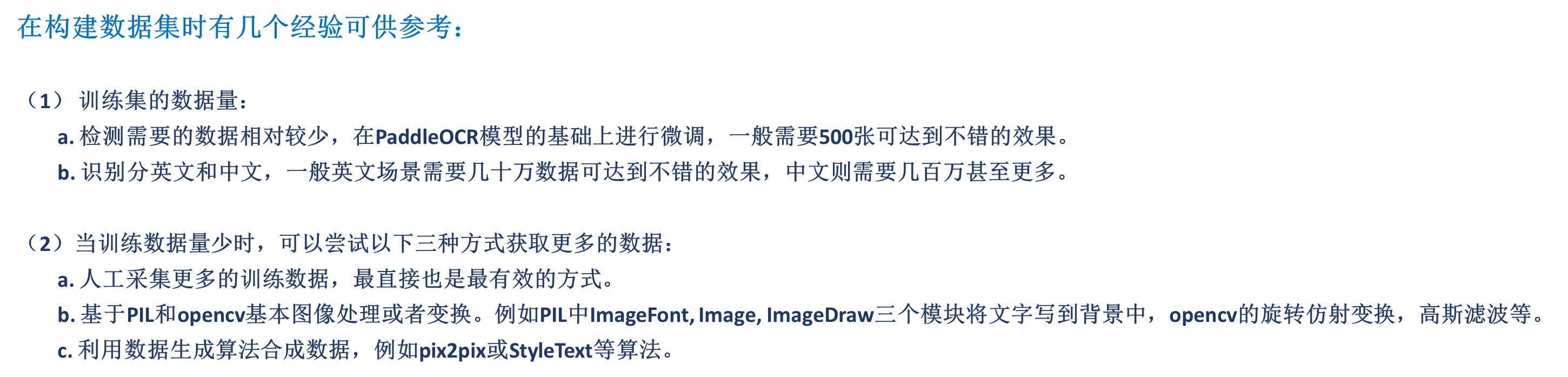

2. 在PPOCRLabel文件夹下有两个.py文件是制作数据集所需的

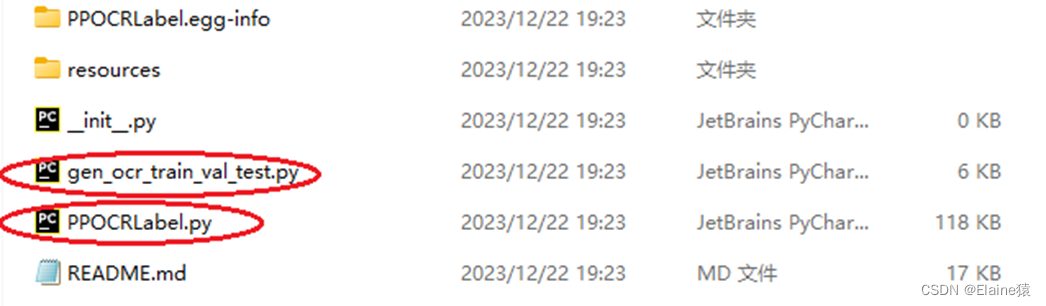

3. PPOCRLabel根目录下,终端运行: python PPOCRLabel.py --lang ch

python PPOCRLabel.py --lang ch # 启动【普通模式】,用于打【检测+识别】场景的标签

python PPOCRLabel.py --lang ch --kie True # 启动【KIE 模式】,用于打【检测+识别+关键字提取】场景的标签

4. 打开后点击文件,点击打开目录选择需要打标签的数据集文件夹,点击左下角自动标注

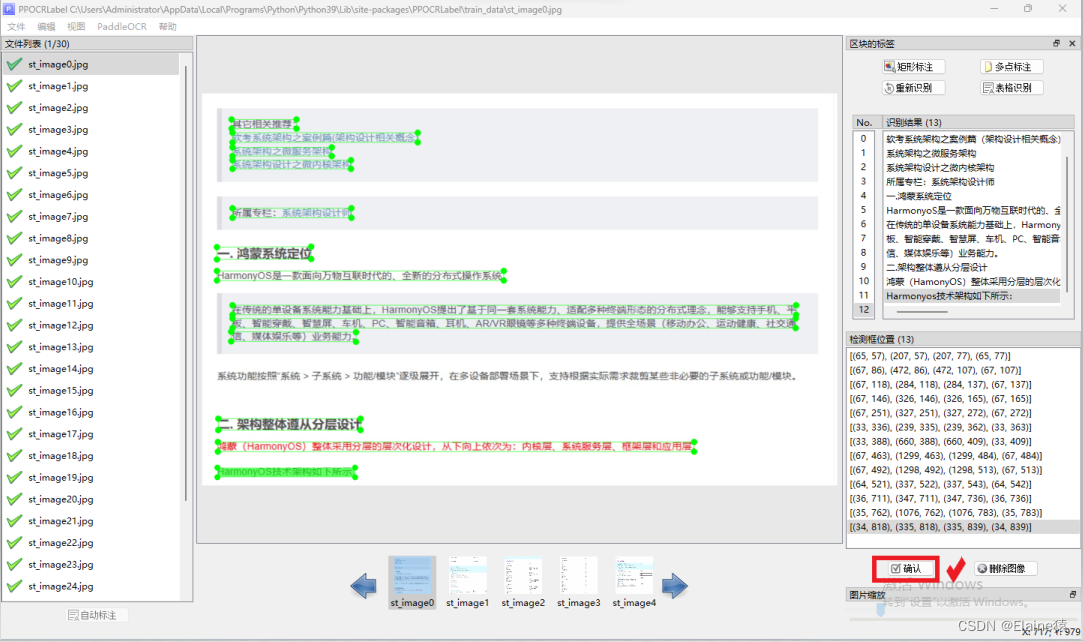

5. 然后从第一张开始检查。漏打标的按下Q框出字体;打标文字错误的,点击方框,在右边框里修改,并对每一个方框给出关键词列表(点击编辑点击更改box关键词信息)。支持矩形标注和多点标注,最后删除无用信息,点确认后,切换下一张快捷键为D,如下图所示。

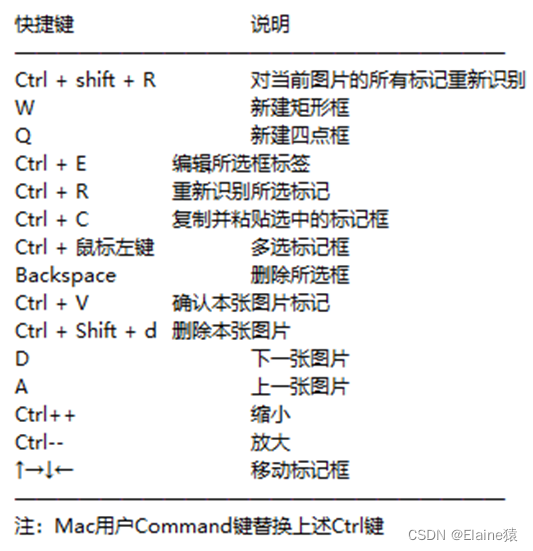

相关快捷键:

6. 导出标记结果及识别结果

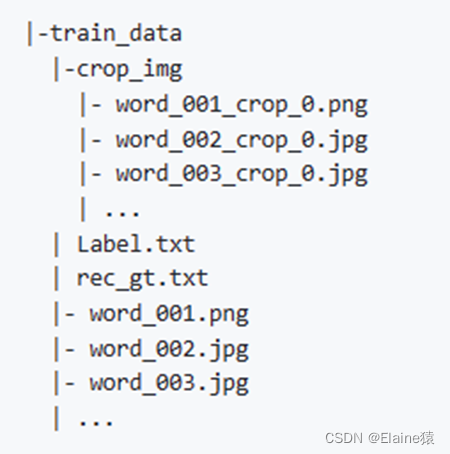

全部打标完成之后,点击文件选择导出标记结果,再点击文件选择导出识别结果,完成后文件夹里多出四个文件crop_img、fileState、Label、rec_gt。

- crop_img中的图片用来训练文字识别模型

- fileState记录图片的打标完成与否

- Label为训练文字检测模型的标签

- rec_gt为训练文字识别模型的标签

命名为train_data文件夹存放的是打标签生成的文件和图片

其结构如下图所示

7. 将数据集划分(训练集/验证集/测试集)

PPOCRLabel根目录下,终端运行:python gen_ocr_train_val_test.py --trainValTestRatio 6:2:2 –-datasetRootPath xx --detRootPath xx --recRootPath xx

参数说明:

- trainValTestRatio 是训练集、验证集、测试集的图像数量划分比例,根据实际情况设定,默认是6:2:2

- datasetRootPath 是PPOCRLabel标注的完整数据集存放路径。默认路径是 …/train_data/

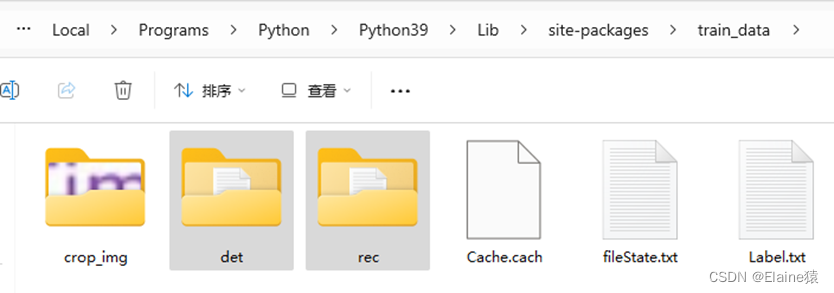

就是步骤6的结果文件夹train_data文件夹。 - detRootPath 是输出训练文字检测的数据集存放路径。默认路径是 …/train_data/det

- recRootPath 是输出训练文字识别的数据集存放路径。默认路径是 …/train_data/rec

输入指令之后,在train_data文件夹下会出现两个文件:

其中det是用来训练文字检测的数据集,

rec是用来训练文字识别的数据集。

Part5. 训练模型

1. 按需下载文本检测、文本识别的配置文件和训练模型

官方网址:https://github.com/PaddlePaddle/PaddleOCR/blob/release/2.7/doc/doc_ch/models_list.md

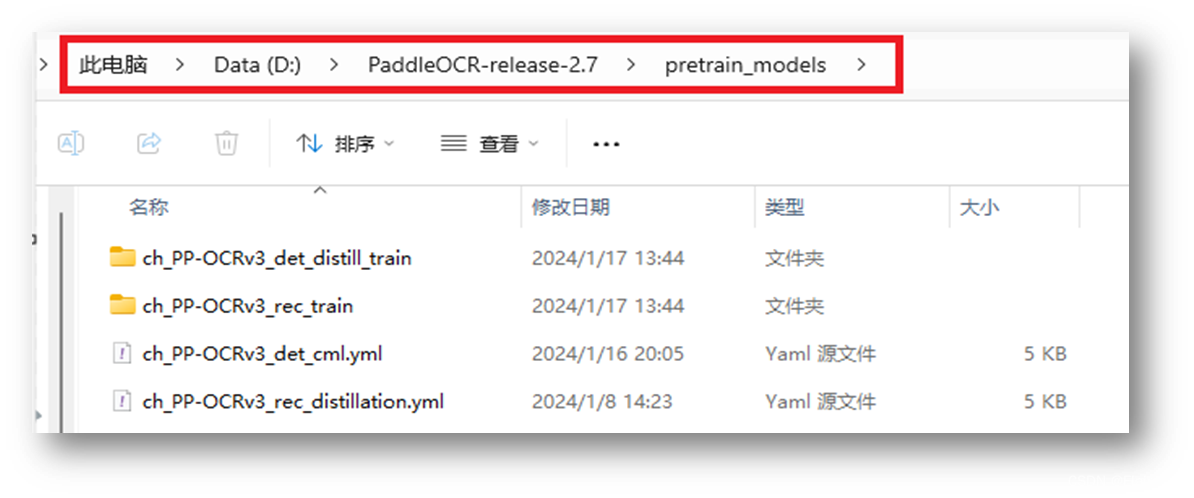

2. 在PaddleOCR-release-2.7目录下新建pretrain_models文件夹,存放前面下载的配置文件和训练模型

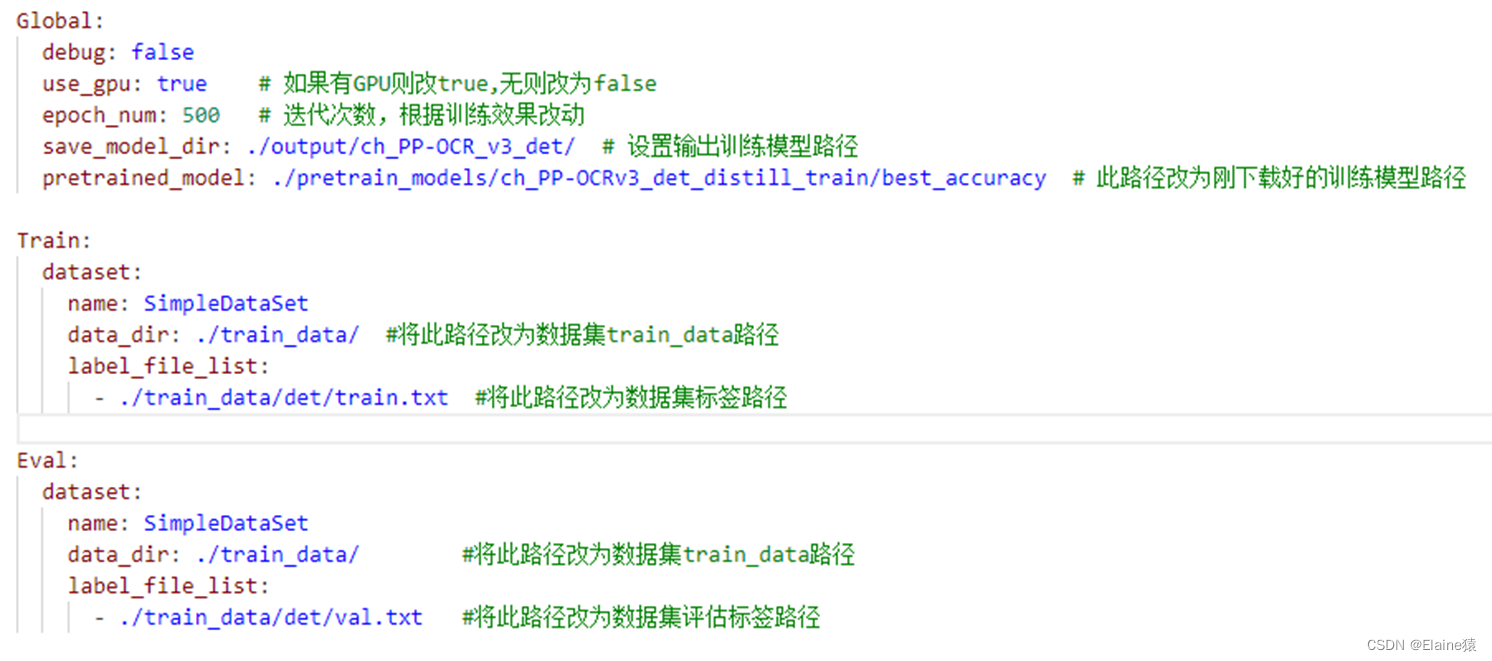

3. 训练文字检测模型

3.1 手动修改配置文件ch_PP-OCRv3_det_cml.yml

已列出需要修改的參數,完整參數説明請參考

官方文档https://github.com/PaddlePaddle/PaddleOCR/blob/release/2.7/doc/doc_ch/config.md

3.2 开始训练

在PaddleOCR-release-2.7根目录下,执行命令开始训练:

python tools/train.py -c pretrain_models/ch_PP-OCRv3_det_cml.yml

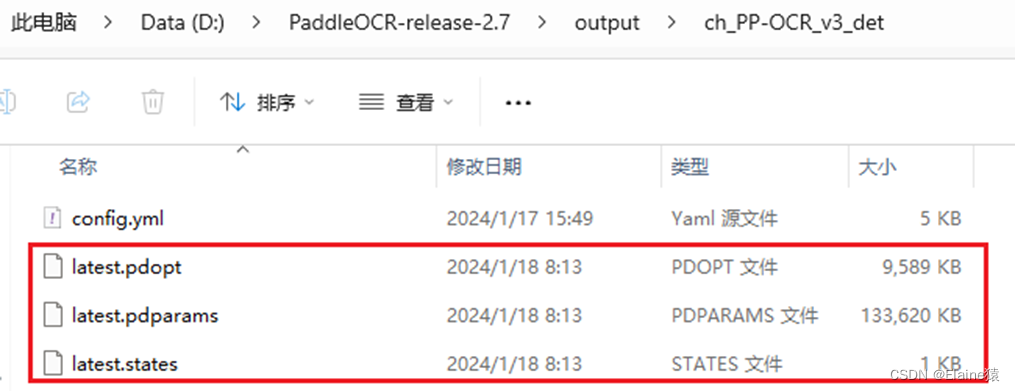

模型训练完之后会在文件夹下保存训练好的模型,具体保存的文件夹路径依据配置文件:

save_model_dir: ./output/ch_PP-OCR_v3_det/ # 设置输出训练模型路径

训练过程中产生的模型称为检查点(checkpoints)模型,包含完整参数,用于恢复训练及二次训练。一 个检查点模型包含三个文件:

.pdopt:训练优化器参数

.pdparams:训练网络参数

.states:训练状态

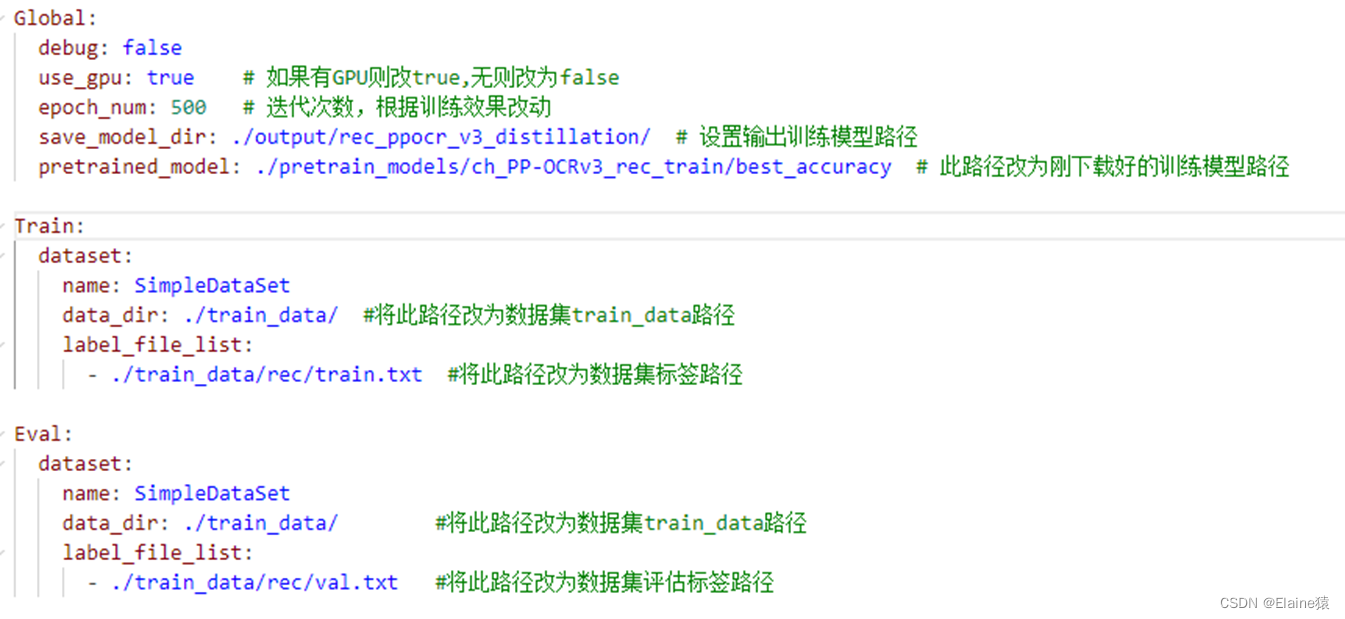

4. 训练文字识别模型(跟训练文字检测模型步骤几乎一样)

4.1 手动修改配置文件ch_PP-OCRv3_rec_distillation.yml

下面列出需要修改的參數,修改的地方和文字检测修改的类似。

4.2 开始训练

在PaddleOCR-release-2.7根目录下,执行命令开始训练:

python tools/train.py -c pretrain_models/ch_PP-OCRv3_rec_distillation.yml

模型训练完之后会在文件夹下保存训练好的模型,具体保存的文件夹路径依据配置文件:

save_model_dir: ./output/rec_ppocr_v3_distillation/

5. 断点训练

如果训练程序中断,希望加载训练中断的模型从而恢复训练,可以通过指定Global.checkpoints指定要加载的模型路径:

python tools/train.py -c pretrain_models/ch_PP-OCRv3_rec_distillation.yml -o Global.checkpoints=./your/trained/model

注意:Global.checkpoints的优先级高于Global.pretrained_model的优先级,即同时指定两个参数时,优先加载Global.checkpoints指定的模型

6. 模型微调

官方讲解较详细:https://github.com/PaddlePaddle/PaddleOCR/blob/release/2.7/doc/doc_ch/finetune.md

Part6. 转换成推理模型并应用

1. 转换成推理模型

推理模型是可以直接被调用进行识别和检测。推理模型体积更小,在预测部署、加速推理上性能优越、灵活方便,但不能用于恢复训练及二次训练。

执行以下命令将训练好的检测、识别模型导出为推理模型:

python tools/export_model.py -c pretrain_models/ch_PP-OCRv3_det_cml.yml -o Global.pretrained_model=./output/ch_PP-OCR_v3_det/latest Global.save_inference_dir=./inference_model/det_model/

python tools/export_model.py -c pretrain_models/ch_PP-OCRv3_rec_distillation.yml -o Global.pretrained_model=./output/rec_ppocr_v3_distillation/latest Global.save_inference_dir=./inference_model/rec_model/

参数说明:

- -c 指定导出模型使用的配置文件,需与训练时使用的配置文件相同

- -o 指定配置文件中的某个参数,即在不修改配置文件的情况下修改参数

- Global.pretrained_model 此处是指要导出模型的参数文件路径

- Global.save_inference_dir 指导出模型的保存路径

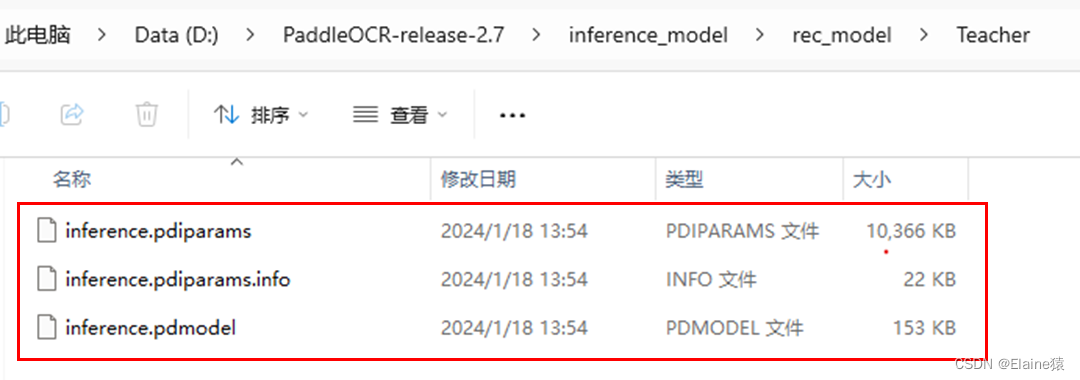

结果:

2. 模型使用

import cv2

from paddleocr import PaddleOCR

paddleocr = PaddleOCR(lang=‘ch’, show_log=False, enable_mkldnn=True,

det_model_dir=f’D:\PaddleOCR-release-2.7\inference_model\det_model\Teacher’,

rec_model_dir=f’D:\PaddleOCR-release-2.7\inference_model\rec_model\Teacher’) # 推理模型路径

img = cv2.imread(‘ch2.jpg’) # 打开需要识别的图片

result = paddleocr.ocr(img)

for i in range(len(result[0])):

print(result[0][i][1][0]) # 输出识别结果

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上鸿蒙开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

中…(img-zHj7PcqF-1715727679936)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上鸿蒙开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

6470

6470

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?