既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!

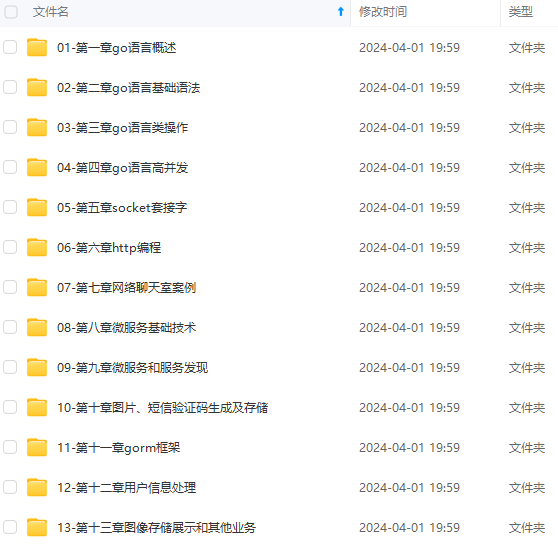

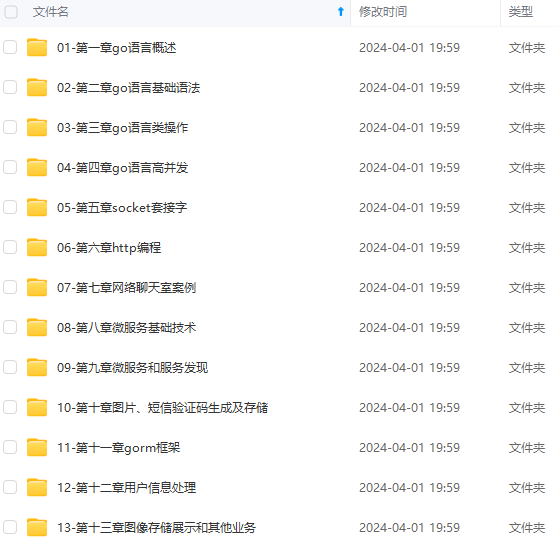

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

package crawler

import (

"fmt"

"io/ioutil"

"net/http"

)

type Crawler struct {

}

func (c \*Crawler) Download(url string) ([]byte, error) {

resp, err := http.Get(url)

if err != nil {

return nil, err

}

defer resp.Body.Close()

body, err := ioutil.ReadAll(resp.Body)

if err != nil {

return nil, err

}

return body, nil

}

func (c \*Crawler) Parse(body []byte) {

// 解析网页内容

// 提取所需的数据

}

func (c \*Crawler) Store(data string) {

// 存储数据到本地或数据库

}

func (c \*Crawler) Run(url string) {

body, err := c.Download(url)

if err != nil {

fmt.Println("下载网页失败:", err)

return

}

c.Parse(body)

c.Store("提取的数据")

}

在上面的示例中,我们定义了一个Crawler结构体,其中包含了下载、解析和存储等功能。Download方法负责从给定的URL下载网页内容,并返回字节切片。Parse方法负责解析网页内容,提取所需的数据。Store方法负责将提取的数据存储到本地或数据库中。Run方法是爬虫的入口,负责调用其他功能方法来完成整个爬取流程。

3. 使用爬虫封装模块

使用封装的爬虫模块非常简单,只需实例化Crawler结构体并调用Run方法即可。以下是一个使用示例:

package main

import "crawler"

func main() {

c := crawler.Crawler{}

c.Run("http://example.com")

}

在上面的示例中,我们导入了封装的爬虫模块,实例化Crawler结构体并调用Run方法来启动爬虫程序。这样就完成了一个简单的爬虫任务。

4. 爬虫的进一步封装

上面的示例只是一个简单的爬虫封装模块,实际应用中可能需要更多的功能和扩展。下面是一些可以进一步封装的功能点:

并发爬取

使用Golang的并发特性,可以实现爬虫的并发执行,提高爬取效率。我们可以使用goroutine和channel来实现并发爬取,例如使用一个WorkPool来控制并发数量,每个goroutine负责一个URL的下载、解析和存储。

定时爬取

如果需要定时执行爬取任务,可以使用Golang的time包来实现定时任务。可以创建一个定时器,在每个时间间隔内执行爬取任务。

动态配置

为了增加灵活性,可以将爬虫的配置参数进行动态化。可以使用Golang的flag包来定义命令行参数,或者使用配置文件来配置爬虫的各项参数。

错误处理

在爬虫过程中可能会遇到网络异常、解析错误等问题,我们需要对这些错误进行恰当的处理。可以使用Golang的error类型来表示错误,并进行适当的错误处理和日志记录。

5. 案例1:爬取图片链接

在这个案例中,我们将演示如何使用封装的爬虫模块来爬取网页中的图片链接。我们将使用goquery库来解析HTML并提取图片链接。

首先,我们在Parse方法中添加以下代码来解析网页并提取图片链接:

func (c \*Crawler) Parse(body []byte) {

doc, err := goquery.NewDocumentFromReader(bytes.NewReader(body))

if err != nil {

log.Fatal(err)

}

doc.Find("img").Each(func(i int, s \*goquery.Selection) {

link, exists := s.Attr("src")

if exists {

fmt.Println(link)

}

})

}

在上述代码中,我们使用goquery库的NewDocumentFromReader方法将HTML内容解析为Document对象。然后,我们使用Find方法和选择器img来找到网页中的所有图片元素。然后,我们使用Attr方法获取图片元素的src属性值,即图片链接。最后,我们将图片链接打印出来。

接下来,我们在main函数中添加以下代码来运行爬虫:

func main() {

crawler := NewCrawler()

crawler.Run("https://www.example.com")

}

这个案例将爬取https://www.example.com网页中的所有图片链接,并将其打印出来。

6. 案例2:爬取文章标题和内容

在这个案例中,我们将使用封装的爬虫模块来爬取网页中的文章标题和内容。我们将使用goquery库来解析HTML并提取文章标题和内容。

首先,我们在Parse方法中添加以下代码来解析网页并提取文章标题和内容:

func (c \*Crawler) Parse(body []byte) {

doc, err := goquery.NewDocumentFromReader(bytes.NewReader(body))

if err != nil {

log.Fatal(err)

}

title := doc.Find("h1").Text()

fmt.Println("标题:", title)

content := doc.Find("div.content").Text()

fmt.Println("内容:", content)

}

在上述代码中,我们使用goquery库的NewDocumentFromReader方法将HTML内容解析为Document对象。然后,我们使用Find方法和选择器h1来找到网页中的标题元素,使用Text方法获取标题文本,并将其打印出来。接着,我们使用Find方法和选择器div.content来找到网页中的内容元素,使用Text方法获取内容文本,并将其打印出来。

接下来,我们在main函数中添加以下代码来运行爬虫:

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

1268

1268

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?