网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

selector = Selector(response)

# 提取数据

data = selector.xpath('//h1/text()').get()

yield {'data': data}

在上述代码中,我们使用SeleniumRequest来发送请求,并使用Selenium来加载和渲染动态页面。在parse()方法中,我们使用Scrapy-Selector来解析响应,并使用XPath或CSS选择器来提取数据。

4. 运行爬虫

通过运行以下命令来启动爬虫:

scrapy crawl myspider

Scrapy将会自动启动Selenium,并使用它来加载和渲染动态页面。然后,Scrapy-Selector将会解析响应并提取我们需要的数据。

注意事项:

* 确保已经正确配置了Chrome浏览器和对应的ChromeDriver,并将其路径正确设置在"settings.py"文件中的SELENIUM\_DRIVER\_EXECUTABLE\_PATH配置项中。

* 动态页面的加载可能会比较耗时,所以爬取速度可能会受到影响。可以通过调整Scrapy的并发请求数和下载延时来优化爬取速度。

下面将提供几个案例:

案例1:使用Scrapy爬取JavaScript渲染的页面

import scrapy

from scrapy.selector import Selector

from scrapy_selenium import SeleniumRequest

class MySpider(scrapy.Spider):

name = ‘myspider’

start_urls = [‘http://www.example.com’]

def start\_requests(self):

for url in self.start_urls:

yield SeleniumRequest(url=url, callback=self.parse)

def parse(self, response):

# 使用Scrapy-Selector解析响应

selector = Selector(response)

# 提取数据

data = selector.xpath('//h1/text()').get()

yield {'data': data}

在这个案例中,我们使用SeleniumRequest来发送请求,并使用Selenium来加载和渲染动态页面。在parse()方法中,我们使用Scrapy-Selector来解析响应,并使用XPath或CSS选择器来提取数据。

案例2:使用Scrapy-Selector提取动态页面中的数据

import scrapy

from scrapy.selector import Selector

from scrapy_selenium import SeleniumRequest

class MySpider(scrapy.Spider):

name = ‘myspider’

start_urls = [‘http://www.example.com’]

def start\_requests(self):

for url in self.start_urls:

yield SeleniumRequest(url=url, callback=self.parse)

def parse(self, response):

# 使用Scrapy-Selector解析响应

selector = Selector(response)

# 提取数据

data = selector.xpath('//h1/text()').get()

yield {'data': data}

在这个案例中,我们使用SeleniumRequest来发送请求,并使用Selenium来加载和渲染动态页面。使用Scrapy-Selector来解析响应,并使用XPath或CSS选择器来提取数据。

案例3:使用Scrapy爬取动态页面中的表单数据

import scrapy

from scrapy_selenium import SeleniumRequest

class MySpider(scrapy.Spider):

name = ‘myspider’

start_urls = [‘http://www.example.com’]

def start\_requests(self):

for url in self.start_urls:

yield SeleniumRequest(url=url, callback=self.parse)

def parse(self, response):

# 提交表单数据

yield scrapy.FormRequest.from_response(

response,

formdata={'username': 'myusername', 'password': 'mypassword'},

callback=self.after_login

)

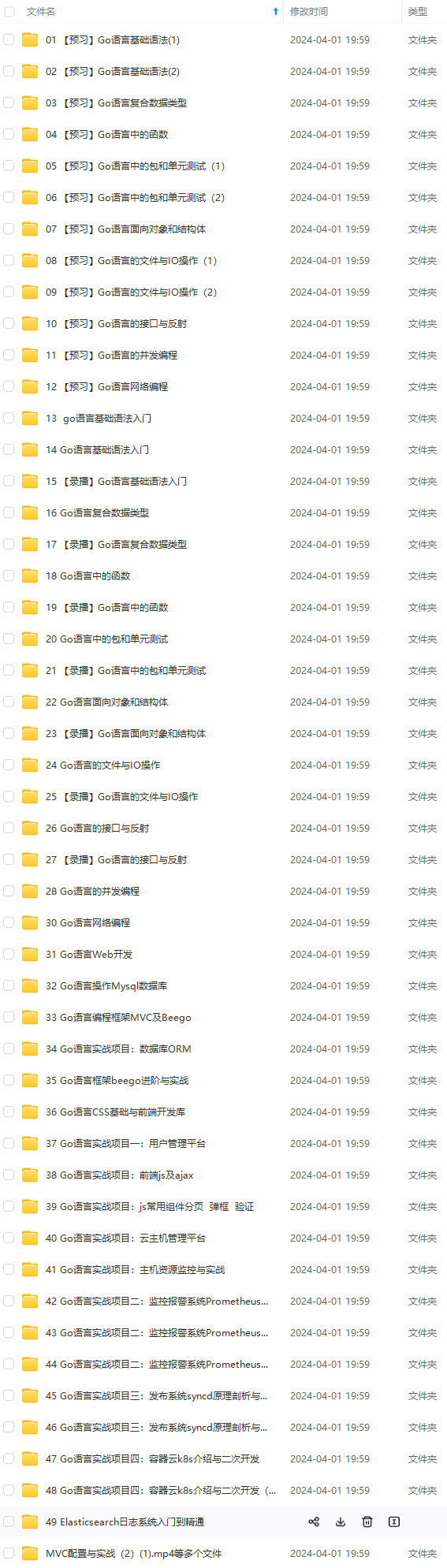

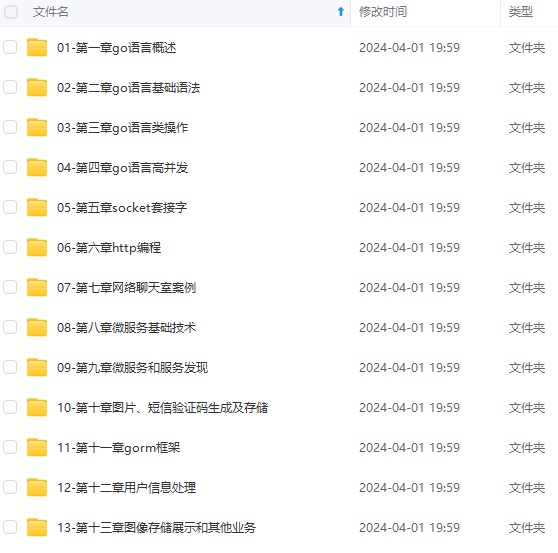

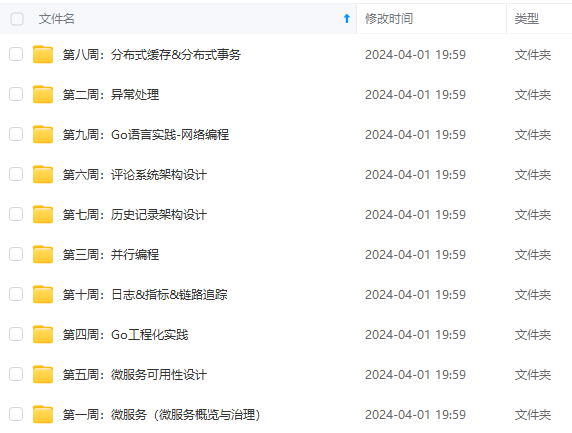

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Go语言开发知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

388

388

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?