在AI绘画领域,Stable

Diffusion 因其开源特性而受到广泛的关注和支持,背后聚拢了一大批的应用开发者和艺术创作者,是AI绘画领域当之无愧的王者。

目前使用 Stable Diffusion 进行创作的工具主要有两个:Stable Diffusion WebUI 和 ComfyUI。

Stable Diffusion WebUI

开箱即用,基本功能齐全,社区也有很多的插件支持,入门比较简单,适合新手,但是可定制性稍微差点,很多作品不容易传播复现,使用API进行操作也有一定的难度。

ComfyUI

虽然出来的晚一点,但是它的可定制性很强,可以让创作者搞出各种新奇的玩意,通过工作流的方式,也可以实现更高的自动化水平,创作方法更容易传播复现,发展势头特别迅猛,但是

ComyUI 的上手门槛有点高,对 Stable Diffusion 以及各种扩展能力的原理需要有一定的理解,动手能力要求也比较高。

从解放生产力以及工业化批量生产的角度看,ComfyUI 具备更广阔的应用前景,因此从这篇文章开始,我将开始介绍一些 ComfyUI

的概念和使用方法,让大家更快的掌握 ComfyUI 的使用技巧,创作出自己独特的艺术作品。

安装部署

ComfyUI 目前支持多种类型的显卡,包括

Nvidia、AMD、Intel

等架构的显卡,也支持仅在 CPU

上运行,不过最流畅的环境还是使用Nvidia显卡,在其它环境下生成速度会受到很大的限制,还可能需要更复杂的配置,不推荐使用。如果本地没有合适的显卡,推荐大家试用下云平台。

Python环境准备

目前AI的程序大多是由 Python 语言编写的,Python 程序运行环境必不可少。

建议使用 conda 管理 Python 运行环境,conda 可以看做是一个软件包管理器,安装相关程序比较方便。

如果你是租用的云服务器,一般都自带了某个版本的 conda ,不用再单独安装,可以跳到下一步。

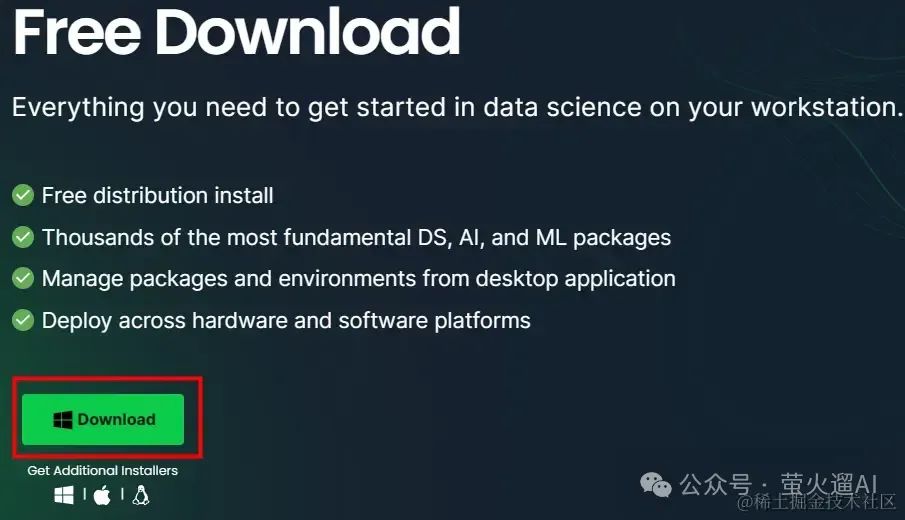

如果你是在本机运行,建议安装 Anaconda,官方下载地址是:www.anaconda.com/download 。

如下图所示,点击页面中的“Download”按钮即可下载。

请注意选择你使用的操作系统,下面以Windows系统为例,其它系统请自行查找对应的使用方法。

整个安装包有800多M,下载时间取决于你的网路。Anaconda

的安装比较简单,但是安装中间还需要下载很多程序,所以需要的时间可能会久一点;另外全部安装完毕后,可能会占用5G多的硬盘空间,需要提前预留好。

安装完成后,我们可以在开始菜单中找到这个 Anaconda 的命令执行工具。

点击打开 Anaconda Prompt,是一个黑色命令执行窗口,我们将在这里执行一些命令,以完成后续的安装过程。

执行下边的命令,使用 conda 创建一个 python 虚拟环境:

conda create -n ComfyUI python=3.9 -y

conda activate ComfyUI

这里使用的是 python 3.9,可以兼容大多数 ComfyUI 插件。

conda activate 是用来激活 Python 虚拟环境的,如果 Linux 环境不能执行成功,改为: source activate

试试。

安装 ComfyUI

1、首先把 ComfyUI 的程序代码下载到本地:

ComfyUI 的开源地址:https://github.com/comfyanonymous/ComfyUI

ComfyUI

的更新速度很快,可以通过这个地址下载到最新的代码:https://github.com/comfyanonymous/ComfyUI/archive/refs/heads/master.zip

2、然后把 SD 基础模型放到对应的模型目录下:_ComfyUI/_models/checkpoints

SD 基础模型有很多地方可以下载,国内可以访问 https://iblib.art

3、安装显卡驱动,请根据自己的显卡类型选择合适的命令:

Nvidia 显卡:

pip install torch torchvision torchaudio --extra-index-url

AMD显卡(Linux):

pip install torch torchvision torchaudio --index-url

AMD显卡(Windows):

pip install torch-directml

Apple Mac silicon (M1 or M2):

pip install --pre torch torchvision torchaudio --extra-index-url

Intel 架构的显卡:

仅在Linux 系统上可用,尚不完善,使用方法参见:

4、安装依赖

pip install -r requirements.txt

5、启动 ComfyUI

基本命令:python main.py

AMD显卡+Windows 需要使用 python main.py --directml

启动成功后,会显示如下信息:

Starting server

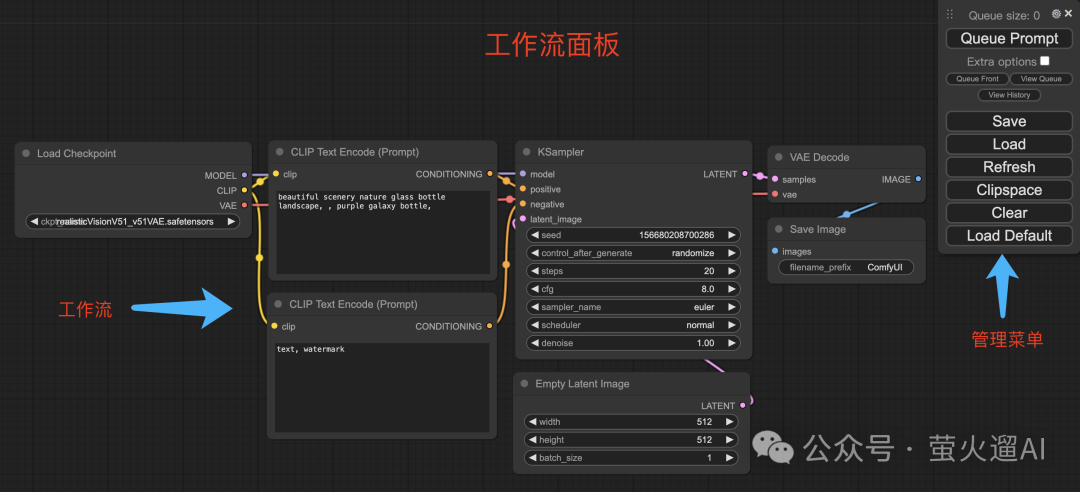

ComfyUI,使用界面如下图所示:

用好ComfyUI

用好 ComfyUI:

-

首先需要对 Stable Diffusion 的基本概念有清晰的理解,熟悉 ComfyUI 的基本使用方式;

-

然后需要在实践过程中不断尝试、不断加深理解,逐步掌握各类节点的能力和使用方法,提升综合运用各类节点进行创作的能力。

我将在后续文章中持续输出 ComfyUI 的相关知识和热门作品的工作流,帮助大家更快的掌握 ComfyUI,创作出满足自己需求的高质量作品。

需要ComfyUI工作流的小伙伴,文末扫码获取!

如何训练LorA

对于很多刚学习AI绘画的小伙伴而言,想要提升、学习新技能,往往是自己摸索成长,不成体系的学习效果低效漫长且无助。

如果你苦于没有一份Lora模型训练学习系统完整的学习资料,这份网易的《Stable Diffusion LoRA模型训练指南》电子书,尽管拿去好了。

包知识脉络 + 诸多细节。节省大家在网上搜索资料的时间来学习,也可以分享给身边好友一起学习。

由于内容过多,下面以截图展示目录及部分内容,完整文档领取方式点击下方微信卡片,即可免费获取!

篇幅有限,这里就不一一展示了,有需要的朋友可以点击下方的卡片进行领取!

5024

5024

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?