### 2.安装KafKa

将安装包传送到服务器并解压,这里我放到opt下面

###### 1. 解压安装包

cd opt

tar -zxvf kafka_2.12-3.6.0.tgz

###### 2. 配置kafka

在kafka解压目录同一路径下创建

mkdir -p /opt/software/kafka

mkdir -p /opt/software/kafka/zookeeper #zookeeper数据目录

mkdir -p /opt/software/kafka/log #kafka日志

mkdir -p /opt/software/kafka/zookeeper/log #zookeeper日志

###### 3 进入配置文件目录

cd /opt/kafka_2.12-3.6.0/config/

###### 4 修改配置文件server.properties,添加下面内容

broker.id=0

port=9092 #端口号

host.name=localhost #服务器IP地址,修改为自己的服务器IP

log.dirs=/opt/software/kafka/log #日志存放路径,上面创建的目录

zookeeper.connect=localhost:2181 #zookeeper地址和端口,单机配置部署,localhost:2181

###### 5 配置zookeeper服务 zookeeper.properties

dataDir=/opt/software/kafka/zookeeper #zookeeper数据目录

dataLogDir=/opt/software/kafka/zookeeper/log #zookeeper日志目录

clientPort=2181

maxClientCnxns=100

tickTimes=2000

initLimit=10

syncLimit=5

###### 6 创建启动和关闭的 kafka 执行脚本

###### 6.1 创建启动脚本

cd /opt/kafka_2.12-3.6.0/

vi kafkaStart.sh

配置启动脚本 kafkaStart.sh

#启动zookeeper

/opt/kafka_2.12-3.6.0/bin/zookeeper-server-start.sh /opt/kafka_2.12-3.6.0/config/zookeeper.properties &

sleep 3 #等3秒后执行

#启动kafka

/opt/kafka_2.12-3.6.0/bin/kafka-server-start.sh /opt/kafka_2.12-3.6.0/config/server.properties &

###### 6.2 创建关闭脚本 kafkaStop.sh

cd /opt/kafka_2.12-3.6.0/

vi kafkaStop.sh

配置关闭脚本 kafkaStop.sh

#关闭zookeeper

/opt/kafka_2.12-3.6.0/bin/zookeeper-server-stop.sh /opt/kafka_2.12-3.6.0/config/zookeeper.properties &

sleep 3 #等3秒后执行

#关闭kafka

/opt/kafka_2.12-3.6.0/bin/kafka-server-stop.sh /opt/kafka_2.12-3.6.0/config/server.properties &

###### 7 启动脚本,关闭脚本赋予权限

chmod 777 kafkaStart.sh

chmod 777 kafkaStop.sh

启动和关闭kafka

cd /opt/kafka_2.12-3.6.0/

sh kafkaStart.sh #启动

sh kafkaStop.sh #关闭

###### 8 创建生产者 topic 和 消费者 topic

---

cd /opt/kafka_2.12-3.6.0/bin/ #进入kafka目录

./kafka-console-producer.sh --broker-list localhost:9092 --topic test #创建生产者 test你要建立的topic名

./kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test #创建消费者

查看 kafka 是否启动

[root@localhost kafka_2.12-3.6.0]# jps

21324 QuorumPeerMain

15211 Jps

21215 Kafka

里面有QuorumPeerMain和kafkas说明启动成功了

查看当前的一些topic

cd /opt/kafka_2.12-3.6.0/bin/

./kafka-topics.sh --zookeeper localhost:2181 --list

./kafka-topics.sh --list --bootstrap-server localhost:9092

###### 9 Spring boot集成Kafka

1、pom依赖

2.消费者

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

@RequestMapping(“/userGets”)

public Object gets() {

// send 第一个参数为topic的名称,第二个参数为我们要发送的信息

kafkaTemplate.send(“topic.quick.default”,“1231235”);

return “发送成功”;

}

@KafkaListener(topics = {“topic1”})

public void onMessage(ConsumerRecord<?, ?> record) {

System.out.println(record.value());

}

@KafkaListener(topics = {“topic2”})

public void getMessage(ConsumerRecord<String, String> record) {

String key = record.key();

String value = record.value();

}

3. 测试

//生产者

public static void main(String[] args) {

Properties properties = new Properties();

properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, “localhost:9092”);

properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, StringSerializer.class.getName());

KafkaProducer<String, String> producer = new KafkaProducer<>(properties);

String topic = "test-topic";

for (int i = 0; i < 10; i++) {

String message = "Message " + i;

producer.send(new ProducerRecord<>(topic, message));

System.out.println("Sent: " + message);

}

producer.close();

}

//消费者

public static void main(String[] args) {

Properties properties = new Properties();

properties.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

properties.put(ConsumerConfig.GROUP_ID_CONFIG, "group1");

properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class.getName());

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

//消息者订阅主题

consumer.subscribe(Collections.singletonList("test-topic"));

//循环

while (true) {

//每次拉取 1千条消息

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(1000));

for (ConsumerRecord<String, String> record : records) {

System.out.println("=============> 消费kafka消息:"+ record.value());

}

}

}

4.配置文件

server:

port: 8080

spring:

kafka:

bootstrap-servers: 172.16.253.21: 9093

producer: # 生产者

retries: 3 # 设置大于 0 的值,则客户端会将发送失败的记录重新发送

batch-size: 16384

buffer-memory: 33554432

acks: 1

# 指定消息key和消息体的编解码方式

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer

consumer:

group-id: default-group

enable-auto-commit: false

auto-offset-reset: earliest

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

max-poll-records: 500

listener:

# 当每一条记录被消费者监听器(ListenerConsumer)处理之后提交

# RECORD

# 当每一批poll()的数据被消费者监听器(ListenerConsumer)处理之后提交

# BATCH

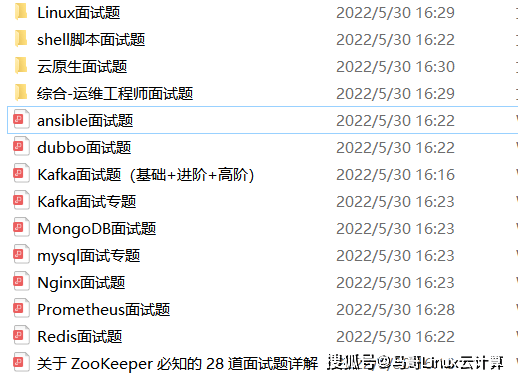

为了做好运维面试路上的助攻手,特整理了上百道 【运维技术栈面试题集锦】 ,让你面试不慌心不跳,高薪offer怀里抱!

这次整理的面试题,小到shell、MySQL,大到K8s等云原生技术栈,不仅适合运维新人入行面试需要,还适用于想提升进阶跳槽加薪的运维朋友。

本份面试集锦涵盖了

- 174 道运维工程师面试题

- 128道k8s面试题

- 108道shell脚本面试题

- 200道Linux面试题

- 51道docker面试题

- 35道Jenkis面试题

- 78道MongoDB面试题

- 17道ansible面试题

- 60道dubbo面试题

- 53道kafka面试

- 18道mysql面试题

- 40道nginx面试题

- 77道redis面试题

- 28道zookeeper

总计 1000+ 道面试题, 内容 又全含金量又高

- 174道运维工程师面试题

1、什么是运维?

2、在工作中,运维人员经常需要跟运营人员打交道,请问运营人员是做什么工作的?

3、现在给你三百台服务器,你怎么对他们进行管理?

4、简述raid0 raid1raid5二种工作模式的工作原理及特点

5、LVS、Nginx、HAproxy有什么区别?工作中你怎么选择?

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

详情docs.qq.com/doc/DSmdCdUNwcEJDTXFK

6、Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

7、Tomcat和Resin有什么区别,工作中你怎么选择?

8、什么是中间件?什么是jdk?

9、讲述一下Tomcat8005、8009、8080三个端口的含义?

10、什么叫CDN?

11、什么叫网站灰度发布?

12、简述DNS进行域名解析的过程?

13、RabbitMQ是什么东西?

14、讲一下Keepalived的工作原理?

15、讲述一下LVS三种模式的工作过程?

16、mysql的innodb如何定位锁问题,mysql如何减少主从复制延迟?

17、如何重置mysql root密码?

详情docs.qq.com/doc/DSmdCdUNwcEJDTXFK

2518

2518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?