2024深度学习发论文&模型涨点之——大模型RAG

RAG(Retrieval Augmented Generation)是一种优化大型语言模型(LLM)输出的方法,使其能够在生成响应之前引用训练数据之外的权威知识库。RAG通过访问特定领域或组织的内部知识库,而无需重新训练模型,进一步提升了其输出的相关性、准确性和实用性。这是一种经济高效的改进方法,适用于各种情境,也是搜索推荐等推荐系统场景的重要演进架构。

RAG解决的LLM应用痛点包括在没有答案的情况下提供虚假信息的问题。它通过引入外部知识库等额外信息源,为这些问题提供了有效的缓解策略。RAG在那些需要不断更新知识的知识密集型场景或特定领域应用中尤为有效。与其他方法相比,RAG的一大优势是无需针对特定任务重新训练大语言模型。

小编整理了一些RAG【论文】合集,需要的同学公人人人号【AI创新工场】自取。

论文精选

论文1:

Adaptive-RAG: Learning to Adapt Retrieval-Augmented Large Language Models through Question Complexity

通过问题复杂性适应检索增强型大型语言模型的学习

方法

-

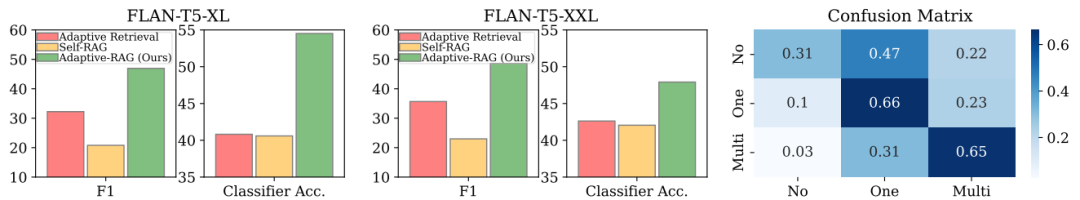

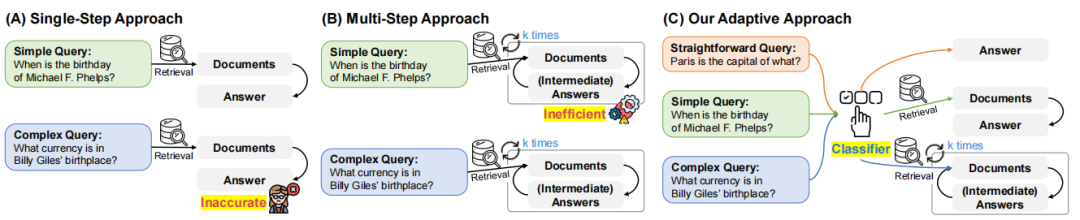

动态策略选择:提出了一个新颖的自适应问答框架,能够根据问题复杂性动态选择从最简单的到最复杂的策略。

-

查询复杂性分类:使用一个小型语言模型训练的分类器来预测输入查询的复杂性水平,并自动收集训练数据集。

-

自动数据集构建:利用模型预测结果和数据集中的固有偏差自动构建训练数据集,无需人工标注。

-

多策略融合:提出了一种方法,可以平衡迭代增强的大型语言模型(LLM)用于复杂查询,单步方法用于简单查询,甚至对于最直接的查询不使用检索增强方法。

创新点

-

查询复杂性自适应:首次提出根据查询复杂性动态调整检索增强型LLM的操作策略,以适应不同复杂性的查询。

-

查询复杂性自动标注:创新性地提出自动标注查询复杂性的方法,通过利用模型预测结果和数据集偏差,减少了人工标注的需求。

-

效率与准确性的平衡:通过自适应方法在处理复杂查询时提供必要的资源,同时高效处理简单查询,实现了效率和准确性之间的平衡。

-

实际应用验证:在多个开放域问答数据集上验证了模型,涵盖了从单跳到多跳查询的多种复杂性,证明了模型在实际应用中的有效性。

论文2:

Are Large Language Models Good at Utility Judgments?

大型语言模型在效用判断上的表现如何?

方法

-

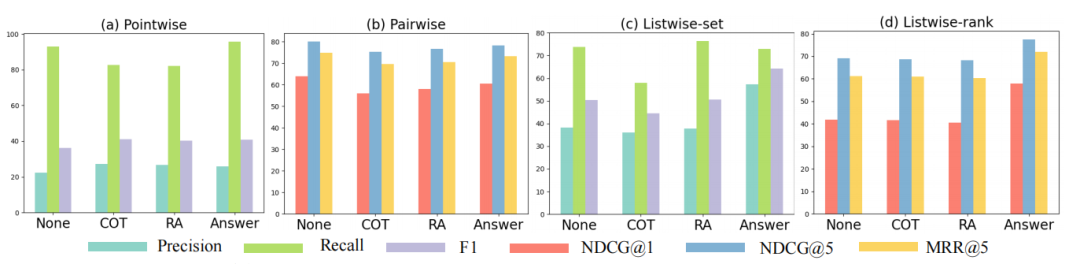

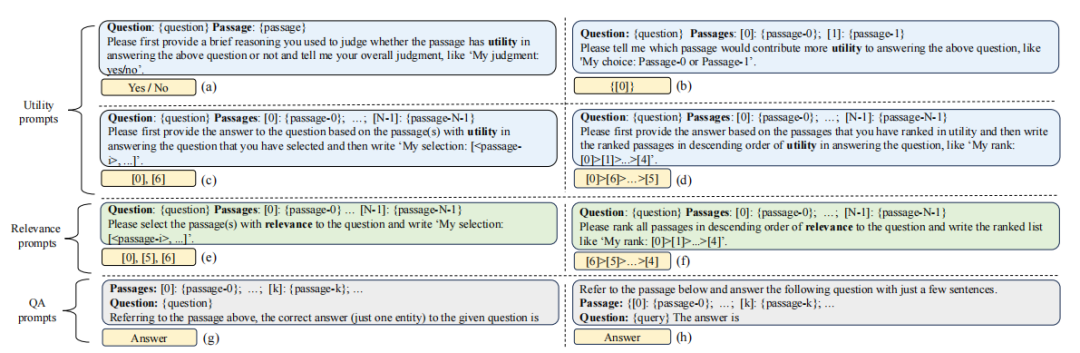

效用评估基准程序:引入了一个新的基准程序和候选段落集合,用于评估大型语言模型(LLMs)在开放域问答(QA)中的效用评估能力。

-

效用与相关性区分:通过设计实验来区分LLMs在评估段落的相关性和效用方面的能力。

-

关键因素分析:研究了影响LLMs效用判断的关键因素,包括指令设计、输入段落的顺序等。

-

效用判断对问答能力的影响:探讨了LLMs的效用判断如何影响检索增强型LLMs的问答能力。

创新点

-

效用评估任务的提出:首次提出了效用评估任务,以评估LLMs在选择对回答问题有用的支持证据方面的能力。

-

效用与相关性的区分:揭示了LLMs在区分段落的相关性和效用方面的能力,这是对LLMs评估能力的一个重要补充。

-

效用判断的影响因素分析:深入分析了影响LLMs效用判断的多种因素,为改进LLMs的效用评估提供了方向。

-

检索增强型LLMs的效用判断应用:通过实验验证了效用判断在实际检索增强型LLMs应用中的有效性,为提高问答系统的性能提供了新的方法。

论文3:

Telco-RAG: Navigating the Challenges of Retrieval Augmented Language Models for Telecommunications

Telco-RAG:导航电信领域检索增强型语言模型的挑战

方法

-

Telco-RAG框架:开发了一个开源的RAG框架,专门处理电信标准,尤其是3GPP文档的特定需求。

-

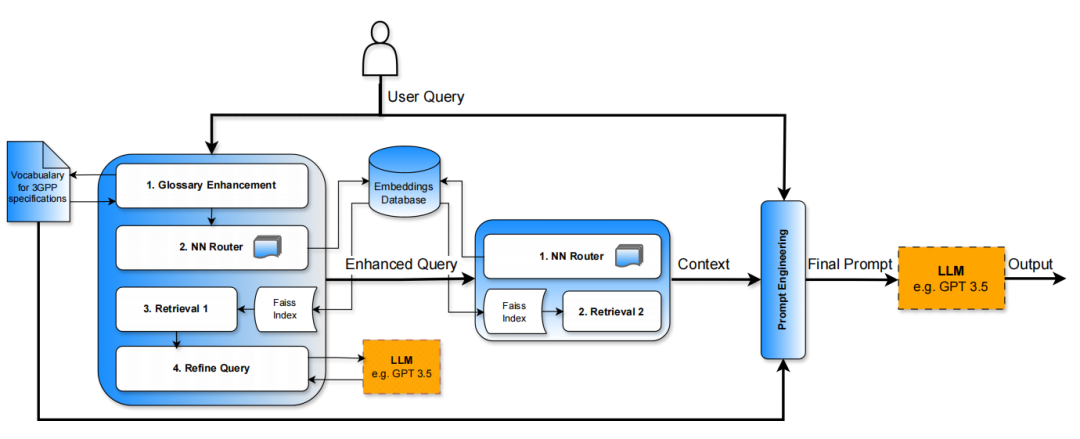

双阶段管道:包括查询增强阶段和检索阶段,查询增强阶段包括使用技术术语词汇表增强查询,以及神经网络(NN)路由器选择相关文档。

-

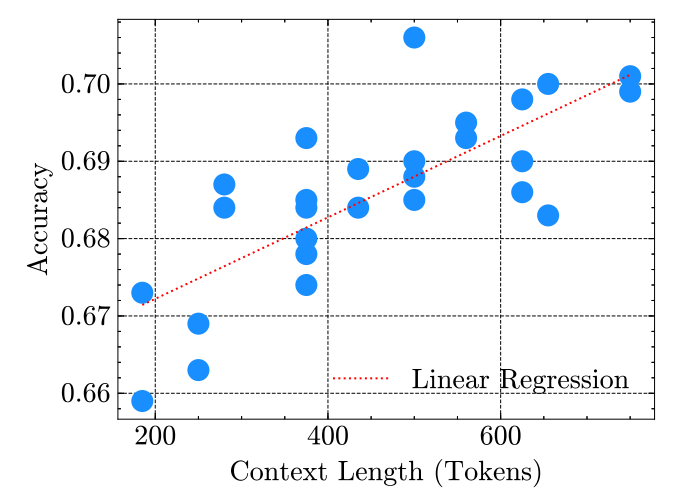

超参数优化:对块大小、上下文长度、索引策略和嵌入模型进行了细致的优化。

-

查询增强:通过技术术语和缩写的词汇表增强查询,以及生成候选答案来增强用户查询。

创新点

-

专门化的RAG管道:Telco-RAG针对3GPP文档进行了特别优化,解决了电信标准领域的复杂需求。

-

神经网络路由器:通过预测与查询相关的3GPP系列来减少RAM使用,显著提升了信息检索的针对性和效率。

-

查询增强:通过技术词汇表和候选答案增强查询,提高了检索阶段的精确度和最终答案的质量。

-

开源贡献:Telco-RAG作为开源聊天机器人,为3GPP标准提供了AI集成的实质性贡献,推动了电信领域AI的应用。

论文4:

Evaluating Large Language Models with RAG Capability: A Perspective from Robot Behavior Planning and Execution

评估具有RAG能力的大规模语言模型:从机器人行为规划与执行的视角

方法

-

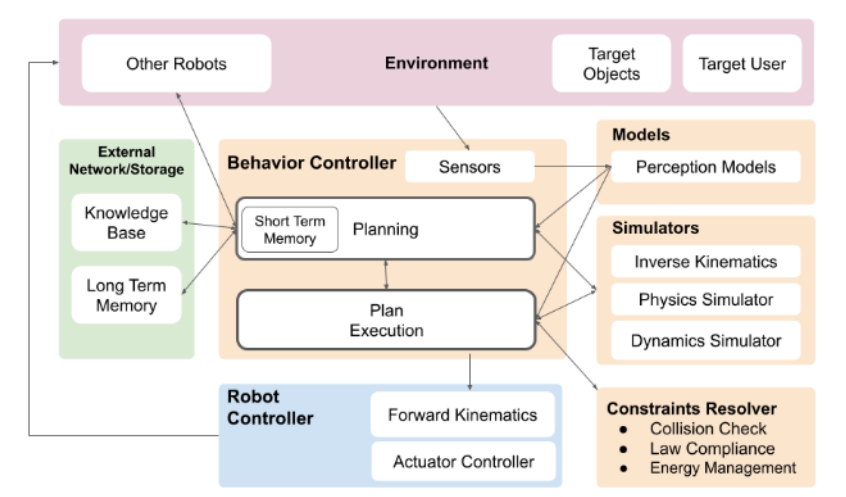

类人机器人控制组件框架:创建了一个广泛的组件框架,用于规划和控制开放环境中的类人机器人,以评估LLMs的核心能力及其在这些组件中的缺陷影响。

-

多模态理解和对话技能:LLMs展示了显著的多模态理解能力和对话技能,能够以Chain of Thought的方式澄清和确认用户的请求。

-

RAG增强记忆:RAG补充了LLMs的长期记忆能力,使其能够搜索外部的长期记忆和知识。

-

强化学习从人类反馈(RLHF):使用RLHF为系统提供高质量的正面样本,以便系统学习,特别是在难以建模的领域,如社会系统。

-

组件图映射:从先前研究中引入的类人机器人控制的组件图映射,用于详细探讨LLMs在规划、沟通和感知方面的影响和风险。

创新点

-

LLMs与类人机器人的类比:将LLMs在社会系统中的行为与开放环境中的类人机器人进行类比,以评估LLMs对社会系统的影响。

-

核心能力评估:通过创建组件框架,系统地评估LLMs在问题解决任务中的核心能力,以及这些能力中的缺陷可能带来的风险。

-

社会系统影响的模拟:开发了组件结构图,以模拟LLMs在社会系统中的潜在影响,特别是关注LLMs在不准确或不充分的情况下表现出的自信行为。

-

LLMs的局限性和风险识别:识别了LLMs在复杂推理、多步规划、领域特定知识等方面的局限性,并强调了在社会系统中负责任地开发和部署LLMs的重要性。

-

自我调节机制的提议:提出了未来LLMs应具备自我调节机制的观点,以便它们能够自主调整并对其预期目标的实现负责,从而提高在现实世界社会系统中的可靠性和有效性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?