使用AppSync构建Amazon Bedrock的AI网关

关键字: [Amazon Web Services re:Invent 2024, 亚马逊云科技, 生成式AI, Amazon AppSync, Amazon Bedrock Integration, Amazon Web Services Appsync Gateway, Generative Ai Applications, Real-Time Updates, Enterprise Use Cases]

导读

将生成式AI集成到应用程序中可能很复杂,通常需要开发人员在访问AI后端时处理复杂的权限、暴露的凭证和身份管理挑战。本次会议讨论如何使用Amazon AppSync来简化与Amazon Bedrock等AI后端的集成,为您的用例实现定制查询,利用安全功能部署生产就绪的API,并控制对生成式AI资源的访问。它涵盖了同步和异步两种使用场景。

演讲精华

以下是小编为您整理的本次演讲的精华。

在2024年的亚马逊云科技 re:Invent大会上,有一场题为“如何使用Amazon AppSync为Amazon Bedrock构建AI网关”的精彩会议。Amazon AppSync的主要产品经理Bliss Pele登台阐述了生成式AI的快速采用,以及客户在将应用程序连接到像Amazon Bedrock这样的生成式AI后端时所面临的挑战。Pele强调,虽然生成式AI无处不在,但客户在将应用程序连接到生成式AI后端时仍面临着灵活的安全性和访问控制、灵活的请求处理以及灵活的模型选择等挑战。

为了解决这些挑战,Pele将Amazon AppSync引入作为AI网关解决方案,它已经发展成为许多客户的AI网关。AppSync能够安全地连接到Amazon Bedrock,通过其原生的WebSocket订阅功能为长时间运行的工作负载提供实时解决方案,控制用户和模型访问,并能够将应用程序与模型解耦。Pele深入探讨了AppSync所使用的查询语言GraphQL,它允许客户端高效地向API发出请求,避免过度获取数据。

AppSync提供了各种授权类型,包括Amazon Cognito用于用户授权、API密钥以及自定义Lambda授权者。Pele演示了如何使用AppSync连接到Amazon Bedrock模型,同步或异步调用它们,并使用订阅处理长时间运行的调用并实时更新。他展示了使用AppSync进行内容分析、语言翻译和总结任务的示例。

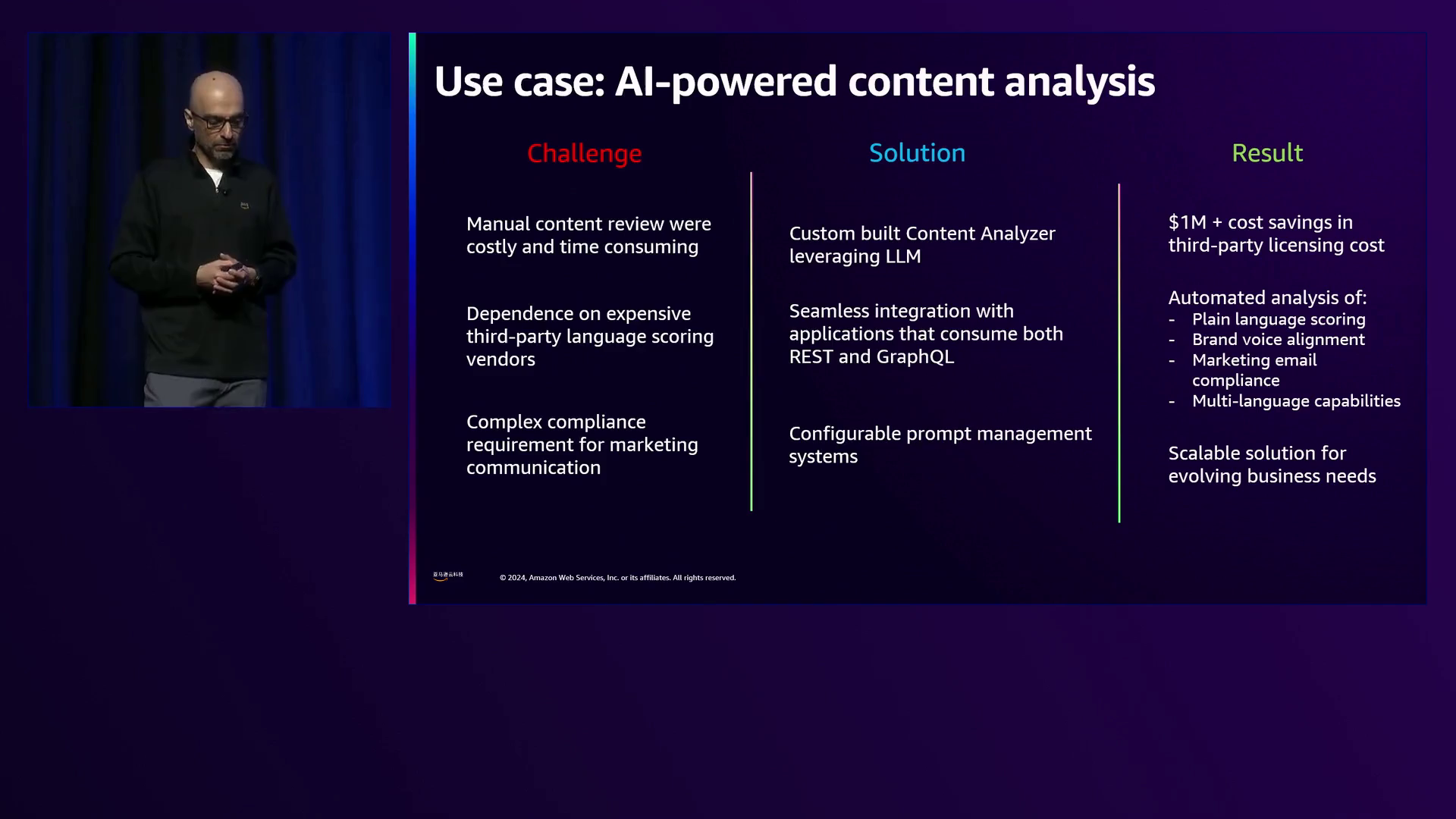

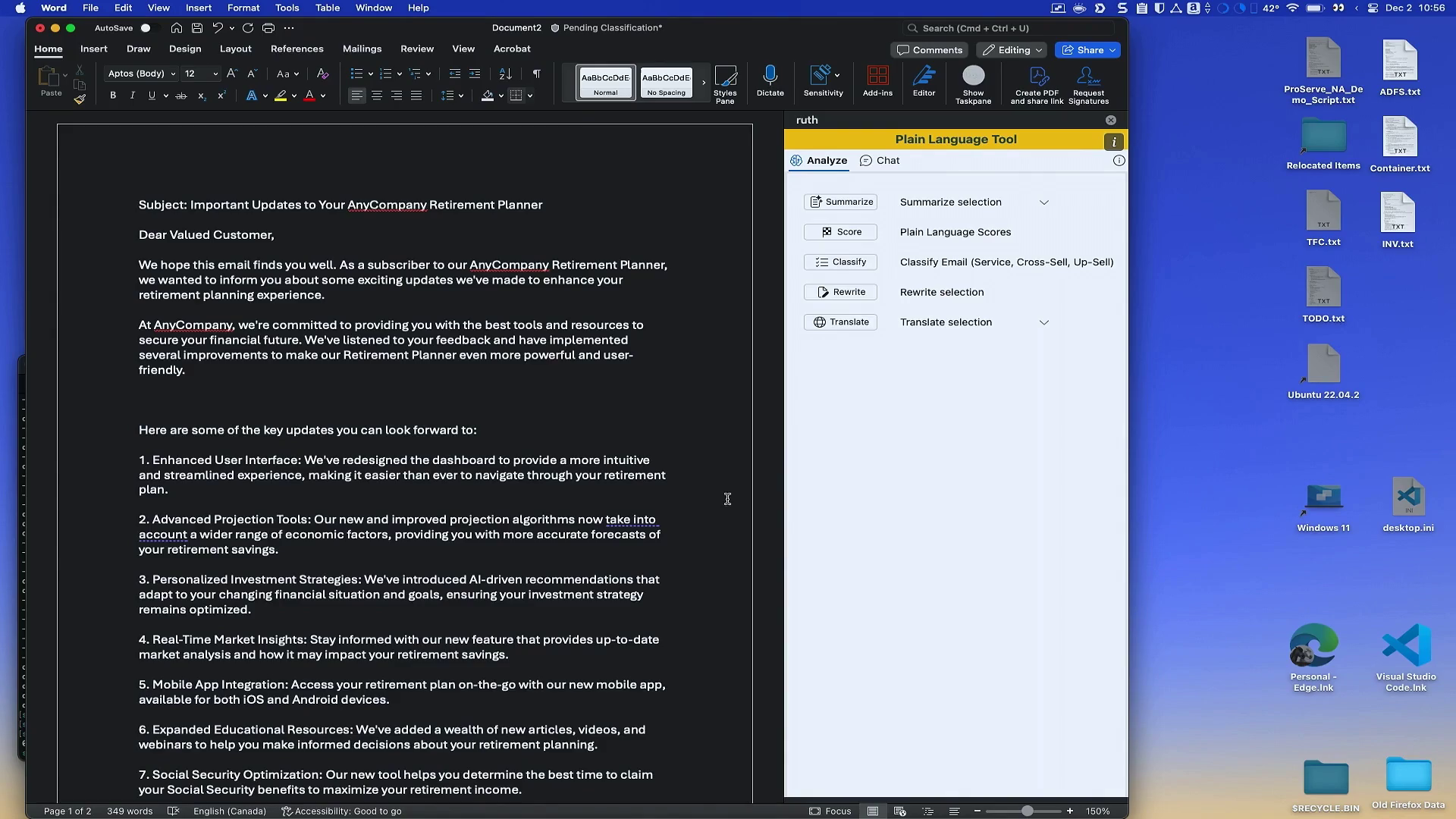

亚马逊云科技的首席顾问Salman Mogul随后介绍了两个利用AppSync作为AI网关的企业用例。第一个案例涉及使用大型语言模型(LLM)如Anthropic的Claude进行内容分析。Mogul展示了如何将AppSync与Microsoft Office应用程序集成,实现实时内容分析和语言评分,从而为营销专业人士节省大量成本并自动分析语言。

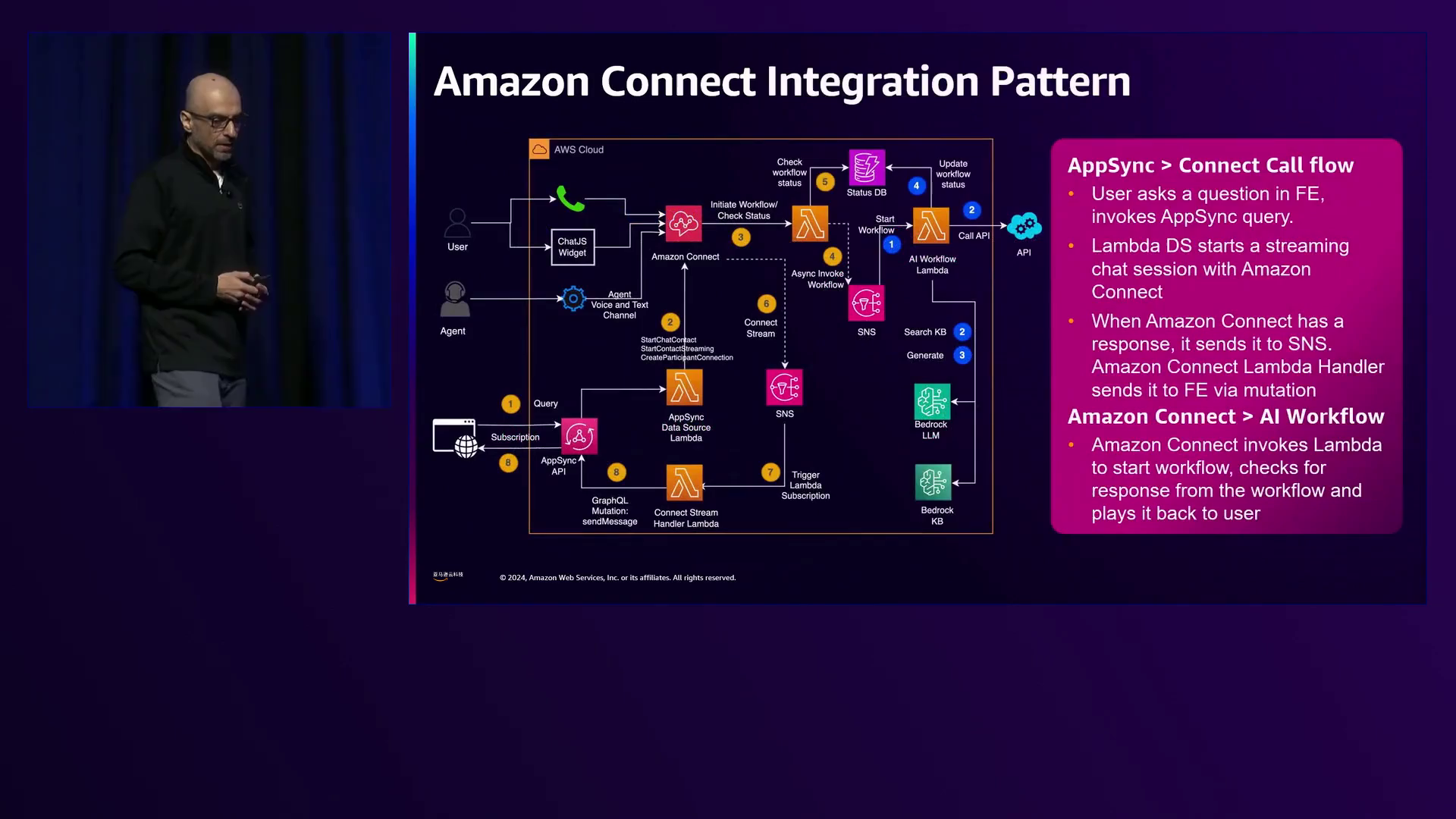

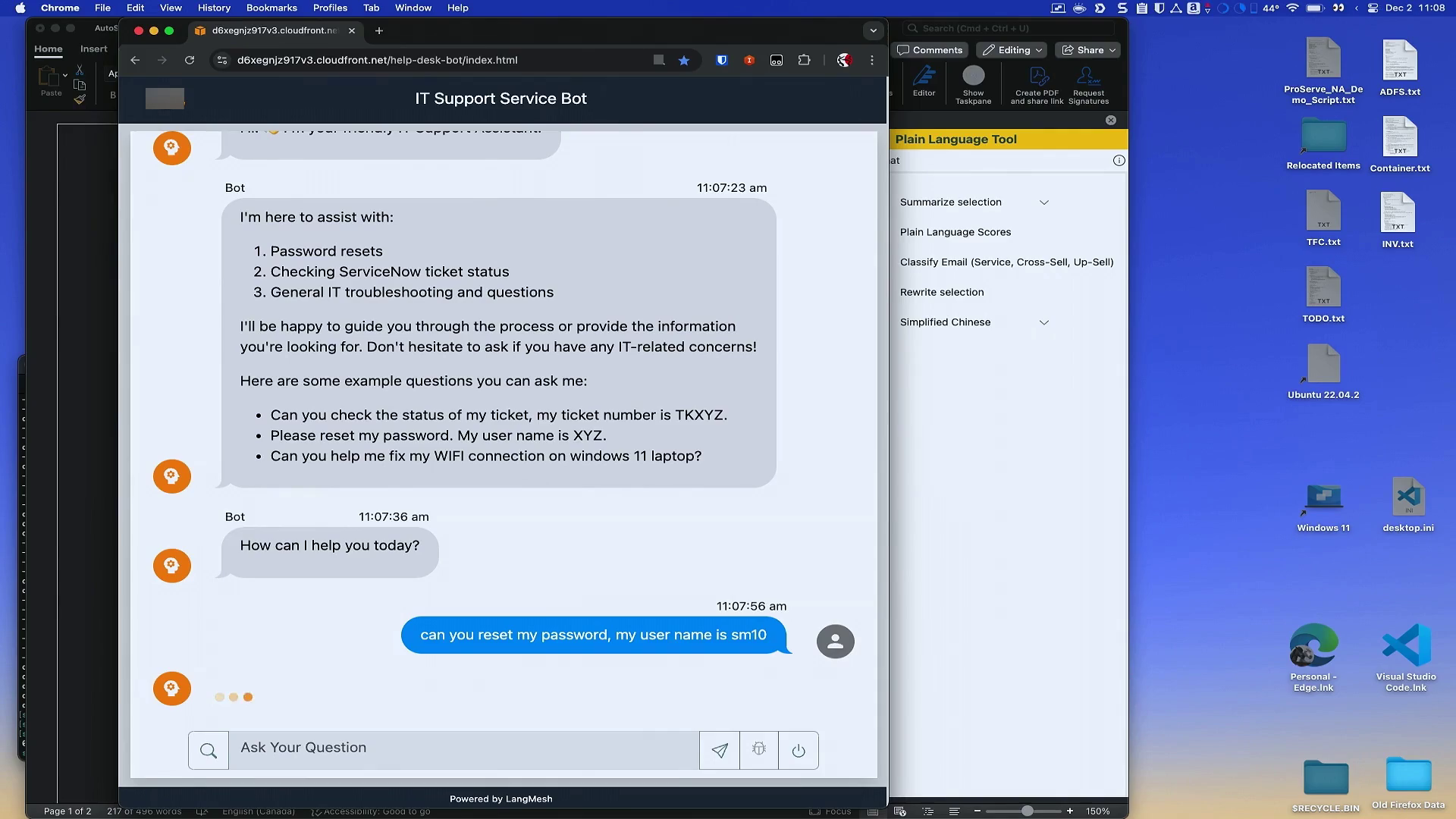

第二个用例关注于联系中心,以及AppSync如何通过克服Amazon Connect的8秒超时限制来实现长时间运行的工作流程。Mogul演示了AppSync如何实现对等待电话的客户的实时更新,缩短平均解决时间并引入24/7支持。他展示了一个利用Claude理解复杂查询并执行适当工具(如密码重置、票证状态检查和知识库搜索)的代理工作流程。

来自Anthropic应用AI团队的Kyle Rube随后讨论了在构建LLM时面临的五大常见挑战。首先是模型选择:Rube建议使用公开的基准测试和排行榜来缩小模型选择范围,考虑价格和延迟要求,并为特定任务制定评估策略。他强调了Anthropic的模型,包括具有智能和视觉能力的Claude 3.5 Sonnet,以及适用于需要实时性能的任务的高速Claude 3.5 Haiku。

其次是提示:Rube强调了清晰、直接的提示以及结构化示例和思维链输出的重要性。他讨论了元提示工具在创建和改进提示方面的作用,以及使用示例和思维链来提高输出质量的技术。Rube提到,虽然Claude 2需要大量的提示工程工作,但较新的Claude 3及以上版本在提示方面更加直观和易于使用。

第三是延迟:输出流、使用更快的模型如Claude 3.5 Haiku、减少输出标记、提示缓存和缩短输入标记等技术可以帮助改善延迟。Rube强调了根据使用场景平衡速度和准确性的重要性,指出在处理数千个标记时,减少输出标记或缩短提示可能会对延迟产生显著影响。

第四是结构化数据输出:Rube提供了从LLM获取一致、高质量JSON输出的技术,包括明确的指令、示例、工具使用和预填充。他解决了将LLM集成到需要结构化数据的后端流程的常见挑战,强调即使没有正式的JSON模式,Claude 3及以上版本也已经通过适当的提示训练来输出JSON。

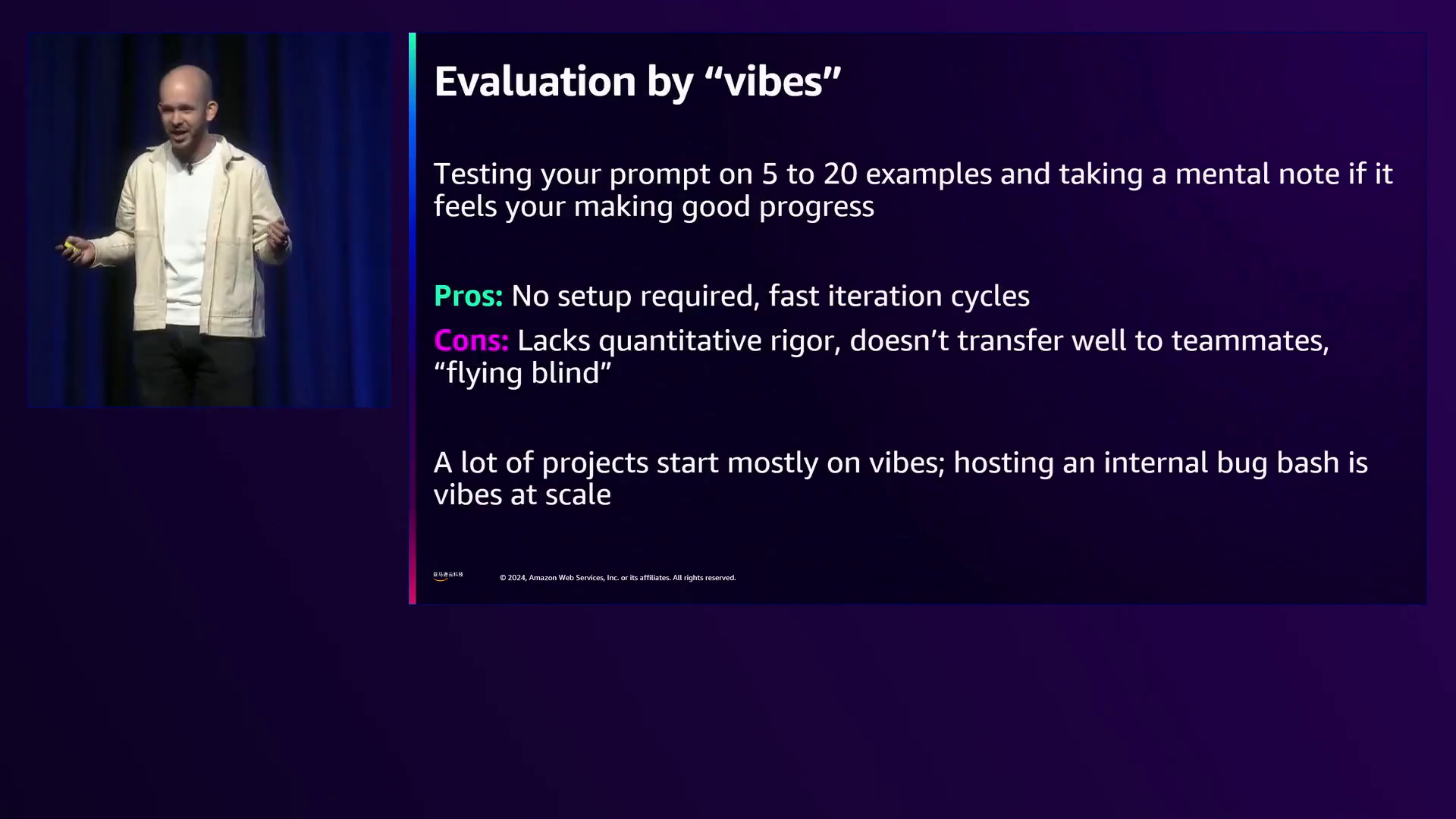

第五是评估:Rube讨论了各种评估方法,包括“vibes”(主观评估)、人工评估(带评分标准)、A/B测试、程序化检查以及使用LLM作为评判者。他建议根据业务目标采用混合方法,并在提示工程和LLM功能开发过程中进行迭代。Rube提到,虽然“vibes”评估缺乏定量严谨性,但在初始提示工程阶段可能有用,而举办内部“bug狩猎”活动可被视为“大规模vibes”。

总之,本次会议涵盖了使用Amazon AppSync作为AI网关将应用程序连接到Amazon Bedrock、在内容分析和联系中心的企业用例,以及在使用LLM时模型选择、提示、延迟优化、结构化数据输出和评估的最佳实践。演讲者提供了见解和演示,帮助客户应对生成式AI集成的挑战和机遇,利用Amazon AppSync和Anthropic的Claude等LLM的功能。

下面是一些演讲现场的精彩瞬间:

演讲者承认生成式人工智能的广泛采用,并强调客户在将其应用程序与生成式人工智能后端集成时所面临的挑战。

利用大型语言模型Claude来自动生成内容、提供语气指导和语言分析,从而实现显著的成本节约和增强品牌语音的一致性。

演讲者演示了使用Amazon AppSync作为网关进行同步调用,以利用大型语言模型执行内容分析,展示了根据提供的指导原则实时响应和分析文档写作风格的情况。

演讲者解释了实时聊天系统的架构,该系统集成了Amazon Connect、Amazon Lambda、Amazon Lex和其他服务,为用户提供无缝的对话体验。

Claude展示了如何连接Amazon Connect和长期运行的工作流程,无缝处理重置密码和检查票证状态等多步骤请求。

Andrej Karpathy强调了“通过直觉评估”在提示工程中的方法,在这种方法中,您可以根据直觉和心理笔记反复测试和完善提示,同时承认其在定量严谨性和可转移性方面的局限性。

演讲者强调,语言模型的评估方法应与业务目标保持一致,提示工程是一个迭代过程,可从灵活的评估过程中获益,以加快产品开发。

总结

简介: 本次演讲深入探讨了将Amazon AppSync作为AI网关的应用,实现应用程序与Amazon Bedrock等生成式AI后端的无缝集成。它探讨了企业用例,并解决了构建利用大型语言模型(LLM)的应用程序时面临的常见挑战。

关键点1: AppSync作为强大的AI网关,促进应用程序与Amazon Bedrock模型之间的安全连接。它提供灵活的安全性和访问控制,使授权用户能够与模型交互,同时保护知识产权。AppSync支持同步和异步调用、实时更新以及前端和后端访问模式的解耦,适用于各种应用程序类型。

关键点2: 演讲展示了两个企业用例:使用LLM进行内容分析,以及将Amazon Connect与生成式AI功能集成。内容分析用例展示了如何使用AppSync自动进行语言评分、品牌语音分析和基于提示和Claude模型的内容生成。Amazon Connect集成说明了AppSync如何支持长时间运行的工作流,实现对通话客户的实时更新,缩短平均解决时间。

关键点3: 讨论了构建基于LLM的应用程序时面临的常见挑战,包括模型选择、提示工程、延迟优化、结构化数据输出和评估策略。探讨了使用示例、思维链提示、流式输出和利用元提示工具等技术。还介绍了人工评分、A/B测试、程序化检查和使用LLM作为评判者等评估方法。

总结陈词: 演讲强调了迭代式提示工程和评估过程的重要性,以快速将基于LLM的产品投入生产。它突出了Amazon AppSync作为强大的AI网关,使企业能够安全高效地利用生成式AI功能,同时解决构建基于LLM的应用程序时面临的常见挑战。

亚马逊云科技(Amazon Web Services)是全球云计算的开创者和引领者。提供200多类广泛而深入的云服务,服务全球245个国家和地区的数百万客户。做为全球生成式AI前行者,亚马逊云科技正在携手广泛的客户和合作伙伴,缔造可见的商业价值 – 汇集全球40余款大模型,亚马逊云科技为10万家全球企业提供AI及机器学习服务,守护3/4中国企业出海。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?