你是否在做多模态情感分析却苦于找不到优质论文?

是否想快速复现SOTA模型却卡在代码细节上?

别急!我们整理了7篇多模态情感分析的顶会论文+开源代码,覆盖Transformer、低秩融合、对比学习等前沿技术,助你轻松掌握领域核心!

内容亮点👇

1️⃣ 创新模型:跨模态注意力、强化学习动态融合、情感预训练Transformer…

2️⃣ 权威数据集:CMU-MOSEI、MOSI等主流数据集解析与使用指南。

3️⃣ 即拿即用:每篇论文附PDF下载链接和GitHub代码仓库,一键复现实验结果!

工棕号“AI因斯坦”回复 “7多模态+情感分析” 即可领取【多模态+情感分析】研究论文

Multimodal Transformer for Unaligned Multimodal Language Sequences

文章解析

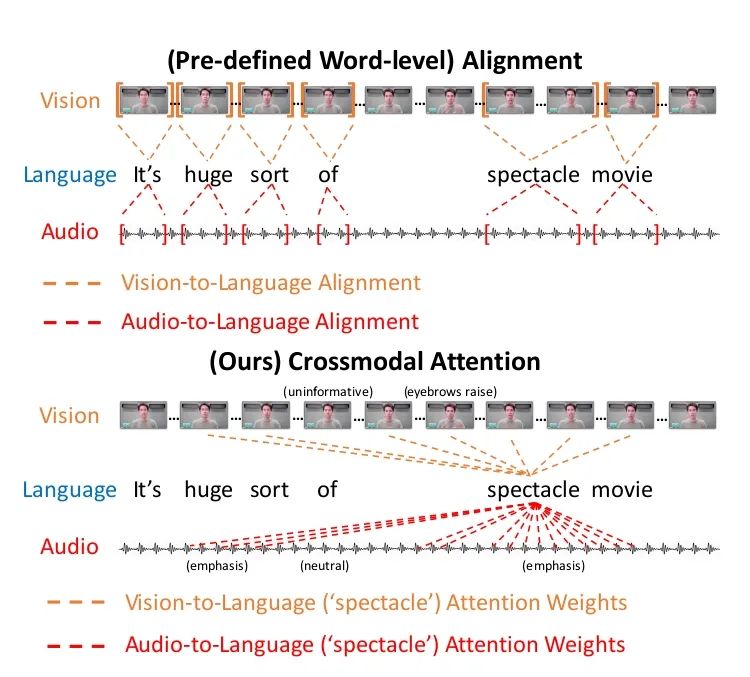

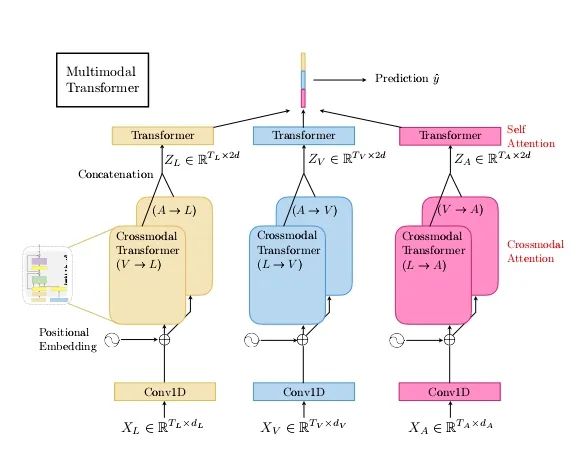

本文提出了一种基于Transformer的多模态融合模型(MulT),解决了多模态数据(文本、音频、视觉)在时间上未对齐的问题,通过跨模态注意力机制实现模态间的动态交互。

创新点

1.引入跨模态注意力模块,无需人工对齐时序数据,直接建模模态间依赖关系。

2.双向跨模态注意力机制:允许任意两种模态间双向交互(如文本→音频、音频→文本),而非单向融合。

3.时序位置编码增强:针对未对齐数据设计相对位置编码,捕捉跨模态的局部时序依赖关系。

Memory Fusion Network for Multi-view Sequential Learning

文章解析

本文提出记忆融合网络(MFN),通过LSTM和动态记忆网络捕捉多模态序列的长期跨模态交互。

创新点

1.文章结合多视图LSTM和门控记忆模块,解决多模态数据中的时序不一致性和噪声问题。

2.分层记忆结构:通过短期记忆(LSTM)和长期记忆(Delta-memory)分层建模,兼顾细粒度与全局交互。

3.自适应时间建模:动态调整不同模态的时间窗口权重,缓解多模态时序异步问题。

CMU-MOSEI: Multimodal Language Analysis in the Wild

文章解析

本文发布大规模多模态情感分析数据集CMU-MOSEI,提供文本、音频、视频数据及细粒度情感标注。

创新点

1.首个包含23,500条YouTube视频片段的多模态数据集,支持情感强度、情绪分类等多任务。

2.多模态对齐工具包:提供自动对齐文本、音频、视频时序的工具,降低数据预处理门槛。

3.多任务标注框架:同时支持情感强度、情绪分类、主观性检测等任务,扩展研究边界。

Efficient Low-rank Multimodal Fusion with Modality-Specific Factors

文章解析

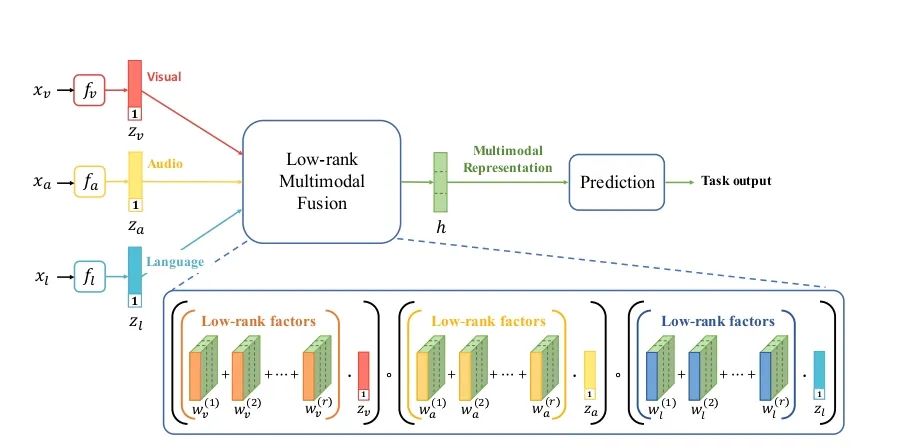

本文提出低秩多模态融合(LMF)方法,通过张量分解降低多模态融合计算复杂度。

创新点

1.引入模态特定因子分解,将融合复杂度从指数级降至线性级,提升效率。

2.张量分解参数共享:通过共享低秩因子矩阵减少冗余参数,提升模型泛化能力。

3.动态模态权重调整:根据输入数据动态分配模态融合权重,避免噪声模态干扰。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?