一、蒸馏技术概述

1.什么是大模型蒸馏

大模型蒸馏(Knowledge Distillation)是一种将庞大、复杂的教师模型(Teacher Model)中的知识迁移到更小、更高效的学生模型(Student Model)中的技术。这一概念最早由Hinton等人在2015年提出,现已成为大模型优化领域的关键技术。

2.为什么需要模型蒸馏

部署瓶颈:GPT-3等大模型参数量高达1750亿,难以在资源有限设备运行

成本问题:大模型推理需要昂贵计算资源,如A100 GPU

效率需求:实际应用往往需要毫秒级响应,大模型难以满足

隐私考虑:某些场景无法将数据上传到云端大模型

3.蒸馏的核心思想

通过让学生模型不仅学习原始数据的标签,还学习教师模型的"软标签"(soft targets)和中间层特征,实现知识的高效迁移。

二、技术架构详解

1.系统架构设计

现代蒸馏系统采用分层知识迁移架构,包含三大核心组件:

class DistillationSystem:

def __init__(self, teacher, student):

self.teacher = teacher # 冻结参数的预训练大模型

self.student = student # 待训练的小模型

def knowledge_extraction(self, inputs):

# 提取教师模型的三种知识

with torch.no_grad():

teacher_logits = self.teacher(inputs)

hidden_states = self.teacher.get_hidden_states(inputs)

attention_maps = self.teacher.get_attention(inputs)

return teacher_logits, hidden_states, attention_maps

def loss_calculation(self, student_outputs, teacher_data):

# 多维度损失计算

logit_loss = KL_divergence(student_outputs.logits, teacher_data.logits)

feature_loss = MSE(student_outputs.hiddens, teacher_data.hiddens)

relation_loss = CosineSimilarity(student_outputs.attn, teacher_data.attn)

return logit_loss + feature_loss + relation_loss

2.主流蒸馏范式对比

三、关键技术实现

1.温度调节(Temperature Scaling)

软化概率分布,增强暗知识信号:

T = 5 # 温度参数

soft_targets = F.softmax(teacher_logits / T, dim=-1)

student_probs = F.log_softmax(student_logits / T, dim=-1)

kld_loss = F.kl_div(student_probs, soft_targets, reduction='batchmean') * T**2

2.层映射策略(Layer Mapping)

解决师生模型结构不匹配问题:

# 将BERT的12层映射到DistilBERT的6层

layer_mapping = {

0: [0, 1], # 学生第0层学习教师0-1层

1: [2, 3],

...,

5: [10, 11]

}

3.渐进式训练(Progressive Training)

分阶段迁移不同粒度的知识:

# 训练计划示例

scheduler = {

'stage1': {'epochs': 10, 'components': ['logits']},

'stage2': {'epochs': 20, 'components': ['hiddens', 'attn']},

'stage3': {'epochs': 10, 'components': ['logits', 'hiddens']}

}

4.对抗蒸馏(Adversarial Distillation)

引入判别器提升知识迁移效果:

discriminator = Discriminator()

g_loss = BCEWithLogitsLoss(discriminator(student_logits), real_label)

d_loss = BCEWithLogitsLoss(discriminator(teacher_logits), fake_label)

四、未来前景

1.技术发展趋势

自动化蒸馏:自动设计最优学生模型架构、自适应知识选择机制、蒸馏过程自动优化

多模态蒸馏:跨模态知识迁移(文本→图像→语音)、统一的多模态表示学习、多模态联合蒸馏框架

持续学习蒸馏:增量式知识更新、终身学习蒸馏系统、动态适应新任务和新数据

2.应用前景展望

边缘计算革命

移动端AI:智能手机上的大模型应用

IoT设备:智能家居、可穿戴设备的AI升级

实时系统:AR/VR、自动驾驶的实时处理

行业深度应用

医疗健康:便携式诊断设备

金融服务:实时风险控制系统

智能制造:设备端的质量检测

隐私保护场景

联邦学习+蒸馏:保护数据隐私的同时共享知识

完全本地化AI:敏感数据不出设备

安全关键应用:国防、金融等领域的AI部署

大模型蒸馏技术正成为AI落地应用的关键桥梁。从最初的简单输出模仿,到现在的多层次知识迁移,蒸馏技术已经发展成为一个丰富而深入的研究领域。未来,随着算法的不断创新,我们将看到更多"小而精"的蒸馏模型在各个行业大放异彩。

对于AI从业者来说,掌握蒸馏技术不仅能够解决实际部署问题,更是深入理解模型压缩和知识迁移的重要途径。建议读者从简单的实验开始,逐步探索这一充满可能性的技术领域。记住,在AI的世界里,有时候"小"才是真正的"大"——小而精的模型往往能带来更大的应用价值。

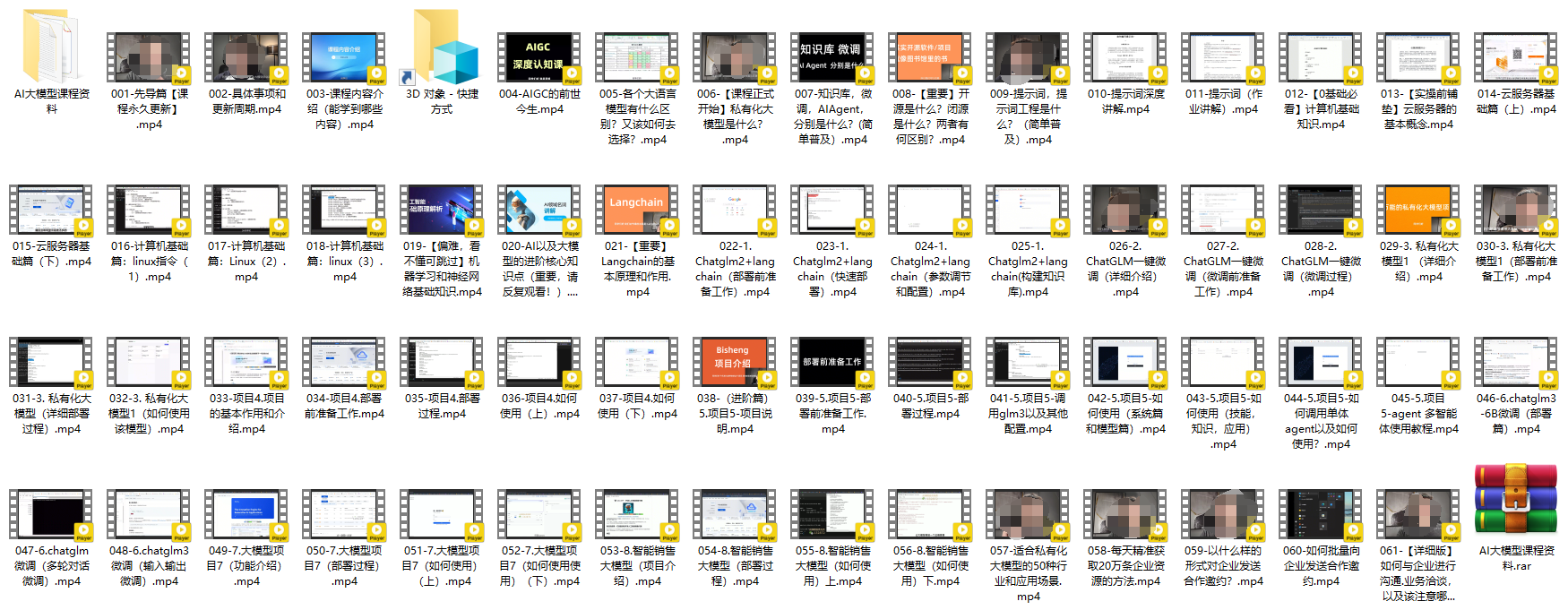

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

3.AI大模型视频合集

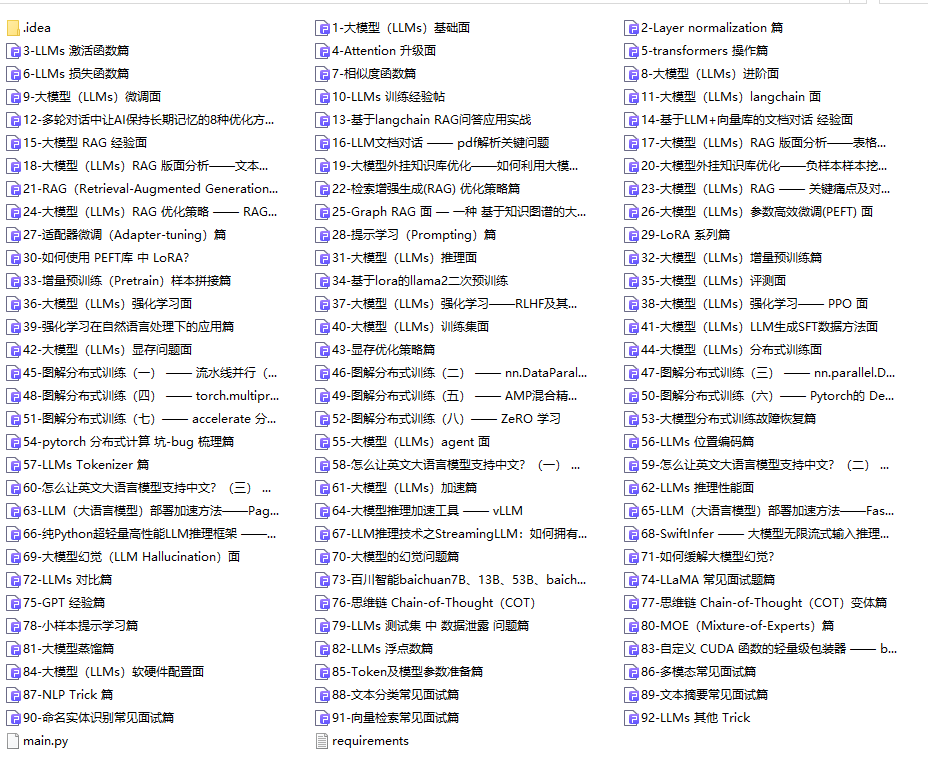

4.LLM面试题和面经合集

5.AI大模型商业化落地方案

📣朋友们如果有需要的话,可以V扫描下方二维码联系领取~

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?