一、微调定义

1.微调技术的本质与价值

在人工智能领域,大模型微调(Fine-tuning)已成为连接通用AI能力与垂直行业应用的桥梁。这项技术通过在预训练大模型(如GPT-4、LLaMA等)基础上进行针对性训练,使模型具备特定领域的专业知识或任务能力。与动辄需要数百万美元训练的基座模型相比,微调技术能以1%-10%的成本实现90%以上的专业场景效果。

典型案例对比:

通用ChatGPT在医疗问答中的准确率:约65%

经过医学文献微调的版本准确率:可达92%以上

训练成本对比:从头训练需4.6Mvs微调仅需4.6Mvs微调仅需50k

2.微调技术的适用场景矩阵

| 场景类型 | 数据规模 | 推荐方法 | 训练时间 | 典型准确率提升 |

|---|---|---|---|---|

| 专业领域适配 | >10万条 | 全参数微调 | 20-100小时 | 25-40% |

| 垂直场景优化 | 1万-10万 | LoRA | 5-20小时 | 15-25% |

| 快速任务适配 | <1万条 | Prompt Tuning | <1小时 | 5-15% |

二、深度解构

1.智能数据处理流水线

数据增强策略:

同义词替换(保留95%语义)

回译增强(中→英→中)

语法树扰动

领域术语注入

质量评估指标:

def calculate_data_quality(dataset):

diversity = len(set(dataset)) / len(dataset)

complexity = avg([len(text.split()) for text in dataset])

domain_sim = cosine_sim(domain_emb, dataset_emb)

return 0.4*diversity + 0.3*complexity + 0.3*domain_sim2.动态微调调度器

实现原理:

class DynamicScheduler:

def __init__(self, model, initial_lr=5e-5):

self.optimizer = AdamW(model.parameters(), lr=initial_lr)

def step(self, current_loss):

# 基于损失变化动态调整学习率

if loss_decreased:

self.optimizer.param_groups[0]['lr'] *= 1.1

else:

self.optimizer.param_groups[0]['lr'] *= 0.9三、前沿技术实现

1.混合专家微调(MoE)实战

典型配置:

from transformers import MoEModel

model = MoEModel.from_pretrained(

"google/switch-base-32",

num_experts=32,

expert_capacity=64

)

# 训练时仅激活2个专家

outputs = model(input_ids, num_active_experts=2)性能优势:

训练速度提升3-5倍

显存占用减少60%

保持95%以上模型精度

2.量化微调技术(QLoRA)

实现流程:

将原始模型量化为4-bit

添加可训练的32-bit低秩适配器

仅更新适配器参数

内存对比:

| 方法 | 参数量 | 显存占用 | 训练速度 |

|---|---|---|---|

| 全参数 | 7B | 80GB | 1x |

| LoRA | 0.1B | 24GB | 1.2x |

| QLoRA | 0.1B | 8GB | 1.5x |

3.多模态联合微调

架构设计:

[文本编码器] ←对比学习→ [图像编码器]

↓ ↓

[跨模态融合层] ←注意力机制→

↓

[任务特定头部]关键技术:

模态对齐损失函数、跨模态注意力机制、渐进式微调策略

四、实战指南

1.学习路线图

入门阶段(1个月):

HuggingFace Transformers基础、简单分类任务微调、可视化监控工具使用

进阶阶段(3个月):

参数高效微调实现、分布式训练优化、模型压缩技术

专家阶段(6个月+):

自定义微调算法、多模态联合微调、自动化微调系统开发

2.推荐工具栈

| 工具类型 | 推荐选择 | 适用场景 |

|---|---|---|

| 框架 | PyTorch Lightning | 快速原型开发 |

| 微调库 | HuggingFace PEFT | 参数高效微调 |

| 分布式 | DeepSpeed | 大规模训练 |

| 可视化 | Weights & Biases | 实验追踪 |

从通用智能到垂直场景,微调技术正成为AI工业化落地的核心驱动力。随着自动化工具链的成熟与边缘计算的突破,未来企业可通过“预训练模型+轻量化微调”快速构建领域专属模型,将大模型潜力转化为生产力。而如何在性能、效率与安全之间找到平衡点,将是技术持续突破的关键。

AI不会淘汰人类,但会淘汰不会用AI的人

这不是科幻电影,而是2025年全球职场加速“AI化”的缩影。从最新数据看,全球已有23%的知识型岗位因AI大模型缩减规模,而在编程、翻译、数据分析等领域,替代率更飙升至40%以上。当AI开始撰写法律合同、设计建筑图纸、甚至独立完成新药分子结构预测时,一个残酷的真相浮出水面:人类与AI的竞争,已从辅助工具升级为生存战争。

留给人类的时间窗口正在关闭。学习大模型已不是提升竞争力的可选项,而是避免被淘汰的必选项。正如谷歌CEO桑达尔·皮查伊所说:“未来只有两种人:创造AI的人,和解释自己为什么不需要AI的人。”你,选择成为哪一种?

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

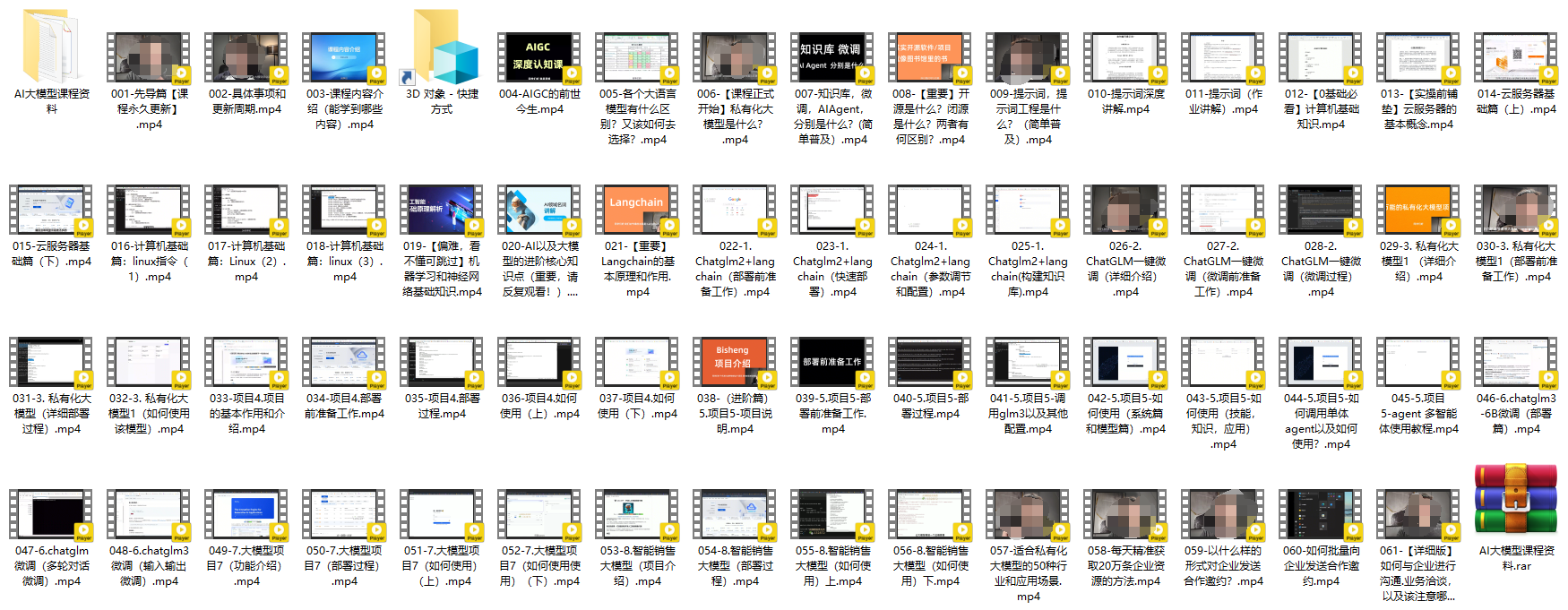

3.AI大模型视频合集

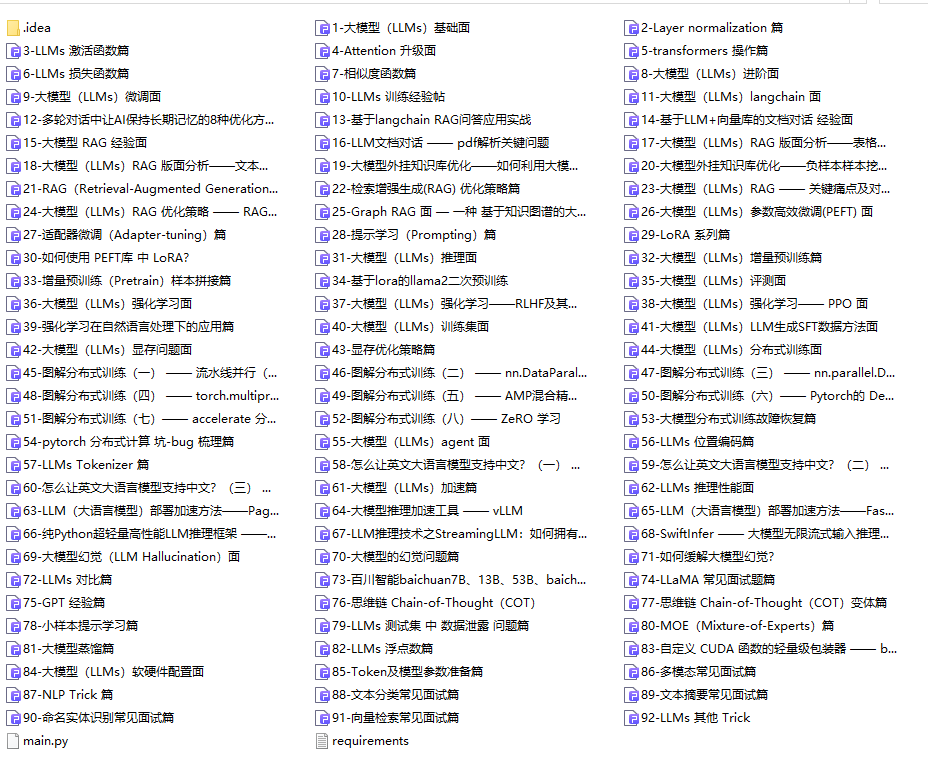

4.LLM面试题和面经合集

5.AI大模型商业化落地方案

📌朋友们如果有需要的话,可以V扫描下方二维码联系领取~

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?