一、大模型框架概述

在人工智能技术飞速发展的今天,大型语言模型(LLM)已成为推动行业变革的核心驱动力。AI大模型框架作为支撑这一技术的基础设施,正在重塑AI应用的开发方式。这类框架通过提供标准化的开发接口、优化的计算架构和高效的资源管理,使开发者能够更便捷地构建和部署大模型应用。

当前主流的大模型框架生态系统呈现出多元化发展态势:开发框架如LangChain和Dify通过模块化设计降低开发门槛;微调平台如LLAMA Factory专注于模型优化;推理加速方案如TensorRT和vLLM则显著提升服务性能。这些框架共同构成了大模型技术落地的完整技术栈。

二、技术架构深度解析

1.分层架构设计

现代大模型框架普遍采用四层架构设计:

应用接口层:

提供RESTful API和SDK、可视化开发界面、多语言支持(Python/Java/Go等)

核心服务层:

模型管理服务、任务调度引擎、资源管理系统、监控告警模块

计算加速层:

分布式训练框架、推理优化引擎、硬件加速接口(CUDA/ROCm)

数据支撑层:

参数存储系统、训练数据管理、特征工程管道

2.典型架构对比

| 框架类型 | 代表产品 | 架构特点 | 适用场景 |

|---|---|---|---|

| 开发框架 | LangChain | 组件化设计,丰富扩展 | AI应用快速开发 |

| 微调平台 | LLAMA Factory | 高效参数更新,任务定制 | 领域模型优化 |

| 推理引擎 | TensorRT | 极致优化,低延迟 | 生产环境部署 |

三、关键技术实现剖析

1.分布式训练核心技术

混合并行策略:

3D并行(数据/模型/流水线)、自动并行度调整、异构计算支持

内存优化技术:

ZeRO-3优化器状态分区、梯度检查点技术、动态显存管理

通信优化:

异步梯度聚合、拓扑感知通信调度、梯度压缩(1-bit Adam等)

2.推理加速创新方案

量化技术演进:

动态量化(DQ)、稀疏量化(SQ)、混合精度量化

注意力机制优化:

FlashAttention实现、内存高效注意力、稀疏注意力模式

服务化创新:

动态批处理、请求优先级调度、自动扩缩容

四、未来发展趋势展望

1.技术演进方向

全栈一体化:

训练/微调/服务统一框架、自动机器学习(AutoML)集成、端到端优化工具链

多模态融合:

跨模态统一表示、多模态预训练架构、联合推理引擎

边缘计算适配:

模型轻量化技术、联邦学习支持、边缘-云协同架构

2.行业应用前景

垂直领域深耕:

金融风控模型、医疗诊断系统、工业质检方案

新型服务模式:

模型市场生态、按需计算服务、专属模型定制

AI大模型框架的发展正在加速人工智能技术的民主化进程。随着技术不断成熟,我们预计将看到:

1.开发门槛持续降低,更多非AI专家能够构建复杂应用

2.推理效率大幅提升,单位成本显著下降

3.行业专用框架涌现,推动垂直领域创新

对于开发者而言,深入理解大模型框架的技术原理,掌握核心优化方法,将是在这一波AI浪潮中保持竞争力的关键。建议持续关注开源社区动态,积极参与框架优化实践,共同推动大模型技术的发展。

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

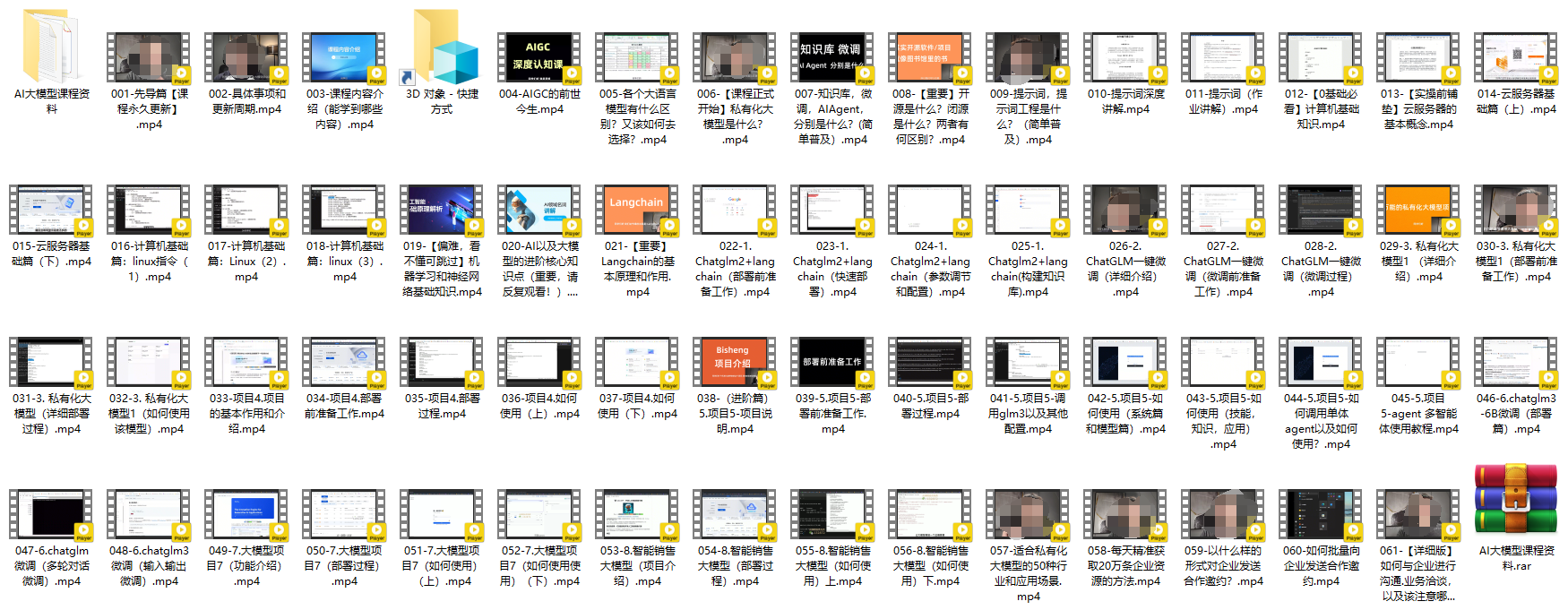

3.AI大模型视频合集

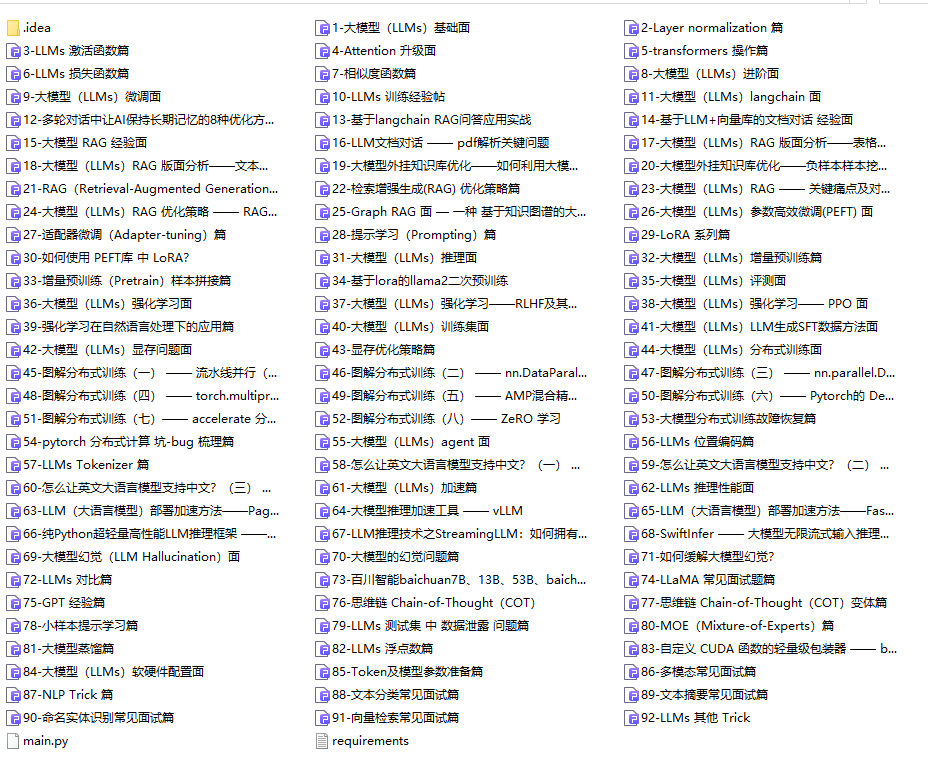

4.LLM面试题和面经合集

5.AI大模型商业化落地方案

📣朋友们如果有需要的话,可以V扫描下方二维码联系领取~

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?