(如果报错,复制代码到deep seek中查找解析)

一.Ubuntu 虚拟机的安装

1.打开VMware,点击左上角文件,新建虚拟机

2.配置类型:典型(默认),下一步 ,

,

3. 安装来源:选择“安装程序光盘映像文件(iso)”,点击右侧的浏览按钮, 找到下载好的 ubuntu-20.04.4-desktop-amd64.iso 文件,然后点击下一步

4. 在简易安装信息的窗体中,将全名、用户名、密码、确认等几项均设为“spark”, 方便后面使用,然后点击下一步

5. 在命名虚拟机的窗体中,可以设定一下虚拟机名称或直接按默认,然后点击下一步

6. 磁盘容量:60GB, 下一步

7.最后点击完成

8. Vmware 完成新建虚拟机后,会自动启动 Ubuntu20.04 的安装过程

9.稍候几分钟的时间进行安装,当虚拟机安装完毕,就会出现 Ubuntu20.04 的登录界面

10.点击账户spark后,输入密码”spark”

11. Ubuntu20.04 操作系统的初始界面如图所示,第一次启动时会相继提示几个信息的 设置,包括网络在线帐号设置、更新设置、问题提交、隐私设置等,直接点击右上角的“Skip” 和“Next”,直至最后一个窗体点击“Done”全部完成.

12如果在使用过程中出现类似下面的升级提示,直接点击“Don't Upgrade”保持当 前所用 Ubuntu20.04 版本即可

13. 为方便后续操作,这里再整理一下 Ubuntu20.04 左侧任务栏的图标,只保留最常用 的几个快捷方式。方法是:找到左侧垂直的任务栏,在要隐藏的图标上点击鼠标右键,选择 “Remove from Favorites”,完成后的操作系统桌面如图所示(左侧的问号隐藏)

14. 鼠标右键点击 Ubuntu20.04 桌面的中间空白位置(注意不是在应用程序图标上), 选择弹出菜单中的“Open in Terminal”,启动 Linux 终端控制台窗体

15. Linux 终端窗体启动后,在左侧任务栏的“Linux 终端”图标上点击鼠标右键,选 择弹出菜单中的“Add to Favorites”将其固定在任务栏

16. 点击 Ubuntu20.04 桌面右上角的电源图标,选择“Power Off/Log Out”下面的“Power Off”菜单项,然后在弹出的窗体中再点击“Power Off”按钮,关闭当前虚拟机

17. 回到 Vmware Workstation,选中这里安装的 Ubuntu20.04,然后点击“编辑虚拟机设置”

18. 4GB 内存和 2 个处理器

二.Ubuntu 基本配置

1.开启ubuntu64位虚拟机,打开终端, 输入下面的命令更新一下软件源:sudo apt update

2. 为避免版本冲突先卸载内置的 openssh-client,在安装 openssh-server 时会自动安装匹配版本的 openssh-client

(代码: sudo apt -y remove openssh-client

sudo apt -y install openssh-server)

3. 继续输入下面的命令安装 vim,即vi 编辑器的增强版,它支持一些更丰富的功能, 如不同颜色的高亮代码显示等。当 vim 安装完毕,在终端输入 vi或 vim 命令,实际启动的 就是这个增强版的vim 编辑器

(代码:sudo apt -y install vim)

4. 输入下面的命令,将 Ubuntu20.04 自带的防火墙禁用掉,避免在远程终端连接时出 现问题,包括运行 Hadoop 和 Spark 时也要禁用防火墙

(代码:sudo ufw disable)

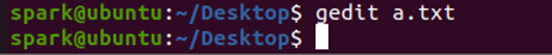

5. Windows 自带的记事本是一个简单易用的文字编辑器,在 Ubuntu20.04 的桌面环境 中也有一个类似的图形化“Text Editor”文本编辑器,可以在应用程序列表中找到并将它 启动起来

(1) 在使用这个图形化的文本编辑器打开或保存文件时,若编辑的文本文件对当前 Linux 帐户无访问权限的话,将导致无法正常打开或保存。此外,还可以通过终端命令启动编辑器, 执行 gedit命令时可以在前面加上 sudo 获取 root 权限,后面加上文件名进行编辑 (代码:gedit a.txt)

三.Vi 编辑器

1.进入vim编辑器

四.MobaXterm 远程连接工具

1. MobaXterm下载地址是 MobaXterm Xserver with SSH, telnet, RDP, VNC and X11 - Download,下载第一个免费版, 当 MobaXterm 便携版下载好后,将其解压缩到 Windows 的一个目录中,然后启动里面的 MobaXterm_Personal 可执行文件,就会打开 MobaXterm 窗体的初始界面

2下面以我们的 Ubuntu20.04 虚拟机为目标来简单说明一下 MobaXterm 的基本使用。首先 在 Linux 终端窗体中输入下面的命令查看一下当前虚拟机的 IP 地址.(代码:ip addr)

3. 在 MobaXterm 窗体左上角找到 Session 图标,点击后会打开一个连接会话设置窗体,这 个窗体列出了 MobaXterm 支持的各种远程连接类型,点击选择其中的第一项 SSH 图标,输入 虚拟机的 IP 地址,然后指定登录所用的帐号 spark,再点击 OK 即可

4. 首次连接到远程服务器时,MobaXterm 还会显示一个确认窗体。在这个窗体中,勾选“Do not show this message again”(不要再显示本确认信息),然后点击 Accept 即可

5. 输入连接所用帐户 spark 的密码(密码也是 spark)并回车,在弹出的是否要保存密码 的窗体中,勾选“Do not show this message again”(不再显示本信息),然后点击 No 不 保存登录密码

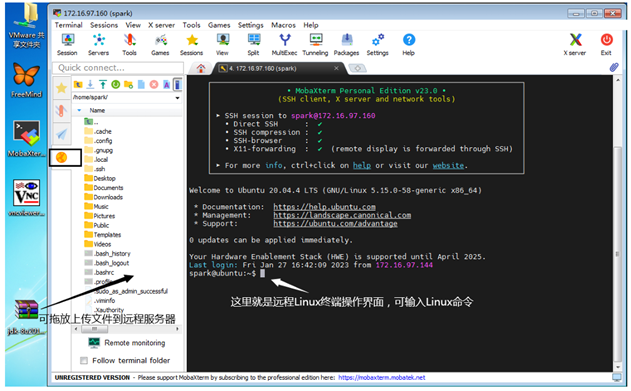

6. MobaXterm 成功连接远程服务器后的界面,如图所示。在这里,可以像 Linux 系统本地 一样执行命令,还可以通过左侧 SFTP(橘色圆形图标)将 Windows 本地的文件拖放上传到 远程服务器,后面的 JDK、Hadoop、Spark 等软件的安装就是通过这样的方法上传到 Ubuntu20.04 虚拟机的。使用完毕,只需按下 Ctrl+D 键或输入 exit 命令即可退出远程登录

Hadoop 伪分布集群环境搭建

- JDK 的安装配置

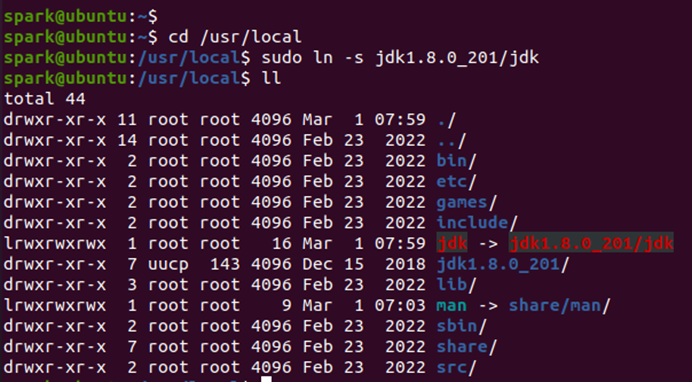

- 打开终端,输入下列代码. 将 JDK 解压缩到/usr/local 目录中, 并创建一个软链接指向 JDK 目录(代码:sudo tar -zxf jdk-8u201-linux-x64.tar.gz -C /usr/local

修改/etc/profile 文件,在其中添加有关 JDK 的环境变量设置,输入sudo vi /etc/profile进入编辑器

修改/etc/profile 文件,在其中添加有关 JDK 的环境变量设置,输入sudo vi /etc/profile进入编辑器

(输入a开始编辑,退出先按esc键,在输入:wq保存退出,在文末加入#jdk以下内容)

3. 测试JDK 的配置是否正常

4. JDK 安装完毕,最好重新启动一下 Ubuntu20.04 虚拟机,这样设置的环境变量就会 在 Linux 系统全局生效

Linux 免密登录

1.先在本机通过 ssh 命令执行一下远程连接,测试一下是否正常

2. 通过 ssh-keygen 生成免密登录所需的密钥信息(回车)

3.把本地主机的公钥复制到远程主机的 authorized_keys 文件上,以便双方连接通信时使用(密码:spark)

4. 测试一下是否能够免密登录

Hadoop 的安装

- 解压缩 hadoop-2.6.5.tar.gz 这个软件包

(代码:sudo tar -zxvf hadoop-2.6.5.tar.gz -C /usr/local

cd /usr/local

sudo ln -s hadoop-2.6.5 hadoop

ll)

2. 设置解压的 hadoop-2.6.5 目录的用户和组权限

3. 测试 Hadoop 是否能够正常使用

HDFS配置

1. 修改其中的 hadoop-env.sh 运行环境文件(JAVA_HOME 变量)

2. 修改 Hadoop 核心配置文件 core-site.xml

![]()

(添加以下代码 如图所示 保存退出

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>)

3. 修改 HDFS 设置文件 hdfs-site.xml

![]()

4. 最后查看一下 slaves 配置文件的内容

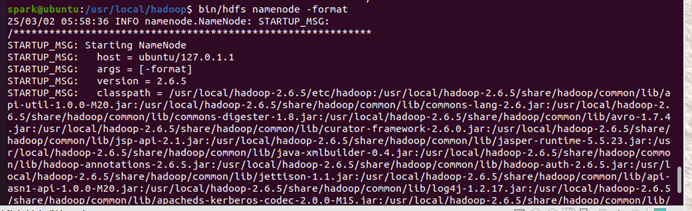

5. 配置文件修改完毕,首次运行之前要初始化 HDFS 的文件系统. 如果要重新初始化,应先清除相关目录中的内容(HDFS 存储过的数据会丢失),否则执行会失败

6. 启动 HDFS 服务程序

7. 使用 jps 命令查看 HDFS 的进程是否正常运行

YARN的配置

1. 打开 yarn-env.sh,找到其中的 JAVA_HOME 变量进行修改![]()

2. 打开 yarn-site.xml 文件,在其中增加与内存检查相关的设置

![]()

3.配置完毕,可以启动 YARN 服务相关的程序,执行过程中会分别运行 ResourceManager 和 NodeManager 这两个进程

4. 从 jps 命令的输出结果可以看出,YARN 集群资源管理服务已在运行

HDFS 和 YARN 的测试

- 使用 vi 编辑器修改/etc/profile 文件,在其中添加有关 Hadoop 环境变量设置

![]()

- 通过 source 命令使/etc/profile 的内容修改生效。注意:如果新开一个终端窗体, 需要在新终端重新执行一次 source 命令,除非重启动虚拟机才会全局有效

![]()

- 现在可以测试是否能够正常操作 HDFS,比如创建目录,上传文件等 (码:1. source /etc/profile

(2. touch hello.txt

(3. echo "hello,hello" >> hello.txt

(4. hdfs dfs -mkdir /mydata

(5. hdfs dfs -put hello.txt /mydata

(6. hdfs dfs -put hello.txt /mydata

(7. hdfs dfs -ls /mydata/*

(若遇到这个问题在nano ~/.bashrc中加入

export PATH=$PATH:/usr/local/hadoop/bin)

- 还可以在 Ubuntu20.04 里面启动浏览器,访问http://localhost:50070 查看 HDFS的 WebUI 管理页面,如图 1-38 所示。如果是在 Windows 的浏览器访问,则需要将网址中的 localhost 改成 Ubuntu20.04 虚拟机的 ip 地址(通过 Linux 终端命令 ip addr 可以找到)

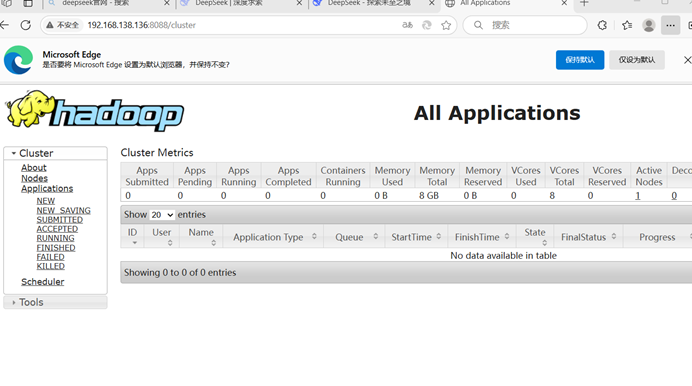

5. 在 Ubuntu20.04 浏览器中访问 http://localhost:8088,查看 YARN 的 WebUI 管理页 面,如图 1-39 所示。如果是在 Windows 的浏览器访问,则需要将网址中的 localhost 改成 Ubuntu20.04 虚拟机的 IP 地址才行

Spark 单机运行环境搭建

.Spark 的安装配置

1. 打开一个Linux终端,在其中执行以下命令将Spark软件包解压到/usr/local目录 中,并创建一个软链接文件指向Spark目录并修改目录的用户属性

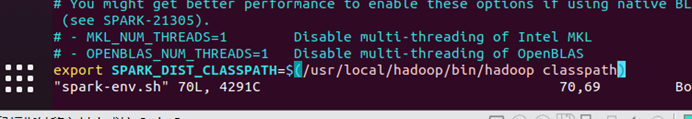

2. 接下来开始配置Spark运行环境,相比而言Spark的配置更简单,所有配置文件均 位于conf目录

(文末加入)

3. 使用 vi 编辑器修改/etc/profile 文件,在其中添加有关 Spark 的环境变量设置

- 通过source命令使/etc/profile的内容修改生效。注意:如果新开一个终端窗体,需要在新终端重新执行一次source命令,除非重启动虚拟机才会全局有效。

SparkShell交互编程环境

- 打开Linux终端窗体,输入spark-shell命令启动SparkShell交互式编程环境。启 动过程中可能会出现一个NumberFormatException的异常信息,这个问题不影响使用

等待一段时间后 如图下所示

正常的话,运行完毕就会打印输出hello.txt文件中的内容,说明Spark可以正常读取 本地磁盘的文件

2.再新开一个Linux终端,在里面输入jps命令查看HDFS服务是否在运行,如果没有 运行就要先将HDFS服务启动,正如在配置HDFS服务时所做的那样

- 现在可以验证Spark能否正常访问HDFS上的文件。前面测试HDFS时已经上传过一 个文件,路径为:/mydata/hello.txt,下面准备测试在SparkShell中读取这个文件。请转 至运行SparkShell的终端窗体,输入下面的代码

4. 通过上述的测试,说明Spark的安装配置是正确的。要退出SparkShell交互编程环 境,可以按下键盘上的Ctrl+D快捷键,或输入“:quit”并回车(冒号输入也包含在内)

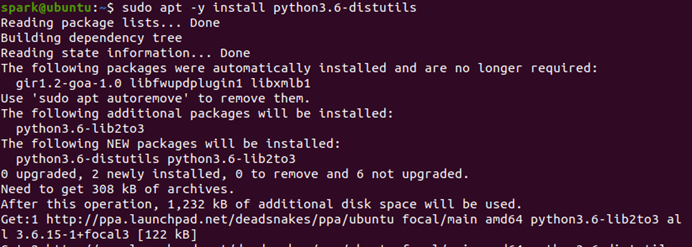

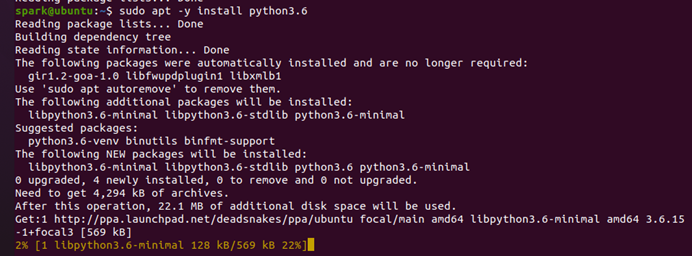

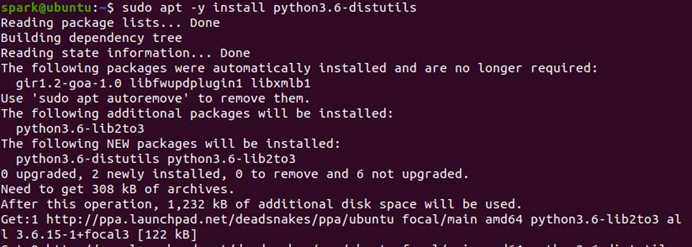

Python3.6的安装

1. 先查看 Ubuntu20.04 上已安装的 Python 相关程序文件

2. 我们可以分别运行 python3 和 python3.8 命令,以确认它们是否为同一个

3. 现在面临两个选择,一是将系统默认安装的 Python3.8 卸载替换成 Python3.6,这 种做法存在一定风险,因为可能影响到其它一些程序的使用。还有一种做法,就是在系统中 同时保留多个 Python 版本,然后根据实际需要切换使用(有现成工具辅助 Python 的多版本 管理)。这里准备采取第二种做法,即保留预装的 Python3.8,另外安装一个 Python3.6 运 行环境到系统中

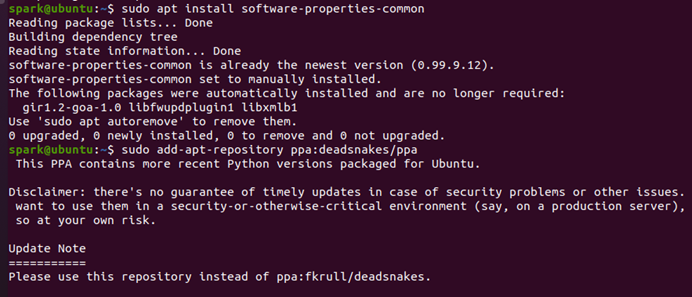

4. 由于 Ubuntu 软件源不含 Python3.6 的预编译版本,所以就要使用一个非常优秀的第 三方软件源 Deadsnakes PPA。请按照下面步骤将其安装进来

4. 由于 Ubuntu 软件源不含 Python3.6 的预编译版本,所以就要使用一个非常优秀的第 三方软件源 Deadsnakes PPA。请按照下面步骤将其安装进来

5.现在可以开始安装 Python 3.6,安装完毕查看一下 Python3.6 的启动程序

6.为了使得 pyspark 脚本能够找到正确的 Python 运行环境,可以在运行脚本之前设置一下 PYSPARK_PYTHON 的环境变量。为方便起见我们将其添加到/etc/profile 文件(或者在 Spark 中的 spark-env.sh 文件配置也可以)

![]()

PySparkShell交互编程环境

- 当 Python3.6 运行环境准备就绪,现在就可以启动 PySparkShell 交互编程环境了

(报错解决)

之后输入pyspark,如下图所示则表示成功 ,(进入pyspark输入quit()表示退出或Ctrl=D)

Pip的安装配置

1. 在Linux终端执行下面的命令安装pip工具,然后查看一下pip的版本信息,以及 和对应管理的Python版本

![]()

3. 现在可以验证 pip 和 pip3 的设置是否达到了预期目标

- 当 pip 包管理工具安装配置好之后,考虑到实际使用时需要访问网络下载软件,下 面将 pip 源改成国内镜像(如阿里云、清华镜像站点等),以加快下载速度

进入 sudo vi /etc/pip.conf

输入:

[global]

index-url=https://pypi.tuna.tsinghua.edu.cn/simple

trusted-host=pypi.tuna.tsinghua.edu.cn

[list]

format = columns

3.(pip config list -v)

(pip3 config list -v )

Spark框架目录结构

(输入a开始编辑,退出先按esc键,在输入:wq保存退出,在文末加入#jdk以下内容)

3. 测试JDK 的配置是否正常

4. JDK 安装完毕,最好重新启动一下 Ubuntu20.04 虚拟机,这样设置的环境变量就会 在 Linux 系统全局生效

Linux 免密登录

1.先在本机通过 ssh 命令执行一下远程连接,测试一下是否正常

2. 通过 ssh-keygen 生成免密登录所需的密钥信息(回车)

3.把本地主机的公钥复制到远程主机的 authorized_keys 文件上,以便双方连接通信时使用(密码:spark)

4. 测试一下是否能够免密登录

Hadoop 的安装

(代码:sudo tar -zxvf hadoop-2.6.5.tar.gz -C /usr/local

cd /usr/local

sudo ln -s hadoop-2.6.5 hadoop

ll)

2. 设置解压的 hadoop-2.6.5 目录的用户和组权限

3. 测试 Hadoop 是否能够正常使用

HDFS配置

1. 修改其中的 hadoop-env.sh 运行环境文件(JAVA_HOME 变量)

2. 修改 Hadoop 核心配置文件 core-site.xml

![]()

(添加以下代码 如图所示 保存退出

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>)

3. 修改 HDFS 设置文件 hdfs-site.xml

![]()

4. 最后查看一下 slaves 配置文件的内容

5. 配置文件修改完毕,首次运行之前要初始化 HDFS 的文件系统. 如果要重新初始化,应先清除相关目录中的内容(HDFS 存储过的数据会丢失),否则执行会失败

6. 启动 HDFS 服务程序

7. 使用 jps 命令查看 HDFS 的进程是否正常运行

YARN的配置

1. 打开 yarn-env.sh,找到其中的 JAVA_HOME 变量进行修改![]()

2. 打开 yarn-site.xml 文件,在其中增加与内存检查相关的设置

![]()

3.配置完毕,可以启动 YARN 服务相关的程序,执行过程中会分别运行 ResourceManager 和 NodeManager 这两个进程

4. 从 jps 命令的输出结果可以看出,YARN 集群资源管理服务已在运行

HDFS 和 YARN 的测试

![]()

![]()

(2. touch hello.txt

(3. echo "hello,hello" >> hello.txt

(4. hdfs dfs -mkdir /mydata

(5. hdfs dfs -put hello.txt /mydata

(6. hdfs dfs -put hello.txt /mydata

(7. hdfs dfs -ls /mydata/*

(若遇到这个问题在nano ~/.bashrc中加入

export PATH=$PATH:/usr/local/hadoop/bin)

5. 在 Ubuntu20.04 浏览器中访问 http://localhost:8088,查看 YARN 的 WebUI 管理页 面,如图 1-39 所示。如果是在 Windows 的浏览器访问,则需要将网址中的 localhost 改成 Ubuntu20.04 虚拟机的 IP 地址才行

Spark 单机运行环境搭建

.Spark 的安装配置

1. 打开一个Linux终端,在其中执行以下命令将Spark软件包解压到/usr/local目录 中,并创建一个软链接文件指向Spark目录并修改目录的用户属性

2. 接下来开始配置Spark运行环境,相比而言Spark的配置更简单,所有配置文件均 位于conf目录

(文末加入)

3. 使用 vi 编辑器修改/etc/profile 文件,在其中添加有关 Spark 的环境变量设置

SparkShell交互编程环境

等待一段时间后 如图下所示

正常的话,运行完毕就会打印输出hello.txt文件中的内容,说明Spark可以正常读取 本地磁盘的文件

2.再新开一个Linux终端,在里面输入jps命令查看HDFS服务是否在运行,如果没有 运行就要先将HDFS服务启动,正如在配置HDFS服务时所做的那样

4. 通过上述的测试,说明Spark的安装配置是正确的。要退出SparkShell交互编程环 境,可以按下键盘上的Ctrl+D快捷键,或输入“:quit”并回车(冒号输入也包含在内)

Python3.6的安装

1. 先查看 Ubuntu20.04 上已安装的 Python 相关程序文件

2. 我们可以分别运行 python3 和 python3.8 命令,以确认它们是否为同一个

3. 现在面临两个选择,一是将系统默认安装的 Python3.8 卸载替换成 Python3.6,这 种做法存在一定风险,因为可能影响到其它一些程序的使用。还有一种做法,就是在系统中 同时保留多个 Python 版本,然后根据实际需要切换使用(有现成工具辅助 Python 的多版本 管理)。这里准备采取第二种做法,即保留预装的 Python3.8,另外安装一个 Python3.6 运 行环境到系统中

4. 由于 Ubuntu 软件源不含 Python3.6 的预编译版本,所以就要使用一个非常优秀的第 三方软件源 Deadsnakes PPA。请按照下面步骤将其安装进来

4. 由于 Ubuntu 软件源不含 Python3.6 的预编译版本,所以就要使用一个非常优秀的第 三方软件源 Deadsnakes PPA。请按照下面步骤将其安装进来

5.现在可以开始安装 Python 3.6,安装完毕查看一下 Python3.6 的启动程序

6.为了使得 pyspark 脚本能够找到正确的 Python 运行环境,可以在运行脚本之前设置一下 PYSPARK_PYTHON 的环境变量。为方便起见我们将其添加到/etc/profile 文件(或者在 Spark 中的 spark-env.sh 文件配置也可以)

![]()

PySparkShell交互编程环境

(报错解决)

之后输入pyspark,如下图所示则表示成功 ,(进入pyspark输入quit()表示退出或Ctrl=D)

Pip的安装配置

1. 在Linux终端执行下面的命令安装pip工具,然后查看一下pip的版本信息,以及 和对应管理的Python版本

![]()

3. 现在可以验证 pip 和 pip3 的设置是否达到了预期目标

进入 sudo vi /etc/pip.conf

输入:

[global]

index-url=https://pypi.tuna.tsinghua.edu.cn/simple

trusted-host=pypi.tuna.tsinghua.edu.cn

[list]

format = columns

3.(pip config list -v)

(pip3 config list -v )

Spark框架目录结构

- 当安装好了 Spark 之后,在 Spark 的系统目录中包含有一系列的文件和子目录内容,每 个目录都有其特定的目的和用途。Spark 安装目录的内容结构如图所示

(如果报错,复制代码到deep seek中查找解析)

一.Ubuntu 虚拟机的安装

1.打开VMware,点击左上角文件,新建虚拟机

2.配置类型:典型(默认),下一步

,

,3. 安装来源:选择“安装程序光盘映像文件(iso)”,点击右侧的浏览按钮, 找到下载好的 ubuntu-20.04.4-desktop-amd64.iso 文件,然后点击下一步

4. 在简易安装信息的窗体中,将全名、用户名、密码、确认等几项均设为“spark”, 方便后面使用,然后点击下一步

5. 在命名虚拟机的窗体中,可以设定一下虚拟机名称或直接按默认,然后点击下一步

6. 磁盘容量:60GB, 下一步

7.最后点击完成

8. Vmware 完成新建虚拟机后,会自动启动 Ubuntu20.04 的安装过程

9.稍候几分钟的时间进行安装,当虚拟机安装完毕,就会出现 Ubuntu20.04 的登录界面

10.点击账户spark后,输入密码”spark”

11. Ubuntu20.04 操作系统的初始界面如图所示,第一次启动时会相继提示几个信息的 设置,包括网络在线帐号设置、更新设置、问题提交、隐私设置等,直接点击右上角的“Skip” 和“Next”,直至最后一个窗体点击“Done”全部完成.

12如果在使用过程中出现类似下面的升级提示,直接点击“Don't Upgrade”保持当 前所用 Ubuntu20.04 版本即可

13. 为方便后续操作,这里再整理一下 Ubuntu20.04 左侧任务栏的图标,只保留最常用 的几个快捷方式。方法是:找到左侧垂直的任务栏,在要隐藏的图标上点击鼠标右键,选择 “Remove from Favorites”,完成后的操作系统桌面如图所示(左侧的问号隐藏)

14. 鼠标右键点击 Ubuntu20.04 桌面的中间空白位置(注意不是在应用程序图标上), 选择弹出菜单中的“Open in Terminal”,启动 Linux 终端控制台窗体

15. Linux 终端窗体启动后,在左侧任务栏的“Linux 终端”图标上点击鼠标右键,选 择弹出菜单中的“Add to Favorites”将其固定在任务栏

16. 点击 Ubuntu20.04 桌面右上角的电源图标,选择“Power Off/Log Out”下面的“Power Off”菜单项,然后在弹出的窗体中再点击“Power Off”按钮,关闭当前虚拟机

17. 回到 Vmware Workstation,选中这里安装的 Ubuntu20.04,然后点击“编辑虚拟机设置”

18. 4GB 内存和 2 个处理器

二.Ubuntu 基本配置

1.开启ubuntu64位虚拟机,打开终端, 输入下面的命令更新一下软件源:sudo apt update

2. 为避免版本冲突先卸载内置的 openssh-client,在安装 openssh-server 时会自动安装匹配版本的 openssh-client

(代码: sudo apt -y remove openssh-client

sudo apt -y install openssh-server)

3. 继续输入下面的命令安装 vim,即vi 编辑器的增强版,它支持一些更丰富的功能, 如不同颜色的高亮代码显示等。当 vim 安装完毕,在终端输入 vi或 vim 命令,实际启动的 就是这个增强版的vim 编辑器

(代码:sudo apt -y install vim)

4. 输入下面的命令,将 Ubuntu20.04 自带的防火墙禁用掉,避免在远程终端连接时出 现问题,包括运行 Hadoop 和 Spark 时也要禁用防火墙

(代码:sudo ufw disable)

5. Windows 自带的记事本是一个简单易用的文字编辑器,在 Ubuntu20.04 的桌面环境 中也有一个类似的图形化“Text Editor”文本编辑器,可以在应用程序列表中找到并将它 启动起来

(1) 在使用这个图形化的文本编辑器打开或保存文件时,若编辑的文本文件对当前 Linux 帐户无访问权限的话,将导致无法正常打开或保存。此外,还可以通过终端命令启动编辑器, 执行 gedit命令时可以在前面加上 sudo 获取 root 权限,后面加上文件名进行编辑 (代码:gedit a.txt)

三.Vi 编辑器

1.进入vim编辑器

四.MobaXterm 远程连接工具

1. MobaXterm下载地址是 MobaXterm Xserver with SSH, telnet, RDP, VNC and X11 - Download,下载第一个免费版, 当 MobaXterm 便携版下载好后,将其解压缩到 Windows 的一个目录中,然后启动里面的 MobaXterm_Personal 可执行文件,就会打开 MobaXterm 窗体的初始界面

2下面以我们的 Ubuntu20.04 虚拟机为目标来简单说明一下 MobaXterm 的基本使用。首先 在 Linux 终端窗体中输入下面的命令查看一下当前虚拟机的 IP 地址.(代码:ip addr)

3. 在 MobaXterm 窗体左上角找到 Session 图标,点击后会打开一个连接会话设置窗体,这 个窗体列出了 MobaXterm 支持的各种远程连接类型,点击选择其中的第一项 SSH 图标,输入 虚拟机的 IP 地址,然后指定登录所用的帐号 spark,再点击 OK 即可

4. 首次连接到远程服务器时,MobaXterm 还会显示一个确认窗体。在这个窗体中,勾选“Do not show this message again”(不要再显示本确认信息),然后点击 Accept 即可

5. 输入连接所用帐户 spark 的密码(密码也是 spark)并回车,在弹出的是否要保存密码 的窗体中,勾选“Do not show this message again”(不再显示本信息),然后点击 No 不 保存登录密码

6. MobaXterm 成功连接远程服务器后的界面,如图所示。在这里,可以像 Linux 系统本地 一样执行命令,还可以通过左侧 SFTP(橘色圆形图标)将 Windows 本地的文件拖放上传到 远程服务器,后面的 JDK、Hadoop、Spark 等软件的安装就是通过这样的方法上传到 Ubuntu20.04 虚拟机的。使用完毕,只需按下 Ctrl+D 键或输入 exit 命令即可退出远程登录

Hadoop 伪分布集群环境搭建

- JDK 的安装配置

- 打开终端,输入下列代码. 将 JDK 解压缩到/usr/local 目录中, 并创建一个软链接指向 JDK 目录(代码:sudo tar -zxf jdk-8u201-linux-x64.tar.gz -C /usr/local

修改/etc/profile 文件,在其中添加有关 JDK 的环境变量设置,输入sudo vi /etc/profile进入编辑器

修改/etc/profile 文件,在其中添加有关 JDK 的环境变量设置,输入sudo vi /etc/profile进入编辑器- 解压缩 hadoop-2.6.5.tar.gz 这个软件包

- 使用 vi 编辑器修改/etc/profile 文件,在其中添加有关 Hadoop 环境变量设置

- 通过 source 命令使/etc/profile 的内容修改生效。注意:如果新开一个终端窗体, 需要在新终端重新执行一次 source 命令,除非重启动虚拟机才会全局有效

- 现在可以测试是否能够正常操作 HDFS,比如创建目录,上传文件等 (码:1. source /etc/profile

- 还可以在 Ubuntu20.04 里面启动浏览器,访问http://localhost:50070 查看 HDFS的 WebUI 管理页面,如图 1-38 所示。如果是在 Windows 的浏览器访问,则需要将网址中的 localhost 改成 Ubuntu20.04 虚拟机的 ip 地址(通过 Linux 终端命令 ip addr 可以找到)

- 通过source命令使/etc/profile的内容修改生效。注意:如果新开一个终端窗体,需要在新终端重新执行一次source命令,除非重启动虚拟机才会全局有效。

- 打开Linux终端窗体,输入spark-shell命令启动SparkShell交互式编程环境。启 动过程中可能会出现一个NumberFormatException的异常信息,这个问题不影响使用

- 现在可以验证Spark能否正常访问HDFS上的文件。前面测试HDFS时已经上传过一 个文件,路径为:/mydata/hello.txt,下面准备测试在SparkShell中读取这个文件。请转 至运行SparkShell的终端窗体,输入下面的代码

- 当 Python3.6 运行环境准备就绪,现在就可以启动 PySparkShell 交互编程环境了

- 当 pip 包管理工具安装配置好之后,考虑到实际使用时需要访问网络下载软件,下 面将 pip 源改成国内镜像(如阿里云、清华镜像站点等),以加快下载速度

- 当安装好了 Spark 之后,在 Spark 的系统目录中包含有一系列的文件和子目录内容,每 个目录都有其特定的目的和用途。Spark 安装目录的内容结构如图所示

20万+

20万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?