目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

🎯基于卷积神经网络的飞禽(鸟类)图像识别方法

项目背景

鸟类是生态系统中重要的组成部分,其多样性反映了生态环境的健康状况。然而,传统的鸟类识别方法多依赖于专业鸟类学家的经验,不仅耗时且容易出错。利用深度学习和计算机视觉技术进行鸟类识别,能够实现快速、准确的物种分类,为生态研究、鸟类保护以及环境监测提供强有力的技术支持。这项研究不仅具有重要的科学意义,还有助于提高公众对鸟类保护的意识。

数据集

图像采集阶段,选择自主拍摄和互联网采集两种方式,以确保数据集的丰富性和多样性。自主拍摄主要在不同的自然环境中进行,目标是捕捉各种飞禽鸟类的真实场景。为了获取不同气候、季节和时间段下的图像,拍摄者在不同的地点进行观察和拍摄。这种方法的优点在于能够获得高质量的原始图像,能够真实反映鸟类的自然行为和栖息环境。同时,拍摄过程中可以根据需要调整拍摄角度、光线和构图,以确保图像的多样性和代表性。

数据标注使用专业标注工具进行,确保每张图像中的飞禽鸟类目标被准确标记。仔细识别每个目标的位置和类别,标注工具通常提供矩形框功能,以便准确划定鸟类的边界框。通过这种方式,为后续的模型训练提供高质量的标注数据,确保模型能够准确识别不同种类的飞禽鸟类。

数据集划分阶段将数据分为训练集、验证集和测试集,以确保模型的有效评估和泛化能力。训练集用于模型的实际学习,验证集用于模型调优,而测试集则用于最终性能评估。为了增加数据集的多样性,进行数据扩展是一个重要步骤。通过旋转、翻转、缩放、剪裁、颜色调整等变换技术,生成更多样本数据,提升模型鲁棒性和泛化能力。

设计思路

深度学习技术在动物图像识别领域广泛应用,其核心思想通过对大量图像进行学习和训练,使计算机能够自动学习提取特征,并对目标进行有效分类和识别。利用深度学习的动物图像识别模型能够有效处理动物图像中的复杂背景信息,并提取出动物本身的特征,从而显著提高动物图像的识别精度。模型的改进包括基于传统网络架构的ZF网络、VGG网络,以及引入新结构的网络,诸如为解决退化问题而设计的残差网络。

残差网络在VGG网络的基础上嵌入了残差单元,成为对应的残差版本,并对全连接层进行了替换,以规避信息传递丢失的问题,直接将输入信息传递到输出。该网络拥有多个版本,不同版本配有不同的残差结构,主要使用的版本是残差网络50。通过修改该网络,增添了跨通道注意力模块,使得该网络在不增加额外成本的情况下,能够直接用于下游任务。整体结构可以通过三个步骤进行概括:划分、获得注意力和汇聚。

在某些应用场景中,大而复杂的神经网络模型难以应用,主要原因在于存在内存不足、响应缓慢和延迟高等问题。轻量级深层神经网络是为手机等嵌入式设备设计的,内存小且运行高效。深度可分离卷积由深度卷积和逐点卷积共同构成,其过程相较于标准卷积更为高效。该轻量级网络有三种架构,其中第一版本的核心思想是采用深度可分离卷积,引入两个超参数。第二版本在第一版本的基础上增添了层与层之间的线性瓶颈及瓶颈之间的快捷链接,而第三版本的创新点在于引入了注意力模块及激活函数的改进。

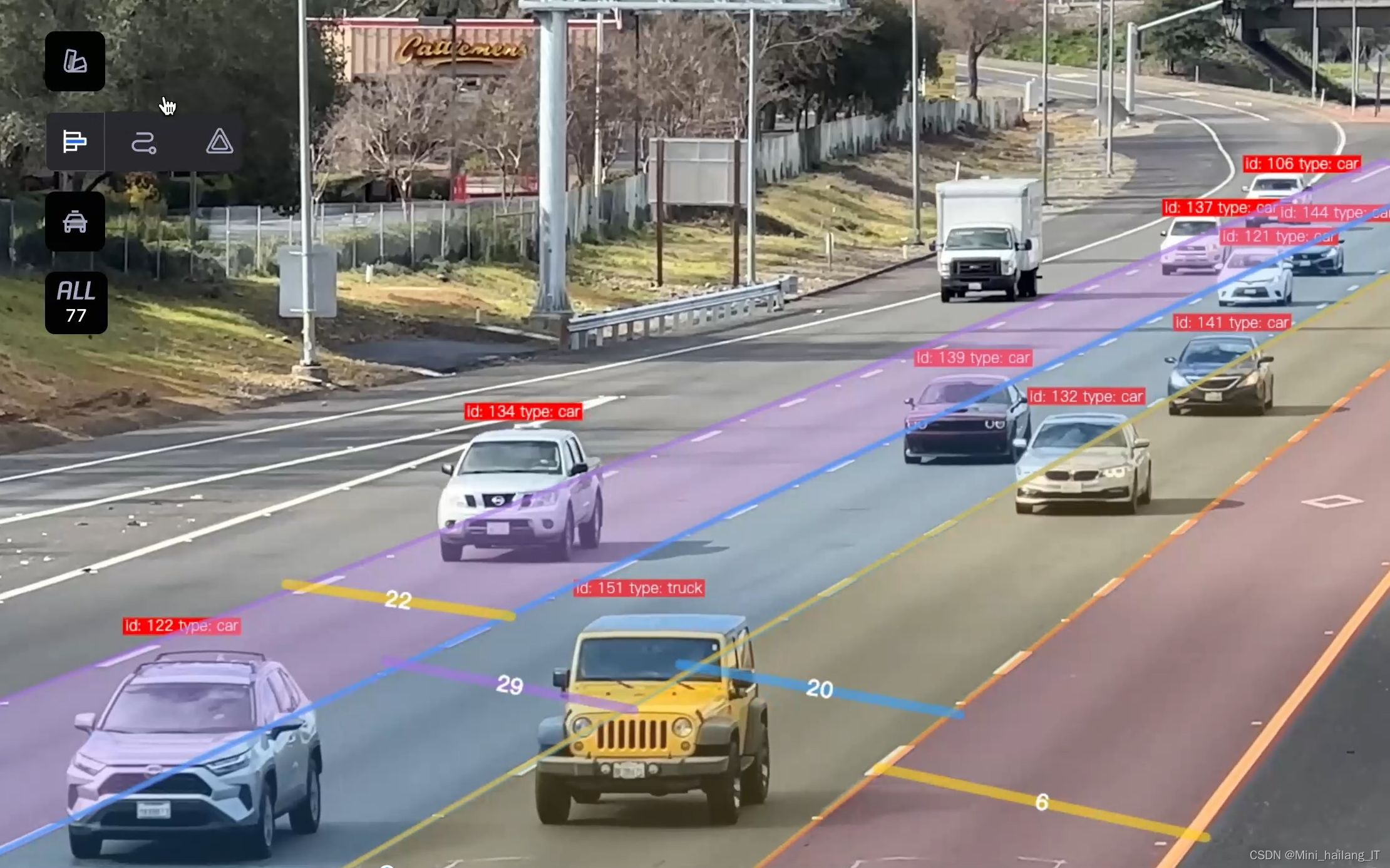

YOLOv5是目标检测领域中的一种先进模型,因其高效性和准确性受到广泛关注。该模型基于YOLO系列的思想,采用单阶段的检测方式,即在一次前向传播中同时预测目标的类别和边界框。这种设计使得YOLOv5在处理速度上相较于其他模型具有显著优势,能够适应实时应用场景,如视频监控和自动驾驶等。YOLOv5通过多层特征融合和多尺度检测,有效提升了对小目标和复杂场景的检测能力。

YOLOv5的结构由多个关键组件组成,旨在实现高效的目标检测。首先,主干网络负责特征提取,采用CSPNet架构,能够在提取深层特征的同时降低计算复杂度。CSPNet通过划分特征图并在不同阶段进行组合,增强了特征的表达能力,使模型能够更好地捕捉复杂的目标特征。此外,特征金字塔在结构中起到关键作用,能够融合来自不同层次的特征信息。通过多尺度特征的结合,YOLOv5能够有效应对不同大小目标的检测需求,尤其是在处理小目标时表现出色。这一设计使模型具备了高效的特征提取和丰富的信息表达能力。

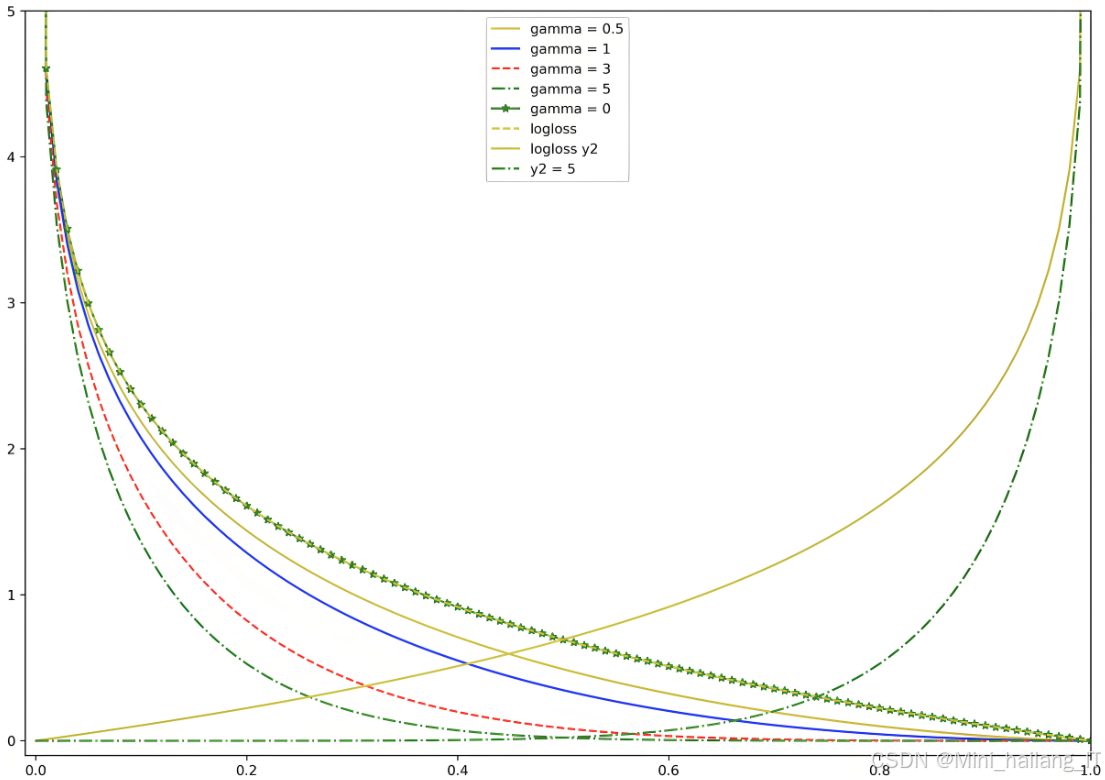

检测头则负责生成目标的边界框和类别预测,采用回归方法输出每个目标的位置信息和分类结果。为了提高模型的鲁棒性,YOLOv5引入了多种数据增强技术,包括随机裁剪、颜色抖动等,以增强训练数据的多样性,从而提升模型的泛化能力。同时,Focal Loss损失函数的应用,使得模型在处理难以检测的目标时更加关注,优化了训练效果。这种综合性的结构设计使得YOLOv5在速度与精度之间达到了良好的平衡,适应于实时目标检测的需求。

飞禽鸟类的图像可以通过自主拍摄和互联网获取,确保数据的多样性和丰富性。图像标注使用工具进行,确保每个目标的边界框和类别信息准确无误。数据集需要划分为训练集、验证集和测试集,以便在训练过程中进行有效评估。

import os

import cv2

import numpy as np

from sklearn.model_selection import train_test_split

# 假设图像和标签存放在指定文件夹中

image_folder = 'path/to/images'

label_folder = 'path/to/labels'

# 读取图像和标签

images = []

labels = []

for filename in os.listdir(image_folder):

if filename.endswith('.jpg'):

img_path = os.path.join(image_folder, filename)

label_path = os.path.join(label_folder, filename.replace('.jpg', '.txt'))

# 加载图像

image = cv2.imread(img_path)

images.append(image)

# 加载标签

with open(label_path, 'r') as f:

label = f.readlines()

labels.append(label)

# 划分数据集

train_images, val_images, train_labels, val_labels = train_test_split(images, labels, test_size=0.2, random_state=42)YOLOv5是一个常用的目标检测模型,它具有快速的检测速度和较高的准确性。配置时需要指定输入图像的尺寸、学习率、批量大小等参数,以适应具体的训练需求。同时,可以根据数据集的特点,选择合适的预训练权重进行微调。在训练过程中,损失函数的选择直接影响模型的学习效果。YOLOv5使用GIoU损失来计算边界框的损失,以及对象置信度和分类损失。这三部分组成了总损失函数,通过最小化该损失函数,使模型不断优化,提升检测性能。通过输入训练数据,不断调整参数以最小化损失函数。根据设定的学习率和批量大小,进行多轮迭代训练,并在每个epoch后使用验证集评估模型性能,及时调整训练策略以避免过拟合。

import torch

from models.yolo import Model

# 设置超参数

img_size = 640 # 输入图像尺寸

num_classes = 3 # 假设飞禽鸟类有3个类别

batch_size = 16 # 批量大小

# 加载YOLOv5模型

model = Model(cfg='yolov5s.yaml', ch=3, nc=num_classes) # ch: 输入通道数, nc: 类别数

# 设置优化器

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)训练完成后,使用测试集对模型进行评估。Precision和Recall是常用的评估指标,用于衡量模型的分类和检测效果。mAP则综合考虑了Precision和Recall,反映整体性能。mAP@0.5:0.95表示在不同IoU阈值下的平均mAP,而mAP@0.5则表示IoU大于0.5时的平均mAP,通常用于客观评估算法的性能。

from utils.metrics import ap_per_class

# 假设 preds 和 targets 是模型预测和真实目标

preds = [] # 存放预测结果

targets = [] # 存放真实目标

# 模型评估

model.eval() # 设置模型为评估模式

with torch.no_grad():

for imgs, targets in zip(val_images, val_labels):

imgs = torch.tensor(imgs).permute(0, 3, 1, 2) # 转换为PyTorch张量并调整维度

predictions = model(imgs) # 进行前向传播

preds.append(predictions)

# 计算mAP

ap, _, _ = ap_per_class(preds, targets, iou_thres=0.5) # 计算mAP

mAP = ap.mean() # 计算平均精度

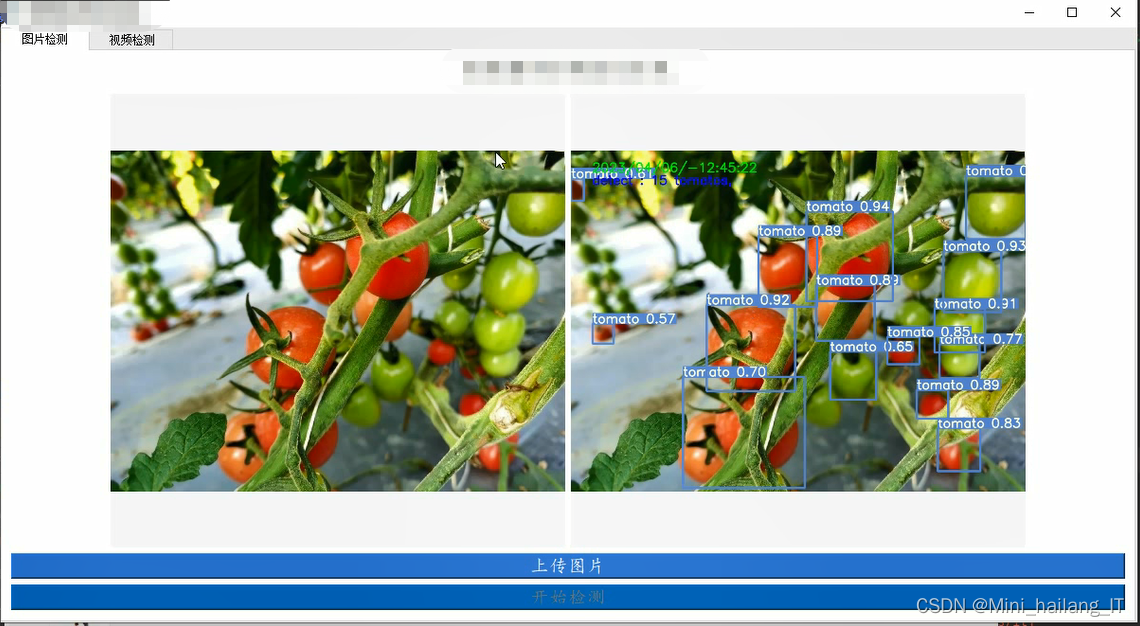

print(f'mAP: {mAP:.4f}')海浪学长项目示例:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?