资料

如何画出一张合格的技术架构图?

如何画架构图?

产品经理的高阶能力:架构图的设计与画法

设计图都不会画,还想做”架构师“?

你知道如何画好一幅架构图么?

系统逻辑架构图怎么画

想要做”架构师“,一定要会画设计图

画出你的项目架构图

一个关于“系统架构图怎么画?”的问题

不错的架构图

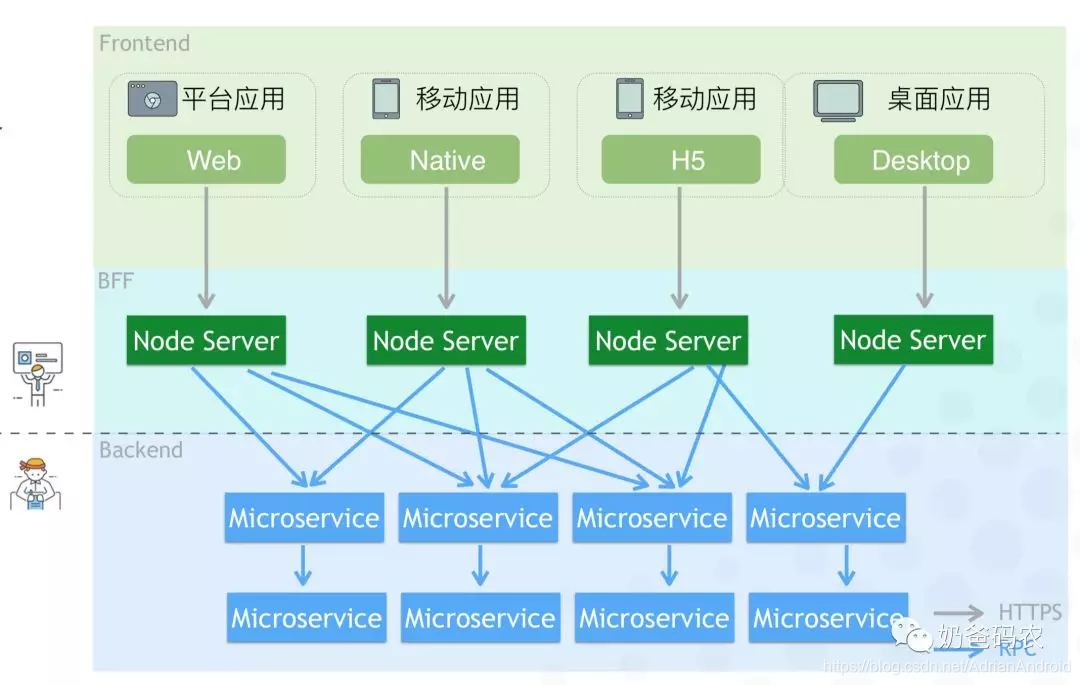

BFF - Backend for Frontend

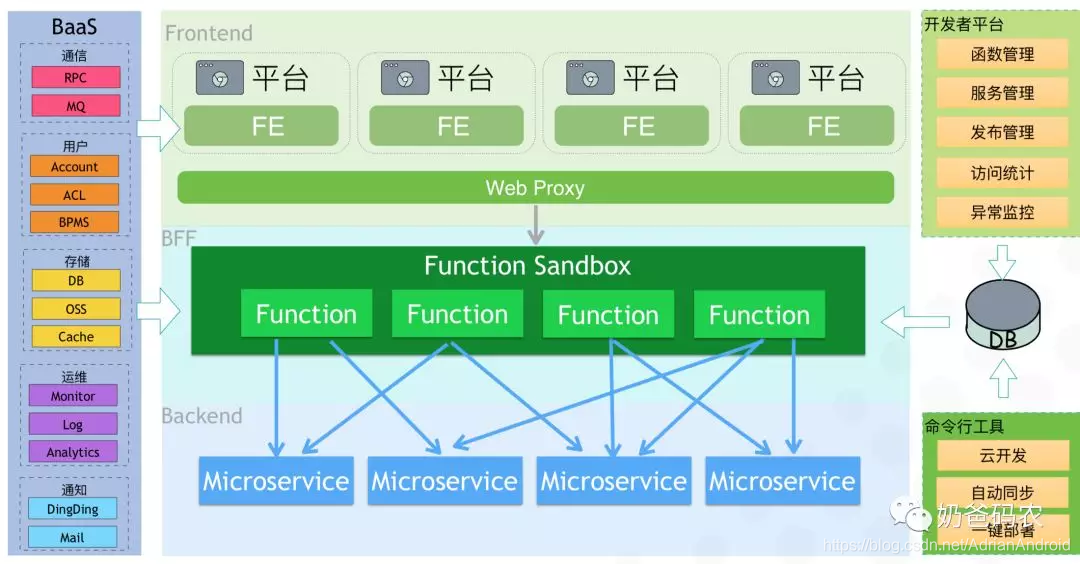

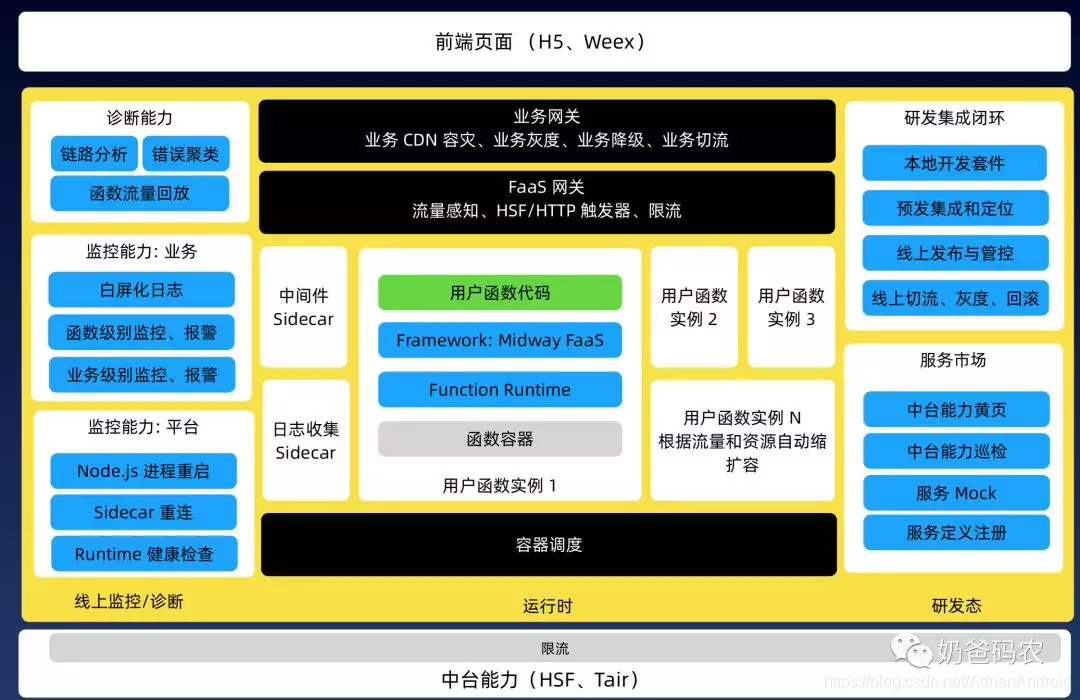

BFF in Serverless

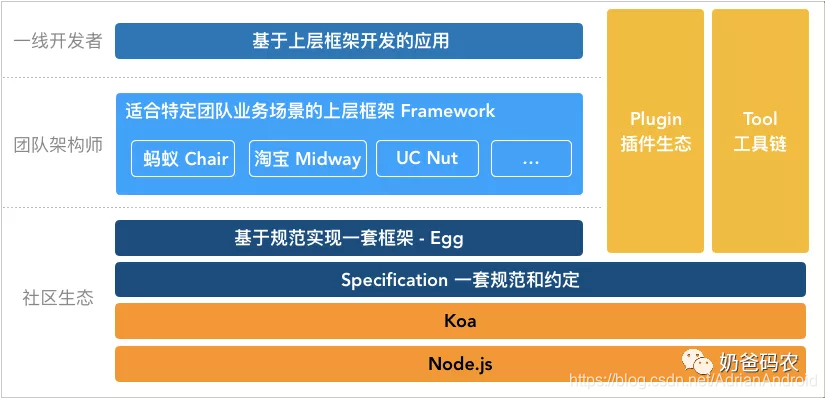

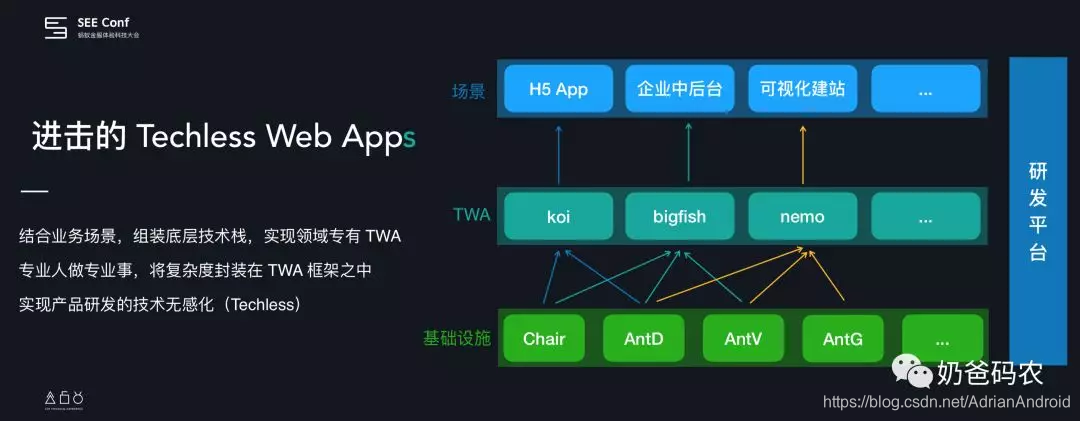

前端应用框架 TWA - Techless Web Apps

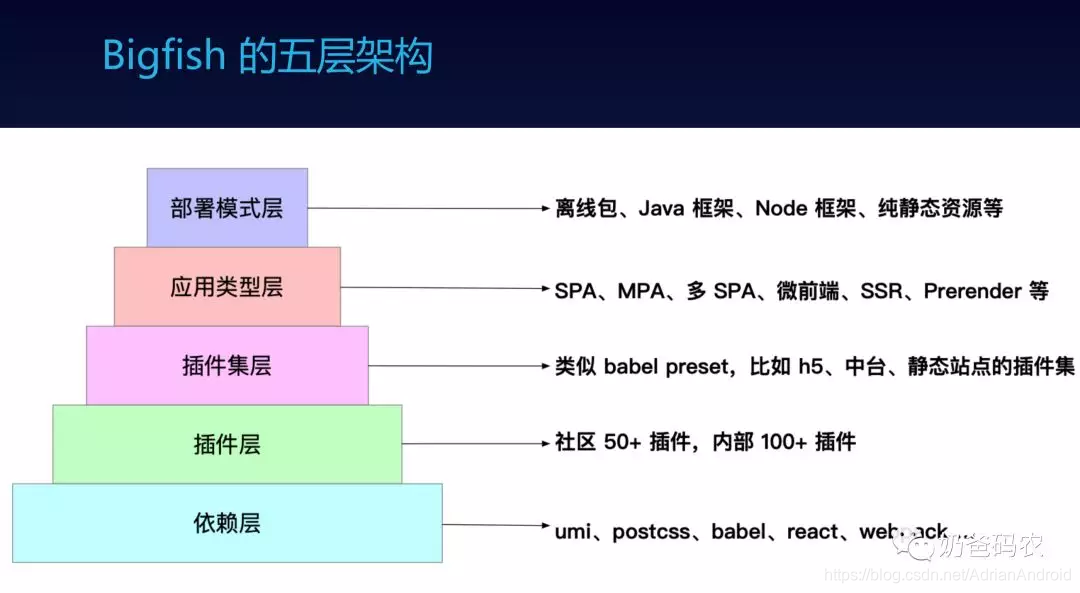

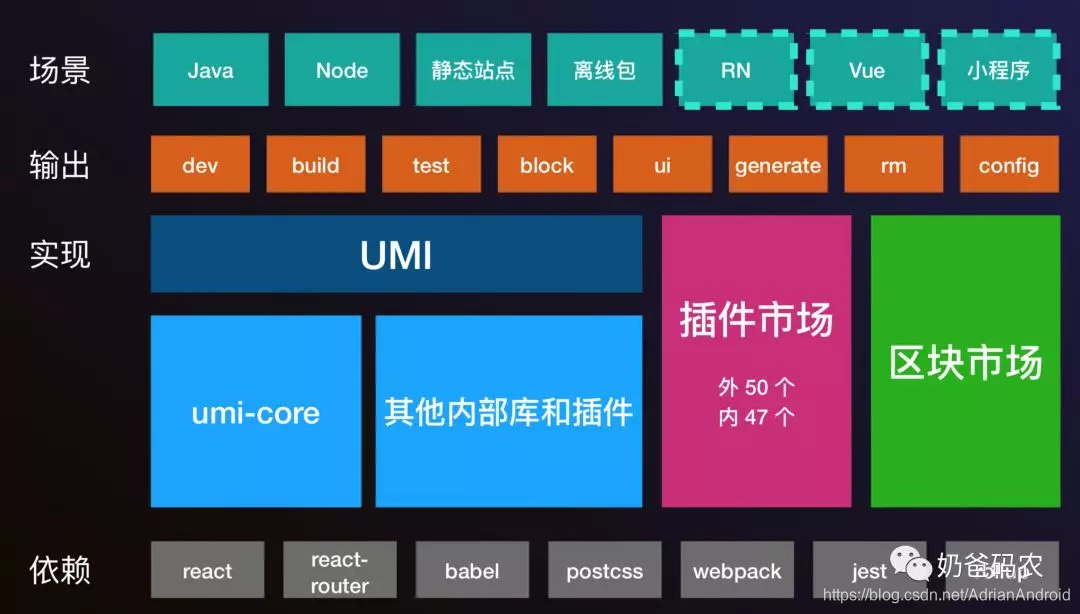

前段应用框架-Bigfish/Umi

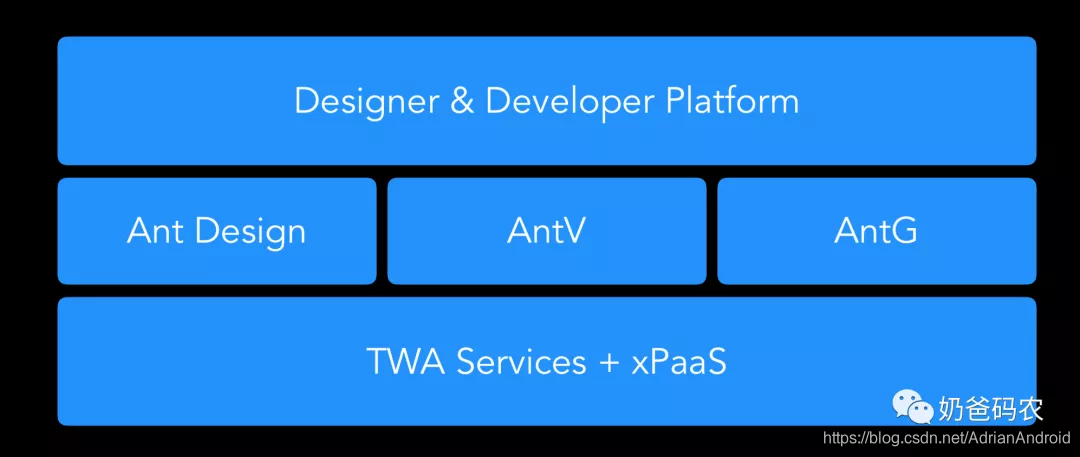

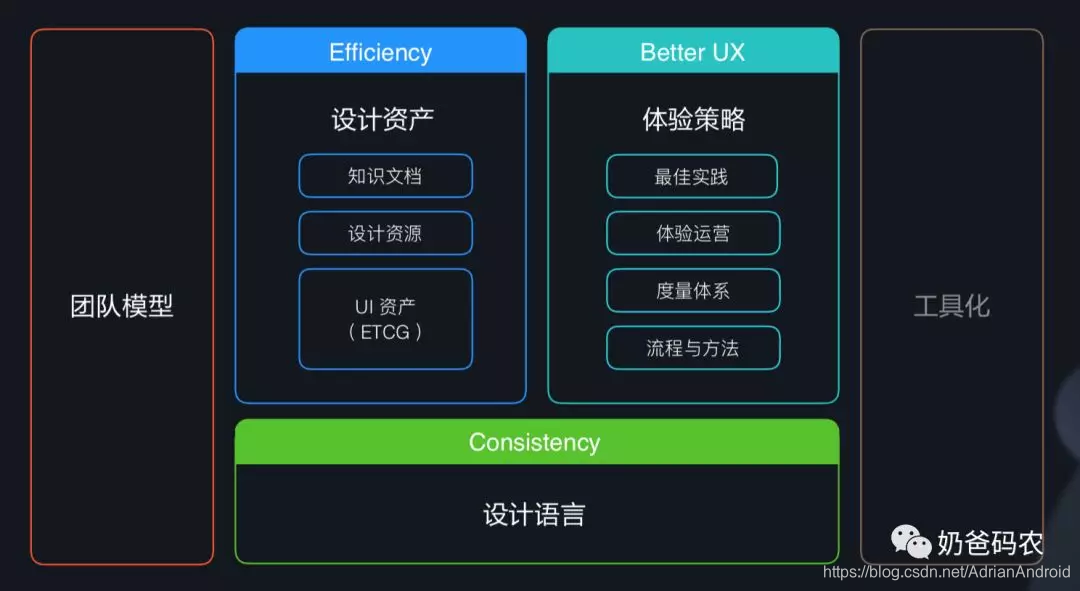

前段UI组件库

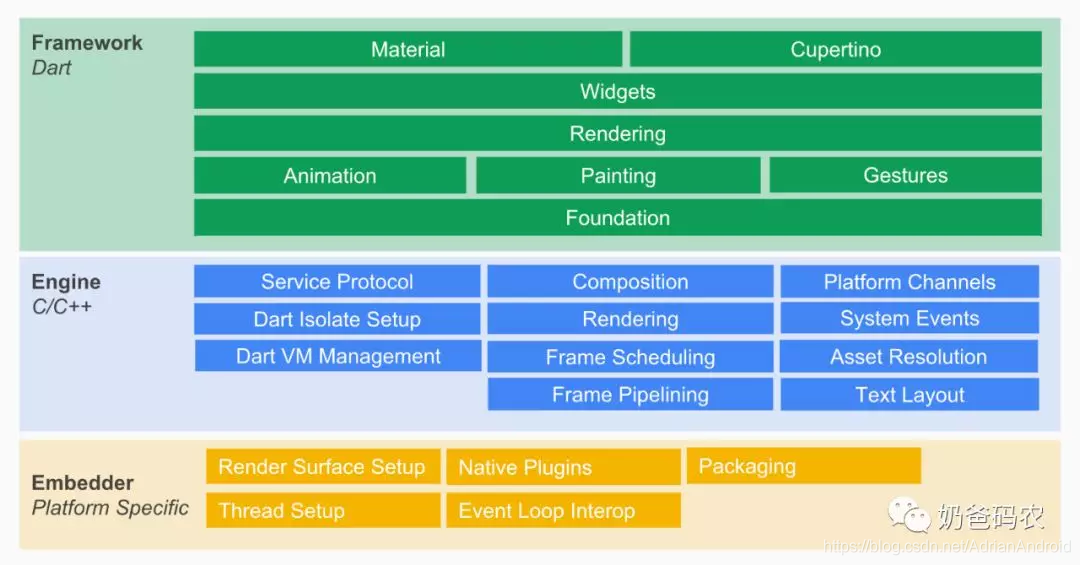

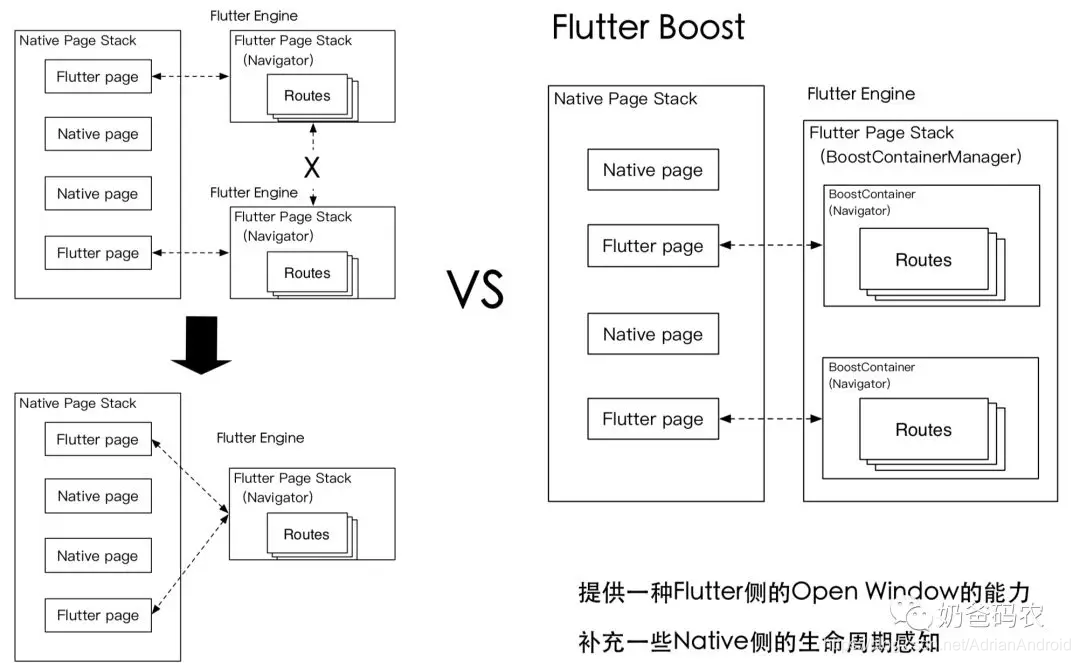

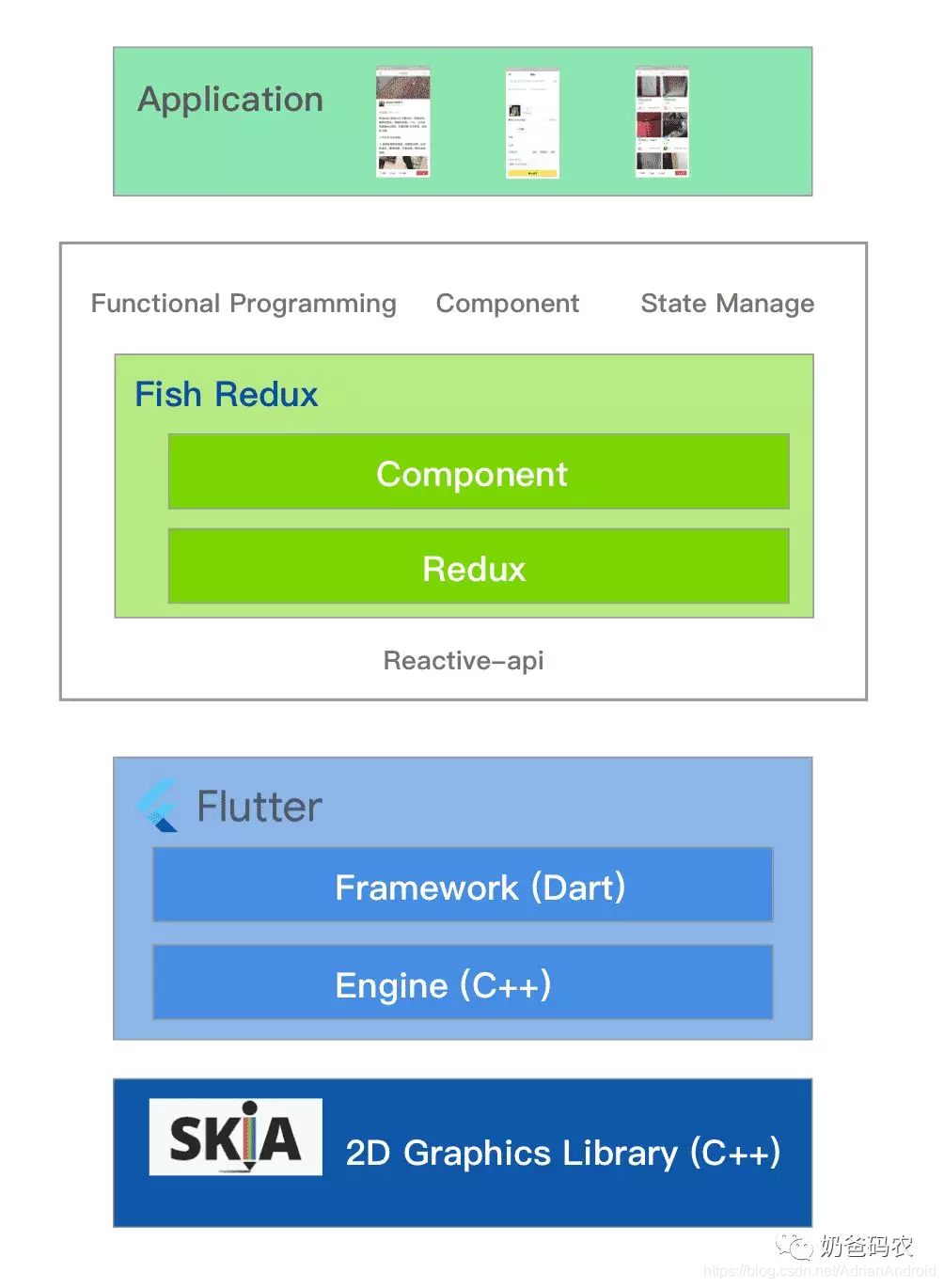

跨平台

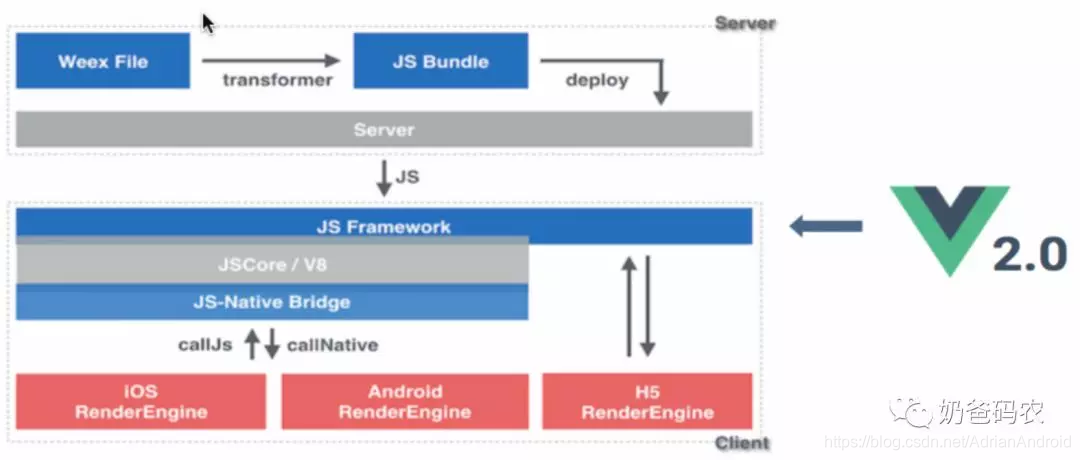

weex

场景试图

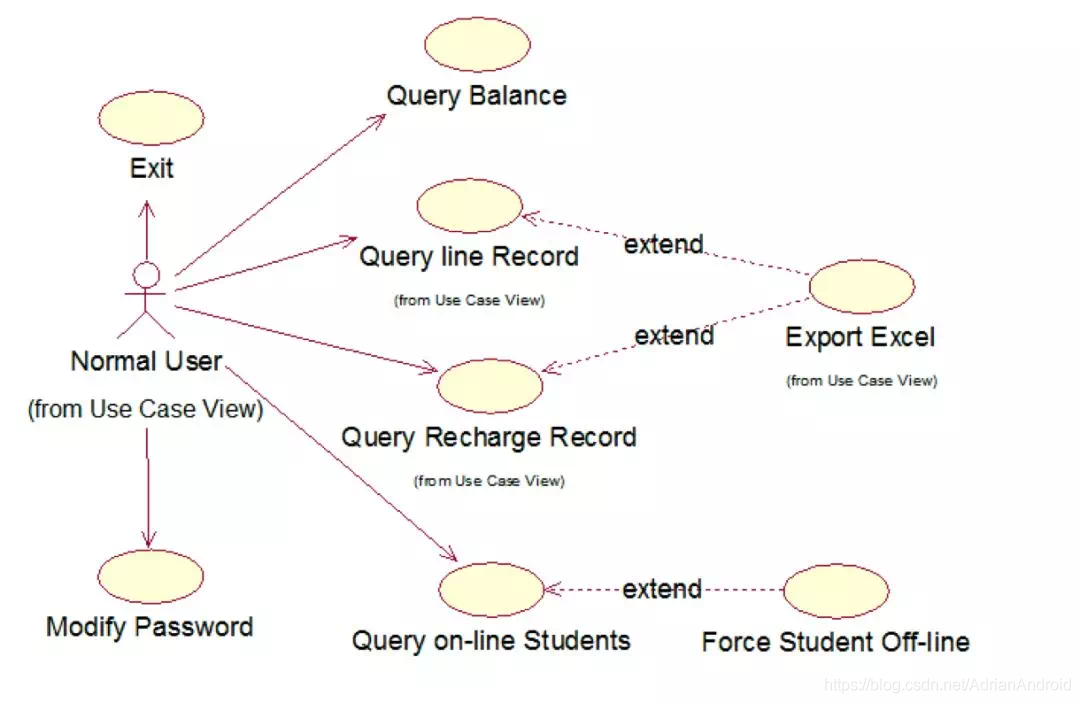

逻辑视图

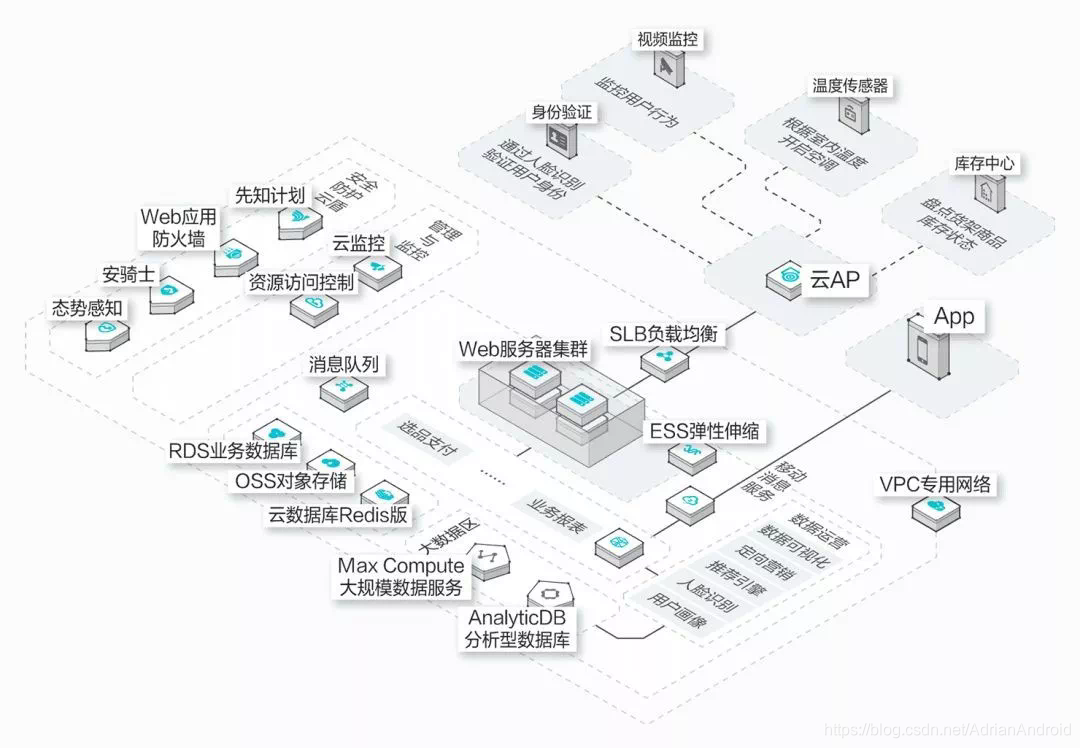

物理视图

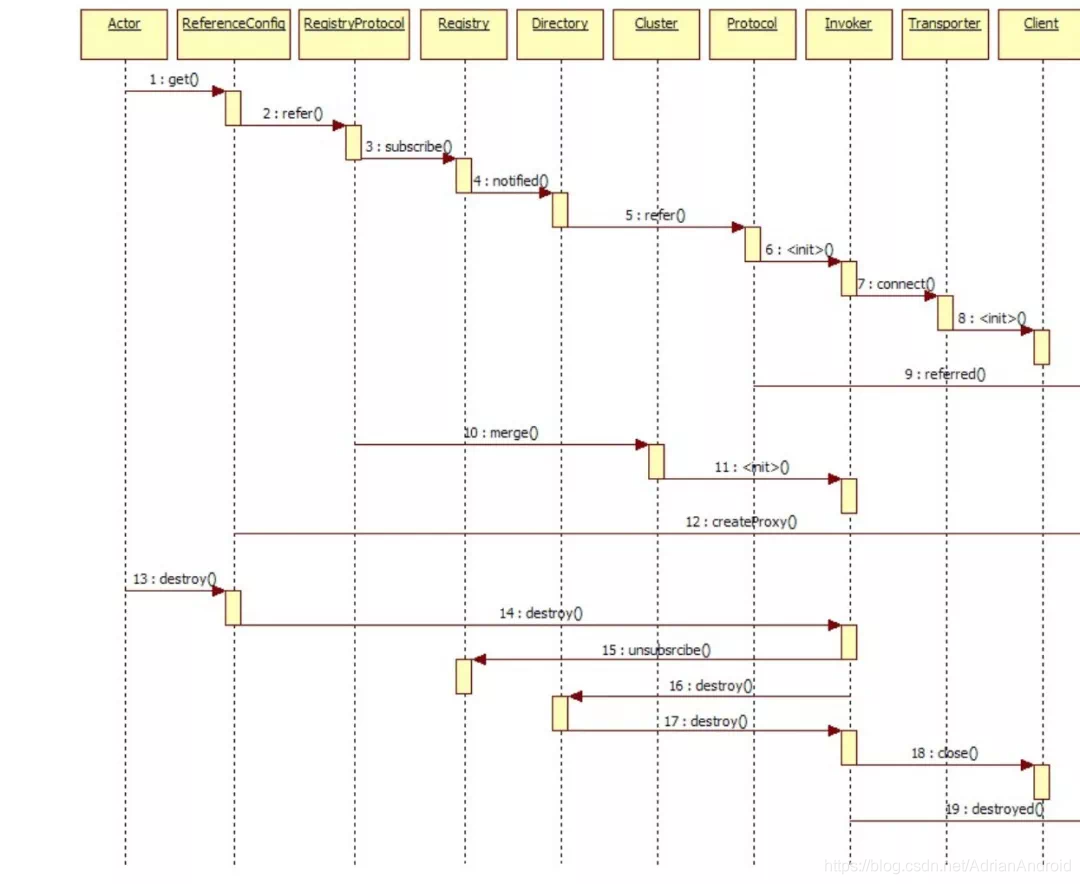

处理流程视图

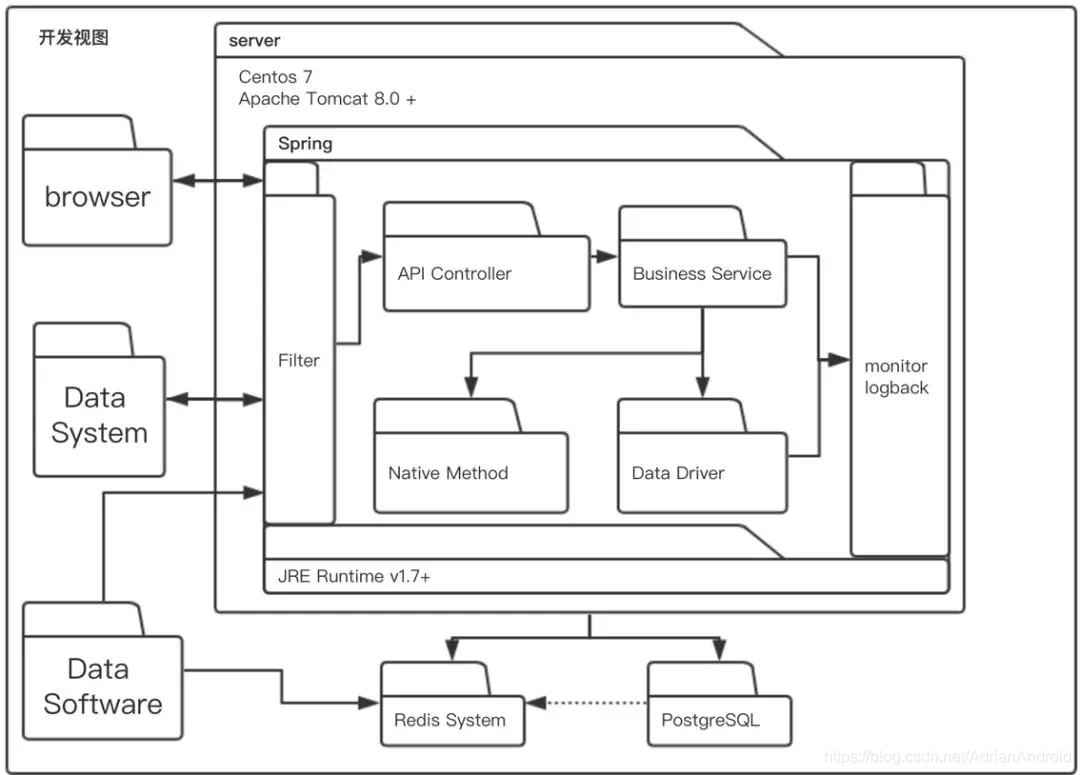

开发视图

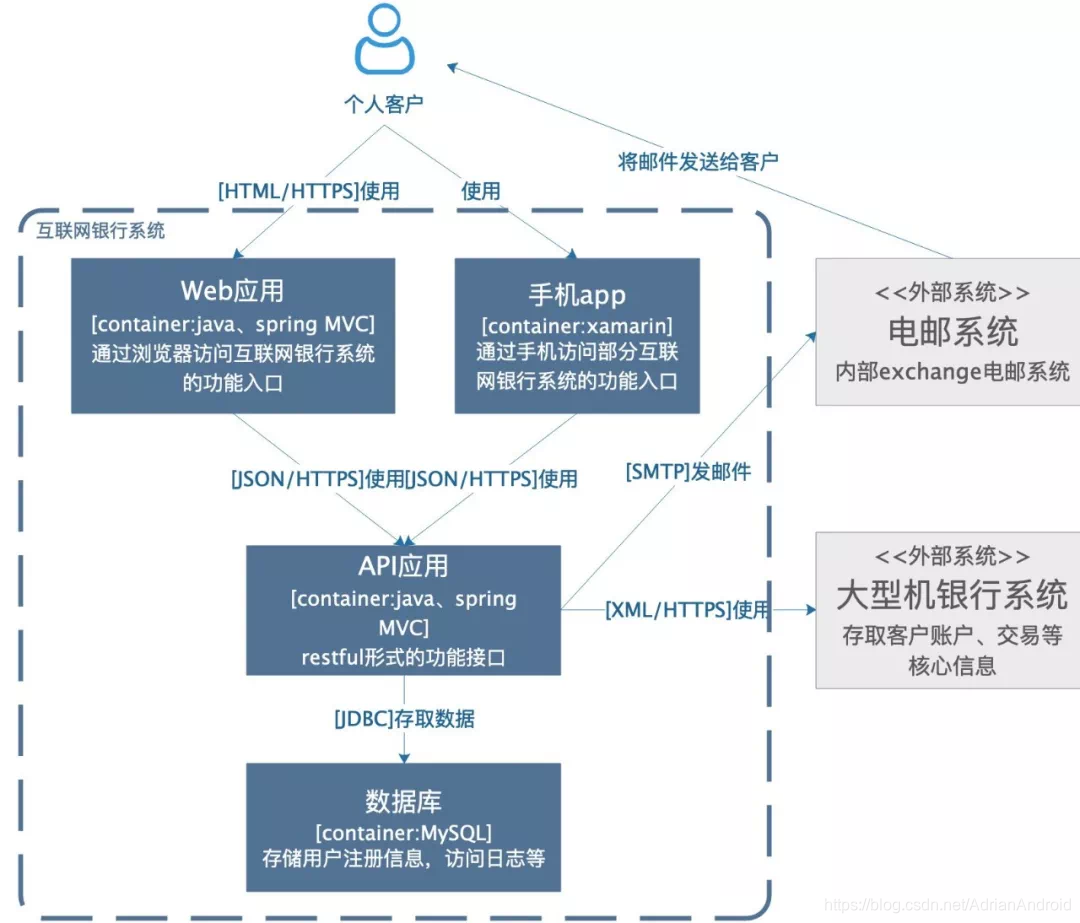

语境图

容器图

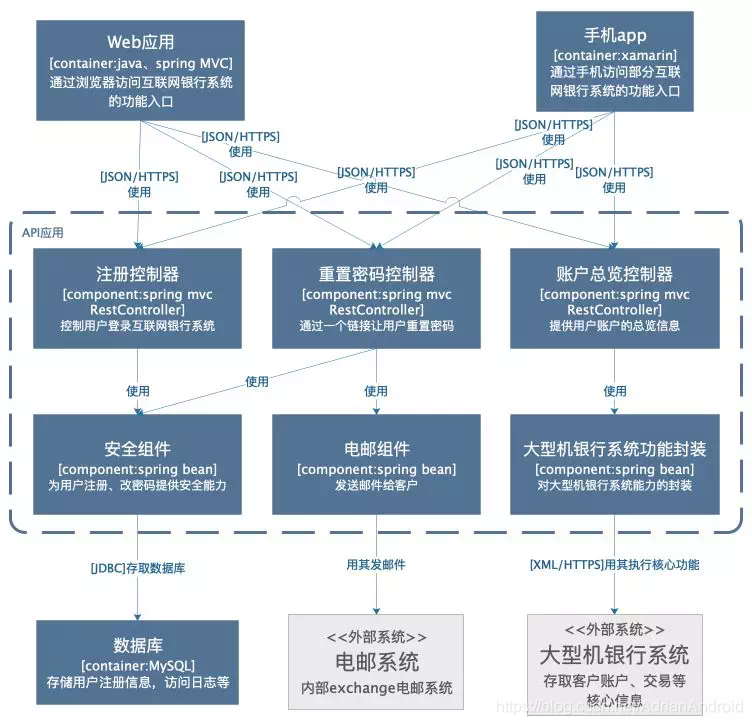

组件图

案例分享

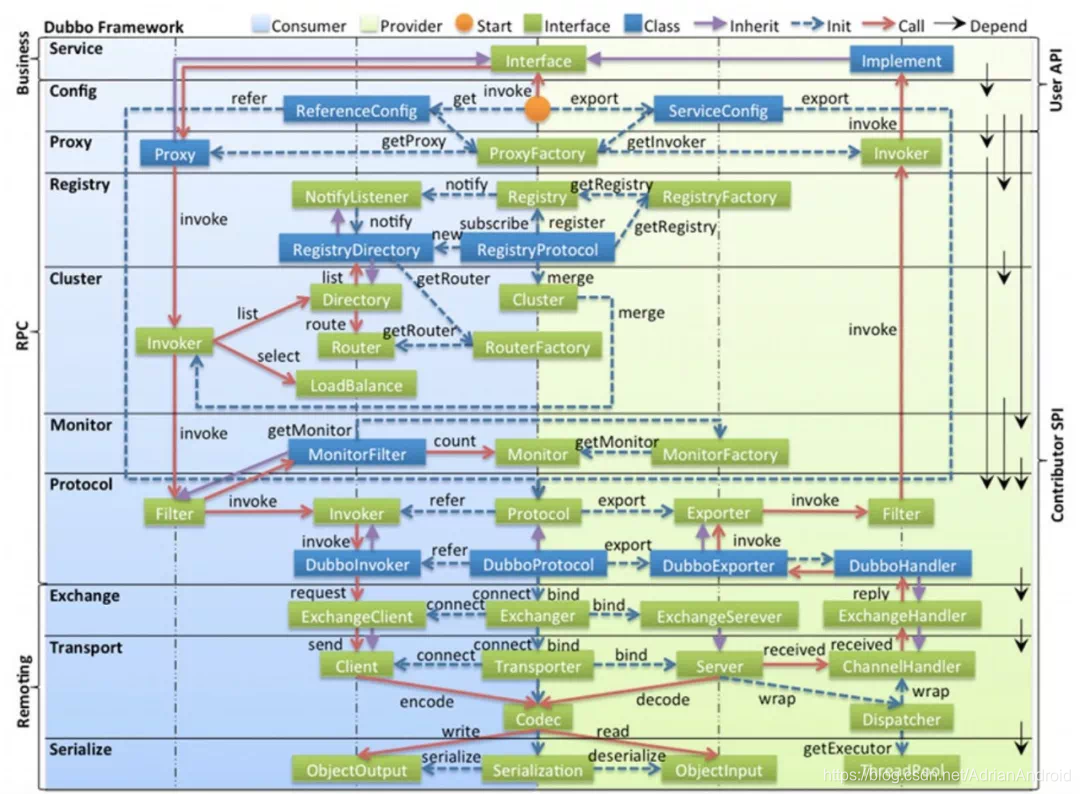

本文探讨了如何绘制高质量的技术架构图,涵盖了架构图的基本类型,如逻辑视图、物理视图、处理流程视图等,并分享了成为优秀架构师所必需的绘图技巧。

本文探讨了如何绘制高质量的技术架构图,涵盖了架构图的基本类型,如逻辑视图、物理视图、处理流程视图等,并分享了成为优秀架构师所必需的绘图技巧。

232

232