这节列出学习课程 线性降维中遇到的一些 问题. 整理下线代基本概念 .

文章目录

基本概念

0. 正交向量 orthonormal vector

点积为零的两个或多个向量

1. 正交矩阵

如果AAT=E(E为单位矩阵,AT表示“矩阵A的转置矩阵”)或ATA=E,则n阶实矩阵A称为正交矩阵 。正交矩阵是实数特殊化的酉矩阵,因此总是属于正规矩阵。

|A|=1或-1 , 所有行列都是单位向量,且相互正交

2. 协方差矩阵 covariance matrix

协方差的意义,协方差的意义是计算元素之间的相关性(相关程度)

协方差计算的是特征a和特征b之间即自身的相关性。我们发现主对角线是自相关性,自己和自己肯定相关性最大,副对角线是互相关性,即特征a和特征b的相关性。

3. 特征值和特征向量 eigenvalue eigenvector

如何理解特征值和特征向量

一个矩阵和该矩阵的非特征向量相乘是对该向量的旋转变换;一个矩阵和该矩阵的特征向量相乘是对该向量的伸缩变换。特征向量就是一个在矩阵A的变换下没有旋转只是伸缩变换,那到底伸缩了多少倍呢?伸缩了“特征值”倍

4. 拉格朗日乘子 agrange multiplier

5. SVD 奇异值分解

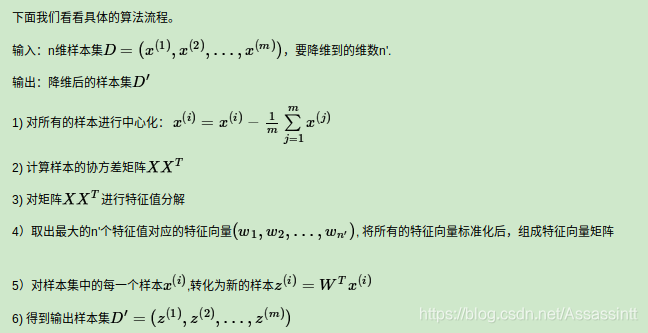

6. PCA 主成分分析

主成分分析(PCA)原理总结

https://www.cnblogs.com/pinard/p/6239403.html

PCA 的本质

https://blog.csdn.net/sunshine_in_moon/article/details/51513880

去相关decorrelation

PCA的目标就是使协方差矩阵的主对角线的值尽可能的大,副对角线上的值尽可能的小,最好为0.为什么呢?协方差的意义是衡量计算元素之间的相关性,如果我让副对角线的值为0,也就说明了特征a和特征b之间相关性为0,无相关性了。这也就是我们经常听到的PCA具有去相关性的作用。

为什么要去除特征之间的相关性呢?比如在特征中有两个特征a,b,我们已知a+b=1,如果我们的样本中已经知道特征a的值,那么我们一定知道特征b的值,那我们还要特征b干嘛呢?这就是所谓的特征冗余。去除特征的相关性就是去除特征b,使保留下来的特征尽量无相关性。少量特征时,我们看不出去相关性的优势。想想一下,如果我们的特征有1亿维,而且这些特征的相关性非常高,那我们的很多计算都是多余的,这样会浪费大量的时间。所以我们需要利用PCA进行去相关性。

降维

A矩阵经过特征值分解后,最终得到一个累加形式,如果我们对特征值进行排序,省略的掉值很小的部分,这样特征值的个数减小了,那么矩阵会减小,相应的矩阵U和UT也会减小(维度上),这样我们我们返代回去求得A矩阵维度也会减小,这样就降维的目的。

原文链接:https://blog.csdn.net/sunshine_in_moon/article/details/51513880

本文深入探讨无监督学习中的线性降维技术,包括正交向量、正交矩阵、协方差矩阵等基本概念,重点讲解特征值、特征向量、拉格朗日乘子、SVD奇异值分解及PCA主成分分析。揭示PCA去相关性和降维的原理,阐述其在减少特征冗余、提高计算效率方面的关键作用。

本文深入探讨无监督学习中的线性降维技术,包括正交向量、正交矩阵、协方差矩阵等基本概念,重点讲解特征值、特征向量、拉格朗日乘子、SVD奇异值分解及PCA主成分分析。揭示PCA去相关性和降维的原理,阐述其在减少特征冗余、提高计算效率方面的关键作用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?