Agent一词在英文中意为“做事的主体”,在AI研究中,Agent被赋予了模仿人类主观能动性的能力,能够主动进行计划、组织、实施和学习,直至完成任务。OpenAI联合创始人Andrej Karpathy在去年的公开活动中表示,OpenAI内部对AI Agents研究最感兴趣。

Agent究竟有何魅力?多智能体走向群体智能还有哪些问题和挑战?LLM和Agent如何结合,引领未来智能系统乃至AGI的新方向?

6月14日下午,智源大会「Agent」专题论坛如期举行。本次论坛由清华大学副教授、智源学者刘知远主持,邀请到了清华大学博士后钱忱、美国罗格斯大学计算机科学学院副教授张永锋、CAMEL作者李国豪、爱丁堡大学副教授Stefano V. Albrecht等该领域的头部研究者,共同交流Agent领域的最新研究成果和实践经验。报告内容涵盖大模型驱动的群体智能、大模型智能体操作系统等方向。

钱 忱:进阶智能体的发展愿景是从独立的实体进化为可协作和可演化的系统,通过集体智慧实现可涌现的效率和结果。

张永锋:在解决复杂任务时,Agent并不采用Chain of Thought一次性解决的技术路线,而是选择将任务拆解为若干小问题并逐个击破,这与人类解决问题的思维模式相似。

李国豪:未来的AGI不是一个模型来实现,它一定是一个多智能体组成的AGI系统。

......

以下是核心内容整理 ↓ (回放链接:https://event.baai.ac.cn/live/788)

大模型驱动的群体智能

报告嘉宾:钱 忱 | 清华大学博士后

现在已经进入了大语言模型的时代,模型能够操纵百亿或者千亿参数,呈现出很强的以文本来表达世界知识的能力。但同时也存在一些缺陷和只靠增加模型参数规模并不能实现的愿景,这里总结了4个点。

1、大数据缺乏实时知识的掌握;

2、缺乏专业的技能;

3、自主能力不足;

4、各个模型之间没有形成协作。

智能体系统分为社会模拟型的智能体系统和任务完成性的智能体系统。这里想解决的问题是如何去驱动任务为导向的多智能体系统。针对任务完成型的多智能体系统,每个智能体或群体需要有对话的目标;智能体之间交互的组织架构形成了联盟的拓扑;智能体之间合作来完成解决方案的产出,也可能以人为的划分在智能体团队之间形成竞争;动态策略智能体交互的路由,使得他们遵循区域任务完成或任务推进的路由次序的策略。

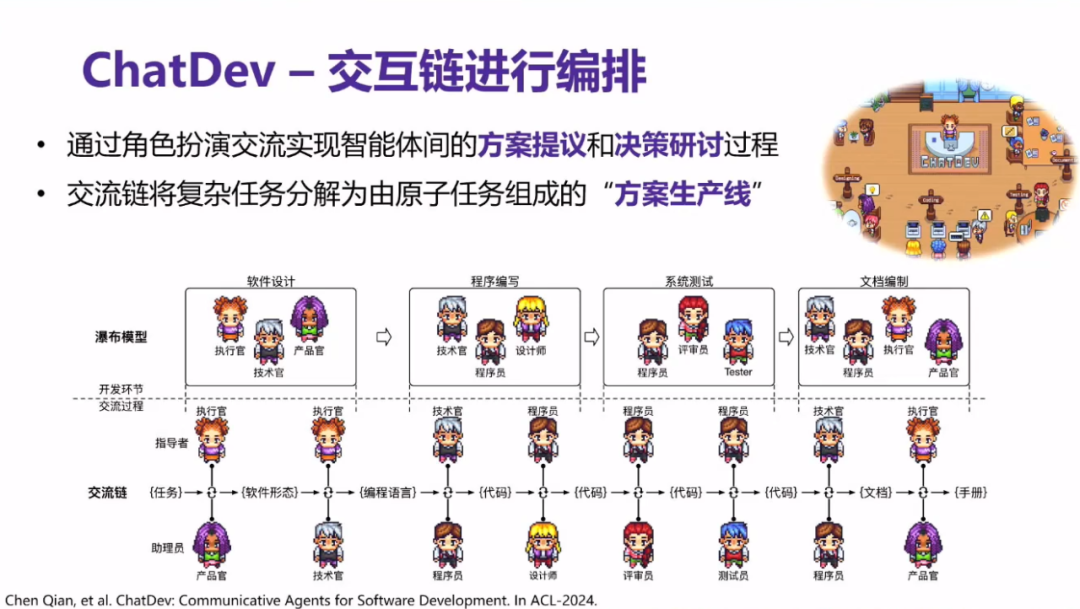

在此背景需求下,团队提出新的软件工程技术-ChatDev,技术的主要模式是通过角色扮演的形式来使得智能体编排成一条交流链,把复杂的任务分解成一个个原子任务来组成软件生成线或解决方案的生产线,并通过工具型或对话型两种机制来缓解幻觉现象。随着经验的增长,智能体所完成的任务质量也会越来越高。

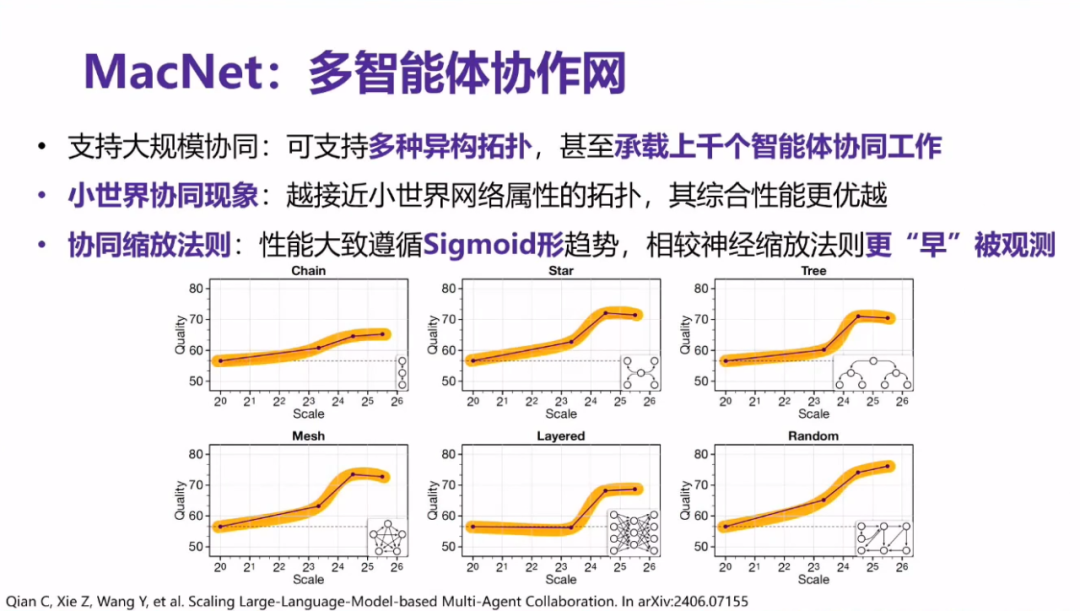

这里提出多智能体协作网-MacNet,是通用性比较强且可拓展的多智能体协作网络。

在智能体交互网上仅仅传播交互解决方案而不是整个过程,这样可以承载非常大规模的智能体协同;同时多智能体的架构越接近小世界网络属性,其综合性能往往会越好。多智能体系统随着多智能体数量增加,通常产生的任务的性能是形成Sigmoid形,称之为“协同缩放法则”。

进阶智能体的发展愿景是从独立的实体进化为可协作和可演化的系统,通过集体智慧实现可涌现的效率和结果。

AIOS:大模型智能体操作系统

报告嘉宾:张永锋 | 美国罗格斯大学计算机科学学院副教授

当前大语言模型(LLM)在理解指令、推理以及解决问题等方面展示出强大的能力,为实现Agent领域开发独立操作、决策的系统提供了更高的任务执行力。基于LLM的Agent能够接收用户提供的自然语言任务,通过自身的推理能力以及调用外部资源工具,制定出解决这些任务的详细规划,例如特定主题的艺术创作、个性化旅行规划的制定等。

在解决复杂任务时,Agent并不采用Chain of Thought一次性解决的技术路线,而是选择将任务拆解为若干小问题并逐个击破,这与人类解决问题的思维模式相似。多个不同Agent的合作是解决复杂问题的必要方式,然而,基于LLM的Agent集成和部署面临着三个重大挑战:

1.在LLM上优化agent请求的调度和资源分配;

2.维护Agent与LLM交互期间的上下文;

3.整合具有不同能力的专业化Agent的复杂性。

张永锋教授团队提出了AIOS(人工智能操作系统),相较于传统的操作系统,AIOS在多个方面均有所改进。

首先,在内核层中,张教授团队设计专门针对 LLM 的内核,该内核将类似操作系统的职责进行了区分,以实现更好的性能和效率。其次,AIOS采用了分层架构,包括应用层、内核层和硬件层,这种架构使得不同层次之间的职责更为清晰明确,便于系统的维护和升级。最后,AIOS提供了丰富的工具箱,使开发者能够更轻松地创建复杂的Agent应用程序。AIOS操作系统的核心特性和功能涵盖了Agent的管理、调度、安全控制和资源管理。它通过提供SDK和系统调用来支持开发者的高效开发,在处理多Agent环境时具有缩短等待时间、提高执行效率和保障数据安全等诸多优势。

最后,张永锋教授对AIOS的未来发展提出了展望,包括实现多核操作系统、实现可控生成方式以及开发自然语言编程平台等目标。他希望通过这些不断进化的功能,使AIOS成为大模型和智能体技术发展的核心驱动力。

Finding the scaling law of agents

报告嘉宾:李国豪 | CAMEL-AI.org

当模型需要增加更多的参数,处理更多的数据,如果没有保证下一代系统会变得更加智能,那要寄希望于scaling Agent,这是未来发展的方向。

38年前《The Society of mind》,这可能是最早的介绍Agent起源的书之一,提出Agent这个词。书中定义的Agent是一些没有思想的进程,Agent自己只能做一些非常简单的事情,人类的智能是由很多小的Agent组成。当这些Agent结合到一起成为一个society会导致真正的智能。智能是来源于多样性,并不存在于单一完美的准则。未来的AGI不是一个模型来实现,它一定是一个多智能体组成的AGI系统。

再近一点,在强化学习中,书里面定义的Agent具有学习能力,并且可以去影响环境,环境给Agent反馈,Agent可以根据反馈来改变策略,来更好地跟环境交互。但是强化学习中Agent存在一个很大的问题,一般states和action预先已经定义好,所以很难泛化到不同环境,比如训练在围棋的环境没有办法泛化到象棋,模型泛化能力太差。这里面有非常多的研究工作,但是一直没有被很好的落地,主要是泛化能力的问题。

直到大语言模型的出现,大语言模型做Agent,最早的工作可能是WebGPT,最早OpenAI的工作是用大语言模型来做网络搜索。语言模型训练完之后knowledge已经是规定了,如果要去对最新的信息进行查找或者是想要提高模型能力的话,需要根据搜索结果来同时生成语言模型的回复。

语言模型输入和输出都是语言。action和states都可以通过语言来去表达,所以语言模型的Agent可以泛化到各种各样的场景,因为state和Action表达空间非常大。但是这里面有缺失的地方,Agent也是应该能够跟其他Agent做Communication,也可以做learning,这些可能在之前的框架里都没有提到过。

CAMEL-AI是团队一起完成的一个开源项目。CAMEL包含了最早研究智能体交互的工作,后续还包含许多工作包。CAMEL-AI的功能框架主要分成两部分:第一部分是Human Input,第二部分是 Role Playing Session。一旦有了人类的输入方案,AI系统就开始合作完成任务。

系统采用了三个prompt完成这部分工作,一个是Task Specifier prompt,将想法变成具体的任务。然后是Assistant System prompt和User System Prompt,主要完成的事情是确定Agent跟谁合作,合作的任务以及如何通信。

对系统实验的结果,在两个数据集里,超过70%的概率使用两个Agent的结果会比一个Agent效果更好,这两个Agent使用的是3.5turbo的bass model。另外有一个非常实用的应用,在对话过程中系统生成非常多的数据,可以将这个数据加入模型中增强数据,微调模型。

在系统设计过程中也遇到了许多挑战。第一个常规的挑战是Role Flipping,存在这两个Agent可能不能融合的情况,需要其他工具辅助解决;另外一个挑战是Assistant重复了一个指令导致了分化;还有一个很常见的问题称为Flake Reply,Assistant只是对指令进行简单地回复却并没有真正完成任务;最后一个挑战是AI系统设置了对话轮次的上限和停止的条件才解决何时停止的问题。

如何去衡量不同语言模式之间能力的差距,最重要的事情是制定基准。现在很多常见的基准已经无法评价语言模型的差距。在未来通过让模型完成一些智能体的任务来对模型能力进行衡量是一个很重要的制定基准的方向。基准不能只应用于模型的推理领域,还需要同时能够评价语言模型的Agent能力,在这一方面模型之间还是有很大的差距的。

From Deep Reinforcement Learning to LLM-based Agents: Perspectives on Current Research

报告嘉宾:Stefano V. Albrecht | 爱丁堡大学副教授

主要内容:来自爱丁堡大学自主智能体研究组的Stefano V. Albrecht教授主要介绍其团队在深度强化学习领域的工作和大语言模型(LLM)研究的最新成果和观点。以及,他著作的第一本多智能体教科书——《Multi-Agent Reinforcement Learning: Foundations and Modern Approaches》(www.marl-book.com),由麻省理工学院出版社出版。

首先在深度强化学习领域,教授团队重点研究四个方向:

1.样本复杂性和解决方案质量

2.解决方案的鲁棒性和泛化能力

3.多智能体应用

4.行业应用

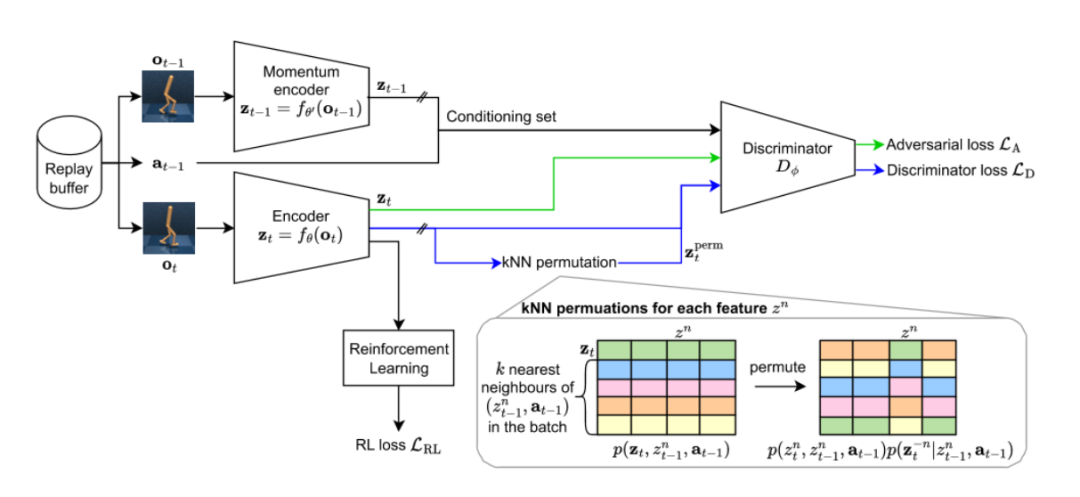

「CMID」是首个基于条件独立性专门用于学习强化学习分离表示的方法。该方法通过最小化表示特征之间的条件互信息,来学习高维观察值中具有相关特性的分离表征。CMID利用MDP的因果图来确定一个通用条件集,在该条件集下,表示中的特征条件独立。这种分离表示避免了伪相关性的依赖,将高维观察中的相关变化因素分解为表示中的不同特征,从而在相关性转移时实现更佳的泛化能力。在实验中,SVEA-CMID算法在多个环境突变的控制任务中均展现出优于其他基准算法的适应性和泛化性。

在多智能体强化学习中,参数共享策略能够显著减少可训练参数的数量,进而缩短训练时间。然而,当所有智能体都共享相同参数时,其有效性高度依赖于环境特性。「SePS」选择性参数共享的提出旨在结合参数共享的优势,同时避免潜在的瓶颈。SePS能够自动识别那些根据其能力和目标可能从共享参数中获益的智能体,并使用确定的函数将这些智能体映射到参数化策略中。通过这种方式,共享参数的智能体能够从神经网络的隐藏层中共享信息,而不会干扰到其他未共享参数的智能体。

在仓库自动化领域,该团队与DEMATIC合作,成功研发出一套高效的仓库管理系统,实现了人类和机器人协作的优化,并在真实仓库环境中验证了该方案的可行性。在自动驾驶领域,团队与Five AI携手开发完整的自动驾驶技术栈,包括感知、规划、预测和控制等,并在伦敦的实际道路上成功进行了测试。

其次在LLM领域,教授重点介绍了在使用LLM处理涉及空间推理和对象操作任务方面的最新进展。其团队构建了LLM-Personalize框架,该框架旨在通过强化自我训练和模仿学习相结合的方式,将LLM个性化为家庭机器人任务规划器。

Stefano V. Albrecht教授提出,未来的研究工作应聚焦于开发大型、多样化的控制数据集,以推进大决策模型的发展。

- 点击“查看原文” ,观看完整大会视频回放 -

Llama2、王兴兴、王鹤、卢宗青、邵林、高阳等专家共论具身前沿

Llama2、百川、ChatGLM、MiniCPM、Llama作者等共论LLM关键问题

Llama2、3作者中国首讲!LLM前世今生,AGI是我们这代人的哥白尼革命

GPT-4o、SAM、DiT、DCN、SegGPT作者共话多模态模型前沿进展

Sora团队负责人Aditya Ramesh对话谢赛宁丨压缩一切!视觉与语言模态的融合

402

402

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?