一、安装Ollama

1. 打开Ollama官网/Ollama官网,根据自己的操作系统下载相应版本的安装文件(#^.^#),我选择的是Windows版~

2. 下载好后,直接双击打开安装文件,并点击“Install”安装。

3.安装好后,在电脑的右下角的^,就可以看到一只可爱的羊驼,^0^

咩~~~

咩~~~

4.Ollama的默认安装路径为 C:\Users\用户名\AppData\Local\Programs\Ollama

下图是Ollama在我的电脑中的位置

*如果想将Ollama移动到别的盘符,需在环境变量中修改Path选项,添加Ollama文件绝对路径——打开控制面板,搜索“环境变量”,然后再【用户变量】中选中Path,点击右下的编辑按钮,新建新的路径。

5.测试Ollama是否安装成功。

按Windows+R,并输入cmd,回车确定

在cmd中输入

ollama -h若出现如下图所示则说明Ollama安装成功

二、安装Deepseek_R1

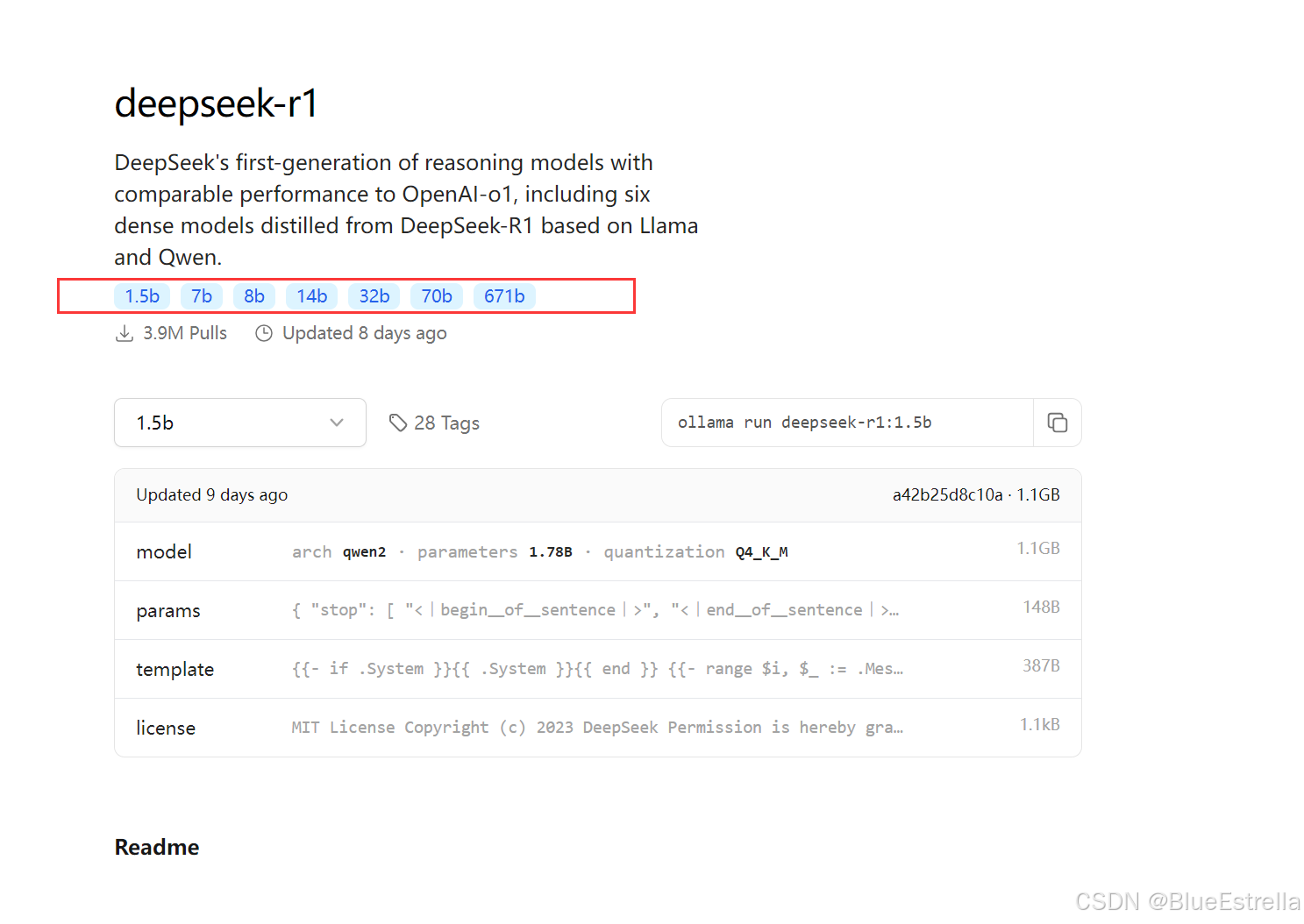

1.同样在Ollama官网搜索"Deepseek_R1",根据自身电脑配置选择不同大小的模型

DeepSeek模型显卡和macOS运行内存需求一览表(网络整理)

模型大小 显存需求(FP16推理) 显存需求(INT8推理) 推荐显卡 macOS需要的RAM 1.5b ~3GB ~2GB RTX 2060 8GB 7b

~14GB ~10GB RTX 3060 12GB/4070 Ti 16GB 8b ~16GB ~12GB RTX 4070 16GB 14b ~28GB ~20GB RTX 4090 32GB 32b ~64GB ~48GB A100-80G/

2x RTX 090

64GB

2.在cmd界面中输入命令本地安装

例如安装1.5b,以此类比:

ollama run deepseek-r1:1.5b下载完后会显示Success

到这Deepseek_R1大语言模型就部署完成啦,一些基本操作:

- 查看安装的Ollama环境,可以输入Ollama list

- 开启交互,可以输入Ollama run deepseek- r1:7b,输入要问的问题

- 想要退出,只要输入/bye,就可以了啦!

三、在Pycharm中使用Deepseek

1.首先,打开Pycharm,我使用的是Community版本。找到右上角的小齿轮图标,选择【插件/Marketplace】

2.搜索【CodeGPT】,点击安装

3.安装完毕后,在界面右侧就会出现一个如图的图标

4.使用本地离线Deepseek模型

按照图片中所示步骤,选择到【Ollama(Local)】

选择你的模型之后,点击确定

5.具体使用

这样在编写或查看代码的时候,点击右侧的对应图标,就可以选中想要的代码进行提问了

补充:

已更新下一篇内容❥(^_-):

OK~所有的内容到这里就结束啦——

码字不易,希望大家点点关注收藏和赞赞ღ( ´・ᴗ・` )

2051

2051

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?