点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

DriveLM是一个基于语言的驱动项目,它包含一个数据集和一个模型。通过DriveLM,我们介绍了自动驾驶(AD)中大型语言模型的推理能力,以做出决策并确保可解释的规划。

在DriveLM的数据集中,将人工书写的推理逻辑作为连接,促进感知、预测和规划(P3)。在模型中,我们提出了一个具有思维图能力的AD视觉语言模型,以产生更好的规划结果。目前,数据集的演示已经发布,完整的数据集和模型将在未来发布。

项目链接:https://github.com/OpenDriveLab/DriveLM

What is Graph-of-Thoughts in AD?

数据集最令人兴奋的方面是,P3中的问答(QA)以图形风格的结构连接,QA对作为每个节点,对象的关系作为边。

与纯语言的思维树或思维图相比,我们更倾向于多模态。在AD域中这样做的原因是,从原始传感器输入到最终控制动作,每个阶段都定义了AD任务。

DriveLM数据集中包含什么?

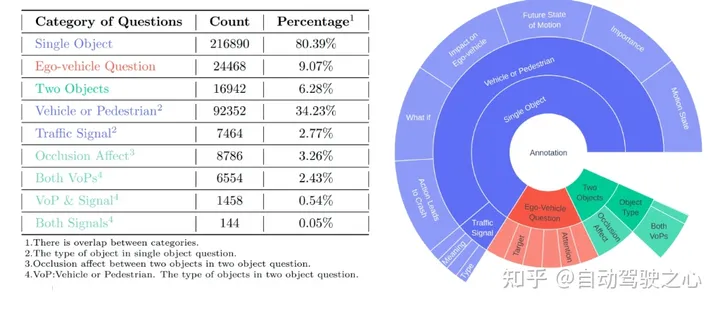

基于主流的nuScenes数据集构建我们的数据集。DriveLM最核心的元素是基于帧的P3 QA。感知问题需要模型识别场景中的对象。预测问题要求模型预测场景中重要对象的未来状态。规划问题促使模型给出合理的规划行动,避免危险的行动。

标定过程如何?

关键帧选择。给定一个剪辑中的所有帧,注释器将选择需要注释的关键帧。标准是,这些框架应该涉及自车运动状态的变化(变道、突然停车、停车后启动等)。

关键对象选择。给定关键帧,注释器需要拾取周围六个图像中的关键对象。标准是这些物体应该能够影响自车(交通信号灯、过街行人、其他车辆)

问答注释。给定这些关键对象,我们会自动生成关于感知、预测和规划的单个或多个对象的问题。更多细节可以在我们的演示数据中找到。

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,如果您希望分享到自动驾驶之心平台,欢迎联系我们!

① 全网独家视频课程

BEV感知、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、协同感知、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

视频官网:www.zdjszx.com

视频官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

近2000人的交流社区,涉及30+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(2D检测、分割、2D/3D车道线、BEV感知、3D目标检测、Occupancy、多传感器融合、多传感器标定、目标跟踪、光流估计)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多模态感知、Occupancy、多传感器融合、transformer、大模型、点云处理、端到端自动驾驶、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向。扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】平台矩阵,欢迎联系我们!

DriveLM项目展示了在自动驾驶中使用语言模型进行决策制定的能力,通过图形化的P3QA连接感知、预测和规划。数据集基于nuScenes,包含关键帧选择、对象识别和多模态问答,预示着更透明的决策过程。

DriveLM项目展示了在自动驾驶中使用语言模型进行决策制定的能力,通过图形化的P3QA连接感知、预测和规划。数据集基于nuScenes,包含关键帧选择、对象识别和多模态问答,预示着更透明的决策过程。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?