点击下方卡片,关注“3D视觉之心”公众号

第一时间获取3D视觉干货

>>点击进入→3D视觉之心技术交流群

基于物理的前提

为了提升真实感,研究逐渐超越了传统表示方式,如点云、网格、体素网格和有符号距离场(SDF)。神经辐射场(Neural Radiance Fields, NeRF)利用神经渲染技术从视频中生成新视角图像,使得模拟内容能够直接来源于捕获的数据,从而应用于交互式游戏、动画和仿真。此外,高斯喷溅(Gaussian Splatting, GS)因其快速渲染和重建速度而广受关注。GS 利用 离散高斯核 来表示 3D 场景,使得从视频中重建的物体更容易直接操作和处理。

然而,当前基于物理的仿真方法,无论是使用 NeRF还是 GS,大多仅关注 合成物体,这允许在重建过程中对物体进行全视角观察;或者仅支持 弹性形变与抖动,即物体仍受限于初始接触表面,无法真正脱离并独立运动。因此,当用户施加外部冲击力时,这些方法无法实现物体的真实分离。

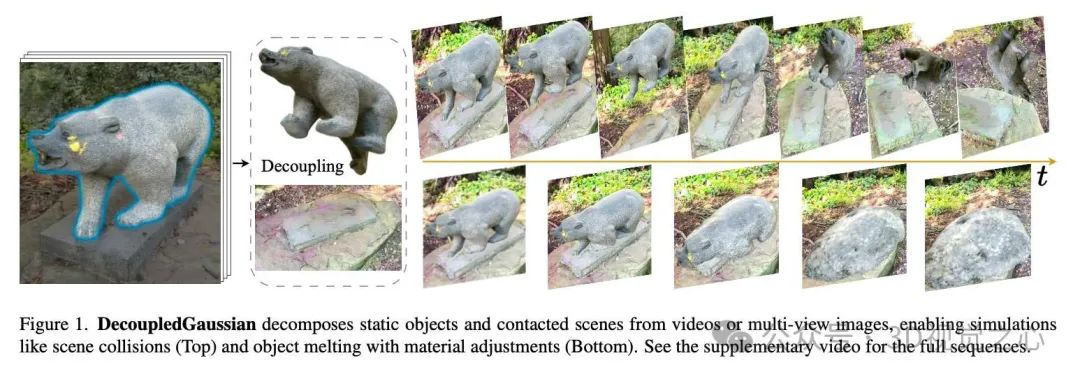

为了让物体能够在仿真前 摆脱初始接触表面的限制,我们需要首先将物体与接触表面解耦。在现实环境中,物体通常受重力影响,并停留在其他表面上,例如图 1 中基座上的雕塑。在拍摄过程中,物体与其接触表面往往被视为一体,这会导致部分区域隐藏或被遮挡,使得物体表面的表示变得支离破碎。因此,解耦的主要挑战在于:在仿真前准确恢复并补全物体及其周围场景的 3D 结构。

为了解决这一问题,本文介绍的**DecoupledGaussian[1]**,该系统利用 高斯喷溅(GS) 从自然场景视频中恢复物体及其接触表面的 3D 几何结构和纹理,为真实的物体-场景交互式仿真奠定基础(见图 1)。值得注意的是,2D 修复(inpainting)(如图 2)通常难以进行 3D 恢复,尤其是在准确捕捉几何位置信息方面。我们的方法通过结合几何先验(假设表面为封闭形状)和多视角观察,从训练视角恢复 真实的物体与场景几何,克服了这些限制。

具体而言,我们的方法采用 联合泊松场(Joint Poisson Fields) 来重建物体和场景的形状指示符,以解决物体与场景的 交叉区域问题。直接使用高斯中心点可能会导致物体重建出现 表面偏差,因为混合渲染会引入伪影。为避免此类问题,我们采用 基于平面的 GS 方法,使用 无偏深度图创建 代理点,以实现更真实的物体重建。此外,我们引入 单向负交叉熵 方法进行 多视角雕刻,以优化几何结构,使其与观测视角对齐。

DecoupledGaussian 是首个 无需 2D 修复 即能独立恢复物体和接触表面几何结构的系统。2D 修复仅用于 纹理属性的优化。我们在真实视频数据集上进行了大量实验,包括 新的解耦基准(decoupling benchmark),并结合 用户研究、定量比较和消融实验,验证了我们的方法在 恢复精确 3D 属性和实现精准交互仿真 方面的有效性。

项目链接:https://wangmiaowei.github.io/DecoupledGaussian.github.io/

主要贡献:

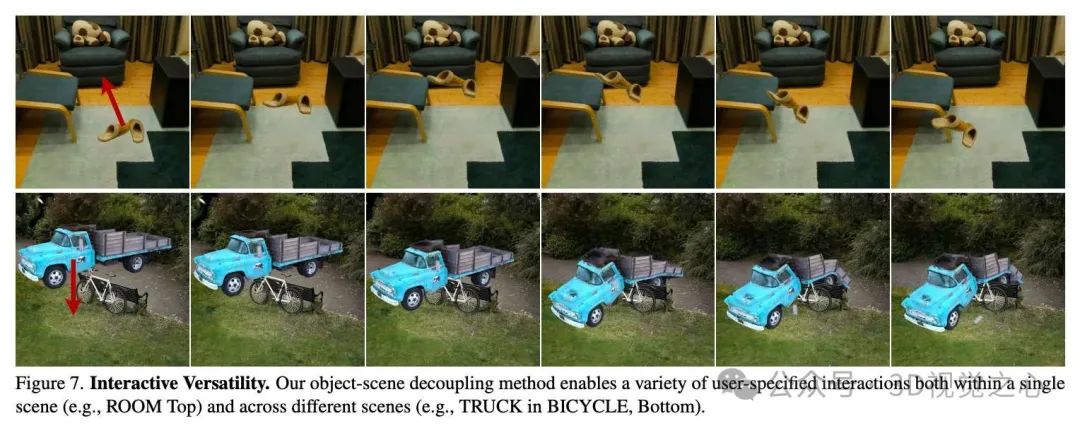

开发了一种物体-场景交互式仿真系统,该系统允许物体在由 自然场景视频 重建并表示为 GS 后,与接触表面完全分离。

引入几何先验,利用联合泊松场 和 多视角观察 结合 单向负交叉熵(UNCE),提升 GS 中的 几何属性恢复能力

具体方法

DecoupledGaussian 系统从重建的高斯喷溅 GS 场景开始,允许静止在平面表面的物体在仿真中实现合理的分离运动,如图 3 所示。首先,物体被分割出来,并采用基于平面的 GS 使高斯点对齐到底层的场景几何结构。在物体与场景分离后,系统利用几何先验信息,通过联合泊松场 Joint Poisson Fields 修复物体和场景的破损表面。对于物体,代理点 proxy points 被用作泊松场的输入,并通过单向负交叉熵 Unilateral Negative Cross-Entropy 方法进行雕刻,以确保几何结构与训练视角对齐。然后,使用二维修复技术对高斯的纹理属性 进行优化,最后通过移动最小二乘-材料点法 MLS-MPM 进行物体和场景的实时交互式仿真。本节将详细介绍各个阶段的实现方法。

三维高斯准备

场景使用普通消费级相机自由录制,然后使用 COLMAP 进行内外部标定,并生成初始高斯中心点。

基于平面的高斯喷溅

仅依赖图像重建损失优化标准的三维高斯模型通常会陷入局部最优,使得几何提取变得困难,而准确的几何提取对于后续的修复阶段至关重要。为了避免这一问题,我们采用 PGSR 方法进行无偏深度 估计。

由于标准高斯分布的无序性,我们首先将高斯点压缩到与场景表面对齐的近似局部平面,通过最小化尺度项 进行优化,以在允许一定渲染质量损失的情况下提高几何精度。

压缩到平面后,我们为高斯点 分配法向量 ,其方向由视角方向确定。到图像平面的距离计算如下:

其中, 为从相机中心到高斯中心 的向量。最终,在像素 处的无偏深度计算如下:

其中, 为相机的内参矩阵, 为像素 的齐次坐标。压缩后的高斯点提供了单视角和多视角的几何正则化,以保证几何一致性,并通过曝光补偿来减少光照变化的影响。

高斯分割

我们采用 GS 分割方法,为每个高斯核 赋予语义亲和特征 ,并通过一个单层 MLP 将 -混合后的特征 映射到 个分割类别的概率分布,并使用 softmax 进行归一化。网络使用交叉熵损失进行训练,训练数据为 SAM2 生成的多视角二维分割标签。为了减少相邻高斯点之间的误分类,我们应用了局部特征平滑。

物体-场景修复

为了模拟物体 与其周围场景表面 的交互,我们首先需要将 从 中分离出来。具体方法是通过比较语义亲和特征 与像素点 处的 -混合特征 ,确定属于 的高斯点集。然后,利用 K 近邻方法去除表示残留伪影的临近高斯点。接下来,我们修复并补全 和 ,以实现真实的物理仿真。

联合泊松场

本方法的核心贡献之一是对 GS 的几何属性 进行几何修复,假设物体 和场景 是平滑、封闭的形状。基于泊松曲面重建与环绕数场的等价性,我们提出联合泊松场 Joint Poisson Fields,该方法利用异构约束同时修复 和 的几何结构。具体步骤如下:

通过屏蔽泊松重建计算场景表面 和物体表面 的指示函数 和 ,以隐式方式确保曲面具有最小曲率。

通过世界坐标变换,将 映射到 所在的网格中,并在交叉区域 处进行冲突解决,以确保 和 互不重叠。

从 生成密集内部点集 ,并应用 Marching Cubes 算法将 转换为网格 ,随后进行重网格化和裁剪,最终转换为世界坐标系。

代理点

由于 -混合效应,直接使用高斯中心点 可能无法准确表示 的复杂表面。为此,我们引入代理点 以增强泊松重建质量。

单向负交叉熵

泊松场通常会导致几何扩张,即额外填充了不属于 的体积。为了解决这一问题,我们提出单向负交叉熵进行多视角雕刻。具体公式如下:

其中, 为 SAM2 生成的二真实物体掩码, 为当前优化过程中物体的 值。

高斯恢复

对于场景 的修复,我们首先绑定新的平坦三维高斯到网格 ,并最小化其法向方向的缩放因子 。在后续优化中,仅优化纹理属性 ,而几何属性 设为固定值。

交互式仿真

我们利用 MLS-MPM 对修复后的高斯进行仿真,以支持用户施加冲击力、弹性形变、碰撞和断裂等交互场景。在 MLS-MPM 网格操作阶段,我们将场景 的网格节点速度设为零,以模拟粘附边界条件。此外,我们使用 RANSAC 估算平面法向量,以自动对齐重力方向。

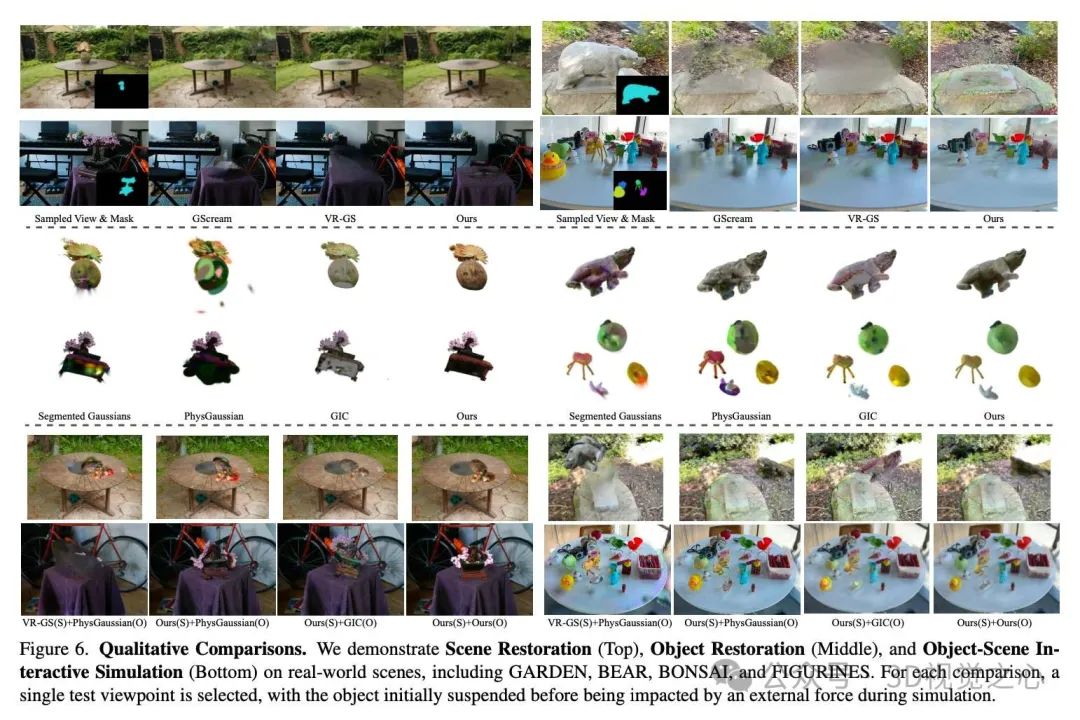

实验效果

总结一下

本文提出了 DecoupledGaussian,这是一种快速且鲁棒的方法,能够从接触表面分离静态物体,并恢复其几何和纹理,以实现基于 MLS-MPM (Moving Least Squares Material Point Method) 模拟器的物体-场景交互。

局限性:本研究未涉及包含多个物体的复杂场景,特别是当物体之间具有不同的接触配置时。此外,物体恢复中的高频纹理补全仍然具有挑战性,未来可能需要借助基于 GS (Gaussian Splatting) 的纹理生成方法来提升细节质量。此外,如何进一步对个体物体的 精细组件 (fine-grained components) 进行分离仍是一个待解决的问题。

参考

[1] DecoupledGaussian: Object-Scene Decoupling for Physics-Based Interaction

本文仅做学术分享,论文汇总于『3D视觉之心知识星球』,欢迎加入交流!

【3D视觉之心】技术交流群

3D视觉之心是面向3D视觉感知方向相关的交流社区,由业内顶尖的3D视觉团队创办!聚焦三维重建、Nerf、点云处理、视觉SLAM、激光SLAM、多传感器标定、多传感器融合、深度估计、摄影几何、求职交流等方向。扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

扫码添加小助理进群

【3D视觉之心】知识星球

3D视觉之心知识星球主打3D感知全技术栈学习,星球内部形成了视觉/激光/多传感器融合SLAM、传感器标定、点云处理与重建、视觉三维重建、NeRF与Gaussian Splatting、结构光、工业视觉、高精地图等近15个全栈学习路线,每天分享干货、代码与论文,星球内嘉宾日常答疑解惑,交流工作与职场问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?