点击下方卡片,关注“自动驾驶之心”公众号

今天自动驾驶之心为大家分享上海期智研究院、理想、同济和清华团队最新的工作—DriveAgent-R1!自动驾驶Agent时代来临,以混合思维和主动感知推动基于VLM的自动驾驶发展。如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群加入,也欢迎添加小助理微信AIDriver005

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Weicheng Zheng等

编辑 | 自动驾驶之心

写在前面 & 笔者的个人理解

DriveAgent-R1 是一款为解决长时程、高层级行为决策挑战而设计的先进自动驾驶智能体。当前VLM在自动驾驶领域的潜力,因其短视的决策模式和被动的感知方式而受到限制,尤其在复杂环境中可靠性不足。

为应对这些挑战,DriveAgent-R1 引入了两大核心创新:

混合思维 (Hybrid-Thinking) 框架: 智能体能够根据场景复杂度,智能地在高效的纯文本推理和深入的工具辅助推理之间自适应切换。

主动感知 (Active Perception) 机制: 配备了强大的视觉工具箱,使智能体能够主动探查环境以解决感知不确定性,从而提高决策的可解释性、透明度与可靠性。

我们设计了一种新颖的三阶段渐进式强化学习策略,创新提出模式分组GRPO(MP-GRPO),强化DriveAgent-R1的双模式特异性能力,为后续智能体的自由探索奠定基础。大量实验证明,DriveAgent-R1 取得了当前最佳性能(SOTA),甚至超越了如 Claude Sonnet 4 等顶尖的多模态大模型。消融实验充分验证了我们训练方法的有效性,并证实了智能体的决策是基于主动感知的视觉驱动,推动了更安全、更智能的自动驾驶。

关键词: 自动驾驶、Agent、视觉语言模型 (VLM)、混合思维、多模态思维链 (M-CoT)、强化学习

论文链接:https://arxiv.org/abs/2507.20879

研究动机与核心挑战

让自动驾驶智能体像人类一样主动“观察”与“思考”

人类驾驶员在面对复杂或不确定的路况时,其行为远非简单的“看到-反应”模式。我们的决策过程是一个主动的、探索性的过程。例如:

在夜间或恶劣天气下行驶时,我们会更加专注地观察,试图从模糊的视野中辨认远处的路标、信号灯或潜在障碍物。

准备在繁忙路口右转时,我们不会只依赖主视野,而是会主动、反复地查看右后视镜和侧窗,确保盲区安全,并预测其他车辆的动向。

遇到前方有施工或事故警示牌时,我们会放慢速度,主动寻找绕行路线或观察交警的指挥手势。

这种“主动寻求信息以消除不确定性”的能力,是人类驾驶员安全、可靠行驶的关键。然而,当前的自动驾驶VLM在很大程度上缺乏这种能力。它们主要面临两大核心挑战:

决策短视 (Myopic Decision-Making): 现有方法(如AlphaDrive)大多专注于单步的动作预测,缺乏对未来数秒内的连贯、长时程规划能力。这就像一个驾驶员只考虑下一秒踩油门还是刹车,而没有一个完整的“通过路口”的计划。

感知被动 (Passive Perception): 模型通常被动地接收固定的、低维度的文本指令(如速度、导航)和高维度的视觉信息。在规划任务中,模型很容易忽视丰富的视觉细节,形成“视觉忽略” (visual neglect)。它们无法像人类一样,在感觉“看不清”或“不确定”时,主动地去“再看一眼”或“凑近点看” 。

因此,我们的核心任务是:赋能智能体进行长时程、高层级的行为决策,同时,当面临不确定性时,能像人类驾驶员一样主动地从环境中寻求关键信息。

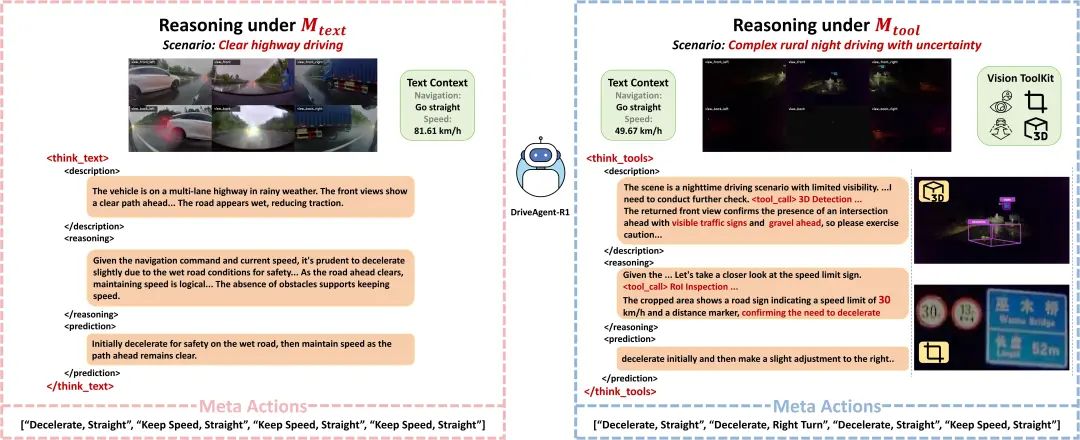

上图生动展示了DriveAgent-R1在面对不同场景的两种思考过程。在一个视线较为清晰的公路上行驶时,DriveAgent-R1准确判断初始输入已经提供了充足的视觉信息,并采用<think_text>模式依赖纯文本做出最终决策。而在一个光线条件较差,充满不确定的乡村夜间道路中,智能体主动调用了“3D Object Detection”和“RoI Inspection”工具,以获取前方道路碎石块和限速标志的关键视觉信息,从而做出了更安全、更有依据的减速决策。

核心创新点

业界首个基于强化学习的智能思维架构: 我们首次在自动驾驶智能体中实现并提出了混合思维架构。DriveAgent-R1能够根据驾驶场景的复杂度,在高效的纯文本多模态思维链 Text-based M-CoT和基于视觉工具辅助多模态思维链 Tool-based M-CoT之间自适应切换,从而智能地适应不同的驾驶场景。

引入主动感知概念: 我们将“主动感知”的概念引入到基于VLM的自动驾驶中,为智能体配备了一个强大的视觉工具箱,使其能够在不确定的环境中主动探索,显著增强其感知鲁棒性。

完整的三阶段渐进式训练策略: 我们设计了一套完整的、以强化学习为核心的三阶段渐进式训练策略,并建立了一套全面的评估体系,用以评估模型的预测准确性、推理质量和自适应模式选择能力。

在挑战性数据集上取得SOTA性能: 在极具挑战性的SUP-AD数据集上,我们的方法取得了SOTA性能,甚至超越了如Claude 4 Sonnet,Gemini2.5 Flash 等前沿多模态大模型 。

方法详解

总体架构

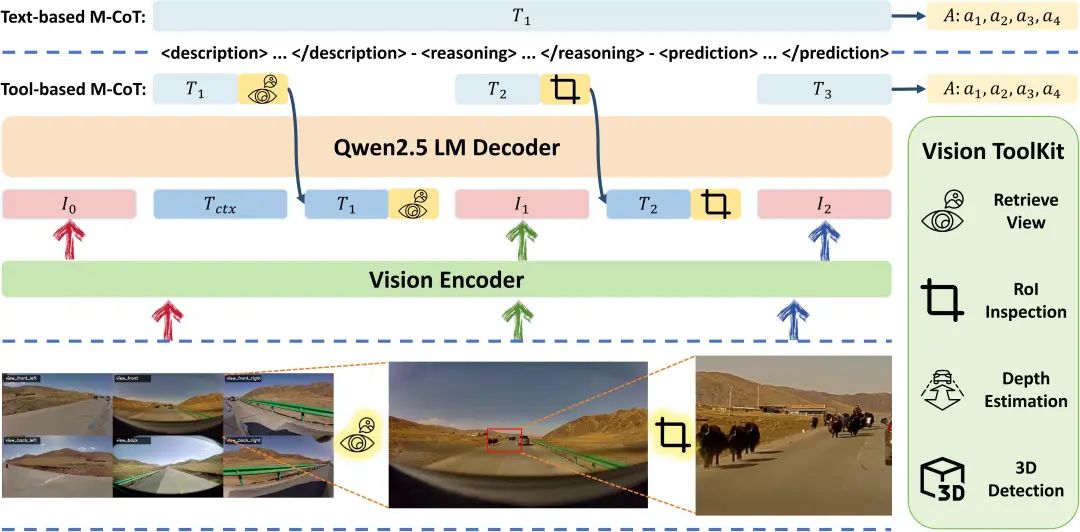

DriveAgent-R1基于轻量级的Qwen2.5-VL-3B模型构建。其主要任务是基于多模态上下文信息(6个环视摄像头的低分辨率图像、当前车速和导航指令),生成一个安全合理的未来8秒长时程驾驶意图决策。这个决策由4个时间步(每步2秒)的离散元动作序列A=(a1, a2, a3, a4)组成,每个元动作包含速度(加速、保持、减速、停止)和轨迹(直行、右转、左转)两个部分。

混合思维 (Hybrid-Thinking) 过程

DriveAgent-R1在正式推理之前,首先根据初始多模态输入判断,当前视觉信息是否充足,基于此做出思考模式的选择,以<think_text>或<think_tools>作为特殊token标识启用思考模式。

文本M-CoT模式 ( ): 在简单的常规场景中,模型会生成

<think_text>激活此模式。它完全依赖初始输入和内部知识进行纯文本推理,优点是计算效率高,适用于信息充足的场景。工具M-CoT模式 ( ): 在复杂或不确定的场景中,模型会生成

<think_tool>激活此模式。它会主动调用外部视觉工具来主动获取多的补充信息,以一种交错、多模态的方式(inter-leaved)丰富其组织思考过程。工具的调用和返回信息可以由智能体根据自身需要任意嵌入到思考过程的任何阶段。

无论选择哪种模式,智能体的思考过程都遵循一个统一的、结构化的三阶段思维链:

描述 (description) → 推理 (reasoning) → 预测 (prediction)

主动感知与视觉工具箱 (Active Perception & Vision Toolkit)

为了实现主动感知,我们为DriveAgent-R1集成了一个强大的视觉工具箱。

获取高分辨率视图 (Retrieve High-Resolution View): 允许智能体按需请求任一特定视角的高分辨率图像。更重要的是,它包含了一个历史记忆池,缓存了过去5秒所有视角的图像,使模型能回溯历史帧以评估交通灯变化或动态物体趋势,避免了处理完整视频序列带来的高昂计算成本。

关键区域检查 (RoI Inspection): 赋予智能体“放大看”的能力,智能体可以根据需要通过提供坐标框来主动检查特定感兴趣区域。这对于确认关键细节信息比如远处交通灯状态或路牌文字至关重要。

深度估计 (Depth Estimation): 利用SOTA的单目深度估计算法(Depth Anything V2,NeurIPS 2024)生成深度图,帮助模型直观地掌握物体的相对距离和空间布局。

3D物体检测 (3D Object Detection): 集成了一个先进的开放词汇表单目3D物体检测工具(DetAny3D,ICCV2025)。它不仅能检测常规物体,其“开放词汇表”的特性还允许模型根据当前场景需要动态指定新的检测对象,展现出极高的灵活性。

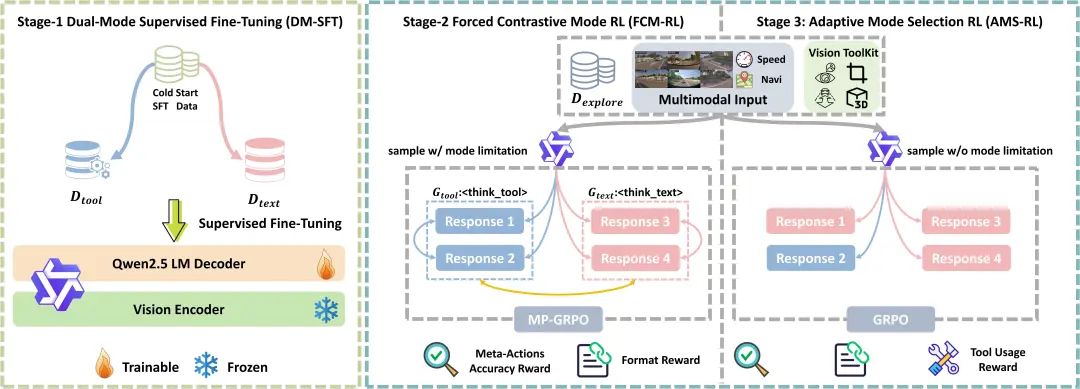

三阶段渐进式训练策略

我们设计了一套“基础构建 → 模式强化 → 自主决策”的渐进式策略来培养智能体的混合思维能力。

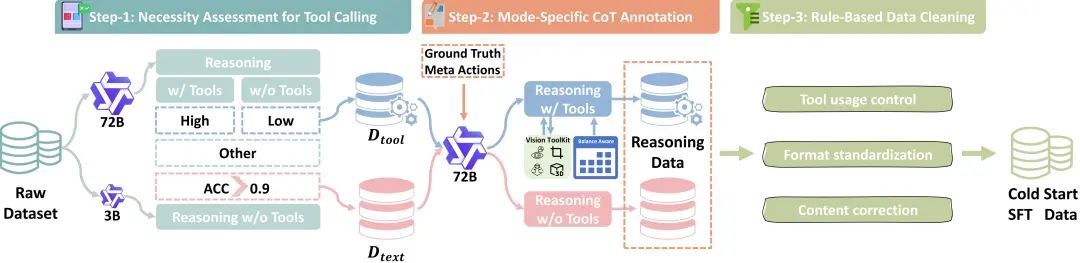

第一阶段:双模式监督微调 (DM-SFT)

目标: 让模型对两种思维模式的格式和语义边界有一个基础的理解。

数据构建: 我们设计了一个自动化的数据构建流水线,1)首先通过一个“工具调用必要性评估”步骤将原始数据划分为工具必需集和工具非必需集。2)然后使用强大的72B“教师模型”为数据进行逆向推理式CoT标注,)最后通过规则进行清洗,构建高质量的冷启动SFT数据集。

第二阶段:强制对比模式强化学习(FCM-RL)

目标: 强化并加深智能体在不同思维模式下的独立思考能力,避免对某种模式产生偏见。

方法: 我们提出了模式分区GRPO (MP-GRPO)算法。对每个输入,我们强制智能体生成两种模式的响应组,从而创造出一种多维度的对比学习信号(模式内对比和模式间对比),为最终的自适应选择奠定基础。

奖励设计: 奖励由准确性奖励 ( ) 和格式一致性奖励( )组成。

第三阶段:自适应模式选择强化学习 (AMS-RL)

目标: 训练智能体根据上下文自主选择最优的思维模式,实现真正的混合思维。

方法: 我们移除了模式强制约束,采用原生的GRPO算法。智能体必须自主选择合适的思维方式。

奖励设计: 在第二阶段的奖励基础上,增加了一个条件性的工具使用奖励 ( ) 。该奖励基于课程学习,设计了一个动态奖励窗口,在训练初期鼓励探索工具的使用,在后期则要求高精度的、有影响力的工具使用。

实验部分

实验设置

数据集: 所有实验均在关注长尾和挑战性场景的SUP-AD数据集上进行。我们构建了5K高质量样本用于SFT,剩余数据用于RL训练。评估数据共1500条。

评估指标:

准确性 (Accuracy): 计算首帧和序列平均的联合准确率,并引入了允许保守预测的“宽松速度匹配”机制。

整体评估分数 (H-Score): 使用SOTA大模型(Gemni 2.5 pro)作为评估器,从安全性、舒适性和准确性三个维度对推理过程和预测结果进行综合打分。

模式选择准确率 (MSA): 用于量化智能体动态选择正确思维模式的能力。

实现细节:

基础模型: Qwen2.5-VL-3B 。

硬件: 8卡 H20 GPU。

训练参数: SFT阶段学习率为2.0e-5,batch size=256。RL阶段采用GRPO框架,reponse group=4,其中第二阶段的MP-GRPO算法中每个模式分组的response group=2。

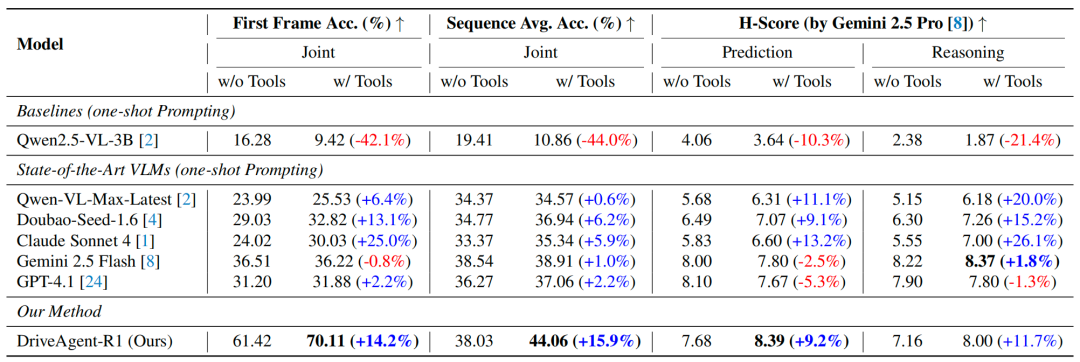

主要结果

工具使用能增强SOTA VLMs的能力: 实验发现,为SOTA VLMs(如Claude Sonnet 4)提供视觉工具箱后,其决策能力普遍得到提升,例如联合准确率提升25.0%,推理质量提升26.1%,证明了主动获取视觉信息是VLM驾驶智能体的一个有前景的方向。

视觉工具是一把“双刃剑”: 如果没有经过专门训练,直接给模型提供工具会导致性能崩溃。我们的基线模型在获得工具权限后,联合准确率暴跌42.1% 。这表明,只有当智能体被明确训练如何利用工具时,工具才能成为资产,否则会引入不确定性,成为一种负担。

DriveAgent-R1:成功将“干扰”变为“放大器”: 与基线模型形成鲜明对比的是,经过我们渐进式训练策略的DriveAgent-R1,在启用工具后所有指标均获得显著提升,例如序列平均准确率提升15.9%。这有力地证明了我们的训练策略至关重要,它成功地将工具从潜在的干扰源转化为了强大的性能放大器。

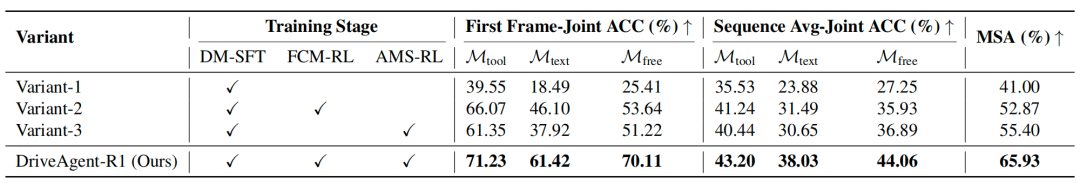

消融实验

渐进式训练策略的有效性:

RL是性能的关键: 所有经过RL训练的变体都显著优于仅进行SFT的基线模型,证明了RL对于释放智能体潜力至关重要。

FCM-RL强化执行,AMS-RL磨练选择: 实验清晰地揭示了两个RL阶段的分工。第二阶段(FCM-RL)对于强化单模式的执行能力至关重要,而第三阶段(AMS-RL)对于教会智能体何时使用这些能力(即模式选择)至关重要。

完整的渐进式策略达到最优性能: 完整的三阶段策略使DriveAgent-R1在所有指标上都达到了最佳性能,实现了单模式执行能力和模式选择智能的协同提升。

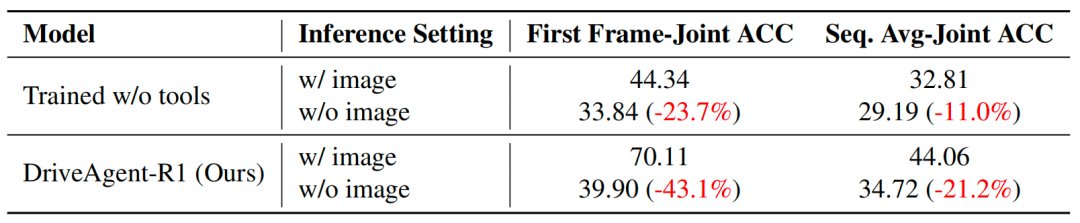

2.主动感知放大了对视觉的依赖:

DriveAgent-R1是真正的视觉驱动: 在推理时移除所有图像输入,DriveAgent-R1的性能出现了灾难性下降(首帧准确率暴跌43.1%),这有力地证实了它的决策是真正由其所见驱动的,而不是利用了文本捷径。

主动感知是深度视觉依赖的关键: 一个未经工具训练的对照组在移除视觉信息后,性能下降幅度远小于DriveAgent-R1(23.7% vs 43.1%)。这表明,正是我们的主动感知机制,培养了模型对视觉现实深刻而有意义的依赖,使其决策更加鲁棒和有据可依。

结论

我们提出了DriveAgent-R1,一个通过主动感知机制和混合思维框架解决长时程、高层级行为决策挑战的先进自动驾驶智能体。通过创新的三阶段渐进式RL训练策略,DriveAgent-R1以轻量级模型的体量实现了SOTA性能。它通过像人类驾驶员一样思考和主动感知,有效提升了决策的可解释性,操作的安全性。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?