序言

阳历生日。今年因为年过得早的缘故,很多事情都相对提前了(比如情人节)。往年过生日的时候基本都还在家,所以一家子出去吃个饭也就罢了。今年承蒙凯爹厚爱,正好也有小半年没聚,他前天也刚正式拿到offer,于是狠狠地宰了他一顿哈哈(srds下个月他过生日还得还回去)。

难得跟人一逛老半天,从乳山四村到正大广场,吃完饭再回来,一路上交换见解与心得,从九点多一直到晚上六点多才走,凯爹的阅历让我受益颇多。我其实很羡慕凯爹这样的人,每一个能从二战走出来的都是勇士中的勇士,就是那种生活很有激情,并且目标明确,矢志不渝,这两个词我觉得是越来越难能可贵。

回来这些天除了泡实验室,每天还是至少会去遛五圈,前天浅浅地跑了5000米,其实也不是很吃力。说起来差不多停跑了有十天,相当致命,不过我发现因为这么多年来屡屡从低谷恢复训练,身体已经习惯了这种节奏,至少今年开始恢复的时候跑起来还是挺轻快的,虽然耐力明显很差,但也没有那么笨重。

初心难追,但是谁又愿意就如此屈服于生活呢?

文章目录

- 序言

- 20230216

- 20230217~20230220

- 20230221

- 20230222~20230224

- 20230225~20230226

- 20230227

- 20230228

- 20230301

- 20230302

- 20230303~20230304

- 20230305~20230306

- 20230307

- 20230308

- 20230309

- 20230310~20230311

- 20230312

- 20230313~20230314

- 20230315

- 20230316

- 20230317

- 20230318

- 20230319

- 20230320~20230321

- 20230322

- 20230323

- 20230324~20230325

- 20230326~20230327

- 20230328

- 20230329

- 20230330

- 20230331

- 20230401

- 20230402~20230403

- 20230404

- 20230405

- 20230406

- 20230407

- 20230408~20230409

- 20230410

- 20230411

- 20230412

- 20230413

- 20230414~20230415

- 20230416

- 20230417~20230418

- 20230419

- 20230420

- 20230421~20230423

- 20230424~20230425

- 20230426~20230427

- 20230428~20230503

- 20230504

- 20230505

- 20230506

- 20230507~20230509

- 20230510

- 20230511

- 20230512

- 20230513

- 20230514~20230515

- 20230516

- 20230517~20230520

- 20230521

- 20230522

- 20230523

- 20230524~20230525

- 20230526~20230528

- 20230529~20230530

- 20230531

- 20230601

- 20230602

- 20230603

- 20230604

- 20230605

- 20230606

- 20230607

- 20230608

- 20230609

- 20230610~20230613

- 20230614

- 20230615

- 20230616~20230617

- 20230618~20230620

- 20230621

- 20230622

- 20230623

- 20230624~20230625

20230216

因果推断之遐想,今年NSFC的通告里着重强调了这个方向,严格上来说这是一个统计学范畴,但是他越来越受到ML以及DM领域的关注,原因在于数据中难免存在难以捕获的偏见。

最近一篇非常好的CasualLM: Causual Model Explanation Through Counterfactual Language Models,提出了一种基于反事实构造的反事实语言模型,可以修整数据中固有的偏见。

但是现阶段因果推断和NLP的结合的工作大多是基于现有的因果图做检验会调整,其实有一个很关键的核心问题是如何捕获混杂因子(在没有因果图的情况下),一些工作会介绍如何从复合变量中分离得到混杂变量以及调整变量,如http://www.meng-jiang.com/pubs/tee-aaai17/tee-aaai17-paper.pdf与https://arxiv.org/abs/arXiv:2006.07040,但是这些工作也是建立在因果图已知,候选的变量已经给定的前提下得到的,一般的情况是只给你上下文语料,如何判断一个基于该语料的任务存在混杂因子。

其实在预训练数据是足够充分的条件下,我们应当认可模型预测的结果是无偏的。问题在于预训练数据总是不够充分的,所以我们需要构造反事实来使得它更为均衡。还有就是Pearl的因果推断理论框架是完全建立在因果图之上的,问题在于没有任何理论保证因果图的有效性,这在因果推断与NLP结合时确实是令人费解的事情,这就有点射箭画靶的意思,为了论证存在混杂,特意构建了一个能够导出混杂的因果图。

20230217~20230220

- 昨天颜烨即兴约我和王凯小聚,在很久以前羊肉串,就很巧,颜烨最近也在看因果推断,不过他是用在推荐上,于是在等王凯时交换了不少意见。吃完去政民路上的一家小酒吧搓了两把以色列麻将,最后险些完成华丽的逆转(7张牌反杀颜烨2张牌,就是有1张怎么想都出不去),狗颜烨手气贼好把把起手百搭,我两把一个百搭都没摸不到(笑)。

- 下个月19号锡马,说实话把握不是很大,但是目标肯定还是要进95分钟,其实说起来我已经有14个月没有跑过20km以上的距离了。恢复期目前练了六天,但是周末歇了两天,今天是2km+1km+1km的间歇,配速4分整,间歇5分钟,心率上到190,痛苦得要死,但是要快速恢复就必须依赖高强度的变速和间歇,耐力还得靠跑量堆上去。目前水平持平去年九月底,想要跑半马至少也要达到去年十一月底的水平。就过往的经验来看只要能把10km跑到43分钟左右,基本上在最佳状态下就有能力冲击半马。

- 说实话也许是我最后一次跑步了,我也确实地感觉到各种压力而无法坚持下去,也许赶不上最后的一次校运会,仍是遗憾无比,除非我愿意能够在高压下坚持训练到4月底,以后大概率是以养生跑为主。尽管大概率还是不能在最巅峰的状态下完成比赛,但跑一次半马是最后的倔强,虽然以后有机会我也许会去跑全马,跑铁三,但是我不愿意自己这么三年多以来的阶段性跑步生涯就如此无疾而终,它应该配得上一个荣誉作为句号。

谈谈我对chatGPT的看法,昨天也跟yy和wk探讨了这个问题。其实去年十一二月的时候,就已经可以在B站上刷到不少chatGPT大战弱智吧的视频,当时我也不是很关注,总觉得是跟以前那种废话文学生成器是一样的toy model。直到今年一月搞科技部课题申报的时候事实上接触chatGPT时才真正震惊于其恐怖的性能。

现在网络上的评价趋于两级分化,有的人奉chatGPT为神,有的人对之嗤之以鼻。就我浅薄的认知而言,假若chatGPT的背后确实没有任何人类技术员的干预(或者说白了就是人工作弊),我认为chatGPT将是一个划时代的产物,以2017年BERT横空出世作对比,chatGPT的创新性至少比BERT要高出一个档次。

因为就我所理解,chatGPT在许多NLP任务上(问答、对话、代码改错、目标文本生成、自然语言推断、阅读理解、文本综述)都远远超过了目前相应领域SOTA模型的性能。具体的细节我也不想写太多,因为我是做这方面工作的,这种效果让我非常震惊。

以前说强AI会取代很多工作,现在看来强AI的出现,第一批失业的或许就是我们这批踩着末流踏进AI研究的,就有点像49年假如guo军的感觉(苦笑)。试想,你针对一个特定任务的做的模型,做得再好也比不过chatGPT,chatGPT在广度和深度上已经超过了大部分研究者的上限,这是一件非常可怕的事情。很多大企业追逐潮流,就会对业务和人员进行结构性调整,谁又能确保之后不会出现第二个chatGPT呢,特别特别有危机感。说实话,保守估计我觉得国内近一年不可能有产品可以超越chatGPT。

所以现在很多的想法就是去做chatGPT做不了的事情,即要跳出NLP,比如图像、推荐等,如果还是要和NLP挂钩,那么要么在方法论上创新,要么只能向多模态发展。这可能也是为什么因果推断成为今年NSFC的一个重要突出领域。

提一个,写开题看到VisualMRC,一开始以为就是VQA,结果VisualMRC竟然是所有的上下文就是一张图像,不过图像中包含区块性的文字以及贴图,VQA是直接给一张图(可能会有简短的描述),然后直接答题。VisualMRC提出的动机是因为大部分现实世界文本都不是以纯文本出现的(比如PDF和HTML),所以只能处理包含文本的图片,不过总觉得只是用OCR识别一下即可划归到一般的VQA,感觉又是为了发paper画靶射箭。

20230221

- 昨晚wyl破天荒开组会从六点开到十点半,我跟黄名媛实在是顶不住了,黄名媛本来晚上约人吃饭,我说估计一个多小时就结束了,可以等结束再去吃。结果她连晚饭都没吃到,离大谱。

- 降温,长袖长裤拉耐力,10圈17’20",配速4’20",其实挺满意的,一周就可以上到4km,比九月份恢复得快(那时候挣扎了半个多月都没能跑10圈)。结识了一下经常来跑的光头大叔,我一直以为他是老师,原来是家属,上周也偷偷跟他跑了几次,发现三年来一点长进没有,配速还是4’40"~4’50"的水平,有点失望,要不然就可以找个pace差不多又看起来很专业的一起练。他都是每天下午三点半之后到操场,我一般是四点,但他拉伸时间很长,所以起跑时间很接近。他不跑比赛,单纯是锻炼身体,但是今年还是本着10km跑进45min在训练,有个目标跑起来确实更有动力一些,这也是我一直拒绝养生跑的原因。如果真的只是以锻炼身体去养生跑,根本是无法坚持长久的。

SQuAD1.1和2.0的下载链接:

https://data.deepai.org/squad1.1.zip

https://rajpurkar.github.io/SQuAD-explorer/dataset/train-v2.0.json

然后NewsQA直接可以在https://download.microsoft.com/download/1/D/8/1D830CEE-F8D1-4807-9224-DE35A8F08DC4/newsqa-data-v1.zip下载,问题是NewsQA里没有上下文(story),只有storyid,因为story的版权不在微软,在CNN,那个要翻墙(https://cs.nyu.edu/~kcho/DMQA/),给翻不了墙的留个门cnn_stories&&dailymail_stories.7z

然后就是昨晚复旦大学对话机器人MOSS,我是真的服了,第一次看到这么能蹭热度的,哗众取宠,还同时蹭两个。国内最先能接近chatGPT的模型肯定不可能是高校首先发布,如果能做出来一定是BAT,学校再有钱也不可能这么去烧。

20230222~20230224

- 周三订酒店,锡马也就上周日才官宣定档,两三天时间周边的酒店预定就已全部售罄,最后好不容易抢到一个距离起点2km以内的,还只剩一个家庭房。毕竟算是疫情后的第一场高规格赛事,可见一斑。

- 这周基本上每天都有5km的量,但是想要从突破到10km依然十分困难,最后三周,尽力而为罢。

SQuAD process:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import json

import pandas

from setting import (SQuAD_JSON_PATH_SUMMARY,

SQuAD_ARTICLE_PATH,

SQuAD_QUESTION_PATH,

)

def SQuAD_to_csv(article_export_path=SQuAD_ARTICLE_PATH, question_export_path=SQuAD_QUESTION_PATH):

article_dict = {'article_id' : list(),

'title' : list(),

'article' : list(),

'type' : list(),

'version' : list(),

}

question_dict = {'question_id' : list(),

'article_id' : list(),

'question' : list(),

'answers' : list(),

'answer_starts' : list(),

'answer_ends' : list(),

'type' : list(),

'version' : list(),

}

for key, data_path in SQuAD_JSON_PATH_SUMMARY.items():

type_, version = key.split('-')

with open(data_path, 'r', encoding='utf8') as f:

data = json.load(f)

count = -1

for sample in data['data']:

title = sample['title']

paragraphs = sample['paragraphs']

for paragraph in paragraphs:

count += 1

article_id = f'{type_}-{version}-{str(count).zfill(5)}'

article = paragraph['context']

for question_and_answer in paragraph['qas']:

question_id = question_and_answer['id']

question = question_and_answer['question']

candidate_answers = question_and_answer['answers']

answer_starts = list()

answer_ends = list()

answers = list()

for candidate_answer in candidate_answers:

answer_start = int(candidate_answer['answer_start'])

answer = candidate_answer['text']

answer_end = answer_start + len(answer)

# assert answer == article[answer_start: answer_end]

answer_starts.append(answer_start)

answer_ends.append(answer_end)

answers.append(answer)

# Write question Dictionary

question_dict['question_id'].append(question_id)

question_dict['article_id'].append(article_id)

question_dict['question'].append(question)

question_dict['answers'].append(answers)

question_dict['answer_starts'].append(answer_starts)

question_dict['answer_ends'].append(answer_ends)

question_dict['type'].append(type_)

question_dict['version'].append(version)

# Write article dictionary

article_dict['article_id'].append(article_id)

article_dict['title'].append(title)

article_dict['article'].append(article)

article_dict['type'].append(type_)

article_dict['version'].append(version)

# Convert to dataframe

article_dataframe = pandas.DataFrame(article_dict, columns=list(article_dict.keys()))

question_dataframe = pandas.DataFrame(question_dict, columns=list(question_dict.keys()))

# Export dataframe

article_dataframe = article_dataframe[['article_id', 'title', 'article', 'type', 'version']]

question_dataframe = question_dataframe[['question_id', 'article_id', 'question', 'answers', 'answer_starts', 'answer_ends', 'type', 'version']]

if article_export_path is not None:

article_dataframe.to_csv(article_export_path, sep='\t', header=True, index=False)

if question_export_path is not None:

question_dataframe.to_csv(question_export_path, sep='\t', header=True, index=False)

return article_dataframe, question_dataframe

20230225~20230226

- 下午绝好天气,3000米跑到11’55",感觉已经恢复到八九成(之前3000米最快能跑到11’40"以内,不过恢复两周能跑进12分钟也并无不满)。我感觉状态绝佳的情况下已经有能力冲击10km(只是今天碰到卢星雨和黄懿嘉在跑间歇,跑得太快,节奏给搞得有点崩),感觉还是很可期的,下周如能继续保持强度与状态,有信心下个周末就能把10km跑进43分钟,然后最后两周拉体能,直到19号能达到半马水平。

- 浪潮发布了源1.0大型中文模型,目前准备开源其训练语料,已经毕业的师兄王明回来准备以组的名义去申请数据,顺便找我们几个小咸鱼搞些合作,确是极好的。王明在阿里也在搞它们的chatGPT,我跟他说现在chatGPT做的这么好,我们这些底层科研狗真的很难实现模型性能上的创新,只能在方法论上做一些横向突破。王明说他也不指望国内短期能做到chatGPT的水平,至少阿里目前确实没有这个水平。这就是现实,别人确实是做到了我们做不到的事情,有时候真的不服不行,而且这行是很可怕的,一旦chatGPT真正投入商用,国内无法跟进脚步,用户群体被垄断后,这个差距就会被进一步拉大,chatGPT会以更加恐怖的速度积累语料训练并不断完善模型,到时候真的很难想象国内到底还有没有机会赶上chatGPT的步伐。我有一种隐隐地感觉,最坏的情况下,chatGPT将会在不久的将来彻底垄断NLP研究领域,因为再也没有机构能在数据积累和模型规模上超越chatGPT,除非天降猛男开辟出一个全新的高效模型训练框架,打破目前这种研究开发的范式,否则确实是一件让人,搞不好大家长又会彻底墙掉chatGPT,来保护国内的资源发展。

吊命的异步下载(拒绝吸血雷):

#coding:utf-8

import asyncio

import sys

import time

import os

import cgi

import re

from urllib import parse

from urllib.parse import urlparse, unquote_plus

file_name_pattern = re.compile(r"utf|UTF-8'\s+'")

import aiohttp

def get_file_name(content_disposition):

_, params = cgi.parse_header(content_disposition)

if "filename" in params:

return params["filename"]

elif "FILENAME" in params:

return params["FILENAME"]

elif "filename*" in params:

return re.split("utf-8'\s+'", params['filename*'], 1, flags=re.IGNORECASE)[1]

elif "FILENAME*" in params:

return re.split("utf-8'\s+'", params['FILENAME*'], 1, flags=re.IGNORECASE)[1]

else:

return None

async def fetch(session, url, startpos, endpos, filename):

headers = {

"Range":"bytes=%s-%s"%(startpos,endpos),

"accept":"text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8",

"accept-encoding":"gzip, deflate, br",

"accept-language":"zh-CN,zh;q=0.9",

"upgrade-insecure-requests":"1",

"user-agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.81 Safari/537.36",

}

print("fetch...", startpos, endpos)

async with session.get(url, headers=headers) as response:

with open(filename, 'rb+') as fd:

fd.seek(startpos)

while True:

chunk = await response.content.read(1024)

if not chunk:

break

fd.write(chunk)

async def main(url, thread_num):

#获取文件的大小和文件名

urlobj = urlparse(url)

filename = ""

start = 0

end = -1

step = 0

tasks = []

headers = {

"accept":"text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8",

"accept-encoding":"gzip, deflate, br",

"accept-language":"zh-CN,zh;q=0.9",

"upgrade-insecure-requests":"1",

"user-agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.81 Safari/537.36",

}

#https://www.cnblogs.com/momoxingchen/p/6493317.html

async with aiohttp.ClientSession() as session:

async with session.head(url, headers=headers) as response:

headers_content = response.headers

print("headers_content", headers_content)

if "Content-Length" not in headers_content:

raise Exception("can't get file size")

filename = urlobj.path.rsplit('/',1)[1]

if 'Content-Disposition' in headers_content:

tmp_file_name = get_file_name(headers_content["Content-Disposition"])

if tmp_file_name is not None and tmp_file_name:

filename = tmp_file_name

filesize = int(headers_content["Content-Length"])

step = filesize // thread_num

print("%s filesize:%s"%(filename,filesize))

with open(filename,'w') as tempf:

tempf.seek(0)

tempf.write("hello")

async with aiohttp.ClientSession() as session:

while end < filesize -1:

start = end +1

end = start + step -1

print("start:end:", start,end)

if end > filesize:

end = filesize

task = asyncio.ensure_future(fetch(session,url,start, end, filename))

tasks.append(task)

await asyncio.gather(*tasks)

if __name__ == "__main__":

url = "https://rajpurkar.github.io/SQuAD-explorer/dataset/train-v2.0.json"

loop = asyncio.get_event_loop()

loop.run_until_complete(main(url, 2))

20230227

- 晚上跟王英林吃了个饭,最近很多事情要跟他当面汇报一下才清楚。明天韩明月预答辩,有一个师姐要离我而去了,她毕业之后我就真的成了组里的老大头,可是依然有所迷惑。实话说明月姐运气确实很好,讲道理那篇ACL我仔细看过,质量不算很高,但是就是被接收了,然后就一篇CCF-A直接定乾坤,其他三篇都是特别水的凑数。但是即便如此她硕士阶段和博士阶段各拿了一次国奖,实力也是强的离谱,反正我这届硕博没有一个人在硕士阶段拿过国奖(因为都被金工的scx和dyt给拿捏了,怎么说硕士阶段我也是硕博这边的综评第一,真是难受)。而且我也看了她的论文初稿,131页,工作量比胡振达要小不少,但是最后两页纸的致谢确是真情流露,人的实力和运气都很重要。

- 晚上3km慢跑,穿羽绒服和老重老重的板鞋跟着lxy和hyj,她俩是真的能跑,估计有15圈,还是外道。权且休整状态,一想到明月姐和胡振达都那么强,我也确不能辱没师门呐,留给我的时间真的不多了。

# -*- coding: UTF-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import os

import time

import urllib

import requests

import traceback

from tqdm import tqdm

from multiprocessing import Process, Pool, Manager, cpu_count

class Downloader(object):

def __init__(self) -> None:

pass

def multi_processing_download(self, url: str, n_process: int=None) -> None:

"""

Download file with multiprocessing.

:param url : The URL of the resource needed to download.

:param n_process: Total number of processes in pool.

"""

if n_process is None:

n_process = cpu_count() - 1

parse_result = urllib.parse.urlparse(url)

filename = parse_result.path.rsplit('/', 1)[1]

headers = requests.head(url).headers

filesize = int(headers.get('Content-Length', None))

manager = Manager()

queue = manager.Queue(10000)

process = Process(target=self._display_download_speed, args=(filesize, queue))

start = 0

end = -1

with open(filename, 'w') as f:

f.seek(0)

pool = Pool(processes=n_process)

step = filesize // n_process

print('Step: {}'.format(step))

while end < filesize - 1:

start = end + 1

end = start + step -1

print('start: {} - end: {}'.format(start, end))

if end > filesize:

end = filesize

pool.apply_async(self._partially_download, args=(url, start, end, filename, queue))

pool.close()

process.start()

pool.join()

process.join()

print('Process join done')

def multi_threading_download(self, url: str) -> None:

pass

def _display_download_speed(self, filesize, queue):

write_size = 0

print('Check download speed')

while True:

speed = 0

current_timestamp = time.time()

while not queue.empty():

item = queue.get(True)

size = item.get('size', 0)

timestamp = item.get('timestamp', current_timestamp - 10000)

write_size += size

if current_timestamp - timestamp > 1:

break

speed += size

ratio = write_size / filesize

try:

self._display_process(ratio, speed)

except:

pass

def _display_process(self, ratio: float, speed: float, n_bar: int=100) -> None:

end_char = '\r'

if ratio >= 1:

end_char = '\n'

bar_number = 100

done_number = round(ratio * bar_number)

done_char = '#' * done_number

remain_char = '-' * (bar_number - done_number)

process_bar = '[{done_char}{remain_char}] {percentage}% speed:{speed}'.format(

done_char=done_char,

remain_char=remain_char,

percentage='%0.2f' % (ratio * 100),

speed=speed,

)

print(process_bar, end=end_char)

def _partially_download(self, url, start_position, end_position, filename, queue) -> None:

try:

with open(filename, 'rb+') as f:

print('Start downloading****')

headers = {'Range': 'bytes=%s-%s' % (start_position, end_position)}

response = requests.get(url, headers=headers, stream=True)

f.seek(startpos)

for data in response.iter_content(chunk_size=1024):

f.write(data)

queue.put({'timestamp': time.time(), 'size':len(data)})

except Exception as e:

print('download error', e)

traceback.print_exc()

if __name__ == '__main__':

d = Downloader()

url = 'https://web.stanford.edu/~hastie/CASI_files/PDF/casi.pdf'

url = '"https://codeload.github.com/lrs1353281004/CS224n_winter2019_notes_and_assignments/zip/refs/heads/master.zip"'

# d.multi_processing_download(url)

d.multi_processing_download(url, 4)

20230228

- 昨晚又是开会到十点半,这周极限冲刺,7号前要把NFSC初稿弄出来,头大。

- 下午把浪潮的申请签好盖章寄掉,时间太晚还是去操场混了二十分钟训练,其实已是末尾冷身,我顺带着跟陈嘉伟晃了四圈顺带热身。嘉伟终于还是被一个寒假给干倒了,嘉伟说他一个寒假没动,前几天跑了个2km就躺了几天,这样的从低谷慢慢恢复的痛苦我已经经历过N多次。暑假相对来说要好一些,但是过年要坚持每天训练,你自己能坚持得下来,家人也不会让你这么去像个神经病在路上狂奔,还要承受别人异样的目光。

- 今天状态跟预估有差距,可能是跑前跑后费了些力气,而且热身的时候跟嘉伟跑得太快,后来4分配跑了2km就直接垮掉,补了一个800米,感觉这周要能上10km挺悬,然时不我待,只剩不到20天了。

Census X12和X13调整需要使用美国统计局已封装号的X12a.exe和X13AS.EXE二进制程序,找了半天只有CSDN上有个资源比较靠谱一些,里面提供了测试代码和两个可执行程序(https://download.csdn.net/download/zhouhao707/12717511?spm=1001.2101.3001.5697)

然鹅需要积分,但是我已经传到盘里了,有需求自取:

https://pan.baidu.com/s/1hDWVXeGp6ovTsLq2i0Dvgg?pwd=957n

另外我做了一个测试程序:

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

import numpy as np

import pandas as pd

from datetime import datetime

from X12a_X13as import X12a, X13as

a = X13as() # 调用这个类的方法

# 随机造了一组数据dataframe, dataframe的index必须是日期格是

df = pd.DataFrame({'data': np.random.random(36)})

df.index = [datetime(2020, i, 1) for i in range(1, 13)] + [datetime(2021, i, 1) for i in range(1, 13)] + [datetime(2022, i, 1) for i in range(1, 13)]

result = a.x13(df)

for k, v in result.items():

print(k, v)

调整后的序列有三个,虽然不是很懂是什么意思(给凯爹做的)。

20230301

- 状态又很迷,下午慢跑10圈都感觉吃力,可能是跟gjw边跑边说话的缘故,我发现不管我用多少配速跑(虽然再慢也不会掉出5分配),时间长了心率都要到170以上,像很多人慢跑心率都能控到150以下。其实就是跑量太少,听说跑量过10000km心率才会有明显降低,现在连5000km都不到。

- 从2月13日恢复训练起算,距离3月19号前只有33个训练日,到目前已经是17个训练日,过半,但跑万米的把握都不到三成,这周虽然很push,但也得设法抽出时间试跑一次万米了,不然真的来不及了。

因果推断遐想(二):

明月姐的预答辩如预期一般的通过了,其实五个老师一个都不懂因果推断,所以基本都是听得云里雾里,牛B哄哄的崔万云都没提一点有意义的建议,只是说因果推断似乎是实验室研究,现实世界是行不通的。诚然如是,但是不可否认的是目前的确因果推断在工业界也是有应用的。我认为因果推断如果想要做出实际意义,那就得做出和知识图谱一般的因果图谱,然而因果图谱要比知识图谱复杂得多,目前的因果图都是确定的有向边,其实现实世界哪有那么多绝对呢?所以因果图理论上应该是概率边,但是如果是概率边,似乎就要破坏目前因果推断的理论基石(do算子、后门调整、前门调整之类的)。

一种主题干预的后门调整情感分析示意图,我改了个超科幻的自动混杂生成的设想图,反正是写本子,天马行空了:

—

—

20230302

- 晚上训练陈嘉伟陪跑,成功恢复到场地万米,节奏很好,有人一起跑动力十足。用时42’22",均配4’14"。前5000米我领跑,用时21’09",后5000米换嘉伟领跑,用时21’13",说到底男人的话一个标点都不能信,嘉伟说他一个寒假没动,现在耐力垮得很,所以这就是指就是轻松跑完10km,又做了100个俯卧撑,最后还补了7圈追逐跑(其实我跑完也不是很累,但是追逐跑了5圈就不想坚持了,这种节奏稳定的万米跑完确实超级享受)。

- 今晚很冷,其实并不适合跑,本来下午阳光明媚,但是我又很想等训练时一起跑,所以下午只是养生晃了三圈,等到晚上跟嘉伟尽兴一下。现在距离锡马开赛还有16天,14个训练日,只要能保持这个状态,跑进95分钟应该是绰绰有余,就看能否稳中求进冲击90分钟大关了。

跟明月姐拉扯了一下午,来看看最终这版天马行空的架构图(难道混杂未知就是你虚空索敌的理由???

20230303~20230304

- 下午训练,状态极佳本以为可以轻松拿下八组400米间歇,结果前两组跑完从臀部到大腿就已经麻得站都站不稳。第一组1’10",第二组1’13",然后就痛苦到死,站着难受,坐着更难受,接着两组掉到1’20",纯靠一丝意志在冲刺,四组跑完所有人都瘫倒在地,再起不能。时隔三个多月,再次被死亡400打回原形。

- 3月11日高百资格赛将在武东田径场进行,这也是疫情后校友们第一次返回学校参赛,作为锡马前的一次热身是再好不过。

关于虚假线索与因果特征的识别,可以基于特征的域适应差异性来进行区分:

20230305~20230306

- 下午计划慢跑十圈,结果刚进场就看到宋镇均在练1000米间歇。上学期十月yq爆发后他就离校一直未归,我以为他真又废了,这学期刚来时我问他多久没跑,他说二月还是练了几次,结果前天400米间歇先是给我一个下马威,今天进场看他的速度还以为是在跑第一个1000米,跑完他告诉这已经是第4个了。我直接震惊了,当即说最后一个我来带他跑,顺便胜之不武地拿捏一下他。尽管我是穿长袖长裤来准备慢跑,但第一圈还是带到3’40"以内的配速,我看他似乎有点不支,于心不忍还是故意放慢等了他一下,结果这年轻人不讲武德,第二圈到一半就把我超了,还真就一直追不上,给我整不会了。

- 后来补了3000米慢跑,气温太高,而且右脚踝隐隐作痛,大约是前天间歇跑得太猛的缘故。明天下午的训练大概率是5×1000米间歇,由于近期已经在为锡马作准备,尽可能地早睡早起,自我感觉状态很好,跑起来却相当吃力(一方面可能是气温太高的原因),但总是觉得很悬的了。

其实变分自编码器是个很理想地产物,反正我觉得实际应用上很难很难用,一个是假设太强,理论上可以进行运用,但是不可能用于实际产品。

最近看孙健老师对一个经典命题的证明,即证明 2 + 3 + 5 + . . . + p \sqrt{2}+\sqrt{3}+\sqrt{5}+...+\sqrt{p} 2+3+5+...+p,对于任意素数 p p p,都不是有理数。

当然其实直接证明 ∑ i = 0 n i \sum_{i=0}^n\sqrt{i} ∑i=0ni不是有理数也是一样的。

这里有一个很巧妙的证法,就是定义这样一个多项式:

f ( x ) = ∏ ( x ± 3 ± . . . ± p ) f(x)=\prod (x\pm{\sqrt{3}\pm...\pm\sqrt{p}}) f(x)=∏(x±3±...±p)

令:

r

=

2

+

3

+

5

+

.

.

.

+

p

r = \sqrt{2}+\sqrt{3}+\sqrt{5}+...+\sqrt{p}

r=2+3+5+...+p

那么 f ( r − 2 ) f(r-\sqrt{2}) f(r−2)显然等于零(因为 r r r是 f ( x ) f(x) f(x)的一个零点)

如果 r r r是一个有理数,那么 r + 2 r+\sqrt{2} r+2是 r − 2 r-\sqrt{2} r−2的一个共轭根,即 f ( r + 2 ) f(r+\sqrt{2}) f(r+2)也是零,但是显然 f ( r + 2 ) > 0 f(r+\sqrt{2})>0 f(r+2)>0(因为 f ( x ) f(x) f(x)里每一项都是正数)。

确实很精妙,但是事实上这个用Galois或者伽罗瓦理论可以直接证明,我这辈子是学不到高等代数里面的数域和群论了,总觉得这辈子数学可能也就学到现在这个水平为止了唉,好难过。

20230307

- 今天并没有跑1000米间歇,东哥让我们弹力带拉了100个引体(我是真废,用最粗的弹力带,拉10个都费事,细一个档次的就完全拉上不去),然后连续跳栏10组,最后接7圈变速+7圈追逐。7圈变速我强行跟住了陈嘉伟(感觉嘉伟确实状态距离巅峰差太多了,放以前不可能让我跟这么轻松),快圈1’20",慢圈1’50",成功套其他四人各一圈,东哥说我最近状态挺好,那可不是么,想要跑半马,当然得保持状态。

- 分手见人品,我说廖是深咋这么久都不来训练,原来是跟李婷玉分了。说实话我是觉得姐弟恋不靠谱,尤其是女博士,男生多少是有一些支配欲的,双方阅历都不是一个层面的,更不要说廖本科都还没毕业,能不能上岸都不靠谱。但是廖在pyq里话说的实在是太难听,摆明了要把对方名声搞臭,对错不论,也不至于恶化到这种程度,男生总归还是要大气一点。

关于引入混杂表示生成的文本分类模型去混杂,想了一个目标二的具体显式表示:

L 2 = ∑ i = 0 c d i f f ( { H t } t : y t = i ) − ∑ 0 ≤ i < j ≤ c d i f f ( { H t } t : y t = i ∪ { H t } t : y t = j ) L_2=\sum_{i=0}^{c}diff\left(\{H_t\}_{t:y_t=i}\right)-\sum_{0\le i<j\le c} d i f f\left(\{H_t\}_{t:y_t=i}\cup\{H_t\}_{t:y_t=j}\right) L2=i=0∑cdiff({Ht}t:yt=i)−0≤i<j≤c∑diff({Ht}t:yt=i∪{Ht}t:yt=j)

这里为了使得学习到的混杂表示能够影响样本标签,因此考虑从聚类角度出发,使得标签相同的样本对应的混杂隐层表示的差异性尽可能小,而样本标签不同的样本对应的混杂隐层表示的差异性尽可能大。从而确保混杂隐层表示与预测标签地强关联性。 d i f f diff diff是预先设置好的一个表示差异化程度的函数。

20230308

- 扬州鉴真国际半程马拉松报名开始,两万人,4月16日开赛。虽说计划是锡马后跑步训练告一段落,但是扬马毕竟是家门口的比赛,也是我最希望参加的比赛。查了一下2019年的市民组成绩,1小时25分进前10,1小时30分进前30,1小时35分进前50,可惜今年只奖励前10,就目前我的水平,稳进135,但130需要极好的状态,125几乎不可能完成,所以想拿奖金难度极大。不过反正报名抽签不要钱,就碰个运气呗,抽中血钻,就当是圆梦了。抽不中就一心一意搞论文咯。

- 晚上wyl又开会到十点半,明月姐天高皇帝远,于是我跟黄名媛两个倒霉蛋跟wyl拉扯了近四个小时。本来今天想好好休息休息,昨天练引体和跳栏,今天背和腰都疼得不行,下午慢跑10圈保持状态,然后网上这么一出,明明ddl还有好几天,真是push起来就不当人。

关于基于软提示的生成。其实目前就硬提示而言,总觉得没什么研究价值,就一帮人在哪儿给PLM喂模板吃,模板不好就改,模板好就发文章,一点意思没有,纯纯的工程项目。但是软提示的确还是挺有趣的,下面是本次申报做的一个反事实增强的生成框架,提示的好处感觉是可以大大缩小训练量,当然代价是需要大模型,因为大模型的参数是freeze的,本质上是在学一个好的提示向量表示。

20230309

- 揠苗助长,状态终归还是一个周期性的数值,虽然这几天感觉饮食作息都ok,晚上计划要跑15km,然后晚饭吃特别多,结果两个多小时没能消化完,五点吃完到七点半都撑得厉害,跑了5km就歇菜了(陈嘉伟有事没来,也有点缺乏动力,本来晚上的状态就稍差些)。随队练了两组蛙跳,然后箭步跳4×60个,做完我就知道明天大腿肯定废了,不过这两天在赶工,下午跟黄名媛又给wyl关了半天牢,11号到晚必须要把稿子修好,万一废了干脆休两天拉倒。我总是觉得赛前至少要拉一个15km,否则至少从心理上来说会有些动摇,但我又不想到临近比赛太过度训练,所以很想这周能把15km给跑掉,还是太急了,但毕竟是首马,总是想以万全的状态去迎战。

- 葛智杰和卢星雨两个倒霉蛋,前天居然食物中毒,据说是吃了新园的啥团子,急性肠胃炎连带发烧,不得不花了大几百去长海吊水,然后今晚又来卷,结果葛智杰直接被卢星雨带崩了,太丢人啦。

关于python字符串输出的几个小技巧:

n = int(input('输入奇数n:'))

if n % 2 == 0:

n = int(input('输入奇数n:'))

m = (n + 1) // 2

string_formatter = '{:^' + str(n + 2) + '}'

for i in range(m + 1):

print(string_formatter.format('*' * (2 * i + 1)))

比如'{:^9}'.format('*')就是划出一个长度为9的空当,然后把*插在中间。

但是如果想要把9替换成任意的n,就得写成上面string_formatter = '{:^' + str(n + 2) + '}'的形式。

20230310~20230311

- 状态低迷的两日,昨天起初大腿还不是很酸,下午硬撑着晃了10圈,就已经站不起来了。

- 今天ddl,决定翘了训练,稿子还没整完,大概率也溜不掉,索性跑休一日。明天降温,也是锡马最后一周倒计时,就是拼了老命,也必须拉一次长距离。

HRCA复现

# -*- coding: utf-8 -*-

# @author: caoyang

# @email: caoyang@163.sufe.edu.cn

# Implementation of HRCA

import torch

from torch.nn import Module, Linear, NLLLoss, functional as F

from setting import DEVICE

from src.tool.pretrained_model_tool import load_transformer_model

from src.module.attention_module import MultiHeadAttention

class HRCA(Module):

"""Forward propagation algorithm of HRCA and HRCA+

Reference: [HRCA+: Advanced Multiple-choice Machine Reading Comprehension Method](www.lrec-conf.org/proceedings/lrec2022/pdf/2022.lrec-1.651.pdf)

- Input:

- $P \in \R^{d×p}$

- $Q \in \R^{d×q}$

- $A = \{A_1, ..., A_m\}, A_j \in \R^{d×a}$

- Output:

- $L \in \R^m$"""

loss_function = NLLLoss()

def __init__(self, args):

super(HRCA, self).__init__()

self.p = args.max_article_token

self.q = args.max_question_token

self.a = args.max_option_token

self.m = args.n_choices

self.l = args.hrca_encoding_size

self.k = args.hrca_num_layers

self.fuse_method = args.hrca_fuse_method

self.plus = args.hrca_plus

self.multi_head_attention = MultiHeadAttention(d_model=args.hrca_encoding_size, num_heads=args.hrca_mha_num_heads, dropout_rate=args.hrca_mha_dropout_rate)

self.fuse_linear_x = Linear(self.l, self.l, bias=True)

self.fuse_linear_y = Linear(self.l, self.l, bias=True)

self.fuse_linear_z = Linear(self.l, self.l, bias=True)

if self.fuse_method in ['mul', 'sum']:

self.W = Linear(self.l, 1, bias=False)

elif self.fuse_method == 'cat':

self.W = Linear(3 * self.l, 1, bias=False)

else:

raise Exception(f'Unknown fuse method: {self.fuse_method}')

if args.load_pretrained_model_in_module:

self.pretrained_model = load_transformer_model(model_name=args.hrca_pretrained_model, device=args.pretrained_model_device)

self.pretrained_model.eval()

else:

self.pretrained_model = None

# @param P : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size, max_article_token)

# @param Q : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size, max_question_token)

# @param A : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size * N_CHOICES, max_option_token)

def forward(self, P, Q, A, pretrained_model=None):

E_P, E_Q, E_A = self.contextualized_encoding(P, Q, A, pretrained_model=pretrained_model)

O = self.human_reading_comprehension_attention(E_P, E_Q, E_A) # O : (batch_size, N_CHOICES, ?)

L_unactived = self.W(O).squeeze(-1) # L_unactived : (batch_size, N_CHOICES)

L = F.log_softmax(L_unactived, dim=-1) # L : (batch_size, N_CHOICES)

return L

# @param P : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size, max_article_token)

# @param Q : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size, max_question_token)

# @param A : {'input_ids': tensor, 'token_type_ids': tensor, 'attention_mask': tensor}, tensor(batch_size * N_CHOICES, max_option_token)

# @return E_P : (batch_size, N_CHOICES, max_article_token, hrca_encoding_size)

# @return E_Q : (batch_size, N_CHOICES, max_question_token, hrca_encoding_size)

# @return E_A : (batch_size, N_CHOICES, max_option_token, hrca_encoding_size)

def contextualized_encoding(self, P, Q, A, pretrained_model=None):

batch_size = P['input_ids'].size(0)

size_of_split_choice = (batch_size, self.m, self.a)

A['input_ids'] = A['input_ids'].view(*size_of_split_choice)

A['token_type_ids'] = A['token_type_ids'].view(*size_of_split_choice)

A['attention_mask'] = A['input_ids'].view(*size_of_split_choice)

E_list = list()

for i in range(self.m):

concat_inputs = {'input_ids' : torch.cat([P['input_ids'], Q['input_ids'], A['input_ids'][:, i, :]], axis=-1), # (batch_size, max_article_token + max_question_token + max_option_token)

'token_type_ids' : torch.cat([P['token_type_ids'], Q['token_type_ids'], A['token_type_ids'][:, i, :]], axis=-1), # (batch_size, max_article_token + max_question_token + max_option_token)

'attention_mask' : torch.cat([P['attention_mask'], Q['attention_mask'], A['attention_mask'][:, i, :]], axis=-1), # (batch_size, max_article_token + max_question_token + max_option_token)

}

E_list.append(pretrained_model(**concat_inputs).last_hidden_state.unsqueeze(1) if self.pretrained_model is None else self.pretrained_model(**concat_inputs).last_hidden_state.unsqueeze(1))

E = torch.cat(E_list, axis=1) # E : (batch_size, N_CHOICES, max_article_token + max_question_token + max_option_token, hrca_encoding_size)

E_P = E[:, :, :self.p, :] # E_P : (batch_size, N_CHOICES, max_article_token, hrca_encoding_size)

E_Q = E[:, :, self.p:self.p+self.q, :] # E_Q : (batch_size, N_CHOICES, max_question_token, hrca_encoding_size)

E_A = E[:, :, self.p+self.q:, :] # E_A : (batch_size, N_CHOICES, max_option_token, hrca_encoding_size)

return E_P.to(DEVICE), E_Q.to(DEVICE), E_A.to(DEVICE)

# @param E_P: (batch_size, N_CHOICES, max_article_token, hrca_encoding_size)

# @param E_Q: (batch_size, N_CHOICES, max_question_token, hrca_encoding_size)

# @param E_A: (batch_size, N_CHOICES, max_option_token, hrca_encoding_size)

# @return O : (batch_size, N_CHOICES, ?) where ? could be hrca_encoding_size or 3 * hrca_encoding_size

def human_reading_comprehension_attention(self, E_P, E_Q, E_A):

O_list = list()

for i in range(self.m):

E_P_U, E_Q_U, E_A_U = self._hrca(E_P[:, i, :, :], E_Q[:, i, :, :], E_A[:, i, :, :])

if self.k > 1:

# Stack k layers

for _ in range(self.k - 1):

E_P_U, E_Q_U, E_A_U = self._hrca(E_P_U, E_Q_U, E_A_U)

O_i = self._fuse(E_P_U, E_Q_U, E_A_U) # O_i : (batch_size, ?)

O_list.append(O_i.unsqueeze(1))

O = torch.cat(O_list, axis=1) # O : (batch_size, N_CHOICES, ?)

return O

# @param E_P_U : (batch_size, max_article_token, hrca_encoding_size)

# @param E_Q_U : (batch_size, max_question_token, hrca_encoding_size)

# @param E_A_U : (batch_size, max_option_token, hrca_encoding_size)

# @return E_P_U : (batch_size, max_article_token, hrca_encoding_size)

# @return E_Q_U : (batch_size, max_question_token, hrca_encoding_size)

# @return E_A_U : (batch_size, max_option_token, hrca_encoding_size)

def _hrca(self, E_P_U, E_Q_U, E_A_U):

if self.plus:

# HRCA: Q2Q -> O2Q -> P2O

E_Q_U = self.multi_head_attention(queries=E_Q_U, keys=E_Q_U, values=E_Q_U) # E_Q_U: (batch_size, max_question_token, hrca_encoding_size)

E_A_U = self.multi_head_attention(queries=E_A_U, keys=E_Q_U, values=E_Q_U) # E_A_U: (batch_size, max_option_token, hrca_encoding_size)

E_P_U = self.multi_head_attention(queries=E_P_U, keys=E_A_U, values=E_A_U) # E_P_U: (batch_size, max_article_token, hrca_encoding_size)

else:

# HRCA+: Q2Q -> Q2O -> O2O -> O2Q -> O2P -> Q2P -> P2P -> P2Q -> P2O

E_Q_U = self.multi_head_attention(queries=E_Q_U, keys=E_Q_U, values=E_Q_U) # E_Q_U: (batch_size, max_question_token, hrca_encoding_size)

E_Q_U = self.multi_head_attention(queries=E_Q_U, keys=E_A_U, values=E_A_U) # E_Q_U: (batch_size, max_question_token, hrca_encoding_size)

E_A_U = self.multi_head_attention(queries=E_A_U, keys=E_A_U, values=E_A_U) # E_A_U: (batch_size, max_option_token, hrca_encoding_size)

E_A_U = self.multi_head_attention(queries=E_A_U, keys=E_Q_U, values=E_Q_U) # E_A_U: (batch_size, max_option_token, hrca_encoding_size)

E_A_U = self.multi_head_attention(queries=E_A_U, keys=E_P_U, values=E_P_U) # E_A_U: (batch_size, max_option_token, hrca_encoding_size)

E_Q_U = self.multi_head_attention(queries=E_Q_U, keys=E_P_U, values=E_P_U) # E_Q_U: (batch_size, max_question_token, hrca_encoding_size)

E_P_U = self.multi_head_attention(queries=E_P_U, keys=E_P_U, values=E_P_U) # E_P_U: (batch_size, max_article_token, hrca_encoding_size)

E_P_U = self.multi_head_attention(queries=E_P_U, keys=E_Q_U, values=E_Q_U) # E_P_U: (batch_size, max_article_token, hrca_encoding_size)

E_P_U = self.multi_head_attention(queries=E_P_U, keys=E_A_U, values=E_A_U) # E_P_U: (batch_size, max_article_token, hrca_encoding_size)

return E_P_U, E_Q_U, E_A_U

# @param x : (batch_size, x_length, hrca_encoding_size)

# @param y : (batch_size, y_length, hrca_encoding_size)

# @param z : (batch_size, z_length, hrca_encoding_size)

# @return : (batch_size, ?) where ? could be hrca_encoding_size or 3 * hrca_encoding_size

def _fuse(self, x, y, z):

x_project = self.fuse_linear_x(x) # x_project : (batch_size, x_length, hrca_encoding_size)

y_project = self.fuse_linear_y(y) # y_project : (batch_size, y_length, hrca_encoding_size)

z_project = self.fuse_linear_z(z) # z_project : (batch_size, z_length, hrca_encoding_size)

x_project_pooled = torch.max(x_project, axis=1)[0] # x_project_pooled : (batch_size, hrca_encoding_size)

y_project_pooled = torch.max(y_project, axis=1)[0] # y_project_pooled : (batch_size, hrca_encoding_size)

z_project_pooled = torch.max(z_project, axis=1)[0] # z_project_pooled : (batch_size, hrca_encoding_size)

if self.fuse_method == 'mul':

return torch.sigmoid(x_project_pooled * y_project_pooled * z_project_pooled) # @return : (batch_size, hrca_encoding_size)

elif self.fuse_method == 'sum':

return torch.sigmoid(x_project_pooled + y_project_pooled + z_project_pooled) # @return : (batch_size, hrca_encoding_size)

elif self.fuse_method == 'cat':

return torch.sigmoid(torch.cat([x_project_pooled, y_project_pooled, z_project_pooled], axis=-1))# @return : (batch_size, 3 * hrca_encoding_size)

else:

raise Exception(f'Unknown fuse method: {self.fuse_method}')

20230312

- 昨天到晚状态跌落到极点,疲乏,虚汗,我甚至怀疑是不是要发烧,这一周五个工作日开了四次会,两次都是晚上开到十点半,昨天更是从早到晚,都没有抽出时间午睡。回去十点倒头就睡,早上六点半起,但是半夜醒了几次,似乎状态未能恢复几分。

- 结果今早寒潮降雨,但是我既然已经准备了今早起跑,补给都准备完毕,无论如何也不愿意就这么放弃,换上背心三分裤硬顶着5℃的寒风细雨,结果5000米就给我干废了。

- 下周日也是同样的时点起跑,无论如何我都想在今天能模拟一次比赛日的场景,所以天气再恶劣也要拼命去冲一次。如此的挫败让我大失所望,我甚至怀疑自己能否真的完赛。

- 最后一周,五个训练日,成败犹未可知。

torchvision.transforms.ToTensor

-

把一个取值范围是 [ 0 , 255 ] [0,255] [0,255]的

PIL.Image或者shape为 ( H , W , C ) (H,W,C) (H,W,C)的numpy.ndarray,转换成shape为 ( C , H , W ) (C,H,W) (C,H,W),取值范围是 [ 0 , 1.0 ] [0,1.0] [0,1.0]的torch.FloadTensor;- 注意会把

channel(大部分图片的channel都是在第三个维度,channel维度值一般为 3 3 3或 4 4 4, 即 R G B \rm RGB RGB或 R G B A \rm RGBA RGBA对应的维度提到了shape的最前面; - 注意该变换并不是直接转为张量, 对于 R G B \rm RGB RGB值的图片型的张量, 观察源码可发现会作除以 255 255 255的归一标准化;

- 不符合上述图片型张量的形式的张量(如输入二维矩阵), 将直接不作任何数值处理直接转为 t o r c h \rm torch torch中的张量;

- 注意会把

-

可以使用

torchvision.transforms.ToPILImage作逆变换, 这两个函数互为反函数;- 这是一个只针对

PIL.Image输入的反函数, 即必然乘以 255 255 255再返回成图片数据类型;

- 这是一个只针对

-

代码示例:

import cv2 import torchvision as tv # torchvision.transforms.ToTensor f = tv.transforms.ToTensor() numpy2tensor = f(np.array([[0, 1, 2, 3], [4, 5, 6, 7], [8, 9, 10, 11]])) image = cv2.imread(r'D:\media\image\wallpaper\1.jpg') image2tensor = f(image) print(numpy2tensor) print(image.shape) print(type(image2tensor)) print(image2tensor.shape) # torchvision.transforms.ToPILImage f1 = tv.transforms.ToTensor() f2 = tv.transforms.ToPILImage() image = cv2.imread(r'D:\media\image\wallpaper\1.jpg') image2tensor = f1(image) tensor2image = f2(image2tensor) print(type(tensor2image)) print(np.asarray(tensor2image))

torchvision.transforms.Normalize

-

这也是个很诡异的函数, 目前没有看出到底是怎么进行标准化的, 两个参数分别为

mean与std;- 我现在看明白了,其实是

x

:

=

(

x

−

mean

)

/

std

x:=(x-\text{mean})/\text{std}

x:=(x−mean)/std,这里的

mean和std是可以对应 c h a n n e l \rm channel channel数来写的

- 我现在看明白了,其实是

x

:

=

(

x

−

mean

)

/

std

x:=(x-\text{mean})/\text{std}

x:=(x−mean)/std,这里的

-

也只能对图片型张量进行处理

-

代码示例:

import torchvision as tv f1 = tv.transforms.ToTensor() f2 = tv.transforms.Normalize([.5], [.5]) image = cv2.imread(r'D:\media\image\wallpaper\1.jpg') image2tensor = f1(image) normal_tensor = f2(image2tensor) print(image.shape) print(image2tensor.shape) print(normal_tensor.shape)

20230313~20230314

- 昨天下午一点开会,又没能睡到午觉。四点补了两个绿豆糕进场。晴朗,10℃,无风,绝佳的天气,结果跑得异常笨重,完全没有两周前的那种轻盈感,将将5000米就顶不下去了,跑得我一头问号,就这臭水平还想把跑进130???太失望了。

- 后来还是冷静了下来,终是我对首马看得太重,谁又能一次就成功呢?急也没有用,现在做的也只有早睡早起,保证睡眠饮食,所以从昨晚起,11点半前必睡,7点起,中午补1小时觉。最后5天我终究不可能强行冲10km以上的长距离,以目前的体能来说,这样的强度后必然需要长时间恢复休息,然而我已经没有时间了。

- 所以今天下午我还是选择跟队练6×1000米间歇,第一组全力冲到3’23"(PB,之前最快到3’25"),仅次于陈嘉伟3’11",最后100米反超了专项练800米的徐瀚韬;后面几组就废了,二三两组掉到3’48"和3’50",第四组间歇了10分钟,又冲回到3’43",第五组摸鱼,最后一组全力冲到3’42",整体来看平均水平仍然不及去年12月(那时每组都能进3’45",而且头尾两组都能进3’30",其实今天还是最后三组陈嘉伟溜了,少了兔子确实很难顶住强度)。

- 给凯爹搞了台打印机,虽然有点笨重,但是男人之间送生日礼物还是实际点儿[偷笑]。

因果推断里面有个比较重要的点是作因果特征分析,其目的是剔出虚假关联。现在常用的一个策略是选取处置变量进行样本加权,来解决处置变量在整体数据中的不平衡问题。具体而言:

w ∗ = arg min i ∑ i = 1 K ∑ m = 1 M i ∥ 1 N 1 i ∑ j : T j i = 1 C m , j i ⋅ w j − 1 N 0 i ∑ j : T j i C m , j i ˆ ⋅ w j ∥ 2 2 w^*=\arg\min_i\sum_{i=1}^K\sum_{m=1}^{M_i}\left\|\frac1{N_1}^i\sum_{j:T_j^i=1}C_{m,j}^i\cdot w_j-\frac1{N_0^i}\sum_{j:T_j^i}C_{}m,j\^i\cdot w_j \right\|_2^2 w∗=argimini=1∑Km=1∑Mi N11ij:Tji=1∑Cm,ji⋅wj−N0i1j:Tji∑Cm,jiˆ⋅wj 22

对应到文本任务中,如果是特征工程类的模型,如one-hot编码的词特征, T j i = 1 T_j^i=1 Tji=1代表当前处置变量(词特征) T i T^i Ti出现在样本 j j j中; T j i = 0 T_j^i=0 Tji=0则代表 T i T^i Ti未出现在样本 j j j中; C m , j i C_{m,j}^i Cm,ji代表当前的处置特征 T i T^i Ti的第 m m m的混杂特征在第 j j j个样本中取值; N 1 i N_1^i N1i代表词特征 T i = 1 T^i=1 Ti=1的样本数目; N 0 i N_0^i N0i代表词特征 T i = 0 T^i=0 Ti=0的样本数目。

这里就衍生出一个推广问题,one-hot的词表示显然是太low了,有没有可能推广到一般的词向量。但是这很难,因为我们是可以解释one-hot词表示每一维的含义的(比如这里就是表示词袋的含义,词是否出现在样本中),但是一般的词向量就没有这种含义,那太过于抽象了,所以至少也是不能称为是样本加权。

其实如果熟悉Gensim里各种语言模型,比如TFIDF,LSI,HDF之类的,会发现除了TFIDF是从词袋模型(即one-hot)上进行计算得到新的词表示,LSI之类的都是在TFIDF的词表示上进一步计算,所以理论上来说是可以将上面这个加权方法推到(至少在)TFIDF这个层面上,此时我们说的因果特征和虚假特征就是非常抽象的概念了,可能是词表示的某几维,而事实上也有关于PLM输出的嵌入的每一维的具体表示含义的研究,即试图去解释词嵌入的每一维表示什么含义。

20230315

- 结果昨晚又被王英林关到十点半之后,刚坚持了两天早睡早起就又被迫破戒。完会跟黄名媛走了一路,因为都住三门路,我也不知道她是否单身,但我感觉练街舞的肯定交际圈很广。怎么说呢,确是喜欢的类型,圆滚滚的脸蛋儿,带些婴儿肥,笑起来直接眯成月牙,还是个川妹子(经常平翘舌不分),谁能不动心呢。可惜大概已经过了那个一见钟情的年纪,地域不同约莫也不会有啥结果。实际点儿cy,女人,只会影响你跑步的速度!

- 晚23:49,我想我可能真的是喜欢上了黄名媛,我对自己真的好失望好失望。今晚又是开会到23点之后(其实是开了一天),结束后我就莫名想等她一起走,在那儿等她跟王英林说了好久。昨晚还只是骑车半路碰到,今天我故意没有去拿车,就是想跟她一起走地下通道回三门路,就这么有些拘谨又有些欣喜地聊了一路。自从上一段已经过了整整两年,这对跑者来说并不是无法承受的孤独,但是当我心里开始有今晚这种念想时,回想以前又对sxy总有那些情愫,我觉得真的是差劲到顶了。

定义混杂:

- E E E与 D D D相关;以 D D D为条件时, E E E与 C C C相关, E E E不在 D D D到 C C C的因果关系路径中。则称 E E E是混杂因子

再说明条件独立和 D D D-分离的概念:

-

三种结构:

- 链式结构: A → B → C A\rightarrow B\rightarrow C A→B→C,在 A A A到 C C C的路径中, B B B称为中介变量。

- 叉式结构: A ← B → C A\leftarrow B\rightarrow C A←B→C,在 A A A到 C C C的路径中, B B B称为混杂变量。

- 对撞结构: A → B ← C A\rightarrow B\leftarrow C A→B←C,在 A A A到 C C C的路径中, B B B称为碰撞变量。

20230316

- 17号0:35,不写点儿心里难受得很。

- 喜提连续三日被王英林拷打到23点之后,昨晚一直到23:30才放人,不过我也是自愿的,王英林知道我要比赛并没有强留,但是我觉得留黄名媛一个人跟王英林对线实在是太残忍了(当然肯定还是有私情的缘故),事实上从结果来看如果我不去push王英林的进度,以他那龟速这本子指定是要流产了。反正我也是打着跟黄名媛一起回三门路的算盘,早睡?不存在的,状态就听天由命吧,反正锡马跑不好还有扬马可以跑,俺又中签了。

- 昨晚还是去队里训练了,因为明天下雨,后天就已经去无锡了,这是最后一练,我请陈嘉伟带我再冲最后一次10000米。我终于又找回了感觉,前5000米还是我带,因为体力充沛,嘉伟5000米过后超上来给我拉住配速,可惜第8个1000米带到了4’05",直接把我带崩了,最后是4’13"的均配跑完了8000米,停了一圈跟嘉伟把最后2000米冲完。我觉得至少八九成的状态是有的,不至于太悲观。

- 前天夜里失眠,很久不失眠了,上次可能还是两年前了,有心事就睡不着,到夜里1点半才睡着,凌晨5点半就醒了,后来就一直睡不着,干脆七点起床算了。

对于叉式结构,具体可以用公式表达:

-

首先根据 A ← B → C A\leftarrow B\rightarrow C A←B→C, p ( a , b , c ) = p ( a ∣ b ) p ( c ∣ b ) p ( b ) p(a,b,c)=p(a|b)p(c|b)p(b) p(a,b,c)=p(a∣b)p(c∣b)p(b)

-

我们求 p ( a , c ) p(a,c) p(a,c),如果 p ( a , c ) = p ( a ) p ( c ) p(a,c)=p(a)p(c) p(a,c)=p(a)p(c),则 A , C A,C A,C是在 B B B条件下独立分布:

-

若 B B B值不确定(未被观测),则:

p ( a , c ) = ∑ b p ( a ∣ b ) p ( c ∣ b ) p ( b ) p(a,c)=\sum_{b}p(a|b)p(c|b)p(b) p(a,c)=b∑p(a∣b)p(c∣b)p(b)

则 A , C A,C A,C不是在 B B B条件下独立分布。 -

若 B B B值确定,则可以知道 B B B取某个 b b b状态的概率为 p ( b ) p(b) p(b),则 b b b条件下 a , c a,c a,c发生的概率为:

p ( a , c ∣ b ) = p ( a , b , c ) p ( b ) = p ( a ∣ b ) p ( c ∣ b ) p(a,c|b)=\frac{p(a,b,c)}{p(b)}=p(a|b)p(c|b) p(a,c∣b)=p(b)p(a,b,c)=p(a∣b)p(c∣b)

满足条件独立。

-

20230317

- 疲乏的一天。昨晚十二点回寝,今早八点半又要出门。一直搞到下午五点,终于把破事给摆平了。但是我并不高兴,因为这意味着似乎也没啥机会再跟黄名媛有啥交集。本来临走时候想问她晚上要不要一起出去吃个饭啥的,毕竟一起忙活近一个月,但是发现她一直跟一个昵称叫Lu’minous的vx好友在聊天(其实我早就有注意到,因为我一直想搞清楚到底是不是单身),而且我也疲惫得很,计划晚上九点多就要睡,明早还要赶高铁。想想真的太猴急,搞不好人家是异地恋,同在屋檐下,以后组会也躲不了要见面,闹得怪尴尬的。

- 然后我发现今天二月廿四,sxy的农历生日。我之前是有想要不等她生日请她吃个饭,毕竟上学期结束一直欠着。但是今天肯定没指望,只能等到下周阳历生日看看情况,总觉得她最近看起来状态不是很好的样子。

- 总之罢了,万事且等锡马结束,为了满足自己那点小心思(真的很可爱呀,可能是我阅历少,但这么多年来能用可爱形容的女生还真不多),这周已经把我这身老骨头都快整散架了。说到底春天是荷尔蒙爆发的季节,多少春心萌动。过了就好,过了就好,谈毛恋爱,省点精力它不香嘛。

- 后来仔细研究了一下她的pyq,远比我想象的要精彩得多,确是异地恋,而且已经有几年了。散了散了,就当是一场梦呗,还好很快就醒了。

对于链式结构,具体可以用公式表达:

-

首先根据 A → B → C A\rightarrow B\rightarrow C A→B→C, p ( a , b , c ) = p ( a ) p ( b ∣ a ) p ( c ∣ b ) p(a,b,c)=p(a)p(b|a)p(c|b) p(a,b,c)=p(a)p(b∣a)p(c∣b)

-

分两种情况:

-

若 B B B值不确定(未被观测),则:

p ( a , c ) = p ( a ) ∑ b p ( b ∣ a ) p ( c ∣ b ) = p ( a ) p ( c ∣ a ) p(a,c)=p(a)\sum_{b}p(b|a)p(c|b)=p(a)p(c|a) p(a,c)=p(a)b∑p(b∣a)p(c∣b)=p(a)p(c∣a)

则 A , C A,C A,C不是在 B B B条件下独立分布。 -

若 B B B值确定:

p ( a , c ∣ b ) = p ( a , b , c ) p ( b ) = p ( a ) p ( b ∣ a ) p ( c ∣ b ) p ( b ) = p ( a ∣ b ) p ( c ∣ b ) p(a,c|b)=\frac{p(a,b,c)}{p(b)}=\frac{p(a)p(b|a)p(c|b)}{p(b)}=p(a|b)p(c|b) p(a,c∣b)=p(b)p(a,b,c)=p(b)p(a)p(b∣a)p(c∣b)=p(a∣b)p(c∣b)

满足条件独立

-

20230318

- 昨晚10点熄灯后心脏跳得厉害,锡马临近,也有因为窥探黄名媛pyq后的胃疼感。一直到快12点才着,5:30又醒,就再也睡不着了。到无锡后补了个下午觉,状态勉强回过来。短短半周失眠了两次,还是不同原因,也是服了我这老六。

- 人呐,总是要在理想与现实间分清界限与寻求平衡,一旦逾越便会自讨苦吃。至少我应该庆幸,这半个多月的高压时光有人陪伴,久违的心动让我很享受,但这并不属于我,当以等价的痛苦来偿还。

- 此页翻过。不管怎样,今天锡马报到的氛围真的太令人太兴奋啦,第一次有一种找到归属、那种跑者圣地的亲切感,许多严肃跑者,追求自己的极限。我本来立的FLAG是1:30:00,但又觉得太难,于是想到可以定1:31:40,均配刚好是4’20"/km,而且凑了个1314。

- 终于,在我第3年的跑步生涯,我即将正式站在马拉松赛道,非常非常激动。多天来我收到了许多田径队朋友以及其他好友的加油,我热爱跑步以及它为我所带来的快乐与满足,尽管我也失去了许多。愿明天我能跑出自己的水平,在半马首战不留遗憾地圆梦,这是首战,或许也是my last war

- 锡马,加油。

这首诗本是第一次失眠后作,现在看来似乎更适合第二次失眠后的心境吧。

《流年》山隐水迢雾朦胧,扁舟一叶探萍踪。

无言何复凭栏意?嫣然回笑花正浓。

一梦一醒一夜终,一叹一咏一枯荣。

歌且不思情何往,但托遗念于悲风。

20230319

- 昨晚只睡着了两个小时,一周失眠三天(昨晚单纯是兴奋),开跑时状态不佳,热身时明显感觉步伐沉重。但是气氛使然,勉强能有八九成气力,然而全浪费在前半程的变速穿插,前半程我跟打了鸡血似的,甚至飙出3’22"配速的分段,但是E组慢摇的人太多了,跟着跑是很轻松,但肯定出不了成绩。后半段明显乏力,但是总归还是成功完赛。

- 晚上回来后再不能顶住,真的要好好睡一觉了。

- 真的累了。

对于对撞结构,具体可以用公式表达:

-

首先根据 A → B ← C A\rightarrow B\leftarrow C A→B←C, p ( a , b , c ) = p ( a ) p ( c ) p ( b ∣ a , c ) p(a,b,c)=p(a)p(c)p(b|a,c) p(a,b,c)=p(a)p(c)p(b∣a,c)

-

同样分两种情况讨论:

-

若 B B B不确定(未观测),由于所有 p ( b ∣ a , c ) p(b|a,c) p(b∣a,c)相加和为一,所以 p ( a , c ) = p ( a ) p ( c ) p(a,c)=p(a)p(c) p(a,c)=p(a)p(c),即条件独立

-

否则 B B B给定,有:

p ( a , c ∣ b ) = p ( a , b , c ) p ( b ) = p ( a ) p ( c ) p ( b ∣ a , c ) p ( c ) p(a,c|b)=\frac{p(a,b,c)}{p(b)}=\frac{p(a)p(c)p(b|a,c)}{p(c)} p(a,c∣b)=p(b)p(a,b,c)=p(c)p(a)p(c)p(b∣a,c)

无法因式分解,因此不是条件独立。

-

20230320~20230321

- 19号晚上回来后再起不能,这可能是这辈子以来最累的一天,出去找了点吃的回来就洗洗睡了,从11点睡到早上8点,完全是自然醒,舒服得要死,中午回来又补了2小时,原地满血复活。

- 锡马净成绩1:42:07,跟预估差不多,半马人数8000,男子排名519,年龄段排名69,总排名601(算上女选手),排名差强人意,虽然比真实水平差了10分钟不止(稳进135,而且大概率能冲到130。142是三年前的水平)。

- 约了sxy,三年了。再不约,可能就…,唉。

使用matplotlib制作mp4或gif动图:

from matplotlib import animation

from IPython.display import HTML

from matplotlib import pyplot as plt

def display_frames_to_video(frames):

# figsize是以英寸为单位,dpi表示每英寸上多少个像素点

plt.figure(figsize=(frames[0].shape[0] / 72, frames[0].shape[1] / 72), dpi=72)

plt.axis('off')

patch = plt.imshow(frames[0])

def animate(i):

patch.set_data(frames[i])

anim = animation.FuncAnimation(plt.gcf(), animate, frames=range(len(frames)), interval=50)

# anim.save('cartpole.mp4')

anim.save('cartpole.gif', writer='imagemagick')

HTML(anim.to_jshtml())

display_frames_to_video(frames)

解释:fig是一开始定义好的图形对象(如plt.gcf()),关键是animate函数,这里的frames是一个列表,每个元素是一张RGB图像张量,这里只是简单的把每一帧给扔进patch,也有在一张静态图上不断移动一个点的写法:

import matplotlib.pyplot as plt

%matplotlib inline

line, = ax.plot([0.5], [2.5], marker='o', color='g', markersize=60)

from matplotlib import animation

from IPython.display import HTML

def init():

line.set_data([], [])

return (line, )

def animate(i):

state = state_history[i]

# 根据state确定点的移动坐标

x = state % 3 + 0.5

y = 2.5 - state // 3

line.set_data(x, y)

# 一秒5帧

anim = animation.FuncAnimation(fig, animate, init_func=init,

frames=len(state_history), interval=200, repeat=False)

anim.save('maze_0.gif', writer='imagemagick')

HTML(anim.to_jshtml())

HTML可以在notebook里做出类似播放器的效果。

20230322

- 阴雨绵绵,让人提不起兴致。下午四点多去操场准备养生一会儿。发现东哥居然在练3000米(五月底有个上海市教工运动会),这不趁机给东哥上个强度,穿牛仔裤也得给他好好拿捏一下。

- 东哥目标进14分钟,带他跑出13’09",最后100米轻松绝杀。对我来说只是热身,而对东哥已是极限,只是可惜忘了给东哥来几张表情包。不过他下周还想进13分钟,机会有的是(ಡωಡ)。就怕到时候例训公报私仇,12×400米间歇给我直接干废哈哈。

最近发现一个很强的UP,五道口纳什,CSDN也有博客,全栈算工,真的是太全面了,啥都会,而且大多数面都要比我要精好多,所以准备把他的vlog全部学一遍,真的很有用。

使用meshgrid方法可以实现3D作图的坐标轴控制:

import numpy as np

import matplotlib.pyplot as plt

from matplotlib import cm

xs, ys = np.meshgrid(np.arange(-2, 2.01, .01), np.arange(-2, 2.01, .01))

zs = np.exp(-(xs**2+ys**2))

# xs: 401 × 401

# ys: 401 × 401

zs = np.exp(-(xs**2+ys**2)) # zs: 401 × 401

fig = plt.figure(figsize=(16, 12))

ax = fig.add_subplot(111, projection='3d')

surface = ax.plot_surface(xs, ys, zs, cmap=cm.jet)

fig.colorbar(surface)

另一种在jupyter里可交互的作图方式:

from mpl_toolkits.mplot3d import Axes3D

%matplotlib notebook

fig = plt.figure()

ax = Axes3D(fig)

xs, ys = np.meshgrid(np.arange(-2, 2.01, .01), np.arange(-2, 2.01, .01))

# creating the plot

surface = ax.plot_surface(xs, ys, zs, color='green', cmap=plt.get_cmap('rainbow'))

# setting title and labels

ax.set_title("3D plot")

ax.set_xlabel('x-axis')

ax.set_ylabel('y-axis')

ax.set_zlabel('z-axis')

fig.colorbar(surface)

# displaying the plot

plt.show()

20230323

- 晚上例训。3000米乳酸阈跑(with嘉伟,11分整,中途要停一圈,这已经是我的极限了,自测3000米最快能到11’30",今天第一个1000米就被带到3’30",力不能及)+ 3000米放松跑(with东哥,13’39",东哥说他五年前能跑到9’08",超二级水平,太恐怖了,没想到现在垮得这么厉害)+ 2000米追逐+ 2000米冷身,外加4组箭步跳和蛙跳。

- 锡马回来后四天在循序渐进地恢复,现在左胯仍抽痛,用力压会疼,其他地方都已经完全恢复,最近休息得很好,虽然没有拉强度,但是应该状态已经恢复到巅峰了,下周队内会有一次体测,争取把5000米再次跑进20分钟。

- 嘉伟周日要去芜湖跑半马,本来卢星雨是芜湖人,可惜她也垮得很,说可以租个儿子去跑亲子欢乐跑,TM笑死。

- 看了一下栾云平的无锡专场,便宜的位置都卖光了,剩余最低580,90分钟一场确实挺贵滴,小园子倒是便宜得多。因为我一直在想要不要送个生日礼物,或许搞个票是不错的选择,但莫名感觉sxy会不会已非单身。害,庸人自扰。

制作2048的环境,以及pygame渲染:

# -*- coding: utf-8 -*-

# @author : caoyang

# @email: caoyang@163.sufe.edu.cn

import numpy

import random

from copy import deepcopy

class Env2048:

initialize_proba_for_2 = .9 # Each round with some probability to generate tile 2 at random position

n_initial_tile = 2 # The number of initial tiles in the start

score = 0 # Log the game score

actions = list(range(4)) # {0, 1, 2, 3} -> {U, R, D, L}

def __init__(self, args, is_debug=False):

self.args = deepcopy(args)

self.is_debug = is_debug

self.reset()

# Restart game

def reset(self):

self.grid = numpy.zeros((self.args.order, self.args.order)).astype(numpy.int16)

for _ in range(2):

self.add_tile()

self.mode = 'run'

# Step to next state with some action

def step(self, action):

if self.mode in ['over', 'win']:

return

grid = self.grid.copy() if self.is_debug else self.grid

score = 0

if action == 0:

# Upward 0

for i in range(self.args.order):

score += self.merge_bar(bar=grid[:, i])

elif action == 1:

# Rightwards 1

for i in range(self.args.order):

score += self.merge_bar(bar=grid[i, ::-1])

elif action == 2:

# Downward 2

for i in range(self.args.order):

score += self.merge_bar(bar=grid[::-1, i])

elif action == 3:

# Leftwards 3

for i in range(self.args.order):

score += self.merge_bar(bar=grid[i, :])

if self.is_over():

self.mode = 'over'

if self.is_win():

self.mode = 'win'

self.add_tile()

self.score += score

return score

# Sample the position of some empty tile

def sample_available_position(self):

available_positions = list()

for x in range(self.args.order):

for y in range(self.args.order):

if self.grid[y, x] == 0:

available_positions.append((y, x))

# assert available_positions, f'There is no empty tiles in grid: {self.grid}'

return random.choice(available_positions) if available_positions else None

# Randomly add 1 tile to grid

def add_tile(self):

position = self.sample_available_position()

if position is not None:

y, x = position

self.grid[y, x] = 2 if random.random() < self.initialize_proba_for_2 else 4

# Move one row or one column for merging

def merge_bar(self, bar):

score = 0

bar_length = len(bar)

for i in range(bar_length - 1):

if bar[i] == 0:

for j in range(i + 1, bar_length):

if not bar[j] == 0:

bar[i] = bar[j]

bar[j] = 0

score += 1

break

if bar[i] == 0:

break

for j in range(i + 1, bar_length):

if bar[j] == bar[i]:

bar[i] += bar[j]

score += bar[j]

bar[j] = 0

break

if not bar[j] == 0:

break

return score

# Whether is game over

def is_over(self):

if 0 in self.grid:

# There exist some empty tiles in grid

return False

for y in range(self.args.order - 1):

for x in range(self.args.order - 1):

# There exist some ways to merge tiles

if self.grid[y][x] == self.grid[y][x + 1] or self.grid[y][x] == self.grid[y + 1][x]:

return False

return True

# Whether is game wins

def is_win(self):

return self.args.game_goal in self.grid

# Stringize

def __str__(self):

string = '====================\n'

for row in self.grid:

string += '-' * (5 * self.args.order + 1) + '\n'

for e in row:

string += '|{:4d}'.format(int(e))

string += '|\n'

string += '-' * (5 * self.args.order + 1) + '\n'

string += '==================\n'

return string

20230324~20230325

- 春寒料峭,昨天状态又极度低迷,感觉这几天衣服穿太少给冻着了,有点发烧的征兆,早早睡了一觉又基本恢复过来了。

- 下午例训,全员8×400米间歇,状态不错,能1’15"~1’20"的pace坚持到底,没有不适,最后两组甚至跑到前三,仅次于杨申宇和宋镇均(不得不说宋镇均的话一个标点不能信,第3组跑完跟我说上头了,让我站他前面出发,然后每组都超我,一点不给老学长面子)。再跟队练三周到扬马结束,至少进个135,了却这桩心愿。

- 找工作确是玄学,尤其是近两年,但无论如何,sxy都确是足够优秀了,实话令人艳羡不已,能去中金真的已是天花板。与三年前很像,不过今天我是听众,熟悉的清澈,褪去了些青涩,多了些岁月的蹉跎,以及恍惚间的落差。好多话没能说出口,也不知道两年后我会何去何从,以后还能否再见。然,人生能有这么一段三年多的邂逅,cy,你也该知足了罢。

2048蒙特卡洛代理,利用两个经典的指标进行:

class MonteCarloAgent(BaseAgent):

gamma = 2.8

def __init__(self, args):

super(MonteCarloAgent, self).__init__(args)

self.env = Env2048(self.args, is_debug=False)

# Generate the next action given grid state

def generate_next_action(self, grid):

action_grades = []

n_empty_tiles = self.count_empty_tiles(grid)

if n_empty_tiles >= self.args.order ** 2 / 3:

# There exist so many empty tiles that we can act randomly

if self.args.gather_to_corner == 'ul':

return random.choice([0, 3]), {'grade': 0}

elif self.args.gather_to_corner == 'ur':

return random.choice([0, 1]), {'grade': 0}

elif self.args.gather_to_corner == 'dl':

return random.choice([2, 3]), {'grade': 0}

elif self.args.gather_to_corner == 'dr':

return random.choice([1, 2]), {'grade': 0}

# Simulate

n_simulate = min(max(n_empty_tiles ** 2, 20), 40)

for action_list in itertools.product(self.env.actions, repeat=self.args.montecarlo_search_depth):

candidate_grades = []

for _ in range(n_simulate):

grid_final = self.generate_simulated_grid(grid, action_list)

candidate_grades.append(self.grade_grid(grid_final))

action_grades.append([action_list, min(candidate_grades)])

action_grades = sorted(action_grades, key=(lambda x: [x[1]]))

for action_list, grade in action_grades[::-1]:

self.env.grid = grid.copy()

if not self.env.step(action_list[0]) == 0:

# Return the first action in sorted actions list by grade

return action_list[0], {'grade': grade / n_simulate}

# Revert

self.env.grid = grid.copy()

return action_grades[-1][0][0], {'grade': action_grades[-1][1] / n_simulate}

# Generate the final grid given a grid and a list of simulated actions

def generate_simulated_grid(self, grid, action_list):

env = Env2048(self.args, is_debug=False)

env.grid = grid.copy()

for action in action_list:

env.step(action)

env.add_tile()

return env.grid

# Grade the current grid

def grade_grid(self, grid):

return self.grade_algorithm_1(grid) + self.gamma * self.grade_algorithm_2(grid)

# Count the number of empty tiles in grid

def count_empty_tiles(self, grid):

return numpy.sum(grid == 0)

20230326~20230327

- 昨日休整,去小姨家养了波胃。前晚肚子不适,不知是九鼎轩东西不干净还是一回来就跑高强度间歇的缘故,总之就是不舒服。陈嘉伟首半马顺利完赛,净成绩1:28:26,配速4’11",这还不是完全发挥出来的水平。半马跟嘉伟的差距要小一些,配速差大概在15秒。

- 注册openai账号,打不过就加入呗,openai还不给china和russia提供服务,买了个巴西的虚拟号码才验证通过,梯子又不稳,凌晨搞到一点才弄好。

- 主要是近半个月很多大模型的api都开放了,所以上周主要在追踪前沿,如提示工程,图像的diffusion之类的。其实prompt很早就有提出,那时候还以为只是简单的补全,现在看来真的是坐井观天。LLM和Prompt,这是方法论和工业应用的双重革新,有预感大变革真的要来了。

- 下午晃了十圈,碰到宋镇均在自测5000米,结果这货少跑了一圈,18’32",亏我还长袖长裤、而且没热身就带了他两段。可惜明天临时要汇报,估计要错过队内测试,这么好的状态多想能重开一次20分大关。(说起来一年半前还打开一次20分钟,自己这么久就一点长进都没有,好菜)。

LLM与提示工程之遐想

其实现在看来提示学习的确是革新了传统的预训练方法,那些传统的预训练模型可能很快就要被淘汰,GPT崛起说明预训练根本不需要搞那么多花里胡哨地操作,做自回归就完事了,有种数学里常说的朴素简洁的美。

关于提示,几乎已经可以覆盖所有的NLP任务,虽说现在提示工程看似只是在对一个黑盒子进行不断地试错,没有什么理论依据可言,之前王英林坚持不肯在本子里写提示学习,就是觉得这种东西没有什么科研价值,就一群人在那儿写模板喂给模型,而且很多时候还需要人类来对模型的输出进行反馈。但是从另一个角度来看,提示工程有点类似在对人脑的思维逻辑进行解析,事实上我们也没有办法完全弄明白人脑的运行逻辑,所以提示工程里有很多提示构建的思路,比如思维链(CoT),ReAct,以及生成外部知识模板,甚至将逻辑用代码形式进行提示,其实都是在帮助模型学习推理的能力,但是这种推理能力并不是结构化的,它依然是非结构化的文本组成,你很难说模型到底学习到的是推理能力,还是只是以文本形式呈现的推理过程,抑或说本身推理确实也可以是非结构化的呢,只是人类更偏爱使用结构化的推理形式而已?

这波冲击对NLP是及其巨大,但是随着多模态提示的发展,图像领域可以预见到的很快也会受到冲击,其实diffusion作为一种MC也可以理解是一种自回归,这和文本预训练上的思路是一致的。其实我一开始以为diffusion是以像素点级别进行自回归扩散的,当时觉得这个思路好神奇,但是并不是这么做的,为什么不是这么做呢?比如对于图像补全,感觉上以像素点进行自回归扩散更合理,OR里面会用nuclear norm来进行优化实现图像补全,本身也是基于熵减的思想。

openai补全接口调用:

import openai

import os

import Ipython

from langchain.llms import OpenAI

from dotenv import load_dotenv

load_dotenv()

openai.api_key = os.getenv("OPENAI_KEY")

os.environ["OPENAI_API_KEY"] = os.getenv("OPENAI_KEY")

os.environ["SERPART_API_KEY"] = os.getenv("SERPART_API_KEY")

def set_open_params(model='text-davinci-003',

temperature=.7,

max_tokens=256,

top_p=1,

frequency_penalty=0,

presence_penalty=0):

openai_params = {}

openai_params['model'] = model

openai_params['temperature'] = temperature

openai_params['max_tokens'] = max_tokens

openai_params['top_p'] = top_p

openai_params['frequency_penalty'] = frequency_penalty

openai_params['presence_penalty'] = presence_penalty

return openai_params

def get_completion(params, prompt):

response = openai.Completion.create(engine=params['model'],

prompt=prompt,

temperature=params['temperature'],

max_tokens=params['max_tokens'],

top_p=params['top_p'],

frequency_penalty-params['frequency_penalty'],

presence_penalty-params['presence_penalty'])

20230328

- 下午组会,错过训练(事后碰到谢震宇问了下,其实东哥根本没来,就没咋练,还好还好,主要状态是挺好,练不了有点可惜)。两天不到把锡马回来一周多看的东西整出来并讲了一遍,颇有所得,从gpt1到gpt4,再到提示工程的技术,以及这个月刚刚开放的各种OpenAI接口,做了一回LLM和AIGC的传教者。从我的角度来说,LLM和AIGC的到来确是令人激动的事情。虽然我们还不能直接无代价的接触到LLM,但只是摸到一点皮毛也足以令人兴奋。

- 会后跟黄名媛回实验楼,在看暑期实习,跟我说加了颜烨,然后这B居然让她去投开发岗,是真TM离谱,颜烨这是人做出来的事儿?

- 21级的时候就来了一个黄名媛,我过了差不多快一年才看到真人。今年进了4个,而且居然有个直博新生,我都以为王英林要退休了,居然还要带博士,这可至少五年,到时候都快70岁。

- 晚上强行想认真跑会儿,之后可能要连着下雨。虽然下午感觉很好,但是到晚上毕竟还是太累了,没睡午觉状态又差,奔着10km去跑结果不到2km就报销了,又断断续续补到5km,说起来还是在扬马备赛期,不论配速,每天还是要把跑量补足。

LLM与提示工程之遐想(二)

提示工程指南:GitHub高星项目

如果说GPT4真就只靠无监督的自回归训练+多任务微调那确实太夸张了,它的训练过程中一定有很多细节没有公开,否则很难想象text-to-SQL以及代码生成等公认的高难度NLP任务就这么被一个说不清道不明的in-context learning一举拿下了。以Text-to-SQL著名的Spider挑战任务为例,上个月刚提出的SOTA模型也超过不了80%的正确率,根本不足以达到应用范畴,但是事实上这也不能在GPT4中测试,因为context太长,除非把Spider的整个数据库扔进去。

即便如此,正如昨天写到的那样,以提示为起点,自回归为方法的LLM&AIGC新方法,抛却了一切花里胡哨的结构化操作,确是一种简单朴素的美。以前总是认为规则、推理是需要用结构化的方式进行表达,比如一阶规则,现在看来自然语言几乎可以概括一切规则。不管你信不信这是不是推理能力,反正LLM就是能推出来。

最后推荐几个图像领域的,从GPT4开始已经可以进行提示生图的操作了,当然这些技术半年前就已经很成熟了,AI绘图早已不是,这么看来,图像还是要比文本要容易一些。我以前也是这么认为,因为文本的精确性要求更高,图像还是有一定容错的。https://civitai.com,Diffusion公式推导

Image Caption(调用Blip模型):

import torch

from transformers import BlipProcessor, BlipForConditionalGeneration

from PIL import Image

device = 'cuda:0'

processor = BlipProcessor.from_pretrained("Salesforce/blip-image-captioning-base")

model = BlipForConditionalGeneration.from_pretrained("Salesforce/blip-image-captioning-base", torch_dtype=torch.float16).to(device)

# processor forward,模型的输入需要经过processor进行预处理

img_inputs = processor([Image.open('./flickr8r-samples/33108590_d685bfe51c.jpg'),

Image.open('./flickr8r-samples/10815824_2997e03d76.jpg')],

return_tensors='pt').to(device, torch.float16)

print(img_inputs['pixel_values'].shape)

out = model.generate(**img_inputs) # 输出结果是一个LongTensor

# 需要用processor解码

# processor.tokenizer.convert_ids_to_tokens(out[0])

captions = processor.decode(out[0], skip_special_tokens=True)

print(captions)

captions = processor.decode(out[1], skip_special_tokens=True)

print(captions)

20230329

- 开始面实习,早上做阿里的行测,智商严重受辱,拿各种小学数学应用,阅读理解还有离谱的图形规律来恶心人。后晚要电面,因为是数算岗,跟近期看的内容不搭嘎,又得刷算法题准备机考,以及把之前写的pyspark和hadoop笔记拿出来复习。就是那种,想、又不想实习的矛盾感。

- 晚饭后准备去操场散会儿步,路上碰见东哥刚练完,告诉我本来上周六3000米已经跑到12’49",结果三天不练又被打回原形。然后卢星雨和丁古丽也在慢跑,想想我也有好几天没有认真跑了,之后又要下雨,晚上状态虽低迷,还是换了衣服鞋子上场拉一拉强度,4000米用时16’04",配速4’01",马马虎虎。

- 说起来,这学期若不是有嘉伟带,我很难两周就重回巅峰。非例训时间里,我一个人训练很难上大强度。以前习惯独自训练,一周也能跑出7个高质量的万米,现在变得越来越依赖随队氛围,就是那种被人认同也认同别人的氛围。然,越是依赖,越是遗憾,早晚会离开这样的欢乐与纯粹。聚少离多,能陪伴一生的人和物是何等的无价珍宝呢。

Legion笔记本,摄像头灯亮,但是显示黑屏问题解决:

摄像头的盖子没掀开阿,如果你发现摄像头最中间是一个红点,那就是被盖住了,看看摄像头上方有个很不起眼的像是滑槽(可以左右滑)的东西,往右边一滑就开了。TM下午搞了半小时,还以为是摄像头驱动坏了,差点准备卸了驱动重装,真是服了。

就特别搞,看网上说联想笔记本摄像头是有物理开关的,我还在想是不是右边那个小孔是开关,用针捅了半天旁边兄弟跟我说那应该是麦克风,我???

20230330

- 晚上例训,跟嘉伟3’54"配速上3000米,我已力竭,于是被嘉伟无情嘲讽,他表示根本没尽兴,才3k就不行了?于是被迫补2组2000米间歇(分别偷懒了大半圈,真心跟不动),休息后8组×32个箭步跳,最后补1组2000米变速。练到胃的一晚,舒服得要死。可是明晚要面,题还没刷完,刷题真是浪费生命,昨晚刷到11点半才回寝,真是无语透顶了,今晚绝不熬夜。

- sxy去了南德,180块vip豪华一排座,属实慕了。讲道理小园子票价还是很亲民的,快乐一天总归比去影院看烂片舒服。

- 我最近又认识了几个跑的还不错的人,大二金融一个(这个要比我强,感觉4分配不在话下),还有今晚认识的一个大四经济(这个应该水平跟我差不多)。其实财大也不算小,想想总归是有些能跑的人,只是缺少号召力把这些人都集中起来,完善现在的训练氛围,长跑水平不见得比交大同济差,可惜我大概是看不到了。

nowcoder个人刷下来链表里感觉最难的是BM5(归并排序K个单链表),还有一些算法说实话思路跟小学奥数题一样,能不能来点不用取巧的算法题,比如什么找两个单链表第一个重合的元素那题,双指针的思路也太离谱了,没见过原题绝对不可能短时间想出来,跟脑筋急转弯似的。

import sys

#设置递归深度

sys.setrecursionlimit(100000)

class Solution:

#两个有序链表合并函数

def Merge2(self, pHead1: ListNode, pHead2: ListNode) -> ListNode:

#一个已经为空了,直接返回另一个

if pHead1 == None:

return pHead2

if pHead2 == None:

return pHead1

#加一个表头

head = ListNode(0)

cur = head

#两个链表都要不为空

while pHead1 and pHead2:

#取较小值的节点

if pHead1.val <= pHead2.val:

cur.next = pHead1

#只移动取值的指针

pHead1 = pHead1.next

else:

cur.next = pHead2

#只移动取值的指针

pHead2 = pHead2.next

#指针后移

cur = cur.next

#哪个链表还有剩,直接连在后面

if pHead1:

cur.next = pHead1

else:

cur.next = pHead2

#返回值去掉表头

return head.next

#划分合并区间函数

def divideMerge(self, lists: List[ListNode], left: int, right: int) -> ListNode:

if left > right :

return None

#从中间分成两段,再将合并好的两段合并

mid = (int)((left + right) / 2)

return self.Merge2(self.divideMerge(lists, left, mid), self.divideMerge(lists, mid + 1, right))

def mergeKLists(self , lists: List[ListNode]) -> ListNode:

#k个链表归并排序

return self.divideMerge(lists, 0, len(lists) - 1)

20230331

- 晚7点阿里面试,面了两个小时,从统计回归问到机器学习,从逻辑回归问到Transformer,又现场考了四道代码题,最后考官表示对我的表现是满意的,并希望很希望我能加入他们的团队。

- 我只准备了两天(而且根本没看这些基础知识,全TM在刷垃圾算法题),硬是靠坚实的基础(臭不要脸一回)全都接下来,可惜sql完全没看,最后一道sql直接缴械,想sql还是在杉数时做的了。其实也有面试官跟我可能熟悉的领域非常相近的缘故,几乎所有问题我都是了解的,就算不知道我也能猜出个大概。

- 时隔三年,又激起了我去实习的欲望。原因这已经很贴近我理想中的工作了,我可能还是不能去做那种尖端产品的开发,太难,而且不确定性太大,保不准哪天就被结构性调整,而且有一说一,这一块国内确实很难追上,因为氛围不对。OpenAI出身是非盈利性组织,那是真正出于爱好和钻研才集合到的一批最炽热的人,方有如今的成就,而工业永远是以利益为目标的,所以永远出现不了OpenAI这种品级的机构。

- 但是数算支持带些深度学习技巧对我来说要容易得多,而且是公司必要且不可或缺的。考官说他对杉数很熟悉,也是看重了我在杉数的那七个多月的经历,团队里也有以前在杉数工作过的人,而我也确实很怀念三年的杉数,那是一群年轻人有福同享,有难同当,没有勾心斗角的时光。

- 然,有得必有失,一天400拿的是很舒服,但我也会失去大部分的自由。我不喜欢被束缚的生活,晚饭后在操场晃悠时又看到卢星雨和丁古丽在跑5000米,而且居然有一个比卢星雨跑得还快的女生,好强,我还以为lxy已经是天花板了,这种充满活力的感觉真好。停三年实习,跑三年步;逃离三年现实,追逐三年梦想,再看自己早已不再年轻,马上就是奔三的人,却仍是孩童样,这是见sxy那天落差感来源,我觉得她已经远比三年前自信成熟了,也许这才是正常的样子吧。

阿里算法岗一面面经回忆(不全):

-

多元线性回归模型中的常用检验?(我答:变量显著性检验、方程显著性检验、异方差检验、多重共线性检验,从几个古典假设入手)

-

多元线性回归模型的OLS估计的解释?(我只回答了矩估计和正规方程组,考官表示还有最大似然和几何角度的解释)

-

对可决系数R方理解?

-

机器学习方法概述?(从逻辑回归到各种树)

-

树模型,GBDT和随机森林的区别(我答Boosting和Bagging,串行和并行)。

-

xgboost的分裂原理?(这个我真不清楚,但是我觉得是可以调的,那些ID3, ID4.5, CART之类的最大熵算法),调参(最大树深,最多叶子,树的数量)及具体场景。

-

xgboost本身自带有避免过拟合的机制,是什么?(这个我也不清楚,我只知道调参,后来好像也搜不到,有知道的吗)

-

lightgbm与xgboost的比较(更快,尤其处理大数据),为什么?(这个我不清楚,但是立刻猜到了应该是采样)

-

这里还问了一个,用树模型是否可以实现单调性?(即x增,y增这种性质,其实我也没太理解,但是肯定是分枝上做一些界限的限制吧)

-

介绍RNN?(略)

-

介绍LSTM中的门,及其为什么这么取名(这个当时我还真忘了,但是刚好开着浏览器就搜了一下三个门,其实就三个式子,还是要稍微熟悉一下,别忘了GRU,下次可能就是这个)

-

RNN的梯度消失与梯度爆炸解释(消失是其中一次是零,爆炸则是太长),及出现该情况时训练会发生什么(梯度消失则不更新,爆炸则乱更新)

-

LSTM的反向传播有什么技巧么?(这个我觉得LSTM其实参数并不多,因为每个Cell是共享参数的,所以我其实不太清楚他想问什么,可能是叠加吧我觉得,大概)

-

Transformer概述(略)

-

Transformer用于时序预测,如果其中有一段没有数据(比如过年期间没有销量),是否可以直接MASK(在文本里面是可以直接MASK的,这很常见,但是时序有特殊性,但是我不能很专业的讲明白,可能要再想清楚点儿)。

-

问了我一些因果推断的东西,因为我在简历里写了,这刚好是我熟悉的,就不多说了。

-

实时机考题(四道):

- pandas题,一个dataframe,A,B,C三个列,现在生成第4个列D,取值B当A=1,取值C当A=0,要求高效(比如处理100万行)

思路,这个给我第一眼我是觉得应该用apply写:

但是要求高效的话,立刻反应过来应该是用向量解:df['D'] = df[['A', 'B', 'C']].apply(lambda x: x[1] if x[0] == 1 else x[2])df['D'] = (df['A'] == 1) * df['B'] + (df['A'] == 0) * df['C'] - 一道简单的哈希表,从list里找到两个相加为target的数的下标,刚好昨天才看过,我诚实地告诉他我刚看过,他也很客气,说就不给我换动态规划了(笑死)。

- 实现Kmeans,封装成类,并且可以继承修改其中的distance算法,这个也不算难,这里额外问了python能否多继承,Java和C++能否多继承的问题。

- 从数据表中筛选出今天的价格比昨天高5%的SKUID,使用SQL/Hive/Progress(我很老实的承认sql很长时间不写了,确实不会写这种比较复杂的,但是pandas我一定会写…)

- pandas题,一个dataframe,A,B,C三个列,现在生成第4个列D,取值B当A=1,取值C当A=0,要求高效(比如处理100万行)

-

最后考官问我还想问他什么,我问了一下他们部门的工作和日常,越发觉得很适合我,我本来跟考官说我很佛系的,过不了也无所谓,现在我又很想进了。考官让好好准备笔试,别考得太烂。

20230401

- 下午队内测试,今天只测立定跳远、立定三级跳、跳远、50米和400米,虽然都是短跨项目,但也顺带试试自己练了这么久,相较本科到底是否提升。结果立定跳居然都不到2米5(本科最远还是能上2米5);立定三级跳完全没练过,所以只能跳6米4,差点进不了坑,跳远倒还行,跳到4米7。跳远考验的是大腿爆发力,显然我是不行的,前两项都是男生中倒二(宋镇均全部垫底,感觉他找不到技巧,立定2米35,三级跳6米17,不过练长跑的爆发力的确是比不过练短跑的),跳远成绩还行,应该是前5。

- 说到底长跑练多了之后肌肉僵硬,弹性不足,确实不适合做这种跳跃项目,陈嘉伟测下来成绩也不好。

- 50米真的拉垮,本科最快还能跑到7秒2,好久不练短跑都不会跑了。主要是不会起跑,如果是慢慢加上去就很符合平时的感觉,但是一下子想把速度加上去就完全找不到步调,然后就保持不了前脚掌跑,居然用后跟跑法冲了50米,而且路线都跑歪了,7秒6,真是废的真实,我觉得自己水平肯定不止于此,但也懒得再测一次了,因为其他人基本都能跑进7秒,再跑一次估计也就7秒整左右的水平。

- 最后400米1’09",意料之中,估计是在70秒左右的水平,还是比较满意的,差不多比一年前提升5秒多,前面冲太猛,后程掉的太厉害了。

关于昨天提到的xgboost自带防止过拟合的机制,我想起来了,他说的是正则项,具体大概是对树深合maxleaf进行惩罚。

重拾SQL:

-

列出所有数据库:

show databases,默认的结果是:information_schema mysql performance_schema sys -

创建新的数据库

cydemo用于示例测试:create database cydemo -

使用

cydemo数据库并展示该数据库中所有的表(此时数据库中没有任何表):use mysql; show tables;

运算符 描述

= 等于

<> 不等于。注释:在 SQL 的一些版本中,该操作符可被写成 !=

> 大于

< 小于

>= 大于等于

<= 小于等于

BETWEEN 在某个范围内

LIKE 搜索某种模式

IN 指定针对某个列的多个可能值

Select * from emp where ename like 'M%';

查询 EMP 表中 Ename 列中有 M 的值,M 为要查询内容中的模糊信息。

% 表示多个字值,_ 下划线表示一个字符;

M% : 为能配符,正则表达式,表示的意思为模糊查询信息为 M 开头的。

%M% : 表示查询包含M的所有内容。

%M_ : 表示查询以M在倒数第二位的所有内容。

20230402~20230403

- 最近大部分时间都花在刷题上,推荐B站一个题讲得挺好的UP灵茶山艾府,全网题量7000+,OMG,怪不得说搞算法竞赛的全是网瘾少年,这大概是真的热爱了吧,反正我是觉得算法题真的无聊,真有天赋应该去搞算法优化和近似算法这类的研究,熟能生巧的东西真的没意思。

- 晚上补了5000米慢跑,风雨欲来。距离扬马只有不到两周,锡马回来之后一直都没有认真跑,上上周是因为刚回来修整了两三天,上周准备面试和笔试。无论如何,这周开始必须养状态,抽时间找陈嘉伟一起拉拉长距离。

- 诸事缠身,总觉得扬马又要凉。害,总不能如意。

判断是否是完全二叉树

- step 1:先判断空树一定是完全二叉树。

- step 2:初始化一个队列辅助层次遍历,将根节点加入。

- step 3:逐渐从队列中弹出元素访问节点,如果遇到某个节点为空,进行标记,代表到了完全二叉树的最下层,若是后续还有访问,则说明提前出现了叶子节点,不符合完全二叉树的性质。

- step 4:否则,继续加入左右子节点进入队列排队,等待访问。

import queue

class Solution:

def isCompleteTree(self , root: TreeNode) -> bool:

# 空树一定是完全二叉树

if not root:

return True

q = queue.Queue()

# 根节点先访问

q.put(root)

# 定义一个首次出现的标记位

flag = False

# 层次遍历

while not q.empty():

sz = q.qsize()

for i in range(sz):

cur = q.get()

# 标记第一次遇到空节点

if not cur:

flag = True

else:

# 后续访问已经遇到空节点了,说明经过了叶子

if flag:

return False

q.put(cur.left)

q.put(cur.right)

return True

20230404

- 从下午两点开会到晚上十点,黄名媛是真tm能讲,一口气讲了两个多小时,水都不喝。晚饭后偷空去跑了2000米+5×400米间歇,2000米配速3’50",间歇圈速1’25",去的时候宋镇均刚跑完14圈变速,东哥也在练间歇。其实今天是有上强度的计划的,实在是无奈之举。明天清明假期,准备找嘉伟出来拉个长距离,赛前十天,该上强度了。

堆石头,leetcode1000,看了大半天终于弄明白了,菜B不会用循环,只会加lru_cache装饰器:

class Solution:

def mergeStones(self, stones, k):

n = len(stones)

if not (n - 1) % (k - 1) == 0:

return False

sum_list = [0] * n

temp = 0

for i in range(n):

temp += stones[i]

sum_list[i] = temp

@lru_cache(None)

def _dp(_i, _j, _t):

if not (_j - _i - _t + 1) % (k - 1) == 0:

return float('inf')

if _i == _j and _t == 1:

return 0

if _t == 1:

if _i == 0:

res = sum_list[_j]

else:

res = sum_list[_j] - sum_list[_i - 1]

return _dp(_i, _j, k) + res

# return min(_dp(_i, _p, 1) + _dp(_p + 1, _j, _t - 1) for _p in range(_i, _j))

return min(_dp(_i, _p, 1) + _dp(_p + 1, _j, _t - 1) for _p in range(_i, _j, k - 1))

return _dp(0, n - 1, 1)

20230405

- 嘉伟这B要出去玩,不跟我练体能。但据我观察,他最近跟袁佩瑶应该又在冷战。那我只好自己跑咯,其实昨晚状态真的特别好,晚上9点半下会甚至还去操场冲了5圈,一点儿不累。结果今天起跑就感觉特别沉重,似乎状态并不好。本来都作了很多准备,最后20’50"跑了个5000米就顶不住,巨不甘心。

- 跑完后宋镇均和卢星雨也来训练。所以跟他们又热身慢跑了6圈,做了些专项训练,补了几圈变速。不服气,准备跟宋镇均一起再测一个5000米,结果三圈多左脚踝抽筋(就是脚踝下面一点刺痛,也不是崴了,反正从来没有过这种疼痛),一用力就疼,实在跑不了,后来疼的连走路都不方便,只能放弃,转而给宋镇均记圈速,希望他能打破自己的PB。最后他19’50"独自完成5000米测试,基本持平前年11月份队内测试的水平。

- 说实话毕竟也练了许久,总归觉得4’00"/km配速跑起来并不吃力。但没有人在前面带,时间久了还是容易顶不下去。我和宋镇均的水平已经停滞太久太久。2021年12月份连续跑出19’59"的5000米,41’25"的10000米,1:32:40的半马,此后我就再也没能突破这三大项的pb,客观原因有很多,但是嘉伟就能从19’30"一路突破到18’16",总是觉得自己仍年轻,肯定还能继续突破,但就是有种力不从心的感觉。

- 4月25日,对我来说是最后一场校运会,16号还有一场半马。最近我也看到不少长跑强手,想必男子5000米必是一场腥风血雨,想进前三很难很难,嘉伟预定冠军,如果李乐康参加亚军也被预定。除了宋镇均外,我看到过的至少就有三个水平与我相当的对手。干完这一票,真就去养老了,以后就每年回扬州跑个半马,不服老还是不行唉,跑不过年轻人了。

我又回想起一些一面的题目答案:

- xgboost自带的防止过拟合机制是他的loss自带了一些正则项(树深,max_leaf)

- 为什么回归loss用MSE,分类任务的loss就用CE呢?分类任务的loss可以用MSE吗?(这个后来查了一些,CE是凸优化,MSE不是凸优化,其实我还是没搞明白,MSE怎么就不是凸优化了,平方不是凸函数吗?还是说对于分类任务的MSE而言,不是凸的?)

- Transformer里怎么处理MASK?这个一般是设置成负无穷,那么就接着问,为什么是设置成负无穷,而不是正无穷,或者是零?(这个的答案是从softmax的角度考虑, e − ∞ = 0 e^{-\infty}=0 e−∞=0)

然后昨天黄名媛作的汇报确实受益颇多,果然是不能小看这些一路考研上来的人,虽然本科院校一般,但是没两把刷子是不可能的。在我认识的硕士里,我觉得她的能力真的算是很强了。

简单记录一些吧:

提示学习除了之前提到过的硬提示(现在的一个主流的形式是CoT,即思维链形式的提示),还有一种称为软提示,其实类似微调,但是不是微调模型的参数,也不是从模型中挑一些参数来微调,而是直接嵌入新的参数进去微调。

首先软提示的出现算是把传统迁移学习直接捏爆。并且从宏观哲学角度来看,软提示的出现,使得复杂的神经网络开始有了代码的那种模块化属性(即加入的新的参数构成一个模块,该模块是具有迁移能力的),感觉从某种意义上赋予了模型可解释性。从软件工程的角度来看,低耦合,高聚合,模型的训练变得更加灵活。

目前可以将这种模块化的思想分为三种类别:

- 参数组合:向模型参数里加一些新的参数 ϕ \phi ϕ

- 输入组合:直接在输入时加一些新的参数(这就是软提示)

- 函数组合:添加额外的函数(网络层)进去(这个最能体现模块化的本质)

今天先把第一个参数组合看一下:

分为三种:

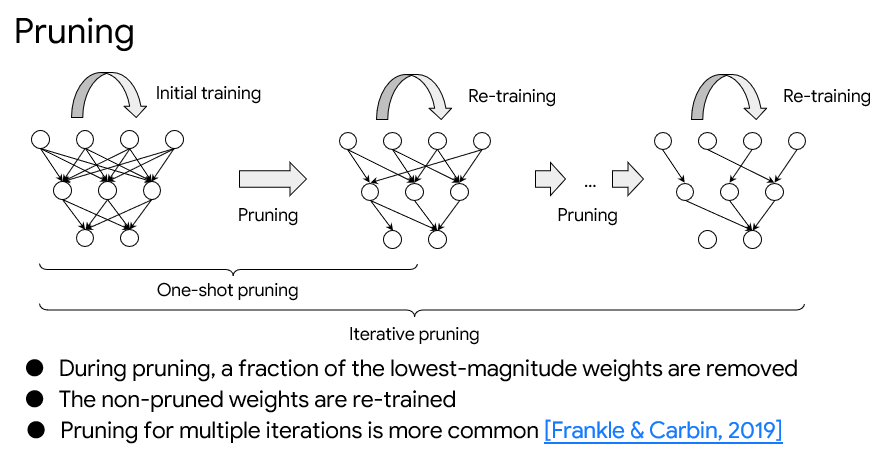

- 稀疏子网络:即新加入的参数

ϕ

\phi

ϕ是稀疏的,那最常见的做法就是剪枝(pruning),具体而言,就是用一个二进制的MASK

b

∈

{

0

,

1

}

∣

θ

∣

{\bf b}\in\{0,1\}^{|\theta|}

b∈{0,1}∣θ∣,来确定是否保留或删除模型中的参数,以此得到一个稀疏的子网络,参考文献是一篇weight magnitude,具体一个剪枝的逻辑如下:

- 结构化组合:TBD

- 低秩组合:TBD

20230406

- 好吧,左脚就是崴了,不过扭得比较轻(应该就是脚落地时没放正,但当时主观上也没感觉),以前脚踝扭伤肿得跟鸡蛋似的,不过那也是高中的事,这么多年没崴过脚昨天就没反应过来,就只是觉得有点刺痛,还强行跑了两段。今天上午走路实在是太不方便,午饭后还是回来老老实实休息。

- 赛前搞这么一出是真的痛苦,还好今天天气不好,休就休一天吧,希望明天基本恢复。跑了这么久,还是第一次扭伤。

- 今天cv大模型也出来了,想往多模态注水也难,杨亦童建议一起去搞理论推导,堆数学。可惜这不是我们组的长项,可能还是觉得在一些方法论上做创新会更好一点。

另一种剪枝的视角:

-

也可以将剪枝视为添加一个task-specific的向量 ϕ \phi ϕ, f θ ′ = f θ + ϕ f'_\theta=f_{\theta+\phi} fθ′=fθ+ϕ,其中 θ \theta θ是原模型的参数,若 b i = 0 b_i=0 bi=0则 ϕ i = 0 \phi_i=0 ϕi=0,即添加的 ϕ \phi ϕ也是一个稀疏参数。

-

那么如果最终的模型参数仍是稀疏的,则 f θ ′ = f θ ∘ b + ϕ f'_\theta=f_{\theta\circ b+\phi} fθ′=fθ∘b+ϕ

状态机买卖股票:(牛客BM82)

class Solution:

def maxProfit(self , prices: List[int]) -> int:

n = len(prices)

#初始化dp为最小

dp = [[-10000] * 5 for i in range(n)]

#第0天不持有状态

dp[0][0] = 0

#第0天持有股票

dp[0][1] = -prices[0]

#状态转移

for i in range(1, n):

dp[i][0] = dp[i - 1][0]

dp[i][1] = max(dp[i - 1][1], dp[i - 1][0] - prices[i])

dp[i][2] = max(dp[i - 1][2], dp[i - 1][1] + prices[i])

dp[i][3] = max(dp[i - 1][3], dp[i - 1][2] - prices[i])

dp[i][4] = max(dp[i - 1][4], dp[i - 1][3] + prices[i])

#选取最大值,可以只操作一次

return max(dp[n - 1][2], max(0, dp[n - 1][4]))

20230407

- 下午自训,左脚还有一点点疼,虽走路已无大碍,但用力跑仍有感觉的。可能是心理作用,但确实跑起来落脚不自然。慢跑3000米,主要在做力量训练,拿了块15kg的片,做10组×30个负重箭步,尽力局,明天大腿要废。

- 虽然比赛临近,但急于求成怕落下更重的伤,确实给整怕了。上周六测跳远时错用左脚起跳,力量不足踉了个大跄都没出事,前天就正常跑圈也能崴到是真无语,从来没有过。

- 下周日程排满,这周末要赶工,扬马又是凶多吉少。不过总归是主场作战,计划下周四跟队最后一练,周五就回家,总归可以好好休息,不至于又老失眠。

SELECT INTO语法:

SELECT *

INTO newtable [IN externaldb]

FROM table1;

SELECT column_name(s)

INTO newtable [IN externaldb]

FROM table1;

例子:

- 复制多个表中的数据插入到新表中:

SELECT Websites.name, access_log.count, access_log.date

INTO WebsitesBackup2016

FROM Websites

LEFT JOIN access_log

ON Websites.id=access_log.site_id;

select into from 和 insert into select 都是用来复制表

两者的主要区别为: select into from 要求目标表不存在,因为在插入时会自动创建;insert into select from 要求目标表存在。

20230408~20230409

- 昨天例训据说是10×400米的间歇,不过东哥没来,估计质量一般。然后王炳杰跟我说他自测了5000米,19’46",我直接震惊,在中金实习了三个月居然还能这么强,去年9月底队内测试时也掉到了20’50",他上周刚从珠江飞回来,这也已经超出我的认知范围,按道理怎么也得恢复半个月才能练回原先水平,这也太夸张了。

- 所以我下午也去自测5000米,结果又是3000米跑崩(菜得真实)。天气太热,而且节奏不对。锡马回来之后一直穿的361°飞飙训练,今天换了竞速鞋Nike Vaporfly,起手步频飙到185,第一个1000米用时不到3’50",我就知道节奏肯定乱了,赶紧调整,第二个1000米掉到4’02",最后3000米用时11’53",实在是坚持不住。本来前天练完力量,大腿就酸痛得很,这太阳又晒得跟盛夏般令人绝望。最后补了4个400米间歇,惨淡收场。

- 不得不服老呀,真是跑不过年轻人。16号扬州天气15~27℃,比今天还要热。到25号校运会肯定更热,而且是下午。为了校运会能跑个好名次,一辈子就这么最后一次,拼了!

提示学习之遐想(三)

传统的NLP研究体系“崩塌”之后,发现许多传统方法都开始为提示学习的prompt服务,比如在Multi-hop QA中,会有将推理类型作为软提示插入模型输入,以及CTG(可控文本生成)中会将生成文本的属性作为软提示插入模型输入。虽然说软提示对于人类来说很难理解,但是目前主流,或者说更有研究价值的方法依然是以软提示为主。

当然不是说硬提示就啥用没有,比如有人提出用强化学习方法来学习硬提示https://aclanthology.org/2022.emnlp-main.222,对应的也有人用QLearning来学习软提示http://arxiv.org/abs/2106.07704,另外根据提示来生成反事实,尤其是多模态领域中的反事实生成,可以有效提升模型鲁棒性,这也是我们组目前所感兴趣的点。

在资源有限的情况下,GPT2是我们能研究的上限。另外基于Prompt的图像合成,Stable Diffusion模型很早就开源了,直接从HuggingFace上clone下来就能用,CompVis/stable-diffusion-v1-4,PC机带4GB的显存+16GB内存,用float16半精度就可以跑通,虽然repository很大,20G,但是确实可行,根据文字的提示,画一张图大概五分钟,相较于openai提供的付费接口,这种开源模型已经相当良心了。

20230410

- 下午四点自训,又是5000米跑崩的一天,热得要命,状态也难以捉摸,补了几组间歇收尾,难受得要死,我只是想跑进20分钟,给自己点儿满足感,现在一个个都猛得离谱。见王炳杰也在练,上次碰面还是寒假前,老王一回来就练这么狠,交流了些近况,他现在在等第二批夏令营,第一批四五月份的应该已经截止了,第二批应该就是暑期那批,不过就只能选清北了,老王这次回来很大原因是为了校运会,前年他1500米和5000米都是差了一两秒错失前三,今年他的野心肯定是很大的,虽然现在我还是萎靡得不行,但是扬马回来后还有一周备赛期,到时候胜负犹未可知。总都想在人生篇章上留下浓墨重彩的一笔,免得将来被单调的色彩给湮没。

- 从上周五开始,天天肝到十点半回寝,王英林就TM指着一只羊薅,明天ddl,后天早上又要笔试,这几天完全没看(我突然想到sql题还没刷,炸了,也不知道会不会考),今晚估计还得熬,烦。

CompVis的Stable Diffusion模型调用:

import torch

from diffusers import StableDiffusionPipeline

model_id = "stable-diffusion-v1-4"

device = "cpu"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float32)

pipe = pipe.to(device)

prompt = "a photo of an astronaut riding a horse on mars"

image = pipe(prompt).images[0]

image.save("astronaut_rides_horse.png")

这里有个注意点,如果是用的cpu的话,那么pipe里必须指定float32,如果用半精度float16,会提示pytorch里的一些函数没有为半精度进行实现。事实上在cpu上确实不太好进行半径度的实现,反正到1.8.0版本的pytorch依然不行,不知道pytorch2之后的版本是否解决了这一问题。如果指定的device是cuda则无所谓,测试下来指定cuda,显存达到4GB即可跑通半精度的pipeline,不过作画质量一般,远远不及openai给的image_completion接口:

这是用半精度stable diffusion画出来的宇航员骑马:

这是用openai接口画出来的宇航员骑马:

前者细节还是差了点

20230411

- 下午汇报完,今天讲得不是很好,Prompt相关工作确实无趣,本来以为找的几篇都是很有用的,结果都是变着花儿在扯淡,第二段很想讲一讲diffusion的,明显这个要有趣的多,可是数学推导在我们组不popular,而且讲完第一段已经过了两个多小时,就很无奈。

- 闷热,雨要又下不下来,下午那么湿热东哥居然让他们练8×400米,宋镇均还主动加量多练了2组,一个个都猛得要死。晚上凉快了下来,但又诡异地冒虚汗,八点去操场自己练了2km+2km+1km+1km的间歇,配速维持在4分整,本来状态差人又多,也没指望能跑很好,最近三天虽然紧凑,但还是逼自己把强度慢慢拉起来,总归是找回了点感觉,嘴上说着无所谓,但还是很想求胜的。

- 东哥今年考核没通过,延到明年上半年,说之前花了六万多托外面公司发论文,结果杂志社倒闭了,直接打水漂,整个人跟热锅上蚂蚁,下午先是问了卢星雨,卢星雨表示她们组发论文写名字得看导师意思,她做不了主。然后我五点下组会来操场时又问我,我觉得倒是可以帮忙水一篇,听说羽队那边的教练就是让李青汶帮忙水了一篇关于羽毛球比赛视频分析的论文,到时候有空看看,反正我们也要发论文,而且这个论文只要学生署一作,老师署二作,按规定教师和学生都可以用来申报成果,听起来是件双赢的事情,而且人工智能最容易水些小领域应用的paper了。

- 明早十点阿里笔试,我本来以为是考算法岗,结果是数据岗(其实投的是数据,但是算法那边觉得更合适就拉过去面掉了,但是笔试安排的还是数据的),所以之前跟颜烨问的东西估计都没啥用了,我想应该是炸了罢。开摆,裸考谁怕谁了还。

Diffusion之遐想

其实跟GAN和VAE这类生成模型是殊途同归的,都是先编码再解码,只是diffusion是通过一种直观的,可解释的增噪过程来实现编码,然后再通过估计逆向过程的均值和方差来实现解码,可解释性要强很多。

训练目标本质是在拟合采样得到的某个时间t的带噪图像 X t X_t Xt的噪声矩阵。DDPM里只是做了这样一件去噪还原的工作。但是在后面的guide diffusion,利用text以及image作为guide来生成隐信号,这个可以参考图文对比学习的CLIP模型的一些工作。

推荐两个把diffusion讲得很明白的两篇博客,其实从去年6月份开始就有很多人在讲diffusion的原理,其实很多都是泛泛而谈,但是真的去琢磨细节又很难看得很明白,所以需要雅俗共赏,把原理到训练以及应用都串通是最关键的。

Diffusion 和Stable Diffusion的数学和工作原理详细解释

20230412

- 笔试炸了,一道SQL和一道编程题写在下面。

- 状态和精神都很低落,东哥把羽毛球队教练陈简妮的那篇paper发给我,果然是李青汶帮忙写的,是关于video summary的,我看了一下这个任务确实研究的人不多,而且也是现在大模型的一个盲点(大模型确实还没有这个能力),但是说实话video summary有两种操作,第一种是浓缩式,就是跟做一张海报来总结视频内容一样,这个其实还挺有技术含量的,因为是一个生成任务,但是他们做的就是从视频里摘取一些clip作为摘要,这个就很简单,因为只要划分一下视频的场景片段就可以了,而且这种标注也是很主观的,人其实也是根据场景转移来切分视频进行标注的,然后从每个片段里抽一些关键帧就可以组成一个summary了。然后挂了个陈简妮的二作,李青汶确实牛批,这可是一篇A刊。所以早上笔试完我跟杨亦童谈了一下这事儿,杨亦童准备做多模态这块,我也觉得似乎是可行的,明天例训(其实也是扬马前最后一练了)准备找东哥谈一下,这个机会很好,东哥和我都有迫切需求,可以试着搞一搞。

- 扬尘天,训练推迟到晚上,以跳绳双摇和间歇训练为主,虽然晚上空气质量好了一点,但我也没有跑长距离的打算,又不想练大腿,怕临赛疼得受不了,索性跳绳练练小腿。我看东哥发了一个他在小区双摇的视频,居然一分钟连续双摇了130×2下,一个没断,我直接震惊了,今天我自己试了一下,最多的一次能连跳45×2下,然后手臂果断麻木到甩不动绳子了。最后一共跳了五百多次双摇,中间穿插跑了一个800米(2’58")+400米(1’19")×2的间歇,心脏都要炸了。

- 最新天气预报16号扬州20~32℃(比上海还热),而且又是E组,锡马有首马带来的肾上腺素加成,这次赛前被折磨得根本兴奋不起来,而且气温太可怕了,很可能跑崩,但我是不可能中途放弃的。

阿里数据笔试题:

SQL题就是汇总快递单销量,以及计算每天相较于前一天单量和营收额的增长率,其实就跟找出比前一天销量高的SQL是一样的,可以参考这个https://zhuanlan.zhihu.com/p/232424418,主要是过了太久又忘了LAG是怎么用的,怎么都调不对。

最后一个算法题很难很难,我到现在都想不出有什么很好的解法:

给定

x

x

x个任务

j

o

b

1

,

.

.

.

,

j

o

b

x

job_1,...,job_x

job1,...,jobx以及它们的负载数组cost,现在给定三台机器,以及一个任务分配列表p,问最少调整几次p中的分配,使得三台机器负载的最大值最小?

比如:cost=[2,3,4,5],p=[1,1,1,2],表示有

4

4

4个任务,负载代价分别是2,3,4,5,然后

p

p

p表示把前三个任务分配给第

1

1

1个机器,最后一个任务分配给第

2

2

2台机器,那么此时三台机器的负载就是

[

9

,

5

,

0

]

[9,5,0]

[9,5,0],最大负载为

9

9

9。

那么答案是最少调配一次,即把第 3 3 3个任务(代价是 4 4 4)分配给第 3 3 3台机器,此时三台机器的负载就是 [ 5 , 5 , 4 ] [5,5,4] [5,5,4],达到了最大负载的最小值(即均衡)。

这道题后来我觉得思路可能是先找出最优解 p ∗ p^* p∗,然后判断从 p p p到 p ∗ p^* p∗需要重新调配几次,但是问题的难点在于可能存在负载代价相同的任务,以及 p ∗ p^* p∗很可能不是唯一的,要找出所有的最优解集,再一个个算代价实在是太难了。

所以我后来也没时间思考,先写了暴力搜索的方法,发现实在是太难写,而且肯定过不了时间空间的限制。只好用贪心的方法,即先找到调度1次的最优解,看看是否比调度0次的要好,如果不好就停止,否则在调度1次的最优解基础上再调度1次,以此类推。这种贪心显然是不可能找到最优解的,但是还是可以通过30%的测试输入。

细想总归最多调配 x x x次,但是这个动态规划好难写,如果把调度 k k k次的最优解当作一个状态,这里麻烦的事情就是最优解不唯一的问题,就比如样例输入,也可以调配两次,即把前两个任务都配给第 3 3 3台机器,结果也是 [ 4 , 5 , 5 ] [4,5,5] [4,5,5],这个动态规划就非常困难?

而且这道题控制了机器的数量,如果机器是 y y y台,就更困难了。这种作业调度负载均衡其实是很常见的问题,算法理论里面是严格的证明了贪心算法是 1 / 2 − a p p r o x 1/2-approx 1/2−approx的,这其实很容易证明,但是这里是必须给出精确算法得出最优解,其实就很困难,而且不仅要得到最优解,还得判断最优解跟目前分配的一个最小distance,如果不用暴力搜索,真的有办法求解吗?

20230413

- 最后一练,4000米全力跑(16’09",with嘉伟)+ 1000米放松过渡 + 3000米全力跑(12’07",with东哥,带他测了一下3000米),两段全力跑间歇不到10分钟,没能达成预定的目标,但还挺满意的。嘉伟昨天跑步机PB10km,37’35",周末的半马他大概率能开125,望尘莫及,校运会5000米他估计能把第二给套圈。

- 收拾东西回扬州。

图像大模型之遐想

关于segment anything,终结了语义分割任务,现在已经可以把清明上河图上那种人挤人,从算法角度很难辨别的实体边界的高难度分割问题都完美解决了。segment anything提供了自测图片的demo网站:https://segment-anything.com/demo

从难度上来说,其实图像处理要比文本处理简单,原因是图像的容错更高,无论是生成还是分类,图像的容忍度明显高于文本,文本一个token的差别会直接导致整体语义的变更,但是图像不会因为一个像素或者super pixel的变化而彻底改变整体语义。

然而现在来看图像领域的大一统模型要更难,因为图像处理任务不像自然语言,完全可以归结到文本生成上,语义分割、Image Caption、Text-to-Image,视频摘要等等,很难用一个统一范式去归结这些问题,但是有一个很tricky的方法,就是把一切问题都归结到自然语言的语义上,然后再根据自然语言的语义去生成所需要的内容。

其实现在来看一切似乎可以归结到语义这个概念上,大模型之后似乎前几年很热的知识图谱就没有那么popular了,但我觉得知识图谱才是语义的集大成者,什么incontext learning还是太浮夸了。

20230414~20230415

- 昨天报到时认识一个从广州过来的爷爷,互相给对方拍了个照片,后来正好也是顺路一起坐公交车。临走时我很好奇他多少岁,我猜是快60岁,没想到居然已经66岁,真是老当益壮,这么不远万里来扬州跑马拉松。不过有一说一,扬州这个半马是双金级别的,在所有半马赛事里算是最高规格的一档了,赛会最好成绩是60分钟以内的,虽然每年都是黑人夺冠。

- 今天骑车把半马路线走了一遍,前6km都是以前上高中常走的路,3km处文昌大桥有一个两三百米的长上坡比较难顶,10km进瘦西湖,里面一段平山堂东路坡度非常大,反正景区里不可能一马平川,上下坡是很频繁的,14km出瘦西湖,最后7km是一条直线,平坦开阔,很适合冲刺,就怕在瘦西湖里上上下下跑崩,浪费最后一段好路线。

- 今天天气非常好,这应该是扬州最美的时节了,褪去了寒冬初春的单调料峭,又没到盛夏的高温蒸煮,瘦西湖里一片桃红柳绿,确是烟花三月鸟语花香、景致嫣然的扬州,说起来我都很多年没有看到这个时节的扬州,人与物都是生机勃勃。sxy前天在滨江道骑行21km,大概是交完论文去看房子的,看得出来精神兴致都很好,心平天地宽,应当祝福。

- 最近休息得很好,主场作战,希望能漂亮地完成这场比赛,go!

LRU缓存实现(BM100)

# 方法:哈希表+双向链表(推荐使用)

# 知识点1:哈希表

# 哈希表是一种根据关键码(key)直接访问值(value)的一种数据结构。而这种直接访问意味着只要知道key就能在O(1)O(1)O(1)时间内得到value,因此哈希表常用来统计频率、快速检验某个元素是否出现过等。

# 知识点2:双向链表

# 双向链表是一种特殊的链表,它除了链表具有的每个节点指向后一个节点的指针外,还拥有一个每个节点指向前一个节点的指针,因此它可以任意向前或者向后访问,每次更改节点连接状态的时候,需要变动两个指针。

# 思路:

# 插入与访问值都是O(1)O(1)O(1),没有任何一种数据结构可以直接做到。

# 于是我们可以想到数据结构的组合:访问O(1)O(1)O(1)很容易想到了哈希表;插入O(1)O(1)O(1)的数据结构有很多,但是如果访问到了这个地方再选择插入,且超出长度要在O(1)O(1)O(1)之内删除,我们可以想到用链表,可以用哈希表的key值对应链表的节点,完成直接访问。但是我们还需要把每次访问的key值节点加入链表头,同时删掉链表尾,所以选择双向链表,便于删除与移动。

# 于是我们的方法就是哈希表+双向链表。

#构建双向链表

class Node:

def __init__(self, key, val):

self.key = key

self.val = val

self.pre = None

self.next = None

class Solution:

def __init__(self):

#双向链表头尾

self.size = 0

self.head = None

self.tail = None

#哈希表记录key值

self.mp = dict()

#将节点插入表头函数

def insertFirst(self, node: Node):

node.pre = self.head

node.next = self.head.next

self.head.next.pre = node

self.head.next = node

#移到表头函数

def moveToHead(self, node: Node):

#已经到了表头

if node.pre == self.head:

return

#将节点断开,取出来

node.pre.next = node.next

node.next.pre = node.pre

#插入第一个前面

self.insertFirst(node)

#删去表尾函数,最近最少使用

def removeLast(self):

#哈希表去掉key

self.mp.pop(self.tail.pre.key)

#断连该节点

self.tail.pre.pre.next = self.tail;

self.tail.pre = self.tail.pre.pre

#插入函数

def set(self, key: int, val: int):

#没有见过这个key,新值加入

if key not in self.mp:

node = Node(key, val)

self.mp[key] = node

#超出大小,移除最后一个

if self.size <= 0:

self.removeLast()

#大小还有剩余

else: