k-近邻算法原理

K-近邻算法采用测量不同特征值之间的距离方法进行分类。

• 优点:精度高、对异常值不敏感、无数据输入假定。

• 缺点:时间复杂度高、空间复杂度高。

适用数据范围:数值型和标称型。

工作原理

存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据 与所属分类的对应关系。输人没有标签的新数据后,将新数据的每个特征与样本集中数据对应的 特征进行比较,然后算法提取样本集中特征最相似数据(最近邻)的分类标签。一般来说,我们 只选择样本数据集中前K个最相似的数据,这就是K-近邻算法中K的出处,通常K是不大于20的整数。 最后 ,选择K个最相似数据中出现次数最多的分类,作为新数据的分类。

# -*- coding: utf-8 -*-

# @Time : 2019/11/9 11:46

# @Author :

import pandas as pd

import numpy as np

from sklearn.neighbors import KNeighborsClassifier

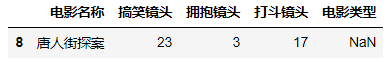

# 准备样本(如图1)

df = pd.DataFrame(data={'电影名称': ['功夫熊猫', '叶问3', '二次曝光', '代理情人', '新步步惊心', '谍影重重', '美人鱼', '宝贝当家', '唐人街探案'],

'搞笑镜头': [39, 3, 2, 9, 8, 5, 21, 45, 23], '拥抱镜头': [0, 2, 3, 38, 34, 2, 17, 2, 3],

'打斗镜头': [31, 65, 55, 2, 17, 57, 5, 9, 17],

'电影类型': ['喜剧片', '动作片', '爱情片', '爱情片', '爱情片', '动作片', '喜剧片', '喜剧片', np.NaN]})

# 获取待求的电影名称的下标

idx = df[df.电影名称 == "唐人街探案"].index

# 样本分离

# 已知电影类型的电影(如图2)

df_konw = df.drop(index=idx)

# 不知电影类型的电影(如图3)

df_test = df.iloc[idx]

# 构建KNN分类器对象,k_neighbors查询默认使用的邻居数

knnclf = KNeighborsClassifier(n_neighbors=5, algorithm='auto')

# 这是一个训练样本集 而且必须是一个二维数组

X_train = np.array(df_konw.loc[:, ["搞笑镜头", "拥抱镜头", "打斗镜头"]])

Y_train = np.array(df_konw["电影类型"])

# 生成训练模型

knnclf.fit(X_train, Y_train)

# 输入测试值

X_test = np.array(df_test.loc[:, ["搞笑镜头", "拥抱镜头", "打斗镜头"]])

# 预测

y_test = knnclf.predict(X_test)

# array(['喜剧片'], dtype=object)

# 输出准确率

# ret = knnclf.score(X_test, y_test)

(图1)

(图2)

(图3)

5441

5441

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?