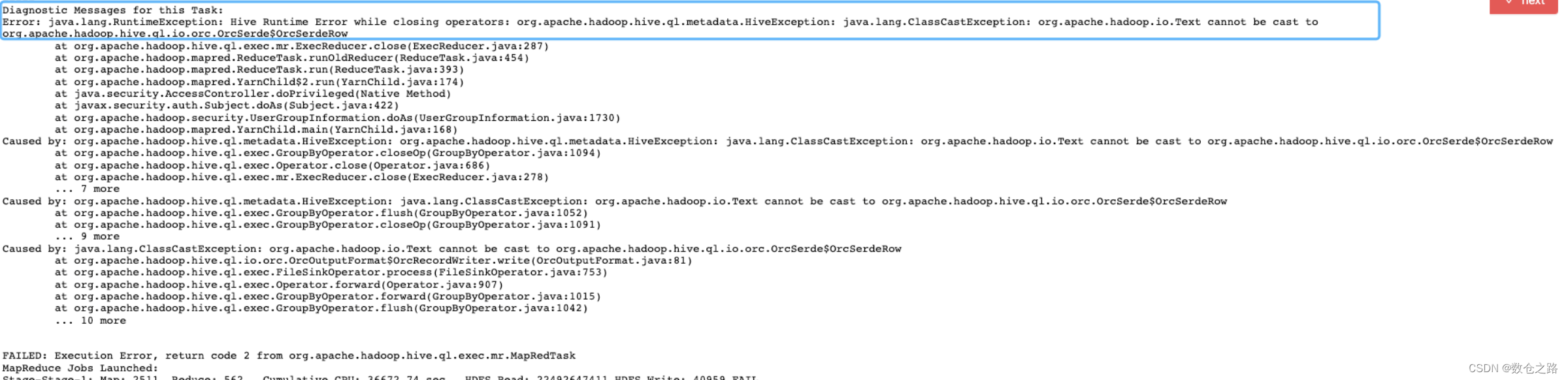

1、报错截图

2、原因分析

该异常发生在insert overwrite阶段,即select出来的数据插入目标表时抛出异常。从异常栈中可以清楚地看到OrcOutputFormat、java.lang.ClassCastException这些信息,可见这是Reduce任务将最终结果进行持久化(写入HDFS文件系统)时出现错误。首先,我们需要明确这个数据持久化的大体流程是什么样的。

Read过程:InputFormat将输入流(InputStream)分割成纪录(<key,value>),Deserializer将纪录(<key,value>)解析成列对象。

Write过程:Serializer将列对象转化为纪录(<key,value>),OutputFormat将纪录(<key,value>)格式化为输出流(OutputStream)。

上图中描绘的分别是数据载入内存和持久化的过程。异常信息中的OrcOutputFormat说明错误出在数据持久化过程中。从图中可知,序列化器Serializer的输出数据,就是OutputFormat的输入数据。接下来就是确定目标表的SerDe/InputFormat/OutputFormat分别是什么。通过下面命令查看。

desc formatted $table结果如下:

Storage InformationSerDe Library: org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe

InputFormat: org.apache.hadoop.hive.ql.io.orc.OrcInputFormat

OutputFormat: org.apache.hadoop.hive.ql.io.orc.OrcOutputFormat由上可知,目标表的SerDe为LazySimpleSerDe,而其Input/OutputFormat是orc的。所以异常的原因也就得出:序列化/反序列化器LazySimpleSerDe在执行serialize后的结果类型是Text,而OrcOutputFormat的接收数据类型必须是OrcSerdeRow。这就造成了ClassCastException。

原因找到后,解决办法就很简单了,将该table的fileformat修改为orc即可,如下所示:

ALTER TABLE $table SET FILEFORMAT ORC;

367

367

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?