目录

事件数据增强方法EventDrop的深入解析与评述

第一章 事件传感器与事件数据基础

1.1 事件传感器原理与特性

事件传感器(如DVS事件相机)是一种仿生传感设备,其工作原理与传统RGB相机存在本质差异:

- 异步触发机制:仅当像素亮度变化超过阈值时触发事件,输出形式为异步离散事件流

- 超高动态范围(140dB vs. 传统相机的60dB)

- 微秒级时间分辨率(时间精度可达1μs)

- 低功耗特性(仅记录变化量,静止场景无数据输出)

异步事件流(Asynchronous Event Stream)是事件传感器输出的特有数据形式,由离散的时空事件构成,具有以下核心特征:

-

触发机制:

- 仅当像素亮度变化超过阈值时触发(ΔL ≥ θ)

- 符合公式:ΔL(x,y,t)=∣L(t)−Llast(x,y)∣>θ

-

数据结构:

每个事件包含四元组:e = (x, y, t, p) - x,y: 像素坐标(整数) - t: 微秒级时间戳(浮点数) - p: 极性(+1/-1,表示亮度增减)

3.与传统数据流对比

| 特征 | 异步事件流 | 传统视频流 |

|---|---|---|

| 数据产生方式 | 事件驱动(变化触发) | 时钟驱动(固定帧率) |

| 时间分辨率 | μs级(1e-6秒) | ms级(1e-3秒) |

| 数据密度 | 稀疏(仅记录变化) | 稠密(全帧记录) |

| 动态范围 | 140dB(可同时看清强光和阴影) | 60dB(普通CMOS) |

| 功耗 | <10mW(静态场景零功耗) | 100mW~1W |

| 典型应用场景 | 高速运动、极端光照 | 常规视频监控 |

PS:极性(Polarity)是事件相机特有的测量维度,表示像素点亮度变化的数学符号:

- +1(ON事件):亮度增加超过阈值(ΔL>+θ)

- -1(OFF事件):亮度减少超过阈值(ΔL<−θ)

1.2 事件数据表示方法

由于传统DNN(指深度神经网络Deep Neural Network,具体特指传统基于同步数据处理的深度学习架构如CNN、ResNet等)无法直接处理异步事件流,需进行结构化表示转换:

| 表示方法 | 维度 | 特征保留情况 | 数学表达 |

|---|---|---|---|

| Event Frame | 2D | 空间分布(丢失时间信息) | 式(2)直方图统计 |

| Event Count | 2D×2 | 极性分离的空间分布 | 式(4)分极性统计 |

| Voxel Grid | 3D | 时空联合分布(固定时间分箱) | 式(5)时间分箱统计 |

| EST | 4D | 时空极性联合分布(可微分处理) | 式(7)三线性核函数卷积 |

图1展示了不同表示方法的可视化对比,其中EST通过可学习的核函数实现了最优时空特征保留。

第二章 EventDrop方法详解

2.1 核心创新动机

- 数据稀缺性:事件数据集规模普遍较小(N-Caltech101仅8,709样本)

- 传感器噪声模拟:实际应用中事件触发存在随机性

- 遮挡鲁棒性需求:现实场景中动态遮挡频繁发生

2.2 事件丢弃策略

提出三种基础丢弃策略及其组合应用:

2.2.1 随机丢弃(Random Drop)

- 操作方式:随机删除 ρ 比例事件(ρ∈[0.1,0.9])

- 数学建模:

- 作用:模拟传感器噪声,增强模型对事件缺失的鲁棒性

2.2.2 时间窗口丢弃(Drop by Time)

- 参数设置:随机选择时间窗口

,窗口长度

- 实现逻辑:保留窗口外事件

- 应用场景:模拟时域遮挡(如快速移动物体遮挡)

2.2.3 空间区域丢弃(Drop by Area)

- 区域选择:随机矩形区域(x0,y0,ρW,ρH),ρ∈[0.05,0.3]

- 数学表达:

- 功能价值:模拟空间遮挡,提升局部特征识别能力

2.3 算法实现细节

- 策略选择机制:每次随机选择一种操作(含Identity),概率均等

- 参数离散化:时间/空间参数分9级离散(保证实验可重复性)

- 计算复杂度:

时间复杂度,适合实时处理

第三章 实验验证与效果分析

3.1 实验设置

-

基准数据集:

- N-Caltech101(模拟场景分类)

- N-Cars(真实场景车辆检测)

-

对比模型:

- 经典CNN架构:ResNet-34, VGG-19, MobileNet-V2, Inception-V3

- 事件表示方法:Event Frame, Event Count, Voxel Grid, EST

-

训练参数:

- 优化器:Adam(lr=1e-4, 每10 epoch衰减0.5)

- Batch Size:4(适配事件数据特性)

| 参数 | 值/范围 |

| 迭代次数 | 200 |

| 学习率衰减 | 每10次衰减0.5倍 |

| 数据增强概率 | 0.25/策略 |

3.2 实验结果

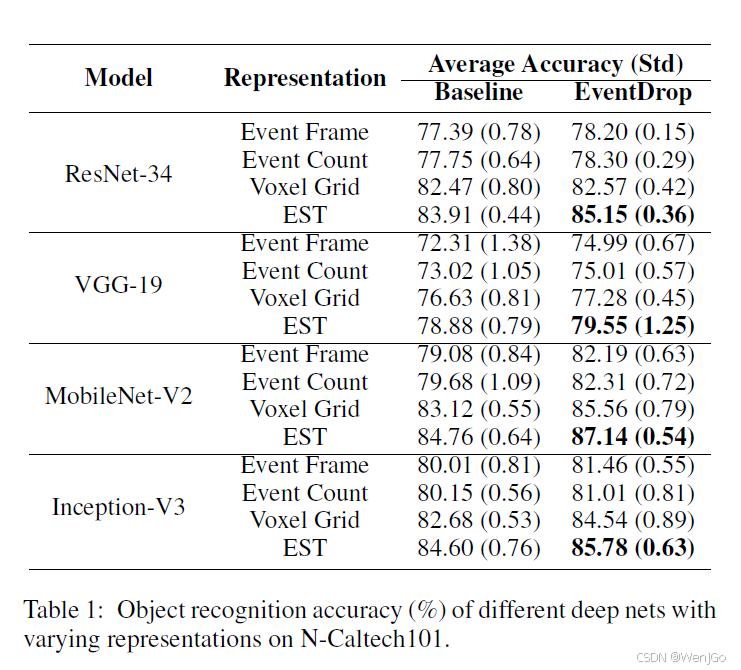

对于表1源自论文原文:

在N-Caltech101数据集上:

- MobileNet-V2+EST组合达到最高87.14%准确率(提升2.38%)

- 所有模型平均提升1.2-3.1%

对于表2源自论文原文:

在N-Cars数据集上:

- ResNet-34+EST组合提升4.47%(95.50% vs 91.03%)

- 真实场景提升幅度显著大于模拟场景

3.3 策略对比实验

表3深入分析各策略的独立效果:

- 时间丢弃:在N-Cars上效果更显著(真实场景时域动态性更强)

- 区域丢弃:对EST表示提升最大(保留时空特征能力更强)

- 组合策略:综合效果优于单一策略(平均提升2.15%)

第四章 理论贡献与扩展应用

4.1 方法论创新点

- 首个系统化的事件数据增强框架

- 多维度丢弃策略组合:时域+空域+随机噪声

- 零参数学习:无需额外训练,即插即用

4.2 理论意义

- 揭示了事件数据冗余特性与模型泛化的内在联系

- 证明了时空调制对事件处理模型的重要性

- 为SNN训练提供了新的数据增强思路

4.3 应用前景

- 扩展任务:视觉里程计、SLAM、动态目标跟踪

- 硬件适配:可集成至事件相机预处理管线

- 跨模态融合:与RGB数据增强方法结合

第五章 局限性与未来方向

5.1 现有局限

- 丢弃策略参数依赖经验设置

- 未考虑事件密度分布特性

- 对极端遮挡场景模拟能力有限

5.2 发展方向

- 自适应丢弃策略:基于注意力机制的动态丢弃

- 物理仿真增强:结合光学模型的真实遮挡模拟

- 脉冲神经网络适配:开发SNN专用增强方法

结语

EventDrop通过创新性的事件丢弃策略,有效解决了事件数据稀缺导致的模型过拟合问题。实验证明其在不同网络架构和事件表示方法中具有显著普适性,为事件驱动型AI系统的发展提供了重要方法论支撑。随着神经形态计算的快速发展,此类数据增强方法将在边缘智能、机器人感知等领域发挥更大价值。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?