原作出至:http://blog.csdn.net/u012453843/article/details/52433457

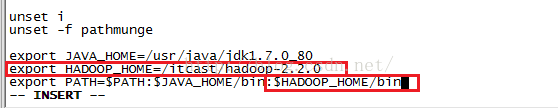

上节我们修改了5个配置文件,这节我们开始学习Hadoop初始化和测试,首先我们需要Hadoop的环境变量,输入命令:vim /etc/profile并按回车进入配置文件,如下图所示,我们添加的内容是下面红色圈住的内容。

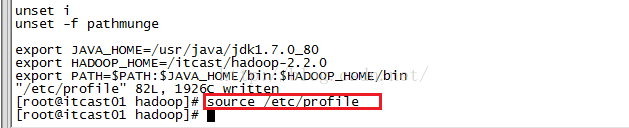

编辑完之后我们按ESC键进行退出编辑,然后输入:wq保存并退出该文件,然后我们输入命令source /etc/profile来使配置起作用,如下图所示。

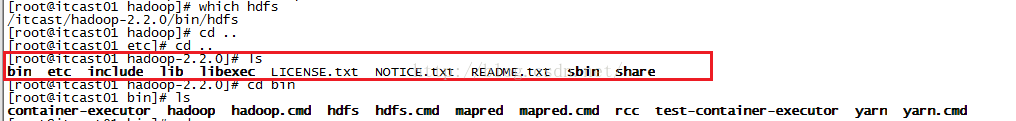

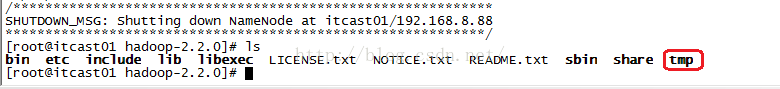

接下来我们开始初始化HDFS(格式化文件系统),格式化之前我们先到hadoop2.2.0目录,查看下该目录下都有哪些文件,从下图我们可以看出目前并没有tmp这个目录。

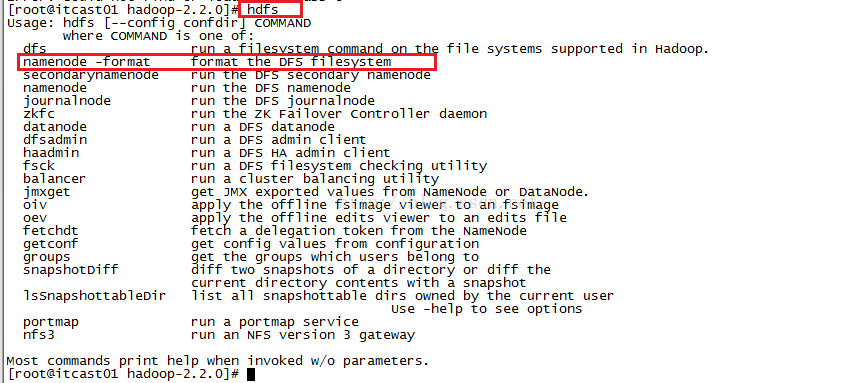

格式化文件的命令如果我们不知道的话,可以输入hdfs之后按回车,看提示信息,如下图所示,我们可以知道格式化的命令是hdfs namenode -format

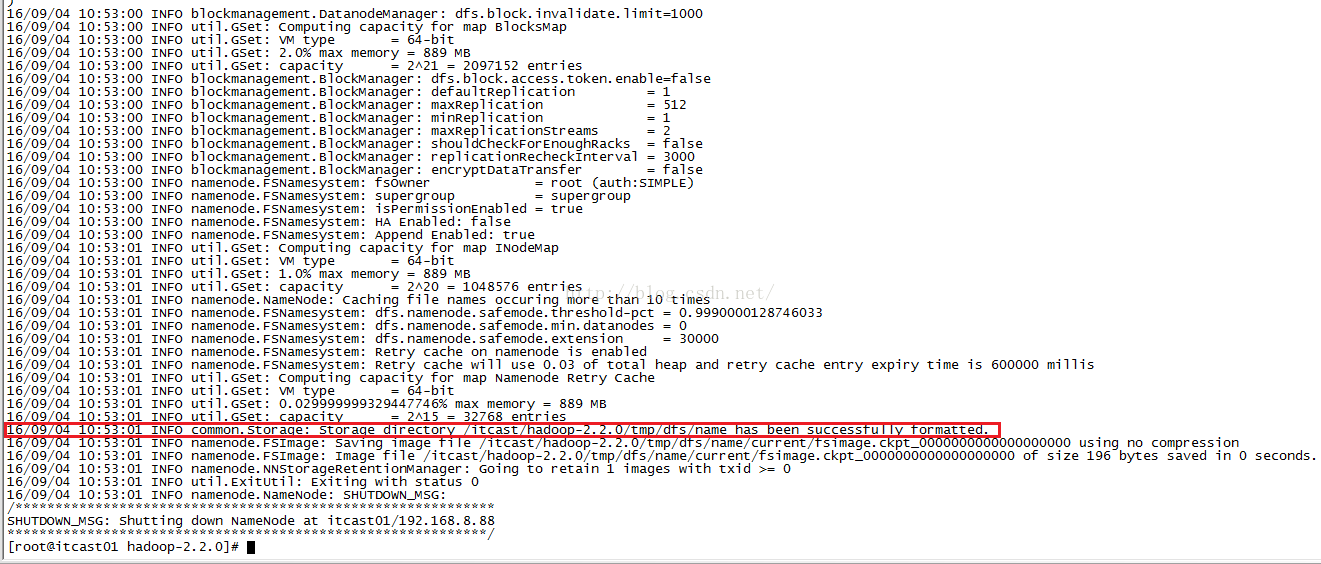

我们输入命令hdfs namenode -format并按回车后就开始进行格式化了,格式化完之后我们如果从信息中看到如下红色圈住的内容(/itcast/hadoop-2.2.0/tmp/dfs/name has been successfully formatted)说明格式化成功了!

格式化完之后,我们再来看看hadoop-2.2.0目录下的文件列表,我们可以看到列表中已经有tmp这个目录了。

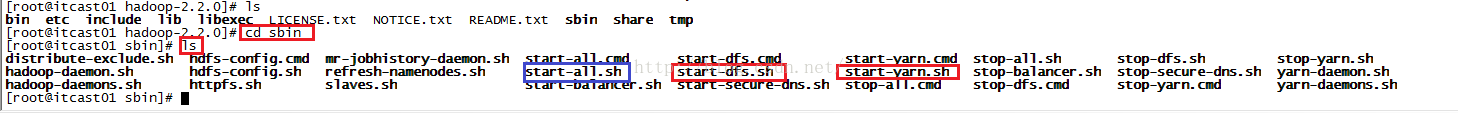

接下来我们开启hdfs和yarn,首先我们进入sbin目录,然后查看都有哪些脚本,我们发现有很多脚本,其中我们用到的是start-dfs.sh、start-yarn.sh,当然,我们也可以直接用start-all.sh(不过已经过时了)来启动,如下图所示。

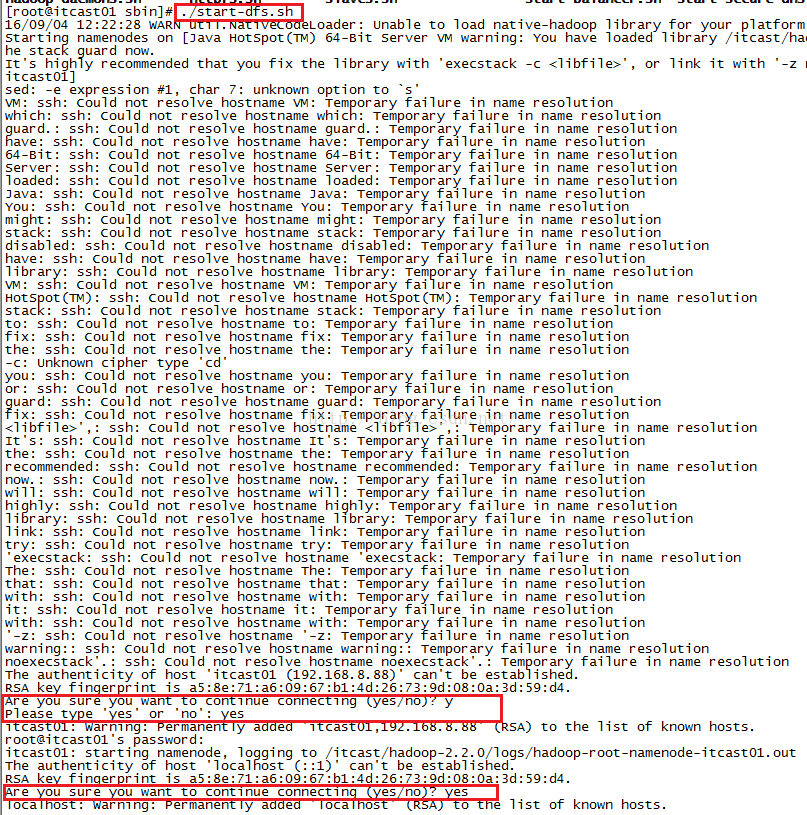

我们先启动dfs,输入命令./start-dfs.sh并按回车,启动过程中会多次让你输入yes和root账号的密码,如下图所示。

启动完start-dfs.sh之后,我们接着启动start-yarn.sh,如下图所示。

本文详细介绍了如何进行Hadoop的环境配置,包括添加环境变量、HDFS的格式化、启动HDFS和YARN,以及通过浏览器验证HDFS和YARN管理界面。此外,还展示了使用HDFS进行文件上传、下载,并通过MapReduce的wordcount实例测试Hadoop的功能。

本文详细介绍了如何进行Hadoop的环境配置,包括添加环境变量、HDFS的格式化、启动HDFS和YARN,以及通过浏览器验证HDFS和YARN管理界面。此外,还展示了使用HDFS进行文件上传、下载,并通过MapReduce的wordcount实例测试Hadoop的功能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

874

874

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?