我不允许还有人WPS接入deepseek不成功!附源码及详细教程

一、写在前面

今天刚好兴趣来了,想试试在wps中接入本地部署的deepseek大模型,网上看了很多帖子,评论区清一色不成功,于是用deepseek生成了一下代码,测试成功,记录一下。

安装测试环境:win11+wps365+ollama+deepseek1.5b。

二、本地化部署ollama+deepseek

参考我的这篇文章:Windows系统基于ollama+anythingLLM本地化部署deepseek 第二、三章节。

三、配置WPS

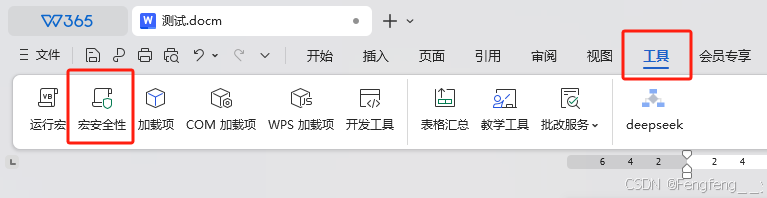

1、宏安全性设置

新建文档、打开工具、宏安全性,设置为低,确定。点击开发工具。如无此按钮,需在文件、选项、自定义功能区中将缺失按钮勾选。

2. 插入代码

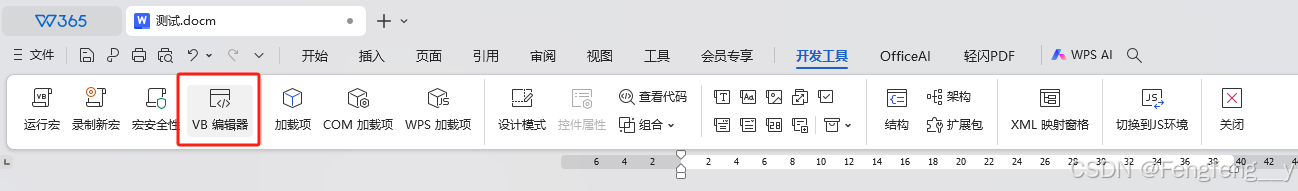

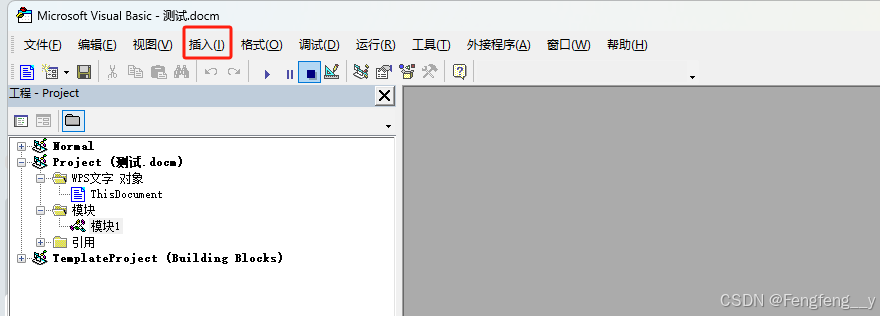

打开VB编辑器

方式一: 文件导入

下载下面百度网盘文件后,选择左上角文件、导入文件,选择所下载的文件。

链接: https://pan.baidu.com/s/16pOZ2WGyOHgG8EfJJZcluA?pwd=2468 提取码: 2468

方式二: 代码编辑

点击插入、模块、修改模块名为deepseek。

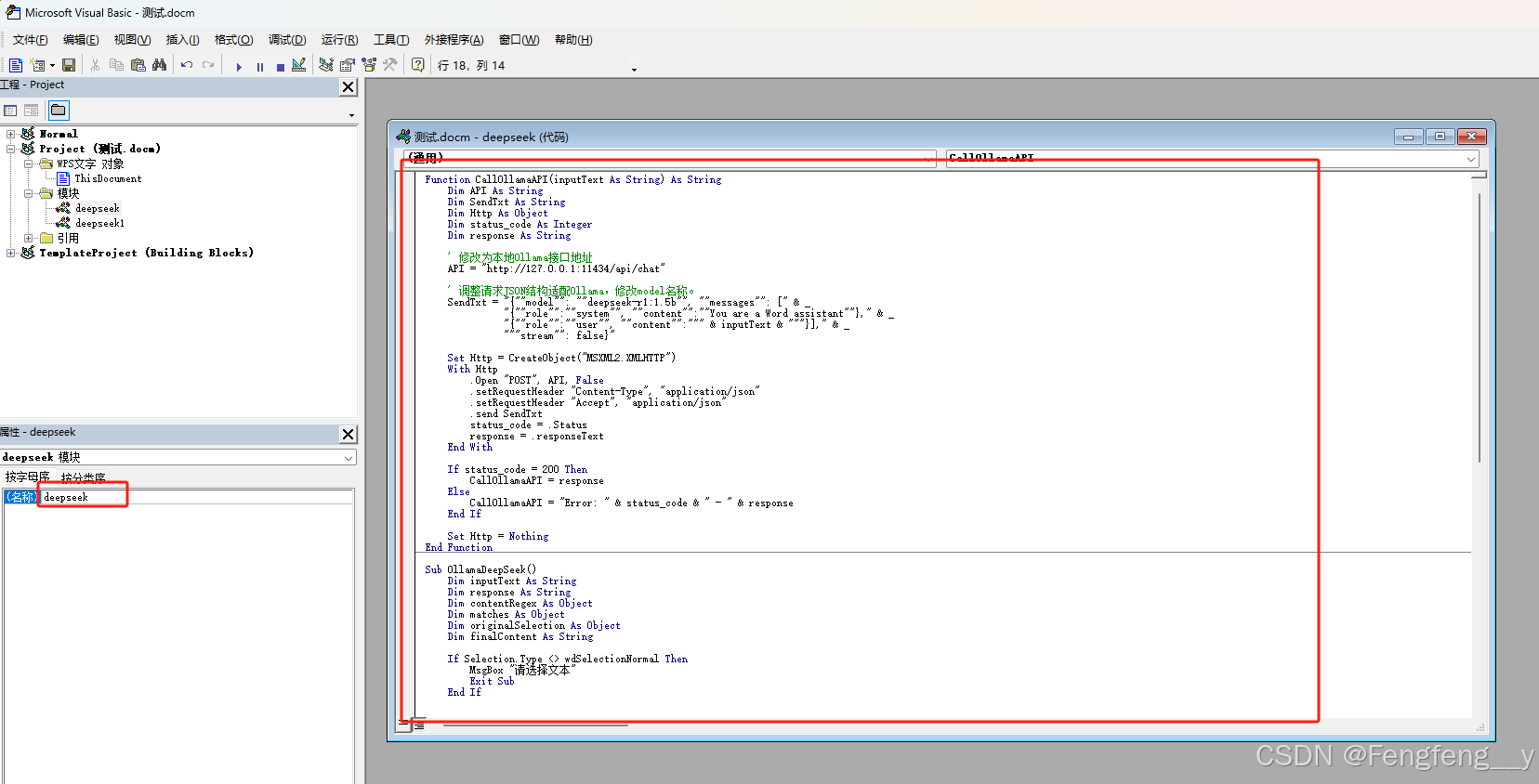

复制以下代码并粘贴至编辑区并保存。

// wps调用本地ollama代码。

Function CallOllamaAPI(inputText As String) As String

Dim API As String

Dim SendTxt As String

Dim Http As Object

Dim status_code As Integer

Dim response As String

' 修改为本地Ollama接口地址

API = "http://127.0.0.1:11434/api/chat"

' 调整请求JSON结构适配Ollama,修改model名称。

SendTxt = "{""model"": ""deepseek-r1:1.5b"", ""messages"": [" & _

"{""role"

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?