原文链接:https://arxiv.org/pdf/2202.09389.pdf

evasion attack

1 Abstract & Introduction

本文将节点注入攻击建模为一个马尔可夫决策过程,并提出了一种基于 advantage actor critic 的图增强学习框架 GA2C,以生成注入节点的真实特征,并将它们无缝地合并到具有相同拓扑特征的原始图中。

本文使用黑盒攻击。这种攻击可以简单地认为是一个具有指数级大搜索空间的搜索过程,可以用蛮力搜索来解决。但是,从实用性的角度来看,应该使用一个近似搜索过程最优解的机器学习辅助框架。为了解决上述问题,基于高级行为批评家(advanced actor critic, A2C),本文提出了一个基于增强学习的攻击框架,即 GA2C,该框架只需要从受害者模型中查询。具体来说,将节点注入攻击描述为马尔可夫决策过程(MDP),攻击被解耦为节点生成和边连接。在节点生成阶段,通过 Gumbel-Softmax 的一种特殊情况,将不易察觉的离散特征归因于对抗节点。在边连接阶段,注入节点和剩余图之间的边从一个可学习的条件概率分布中采样。

Contributions:

第一个黑盒设置下的节点注入攻击(存疑)。将节点注入攻击设置成 MDP,并使用奖励函数,提出了一个图增强学习框架 GA2C,在极有限的黑盒设置下近似最优解。具有较高的攻击效率。

2 Preliminary

2.1 GNN

GCL 表示图卷积层。

2.2 Graph Adversarial Attack

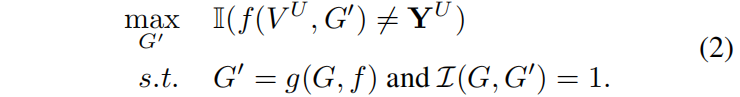

![]() 可以是测试节点集或感兴趣的节点;

可以是测试节点集或感兴趣的节点;![]() 是返回真实条件的指示函数;

是返回真实条件的指示函数;![]() 是一个指示函数,如果两个图在分类语义下是等价的,就返回1。

是一个指示函数,如果两个图在分类语义下是等价的,就返回1。![]() 是 GNN 模型,

是 GNN 模型,![]() 是攻击者。

是攻击者。

攻击一个节点时注入节点(对抗节点)数![]() ,对抗节点度数

,对抗节点度数![]() ,对抗节点的特征数

,对抗节点的特征数![]() 。于是 Eq.(2) 中的指示函数就变成了

。于是 Eq.(2) 中的指示函数就变成了

3 Methodology

原始干净图![]() ,对抗节点

,对抗节点![]() ,对抗节点的属性

,对抗节点的属性![]() 。在注入节点

。在注入节点![]() 后,攻击者 g 产生对抗边

后,攻击者 g 产生对抗边![]() 来逃避 GNN f 对节点

来逃避 GNN f 对节点![]() (无标签节点)的检测。

(无标签节点)的检测。![]() 是被攻击的图,其中

是被攻击的图,其中![]()

![]() ,

,![]() 是追加操作。

是追加操作。

注入节点涉及生成离散的图数据,如离散的邻接矩阵或特征矩阵,基于梯度的方法在很多情况下处理效果较差。这种现象可能会因黑盒设置而进一步恶化,其中代理模型的梯度信息是不准确的。此外,生成节点和分配边是顺序的,增强学习适合这种马尔可夫决策过程(MDP)。为了处理 Eq.(2) 的优化任务,本文提出探索深度增强学习(Deep Reinforcement Learning)。具体来说,采用了 on-policy A2C(Advantage Actor Critic) 的增强学习框架,该框架改编自 [Mnih et al.,2016],而不是如 deep Q-learning 的 off-policy 算法。由于 A2C 避免了计算每个可能的特征组合的预期未来值的需要,这些组合是指数级大的(如,Q learning 计算![]() Q 值,在通常选择

Q 值,在通常选择![]() 和

和![]() 时,超过了

时,超过了![]() 种可能性;然而 on-policy A2C 只需要一个步骤)。

种可能性;然而 on-policy A2C 只需要一个步骤)。

GA2C 的概述如图 1 所示。给定图 G 和目标节点

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?