HBase架构介绍:

zookeeper:

可以帮助master分解压力,对数据的读写可以不经过master,但对regoin的分配还有其他一些元数据时, 是必须需要master的.

Master: 主要用于对元数据的修改;

HLog:

对数据丶元数据等的操作, 都会先记录在HLog当中, 一般情况是不会访问的,但当机器故障,导致内存中的数据没有flush出去, 这时候就会读取Hlog恢复数据.

regoin:

对数据进行横向切割,切成一个个的regoin,便于数据的查找等

store:

store其实就是一个一个的列族, 每个store都会存放在单独的文件夹,有利于高效查找

Mem store :

对数据的修改会都先放在内存中, 当达到某些定值条件(时间或者文件大小或者正常关闭), 内部通过HDFS Client 写入到hdfs上去,这些每次都会生成文件,这样就会出现很多的小文件,内部会将小文件进行合并, 当文件大小达到一定的数值, 又会进行分切( 内部会一直做合并,分割操作)

优点: 放在内存上的效率快

HFile : 只是一种文件的格式

稀疏性

mysql : 当数据为空时,使用默认值null进行填写,浪费存储空间

hbase: 你可以指定任意多的列,在列数据为空的情况下,是不会占用存储空间的

WAL文件说明

可以去查看: wal文件详解

写流程

文字说明:

当我们需要put写入数据时, zk的/hbase/meta-regoin-server上存放着meta的文件存放节点位置(meta也是一个regoin),先去拿到meta的数据, 并将meta的数据记载到内存中, meta记录着各个regoin数据的节点存放位置. 一个表也可能有多个regoin.找到需要写入的regoin的位置,先将操作写到wal(HLog用于数据修复)当中,再写入到对应的store的内存中,当达到一定条件,会刷写到hdfs当中

注意:其实是先构建wal,再写入到内存中,然后进行wal进行同步,如果因为故障,同步失败,就会事务回滚, 只有写入到内存和同步wal一起完成,才算写入成功.

Flush 流程(触发条件)

触发条件:

- 当单个memstore内存达到**hbase.hregion.memstore.flush.size(默认128M)**大小,将当前memstore进行刷写

- 当regoinserver 的memstore总大小达到:

java_heapsize*hbase.regionserver.global.memstore.size(默认值 0.4)*hbase.regionserver.global.memstore.size.lower.limit(默认值 0.95)

说明: 其实为了防止写速度比刷写速度快,达到40%的95%就会开始刷写,达到java堆内存的40%就会进入阻塞状态,禁止客户端写入到memstore

- 当时间达到hbase.regionserver.optionalcacheflushinterval(默认60分钟), 一小时没写入数据也会进行flush

- 当 WAL 文件的数量超过hbase.regionserver.max.logs,region 会按照时间顺序依次进行刷写,直到 WAL 文件数量减小到 hbase.regionserver.max.log 以下(该属性名已经废弃,现无需手动设置,最大值为 32)。

读数据流程

文字介绍流程:

1)Client 先访问 zookeeper,获取 hbase:meta 表位于哪个 Region Server。

2)访问对应的Region Server,获取 hbase:meta 表,根据读请求的namespace:table/rowkey,查询出目标数据位于哪个 Region Server 中的哪个 Region 中。并将该 table 的 region 信息以及 meta 表的位置信息缓存在客户端的 meta cache,方便下次访问。

3)与目标 Region Server 进行通讯;

4)分别在 Block Cache(读缓存),MemStore 和 Store File(HFile, 磁盘)中查询目标数据,并将查到的所有数据进行合并。此处所有数据是指同一条数据的不同版本(time stamp)或者不同的类型(Put/Delete)。

5) 将从文件中查询到的数据块(Block,HFile 数据存储单元,默认大小为 64KB)缓存到

Block Cache。

6)将合并后的最终结果返回给客户端。

block多个版本问题(重要):

HBase是多版本共存的,有多个版本的rowKey那说明这个rowKey会存在多个Block中,其中一个已经在BlockCache中,则省去了一次IO,但是其他Block的IO是无法省去的,它们也需要加载到Block Cache,然后多版本合并,获得需要的版本返回。解决多版本的问题,也是rowKey需要先定位Block然后才去读BlockCache的原因。

文件合并(compact)

minor compaction (小合并)

- 选取部分小的、相邻的HFile文件,形成一个较大的HFile文件。

- 小合并并不会进行过期数据的清除工作。

major compaction(大合并)

- 合并所有的HFile文件为一个大的HFile文件

- 大合并会清理TTL过期数据、超出设定版本号的数据以及delete标记的数据

- 一般是手动进行,将参数

hbase.hregion.majorcompaction的值设为0,表示禁用major compaction。其默认值为7天,允许上下浮动hbase.hregion.majorcompaction * hbase.hregion.majorcompaction.jitter的值,后者默认是0.5。即[7 - 70.5, 7 + 70.5]

触发条件:

minor compaction的运行机制要复杂一些,它由一下几个参数共同决定:

-

hbase.hstore.compaction.min:默认值为 3,表示至少需要三个满足条件的store file时,minor compaction才会启动 -

hbase.hstore.compaction.max默认值为10,表示一次minor compaction中最多选取10个store file -

hbase.hstore.compaction.min.size表示文件大小小于该值的store file 一定会加入到minor compaction的store file中 -

hbase.hstore.compaction.max.size表示文件大小大于该值的store file 一定会被minor compaction排除 -

hbase.hstore.compaction.ratio将store file 按照文件年龄排序(older to younger),minor compaction总是从older store file开始选择,如果该文件的size 小于它后面hbase.hstore.compaction.max个store file size 之和乘以 该ratio,则该store file 也将加入到minor compaction 中。 -

后台线程轮询 ,HBase后台线程CompactionChecker 会定期检查是否需要执行compaction,检查周期为两个参数乘积:

major compact触发条件:

major_compact 命令、majorCompact() API、region server自动运行(相关参数:hbase.hregion.majorcompaction 默认为7天)。

注意:一般这个在生产中都会关闭,因为大合并 执行时间长,且消耗资源大,一般都在业务较少的时间进行手动合并

操作

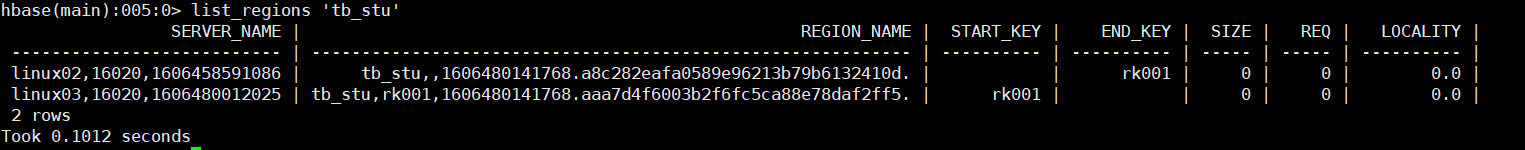

命令行查看表的regoin信息:

list_regions 'tb_stu'

进行合并:

merge_region 'a8c282eafa0589e96213b79b6132410d','aaa7d4f6003b2f6fc5ca88e78daf2ff5'

这个合并是大合并,会占用资源

或者直接使用 compact 或者 major_compact 进行合并

数据的真正删除时间(标记,过期的数据)

- 相同的内存(memstore )当中,flush之前会进行删除相同的数据(但不会删除标记)

- 文件进行合并的时候, 会删除过期的数据和标记,这个时候的删除

split触发:

Region Split 时机:

-

当1个region中的某个Store下所有StoreFile的总大小超过hbase.hregion.max.filesize, 该 Region 就会进行拆分(0.94 版本之前)。

-

当 1 个 region 中 的 某 个 Store 下所有 StoreFile 的 总 大 小 超 过 Min(R^2 * “hbase.hregion.memstore.flush.size”,hbase.hregion.max.filesize"),该 Region 就会进行拆分,其中 R 为当前 Region Server 中属于该 Table 的个数(0.94 版本之后)。切割后, split会越来越大,后面就知道到达10G了

这样的话,就会容易出现负载均衡问题了 ,

例: node1 上存着一些几十M的文件,node2上却存着9.9G的文件

解决: 可以使用数据预分区的方式来解决

问题:

- 当使用多个列族的时候,(逻辑问题)可能出现下面情况,导致大量的小文件需要合并

2009

2009

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?