众所周知,DeepSeek最近火出天际。它推出后迅速登顶了App Store和Google Play排行榜。但是随之而来也有很多问题。大家在使用过程中会发现提问两三个问题后就会频繁收到“服务器繁忙,请稍后再试”的提示,这个问题非常影响使用,让各地用户都很抓狂。

目前最有用的替代方法是用本地部署,然而对于一些新手小白来说,本地部署也是一件繁琐的事情,可能看了很多教程,尝试了很多次,都不一定能成功部署一个大型模型出来。

我想要分享一下工作中使用 AI 冷门野路子,非常简单,即使小白或者没有编程经验也可以马上学会,但请注意此方法目前只适用于macOS系统,Windows 用户就没这个福气了。

一个偶然的机会,我发现平时开发使用的ServBay更新了,它的新版本支持了Ollama。而Ollama 是一个专注于在本地运行大型语言模型(LLMs)的工具。它支持DeepSeek-r1,llama,solar,qwen等等知名AI大模型。

所以你们明白我的意思了吗?也就是说,只要安装了ServBay就可以一键启用这些打包好的常用AI大模型,并且响应速度都不差。

本来Ollama需要通过复杂的流程去安装和启动服务的,但是通过ServBay,只需要一键点击就能启动,安装你所需要的AI模型,不用再考虑环境变量配置的问题。就算是对开发一窍不通的普通用户,也可以点一下就能用。一键启动和关闭,多线程快速下载模型,只要你的 macOS 够用,同时跑多个AI大模型也没问题。

在我的电脑上,下载速度甚至超过了每秒 60MB,秒杀各种其他同类工具,有图有真相。

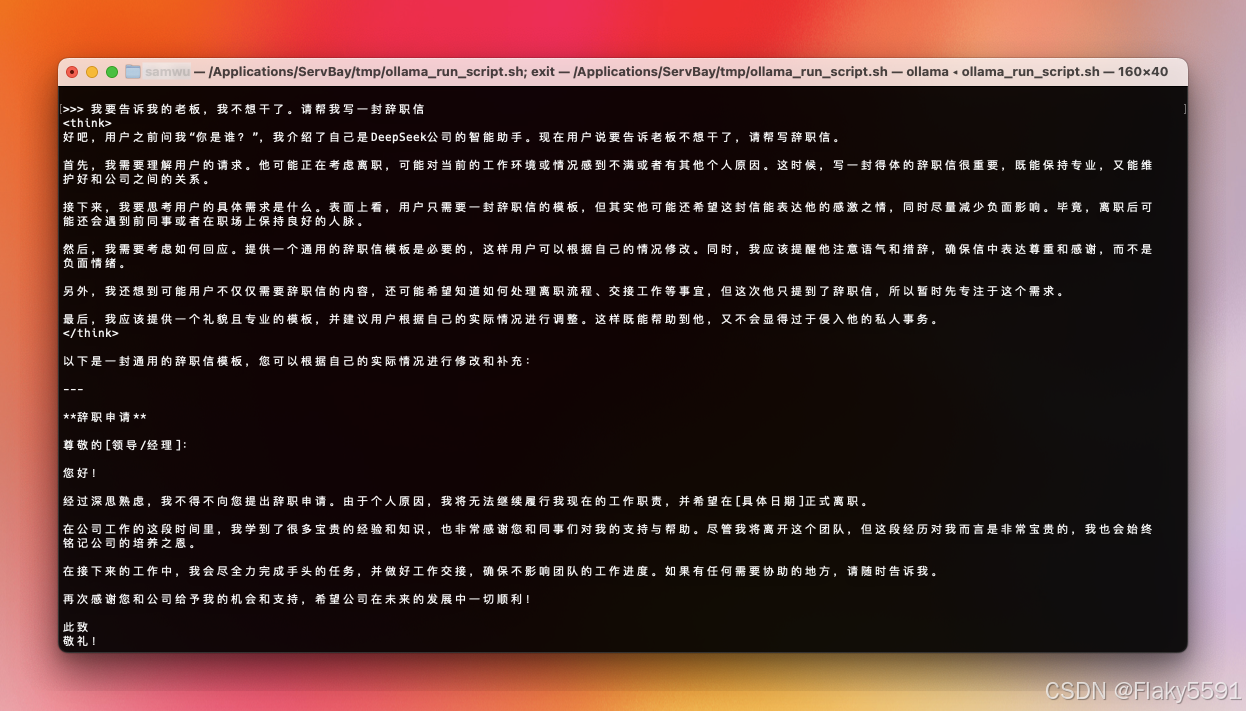

就这样,通过ServBay及Ollama,我就可以在本地部署我的DeepSeek了。看,它运行良好。

瞧!我通过ServBay实现了DeepSeek自由~

对了,最近美国国会已经提出新法案,下载DeepSeek将被定为犯罪,最高判处20年监禁!但是,通过本地部署,离线使用,是不是就可以。。奥,请原谅我脑洞又大开了LOL。。

7486

7486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?