在当今计算领域中,PC集群和Stable Diffusion技术的应用已经成为不可或缺的一部分。这些技术在深度学习、AI绘画、高性能计算、人工智能、大数据、ChatGPT、AIGC等领域中都具有重要的应用价值。特别是在AI生成式内容创作方面,使用PC集群和Stable Diffusion技术可以有效解决大型计算任务所带来的挑战,并实现高质量的生成式AI内容。

通过结合这些技术的创新应用,我们可以更好地利用大规模的训练数据来调整和训练生成式AI模型,以提高其生成质量和准确性。同时,借助创新的加速技术和稳定扩散模型,可以提高AI生成式内容的生成速度和质量。比如,使用PC集群和Stable Diffusion技术配合AI生成式技术可以快速地生成高品质的图像、视频、音乐等内容,节约用户时间和精力,提高生产效率和创作效果。

另外,在企业和办公室环境中,PC集群也是一种非常有效的计算资源管理方法。该方法将任务分解成小的子任务,并分配给不同的计算节点进行处理,提高了计算效率和速度。通过使用PC集群,企业可以降低硬件和维护成本,并实现更高的计算性能和吞吐量,以满足不同任务的需求。同时,PC集群还具有容错机制和易于管理的优点,使得企业能够保持高效的生产和数据访问,减少停机时间和数据丢失风险。

蓝海大脑PC集群解决方案是为了满足用户在进行高性能计算和人工智能相关任务时,基于高效、稳定、易于管理的部署方式而设计的。它采用4U机架式设计,每个机架可插拔4个PC节点,兼具服务器的稳定性和PC的高主频、高性价比的特点,使得用户既可以享受到高性能的计算能力,同时也能够控制相关成本开支。

此外,还集成了Stable Diffusion AI模型,该模型可以帮助用户快速生成高品质的创作内容。相较于传统的人工创作方式,Stable Diffusion Al模型具有更快的产出速度和更高的品质保证,这对于那些需要不断地生产创意和创作内容的用户来说是非常有益的。并且,由于该模型将AI技术应用到了创意生产领域,它对于优化创意生产流程,为企业降低创意生产成本等方面也具有重要意义。

同时在设计上也充分体现了可维护性与升级性。该解决方案采用了模块化可插拔设计,使得维护和升级变得更加容易。这不仅可以为用户节省时间和精力,同时也可以降低因为硬件故障或者设备升级等因素带来的生产中断和数据丢失的风险。

在本文中,我们将介绍生成式AI技术以及Stable Diffusion的原理和应用。同时,我们还将介绍如何使用PC Farm来加速模型的训练,以及如何优化模型的性能。我们希望通过本文的介绍,能够帮助读者更好地理解生成式AI技术,并且能够在实际应用中取得更好的效果。

Stable Diffusion教程

一、背景

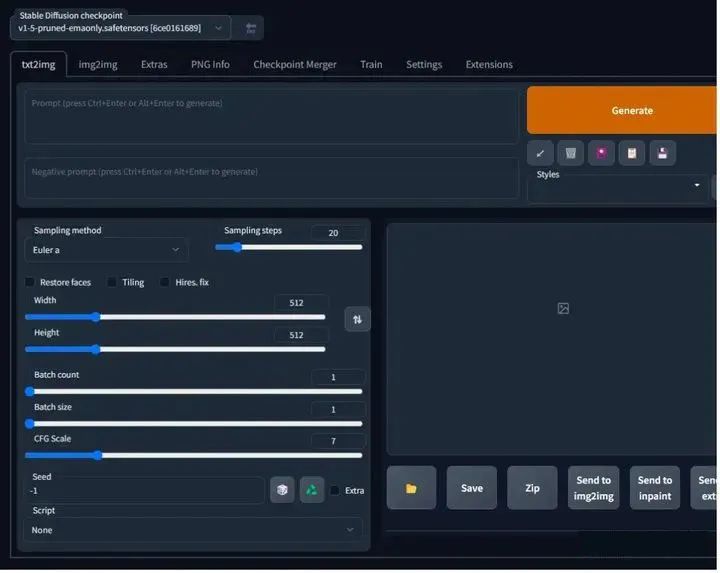

Stable Diffusion是2022年发布的深度学习文本到图像生成模型,可根据文本描述生成详细图像。尽管官方项目不适合新手直接使用,但一些基于Stable Diffusion封装的WebUI开源项目已经出现,使得通过交互式界面使用Stable Diffusion变得更加容易。以下是几个比较热门的WebUI项目:github.com/AUTOMATIC11…和github.com/Sygil-Dev/s…。其中,AUTOMATIC1111的Stable Diffusion WebUI拥有最多的功能和最好的易用性,强烈推荐使用。

二、配置要求

要顺利运行stable-diffusion-webui和模型, 需要足够大的显存,最低配置4GB显存,基本配置6GB显存,推荐配置12GB显存。

三、安装Stable Diffusion模型

关于Stable Diffusion的安装方式,小编在之前的文章中已经有了详细介绍。这里小编就不多做介绍,大家如果感兴趣,可以加小助手微信发送安装教程。

四、启动项目

完成安装配置后,只需直接运行工程下的webui-user.bat文件(或在类Unix系统中运行webui-user.sh),即可开始使用。可以通过执行命令.\webui.bat --theme dark来启动WebUI,并设置主题为dark。

1、启动的是夜间模式(不加theme参数就是日间模式)

首次启动时,系统将自动下载项目所需的Python依赖库(具体哪些库请见工程下的requirements.txt),以及相应的配置和模型文件(例如v1-5-pruned-emaonly.safetensors,约4GB大小)。这个过程可能需要一些时间。完成初始化后,下次启动就会更快了。如果输出中显示Launching Web UI with arguments: … Running on local URL: http://127.0.0.1:7860,则表示启动成功。可以打开指定的网址来使用程序的运行界面。要创建公共链接,请在launch()函数中设置参数share=True。

2、tips:如何安装webUI简体中文语言包

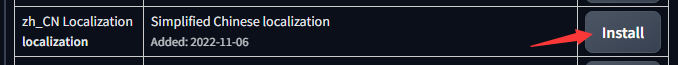

此扩展可以在 Extension 选项卡里面通过加载官方插件列表直接安装

3、官方下载

-

点击 Extension 选项卡,点击 Avaliable 子选项卡

-

取消勾选localization,再把其他勾上,然后点击 橙色按钮,如下图

- 在 zh_CN Localization 这一项的右边点击 install

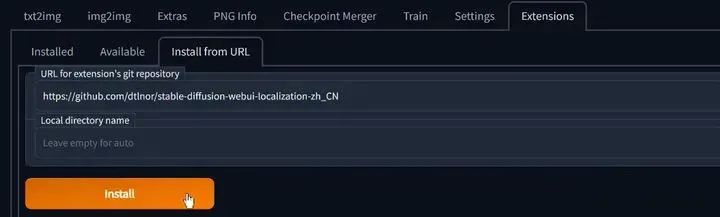

4、通过网址安装

-

点击 Extension 选项卡,点击 Install from URL 子选项卡

-

复制本 git 仓库网址:

https://github.com/dtlnor/stable-diffusion-webui-localization-zh_CN

- 粘贴进 URL 栏,点击 Install,如图

5、配置

-

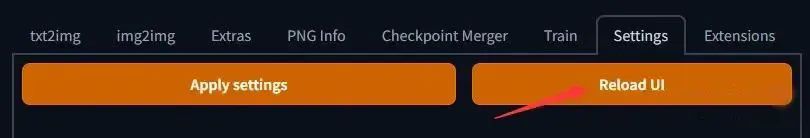

重启webUI以确保扩展已经加载了

-

在 Settings 选项卡,点击 页面右上角的 橙色Reload UI按钮 刷新扩展列表

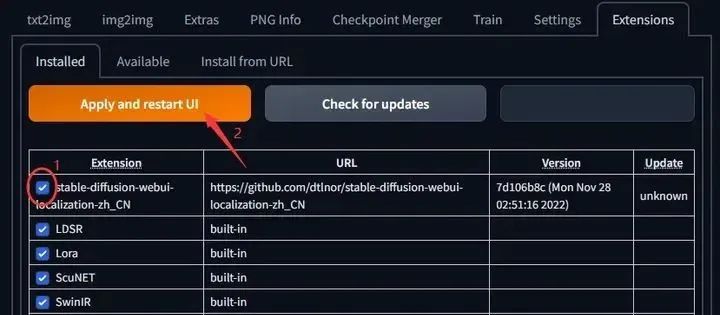

- 在 Extensions 选项卡,确定已勾选本扩展☑️;如未勾选,勾选后点击橙色按钮启用本扩展。

选择简体中文语言包(zh_CN)

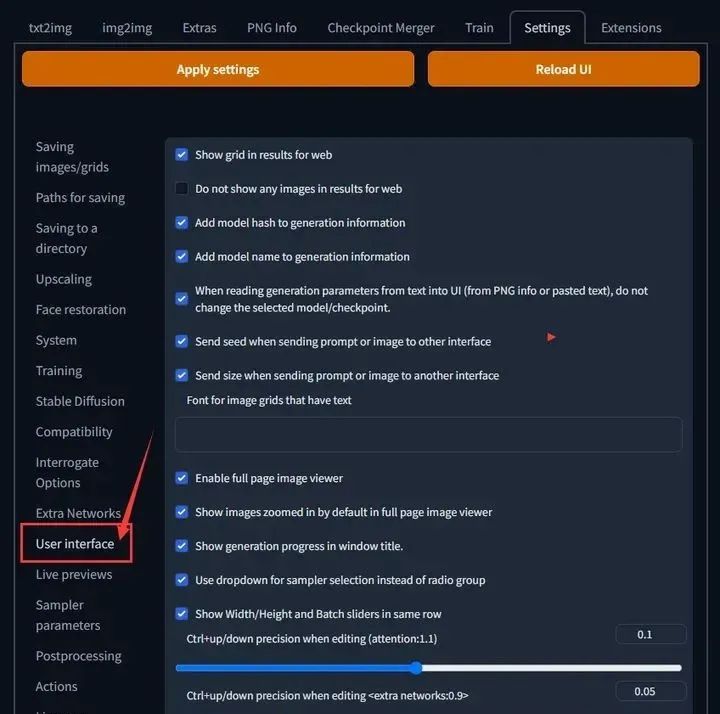

- 在 Settings 选项卡中,找到 User interface 子选项

- 然后去页面最底部,找到 Localization (requires restart) 小项,找到在下拉选单中选中 zh_CN (如果没有就按一下 按钮),如图

- 然后按一下 页面顶部左边的 橙色Apply settings按钮 保存设置,再按 右边的 橙色Reload UI按钮 重启webUI

五、开始使用

stable-diffusion-webui 的功能很多,主要有如下 2 个:

-

文生图(text2img):根据提示词(Prompt)的描述生成相应的图片。

-

图生图(img2img):将一张图片根据提示词(Prompt)描述的特点生成另一张新的图片。

1、文生图(text2img)

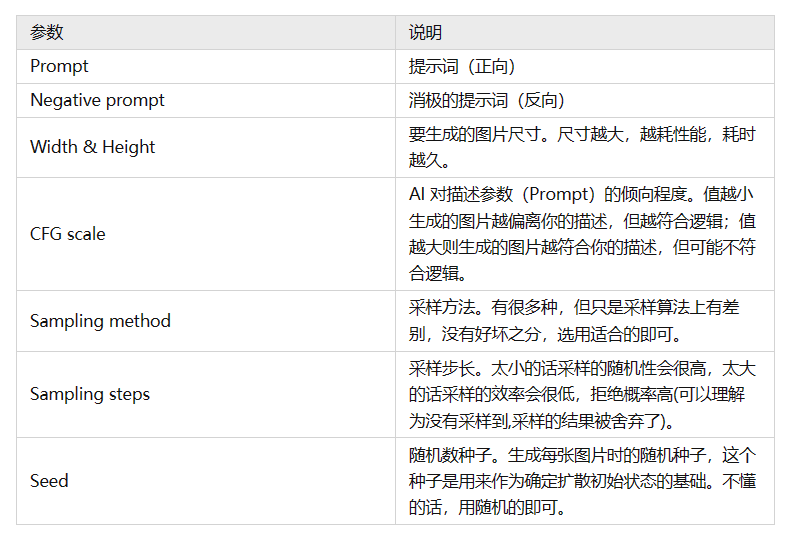

在开始使用文生图之前,有必要了解以下几个参数的含义:

接下来我们来生成一张赛博朋克风格的猫咪图片,配置以下参数后,

点击 “生成” 即可:

Prompt:a cute cat, cyberpunk art, by Adam Marczyński, cyber steampunk 8 k 3 d, kerem beyit, very cute robot zen, beeple | Negative prompt:(deformed, distorted, disfigured:1.3), poorly drawn, bad anatomy, wrong anatomy, extra limb, missing limb, floating limbs, (mutated hands and fingers:1.4), disconnected limbs, mutation, mutated, ugly, disgusting, blurry, amputation, flowers, human, man, woman CFG scale:6.5 Sampling method:Euler a Sampling steps:26 Seed:1791574510

注:提示词(Prompt)越多,AI 绘图结果会更加精准,另外,目前中文提示词的效果不好,还得使用英文提示词。

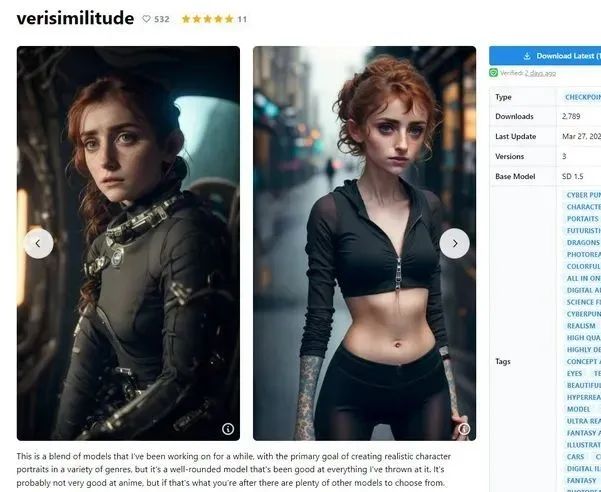

2、模型文件

上面截图里左上角 Stable Diffusion checkpoint 的值怎么跟之前截图里的不一样?这是因为我换了一个模型文件,还记得前面提到那个将近 4 个 G 大小的模型文件(v1-5-pruned-emaonly.safetensors)吗?那是 stable-diffusion-webui 的默认模型文件,用这个模型文件生成出来的图片比较丑,因此我换了另一个模型文件。模型文件下载的网站几个,比较出名的就是 civitai,这上面共享的都是别人训练好的模型。

模型文件下载地址:

-

civitai:civitai.com/

-

默认的 v1-5-pruned-emaonly:huggingface.co/runwayml/st…

模型库

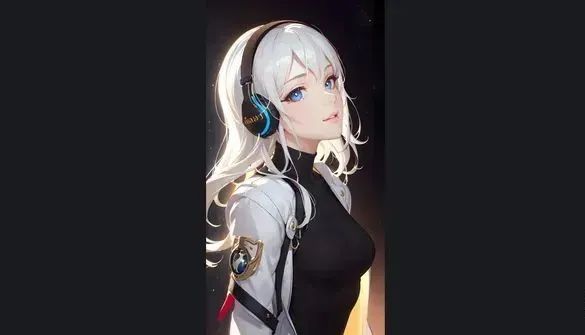

根据你要生成的图片风格(比如:动漫、风景),挑选合适的模型查看,前面那个文生图的例子,使用的就是这个 Deliberate 模型,直接点击 “Download Latest” 即可下载该模型文件。

注:模型文件有 2 种格式,分别是 .ckpt(Model PickleTensor) 和 .safetensors(Model SafeTensor),据说 .safetensors 更安全,这两种格式 stable-diffusion-webui 都支持,随意下载一种即可。

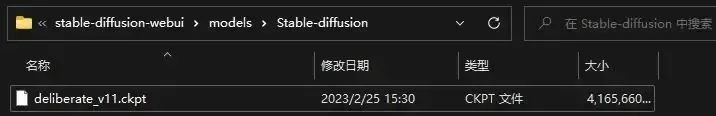

将下载好的模型文件放到 stable-diffusion-webui\models\Stable-diffusion 目录下:

放置好模型文件之后,需要重启一下 stable-diffusion-webui(执行 webui-user.bat)才能识别到。

这些模型文件一般会附带一组效果图,点击任意一张,就可以看到生成该效果图的一些参数配置:

将某些参数配置到"stable-diffusion-webui"中,然后点击"生成"按钮就可以生成类似的图片。需要注意的是,由于AI绘图具有随机性,因此生成的图片可能与效果图略有不同。文生图功能可以用来生成独一无二的图片,但要使用它,必须掌握提示词(Prompt)的语法规则。推荐参考两篇详细说明Prompt的文章:“全网Stable Diffusion Prompt运用技巧"和"Prompt工具网站”。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

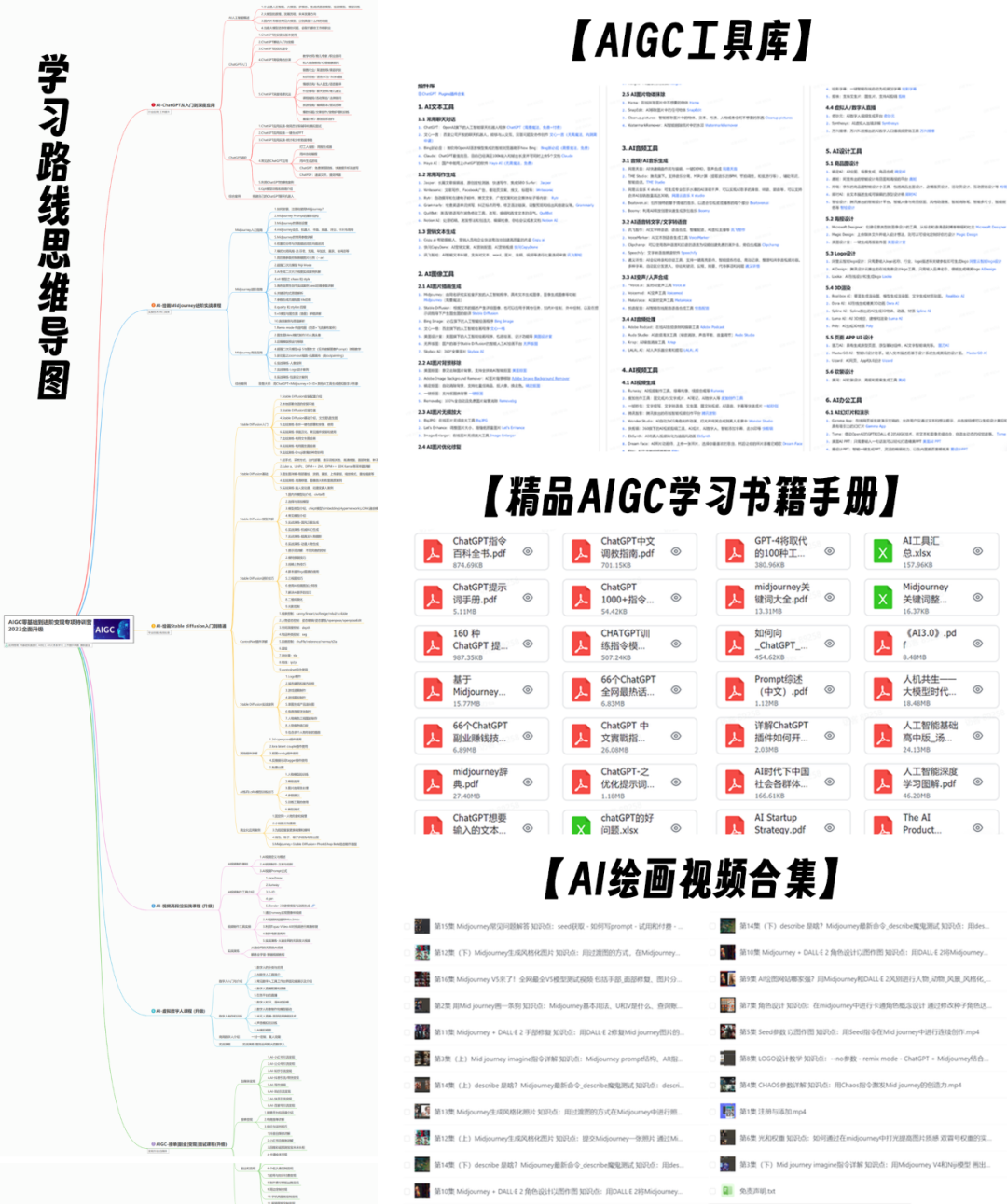

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的AIGC全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

3835

3835

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?