如下图所示:

昨天做一个文本引用的回归分析,数据集和代码见我的github:https://github.com/cooljacket/TextReferenceRegression。

在做上述的线性回归的时候,发现cost一直很高,降不下来,学习速率调高到0.0975或以上,就会发现梯度下降变慢,甚至是变成不收敛的。

然后出于数据集有点大,总共25000个sample,所以就采用了SGD来做,发现降是能够讲到27点多(batch training得到的cost收敛在33点多),但是得做一下cross_validation看是否过拟合了(还没完成CV部分)。

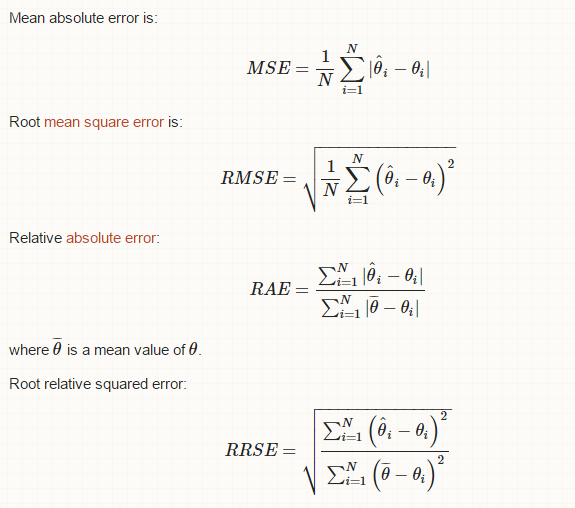

最后打算将自己手写的模型跟已有的软件比较一下,用了weka,待会用scikit-learn试一下。weka跑出来的结果就是,上面的图里的那几个量,完全懵逼。。。google了一下,有大神在stackexchange上面解释了, 保存过来。

觉得自己除了时间不够,基础的知识还是得好好学起来呀,不要”建危房“哈哈。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?