准备条件

在进行Hadoop集群部署之前,我们需要事先准备好以下几个条件

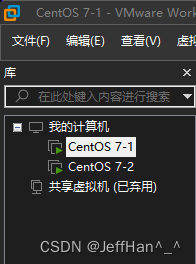

- 1.两台虚拟机

- 2.固定以下两台Centos的IP

可以参考下面文章固定Centos IP - 3.配置SSH免密登录

参考下面文章Centos配置免密登录 - 4.修改hosts文件

- 5.官网下载hadoop官网的包hadoop3.2.4下载

- 6.(必要)配置Java环境

参考下面文章前半段Centos配置Java环境

修改Hadoop配置文件

在 hadoop解压目录下的 etc/hadoop下修改下面配置

core-site.xml

<!-- 设置默认使用的文件系统 Hadoop支持file、HDFS、GFS、ali|Amazon云等文件系统 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://centos1:8020</value>

</property>

<!-- 设置Hadoop本地保存数据路径 注意这个目录不存在会导致启动不起来-->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/data</value>

</property>

<!-- 设置HDFS web UI用户身份 -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>root</value>

</property>

<!-- 整合hive 用户代理设置 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<!-- 文件系统垃圾桶保存时间 -->

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

hdfs-site.xml

<!-- 设置SecondNameNode进程运行机器位置信息 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>centos2:9868</value>

</property>

mapred-site.xml

<!-- 设置MR程序默认运行模式: yarn集群模式 local本地模式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- MR程序历史服务地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>centos1:10020</value>

</property>

<!-- MR程序历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>centos1:19888</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

yarn-site.xml

<!-- 设置YARN集群主角色运行机器位置 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>centos1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 是否将对容器实施物理内存限制 -->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<!-- 是否将对容器实施虚拟内存限制。 -->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<!-- 开启日志聚集 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置yarn历史服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://centos1:19888/jobhistory/logs</value>

</property>

<!-- 历史日志保存的时间 7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

修改workers

centos1

centos2

将修改好的文件发送到其他机器上

scp -r /usr/local/hadoop centos2:/usr/local

启动

格式化文件系统

hdfs namenode -format

在centos1上启动集群

cd /usr/local/hadoop

./sbin/start-dfs.sh

启动yarn

./sbin/start-yarn.sh

访问 http://192.168.37.128:9870

可以看到两台dataNode节点都在线

访问http://192.168.37.128:8088

可以看到resourcemanager的管理界面也已经启动,我这里启动了一个Flink的yarn任务,所以可以看到一个Application

问题汇总

1.root用户登录无法启动问题

vi /etc/profile

添加以下配置

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

source /etc/profile

2.启动时显示Permission denied (publickey,gssapi-keyex,gssapi-with-mic)

- 确保所有的虚拟机能够免密登录

- 由于我们在配置当中配置的是NameNode也作为DataNode,所以导致自己可能也会需要连自己,由此,我们也要将本机的公钥文件放入authorized_keys中

cd /root/.ssh

cat id_rsa.pub >> authorized_keys

在部署Hadoop集群之前,需要准备两台虚拟机,固定IP,配置SSH免密登录和Java环境。接着,修改Hadoop配置文件,包括core-site.xml,hdfs-site.xml,mapred-site.xml和yarn-site.xml等,设置文件系统、NameNode、SecondaryNameNode、ResourceManager等相关参数。最后,启动HDFS和YARN,并检查集群状态。

在部署Hadoop集群之前,需要准备两台虚拟机,固定IP,配置SSH免密登录和Java环境。接着,修改Hadoop配置文件,包括core-site.xml,hdfs-site.xml,mapred-site.xml和yarn-site.xml等,设置文件系统、NameNode、SecondaryNameNode、ResourceManager等相关参数。最后,启动HDFS和YARN,并检查集群状态。

1420

1420

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?