1. 概念

线性回归是有监督学习的一种,线性回归(Linear Regression)解决的是连续数据的预测问题,是一种通过属性的线性组合来进行预测的线性模型,其目的是找到一条直线或者一个平面或者更高维的超平面,使得预测值与真实值之间的误差最小化。线性回归是一个典型的回归问题,也即平时所说的最小二乘法。

2. 特点

优点:结果具有很好的可解释性(参数w直观表达了各属性在预测中的重要性),计算熵不复杂。

缺点:对非线性数据拟合不好

适用数据类型:数值型和标称型数据

3. 理论推导

3.1 数据

给定数据集,其中

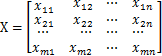

(即线性回归的输出空间是整个实数空间)。因此,在数据集D中共有m个样本,每个样本共有n个特征(或属性),则D可用m*n的矩阵X进行表示:

数据样本的真实值,即标签可用m*1的矩阵表示:

为了构建模型,假设存在参数W,W为n*1的向量:

则线性回归试图学得模型:

![]()

注意:有时候为了方便书写和推导,将偏置也表示成w0,并统一写到W向量中,即:

,其中

此时需要在每个样本第一列添加1,即:

则有

3.2 对于每个样本,预测值与真实值之间多多少少存在一定的差异,即:

![]()

根据假设(或经验等),对于每个样本,误差是独立且同分布的,并且服从均值为0,方差为

的高斯分布(正态分布)。

- 独立:每个样本预测值与真实值之间的差异各不相同,互无关系

- 同分布:由于是同一个模型对不同样本进行预测,故产生的误差具有相同的分布,由模型决定

- 高斯分布:预测的误差不会太大,极小情况下出现浮动较大的情况。

3.3 由于误差服务高斯分布,则由其概率公式:

![]()

得误差的概率表达式为:

由(2)式得:

![]()

代入(3)式得:

![]()

(4)式即表示在已知参数W和数据xi的情况下,预测值为yi的条件概率。

3.4 似然函数

似然函数(Likelihood function):根据样本估计参数值。即什么样的参数与数据组合将可能得到最好的模型结果。

因此,对于所有样本,将其概率相乘,即为模型生成概率:

![]()

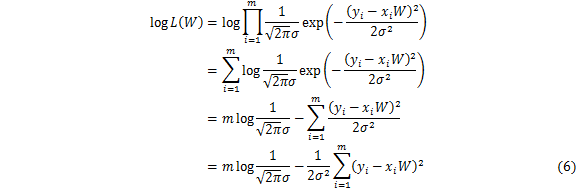

上式(5)中累乘计算复杂,因此可考虑通过对数变换成累加:

3.5 极大似然估计

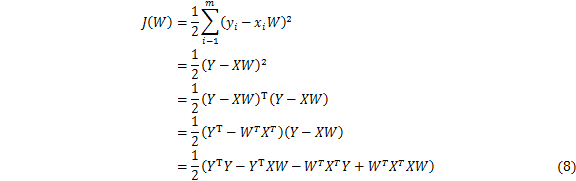

极大似然估计:似然函数代表概率,因此越大越好。则对数似然函数也越大越好。分析式(6)得:第一项为常数项,因此第二项越小越好。令:

![]()

注:留下是考虑到便于求导抵消,所得J(W)为最小二乘法,即通过最小化误差的平方和寻找数据的最佳函数匹配。基于均方误差最小化来求解模型的方法叫最小二乘法。

将(7)式中参数用矩阵的形式表示为:

3.6 求解

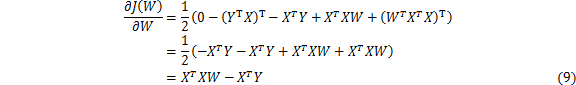

目标函数J(W)为凸函数,因此对W求偏导并令偏导等于0,即可找到最优解。根据式(8)对W求偏导:

令偏导等于0,即:

对于式(10),存在两种情况:

若可逆,则存在唯一解,即:

![]()

则所得线性回归模型为:

![]()

若不可逆,则可能存在多个解,选择哪个解作为输出,将有学习算法的偏好决定,常见的做法是增加

扰动,即:

![]()

3.7 理论上可以根据式(11)或式(13)直接求得W的值,但当X维度较高时矩阵求逆计算量非常大,因此在实际应用中往往采用梯度下降的算法更新W的值,即:

![]()

其中为学习率。

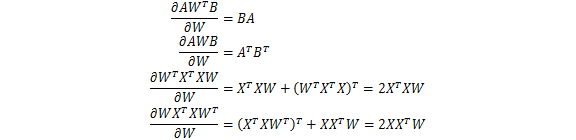

3.8 补充:矩阵求导公式

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?