1.本地安装Ollama大模型

2.Spring AI 调用 Ollama 大模型

Ollama 不仅提供了友好的命令行界面,还支持通过 API 调用,方便与各种应用程序集成。

参考 官方文档Ollama-阿里云Spring AI Alibaba官网官网 (java2ai.com)![]() https://java2ai.com/docs/1.0.0-M6.1/models/ollama/ 可以直接使用开源项目 Ollama 快速安装大模型,无需自己执行脚本安装、也省去了复杂的环境配置。

https://java2ai.com/docs/1.0.0-M6.1/models/ollama/ 可以直接使用开源项目 Ollama 快速安装大模型,无需自己执行脚本安装、也省去了复杂的环境配置。

一、本地安装Ollama大模型

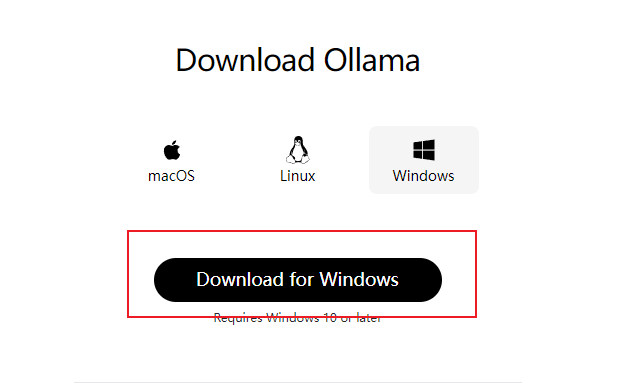

首先下载安装 Ollama,并安装其命令行工具:

https://ollama.com/![]() https://ollama.com/download

https://ollama.com/download

需要使用魔法!!!

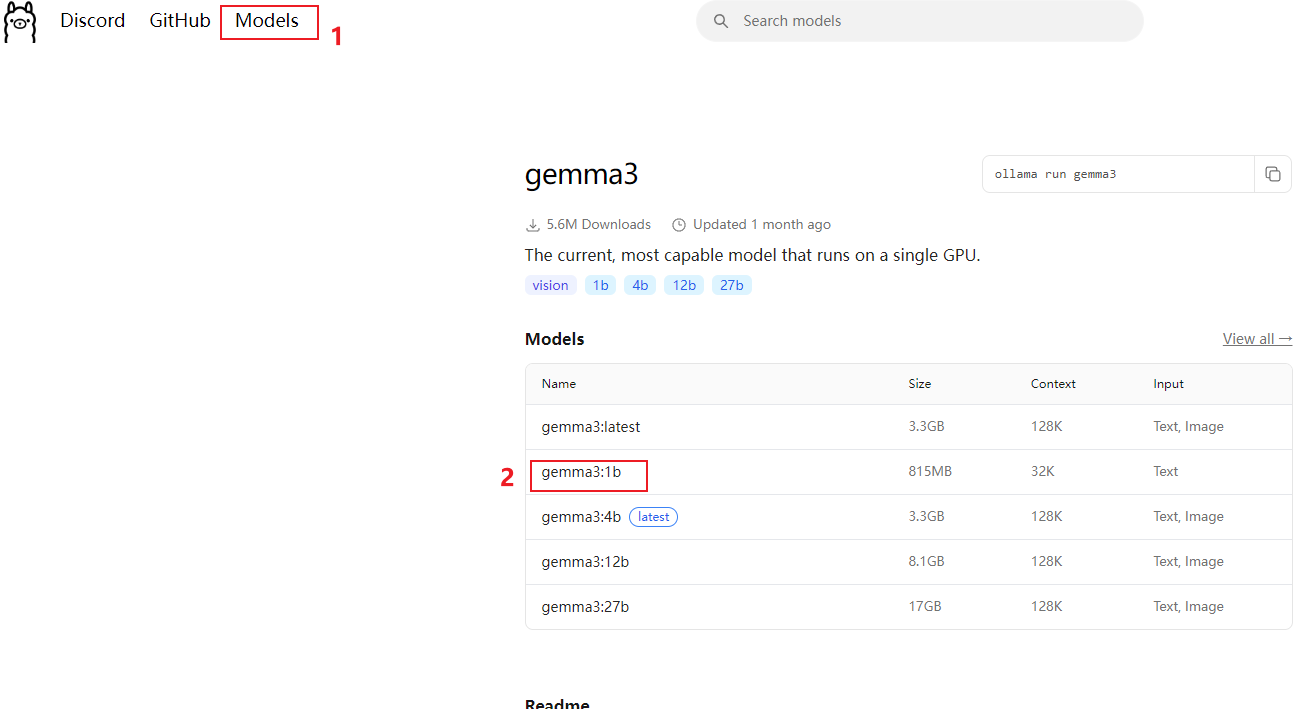

以gemma3:1b为例

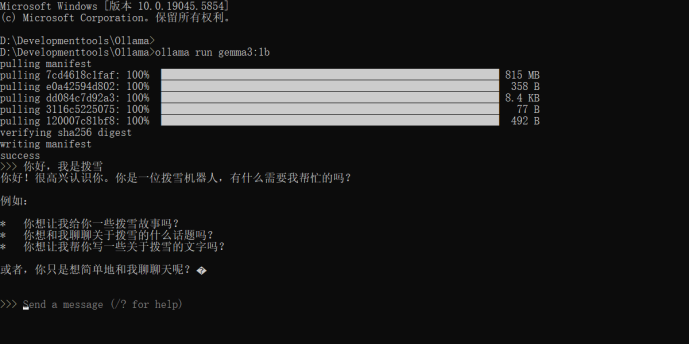

使用魔法下载好Ollama后直接安装,默认c盘,安装好Ollama后,即可在终端运行上述模型命令

ollama run gemma3

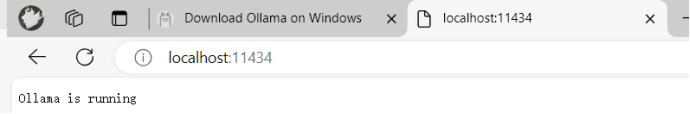

访问 http://localhost:11434,能够看到模型正常运行:

这样就安装成功了

2.Spring AI 调用 Ollama 大模型

Spring AI 原生支持调用 Ollama 大模型。参考 官方文档 。

1.首先需要先引入依赖:

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-ollama-spring-boot-starter</artifactId>

<version>1.0.0-M6</version>

</dependency>

官方提醒:由于 spring-ai 相关依赖包还没有发布到中央仓库,如出现 spring-ai-core 等相关依赖解析问题,请在项目的 pom.xml 依赖中加入如下仓库配置。

<repositories>

<repository>

<id>spring-milestones</id>

<name>Spring Milestones</name>

<url>https://repo.spring.io/milestone</url>

<snapshots>

<enabled>false</enabled>

</snapshots>

</repository>

</repositories>

2.填写配置,注意模型填写为我们刚刚安装并运行的模型:

spring:

ai:

ollama:

base-url: http://localhost:11434

chat:

model: gemma3:1b编写一段测试代码:

// 取消注释即可在 SpringBoot 项目启动时执行

//@Component

public class OllamaAiTest implements CommandLineRunner {

@Resource

private ChatModel ollamaChatModel;

@Override

public void run(String... args) throws Exception {

AssistantMessage output = ollamaChatModel.call(new Prompt("你好,我是拨雪"))

.getResult()

.getOutput();

System.out.println(output.getText());

}

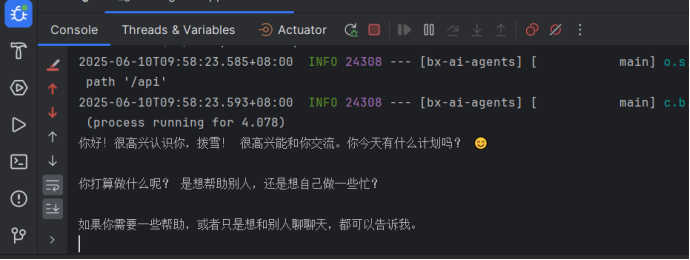

}启动项目,成功运行并查看到 AI 的回答:

1029

1029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?