资讯

研究

ICLR 2024 | 无需训练,Fast-DetectGPT让文本检测速度提升340倍

https://mp.weixin.qq.com/s/lp0nIaBfk2cMMQ86NvnjFg

大语言模型如 ChatGPT 和 GPT-4 在各个领域对人们的生产和生活带来便利,但其误用也引发了关于虚假新闻、恶意产品评论和剽窃等问题的担忧。本文提出了一种新的文本检测方法 ——Fast-DetectGPT,无需训练,直接使用开源小语言模型检测各种大语言模型生成的文本内容。Fast-DetectGPT 将检测速度提高了 340 倍,将检测准确率相对提升了 75% ,成为新的 SOTA。在广泛使用的 ChatGPT 和 GPT-4 生成文本的检测上,均超过商用系统 GPTZero 的准确率。Fast-DetectGPT 同时做到了高准确率、高速度、低成本、通用,扫清了实际应用的障碍!

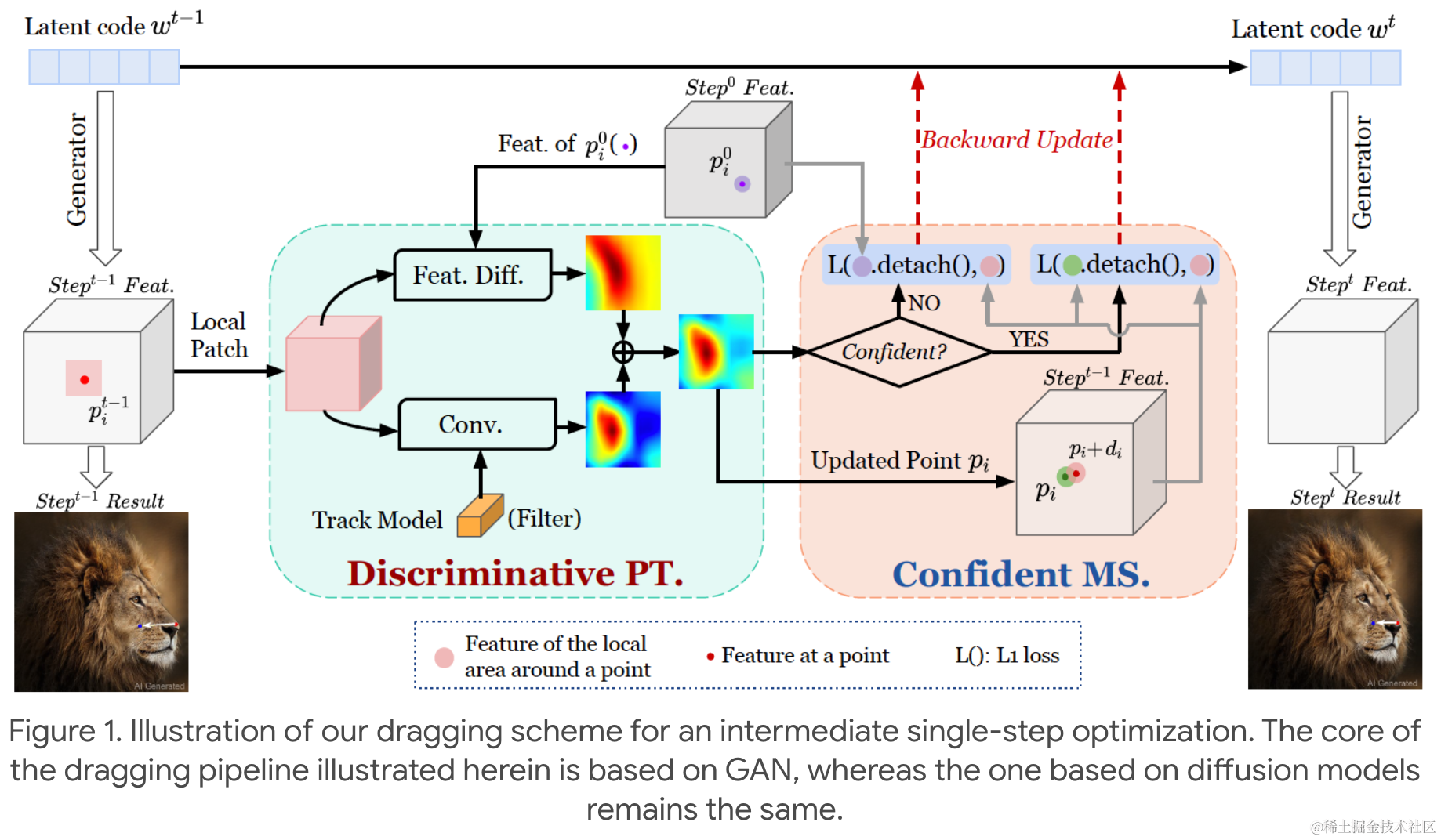

拖拽P图技术又升级了:StableDrag更稳、更准,南大、腾讯联合打造

https://mp.weixin.qq.com/s/kYzziD02DCyxUwfVWzwusg

去年 5 月,动动鼠标就能让图片变「活」得研究 DragGAN吸引了 AI 圈的关注。通过拖拽,我们可以改变并合成自己想要的图像,比如下图中让一头狮子转头并张嘴。实现这一效果的研究出自华人一作领衔的「Drag Your GAN」论文,于上个月放出并已被 SIGGRAPH 2023 会议接收。相关的项目在 GitHub 上已经积累了 34.5k 的 Star 量。之后,新加坡国立大学和字节跳动推出了类似的研究 ——DragDiffusion。他们利用大规模预训练扩散模型,极大提升了基于点的交互式编辑在现实世界场景中的适用性。尽管取得了很大的成功,但类似的拖拽方案存在两个主要缺陷,即点跟踪不准确和动作监督不完整,从而可能导致无法达到满意的拖拽效果。为了克服这些缺陷,南京大学、腾讯的几位研究者提出了一种判别式点跟踪方法并针对动作监督采用了基于置信的潜在增强策略,构建了一个更加稳定和精确的拖拽编辑框架 ——StableDrag。其中判别式点跟踪方法能够精确地定位更新的操纵点,提高长程操纵稳定性;基于置信的潜在增强策略能够在所有操纵步骤中,保证优化的潜在变量尽可能地高质量。

可发现药物靶点,哈佛、Hopkins、中国科学院等机构基于Transformer开发了一种可对蛋白翻译动态变化建模的深度学习方法

https://mp.weixin.qq.com/s/5iF1YZLGcinOuqkw2FLj0g

翻译延伸对于维持细胞蛋白质稳态至关重要,并且翻译景观的改变与一系列疾病相关。核糖体分析可以在基因组规模上详细测量翻译。然而,目前尚不清楚如何从这些数据中的技术产物中分离出生物变异,并识别翻译失调的序列决定因素。在最新的研究中,中国科学院、哈佛大学(Harvard University)、斯坦福大学(Stanford University)、约翰霍普金斯大学(Johns Hopkins University)的研究团队开发了 Riboformer,一个基于深度学习的框架,用于对翻译动态中上下文相关的变化进行建模。Riboformer 利用 Transformer 架构,能够以密码子分辨率准确预测核糖体密度。当在无偏数据集上进行训练时,Riboformer 会纠正以前未见过的数据集中的实验伪影,这揭示了同义密码子翻译中的细微差异,并揭示了翻译延伸的瓶颈。研究人员表明 Riboformer 可以与计算机诱变相结合,以识别有助于核糖体在各种生物环境(包括衰老和病毒感染)中停滞的序列基序。

首个AI软件工程师Devin完整技术报告出炉,还有人用GPT做出了「复刻版」

https://mp.weixin.qq.com/s/2VTiWmu1zoWF3sfSLvuJ-w

文章深入介绍了AI软件工程师Devin和其技术细节,特别是在SWE-bench基准测试中的表现。Devin无需人类辅助,在2294个软件工程问题中解决了13.86%,表现远超当前最先进模型。SWE-bench旨在评估处理真实世界代码库问题的能力,包含问题描述和相应的GitHub拉取请求。Devin通过自动导航文件系统和执行迭代解决方案展现了强大的编码能力,尤其是在逻辑推理和多步骤推导方面。此外,文章还提到社区对Devin的“复刻版”尝试及类似项目BabelCloud,展示了AI在软件开发领域的进步和潜在影响。

产业

马斯克开源Grok-1:3140亿参数迄今最大,权重架构全开放,磁力下载

https://mp.weixin.qq.com/s/hvt5zwoazDx26KOaKuTs_w

说到做到,马斯克承诺的开源版大模型 Grok 终于来了。今天凌晨,马斯克旗下大模型公司 xAI 宣布正式开源 3140 亿参数的混合专家(MoE)模型「Grok-1」,以及该模型的权重和网络架构。这也使得Grok-1成为当前参数量最大的开源大语言模型。

没等来OpenAI,等来了Open-Sora全面开源

https://mp.weixin.qq.com/s/vdr1WBCQVr9aS6bJYcdlRA

不久前 OpenAI Sora以其惊人的视频生成效果迅速走红,在一众文生视频模型中突出重围,成为全球瞩目的焦点。继 2 周前推出成本直降 46% 的 Sora 训练推理复现流程后,Colossal-AI 团队全面开源全球首个类 Sora 架构视频 生成模型 ****「Open-Sora 1.0」,涵盖了整个训练流程,包括数据处理、所有训练细节和模型权重, 携手全球 AI 热爱者共同推进视频创作的新纪元。

月之暗面Kimi模型升级:200万字窗口版可申请,新增“继续”功能

https://mp.weixin.qq.com/s/xsBRTxJWyiI72TNrZJtJGw

继2月以投后约25亿美金估值炸场后,杨植麟的大模型公司月之暗面 () 终于有了一次公开对媒体的活动。虽然杨植麟本人并未露面,但是发布了更长上下文窗口的版本:200万字上下文版本,今天即刻在Kimi上开启内测。并且在与Kimi对话过程中,加入了(不打断模型思路的)“继续”功能按钮。

消息称英伟达洽购以色列人工智能初创公司Run:AI

https://finance.sina.com.cn/stock/usstock/c/2024-03-18/doc-inansyiy2526325.shtml

据知情人士称,英伟达正在就收购以色列人工智能基础设施编排和管理平台Run:AI进行深入谈判。这笔交易的价值估计在数亿美元,甚至可能达到10亿美元。

推特

韩国媒体报道:Sam Altman透露了有关GPT-5的新细节

https://x.com/burny_tech/status/1769549895835226613?s=20

Sam Altman透露了有关GPT-5的新细节

他基本上承认GPT-5将是对GPT-4的巨大升级,因此我们可以期待从GPT-3到GPT-4会有类似的飞跃。

"如果你忽视了改进的速度,你将被'碾压'……Altman对GPT-5的性能很有信心,并发出警告。"

【硅谷特派记者群采访】忽视改进幅度导致业务部署过时,GPT模型没有极限地发展,AGI科研仍是可持续经济发展的驱动力。

OpenAI首席执行官Sam Altman警告不要因忽视GPT-5性能改进幅度而产生"创新延迟",预计其性能将超出预期。他强调,随着GPT下一代模型的开发,需要有更新的思维,取代和抹去各个商业和日常生活领域。这几乎是Altman首席执行官首次对GPT-5的性能表示如此自信的"信号"。他明确表示,构建"通用人工智能(AGI)"是他和OpenAI的目标,暗示如果投入大量计算资源加速AGI的到来,那么目前面临的问题,如AI运作所需的能源危机,都将迎刃而解。

3月14日(当地时间),在与韩国硅谷记者团的会面中,Altman首席执行官提到,"我不确定GPT-5何时会发布,但它将作为在高级推理能力方面实现飞跃的模型取得重大进展。有很多问题是关于GPT是否有任何极限,但我可以自信地说'没有'。"他表示有信心,如果投入足够的计算资源,构建超越人类能力的AGI完全可行。

Altman首席执行官还认为,低估正在开发的GPT-5的改进幅度并相应地部署业务将是一个大错误。这意味着GPT-5的改进幅度超乎想象。他提到,"许多初创公司乐于假设GPT-5只会取得微小进步而不是重大进展(因为这为更多商机敞开大门),但我认为这是个巨大错误。在这种情况下,当技术剧变发生时,它们经常会被下一代模型'碾压'。"

除了"构建AGI",Altman似乎对其他什么都不感兴趣。他对AI以外的其他技术,包括区块链和生物技术,兴趣似乎已经减退。他说,"过去,我对世界上发生的一切都有广泛的视角,可以看到从狭隘视角看不到的东西。遗憾的是,这些天我完全专注于AI(全速投入AI),很难有其他视角。"

最近,Altman首席执行官一直致力于创新全球AI基础设施,引发"7万亿美元资金"传闻的讨论。他说,"除了思考下一代AI模型,我最近花费大部分时间的领域是'计算建设',因为我越来越相信计算将成为未来最重要的货币。然而,世界尚未为足够的计算做好计划,如果不直面这一问题,思考如何以尽可能低的成本建设大量计算,将是一个巨大挑战。"这表明对实现AGI所需计算资源的重大担忧。

斯坦福Andrew Kean Gao浅析Grok开源

https://x.com/itsandrewgao/status/1769447551374156097?s=20

这是对 @grok 架构的深度探索!我刚刚仔细阅读了这个314亿参数的开源巨兽的 model.py 文件,它是完全开放的,没有任何附加条件。

-

基础信息:

-

模型大小: 314 亿参数

-

混合了8个专家模型,其中2个处于活跃状态

-

活跃参数数量: 86亿

-

使用 Rotary Embeddings(旋转嵌入,缩写 RoPE)替代固定位置嵌入

-

-

分词器(tokenizer)词汇量: 131,072 (与 GPT-4 相似)

-

介于 2^17 之间

-

嵌入维度: 6,144 (48*128)

-

64 个 Transformer 层(夸张)

-

每一层都有一个解码器层:包含多头注意力模块(Multihead attention block)和密集模块(denseblock)

-

键值(Key Value)维度: 128

-

-

多头注意力模块:

-

查询(queries)有48个头,键/值(keys/values)有8个头

-

键值(KV)维度为128

-

密集模块(dense feedforward block):

-

宽度因子(widening factor): 8

-

隐藏层大小: 32768

-

每个 token 从8个专家中选择2个

-

-

-

旋转位置嵌入(rotary positional embeddings)维度6144,与模型输入嵌入维度一致

-

上下文长度:8192 tokens

-

精度: bf16

-

提到了一些关于权重的8位量化,但作者本人不是这方面的专家,cc给 @erhartford 征求意见

-

关注作者 @itsandrewgao 获取更多关于 @grok 的报道

-

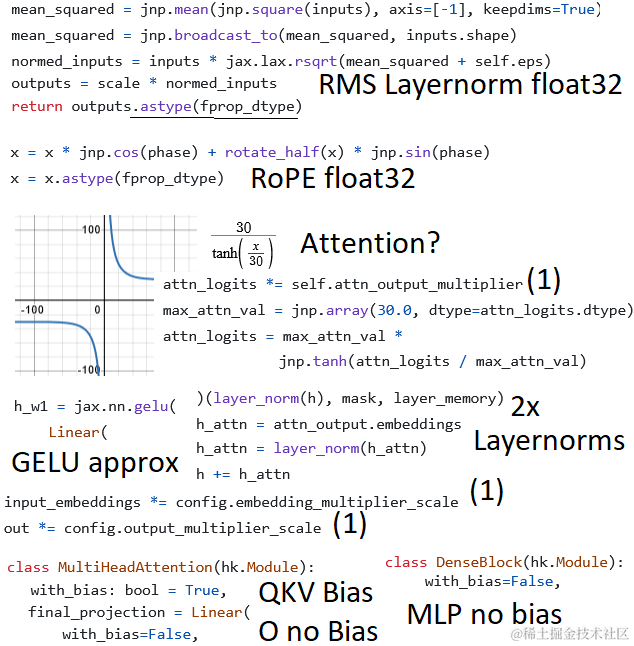

Daniel Han分析Grok代码:注意力(Attention)按30 * tanh(x/30) 进行缩放

https://x.com/danielhanchen/status/1769550950270910630?s=20

我仔细看了一下@Grok的代码:

-

注意力(Attention)按30 * tanh(x/30) 进行缩放?!

-

使用了近似GELU激活函数,与Gemma类似

-

使用了4倍的LayerNorm,而Llama只有2倍

-

RMS LayerNorm在最后进行了向下转换,与Llama不同,但与Gemma相同

-

我认为RoPE(旋转位置嵌入)完全使用float32,与Gemma一样

-

乘数(Multipliers)为1

-

QKV(查询-键-值)有偏置(bias),但输出(Output)和MLP没有偏置

-

词汇表大小为131072,而Gemma为256000。

遗憾的是,它对我来说太大了,无法用@UnslothAI加速微调或运行。70亿参数的Llama可以用Unsloth放入48GB显存中,但Grok将需要太多的GPU资源:(

Open Interpreter预告本周四将会有重大宣布

https://x.com/OpenInterpreter/status/1769448726660337875?s=20

酝酿百年,百时待发。

Juan Stoppa评论:

期待着!周四有重大公告吗?👀

killian回复:

谢谢Juan,没错!

暂时无法在飞书文档外展示此内容

TinyGrad:开放报价,如果购买一台搭载8块H100 SXM GPU的机器,8周内完成超越GroqInc Mixtral演示所达到的500万亿次/秒性能

https://x.com/tinygrad/status/1769388346948853839?s=20

开放报价。

如果有人愿意为我购买一台搭载8块H100 SXM GPU的机器,我们将在8周内(使用tinygrad!)超越@GroqInc的Mixtral演示所达到的500万亿次/秒(500 T/s)的性能,否则归还机器。

AutoMerger:自动合并来自开放大语言模型(Open LLM)排行榜上的两个随机语言模型

https://x.com/Gradio/status/1768606824909922348?s=20

快来看看由@maximelabonne开发的𝐀𝐮𝐭𝐨𝐌𝐞𝐫𝐠𝐞𝐫,这是一个令人着迷的工具,可以自动合并来自开放大语言模型(Open LLM)排行榜上的两个随机语言模型。

它使用@Gradio构建,托管在🤗平台上,仅需10分钟即可在CPU上创建出具有竞争力的模型!

Jensen HuangGTC主题演讲即将开始,Jim Fan:GEAR实验室有一些特别的东西要分享

https://x.com/DrJimFan/status/1769375386645975077?s=20

迫不及待地想看明天Jensen的GTC主题演讲,这是NVIDIA一年中最盛大的节日!一定要坚持到最后!我们新成立的GEAR实验室有一些特别的东西要分享;)您可以在线观看直播或亲自前往SAP中心参加:https://nvidia.com/gtc/keynote

暂时无法在飞书文档外展示此内容

论文

Uni-SMART: 通用科学多模态分析和研究Transformer

链接:http://arxiv.org/abs/2403.10301v1

在科学研究及其应用中,科学文献分析至关重要,因为它使研究者能够在他人工作基础上建立。然而,科学知识的快速增长导致学术文章大量增加,使深入文献分析变得越来越具挑战性和耗时。大语言模型(LLMs)的涌现提供了一种新的解决这一挑战的途径。以其强大的文本总结能力而闻名,LLMs被视为提高科学文献分析的潜在工具。然而,现有的LLMs存在局限性。科学文献往往包含多种多样的多模式元素,比如分子结构、表格和图表,这些对以文本为重点的LLMs来说很难理解和分析。这一问题指向了亟需的新解决方案,能够充分理解和分析科学文献中的多模态内容。为了回应这一需求,我们提出了Uni-SMART(Universal Science Multimodal Analysis and Research Transformer),这是一种设计用于深入理解多模态科学文献的创新模型。通过在多个领域进行严格的定量评估,Uni-SMART展示了优于主流以文本为焦点的LLMs的性能。此外,我们的探索延伸至实际应用,包括专利侵权检测和图表的微妙分析。这些应用不仅突显了Uni-SMART的适应性,也展示了其改变我们如何与科学文献互动的潜力。

RAFT: 将语言模型调整至特定领域的 智能体

链接:http://arxiv.org/abs/2403.10131v1

大语言模型(LLMs)在大型文本数据上的预训练目前已成为标准范例。在许多下游应用中使用这些LLMs时,通常会通过RAG提示或微调来额外融入新知识(如时事新闻或专有领域知识)到预训练模型中。然而,模型获取这些新知识的最佳方法仍是一个未解之谜。本文提出了检索增强微调(RAFT),这是一种训练方法,能够改善模型在“开卷考试”式领域设置下回答问题的能力。在RAFT中,给定一个问题和一组检索到的文档,我们训练模型忽略那些不帮助回答问题的文档,称之为干扰文档。RAFT通过引用相关文档中能够帮助回答问题的正确序列来实现这一点。结合RAFT的思维链式响应方式有助于提高模型的推理能力。在特定领域的RAG中,RAFT在PubMed、HotpotQA和Gorilla数据集上持续改善模型的表现,提出了一个后训练方法来改进预训练的LLMs到领域相关的RAG。RAFT的代码和演示在github.com/ShishirPatil/gorilla中开源。

语言模型中数字属性的单调表示

链接:http://arxiv.org/abs/2403.10381v1

语言模型(LMs)可以表达涉及数值属性的事实知识,如Karl Popper于1902年出生。然而,这些信息是如何编码在模型的内部表示中的并不清楚。在这里,我们介绍了一种简单的方法,用于查找和编辑数值属性的表示,例如一个实体的出生年份。通过实证研究,我们发现以可解释和可编辑的方式单调编码数值属性的低维子空间。当沿着这些子空间中的方向编辑表示时,LM的输出会相应更改。例如,通过沿着“出生年”方向修补激活,我们可以使LM表达出越来越晚的出生年:Karl Popper 于1929年出生,Karl Popper于1957年出生,Karl Popper于1968年出生。在所有考虑模型中,存在跨多个数值属性的属性编码方向,这表明数值属性的单调表示在LM预训练期间会一致涌现。

大型语言模型中快速推理解码的循环起草者

链接:http://arxiv.org/abs/2403.09919v1

在本文中,我们介绍了一种改进的猜测解码方法,旨在提高为大型语言模型提供服务的效率。我们的方法利用了两种已建立技术的优势:经典的双模型猜测解码方法和较新的单模型方法Medusa。受到Medusa的启发,我们的方法采用了单模型策略进行猜测解码。然而,我们的方法通过采用具有循环依赖设计的单一轻量级草稿头来区别自己,本质上类似于经典猜测解码中使用的小型草稿模型,但不涉及完整Transformer架构的复杂性。由于循环依赖,我们可以使用波束搜索快速过滤掉草稿头中不需要的候选项。其结果是一种结合了单一模型设计简易性的方法,并且避免了只为Medusa中推断而创建数据依赖性树注意结构的需要。我们在几个流行的开源语言模型上经验性地证明了所提方法的有效性,同时全面分析了采用这种方法所涉及的权衡。

OverleafCopilot: 用大语言模型增强 Overleaf 中的学术写作

链接:http://arxiv.org/abs/2403.09733v1

大语言模型(LLMs)的快速发展促进了不同领域的各种应用。在这个技术报告中,我们探讨了LLMs和流行的学术写作工具Overleaf的整合,以提高学术写作的效率和质量。为了实现上述目标,存在三个挑战:i)在Overleaf和LLMs之间实现无缝互动,ii)与LLM提供者建立可靠的通信,iii)确保用户隐私。为了应对这些挑战,我们提出了OverleafCopilot,这是第一个能无缝整合LLMs和Overleaf的工具(即浏览器扩展程序),使研究人员在撰写论文时可以利用LLMs的力量。具体来说,我们首先提出了一个有效的框架来连接LLMs和Overleaf。然后,我们开发了PromptGenius,一个网站让研究人员轻松找到和分享高质量的最新提示。第三,我们提出一个智能体命令系统,帮助研究人员快速构建他们可定制的智能体。OverleafCopilot已经在Chrome扩展商店上架,现在为成千上万的研究人员提供服务。此外,PromptGenius的代码已在https://github.com/wenhaomin/ChatGPT-PromptGenius上发布。我们相信我们的工作有可能彻底改变学术写作实践,赋予研究人员在更短时间内生产出更高质量的论文的能力。

Repoformer:基于仓库级代码补全的选择性检索

链接:http://arxiv.org/abs/2403.10059v1

摘要:最近检索增强生成(RAG)技术在存储库级代码自动补全方面开启了新纪元。然而,现有方法中对检索的不变使用暴露了效率和稳健性问题,其中大部分检索到的上下文对于代码语言模型(code LMs)来说既无帮助又有害。为了应对这些挑战,本文提出了一种选择性RAG框架,当不必要时避免使用检索。为了支持该框架,我们设计了一种自监督学习方法,使代码LM能够准确地自我评估检索是否能提高其输出质量,并能够稳健地利用潜在带有噪音的检索上下文。通过将此LM作为选择性检索策略和生成模型,我们的框架在包括RepoEval、CrossCodeEval和一个新基准测试在内的各种基准测试上始终优于目前最先进的提示技术。同时,我们的选择性检索策略使推理速度提高了多达70%,而并不损害性能。我们展示了我们的框架有效地适应不同的生成模型、检索器和编程语言。这些进步将我们的框架定位为朝着更准确和高效的存储库级代码自动补全迈出的重要一步。

AlignmentStudio:将大语言模型与特定上下文规定对齐

链接:http://arxiv.org/abs/2403.09704v1

大语言模型的对齐通常由模型提供者完成,以添加或控制跨用例和上下文普遍理解的行为。与此相反,在本文中,我们提出了一种方法和架构,赋予应用开发人员调整模型到他们特定的价值观、社会规范、法律和其他法规,并在上下文中协调潜在的冲突要求的能力。我们阐述了这种对齐工作室架构的三个主要组件:Framers、Instructors和Auditors,它们共同控制语言模型的行为。我们通过一个示例说明了这种方法,即将一家公司内部企业聊天机器人与其业务行为准则对齐。

产品

Tailor

https://tailor.news/

Tailor 使用 AI 来总结、核查并链接数以千计的文章、播客和 YouTube 视频,为用户提供易于理解、公正的新闻报道和播客。

Katalist AI Storytelling Studio——生成可视化脚本

https://www.katalist.ai/

Katalist 是一个故事创作工具,专注于将文本转化为视觉故事板和帮助进行视频制作。它提供了一系列功能,如将剧本转化为视觉故事板、自动提取故事中的角色和场景并保持一致性、更好的用户界面、即时呈现故事板等。此外,Katalist 还提供了一些控制功能,如改变角色或场景但保持画面内容不变、控制角度和摄像机、角色姿势控制工具等,可以提前预演拍摄的效果,并进行调整。

HuggingFace&Github

Grok开源

https://github.com/xai-org/grok-1

此存储库包含用于加载和运行 Grok-1 开源模型的 JAX 示例代码。

StreamMultiDiffusion:基于区域语义控制的实时交互式生成

https://github.com/ironjr/StreamMultiDiffusion

Diffusion 模型在文本到图像合成领域取得了一定程度的成功,但面对整合作品等情况仍有挑战。为此,提出了StreamMultiDiffusion框架,实现了快速稳定的全景生成和基于区域文本到图像合成。这一解决方案开创了语义调色板范式,能实时生成高质量图像,并编码语义含义。

Cerebrum-1.0-7b

https://huggingface.co/AetherResearch/Cerebrum-1.0-7b

Cerebrum 7b 是一个基于 Mistral 7b 模型的 LLM,在原生思维链数据的小型自定义数据集上进行了微调,并通过目标性 RLHF 进一步改进,这是一种用于样本高效LLM比对的新技术。与许多其他最近的微调方法不同,它的训练管道包括不到 5000 个训练提示和更少的 tRLHF 标记数据点。原生的思维链方法意味着 Cerebrum 接受过培训,可以在解决需要思考的问题之前制定战术计划。对于头脑风暴、知识密集型和创造性任务,Cerebrum 通常会省略不必要的冗长考虑因素。

投融资

算力 解决方案, 光芯片 企业「光本位」完成近亿天使+轮融资

https://news.pedaily.cn/202403/531256.shtml

光子计算芯片公司「光本位」完成了近亿元人民币的天使+轮融资,由中赢创投领投,接力天使、慕石资本跟投。光芯片利用光学技术处理信息,具有高传输速度、低功耗和大带宽优势。公司联合创始人熊胤江指出,光芯片在理想状态下功耗和延迟远低于电子芯片,算力却可达到其100倍以上。光计算芯片被视为中国在算力领域实现超车的机会,尤其在大模型AI算力芯片需求高涨的背景下。光本位的技术路线和团队经验受到投资者的高度评价。

Urbanic获得1.5亿美元投资以增强AI设计能力

https://www.businesstoday.in/latest/corporate/story/urbanic-secures-150-million-investment-to-enhance-ai-design-capabilities-421877-2024-03-18

伦敦时尚品牌Urbanic,在其C轮融资中成功获得1.5亿美元投资,以增强其AI设计能力。投资者包括瑞士的Mirabaud Lifestyle Impact & Innovation Fund、纽约的D1 Capital Partners、JAM Fund以及其他全球投资者和欧洲著名的奢侈时尚家族。该资金将支持Urbanic利用其专有的大型语言模型(LLM)和AIGC创意内容来革新时尚行业,提升供应链效率。

AI音乐初创公司Beatoven.ai在Pre-Series A轮融资中筹集到11亿卢比

https://cxotoday.com/press-release/ai-music-startup-beatoven-ai-raises-inr-11cr/

Beatoven.ai,一家以AI驱动的突破性音乐技术初创公司,成功在Pre-Series A融资轮中筹集了11亿卢比(约合130万美元)。该轮融资由Capital 2B领投,IvyCap Ventures、Entrepreneur First、Upsparks Capital、Rukam Capital以及多位知名天使投资人参投。Beatoven.ai致力于为内容创作者提供一个平台,帮助他们创建无版税、负担得起、易于授权和原创的音乐。目前,该平台已拥有100万用户,并计划在未来2-3年内将用户数量增长到500万。此次获得的资金将用于提升用户体验,持续改进音乐的准确性和质量,并开发可扩展的市场进入策略。Beatoven.ai还计划与至少500位艺术家建立合作关系,扩大其艺术家网络。

学习

预训练视觉模型的参数高效微调

https://mp.weixin.qq.com/s/tmhgzFODsJ8bxYuk_AurEA

本文探讨了预训练视觉模型的参数高效微调新范式,该方法通过在微调过程中仅更新少量参数,而冻结大部分预训练模型参数,以实现与全参数微调相当的性能。参数高效微调在训练效率、存储和通讯效率方面优于传统方法,适用于多任务场景,减少了存储和传输开销,同时提高了模型的泛化能力和优化速度。文章还介绍了基于特征的微调、部分参数微调、基于提示的微调和基于适配器的微调等主要方法,并讨论了参数高效微调在联邦学习、黑盒模型微调和边缘设备训练中的应用前景。

人工智能的黑暗时代

https://zhuanlan.zhihu.com/p/687529180?utm_psn=1753039587784716288

这篇文章是关于人工智能领域的一次讨论,涉及了人工智能的期望与现实之间的差距、媒体报道对公众期望的影响、以及人工智能研究的未来方向。参与者包括学术界和工业界的专家,他们讨论了人工智能技术的实际应用、资金支持、教育和培训问题,以及如何避免人工智能领域的“寒冬”。文章强调了对人工智能的合理期望和科学研究的重要性,并提出了对人工智能未来发展的乐观态度。

2024年了diffusion还有什么可做的?

https://www.zhihu.com/question/647875443?utm_psn=1753039261056823296

这篇文章探讨了2024年扩散模型(diffusion models)在图像生成领域的潜在研究方向。作者从数据、模型、优化和任务四个角度提出了多个技术点,包括提高生成图像的分辨率、生成特定领域图像、压缩模型、网络架构、文本编码、采样优化、对齐人类偏好、推理能力提升以及视频生成和基于指令的编辑等。特别强调了结合大型语言模型(LLM)和扩散模型的潜力,以及在视频生成和Instruction-Based Editing任务中的应用前景。文章提供了相关研究的链接,供感兴趣的读者进一步探索。

Self-Attention & Transformer完全指南:像Transformer的创作者一样思考

https://zhuanlan.zhihu.com/p/630356292?utm_psn=1753040382030446593

这篇文章深入探讨了Transformer模型的核心机制,包括Self-Attention和Positional Encoding,以及它们如何解决RNN在处理长距离依赖问题时遇到的挑战。文章详细解释了Transformer的Encoder-Decoder架构,特别是Masked Self-Attention和Cross-Attention的工作原理,以及多头注意力(Multi-Head Attention)如何增强模型的并行性和语义处理能力。此外,还讨论了Feed Forward Layer的作用和残差连接(Residual Connection)与Layer Normalization在模型中的重要性。整篇文章不仅提供了丰富的理论解释,还鼓励读者通过实践来深入理解Transformer的内部结构和工作流程。

OpenAI Triton入门笔记三 FusedAttention

https://zhuanlan.zhihu.com/p/684557290?utm_psn=1753040461550239744

这篇文章是关于OpenAI Triton的入门教程,重点介绍了如何使用Triton实现FlashAttention V2。文章通过对比Triton和cutlass实现的性能,展示了Triton在不同配置下的性能优势。同时,作者提供了FlashAttention V1和V2的简化Python实现,帮助读者理解算法流程。文章还深入分析了Triton的FlashAttention V2前向传播实现,包括内核函数_attn_fwd_inner和Triton kernel的启动设置,以及如何通过Triton的内存管理和并行计算优化来提高性能。最后,文章总结了FlashAttention V1/V2的实现要点,并提供了相关参考资料。

从 RAG 到 Self-RAG —— LLM 的知识增强

https://zhuanlan.zhihu.com/p/661465330?utm_psn=1753085209929879552

这篇文章介绍了检索增强生成(RAG)技术及其在大型语言模型(LLM)中的应用,强调了RAG在提高模型预测质量、解决幻觉问题、时效性问题和数据安全问题方面的重要性。文章比较了RAG与SFT(Supervised Fine-Tuning)的不同,并详细讨论了RAG的实现方法、典型案例和面临的挑战。此外,文章还探讨了Self-RAG的概念,这是一种更主动的检索增强方法,通过自我反思和检索来生成更准确和可靠的输出。最后,文章提到了LLM作为多智能体系统中的决策中心,以及如何通过API调用和其他工具来完成复杂任务。

LLM fine-tuning 理论篇

https://zhuanlan.zhihu.com/p/667653241

这篇文章是关于大型语言模型(LLM)微调(fine-tuning)的理论篇,介绍了几种常见的微调算法,包括LoRA、QLoRA和AdaLora等。文章强调了微调时如何尽量减少权重参数的更新,以适应资源受限的环境。LoRA通过引入低秩的可训练分解矩阵来减少参数更新量,QLoRA在此基础上进行了优化,包括提出4-bit NormalFloat数据类型和Paged Optimizer。AdaLora则改进了LoRA的参数分配方式,根据参数的重要性动态分配可微调参数的预算。此外,文章还提到了BitFit方法,它专注于Transformer-based Masked Language-models的微调,通过只更新bias参数和特定的线性分类器层来大幅减少训练参数数量。这些方法旨在提高微调的效率,减少资源消耗,同时保持或接近全量微调的效果。

声明

本文档仅供学习交流使用,版权归原作者所有,若涉侵权,请联系Jack Jin 1510113616

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?