打怪升级之小白的大数据之旅(四十四)

Hadoop搭建过程中的一些问题

上次回顾

我用了两章对Hadoop的搭建进行讲解,大家搭建前,先看我开篇的步骤讲解,然后再根据步骤进行搭建,本章就对一些常见问题进行分享,大家也有问题;欢迎后台留言,让我可以扩充这一章节

防火墙没关闭、或者没有启动YARN

如果我们在前面没有关闭防火墙或者没有在hadoop103服务器上启动YARN,那么就会出现下面错误

INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.10.103:8032

解决方案:

# 关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

# 启动yanrn服务(在hadoop103服务器上运行),103是ResourceManager所在的服务器

start-yarn.sh

主机名称配置错误

我们的主机名称没有按照我前面说的配置,或者每一台节点的用户都不是同一个用户名,还有hosts文件没有配置,就会出现项目的错误

1.hadoop启动时datanode报错Shutting down DataNode at java.net.UnknownHostException: master1.hadoop: master1.hadoop: 未知的名称或服务

2.java.net.UnknownHostException: localhost.localdomain: localhost.localdomain

解决方案:

# 修改我们的主机名称

vim /etc/hostname

# 一定记得删除默认的 localhost那一行

hadoop103

# 修改hosts文件

sudo vim /etc/hosts

# 修改的内容如下

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

IP地址配置错误

由于ip 地址设置错误引起

ERROR org.apache.hadoop.hdfs.server.namenode.NameNode: java.net.BindException: Problem

binding to book0/192.168.1.102:9000 : Cannot assign requested address

解决方案:

请检查主机的ip 设置与配置文件的ip 设置是否一致。

使用more /etc/hosts 命令查看ip 与主机名的映射是否设置

root用户和hadoopuser两个用户启动集群不统一

这个我没有遇到,大家遇到userxxx这种异常的时候,检查一下是否用户名和集群名称不同

解决方案

# 检查我们的用户名

ll $HADOOP_HOME

# 查看我们的所属组与所属主是否是同一个,并且我们当前登录的用户是否正确

drwxr-xr-x. 2 hadoopuser hadoopuser 247 5月 12 19:21 bin

ssh没有配置好

没有使用无密登录,就会造成这个错误

shell request failed on channel 0

解决方案

先连接一下,看是否无密登录

ssh hadoop102

如果不是,直接重新进行无密登录,具体回看我博客第四十二章,无密登录配置

多次执行hadoop 格式化

这个是比较常见的异常,我们运行了两次hdfs服务就会出现这个异常

Incompatible clusterIDs in /opt/module/hadoop-3.1.3/data/dfs/data:

namenode clusterID = CID-cf70aa58-18b1-4f48-8b64-3a63db796298; datanode

clusterID = CID-2cb274d4-fde9-411c-9821-e5a2c2996329

解决方案:

1.停止所有的Hadoop进程(三台节点全部都要停-如果不能保证是否停掉全部重启)

2.要删除 hadoop根目录中 data,logs

要删除 sudo rm -rf /tmp/*

注意:三台节点全部都删

3.重新格式化

因为这个问题比较常见,我写了一个清理脚本,大家直接复制到bin目录下即可

vim clear_dfs

# 编写内容如下:

#!/bin/bash

for host in hadoop102 hadoop103 hadoop104

do

ssh $host rm -rf $HADOOP_HOME/data $HADOOP_HOME/logs

ssh $host sudo rm -rf /tmp/*

done

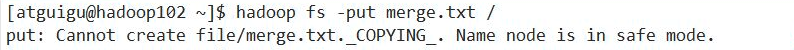

当我们刚启动hdfs时,就进行put上传文件,此时会报下面的错误:

会进行安全模式检查,我们需要等待一下即可,安全模式的原因,我会在后面HDFS原理那一章近进行讲解

总结

我就一些常见的问题进行了总结,如果大家也有不同的异常,欢迎后台私信我,然后扩充我这一章的内容

1418

1418

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?