在过去的十年中,深度学习彻底改变了我们处理数据和解决复杂问题的方式。从图像识别到自然语言处理,再到游戏玩法,深度学习的应用广泛且深入。本文将探讨深度学习的基础知识、关键技术以及最新的研究进展,为读者提供一个全面的视角。

一、浅谈深度学习

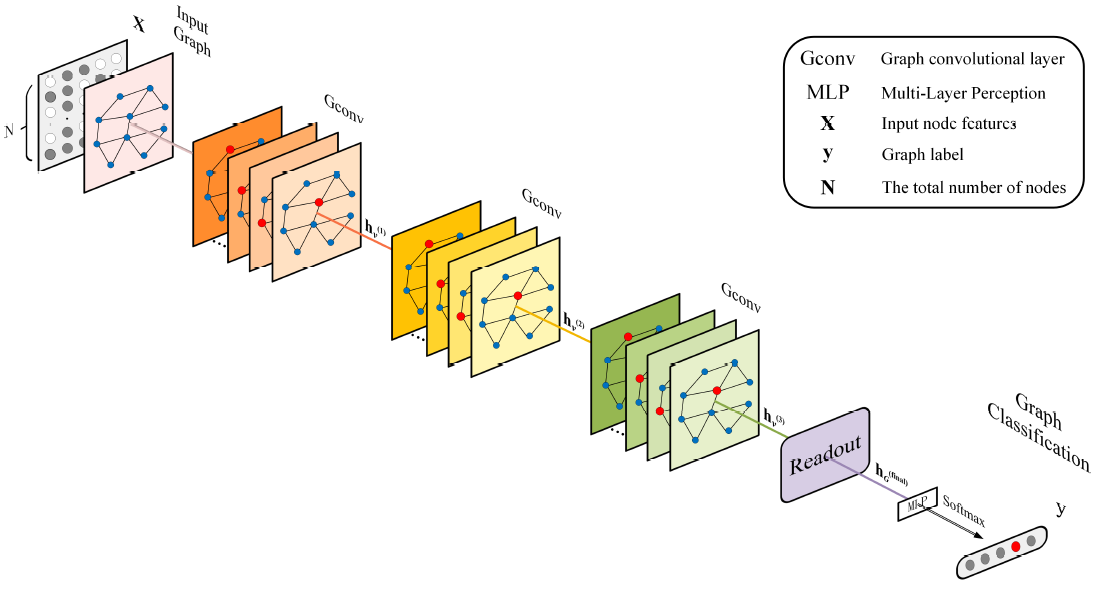

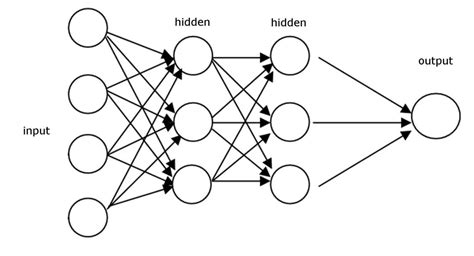

深度学习是机器学习的一个子领域,它使用多层神经网络来模拟人脑处理和分析数据的能力。与传统的机器学习算法相比,深度学习能够自动提取数据的高级特征,无需人工设计特征提取器。

神经网络的核心组件

- 神经元:神经网络的基本单元,负责接收输入、进行加权求和并通过激活函数产生输出。

- 层:神经网络中的神经元被组织成层,包括输入层、隐藏层和输出层。

- 权重和偏置:连接神经元的边具有权重,每个神经元可能有偏置项,这些都是在训练过程中学习得到的参数。

二、深度学习的关键技术

1.反向传播和梯度下降

反向传播算法:计算神经网络中所有权重的梯度,是监督学习中最常用的训练方法。

梯度下降:通过不断调整权重以最小化损失函数,从而优化模型性能。

2.卷积神经网络(CNN)

局部感受野:CNN通过局部感受野来捕捉图像的空间层次结构。

权重共享:同一层的神经元共享权重,减少了模型的参数数量。

池化层:通过降低特征图的维度来减少计算量,同时保留重要的特征信息。

3.循环神经网络(RNN)和长短时记忆网络(LSTM)

时间序列数据处理:RNN用于处理序列数据,如时间序列分析或自然语言处理。

长期依赖问题:LSTM是RNN的一种变体,解决了RNN在长序列上的梯度消失或爆炸问题。

三、深度学习的新进展

1.生成对抗网络(GAN)

原理:由生成器和判别器组成,生成器生成假数据,判别器判断数据的真假,两者相互博弈提高性能。

应用:图像生成、风格迁移、数据增强等。

2.自注意力和Transformer模型

自注意力机制:允许模型在处理序列数据时关注不同部分的信息。

Transformer模型:基于自注意力机制,摒弃了传统的RNN和CNN结构,广泛应用于自然语言处理领域。

3.预训练模型和迁移学习

预训练模型:在大规模数据集上预先训练好的模型,如BERT、GPT等。

迁移学习:利用预训练模型在特定任务上进行微调,显著减少了训练时间和数据需求。

4.强化学习

交互式学习:智能体通过与环境交互来学习策略。

应用:游戏AI、机器人控制、资源管理等。

四、挑战与未来方向

1.解释性和透明度

黑盒问题:深度学习模型往往缺乏可解释性,难以理解其决策过程。

开发可解释的AI模型,提高用户信任和模型可靠性。

2.数据隐私和安全性

数据泄露风险:模型训练涉及大量敏感数据,存在泄露风险。

隐私保护技术,如同态加密、差分隐私等技术正在被研究以保护数据隐私。

3.能效和硬件优化

计算成本:深度学习模型的训练和部署需要大量的计算资源。

研究更高效的算法和专用硬件,减少能源消耗。

结语

深度学习作为人工智能的重要分支,其发展速度之快、应用范围之广令人瞩目。从基础理论到关键技术,再到最新的研究进展,深度学习正不断推动科技界的边界。尽管存在挑战,但未来的发展方向无疑是光明的,深度学习将继续在智能化时代扮演关键角色。

408

408

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?