Chapter 6

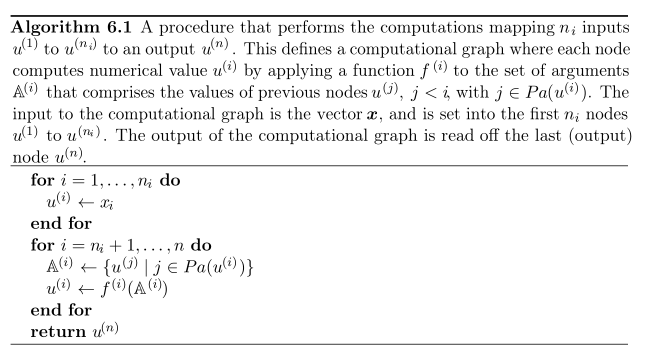

Algorithm 6.1 (forward propagation)

描述神经网络图中,输入是如何映射到输出的。

第一个for循环:

完成第一个到第ni个变量赋值给u对应节点的过程;

第二个for循环:

A(i)代表着u(i)节点对应的父节点的集合;

这个循环将f(i)这个方法作用到了A(i)这个父节点的集合上,进而生成了子节点u(i)。

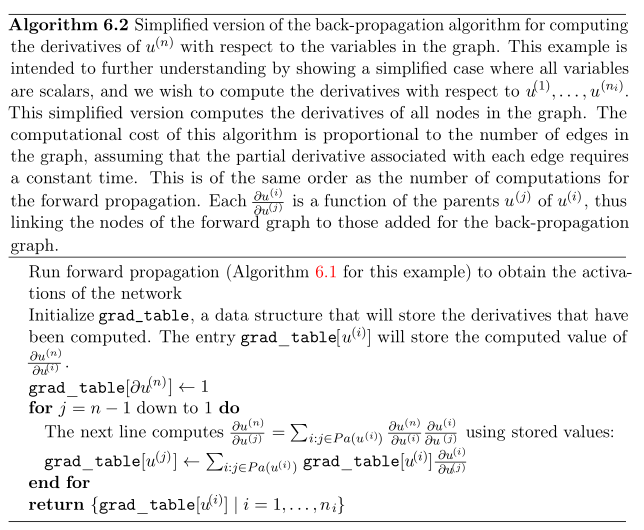

Algorithm 6.2

backprop求导过程的简要版本

这个算法在求导的基础上引入了链式法则(Chain rule),使得子节点求导的结果可以供其父节点调用,进而节省计算开支。

另外,这个求导过程是起始于终点,逐步向起点推的。因此是对应于forward的backward。最后计算的结果存储在grad_table这个结构体中。

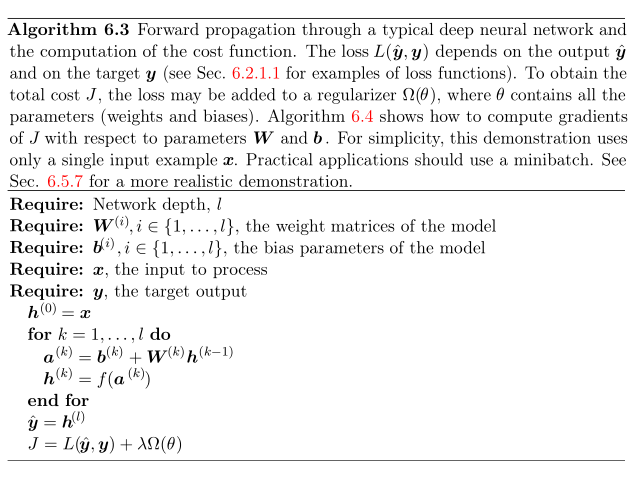

Algorithm 6.3

Algorithm6.1的基础上加了cost function计算的forward propagation。

Algorithm 6.4

这里是从output layer逐步往前推,求得每层对应参数的导数。根据这些导数对参数进行修正可以降低最后输出的误差。

本文介绍了深度学习中的几个关键算法,包括前向传播(Algorithm 6.1)、简化版的反向传播(Algorithm 6.2)、带有成本函数的前向传播(Algorithm 6.3)以及反向传播用于参数更新的过程(Algorithm 6.4)。通过链式法则,这些算法协同工作,从输出层开始计算导数并回溯到输入层,从而优化神经网络的参数,减少误差。作者探讨了算法之间的关系,并指出Algorithm 6.5和6.6是Backprop的实现细节。尽管存在理解难度,作者承诺将继续深入学习和完善内容。

本文介绍了深度学习中的几个关键算法,包括前向传播(Algorithm 6.1)、简化版的反向传播(Algorithm 6.2)、带有成本函数的前向传播(Algorithm 6.3)以及反向传播用于参数更新的过程(Algorithm 6.4)。通过链式法则,这些算法协同工作,从输出层开始计算导数并回溯到输入层,从而优化神经网络的参数,减少误差。作者探讨了算法之间的关系,并指出Algorithm 6.5和6.6是Backprop的实现细节。尽管存在理解难度,作者承诺将继续深入学习和完善内容。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2722

2722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?