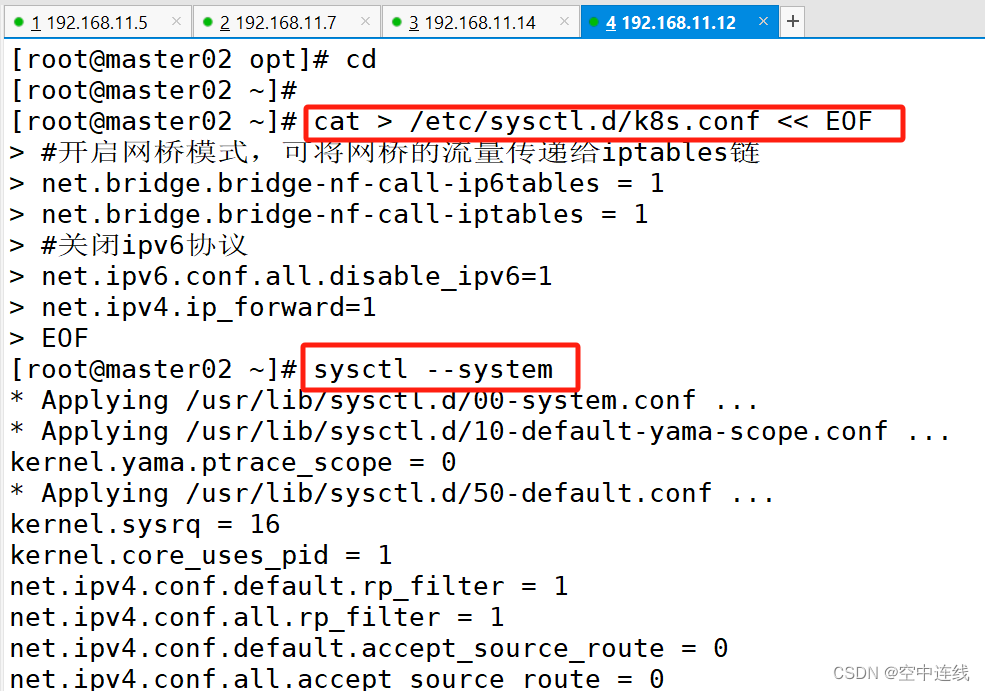

一 master02 节点部署

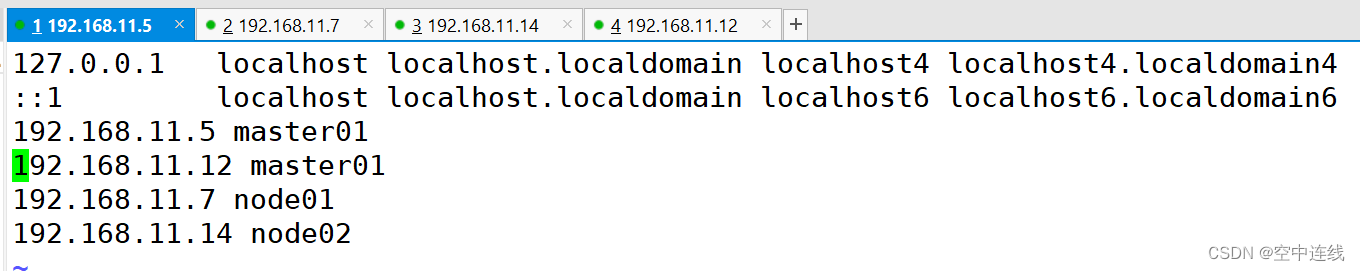

| master01 | 192.168.11.5 | kube-apiserver,kube-controller-manager,kube-scheduler,etcd |

| master02 | 192.168.11.12 | kube-apiserver,kube-controller-manager,kube-scheduler,etcd |

| node01 | 192.168.11.7 | etcd 、kubelet、kube-proxy、docker |

| node02 | 192.168.11.14 | etcd 、kubelet、kube-proxy、docker |

| 负载均衡(master) nginx+keeplived01 | Nginx 、keepalived | |

| 负载均衡(backup) nginx+keeplived02 | Nginx 、keepalived | |

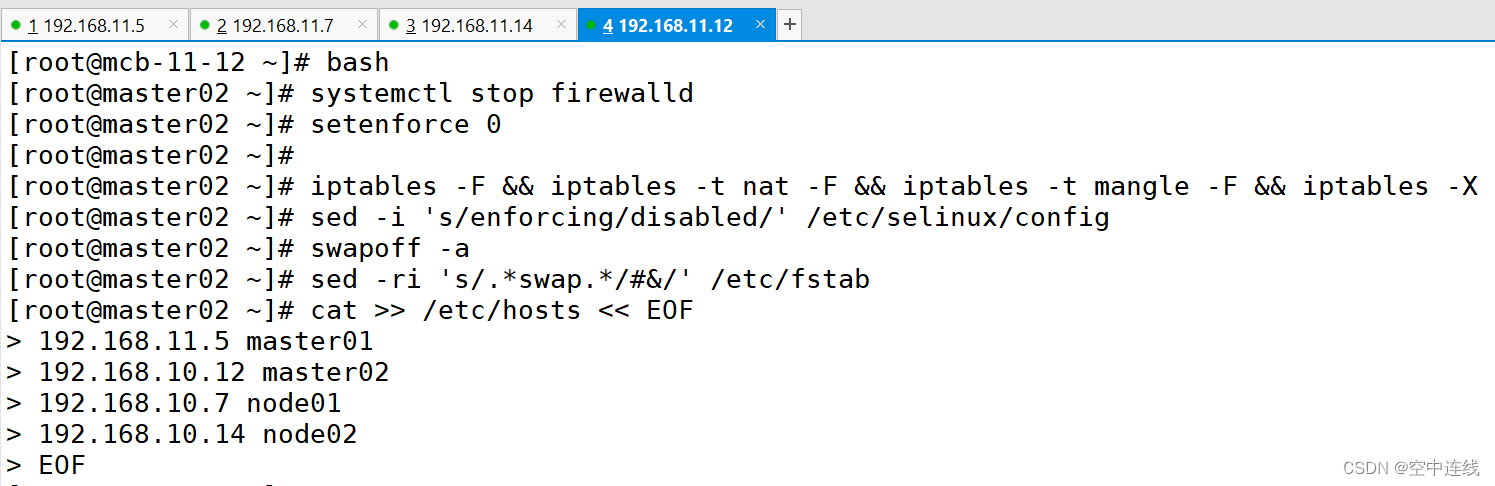

1 master02 开启防火墙防护 做映射

2 部署master02节点

etcd数据库所需要的ssl证书、master01节点的kubernetes安装目录(二进制文件、组件与apiserver通信的集群引导文件、启动参数配置文件)、kubectl与apiserver通信的集群引导文件、各组件被systemd管理的service文件

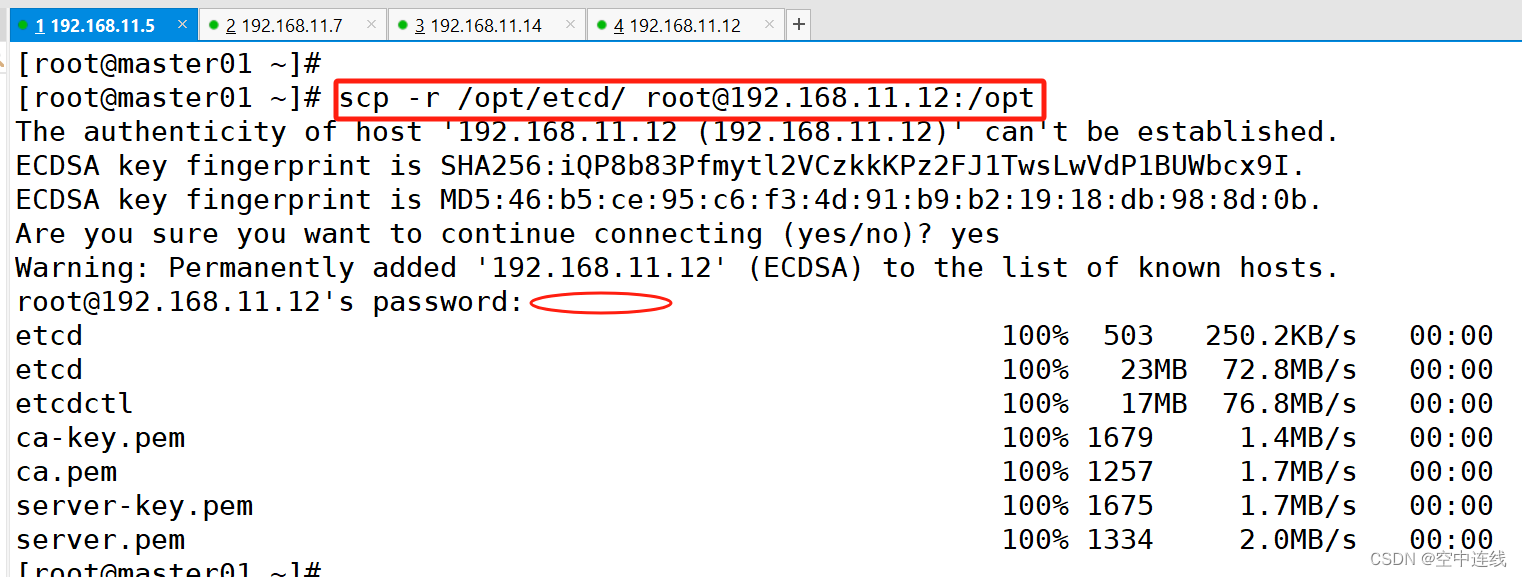

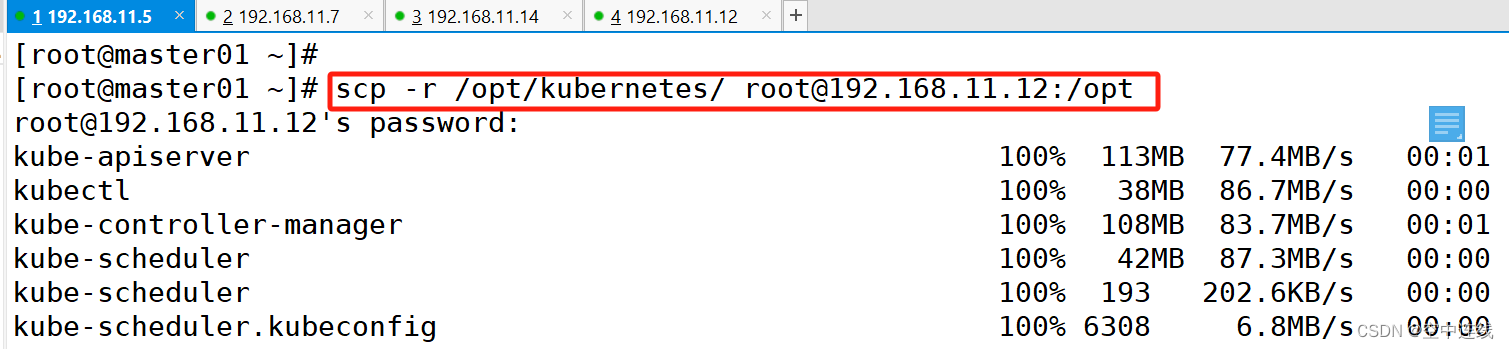

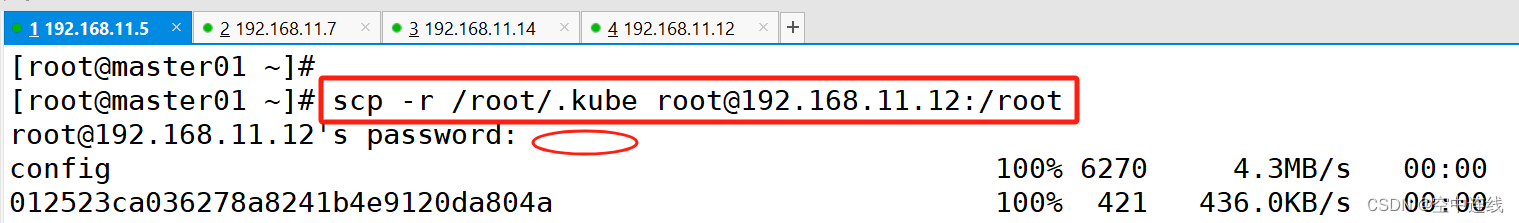

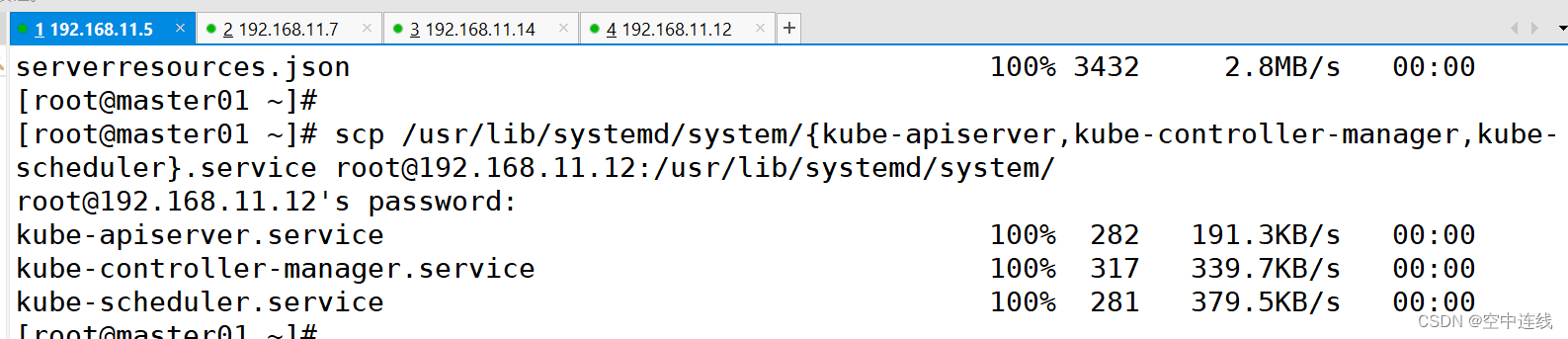

从 master01 节点上拷贝证书文件、各master组件的配置文件和服务管理文件到 master02 节点

scp -r /opt/etcd/ root@192.168.11.12:/opt/

scp -r /opt/kubernetes/ root@192.168.11.12:/opt

scp -r /root/.kube root@192.168.11.12:/root

scp /usr/lib/systemd/system/{kube-apiserver,kube-controller-manager,kube-scheduler}.service root@192.168.11.12:/usr/lib/systemd/system/

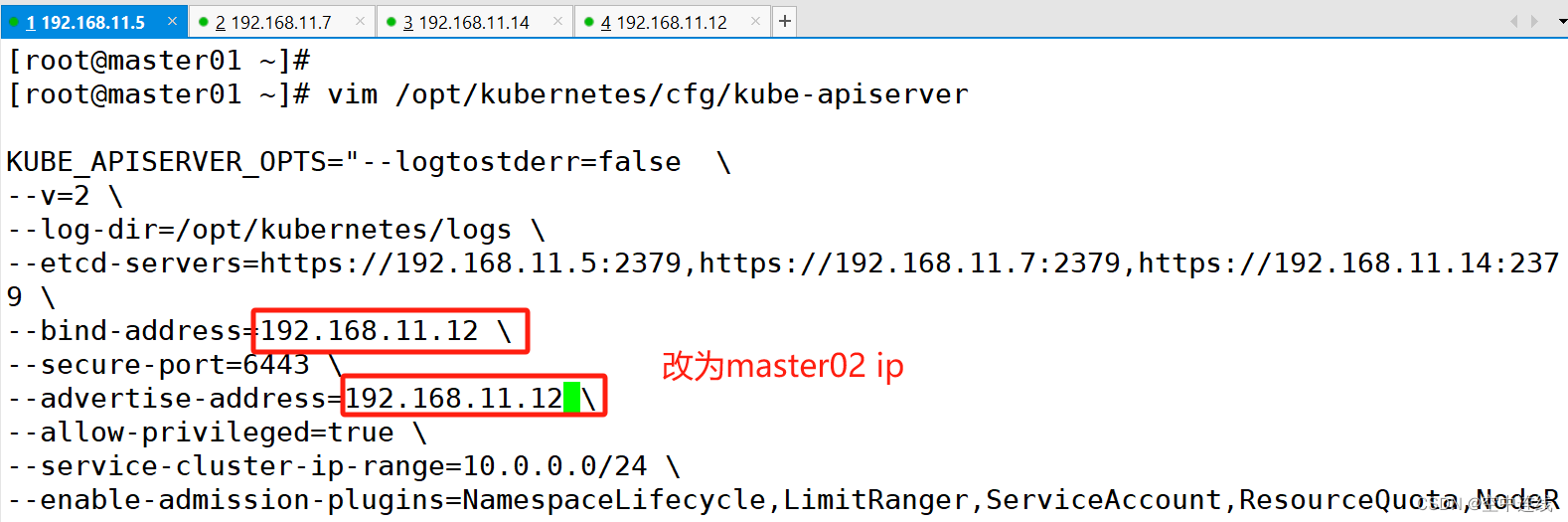

3 修改配置文件kube-apiserver中的IP

修改配置文件kube-apiserver中的IP

vim /opt/kubernetes/cfg/kube-apiserver

KUBE_APISERVER_OPTS="--logtostderr=true \

--v=4 \

--etcd-servers=https://192.168.10.80:2379,https://192.168.10.18:2379,https://192.168.10.19:2379 \

--bind-address=192.168.11.12 \ #修改

--secure-port=6443 \

--advertise-address=192.168.11.12 \ #修改 4 在 master02 节点上启动各服务并设置开机自启

4 在 master02 节点上启动各服务并设置开机自启

在 master02 节点上启动各服务并设置开机自启

systemctl start kube-apiserver.service

systemctl enable kube-apiserver.service

systemctl start kube-controller-manager.service

systemctl enable kube-controller-manager.service

systemctl start kube-scheduler.service

systemctl enable kube-scheduler.service

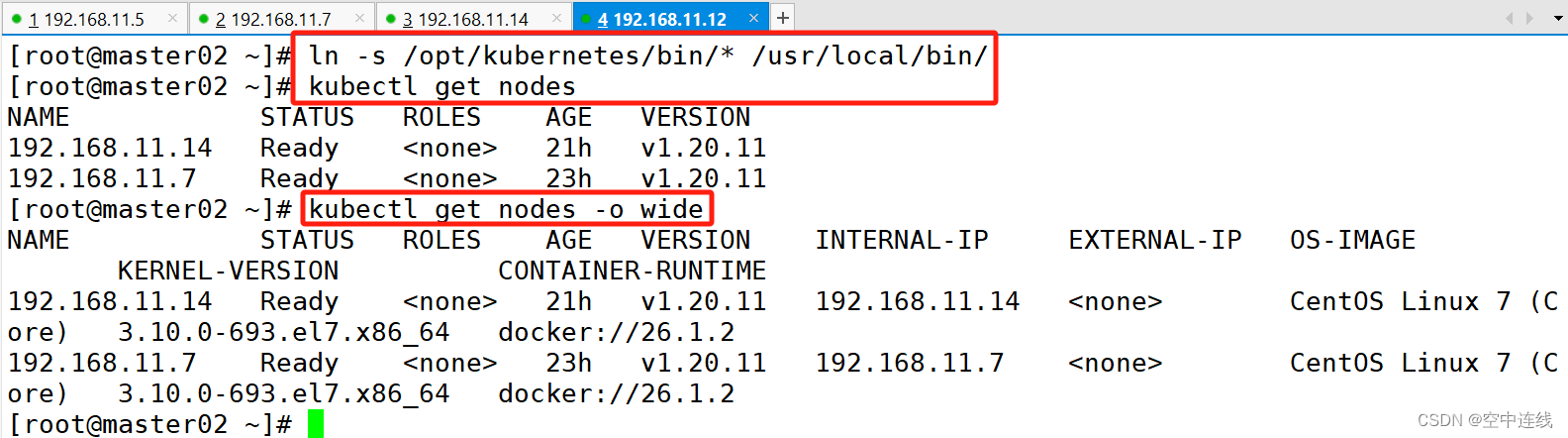

5 在master02查看node节点状态

查看node节点状态

ln -s /opt/kubernetes/bin/* /usr/local/bin/

kubectl get nodes

kubectl get nodes -o wide #-o=wide:输出额外信息;对于Pod,将输出Pod所在的Node名

//此时在master02节点查到的node节点状态仅是从etcd查询到的信息,而此时node节点实际上并未与master02节点建立通信连接,因此需要使用一个VIP把node节点与master节点都关联起来

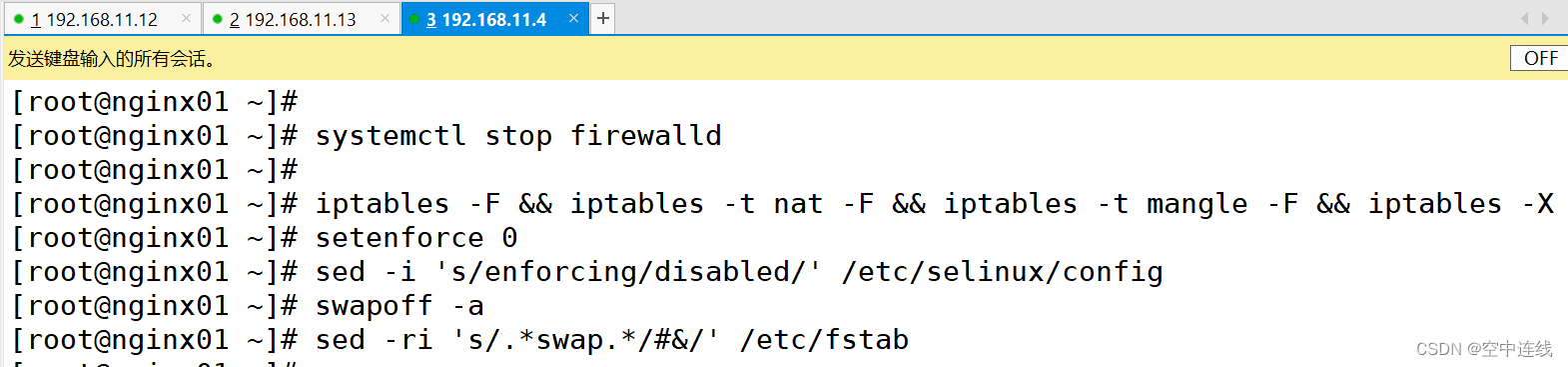

二 负载均衡+高可用部署

1部署初始环境

配置load balancer集群双机热备负载均衡

(nginx实现负载均衡,keepalived实现双机热备;主故障VIP切换从,故障恢复VIP再次漂移过来)

在nginx01、nginx02节点上操作 nginx01:192.168.11.13

nginx01:192.168.11.4

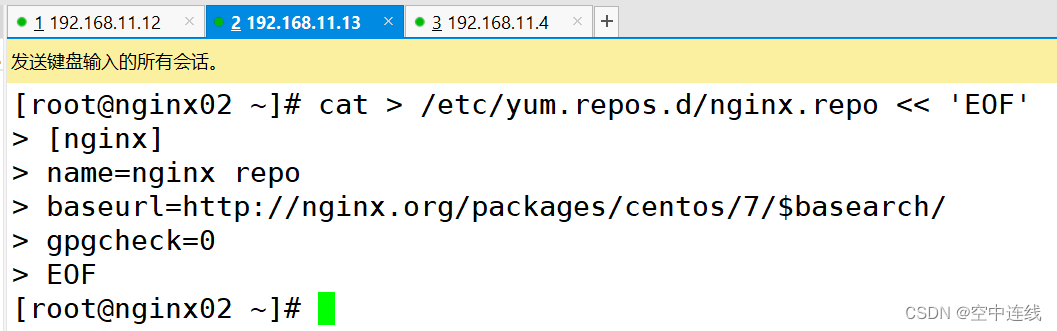

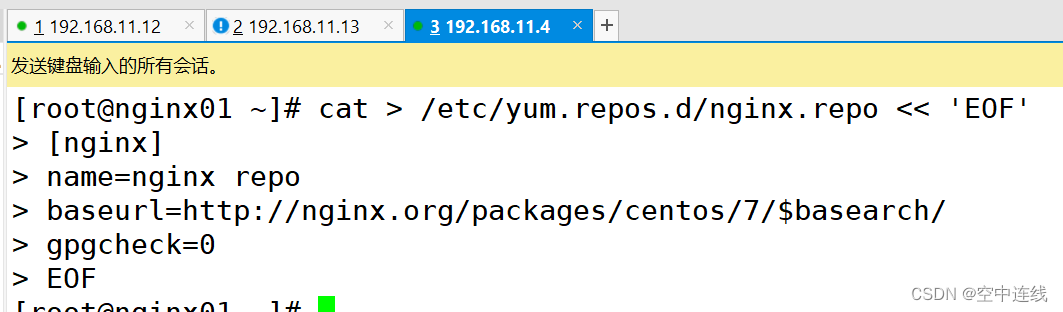

2 配置nginx的官方在线yum源,配置本地nginx的yum源

配置nginx的官方在线yum源,配置本地nginx的yum源

cat > /etc/yum.repos.d/nginx.repo << 'EOF'

[nginx]

name=nginx repo

baseurl=http://nginx.org/packages/centos/7/$basearch/

gpgcheck=0

EOF

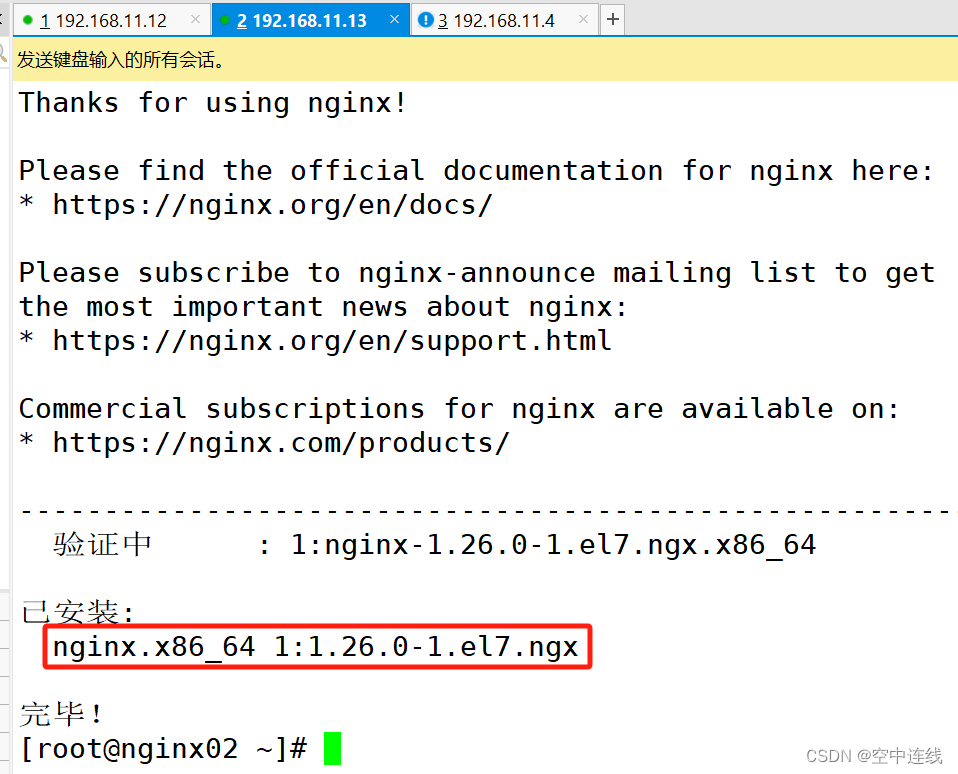

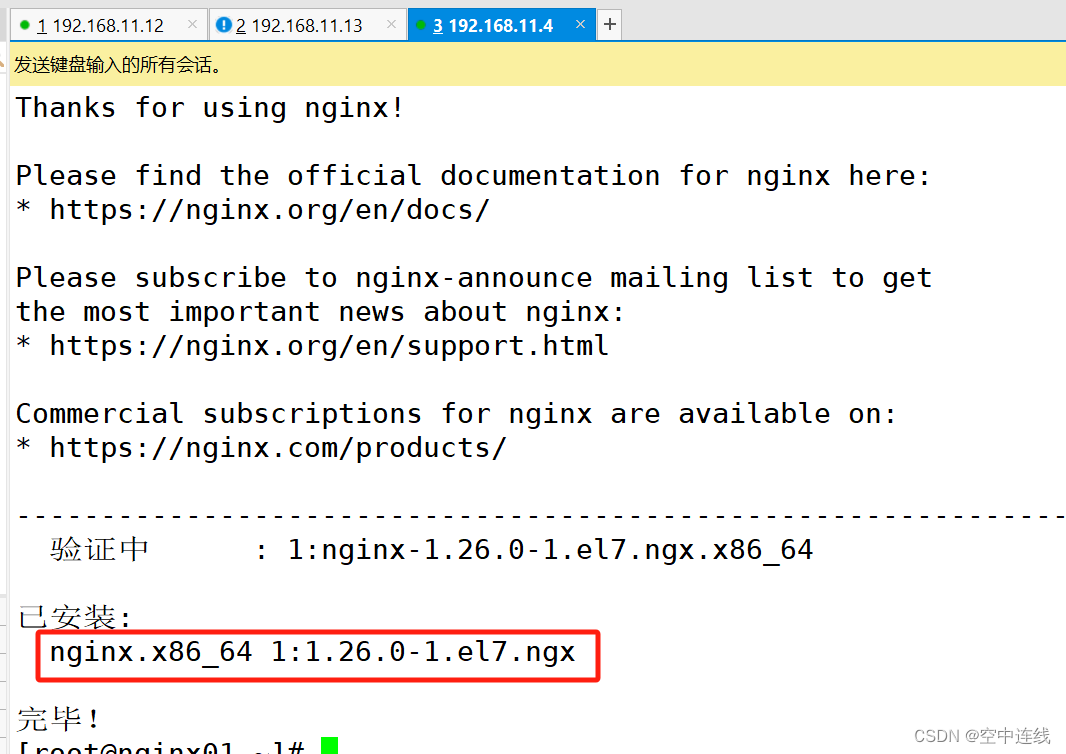

yum install nginx -y

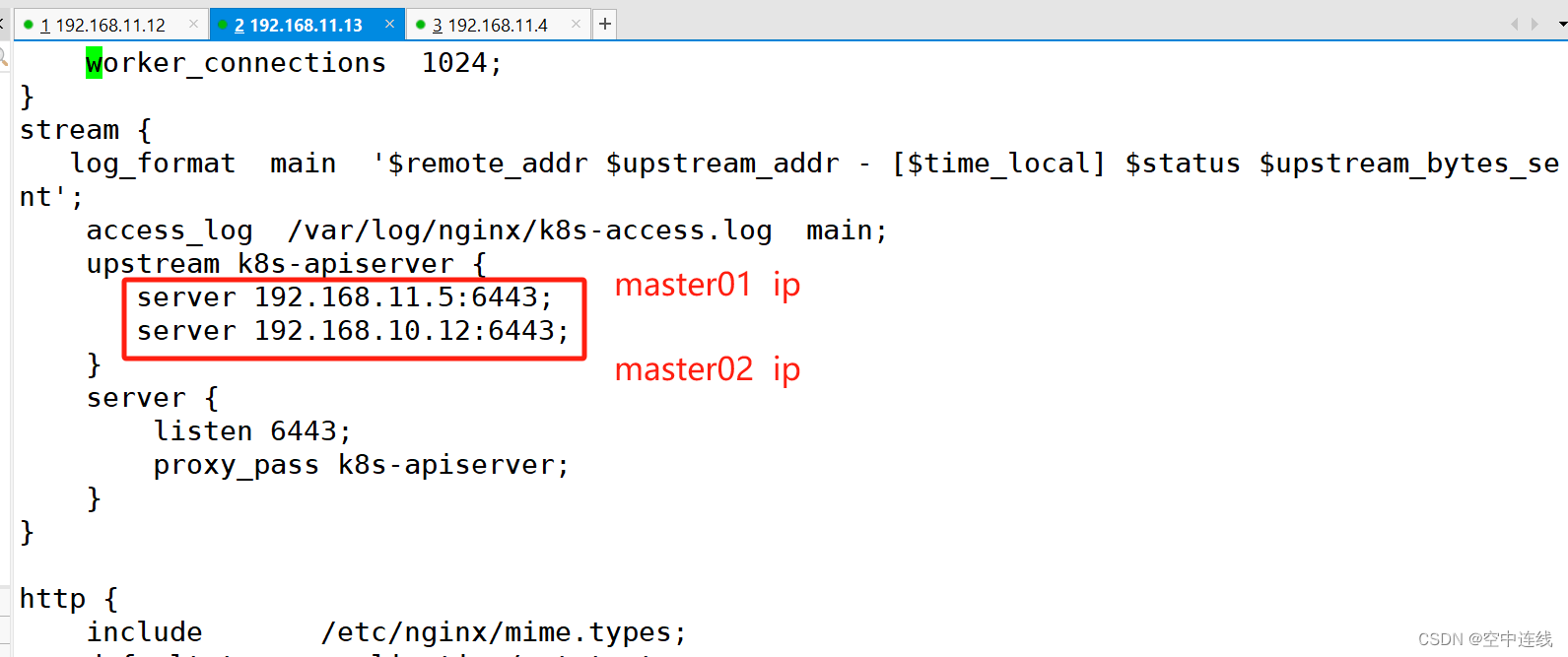

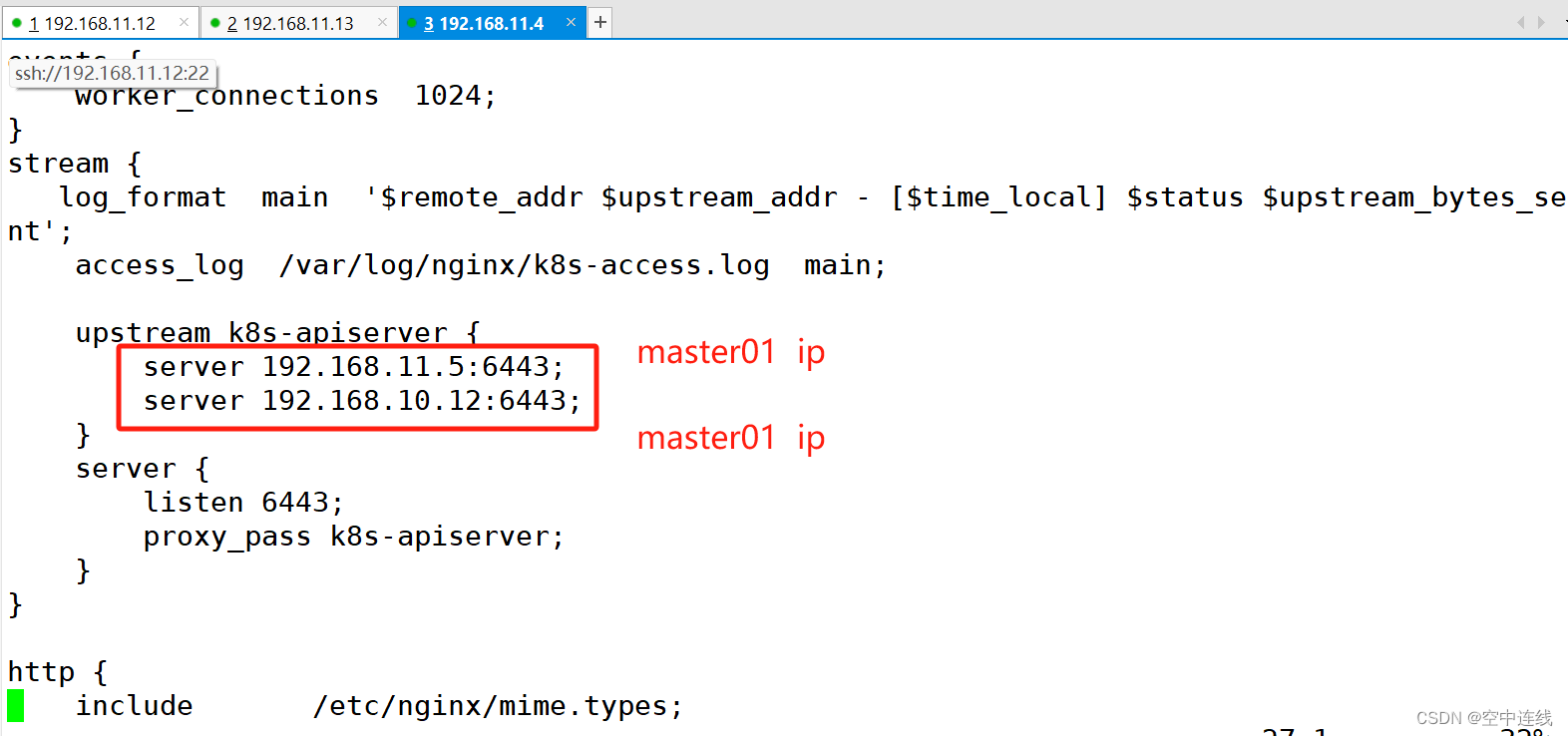

3 部署负载均衡

stream {

log_format main '$remote_addr $upstream_addr - [$time_local] $status $upstream_bytes_sent';

access_log /var/log/nginx/k8s-access.log main;

upstream k8s-apiserver {

server 192.168.11.5:6443;

server 192.168.10.12:6443;

}

server {

listen 6443;

proxy_pass k8s-apiserver;

}

}

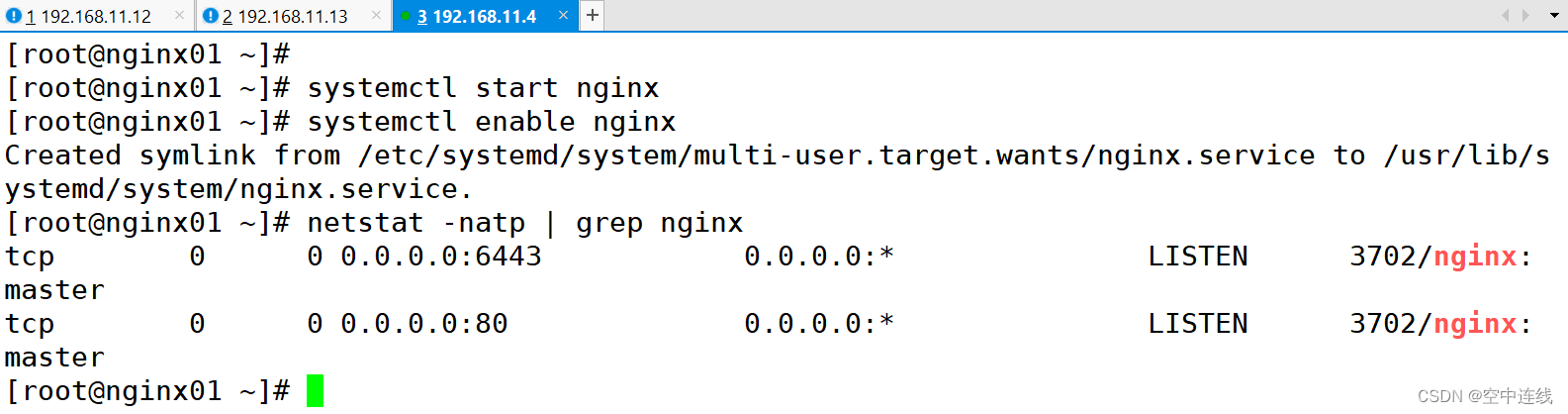

4 检查配置文件语法

5 启动nginx服务,查看监听6443端口

检查配置文件语法

nginx -t

//启动nginx服务,查看已监听6443端口

systemctl start nginx

systemctl enable nginx

netstat -natp | grep nginx

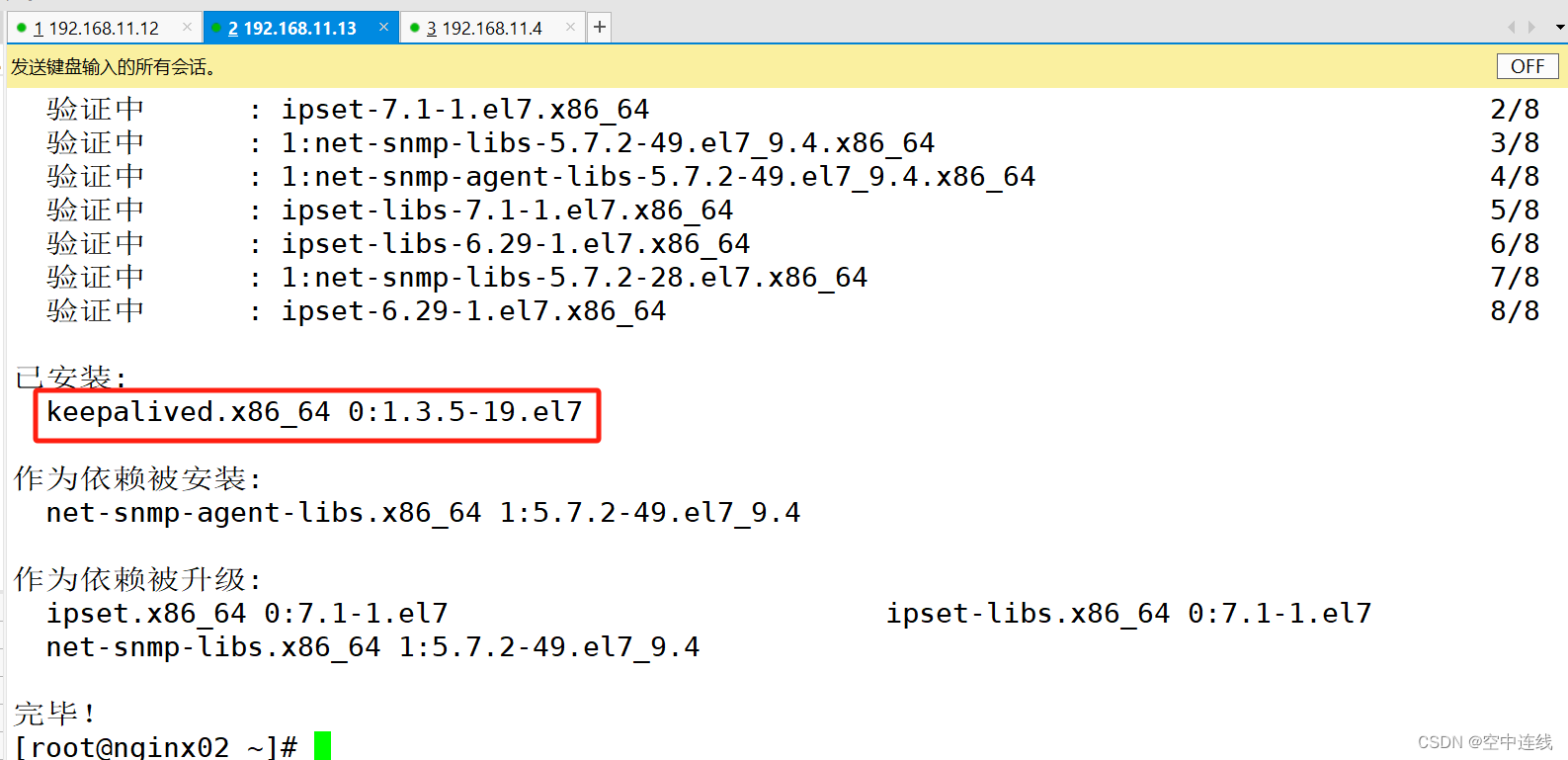

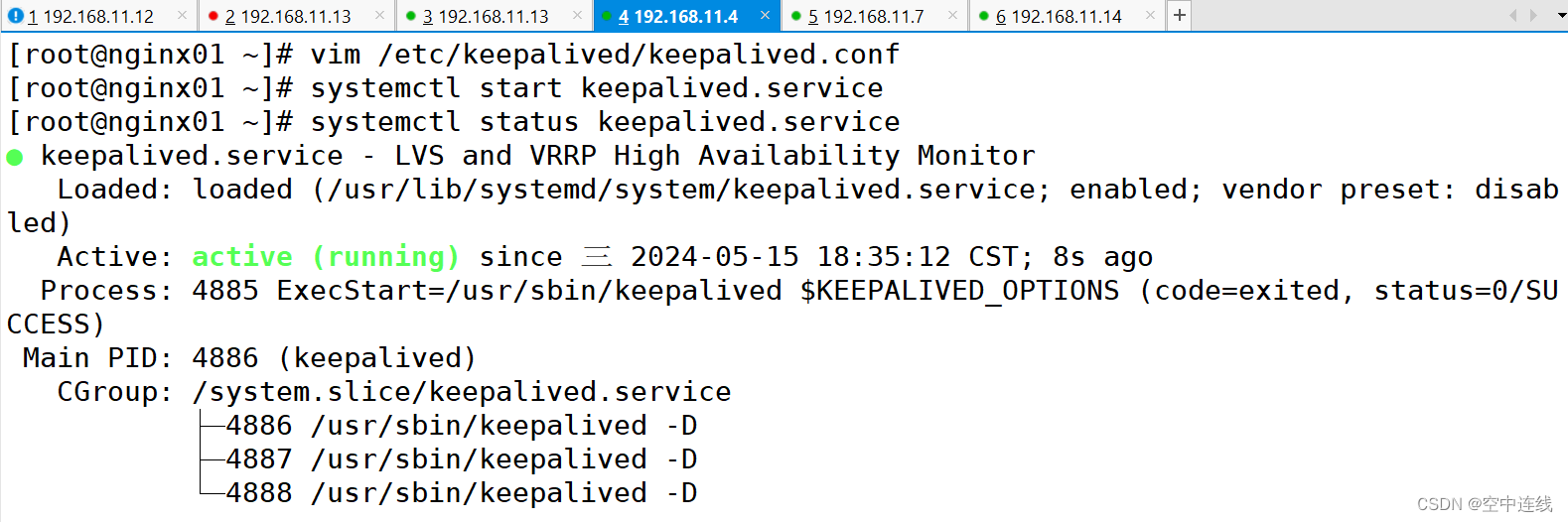

6 部署keepalived服务

部署keepalived服务

yum install keepalived -y

//修改keepalived配置文件

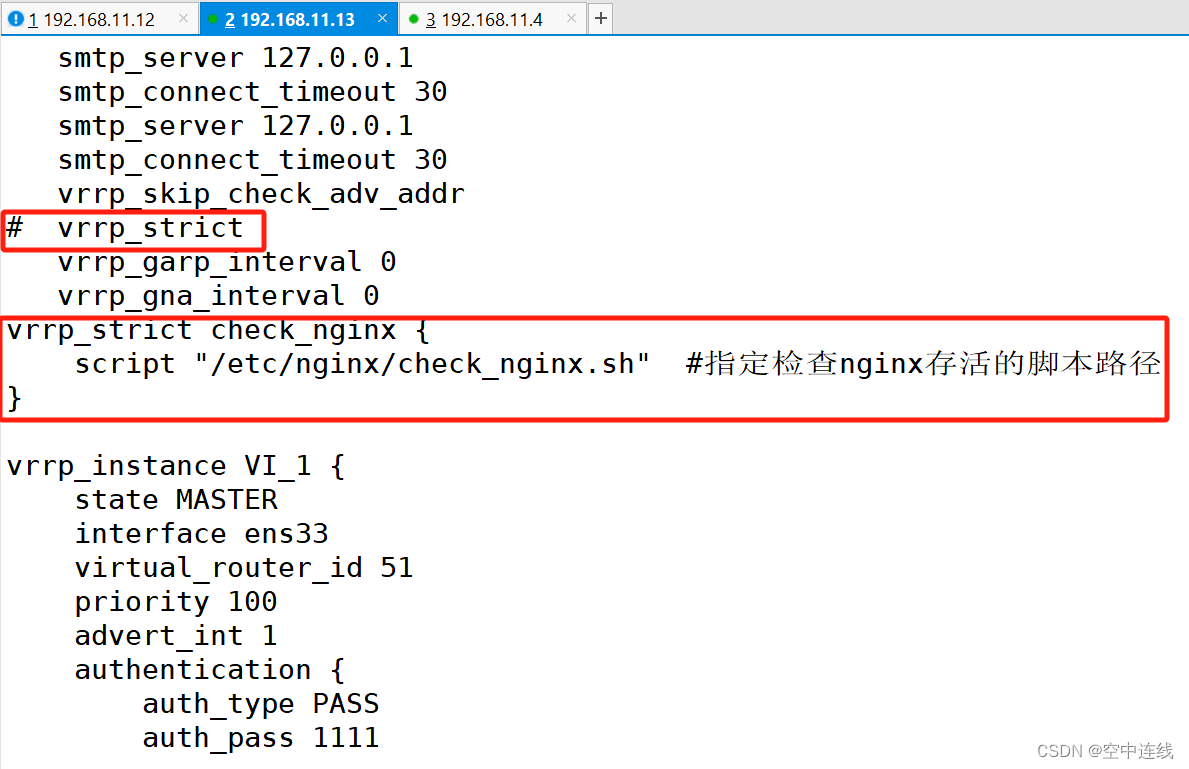

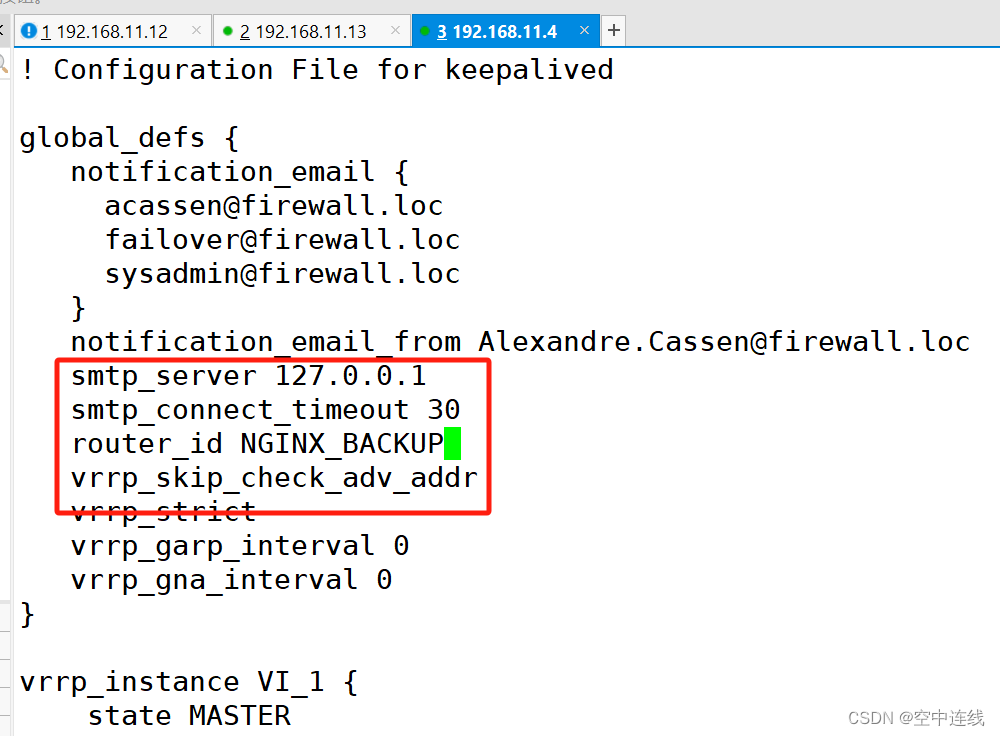

vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

# 接收邮件地址

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

# 邮件发送地址

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 127.0.0.1

smtp_connect_timeout 30

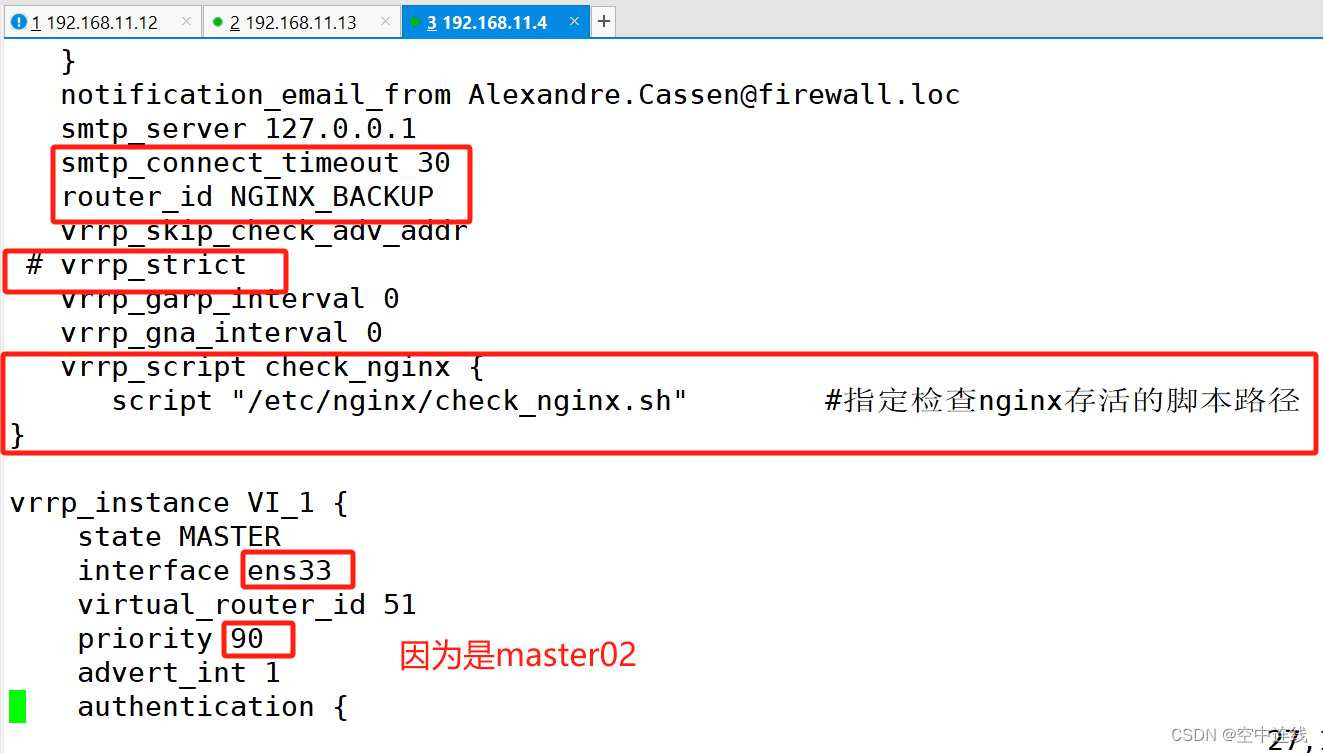

router_id NGINX_MASTER #lb01节点的为 NGINX_MASTER,lb02节点的为 NGINX_BACKUP

}

#添加一个周期性执行的脚本

vrrp_script check_nginx {

script "/etc/nginx/check_nginx.sh" #指定检查nginx存活的脚本路径

}

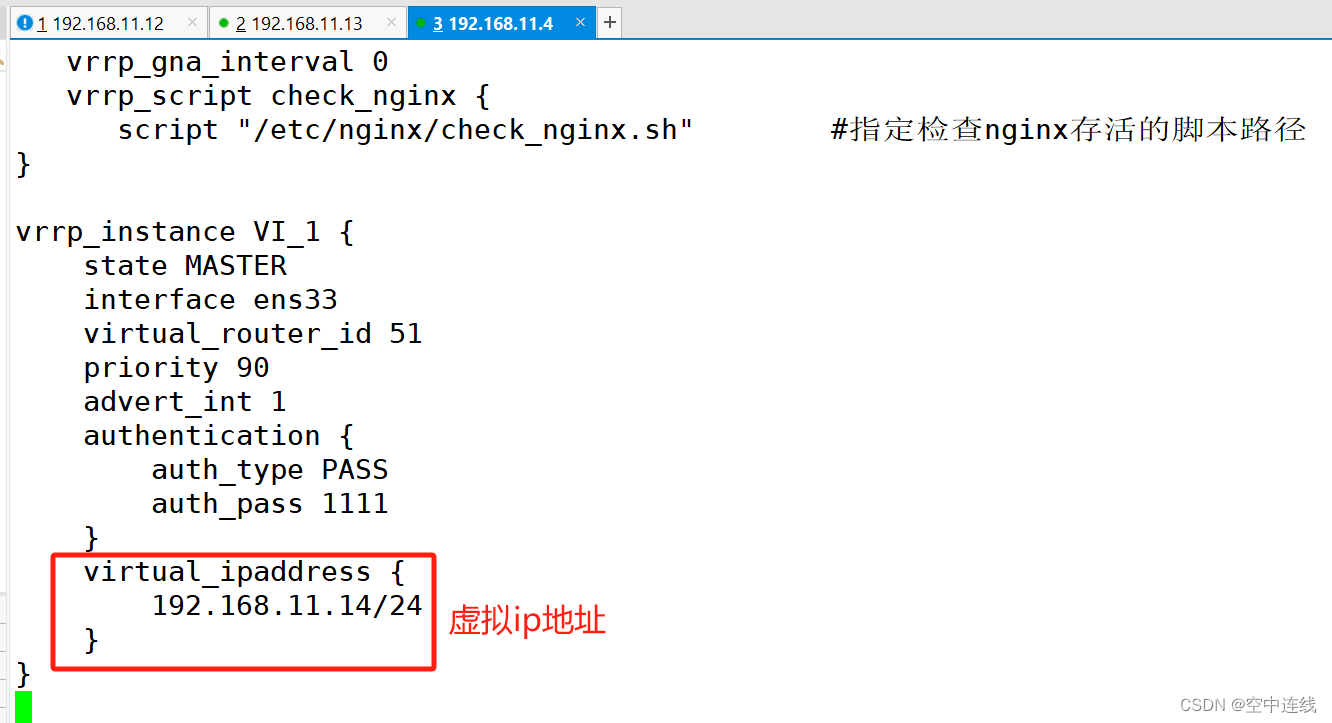

vrrp_instance VI_1 {

state MASTER #lb01节点的为 MASTER,lb02节点的为 BACKUP

interface ens33 #指定网卡名称 ens33

virtual_router_id 51 #指定vrid,两个节点要一致

priority 100 #lb01节点的为 100,lb02节点的为 90

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.10.100/24 #指定 VIP

}

track_script {

check_nginx #指定vrrp_script配置的脚本

}

}

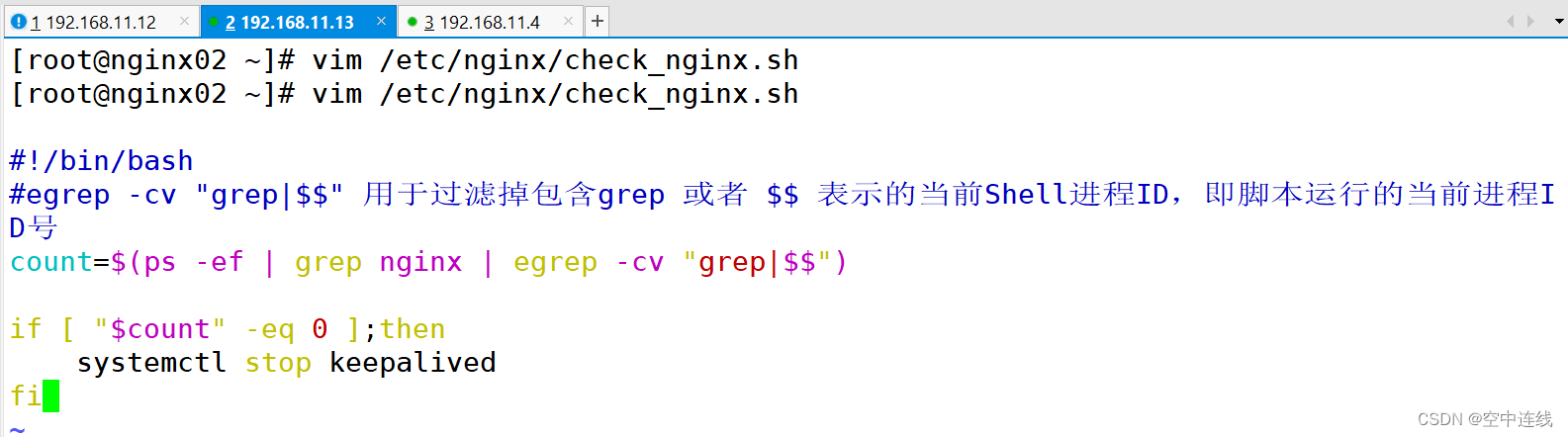

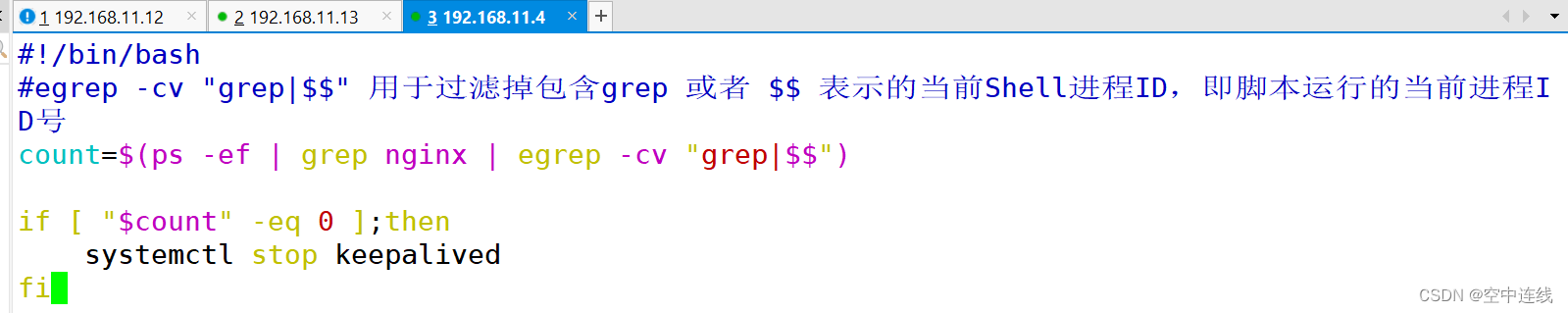

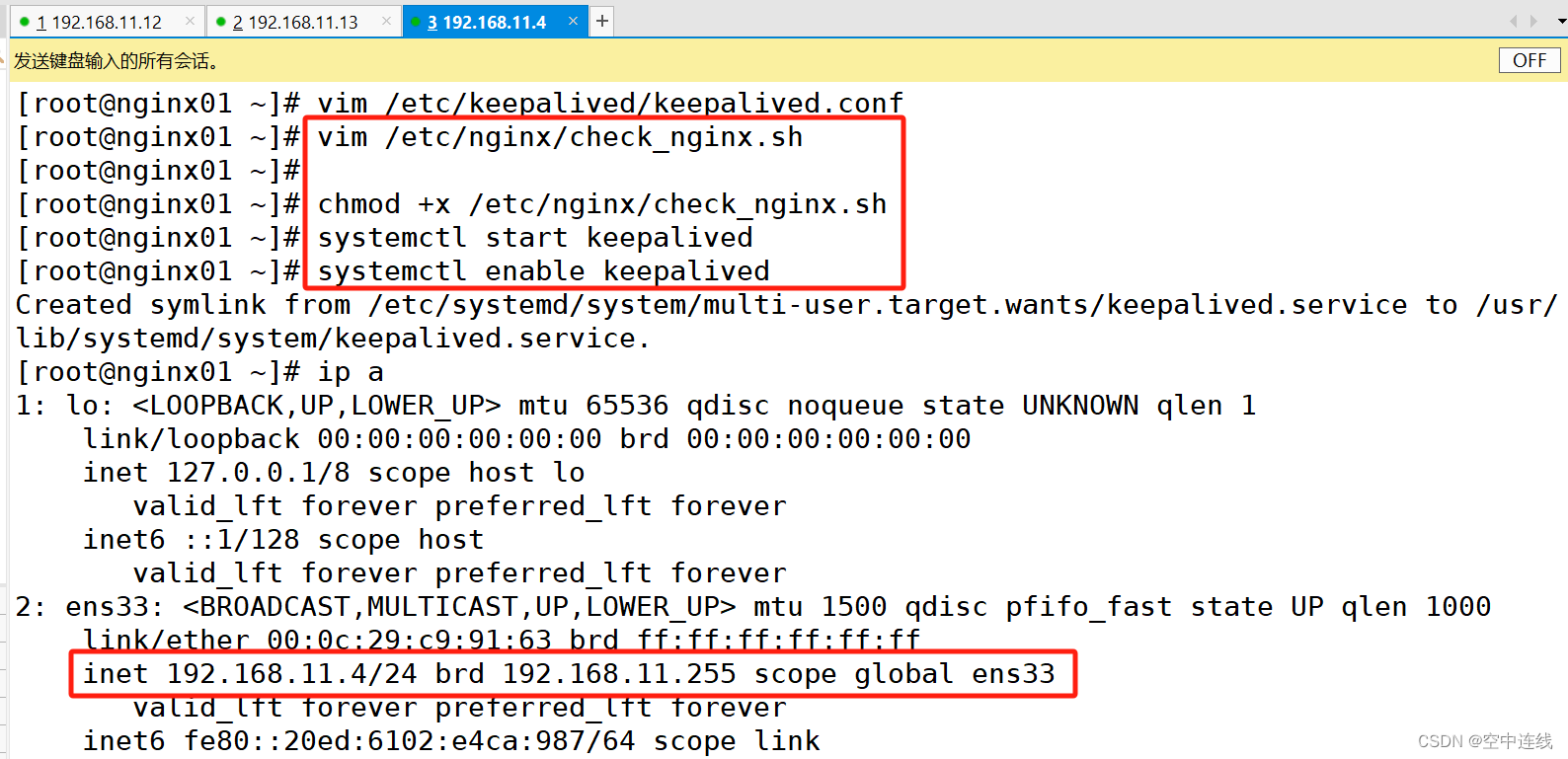

7 创建nginx状态检查脚本

创建nginx状态检查脚本

vim /etc/nginx/check_nginx.sh

#!/bin/bash

#egrep -cv "grep|$$" 用于过滤掉包含grep 或者 $$ 表示的当前Shell进程ID,即脚本运行的当前进程ID号

count=$(ps -ef | grep nginx | egrep -cv "grep|$$")

if [ "$count" -eq 0 ];then

systemctl stop keepalived

fi

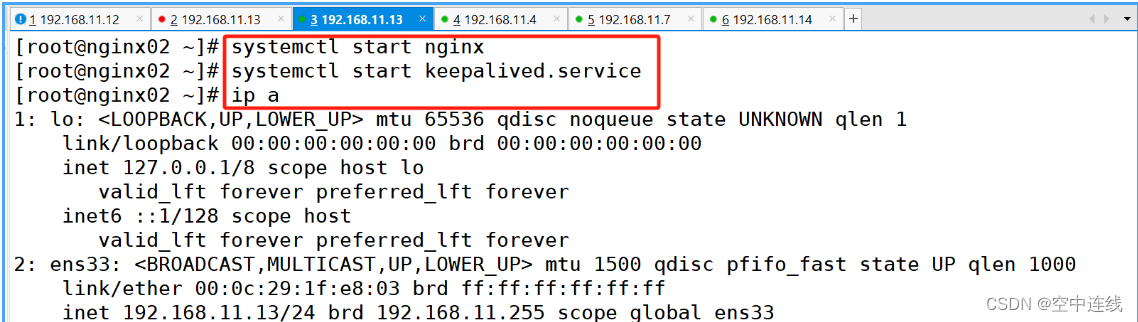

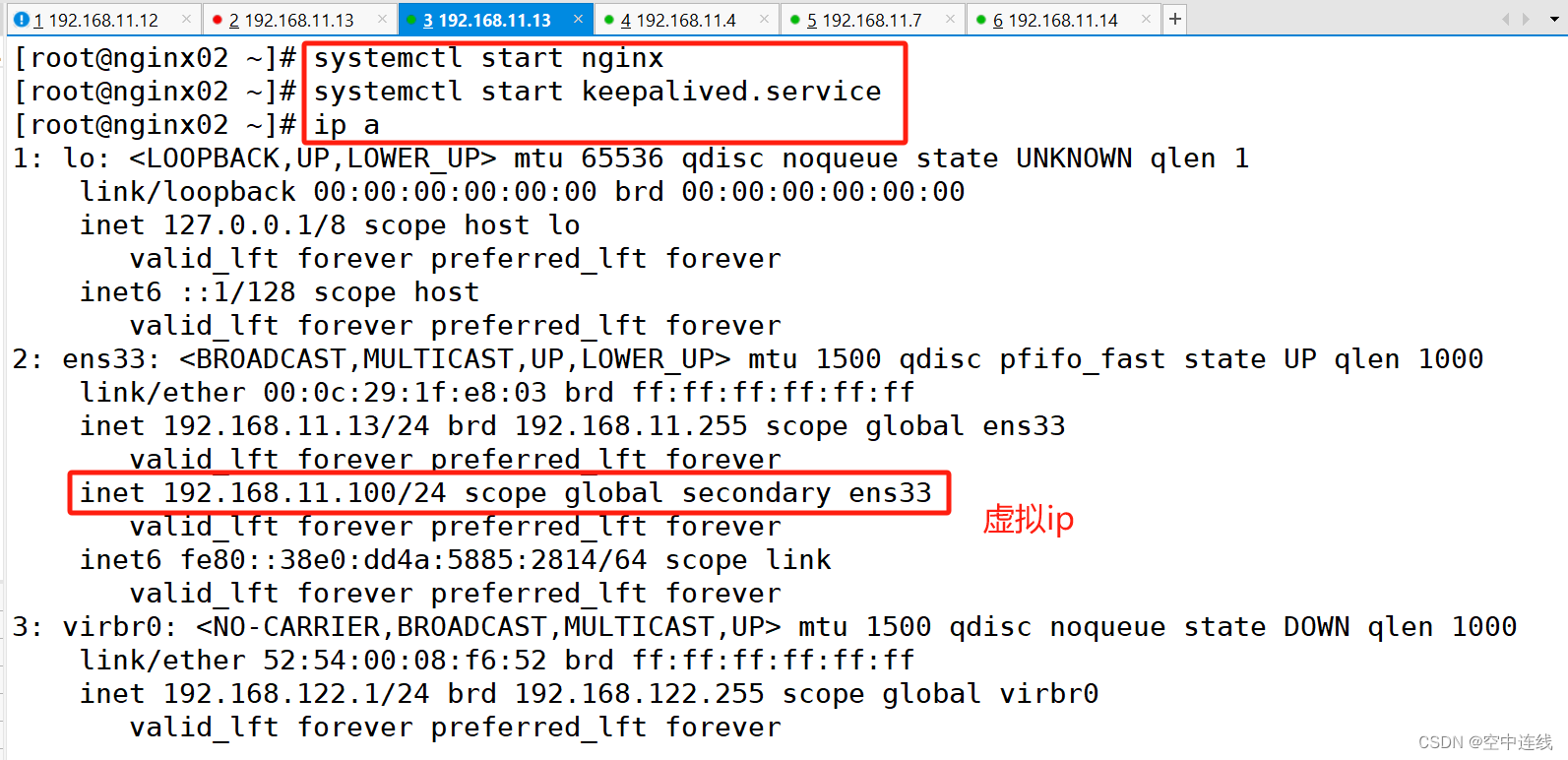

8 启动keepalived服务

注意:要先启动nginx 再启动keeplived

chmod +x /etc/nginx/check_nginx.sh

//启动keepalived服务(一定要先启动了nginx服务,再启动keepalived服务)

systemctl start keepalived

systemctl enable keepalived

ip a #查看VIP是否生成

9 检测是否高可用(虚拟IP漂移)

注意:

看日志:

① cd /var/log----cat messages

②检测 keepalived 服务 vip

由于虚拟环境挂起,导致服务无响应,vip 可能会消失。由于配置文件 bootstrap.kubeconfig、

kubelet.kubeconfig、kube-proxy.kubeconfig 指向 vip,重启 keepalived 服务恢复。

③ journalctl -f -u kubelet.service

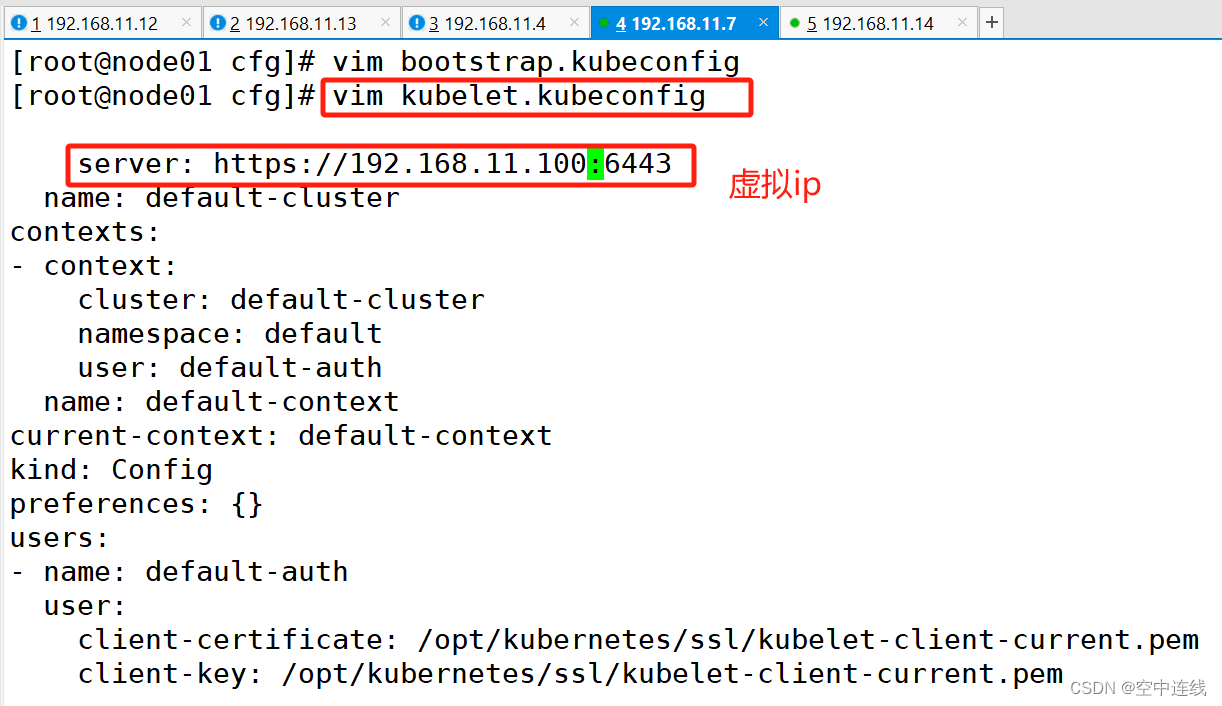

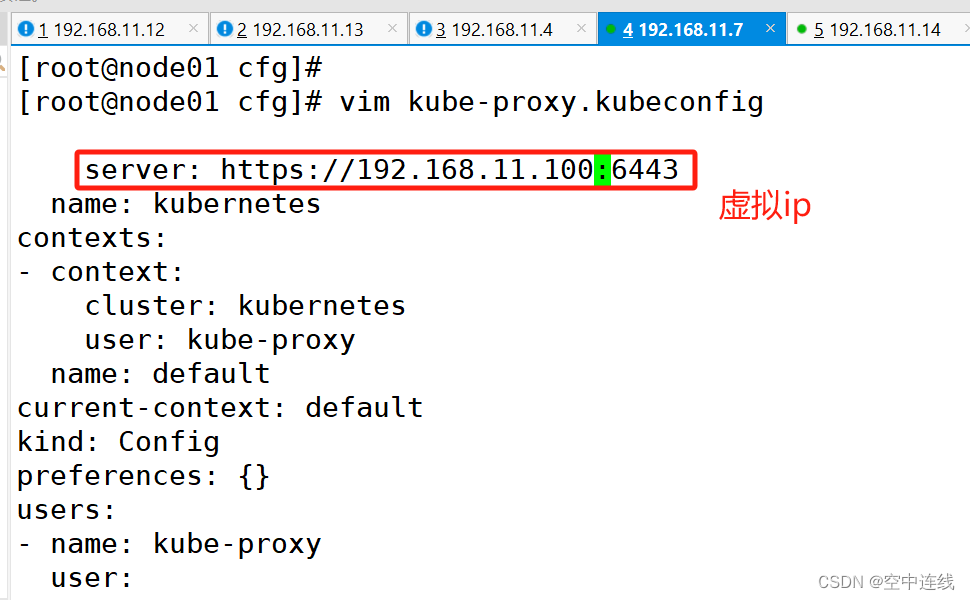

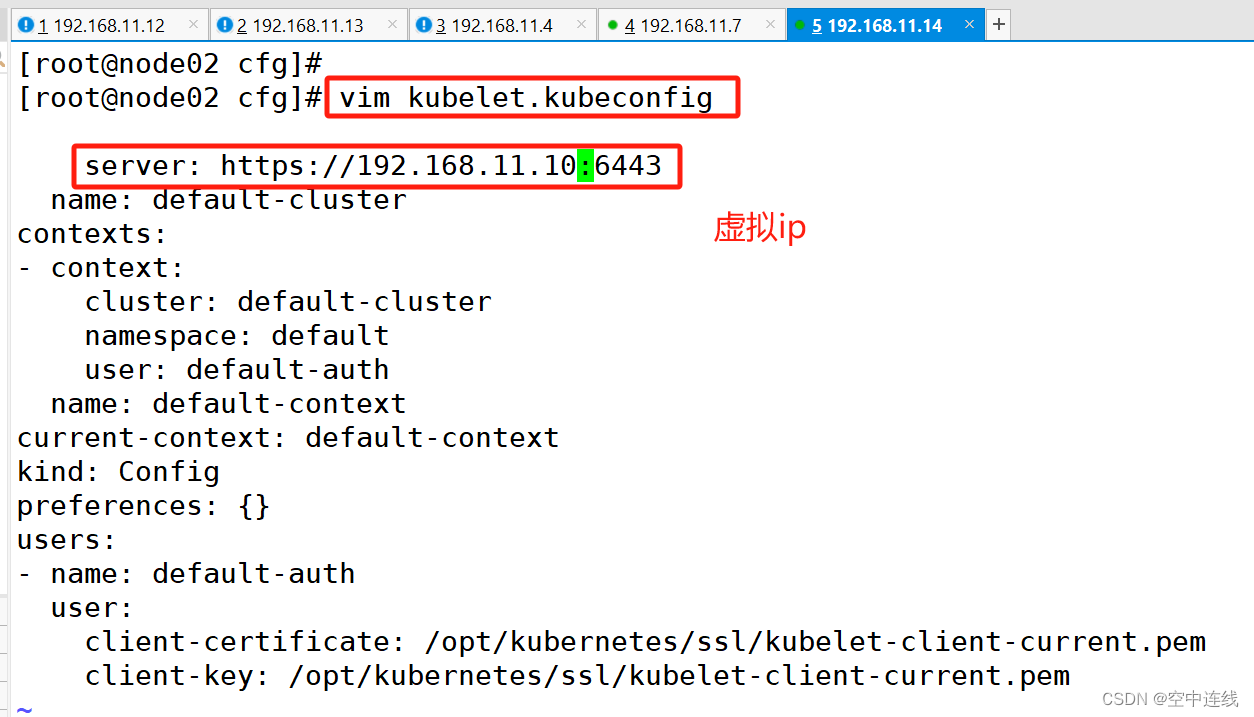

10 修改所有node节点配置文件

修改node节点上的bootstrap.kubeconfig,kubelet.kubeconfig配置文件为VIP

修改node节点上的bootstrap.kubeconfig,kubelet.kubeconfig配置文件为VIP

cd /opt/kubernetes/cfg/

vim bootstrap.kubeconfig

server: https://192.168.11.100:6443

vim kubelet.kubeconfig

server: https://192.168.11.100:6443

vim kube-proxy.kubeconfig

server: https://192.168.11.100:644311 修改 node01节点的bootstrap.kubeconfig 配置文件VIP

12 修改node01节点 kubelet.kubeconfig配置文件vip

13 修改node节点kube-proxy.kubeconfig

13 修改node节点kube-proxy.kubeconfig

node02

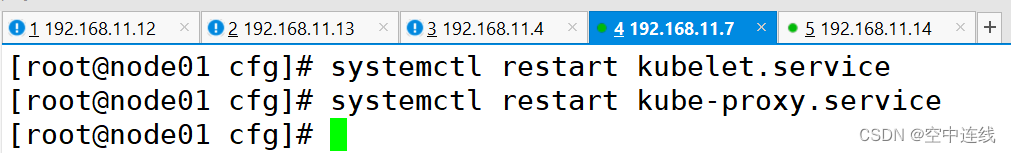

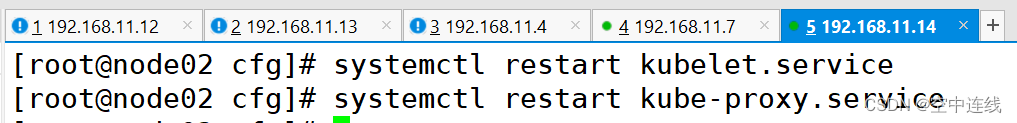

14 重启kubelet和kube-proxy服务

重启kubelet和kube-proxy服务

systemctl restart kubelet.service

systemctl restart kube-proxy.service

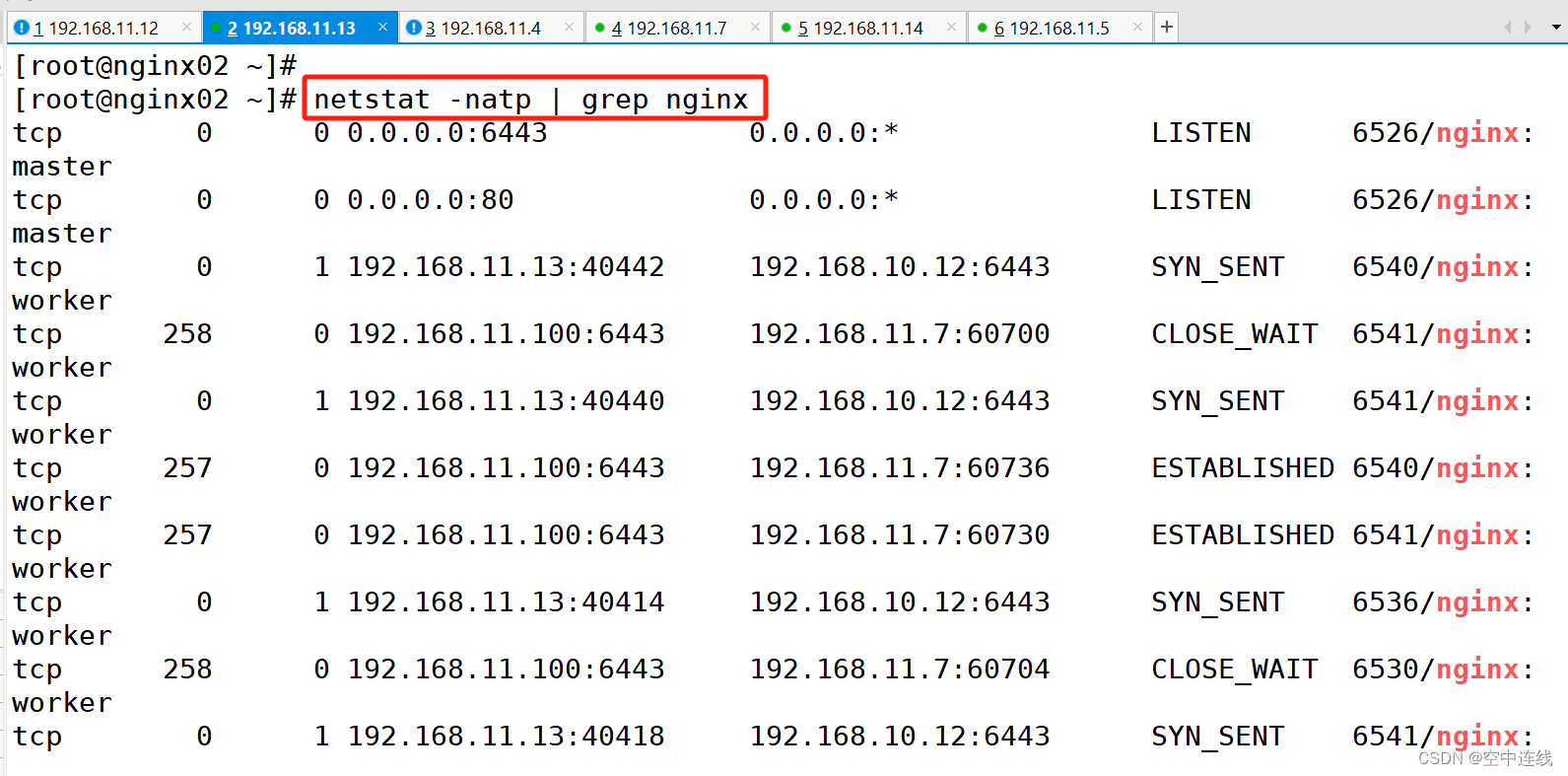

15 查看连接状态

在 nginx01 上查看 nginx 和 node 、 master 节点的连接状态

netstat -natp | grep nginx

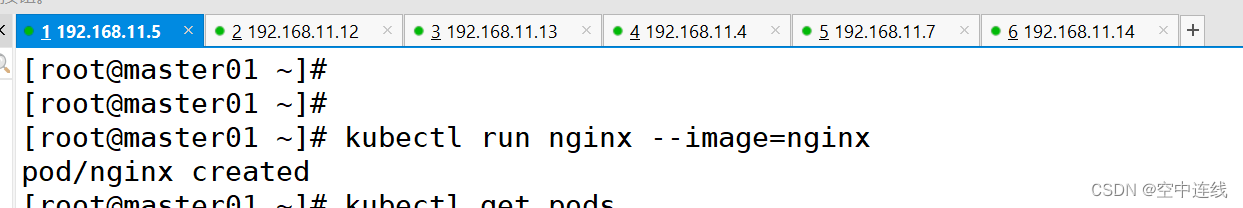

三 在 master01 节点上操作

1 测试创建pod

在 master01 节点上操作

//测试创建pod

kubectl run nginx --image=nginx

2 查看pod的状态信息

kubectl get pods -o wide

3 也可直接使用浏览器

在对应网段的node节点上操作,可以直接使用浏览器或者curl命令访问

curl 192.168.11.1004 这时在master01节点上查看nginx日志

这时在master01节点上查看nginx日志

kubectl logs nginx-dbddb74b8-nf9sk

767

767

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?