感知机:

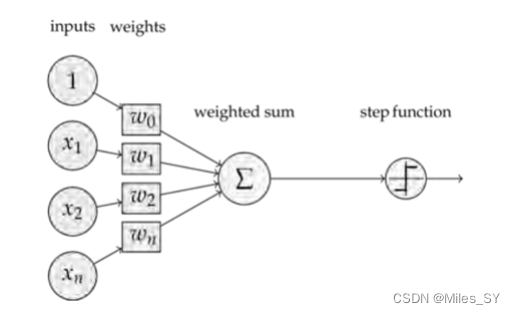

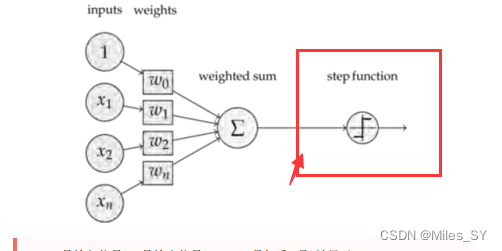

感知机接收多个输入信号, 输出一个信号。 这里所说的“信号”可以想象成电流或河 流那样具备“流动性”的东西。 像电流流过导线, 向前方输送电子一样, 感知机的信 号也会形成流, 向前方输送信息。

核心思想(重点)

BP(BackPropagation) 算法是神经网络深度学习中最重要的算法之一,是一种按照误 差逆向传播算法训练的多层前馈神经网络,是应用最广泛的神经网络模型之一 。了 解BP算法可以让我们更理解神经网络深度学习模型训练的本质,属于内功修行的部分。

BP算法的核心思想是:学习过程由信号的正向传播和误差的反向传播两个过程组成。

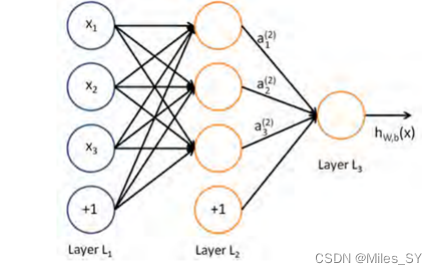

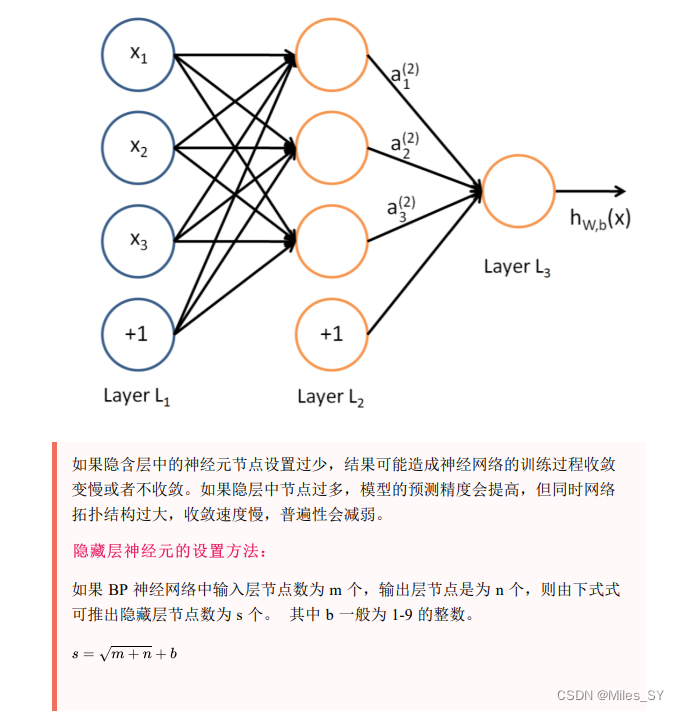

正向传播:输入层的神经元负责接受外界发来的各种信息,并将信息传递给中间层 神经元,中间隐含层神经元负责将接收到的信息进行处理变换,根据需求处理信息, 实际应用中可将中间隐含层设置为一层或者多层隐含层结构,并通过最后一层的隐含 层将信息传递到输出层,这个过程就是BP神经网络的正向传播过程。

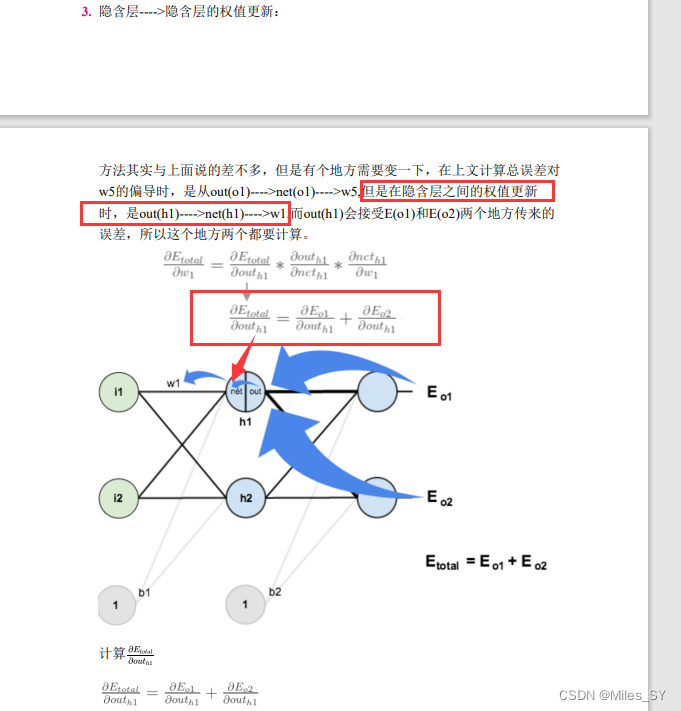

反向传播:当实际输出与理想输出之间的误差超过期望时,就需要进入误差的反向 传播过程。它首先从输出层开始,误差按照梯度下降的方法对各层权值进行修正,并 依次向隐含层、输入层传播。通过不断的信息正向传播和误差反向传播,各层权值会 不断进行调整,这就是神经网络的学习训练。当输出的误差减小到期望程度或者预先 设定的学习迭代次数时,训练结束,BP神经网络完成学习

推导:

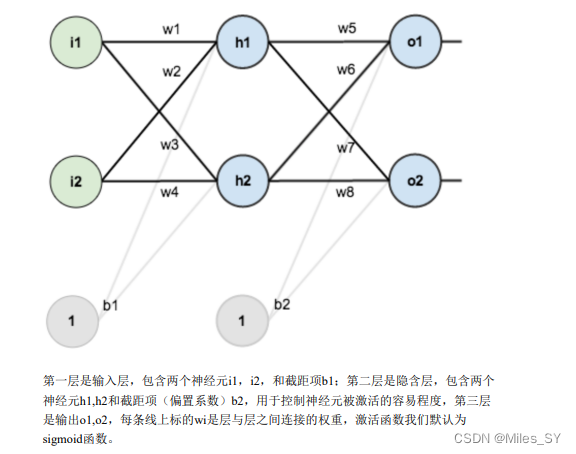

最初的权重(w1.2.3456578..)可以是随机的,可在训练时不断更新。

(out相当于“新的“i1——之后算出o1)

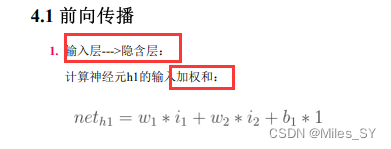

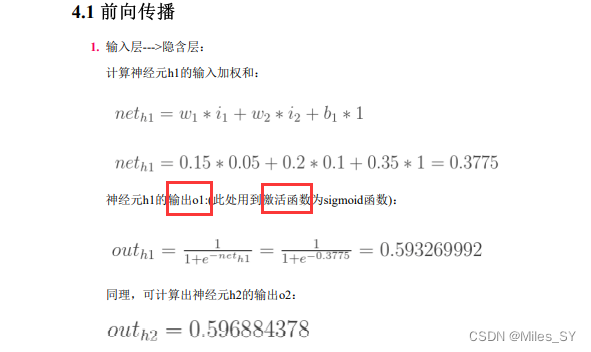

前向传播:

加权求和———neth1![]()

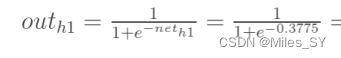

求和之后激活———outh1

这里举例为sigmoid函数

(

py中的一些库算出来?)

下一层——

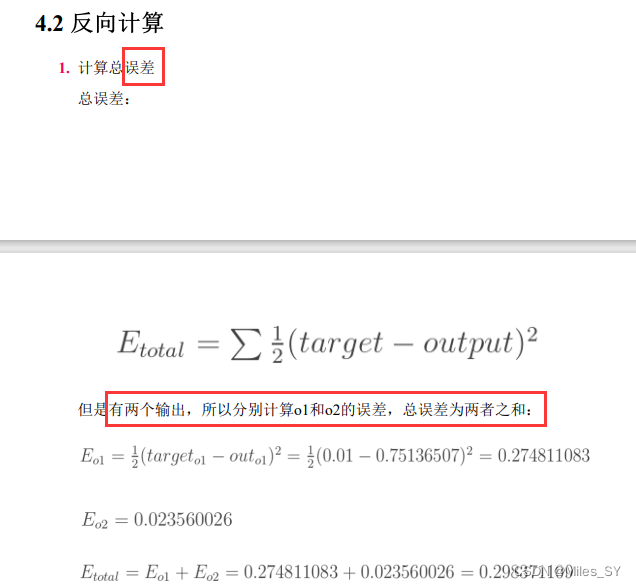

反向计算:

1、误差(损失)有很多损失函数,这里举例为均方差

核心:反向传播——更新权重

。。。。。。

更新权重

(用到了梯度下降的一个式子)

最后更新到输入层

2055

2055

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?