前言

今天整理一下 yarn Container 的日志清理机制。

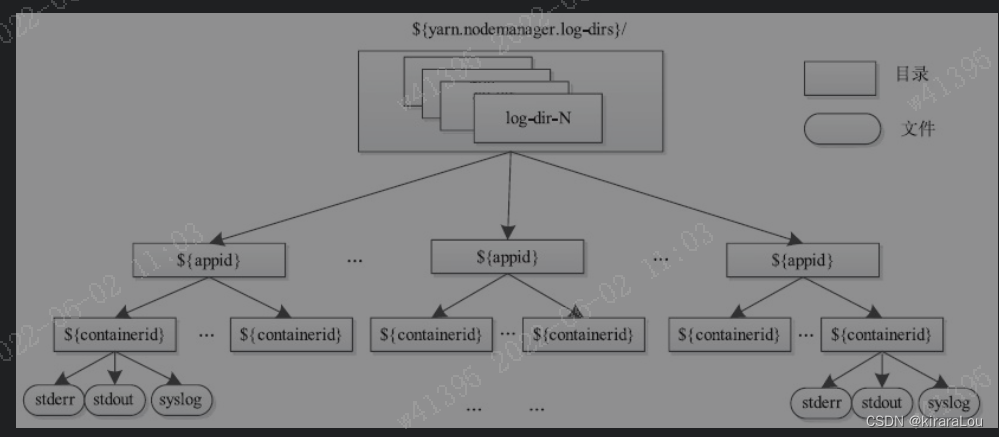

一、container 日志目录结构

Yarn container的日志目录结构如下图所示。

NodeManager 会在所有目录上为同一个应用程序建立相同的目录结构,并采用轮询的调度方式将这些目录分配给不同Container使用。每个Container将输出三类日志:

stdout:使用标准输出函数打印的日志,比如Java中的System.out.print输出的内容。stderr:标准错误输出产生的日志信息。syslog:使用log4j打印的日志信息,这是最常用的打印日志方式,默认情况下,YARN采用了这种方式打印日志,换句话说,通常情况下,只有这个文件中有内容,其他两个文件为空。

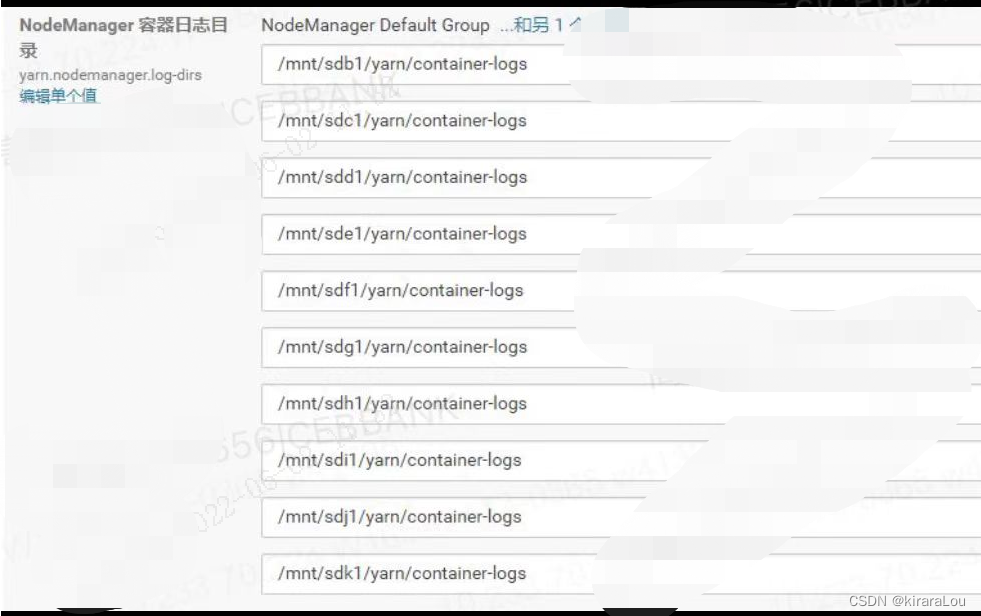

这个配置为 yarn.nodemanager.log-dirs。

二、日志清理机制

由于NodeManager将所有Container的运行日志保存到本地磁盘上,因此,随着时间的积累,日志必将越来越多。为了避免大量Container日志“撑爆”磁盘空间,NodeManager将定期清理日志文件,该功能由组件LogHandler(当前存在两种实现:NonAggregatingLogHandler和LogAggregationService)完成。

总起来说,NodeManager提供了定期删除(由NonAggregatingLogHandler实现)和日志聚集转存(由LogAggregation-Service实现)两种日志清理机制,默认情况下,采用的是定期删除机制。

1. 定期删除

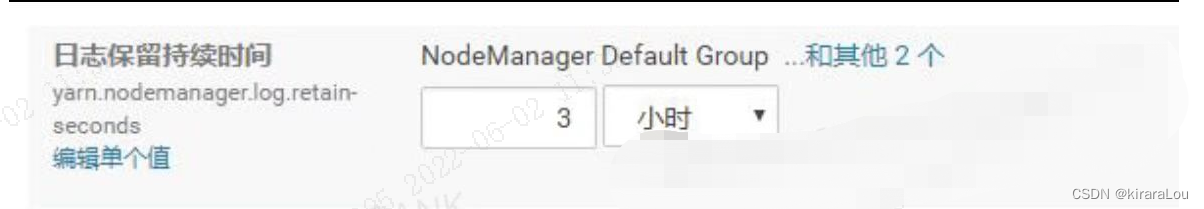

NodeManager允许一个应用程序日志在磁盘上的保留时间为yarn.nodemanager.log.retain-seconds(单位是秒,默认为3×60×60,即3小时),一旦超过该时间,NodeManager会将该应用程序所有日志从磁盘上删除。

注意点:

当开启日志聚合功能后,该配置无效。

yarn.nodemanager.delete.debug-delay-sec:默认值为 0,表示在开启日志聚合功能的情况下,应用完成后,进行日志聚合,然后 NodeManager 的 DeletionService 立即删除应用的本地日志。如果想查看应用日志,可以将该属性值设置得足够大(例如,设置为 600 = 10 分钟)以允许查看这些日志。yarn.nodemanager.delete.thread-count: NodeManager 用于日志清理的线程数,默认值为 4。

2. 日志聚集转存

除定期删除外,NodeManager还提供了另一种日志处理方式——日志聚集转存[插图],管理员可通过将配置参数yarn.log-aggregation-enable置为true启用该功能。

该机制将HDFS作为日志聚集仓库,它将应用程序产生的日志上传到HDFS上,以便统一管理和维护。该机制由两阶段组成:文件上传和文件生命周期管理。

(1) 文件上传

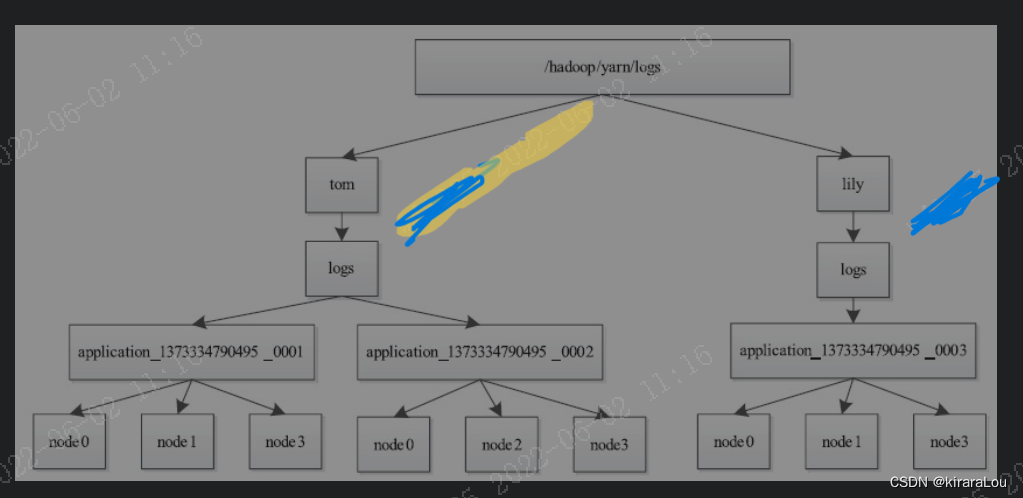

当一个应用程序运行结束时,它产生的所有日志将被统一上传到HDFS上的${remoteRootLogDir}/${user}/${suffix}/${appid} 例如大多都是在 /tmp/logs/userA/logs/appid_xxxx

${remoteRootLogDir}值由参数yarn.nodemanager.remote-app-log-dir指定,默认是/tmp/logs${user}为应用程序拥有者${suffix}值由参数yarn.nodemanager.remote-app-log-dir-suffix指定,默认是"logs"${appid}为应用程序ID

且同一个节点中所有日志保存到该目录中的同一个文件,这些文件以节点ID命名。

日志结构图如下图所示。

一旦日志全部上传到HDFS后,本地磁盘上的日志文件将被删除。此外,为了减少不必要的日志上传,NodeManager允许用户指定要上传的日志类型。当前支持的日志类型有三种:

ALL_CONTAINERS(上传所有Container日志)APPLICATION_MASTER_ONLY(仅上传ApplicationMaster产生的日志)AM_AND_FAILED_CONTAINERS_ONLY(上传ApplicationMaster和运行失败的Container产生的日志),默认情况下采用ALL_CONTAINERS。

(2) 文件生命周期管理

转存到HDFS上的日志的生命周期不再由NodeManager负责,而是由JobHistory服务管理。比如对于MapReduce计算框架而言,它专有的JobHistory负责定期清理MapReduce作业转存到HDFS上的日志,每个日志文件最多存留时间为yarn.log-aggregation.retain-seconds(单位是秒,默认为3×60×60,即3小时)。

用户可通过两种方式查看应用程序日志,一种是通过NodeManager的Web界面;另一种是通过Shell命令查看。

查看一个应用程序产生的所有日志,命令如下:

bin/yarn logs -applicationId application_130332321231_0001

查看一个Container 产生的日志,命令如下:

bin/yarn logs -applicationId application_130332321231_0001 -containerId container_130332321231_0002 -nodeAddress 127.0.0.1_45454

SparkStreaming/Flink

上面说的机制更多的是针对一些不是长时间运行的任务在任务结束后的,日志清理机制。

但是针对 SparkStreaming/Flink 这样的长时间运行的任务来说,Yarn 的日志清理机制并不会起作用,所以需要配置各自框架的 log4j.properties 文件,来实现日志的自动清理。

如 Flink 任务的清理 可参考 https://blog.csdn.net/Mrerlou/article/details/125159007

总结

Yarn Container有本地删除和日志聚合转存删除两种机制。Yarn Contaioner本地日志是由yarn.nodemanager.log.retain-seconds控制。yarn.log-aggregation-enable是开启日志聚合转存。- 转存后的日志由

yarn.log-aggregation.retain-seconds控制。 Yarn的清理机制是针对已完成的任务来实施。对于长时间运行的任务,需要在配置log4j这样的配置。

7450

7450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?