官网:EnerVerse 官网

论文:EnerVerse 论文 —— arxiv

通过自回归扩散模型(autoregressive diffusion),EnerVerse 在生成未来具身空间的同时,能够有效引导机器人完成复杂任务。与现有方法简单应用视频生成模型不同,EnerVerse 深度结合具身任务的需求,创新性地引入了稀疏记忆机制(Sparse Memory)和自由锚点视角(Free Anchor View, FAV)。这些创新不仅显著提升了 4D 生成能力,还实现了动作规划性能的重大突破。

- Initial Reconstruction:使用安装在机器人上的摄像头的观察图像来构建初始 3D 点云,并根据环境和任务专属的需求设置 anchor views。

- Free Anchor View Renders:从这些设定的 anchor views 对场景进行渲染,输出多个图像,得到更全面的场景表示。(增加 ray-direction map)

- Chunkwise Autogressive Generation:根据任务指令,使用多视角视频生成 diffusion 以 chunks 形式(相比连续帧强调长时间序列以及因果推理)生成图像序列,结合噪声帧和参考帧,通过稀疏上下文记忆机制保留关键帧信息,确保生成的一致性和连续性。

Next-Chunk Diffusion Model

定义

- 观测帧为 o 1 : K t = [ o t 1 , o t 2 , … , o t K ] ∈ R K × H × W × C o_{1:K}^t = [o_t^1, o_t^2, \ldots, o_t^K] \in \mathbb{R}^{K \times H \times W \times C} o1:Kt=[ot1,ot2,…,otK]∈RK×H×W×C

- 渲染帧为 r 1 : J t ∈ R J × H × W × C r_{1:J}^t \in \mathbb{R}^{J \times H \times W \times C} r1:Jt∈RJ×H×W×C

- 预测帧为 z 1 : M t = [ z t 1 , z t 2 , … , z t M ] ∈ R M × H × W × C z_{1:M}^t = [z_t^1, z_t^2, \ldots, z_t^M] \in \mathbb{R}^{M \times H \times W \times C} z1:Mt=[zt1,zt2,…,ztM]∈RM×H×W×C 。

任务是基于观测帧

o

1

:

K

t

o_{1:K}^t

o1:Kt 和文本指令

c

c

c ,预测未来的潜在帧

z

1

:

M

t

z_{1:M}^t

z1:Mt,这一过程建模为条件概率

p

θ

(

z

1

:

M

t

∣

c

,

o

1

:

K

t

)

p_\theta(z_{1:M}^t | c, o_{1:K}^t)

pθ(z1:Mt∣c,o1:Kt)。

模型可定义为:

ϵ

θ

(

z

1

:

M

t

,

c

,

o

1

:

K

t

,

t

)

\epsilon_\theta(z_{1:M}^t, c, o_{1:K}^t, t)

ϵθ(z1:Mt,c,o1:Kt,t)

损失函数为:

min

θ

E

t

,

z

∼

z

data

,

ϵ

∼

N

(

0

,

I

)

∥

ϵ

−

ϵ

θ

(

z

1

:

M

t

,

c

,

o

1

:

K

t

,

t

)

∥

2

2

\min_\theta \qquad \mathbb{E}_{t, z \sim z_{\text{data}}, \epsilon \sim \mathcal{N}(0, I)} \left\| \epsilon - \epsilon_\theta(z_{1:M}^t, c, o_{1:K}^t, t) \right\|_2^2

θminEt,z∼zdata,ϵ∼N(0,I)

ϵ−ϵθ(z1:Mt,c,o1:Kt,t)

22

在推理阶段,模型通过自回归方式逐步生成未来帧序列:

- 从随机噪声 z T z^T zT 开始,通过迭代去噪生成第一个 chunk z 1 : M 0 z^0_{1:M} z1:M0。

- 将生成的 chunk 作为新的观测帧,输入模型以生成下一个 chunk。

- 重复这一过程,直到生成完整的未来帧序列或检测到预定义的序列结束(End-of-Sequence, EOS)标志。

实验结果

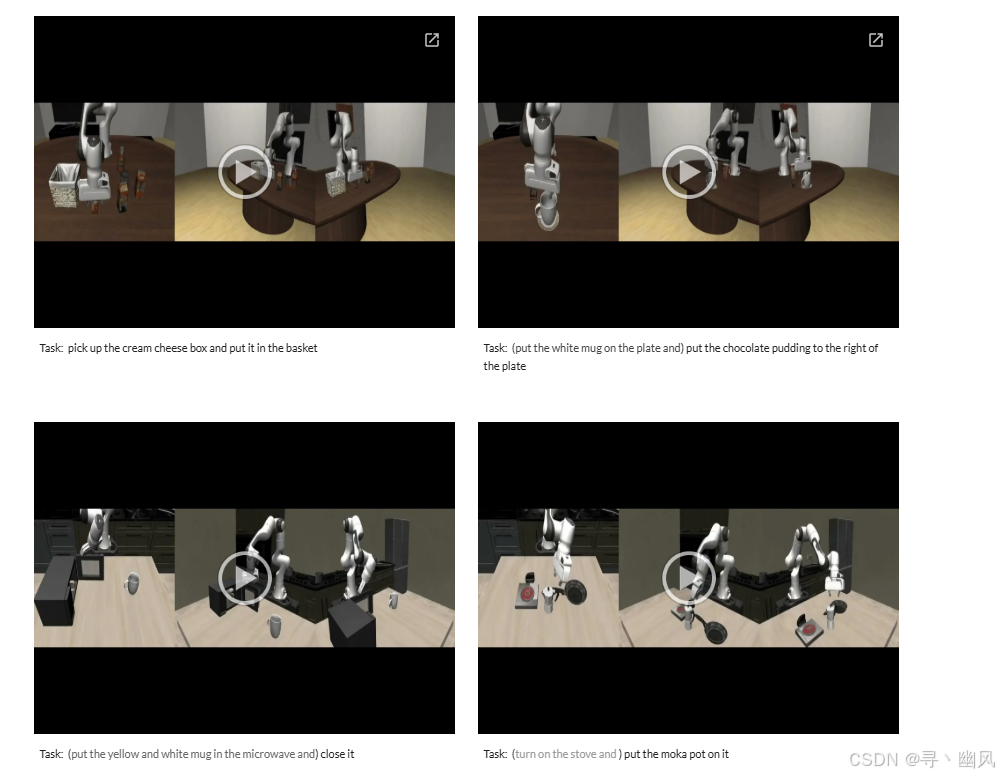

可视化

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?