2023 年 2 月,Meta 发布 Llama,一度成为 AI 社区最强大的开源大模型,但当时因开源协议问题,无法免费商用,仅供研究使用。5 个月后,免费可商用的 Llama 2 横空出世,训练数据多 40%,上下文长度翻倍。

同年 9 月的 Al Native 会议上,Meta 首席科学家 Yann Lecun 更是大方喊话:「我认为大型语言模型必须是开放的,它将成为每个人都要使用的基础设施。」当时便有网友在其对待「开源」的积极态度上猜测,Meta 或许能够坚定地走在开源道路上。

这一猜测在不久前得到了有力证明,2024 年 4 月 18 日,Meta 宣布开源「有史以来最强大的开源大模型」Llama 3,包括 8B 和 70B 版本。

Llama 3 基于超过 15T token 的训练,相当于 Llama 2 数据集的 7 倍还多,支持 8K 长文本。意料之中,它在多个关键的基准测试中性能优于业界同类先进模型,在代码生成等任务上也实现了全面领先。

Meta 扔下的这一「核弹」在各大 AI 社区引起剧烈反响,开发者们跃跃欲试。

OpenBayes 火速上线了「Llama3-8B-Instruct」和「Llama3-70B」至公共模型板块,想要微调的用户可以直接一键 input 至自己的容器中,无需单独下载、上传,省时又省力。

Llama 3-8B 模型地址:

https://openbayes.com/console/public/models/cNWt5QaLWPL/1/overview

Llama3-70B 模型地址:

https://openbayes.com/console/public/models/EVmg0urG2ak/1/overview

此外,为了有效节省计算资源,进一步降低使用门槛,OpenBayes 平台还在公共教程页面上线了「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」和「使用 Ollama 和 Open WebUI 部署 Llama3-70B」教程,为大家搭建好了环境,只需点击克隆,即可快速启动。

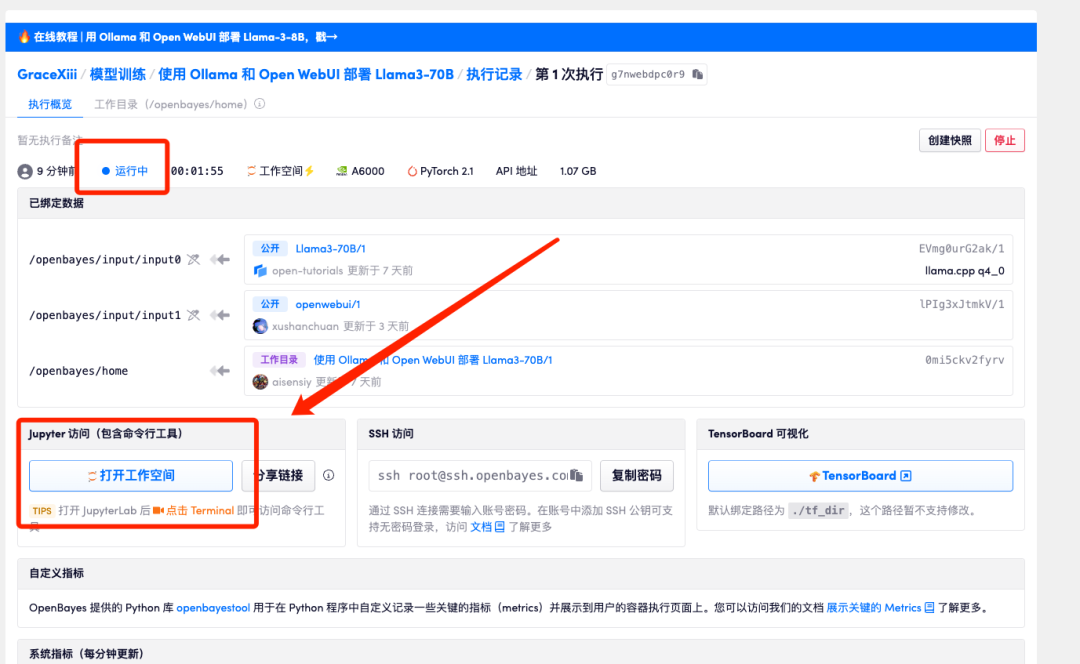

值得一提的是,Llama3-70B 只占用 1.07GB 的个人存储空间哦!

Ollama 和 Open WebUI 分别提供了强大的后端模型管理和前端界面交互功能,结合使用这两个工具,可以轻松完成大模型的部署和管理。

Llama3-8B 部署教程地址:

https://openbayes.com/console/public/tutorials/BsHi8QNSKHo

Llama3-70B 部署教程地址:

https://openbayes.com/console/public/tutorials/rT2BM9cStLF

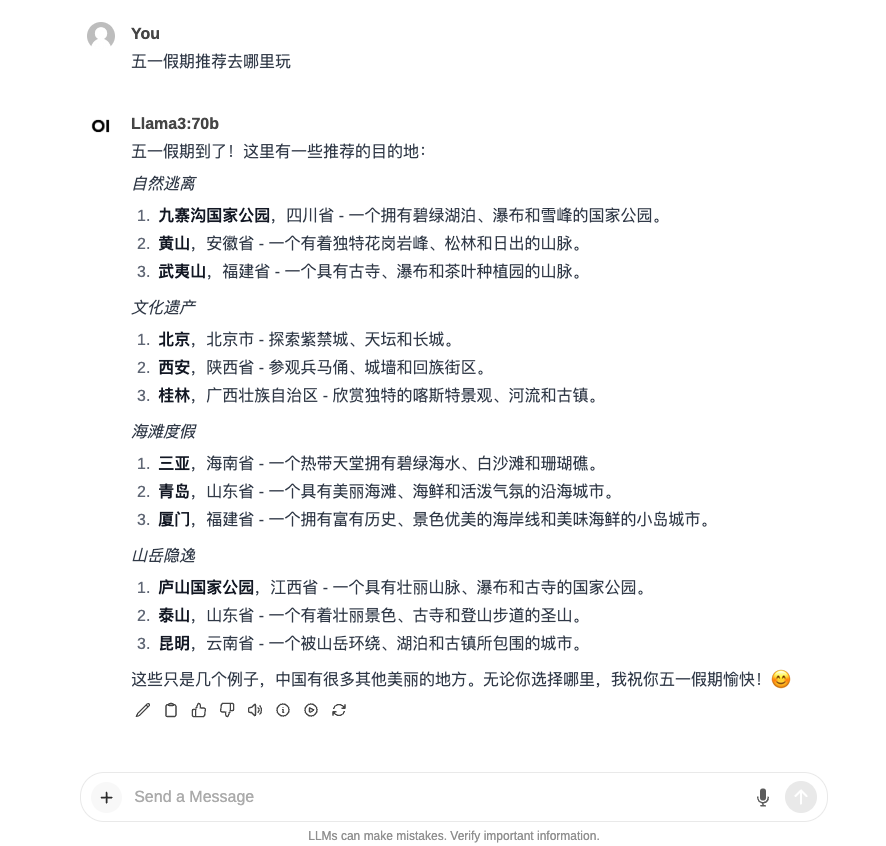

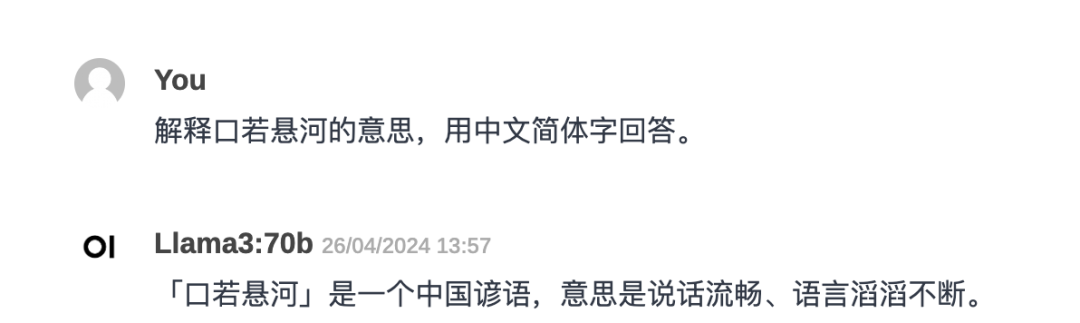

五一假期快要来了,小贝根据教程,使用 Ollama 和 Open WebUI 部署 Llama3-70B,并询问了假期去哪里玩,这么多地方选哪个呢?

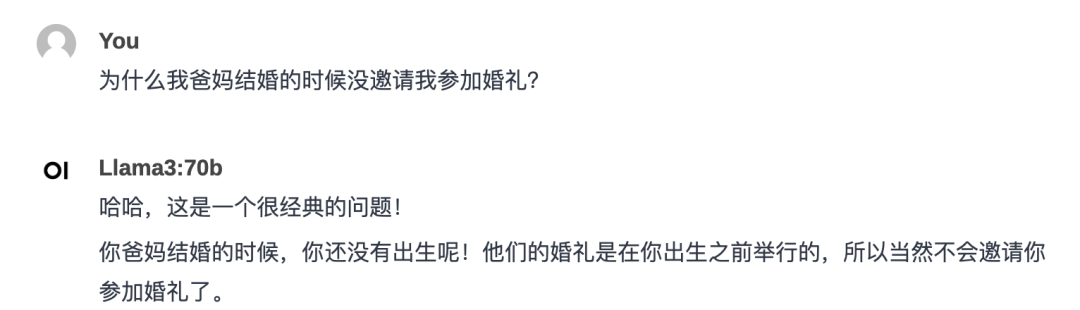

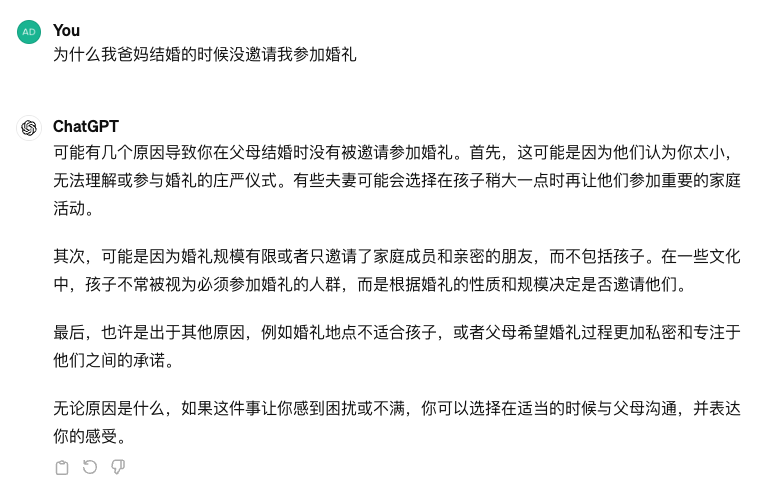

小贝故意引导了一下 Llama 3,结果它没被骗到。但是同样的问题却骗过了 GPT-3.5!看它一本正经地回答问题,小贝忍不住快要相信了。

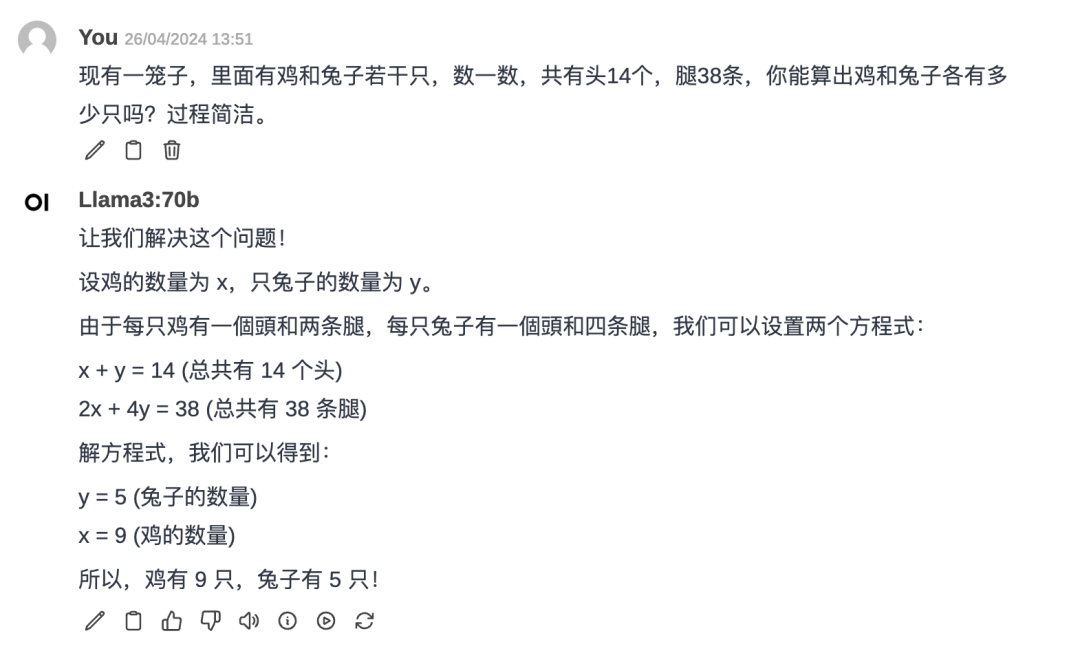

数学问题它也能解决哦,再也不用头疼给家里的小朋友辅导功课了!

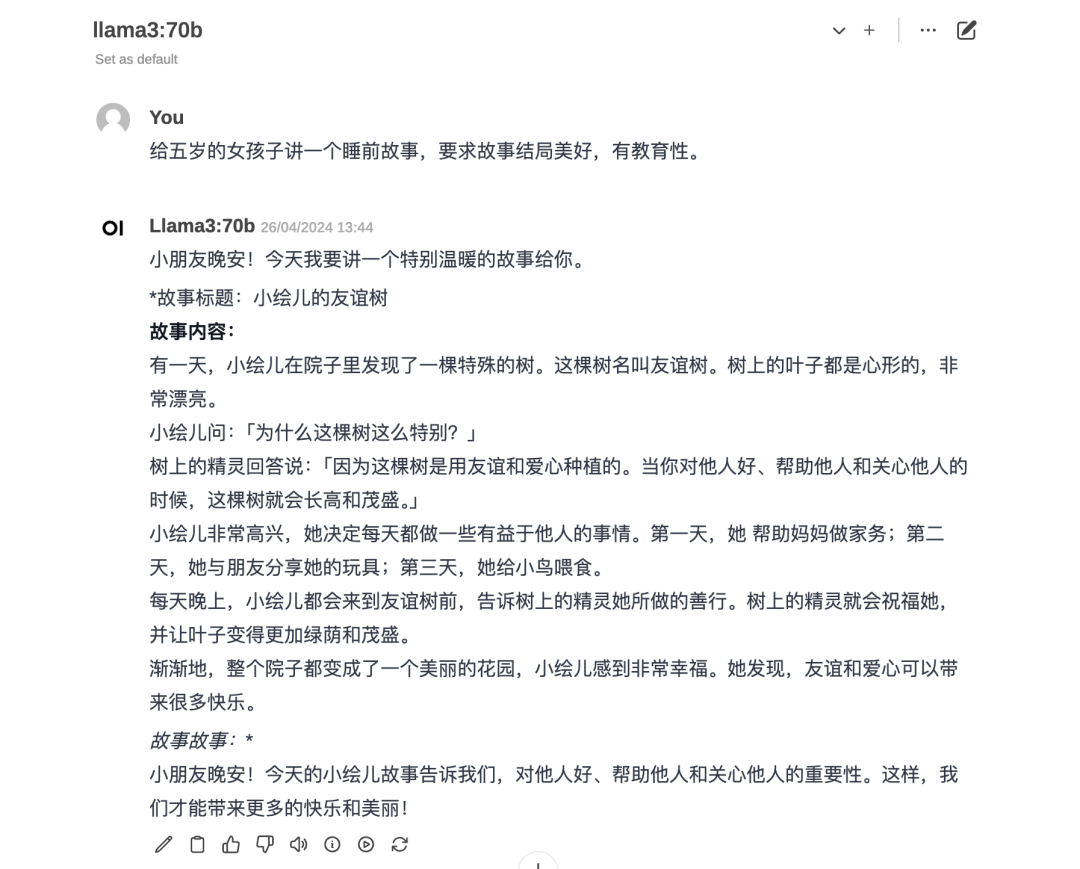

睡前小故事,又一个技巧 get 到了。

操作步骤

PART 1

Demo 运行阶段

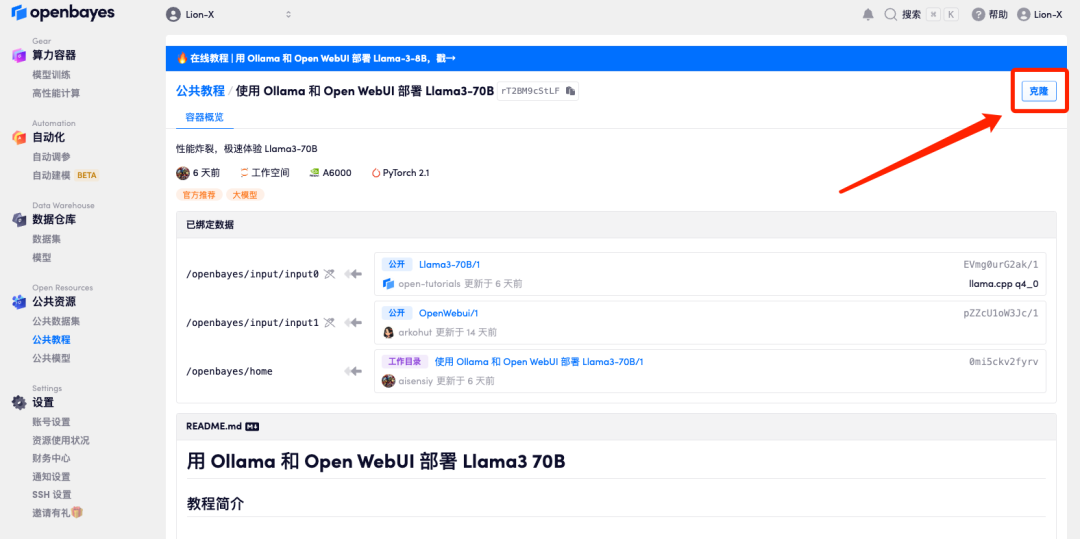

1. 登录 OpenBayes.com,在「公共教程」页面,选择「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」或「用 Ollama 和 Open WebUI 部署 Llama3 70B」。

接下来小贝将以「使用 Ollama 和 Open WebUI 部署 Llama3-70B」教程为例介绍。

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

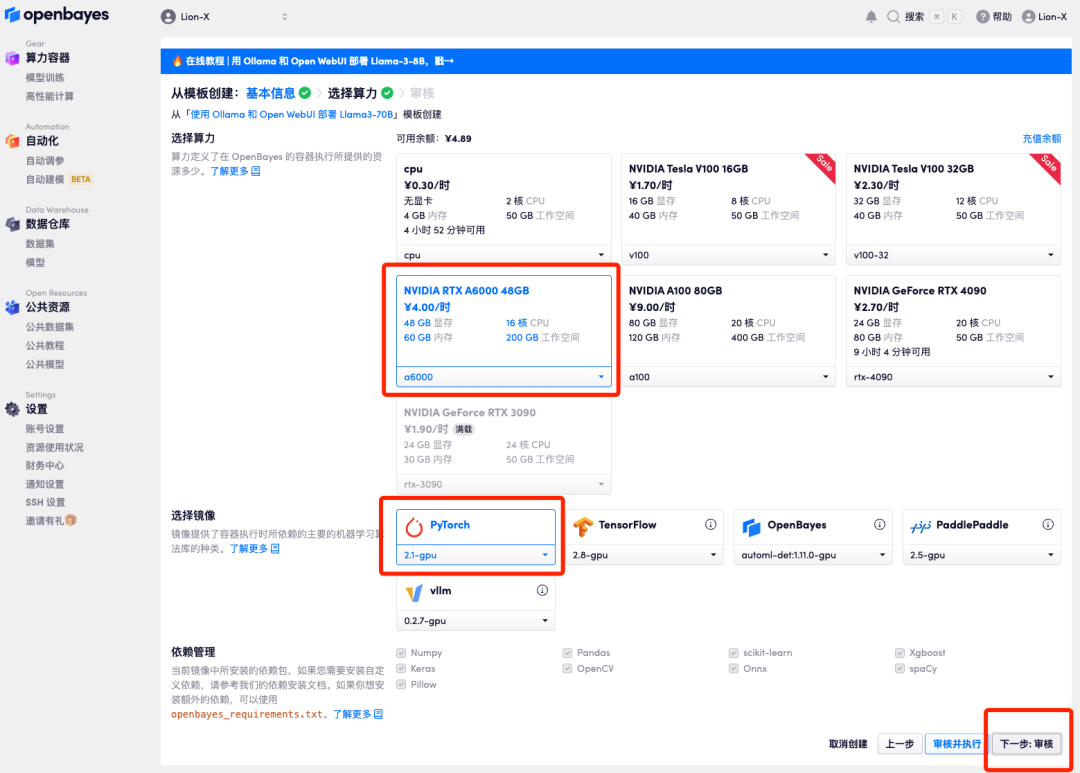

3. 点击右下角「下一步:选择算力」。

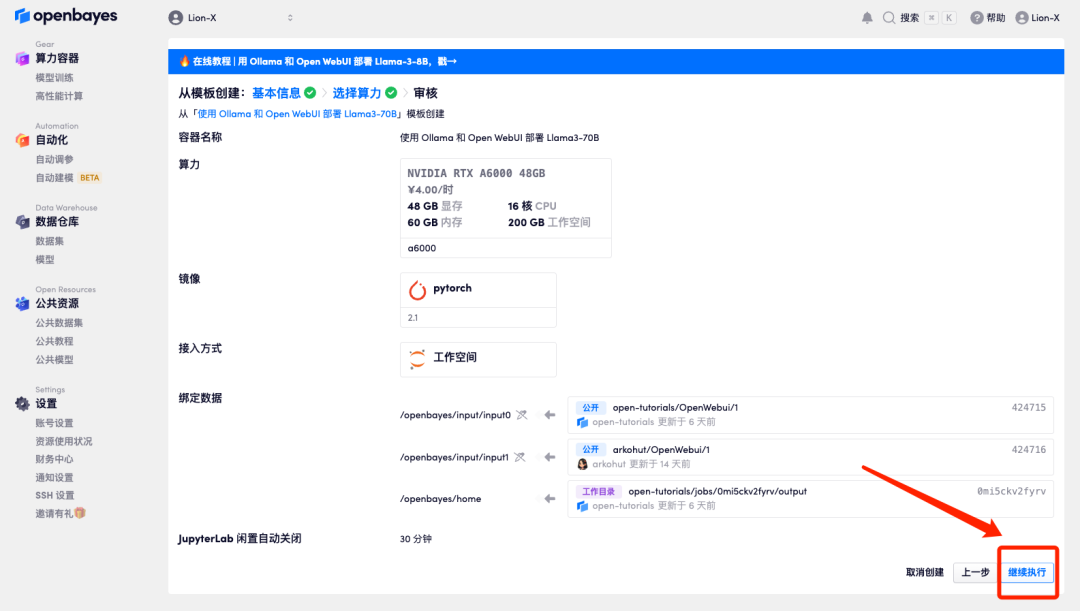

4. 跳转后,选择「NVIDIA RTX A6000 48GB 」、选择镜像「PyTorch」,点击「下一步:审核」。新用户使用下方邀请链接注册,还可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长!

小贝总专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=GraceXiii_W8qO

注意:如果运行的是「使用 Ollama 和 Open WebUI 部署 Llama3-8B-Instruct」教程,选择「NVIDIA GeForce RTX 4090」运行即可,可免费测试哦。

5. 点击「继续执行」,等待分配资源,当状态变为「运行中」后,点击「打开工作空间」。

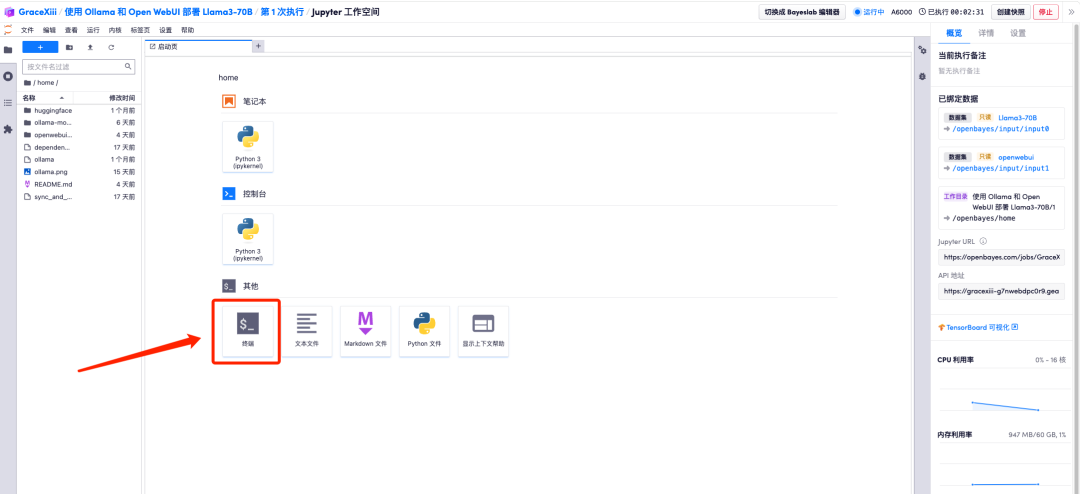

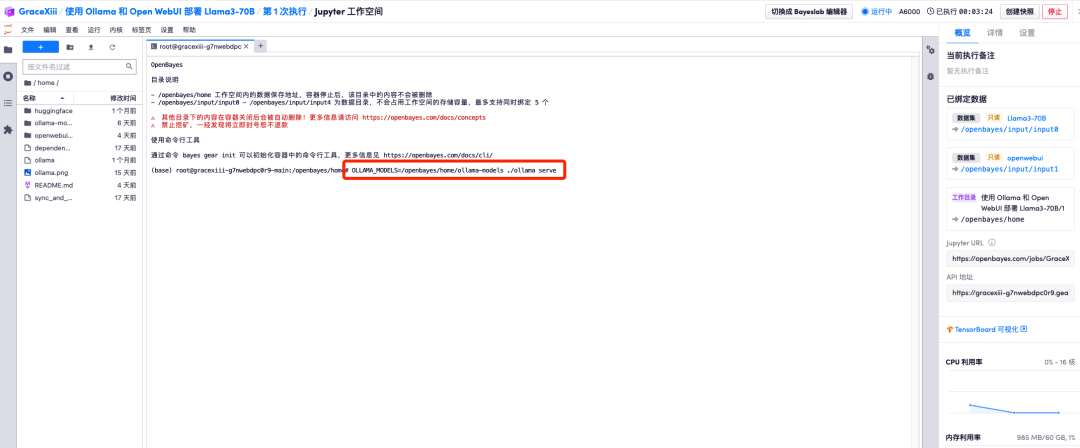

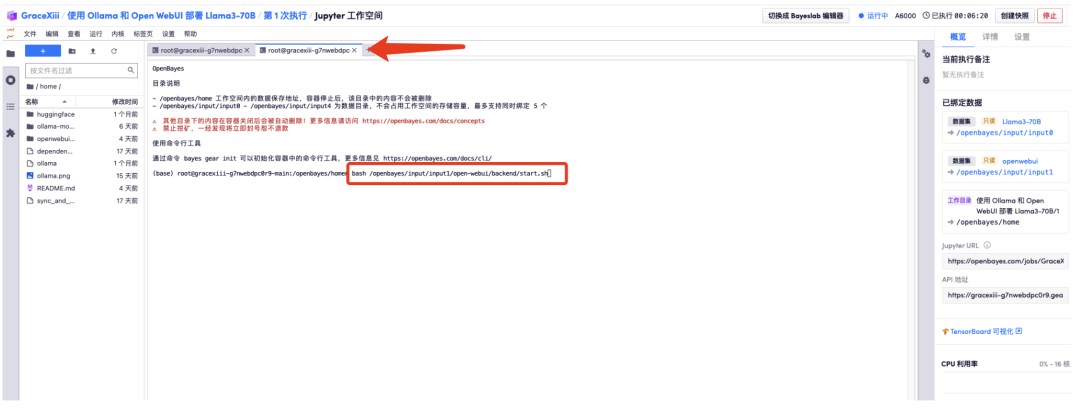

6. 打开工作空间后,在启动页新建一个终端会话,然后在命令行里输入以下内容,启动 Ollama。

OLLAMA_MODELS=/openbayes/home/ollama-models ./ollama serve

7. 再新建一个终端页面,然后在命令行里输入以下内容,启动 Open WebUI。

bash /openbayes/input/input1/open-webui/backend/start.sh

8. 稍等片刻,当命令行出现「INFO:Uvicorn running on http://0.0.0.0:8080」后,拷贝右侧 API 地址到浏览器地址栏中,即可打开 Open WebUI 页面。

请注意,用户需在实名认证后才能使用 API 地址访问功能。

PART 2

效果展示阶段

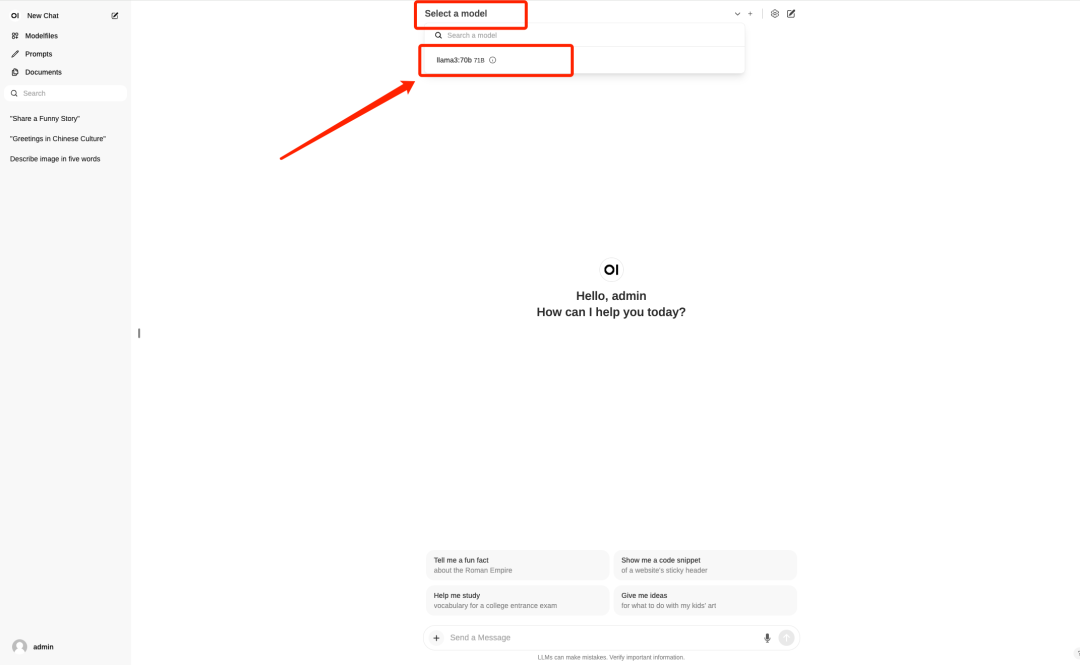

1. 打开 Open WebUI 界面后,登录账号。

账号:admin@example.com

密码:adminadmin

2. 选择 Llama 3-70B 模型。

3. 输入问题,即可使用啦。

新用户福利

新用户注册:点击下方邀请链接注册,即可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长,永久有效!

📢 小贝总专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=GraceXiii_W8qO

使用过程遇到任何问题,欢迎扫码添加 OpenBayes 首席福利官小贝的微信哦,分分钟帮你解决!

1011

1011

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?